Similar presentations:

Линейная парная регрессия

1. Лекция 1

Линейная парная регрессия1. Эконометрика как научная дисциплина.

2. Спецификация уравнения парной регрессии.

3. Параметризация уравнения парной регрессии.

4. Экономическая интерпретация параметров

модели.

2. 1. Эконометрика как научная дисциплина.

Эконометрика – это дисциплина, изучающая методыпостроению на основе статистических данных

аналитических математических моделей

экономических процессов с целью их анализа и

прогнозирования.

Основными целями эконометрики являются:

объяснение поведения экономических и социальных

показателей;

прогнозирование показателей;

управление показателями.

3.

Основными задачами эконометрики считаются:выбор типа эконометрических моделей (регрессионные

модели с одним уравнением, системы взаимозависимых

уравнений, модели временных рядов);

оценка параметров выбранных моделей;

проверка качества модели и ее полученных параметров;

практическое использование построенных адекватных

моделей для анализа, прогноза и осмысленного управления

экономической политикой.

Для решения поставленных задач широко

используется инструментарий, основу которого

составляют основные положения теории вероятностей

и математической статистики.

4.

2. Спецификация уравненияпарной регрессии.

Изучение зависимостей экономических переменных

начнём со случая двух переменных. Обозначим их

символами x и y .

Первую из них (x) будем называть

привычным термином независимая переменная,

или, как принято в эконометрике, - объясняющая

переменная или фактор. Вторую ( y) –зависимой

или объясняемой переменной.

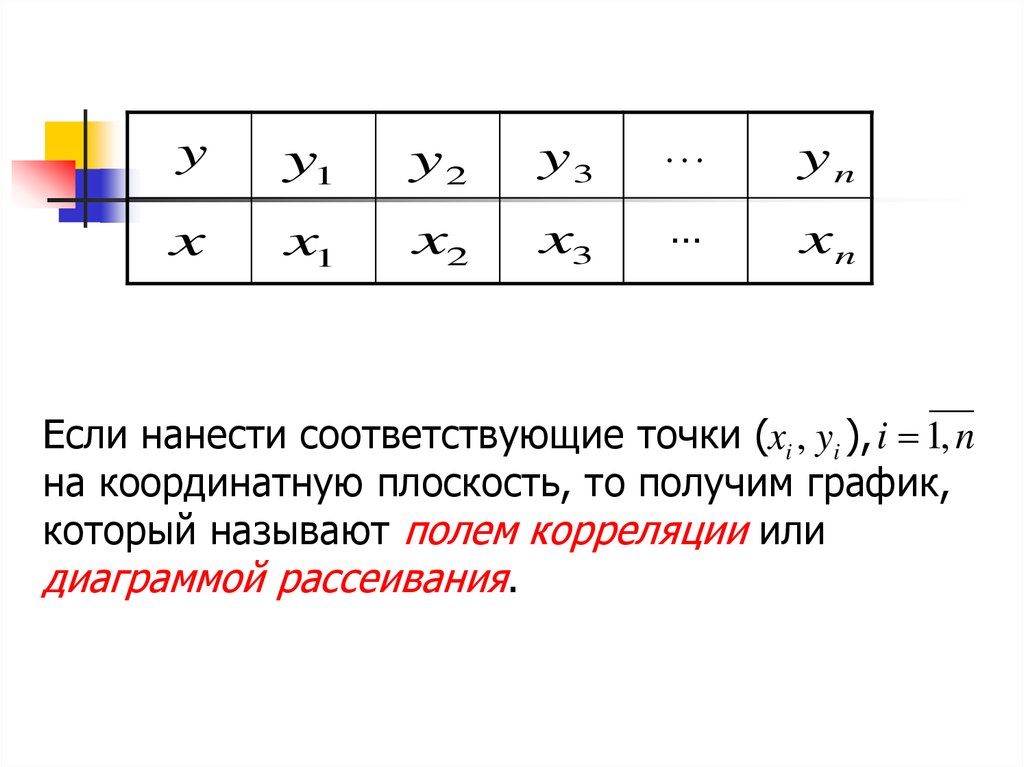

Предположим, что имеются статистические

данные в виде рядов значений указанных

переменных, которые сведены в следующую

таблицу (двумерная выборка объема n , n>7)

5.

yy1

y2

y3

…

yn

x

x1

x2

x3

…

xn

Если нанести соответствующие точки (xi , yi ), i 1, n

на координатную плоскость, то получим график,

который называют полем корреляции или

диаграммой рассеивания.

6.

Рис. 1. Поле корреляцииy

yn

y2

y1

x1

x2

x

xn

7.

Построенные точки на практике никогда не будутрасполагаться на некоторой гладкой линии типа прямой,

параболы, экспоненты и т.д.

Происходит это потому, что на зависимую переменную

помимо фактора влияют другие, либо неучтенные, либо

случайные факторы.

Связь переменных, на которую накладывается

воздействие случайных факторов, называется

статистической связью.

Формула статистической связи между переменными

y f ( x, ) ,

где случайный фактор, называется уравнением

регрессии.

Для двух переменных она называется уравнением

парной регрессии.

8.

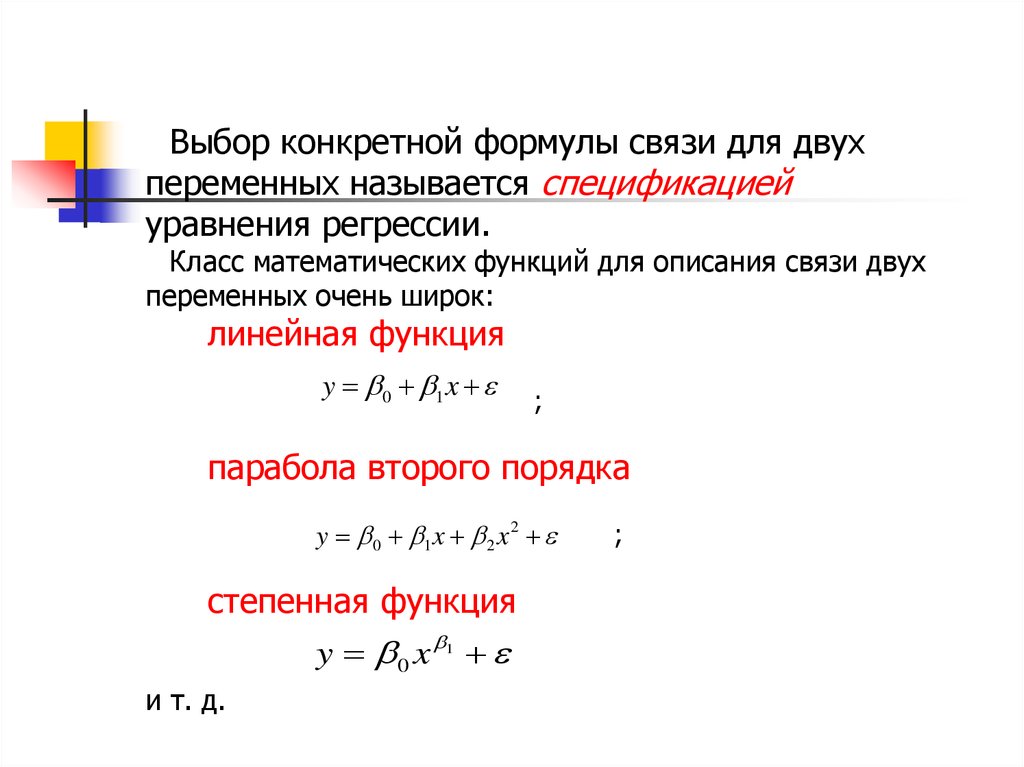

Выбор конкретной формулы связи для двухпеременных называется спецификацией

уравнения регрессии.

Класс математических функций для описания связи двух

переменных очень широк:

линейная функция

y 0 1 x

;

парабола второго порядка

y 0 1 x 2 x 2

степенная функция

y 0 x

1

и т. д.

;

9.

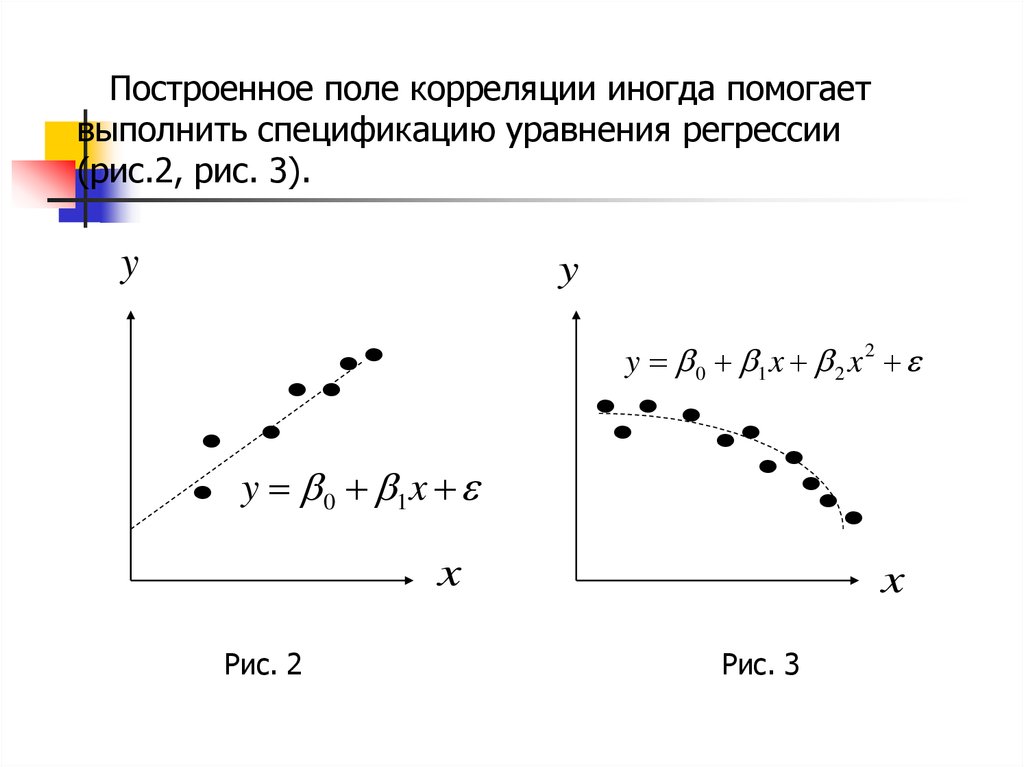

Построенное поле корреляции иногда помогаетвыполнить спецификацию уравнения регрессии

(рис.2, рис. 3).

y

y

y 0 1 x 2 x 2

y 0 1 x

x

Рис. 2

x

Рис. 3

10.

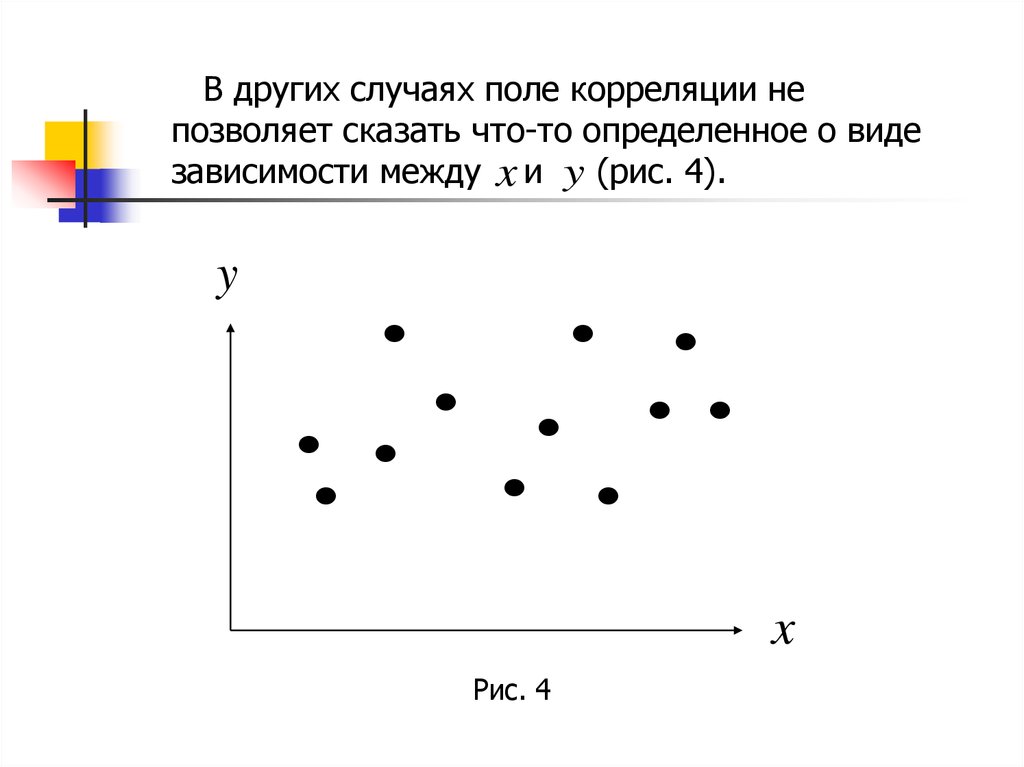

В других случаях поле корреляции непозволяет сказать что-то определенное о виде

зависимости между x и y (рис. 4).

y

x

Рис. 4

11.

В последнем случае начинают с выборанаиболее простой связи – линейной :

y 0 1 x

Если в последующем она не устраивает по

точности, то ищут какую-либо нелинейную

связь между переменными x и y .

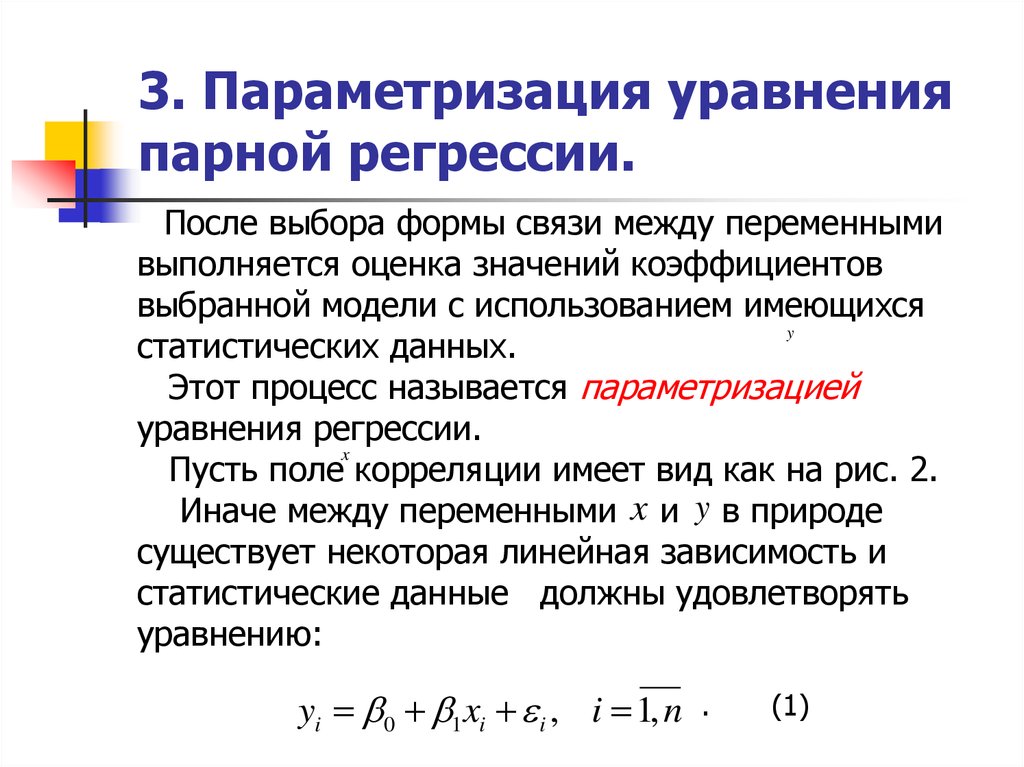

12. 3. Параметризация уравнения парной регрессии.

После выбора формы связи между переменнымивыполняется оценка значений коэффициентов

выбранной модели с использованием имеющихся

y

статистических данных.

Этот процесс называется параметризацией

уравнения регрессии.

x

Пусть поле корреляции имеет вид как на рис. 2.

Иначе между переменными x и y в природе

существует некоторая линейная зависимость и

статистические данные должны удовлетворять

уравнению:

yi 0 1 xi i , i 1, n

.

(1)

13. Здесь коэффициенты, которые подлежат определению, случайная составляющая в м наблюдении, которую называют возмущением.

Здесь0 , 1 коэффициенты, которые

подлежат определению, i случайная

составляющая в i м наблюдении, которую

называют возмущением.

Уравнение (1) называют

уравнением регрессии.

модельным

14.

Возникает задача:по выборке xi , yi , i 1, n оценить уравнение (1)

и такой оценкой является выборочное уравнение

регрессии:

~

y b0 b1 x

(2)

Построение уравнения (2) сводится к

получению точечных оценок b0 ,b1 неизвестных

коэффициентов 0 , 1 модельного уравнения (1).

Классический подход к оцениванию неизвестных

коэффициентов основан на методе наименьших

квадратов (МНК).

15.

Чтобы при этом точечные оценки b0 ,b1были "хорошими" (несмещенными,

эффективными и состоятельными) требуется

сделать следующие предположения

относительно уравнения (1).

1°. Возмущения i

являются случайными

величинами, а переменные xi таковыми не

являются.

2°. Математическое ожидание случайных

величин i во всех наблюдениях равно нулю,

т.е.

M ( i ) 0 , i 1, n .

16.

3°. Дисперсия случайных величин iпостоянна для любого наблюдения:

D( i ) 2 const

.

n

n

2

1

1

x1 x2

Рис. 5

xn

2

x1 x2

xn

Рис. 6

17.

Это свойство называют гомоскедастичностьювозмущений (одинаковый разброс, рис.5).

Если оно не выполняется, то говорят о

гетероскедастичности (различный разброс,

рис. 6).

4°. Возмущения i и j в различных

наблюдениях являются некоррелированными

величинами

M ( i j ) 0 .

5°. Случайные величины i имеют нормальный

закон распределения

i ~ N (0, 2 )

.

18.

При выполнении указанных требований,которые называют предпосылками МНК, модель

(1) называют нормальной классической линейной

регрессионной моделью.

Согласно МНК параметры b0 ,b1 определяются

таким образом, чтобы сумма квадратов

отклонений выборочных значений yi от значений

~

yi , полученных по уравнению регрессии

~

yi b0 b1 xi

по всем i 1, n наблюдениям была минимальной.

19.

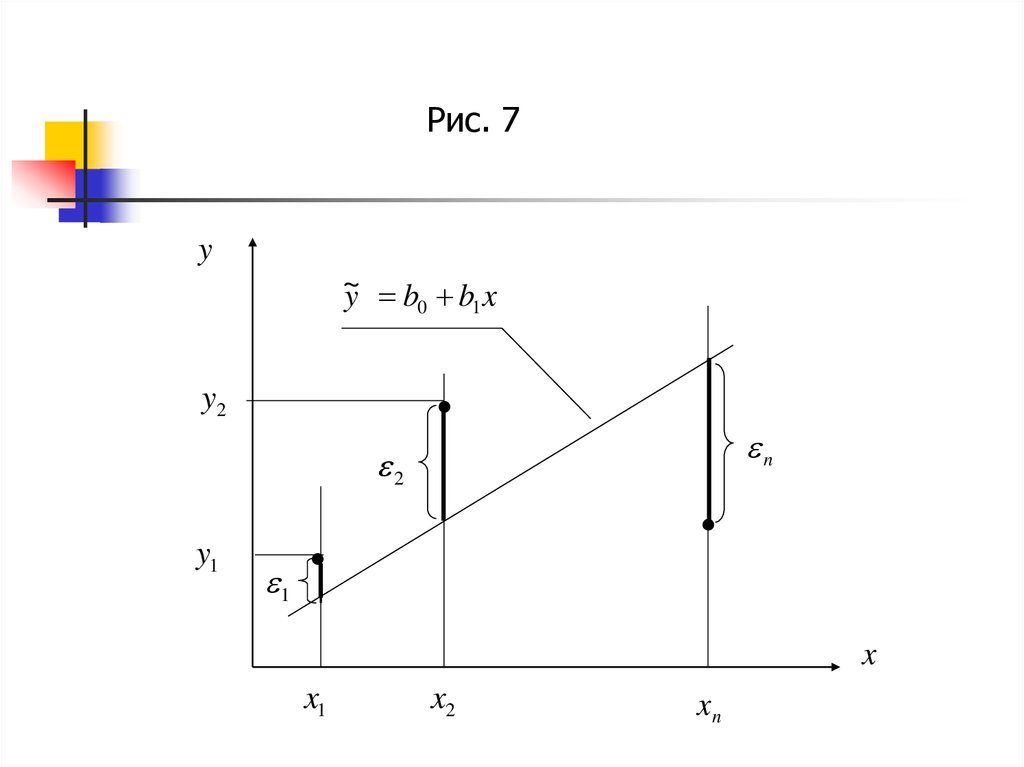

Рис. 7y

~

y b0 b1 x

y2

n

2

y1

1

x

x1

x2

xn

20.

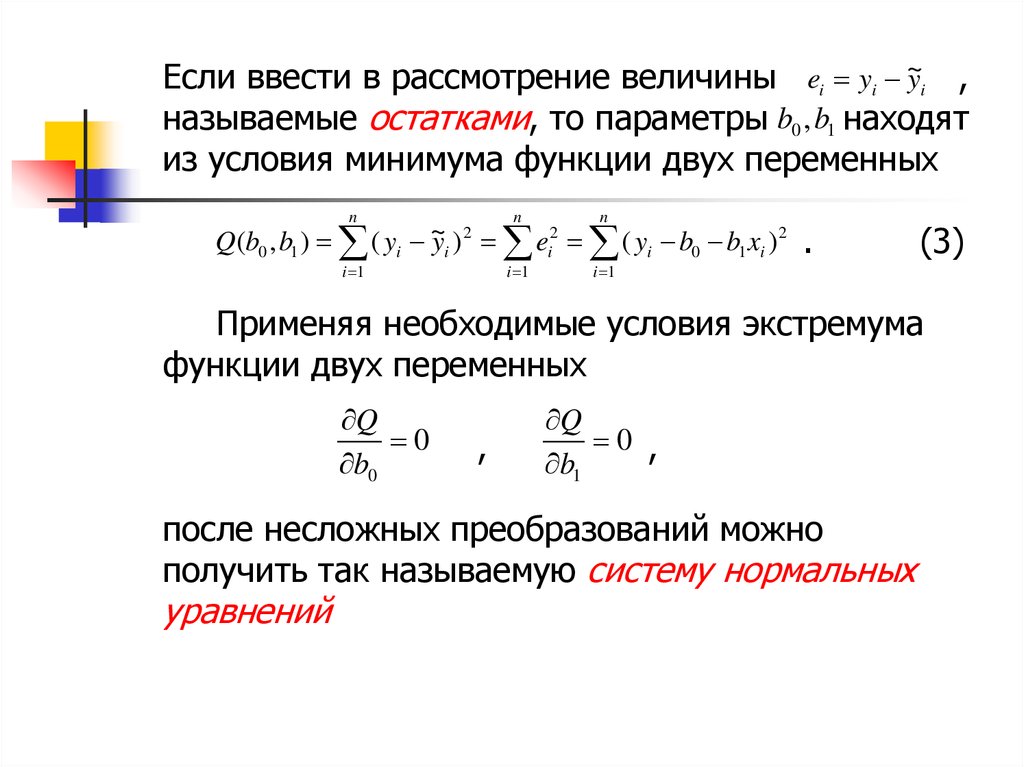

Если ввести в рассмотрение величины ei yi ~yi ,называемые остатками, то параметры b0 ,b1 находят

из условия минимума функции двух переменных

n

n

n

i 1

i 1

i 1

Q(b0 , b1 ) ( yi ~

yi ) 2 ei2 ( yi b0 b1 xi ) 2

.

(3)

Применяя необходимые условия экстремума

функции двух переменных

Q

0

b0

,

Q

0 ,

b1

после несложных преобразований можно

получить так называемую систему нормальных

уравнений

21.

nn

b0 n b1 xi yi ,

i 1

i 1

n

n

n

b0 xi b1 xi2 xi yi

i 1

i 1

i 1

для определения двух неизвестных b0 и b1 .

Разделив обе части уравнений на n ,

получим систему в виде

b0 b1 x y,

2

b

x

b

x

xy,

1

0

где

1 n

x xi ,

n i 1

1 n 2

x xi ,

n i 1

2

1 n

y yi ,

n i 1

1 n

xy xi yi .

n i 1

(4)

22.

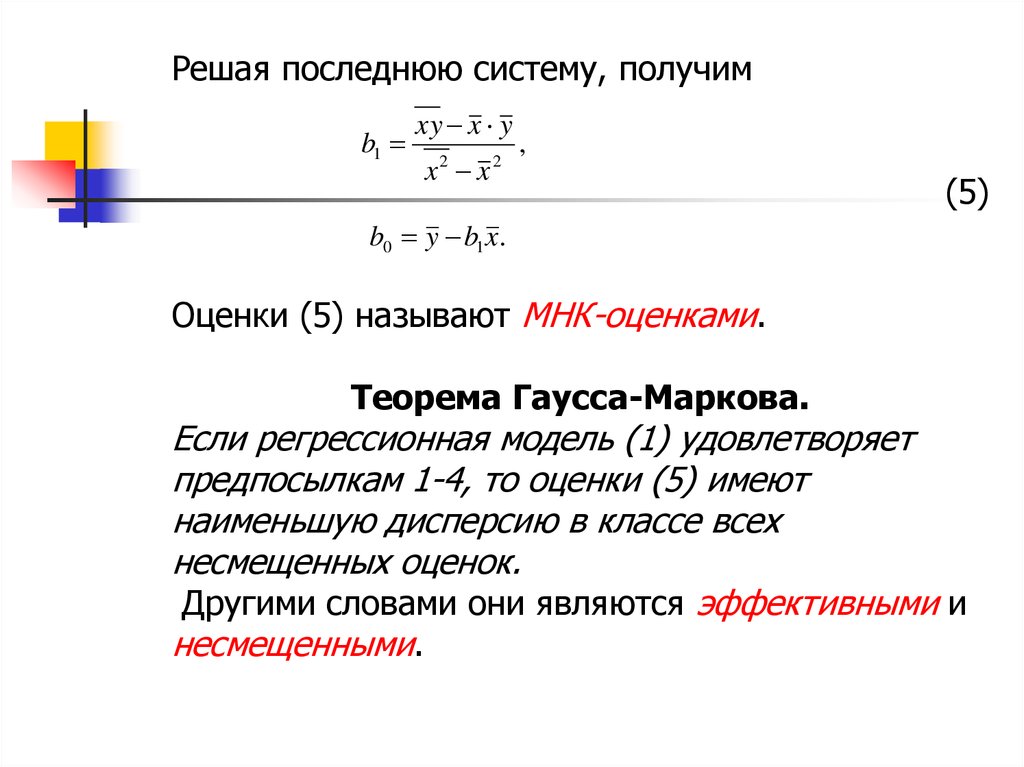

Решая последнюю систему, получимb1

xy x y

x x

2

2

,

(5)

b0 y b1 x.

Оценки (5) называют МНК-оценками.

Теорема Гаусса-Маркова.

Если регрессионная модель (1) удовлетворяет

предпосылкам 1-4, то оценки (5) имеют

наименьшую дисперсию в классе всех

несмещенных оценок.

Другими словами они являются эффективными и

несмещенными.

23.

4. Экономическаяинтерпретация параметров

модели.

Параметр b1 в уравнении регрессии (2)

y

называют выборочным коэффициентом регрессии

по x. Он показывает, на сколько единиц в

среднем изменится переменная y при

увеличении переменной x на одну единицу

своего измерения. В этом экономический смысл

параметра b1 .

Параметр b0 в общем случае не имеет

экономического смысла. Формально - это

значение переменной y при x =0, если такое

возможно.

24.

yИз экономического смысла b1 следует, что он

является измерителем тесноты связи переменных

и x . Однако его значение существенно зависит от

единиц измерения данных переменных.

Например, если y измеряется не в тоннах, а в кг,

то x уменьшается в 1000 раз.

Характеристикой тесноты связи, не

зависящей от единиц измерения, является

величина

x

rxy b1

,

y

где x , y выборочные средние

квадратические отклонения переменных

соответственно.

(6)

y

и

x

25.

Величину rxy называют выборочнымкоэффициентом парной корреляции и он

показывает, на сколько средних квадратических

отклонений y изменяется в среднем переменная

y , когда x увеличится на одно x .

Коэффициент rxy обладает следующими

свойствами.

1. Значения принадлежат отрезку: 1,1 . Чем

ближе rxy к 1, тем теснее связь переменных

y и x .

Если rxy 0 , то эта связь прямая, в противном

случае, когда rxy 0 обратная.

26.

2. При rxy 1 связь представляет линейнуюфункциональную зависимость между

переменными y и x (рис. 8).

y

rxy 0

rxy 0

x

Рис. 8

27.

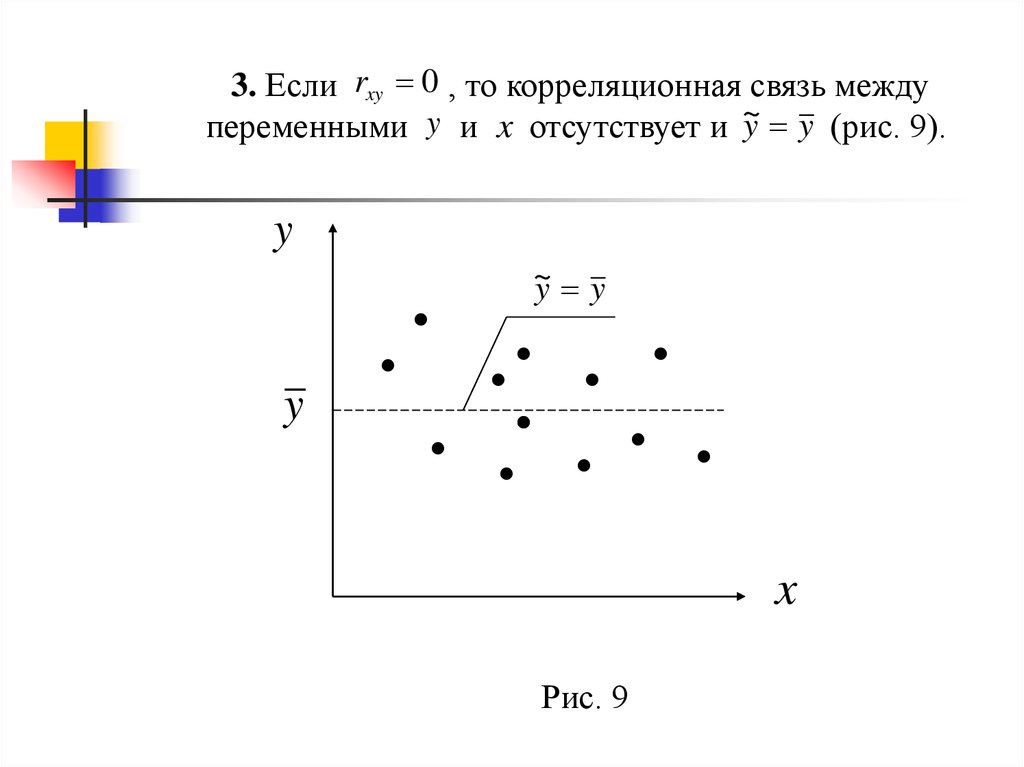

3. Если rxy 0 , то корреляционная связь междуy y (рис. 9).

переменными y и x отсутствует и ~

y

~

y y

y

x

Рис. 9

28.

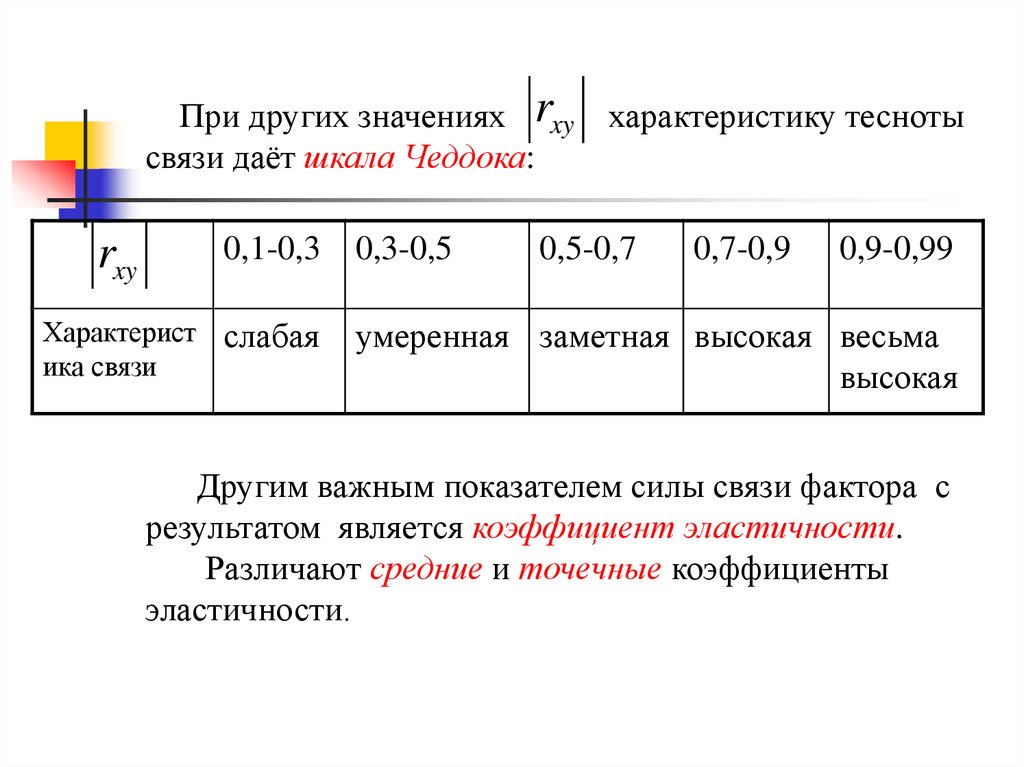

При других значениях rxyсвязи даёт шкала Чеддока:

rxy

0,1-0,3

Характерист слабая

ика связи

0,3-0,5

характеристику тесноты

0,5-0,7

0,7-0,9

0,9-0,99

умеренная заметная высокая весьма

высокая

Другим важным показателем силы связи фактора с

результатом является коэффициент эластичности.

Различают средние и точечные коэффициенты

эластичности.

29.

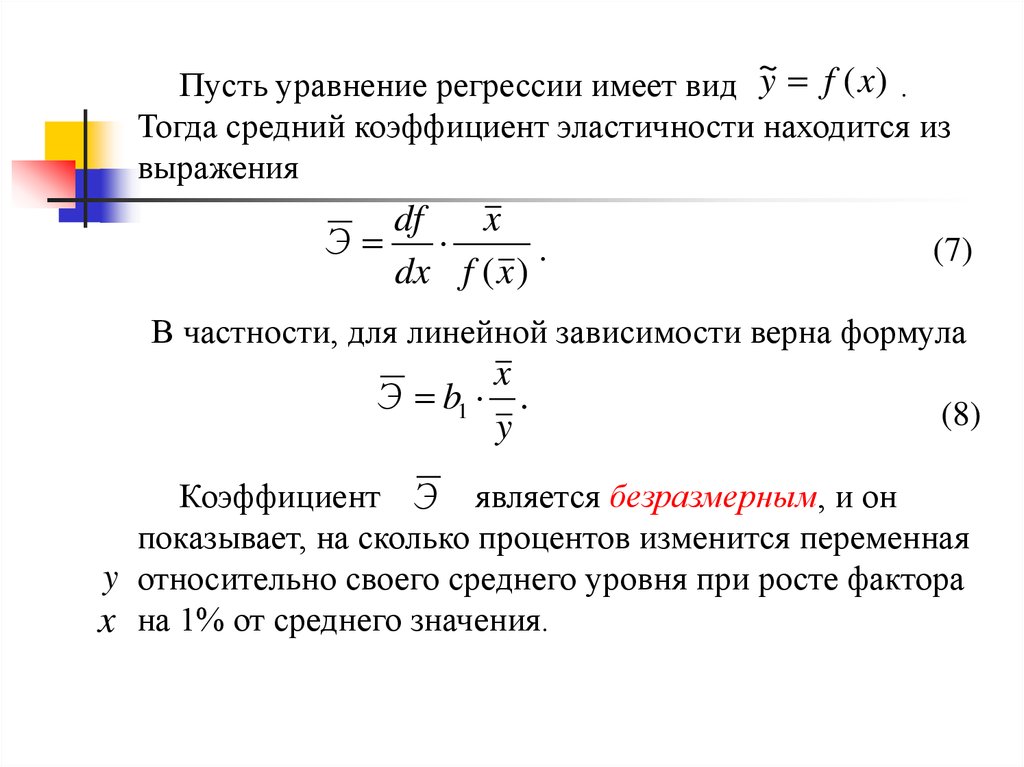

~Пусть уравнение регрессии имеет вид y f ( x) .

Тогда средний коэффициент эластичности находится из

выражения

df

x

Э

.

dx f (x )

(7)

В частности, для линейной зависимости верна формула

x

Э b1 .

y

(8)

Коэффициент Э является безразмерным, и он

показывает, на сколько процентов изменится переменная

y относительно своего среднего уровня при росте фактора

x на 1% от среднего значения.

30.

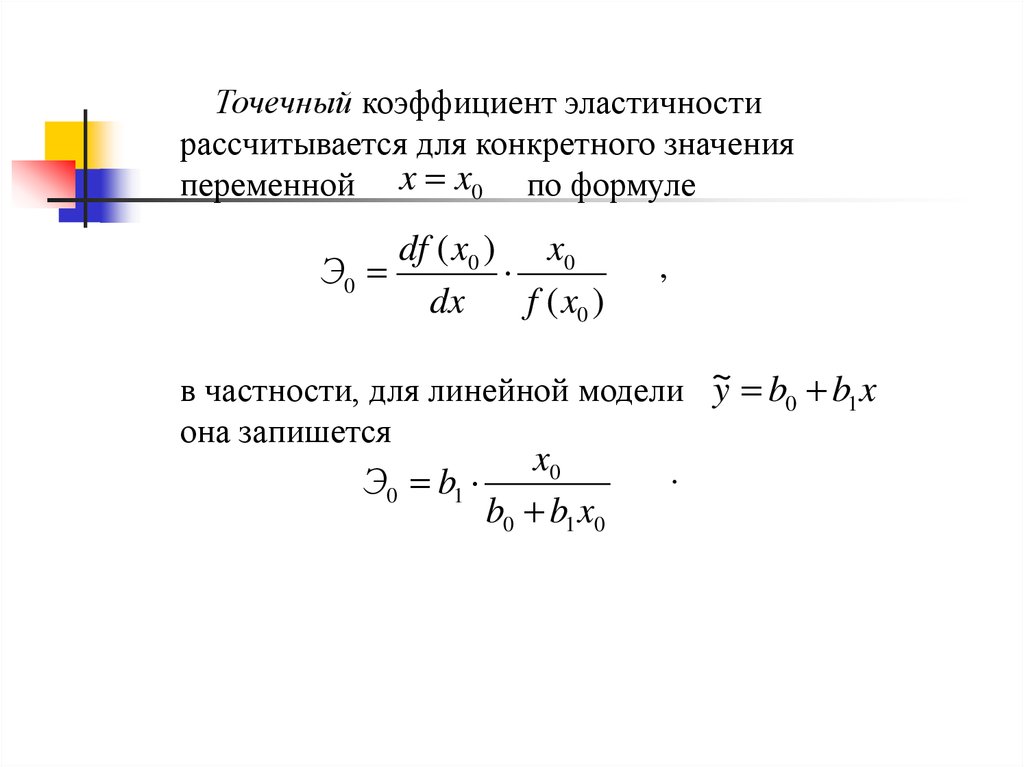

Точечный коэффициент эластичностирассчитывается для конкретного значения

переменной x x0 по формуле

df ( x0 ) x0

Э0

dx

f ( x0 )

,

y b0 b1 x

в частности, для линейной модели ~

она запишется

x0

.

Э b

0

1

b0 b1 x0

mathematics

mathematics