Similar presentations:

Парная линейная регрессия и метод наименьших квадратов

1. Парная линейная регрессия и метод наименьших квадратов

Лекция2. Цели лекции

Раскрыть понятие регрессии.Познакомиться с методом наименьших

квадратов – методом построения

линейного уравнения регрессии.

2

3. Виды зависимостей между переменными

1. Функциональные: Y = f(X).Имеют место при исследовании связей между

неслучайными переменными. Такие связи в

эконометрике не рассматриваются.

2. Статистические: изменение одной из величин

влечет изменение закона распределения другой

(доход – потребление, цена – спрос и т.д.).

3

4. Виды статистических зависимостей

а) Корреляционные: при изменении одной из величинизменяется среднее значение другой (связь между

переменными не носит направленного характера)

M[Y/X = x] = Mx[Y] = (x), M[X/Y = y] = My[X] = (y),

где M[Y/X = x] м. о. случайной величины Y,

вычисленное при условии, что случайная величина X

приняла значение x, (x) const, (y) const.

б) Регрессионные: односторонняя зависимость среднего

значения случайной величины Y от одной X или

нескольких X1, ,Xm случайных величин.

4

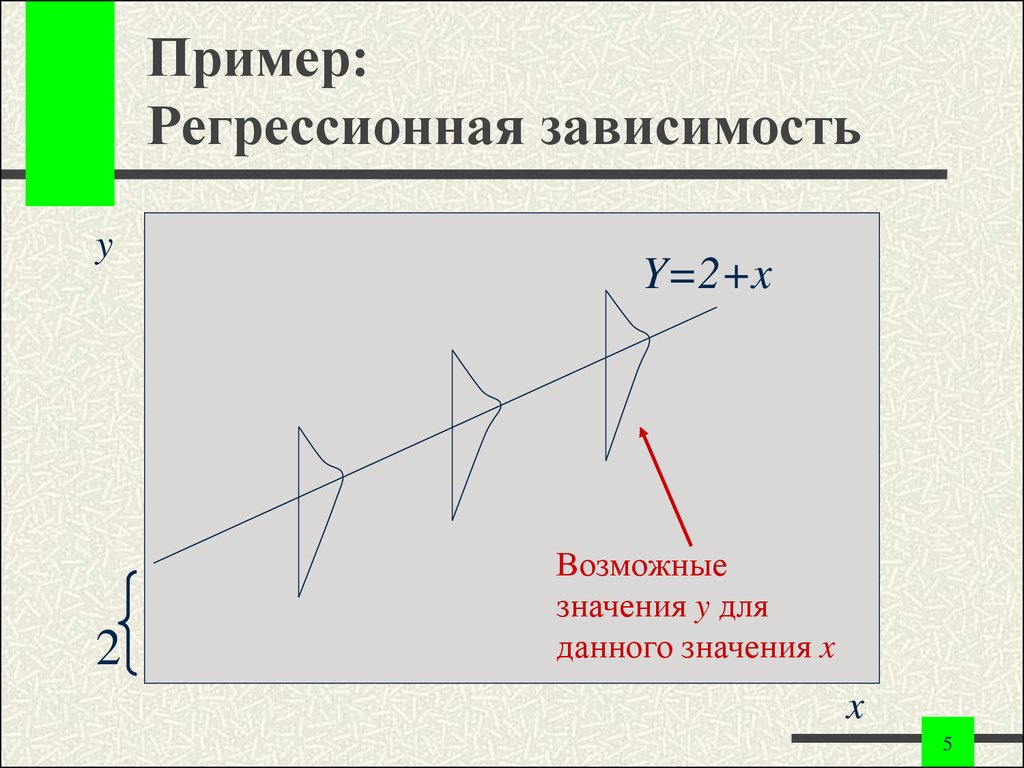

5. Пример: Регрессионная зависимость

y2

Y=2+x

Возможные

значения y для

данного значения x

x

5

6. Что такое регрессионный анализ?

Регрессионный анализ – наиболее частоиспользуемый инструмент в

эконометрике.

Регрессионный анализ представляет

собой анализ форм связи,

устанавливающих количественные

соотношения между случайными

величинами изучаемого случайного

процесса.

6

7. Определение регрессии

Регрессия – функциональная зависимостьмежду объясняющими переменными и

условным математическим ожиданием

(средним значением) зависимой

переменной, которая строится с целью

прогнозирования этого среднего

значения при фиксированных значениях

объясняющих переменных.

7

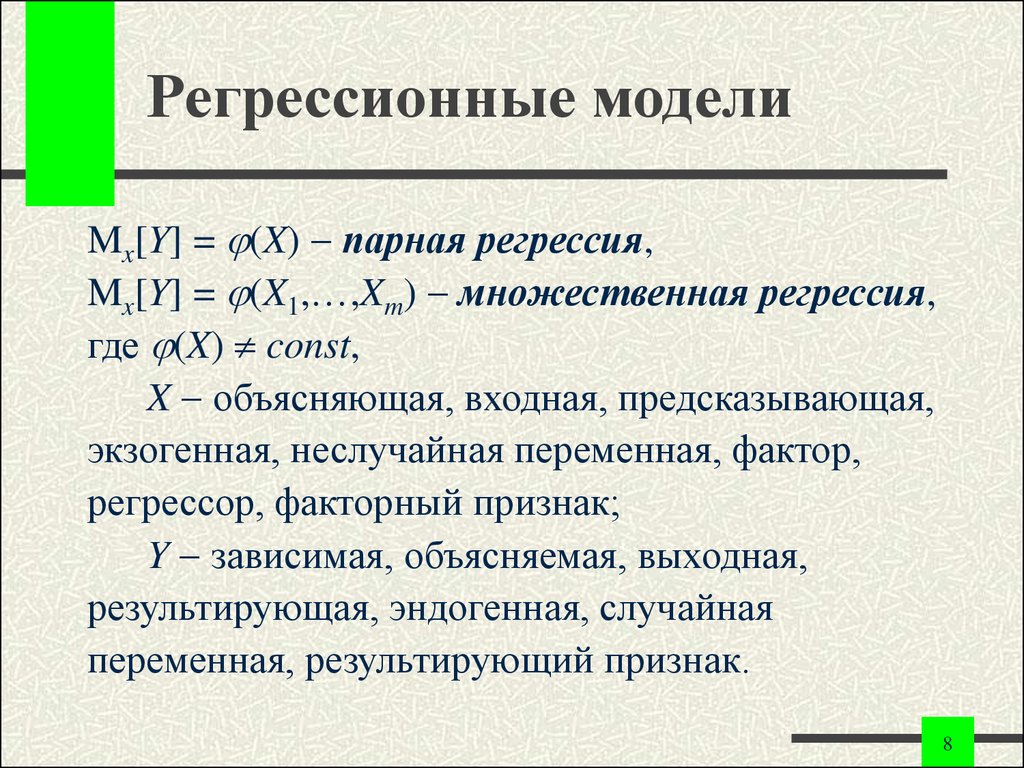

8. Регрессионные модели

Mx[Y] = (X) парная регрессия,Mx[Y] = (X1, ,Xm) множественная регрессия,

где (X) const,

X объясняющая, входная, предсказывающая,

экзогенная, неслучайная переменная, фактор,

регрессор, факторный признак;

Y зависимая, объясняемая, выходная,

результирующая, эндогенная, случайная

переменная, результирующий признак.

8

9. Пример: Парная регрессия

Мы хотим определить зависимостьмежду продажами и затратами на

рекламу.

y – продажи.

x – рекламные расходы.

9

10. Пример: Множественная регрессия

Мы хотим определить связь междупотреблением, доходом семьи,

финансовыми активами семьи и размером

семьи.

y – потребительские расходы.

x1 – доход семьи.

x2 – финансовые активы семьи.

x3 – размер семьи.

10

11. Регрессионные уравнения

Y = M[Y/x] + = (x) + уравнение парнойрегрессии,

Y = M[Y/x1 , , xm] + = (x1 , , xm) +

уравнение множественной регрессии,

где случайный фактор (остаток),

обусловленный многими причинами.

В зависимости от вида функции (x) модели

делятся на линейные и нелинейные.

11

12. Причины обязательного присутствия случайного фактора

1.2.

3.

4.

5.

6.

Невключение в модель всех объясняющих

переменных.

Неправильный выбор функциональной формы

модели.

Агрегирование переменных (факторы

представляют собой комбинацию других

переменных).

Ошибки измерений.

Ограниченность статистических данных.

Непредсказуемость человеческого фактора.

12

13. Этапы построения качественного уравнения регрессии

1.Определение конечных целей эконометрического

моделирования, набора участвующих в модели

факторов и их роли (постановочный этап).

2. Предмодельный анализ экономической

сущности изучаемого явления (априорный этап).

3. Сбор необходимой статистической информации

(информационный этап).

13

14. Этапы построения качественного уравнения регрессии

4. Выбор формулы уравнения регрессии(спецификация уравнения регрессии).

5. Определение параметров выбранного уравнения

(параметризация).

6. Анализ качества уравнения и проверка его

адекватности эмпирическим данным,

совершенствование уравнения (верификация).

14

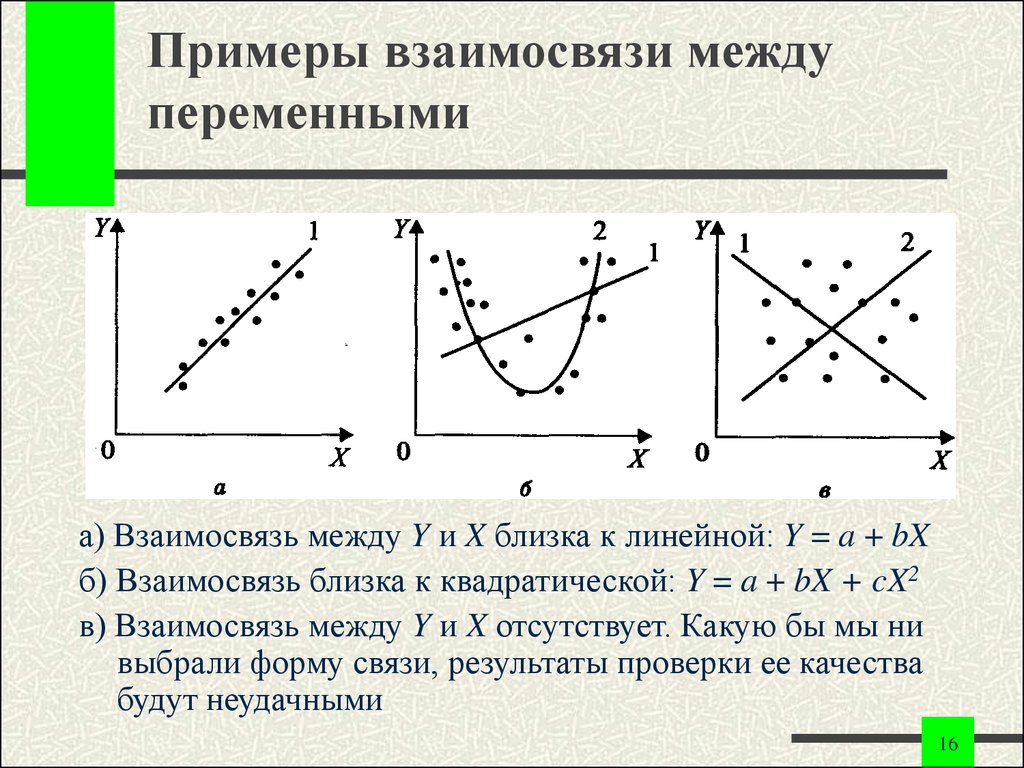

15. Выбор формы парной регрессии

В случае парной регрессии выбор формулыобычно осуществляется по графическому

изображению реальных статистических

данных в виде точек (корреляционное

поле или диаграмма рассеивания).

15

16. Примеры взаимосвязи между переменными

а) Взаимосвязь между Y и X близка к линейной: Y = a + bXб) Взаимосвязь близка к квадратической: Y = a + bX + cX2

в) Взаимосвязь между Y и X отсутствует. Какую бы мы ни

выбрали форму связи, результаты проверки ее качества

будут неудачными

16

17. Парная линейная регрессия

Модель линейной регрессии являетсянаиболее распространенной (и простой)

зависимостью между переменными, а также

может служить начальной точкой

эконометрического анализа.

17

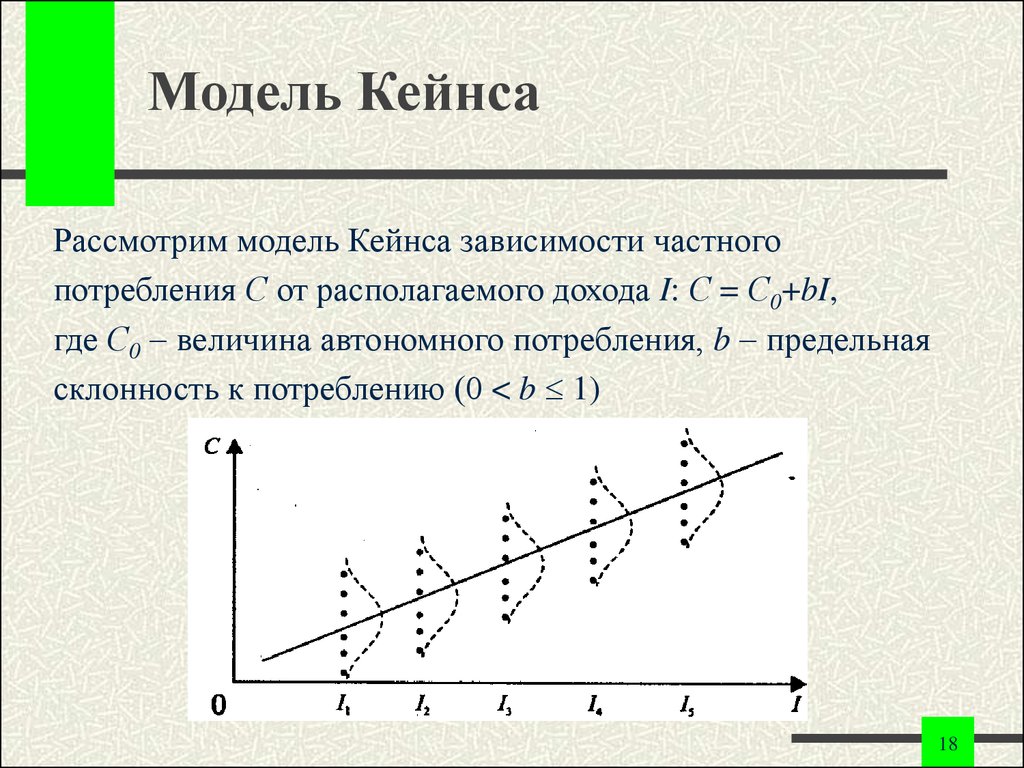

18. Модель Кейнса

Рассмотрим модель Кейнса зависимости частногопотребления С от располагаемого дохода I: С = С0+bI,

где С0 величина автономного потребления, b предельная

склонность к потреблению (0 < b 1)

18

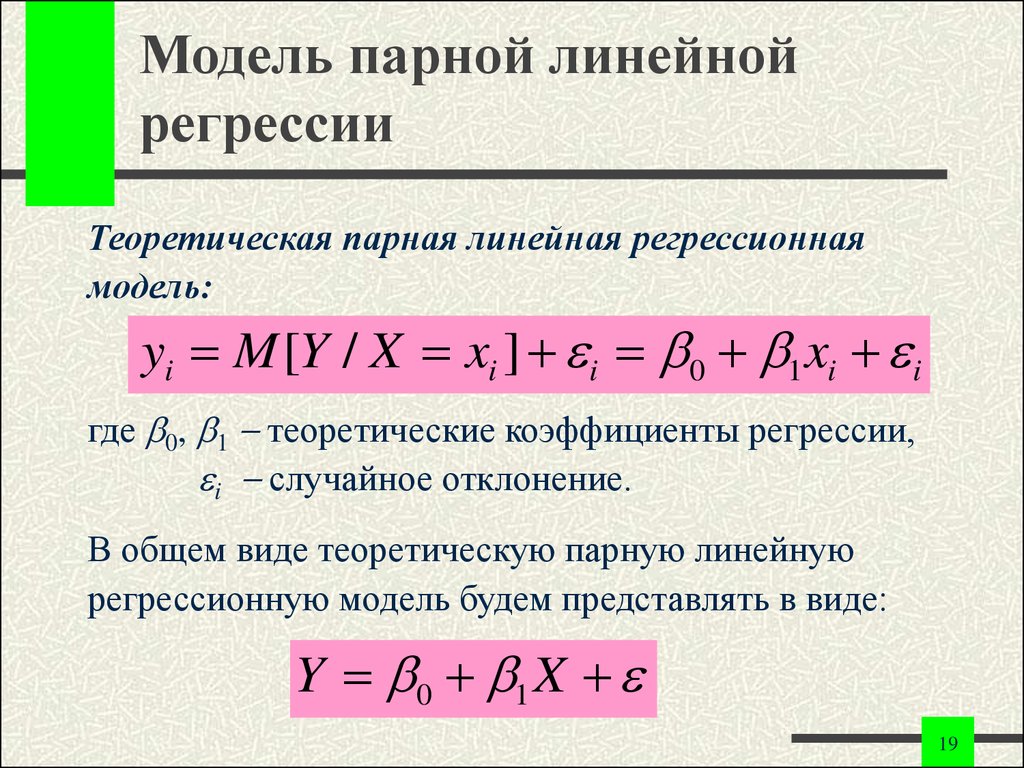

19. Модель парной линейной регрессии

Теоретическая парная линейная регрессионнаямодель:

yi M [Y / X xi ] i 0 1 xi i

где 0, 1 теоретические коэффициенты регрессии,

i случайное отклонение.

В общем виде теоретическую парную линейную

регрессионную модель будем представлять в виде:

Y 0 1 X

19

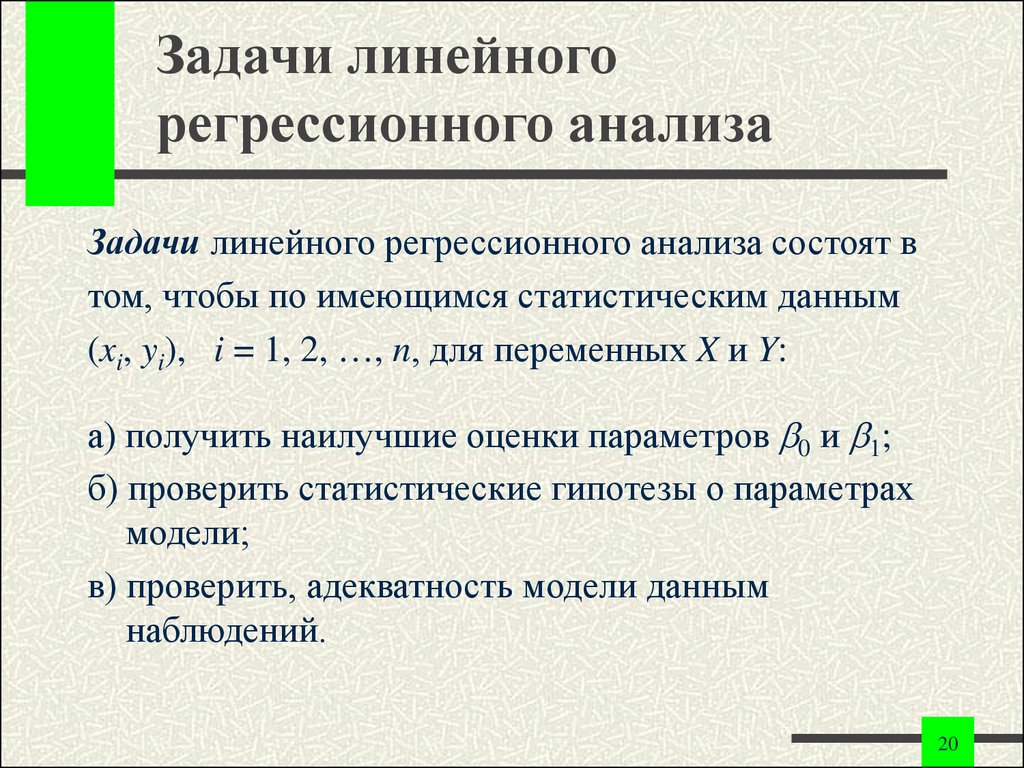

20. Задачи линейного регрессионного анализа

Задачи линейного регрессионного анализа состоят втом, чтобы по имеющимся статистическим данным

(xi, yi), i = 1, 2, , n, для переменных X и Y:

а) получить наилучшие оценки параметров 0 и 1;

б) проверить статистические гипотезы о параметрах

модели;

в) проверить, адекватность модели данным

наблюдений.

20

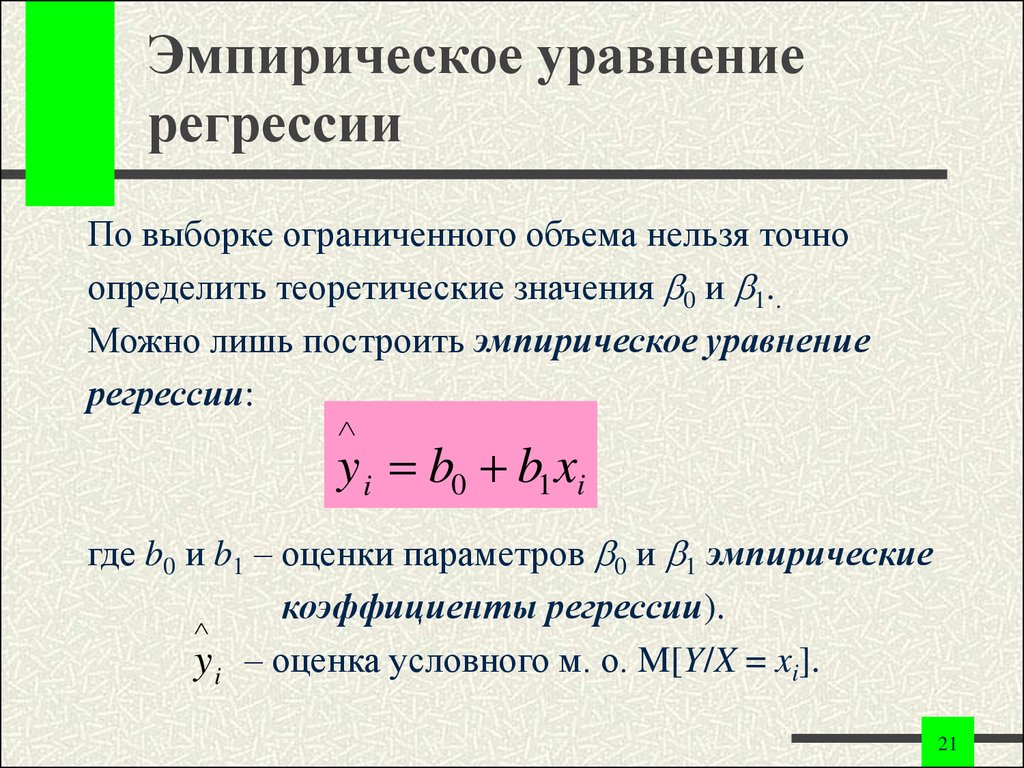

21. Эмпирическое уравнение регрессии

По выборке ограниченного объема нельзя точноопределить теоретические значения 0 и 1..

Можно лишь построить эмпирическое уравнение

регрессии:

y i b0 b1 xi

где b0 и b1 – оценки параметров 0 и 1 эмпирические

коэффициенты регрессии).

y i – оценка условного м. о. M[Y/X = xi].

21

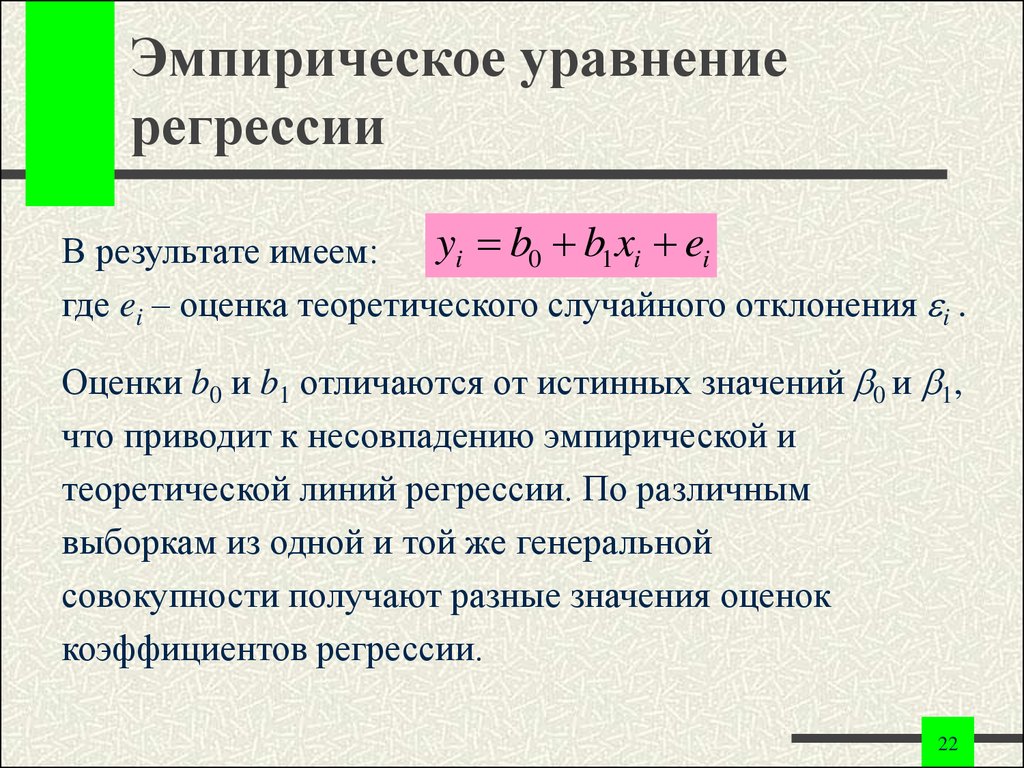

22. Эмпирическое уравнение регрессии

yi b0 b1 xi eiВ результате имеем:

где ei – оценка теоретического случайного отклонения i .

Оценки b0 и b1 отличаются от истинных значений 0 и 1,

что приводит к несовпадению эмпирической и

теоретической линий регрессии. По различным

выборкам из одной и той же генеральной

совокупности получают разные значения оценок

коэффициентов регрессии.

22

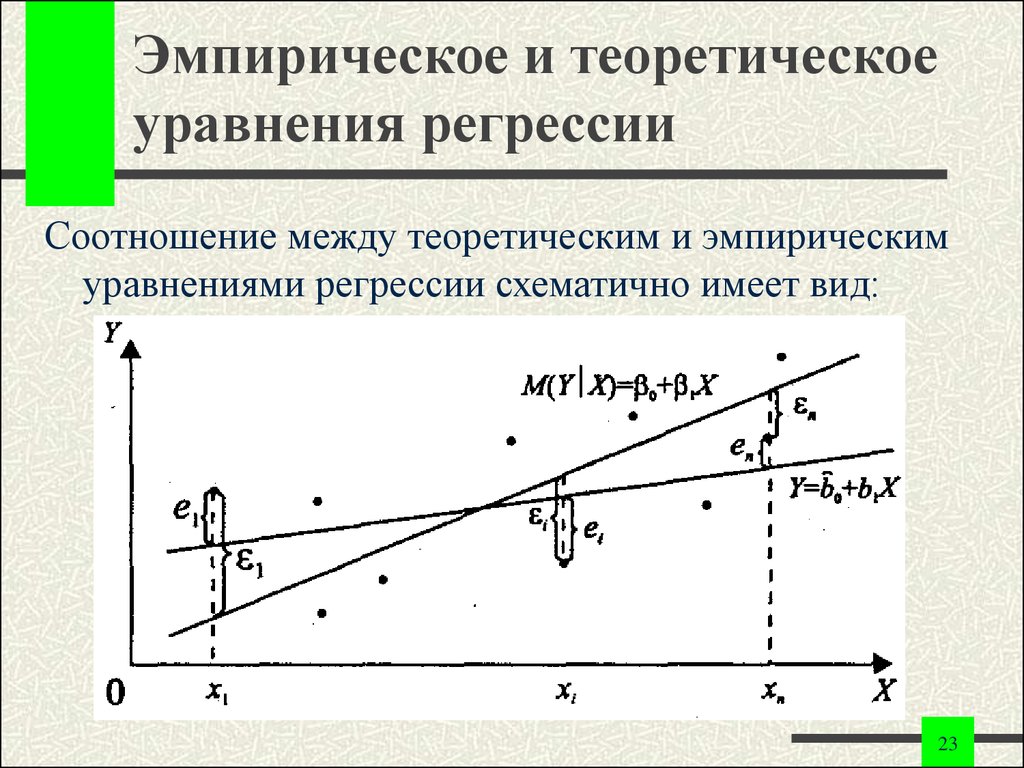

23. Эмпирическое и теоретическое уравнения регрессии

Соотношение между теоретическим и эмпирическимуравнениями регрессии схематично имеет вид:

23

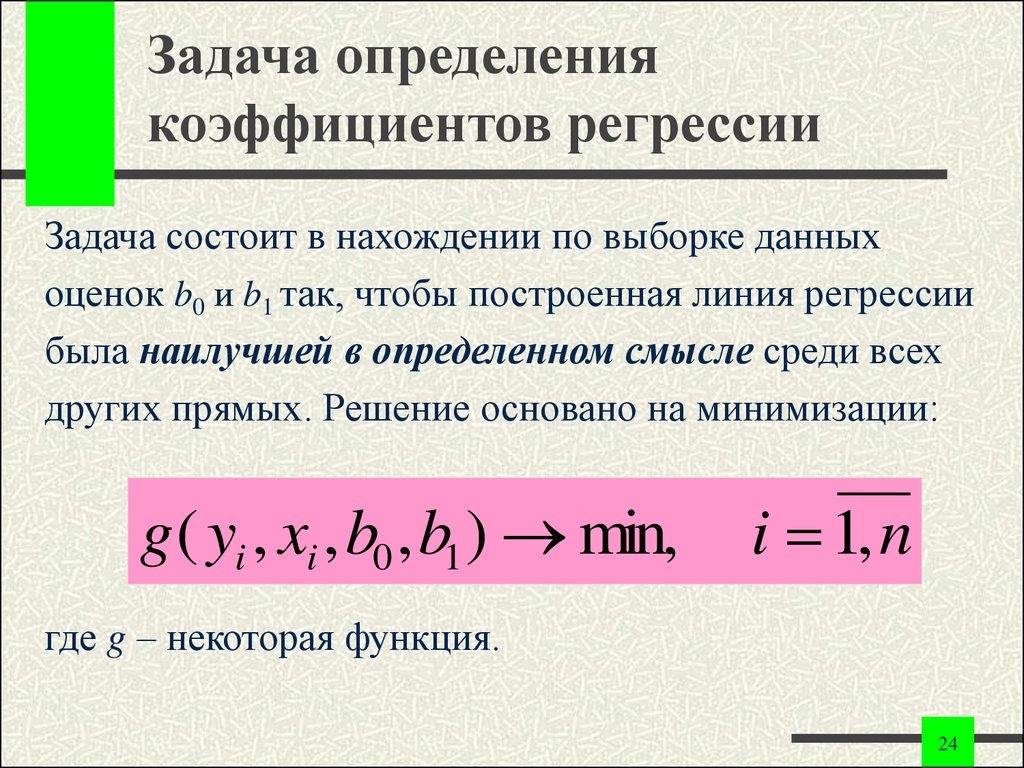

24. Задача определения коэффициентов регрессии

Задача состоит в нахождении по выборке данныхоценок b0 и b1 так, чтобы построенная линия регрессии

была наилучшей в определенном смысле среди всех

других прямых. Решение основано на минимизации:

g ( yi , xi , b0 , b1 ) min,

i 1, n

где g – некоторая функция.

24

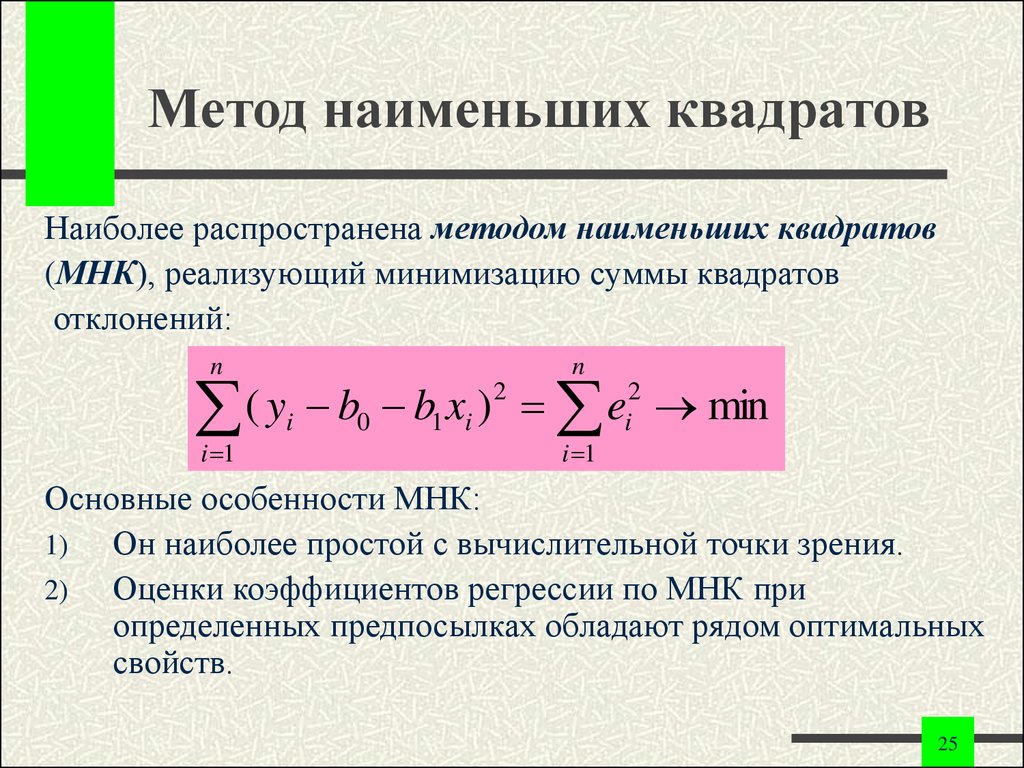

25. Метод наименьших квадратов

Наиболее распространена методом наименьших квадратов(МНК), реализующий минимизацию суммы квадратов

отклонений:

n

n

i 1

i 1

2

2

(

y

b

b

x

)

e

i 0 1 i i min

Основные особенности МНК:

1)

Он наиболее простой с вычислительной точки зрения.

2)

Оценки коэффициентов регрессии по МНК при

определенных предпосылках обладают рядом оптимальных

свойств.

25

26. Метод наименьших квадратов

Пусть по выборке данных (xi, yi), i = 1, 2, , n,требуется определить оценки b0 и b1 эмпирического

уравнения регрессии:

26

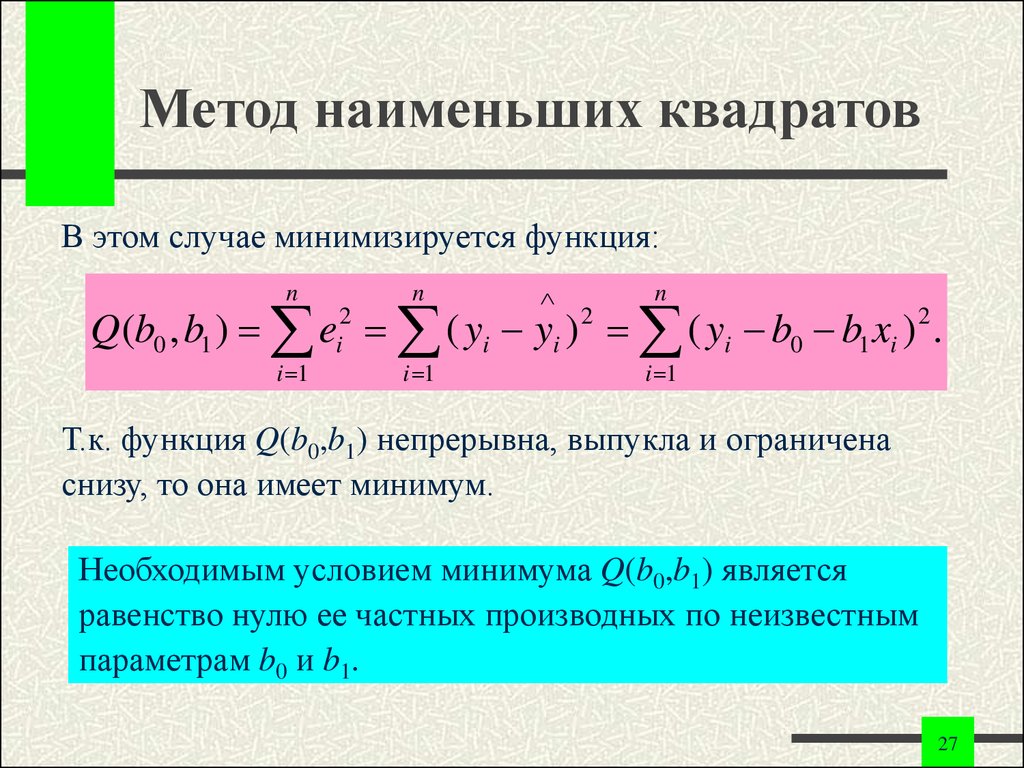

27. Метод наименьших квадратов

В этом случае минимизируется функция:n

n

n

Q(b0 , b1 ) e ( yi yi ) ( yi b0 b1 xi ) .

i 1

2

i

i 1

2

2

i 1

Т.к. функция Q(b0,b1) непрерывна, выпукла и ограничена

снизу, то она имеет минимум.

Необходимым условием минимума Q(b0,b1) является

равенство нулю ее частных производных по неизвестным

параметрам b0 и b1.

27

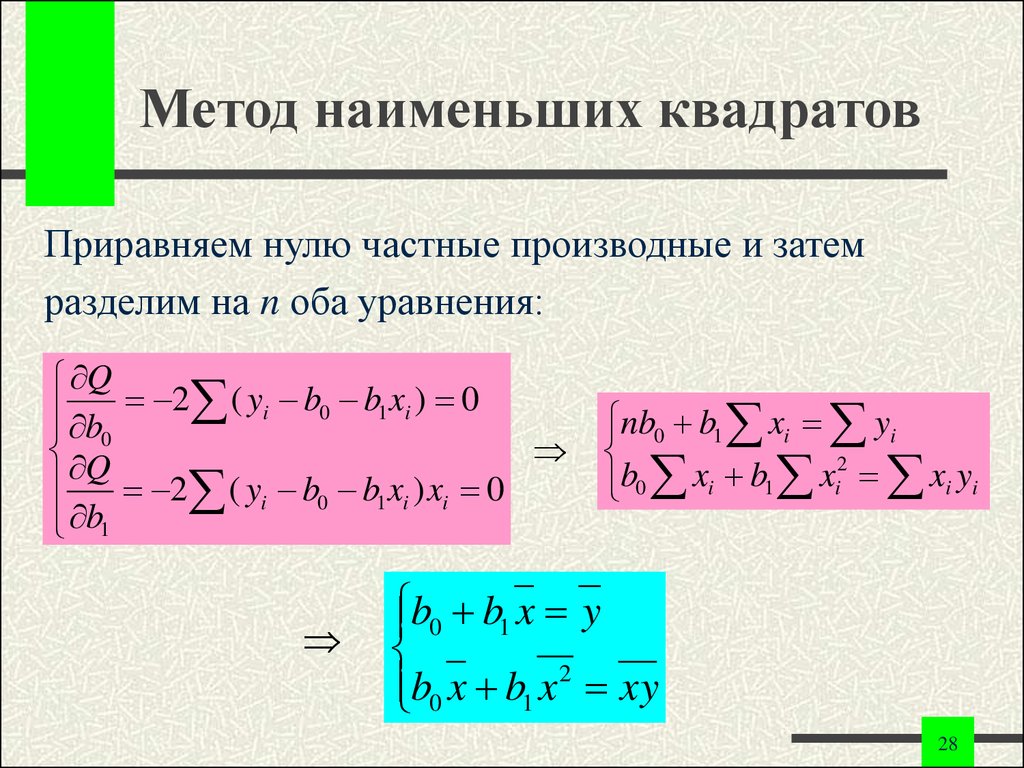

28. Метод наименьших квадратов

Приравняем нулю частные производные и затемразделим на n оба уравнения:

Q

b 2 ( yi b0 b1 xi ) 0

0

Q

2 ( yi b0 b1 xi ) xi 0

b1

nb0 b1 xi yi

2

b

x

b

x

0 i 1 i xi yi

b0 b1 x y

2

b0 x b1 x xy

28

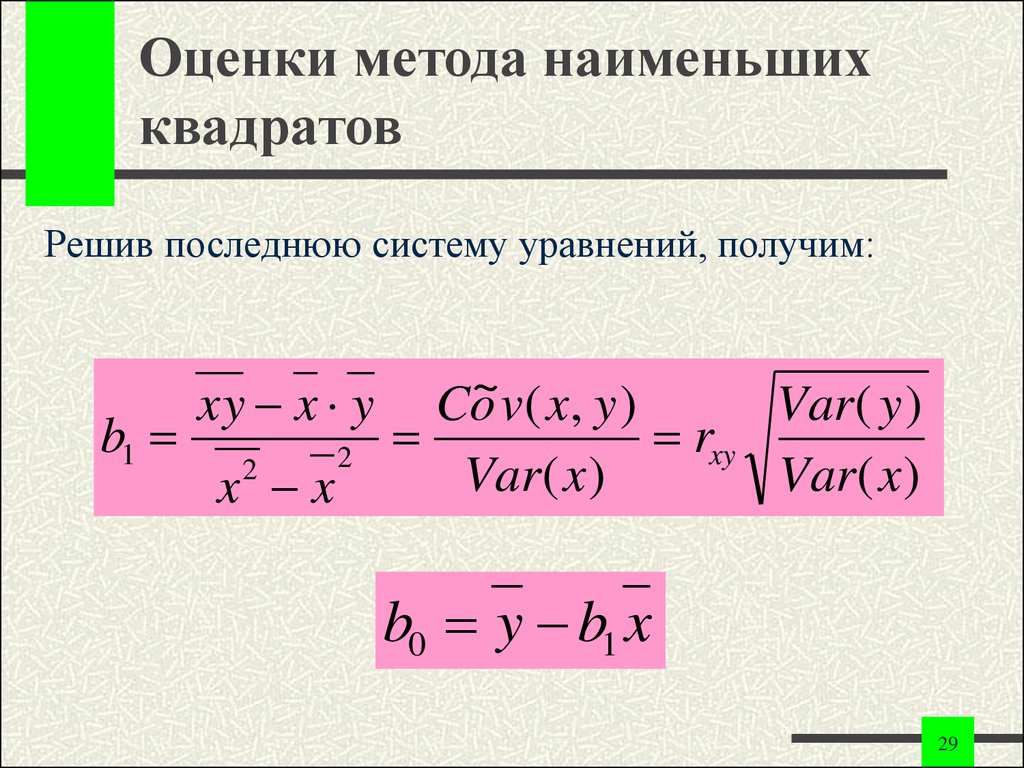

29. Оценки метода наименьших квадратов

Решив последнюю систему уравнений, получим:b1

xy x y

x x

2

2

Co~v ( x, y )

Var( y )

rxy

Var( x )

Var( x )

b0 y b1 x

29

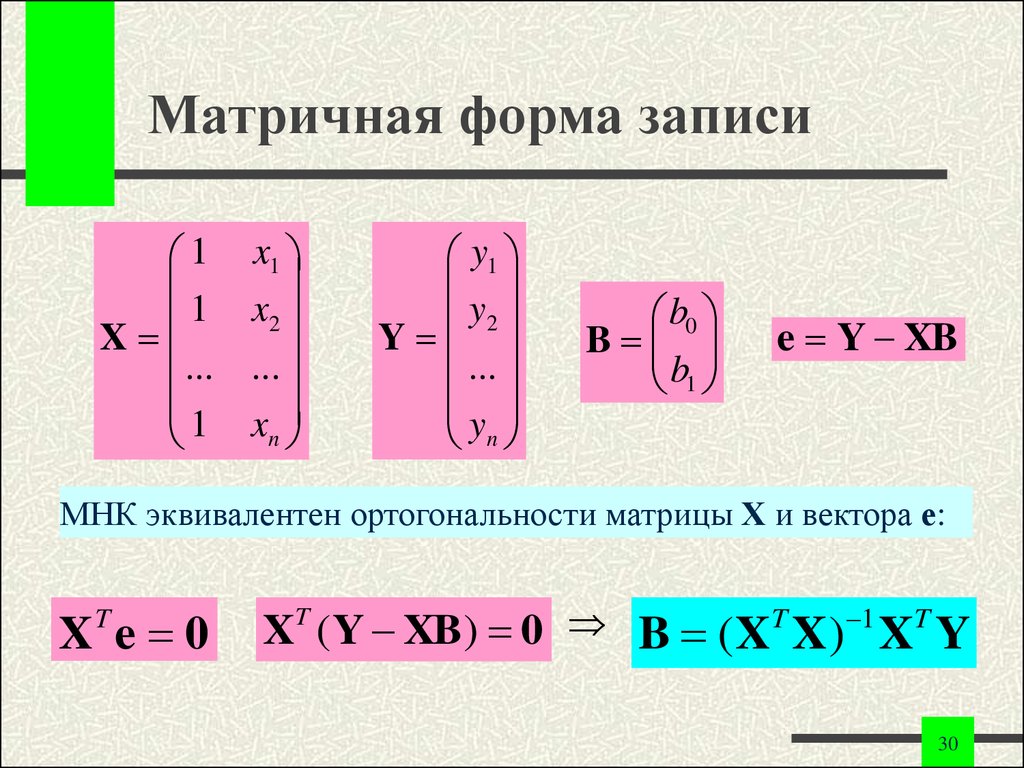

30. Матричная форма записи

1 x11 x2

X

... ...

1 xn

y1

y2

Y

...

yn

b0

B

b1

e Y XB

МНК эквивалентен ортогональности матрицы Х и вектора е:

X e 0

T

X (Y XB) 0 B ( XT X ) 1 XT Y

T

30

31. Выводы

1.Оценки МНК являются функциями от выборки,

что позволяет их легко рассчитать.

2.

Оценки МНК являются точечными оценками

теоретических коэффициентов регрессии.

3.

Эмпирическая прямая регрессии обязательно

проходит через точку ( x, y ).

31

32. Выводы

4.Эмпирическое уравнение регрессии

построено так, что ei 0, e 0.

5.

Случайные отклонения ei не

коррелированы с наблюдаемыми

значениями yi зависимой переменной Y.

6.

Случайные отклонения ei не

коррелированы с наблюдаемыми

значениями xi независимой переменной X.

32

33. Другие методы определения коэффициентов регрессии

Другие методы определения коэффициентоврегрессии:

метод наименьших модулей (МНМ),

метод моментов (ММ),

метод максимального правдоподобия (ММП).

33

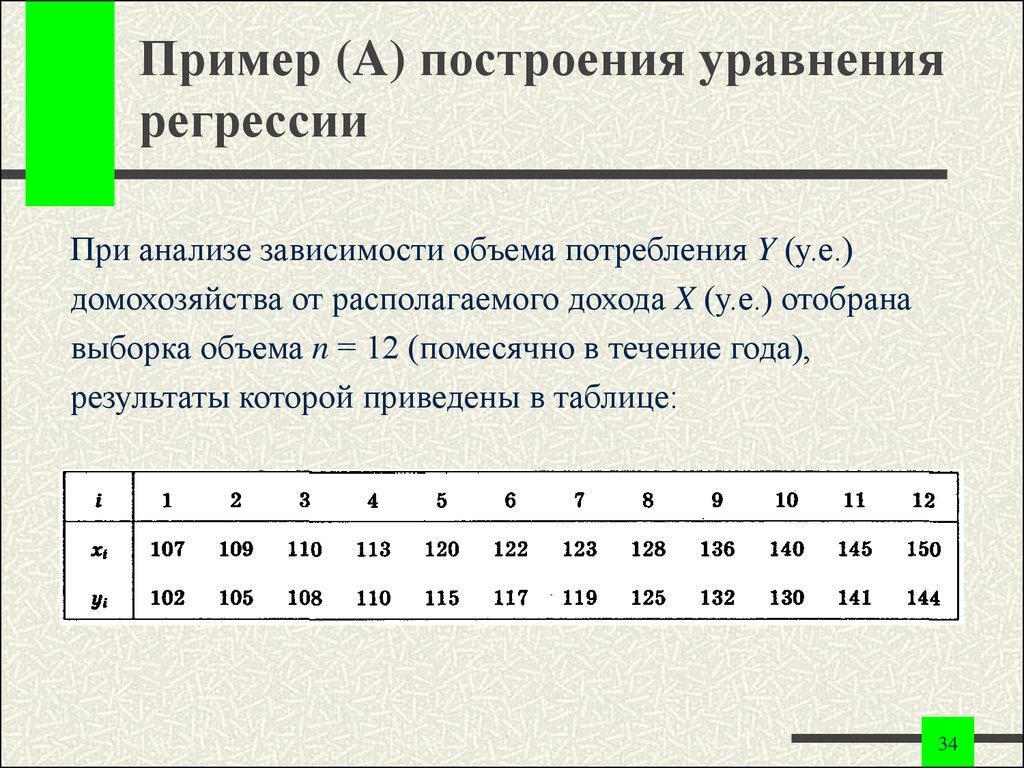

34. Пример (A) построения уравнения регрессии

При анализе зависимости объема потребления Y (у.е.)домохозяйства от располагаемого дохода X (у.е.) отобрана

выборка объема n = 12 (помесячно в течение года),

результаты которой приведены в таблице:

34

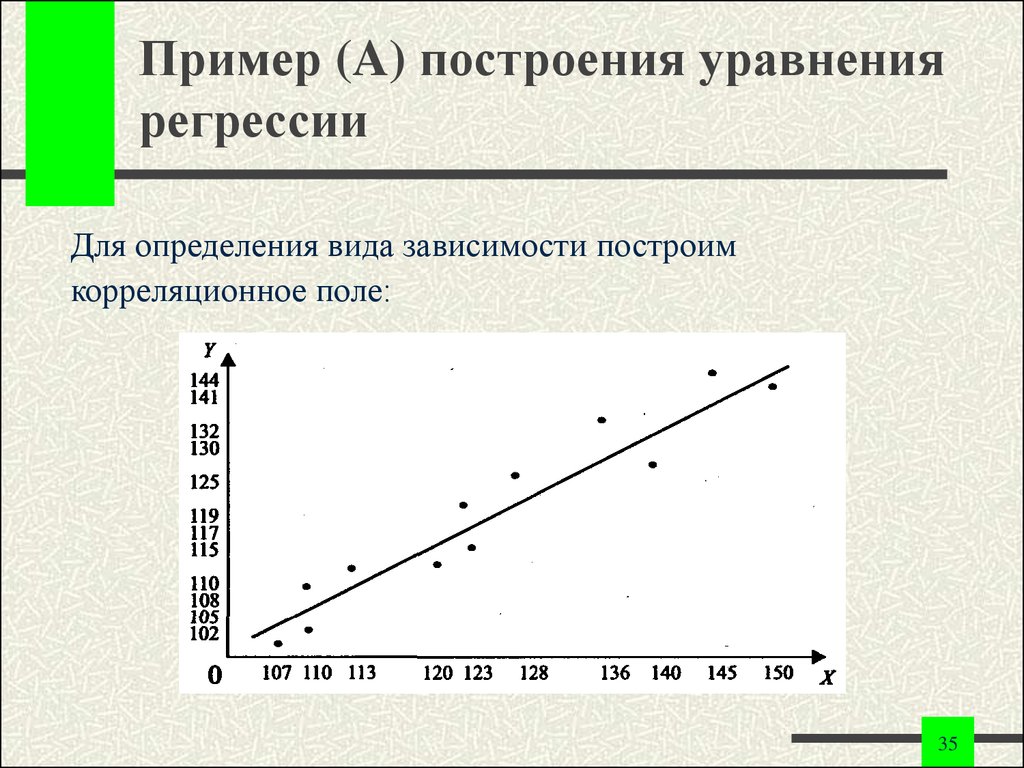

35. Пример (A) построения уравнения регрессии

Для определения вида зависимости построимкорреляционное поле:

35

36. Пример (A) построения уравнения регрессии

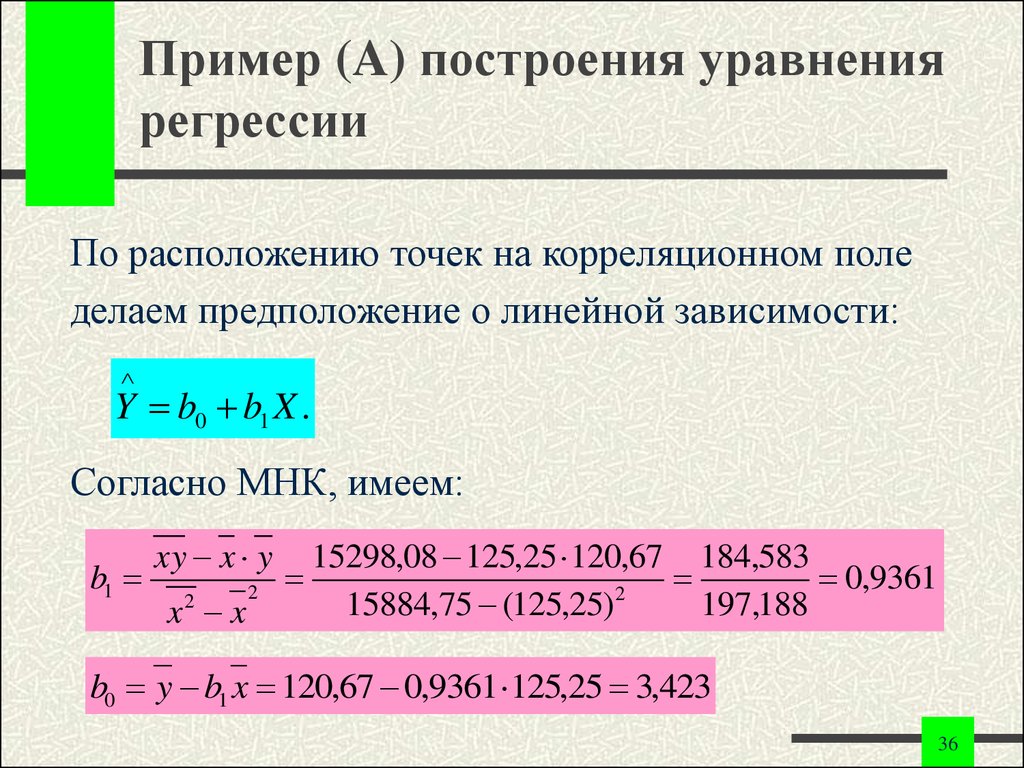

По расположению точек на корреляционном поледелаем предположение о линейной зависимости:

Y b0 b1 X .

Согласно МНК, имеем:

b1

xy x y

x x

2

2

15298,08 125,25 120,67 184,583

0,9361

2

15884,75 (125,25)

197,188

b0 y b1 x 120,67 0,9361 125,25 3,423

36

37. Пример (A) построения уравнения регрессии

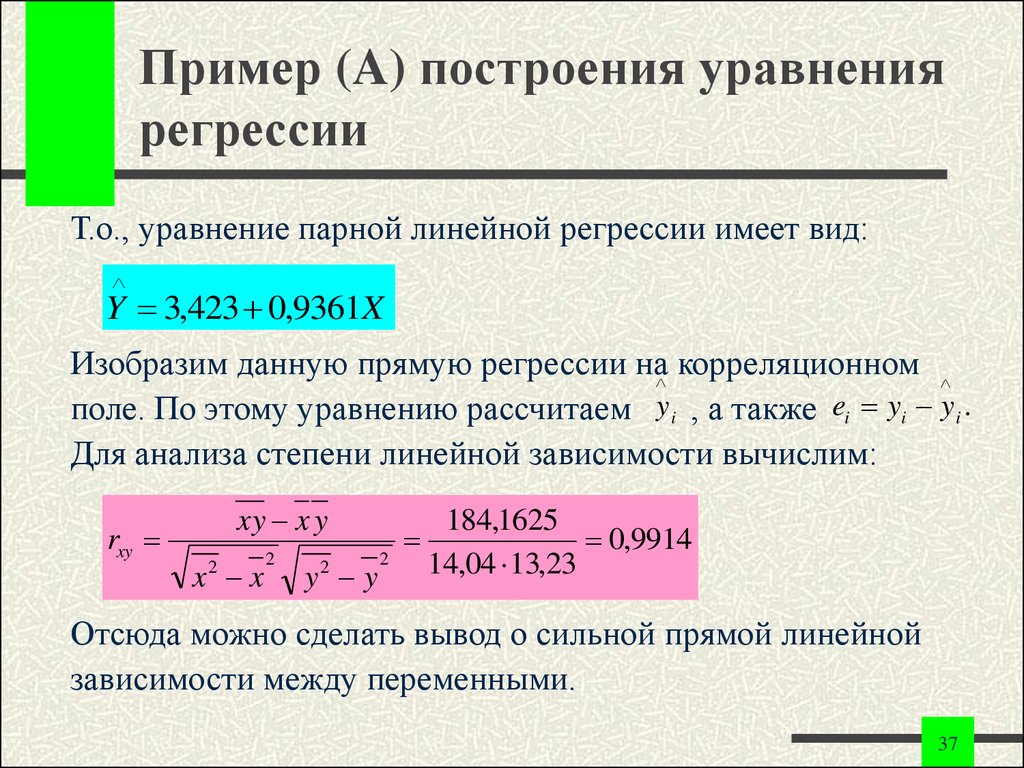

Т.о., уравнение парной линейной регрессии имеет вид:Y 3,423 0,9361X

Изобразим данную прямую регрессии на корреляционном

поле. По этому уравнению рассчитаем y i , а также ei yi y i .

Для анализа степени линейной зависимости вычислим:

rxy

xy x y

x x

2

2

y y

2

2

184,1625

0,9914

14,04 13,23

Отсюда можно сделать вывод о сильной прямой линейной

зависимости между переменными.

37

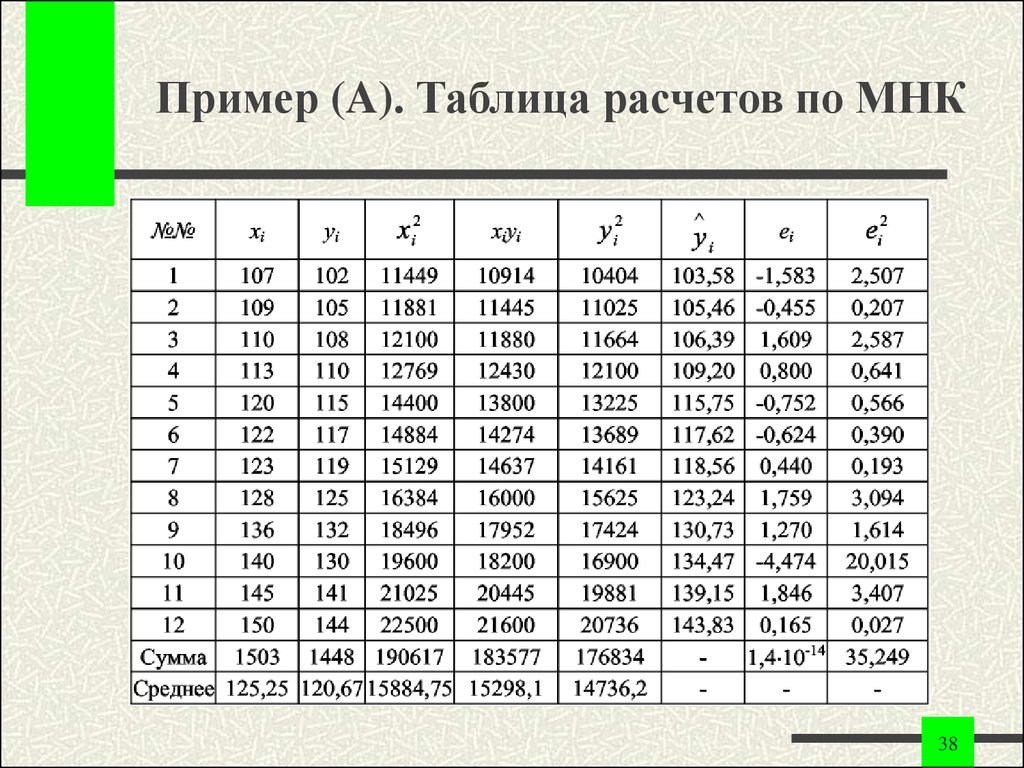

38. Пример (A). Таблица расчетов по МНК

3839.

Конец лекции39

mathematics

mathematics