Similar presentations:

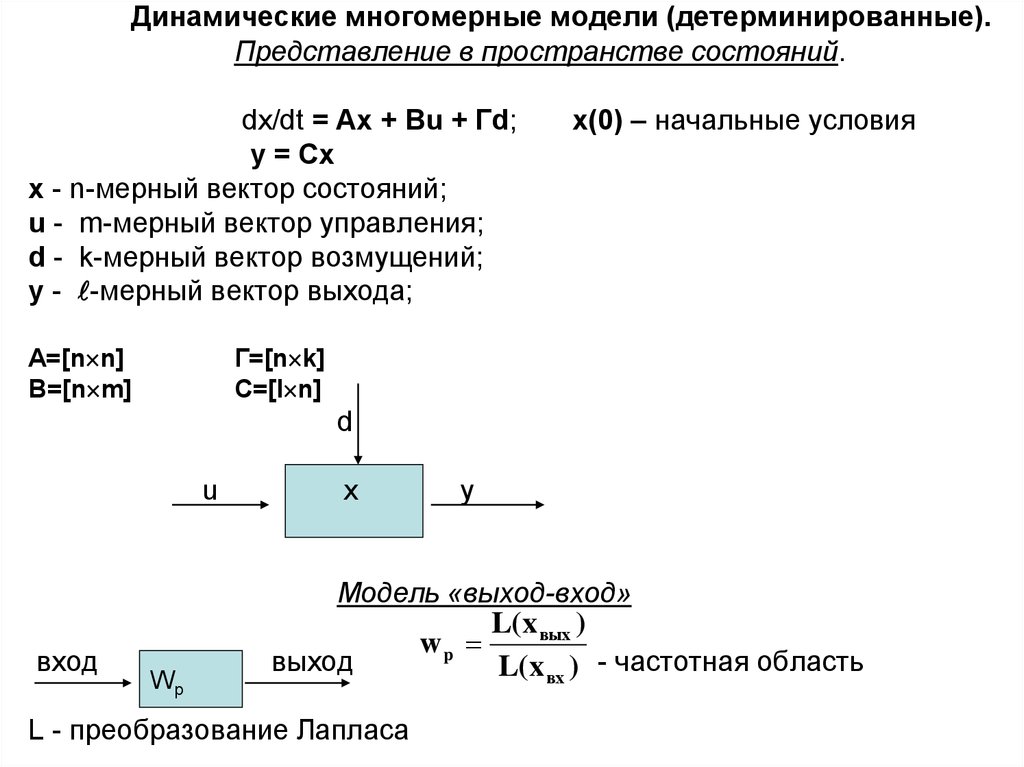

Динамические многомерные модели (детерминированные)

1. Динамические многомерные модели (детерминированные). Представление в пространстве состояний. dx/dt = Ax + Bu + Гd; x(0) –

Динамические многомерные модели (детерминированные).Представление в пространстве состояний.

dx/dt = Ax + Bu + Гd;

y = Cx

x - n-мерный вектор состояний;

u - m-мерный вектор управления;

d - k-мерный вектор возмущений;

y - -мерный вектор выхода;

А=[n n]

В=[n m]

x(0) – начальные условия

Г=[n k]

С=[l n]

d

u

x

y

Модель «выход-вход»

вход

Wp

выход

L - преобразование Лапласа

wp

L( x вых )

L( x вх ) - частотная область

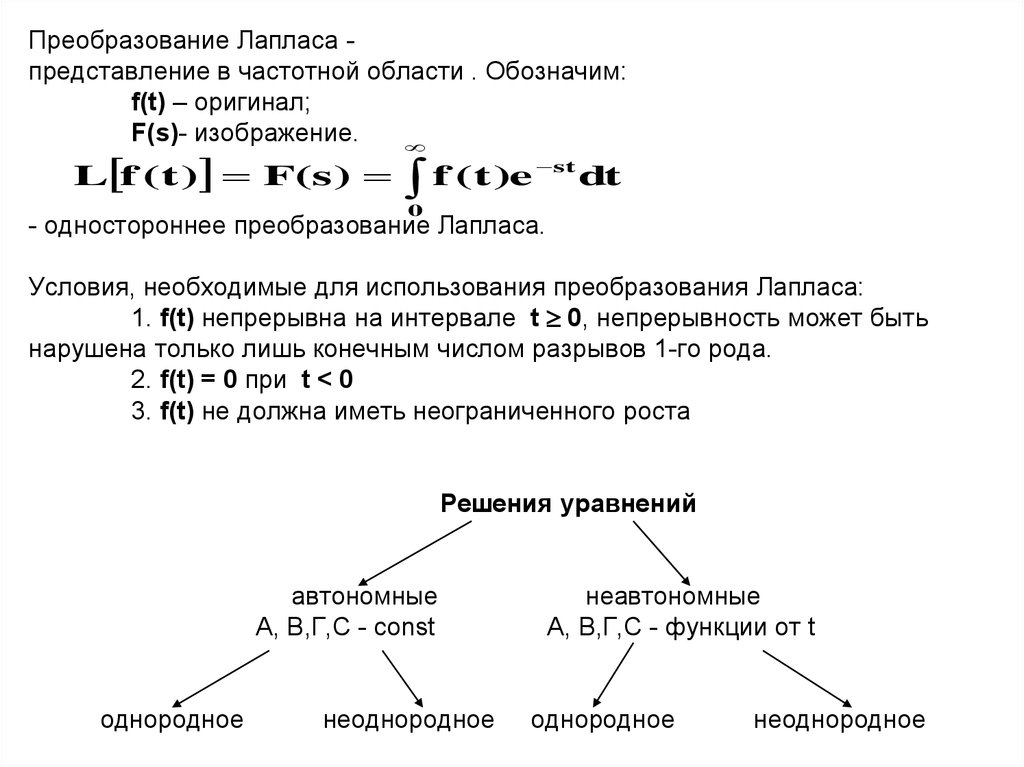

2. Преобразование Лапласа - представление в частотной области . Обозначим: f(t) – оригинал; F(s)- изображение. - одностороннее

Преобразование Лапласа представление в частотной области . Обозначим:f(t) – оригинал;

F(s)- изображение.

L f ( t ) F(s )

st

f

(

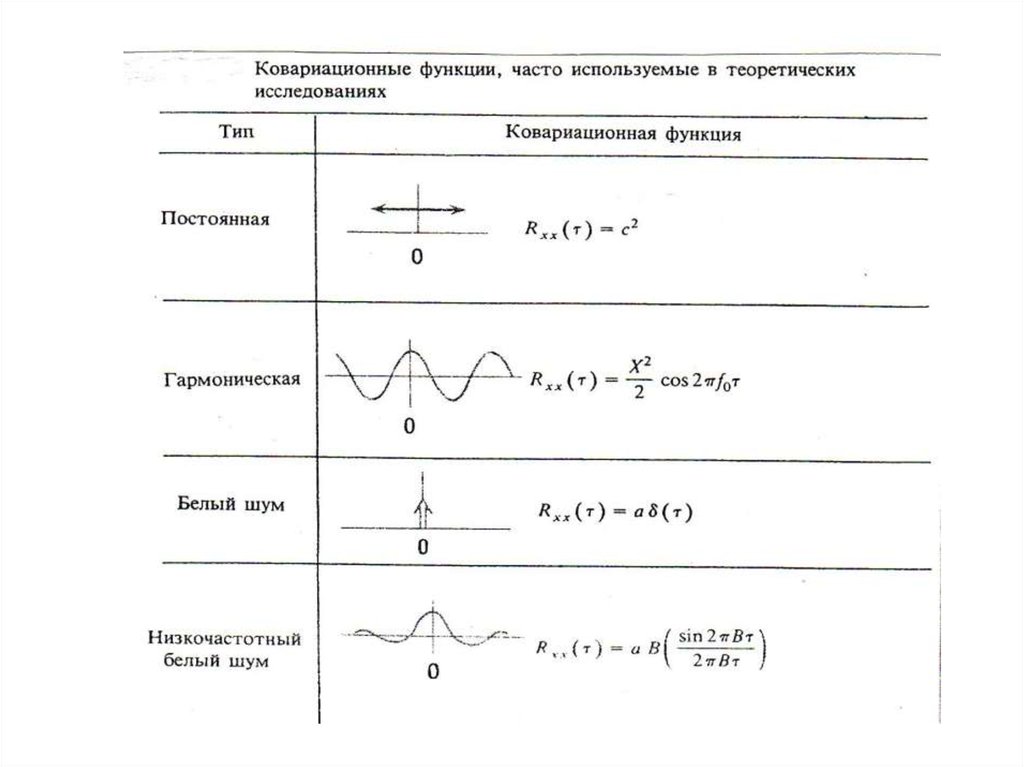

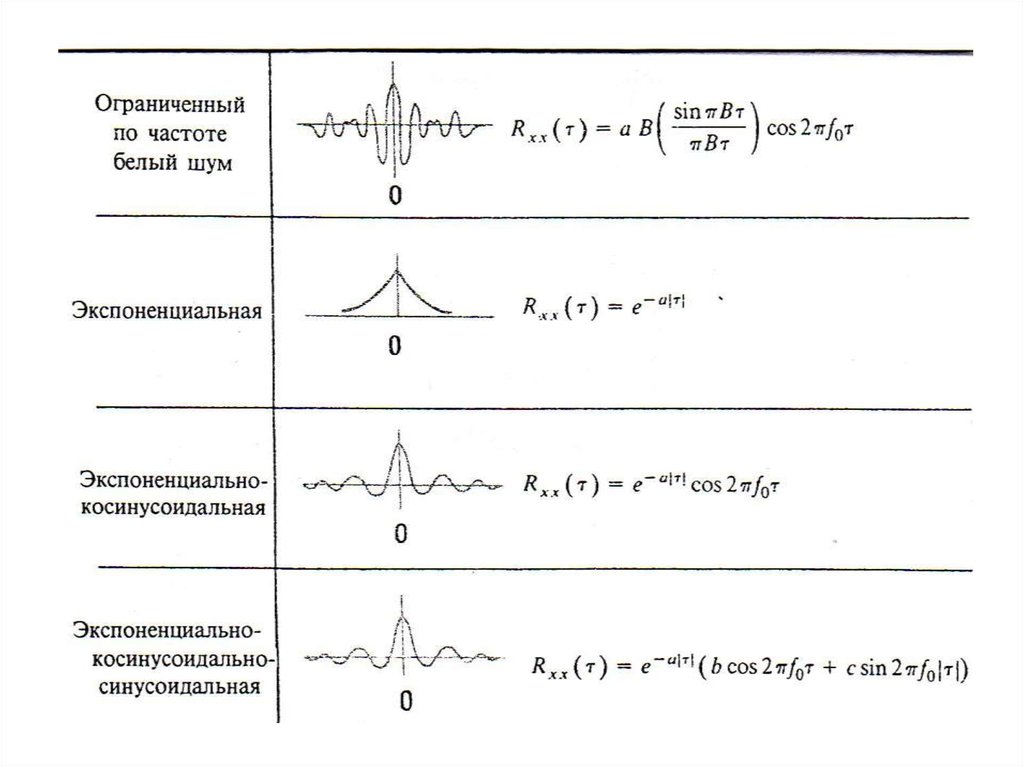

t

)

e

dt

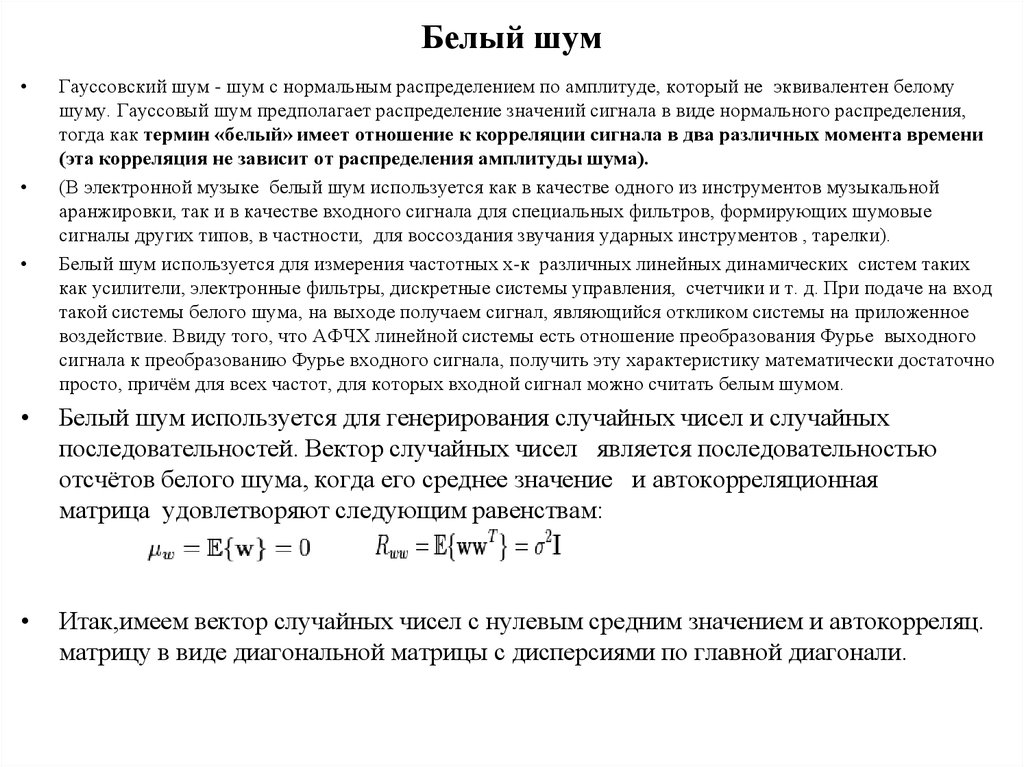

0

- одностороннее преобразование Лапласа.

Условия, необходимые для использования преобразования Лапласа:

1. f(t) непрерывна на интервале t 0, непрерывность может быть

нарушена только лишь конечным числом разрывов 1-го рода.

2. f(t) = 0 при t < 0

3. f(t) не должна иметь неограниченного роста

Решения уравнений

автономные

А, В,Г,С - const

однородное

неоднородное

неавтономные

А, В,Г,С - функции от t

однородное

неоднородное

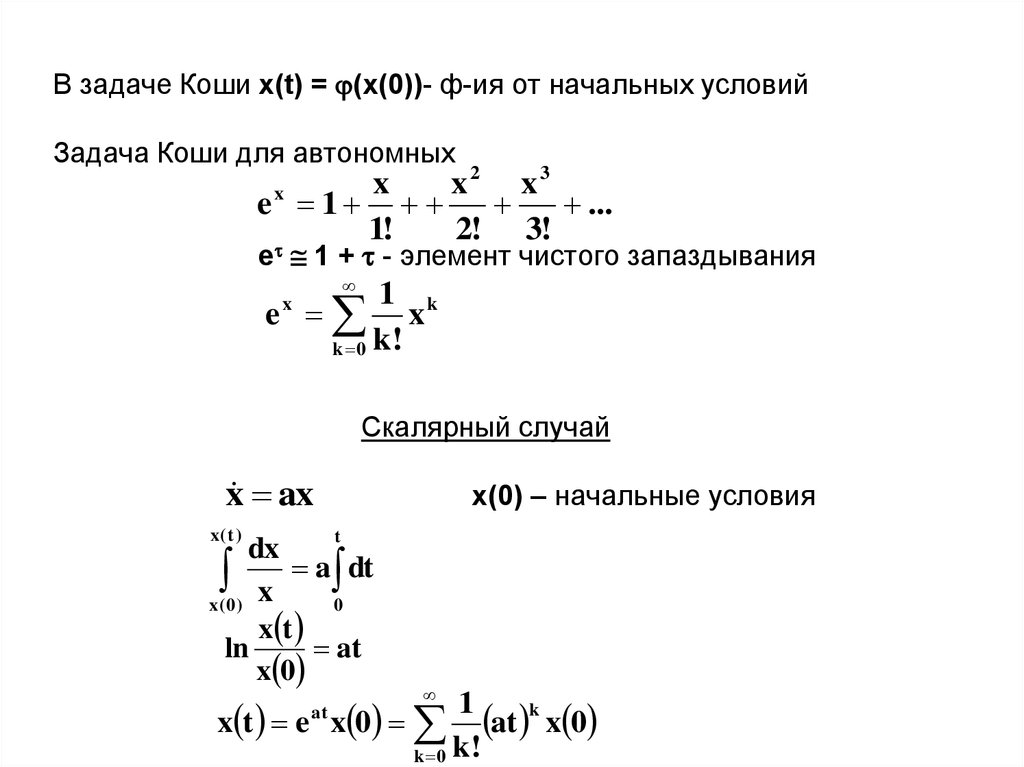

3. В задаче Коши x(t) = (x(0))- ф-ия от начальных условий Задача Коши для автономных e 1 + - элемент чистого запаздывания

В задаче Коши x(t) = (x(0))- ф-ия от начальных условийЗадача Коши для автономных

2

3

x

x

x

ex 1

...

1!

2! 3!

e 1 + - элемент чистого запаздывания

1 k

e x

k 0 k!

x

Скалярный случай

x ax

x( t )

x(0) – начальные условия

t

dx

a dt

x

x( 0)

0

x t

ln

at

x 0

x t e x 0

at

1

at k x 0

k 0 k!

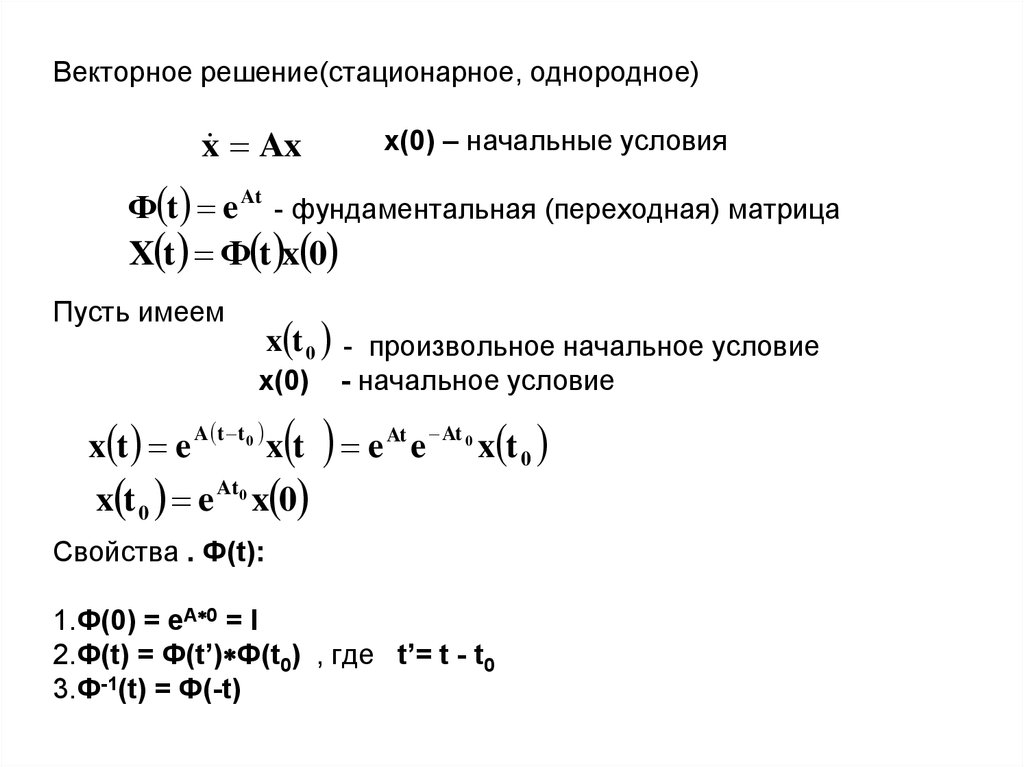

4. Векторное решение(стационарное, однородное) x(0) – начальные условия - фундаментальная (переходная) матрица Пусть имеем -

Векторное решение(стационарное, однородное)x Ax

x(0) – начальные условия

Ф t e At - фундаментальная (переходная) матрица

X t Ф t x 0

Пусть имеем

x t 0 - произвольное начальное условие

x(0)

x t e A t t 0 x t

x t 0 e At0 x 0

- начальное условие

e

At

e At 0 x t 0

Свойства . Ф(t):

1.Ф(0) = eA 0 = I

2.Ф(t) = Ф(t’) Ф(t0) , где t’= t - t0

3.Ф-1(t) = Ф(-t)

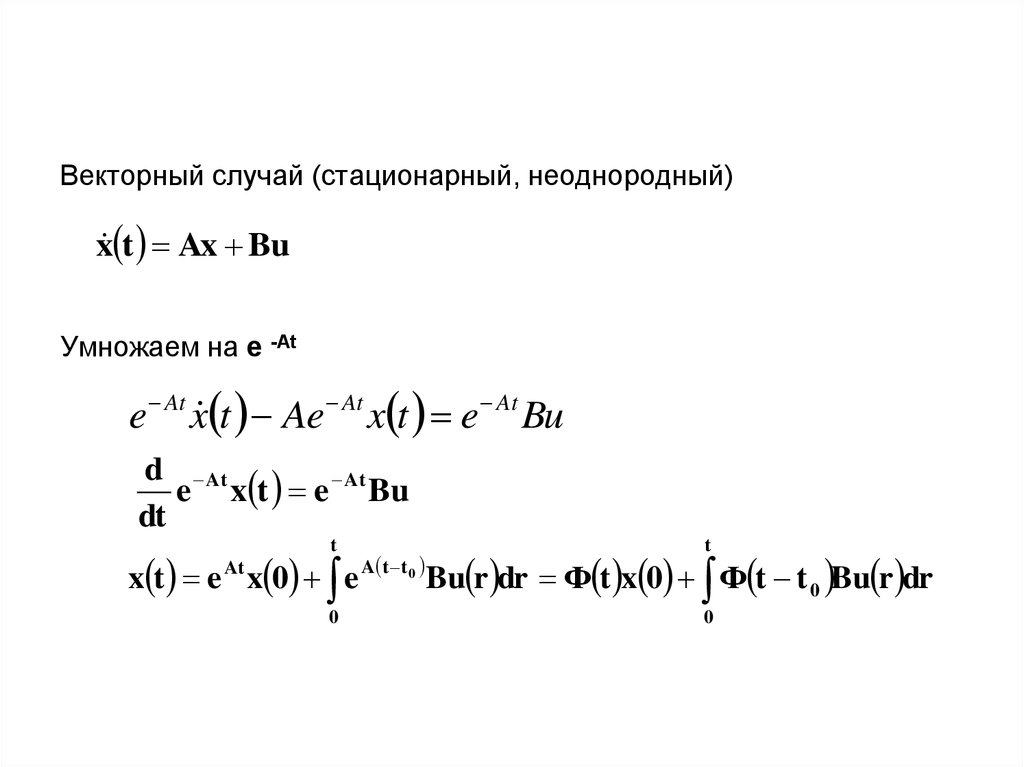

5. Векторный случай (стационарный, неоднородный) Умножаем на e -At

Векторный случай (стационарный, неоднородный)x t Ax Bu

Умножаем на e -At

e At x t Ae At x t e At Bu

d At

e x t e At Bu

dt

t

t

0

0

x t e At x 0 e A t t 0 Bu r dr Ф t x 0 Ф t t 0 Bu r dr

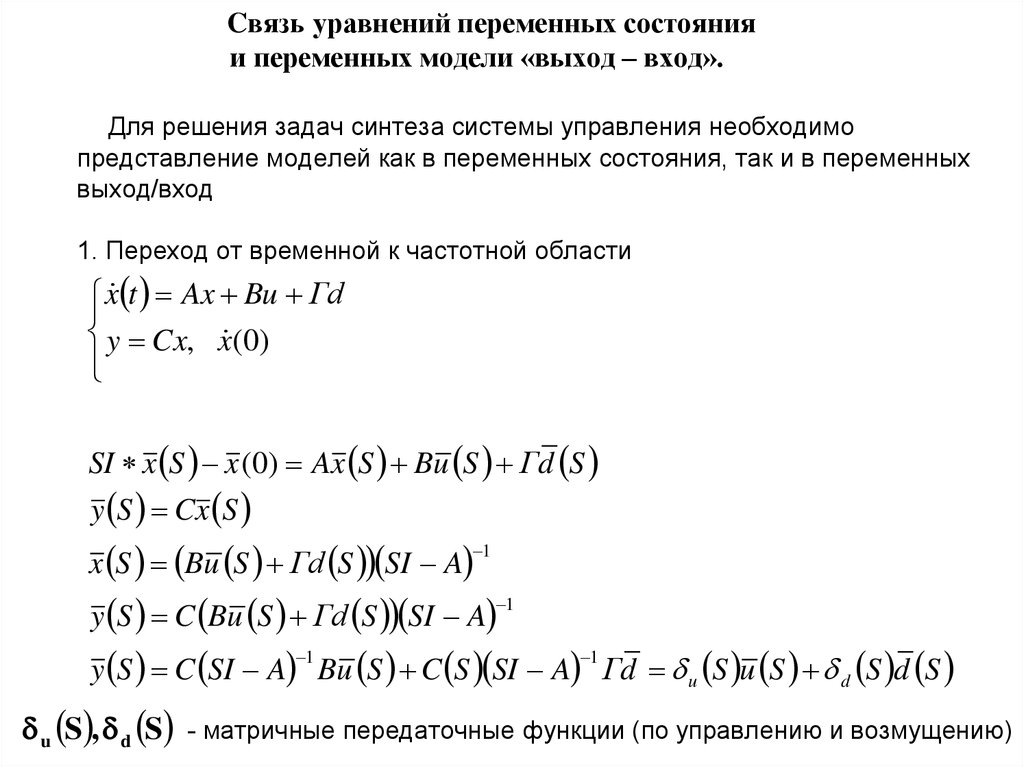

6. Cвязь уравнений переменных состояния и переменных модели «выход – вход». Для решения задач синтеза системы управления

необходимопредставление моделей как в переменных состояния, так и в переменных

выход/вход

1. Переход от временной к частотной области

x t Ax Bu Гd

y Cx, x (0)

SI x S x (0) Ax S Bu S Гd S

y S Cx S

x S Bu S Гd S SI A

1

y S C Bu S Гd S SI A

1

y S C SI A Bu S C S SI A Гd u S u S d S d S

1

1

u S , d S - матричные передаточные функции (по управлению и возмущению)

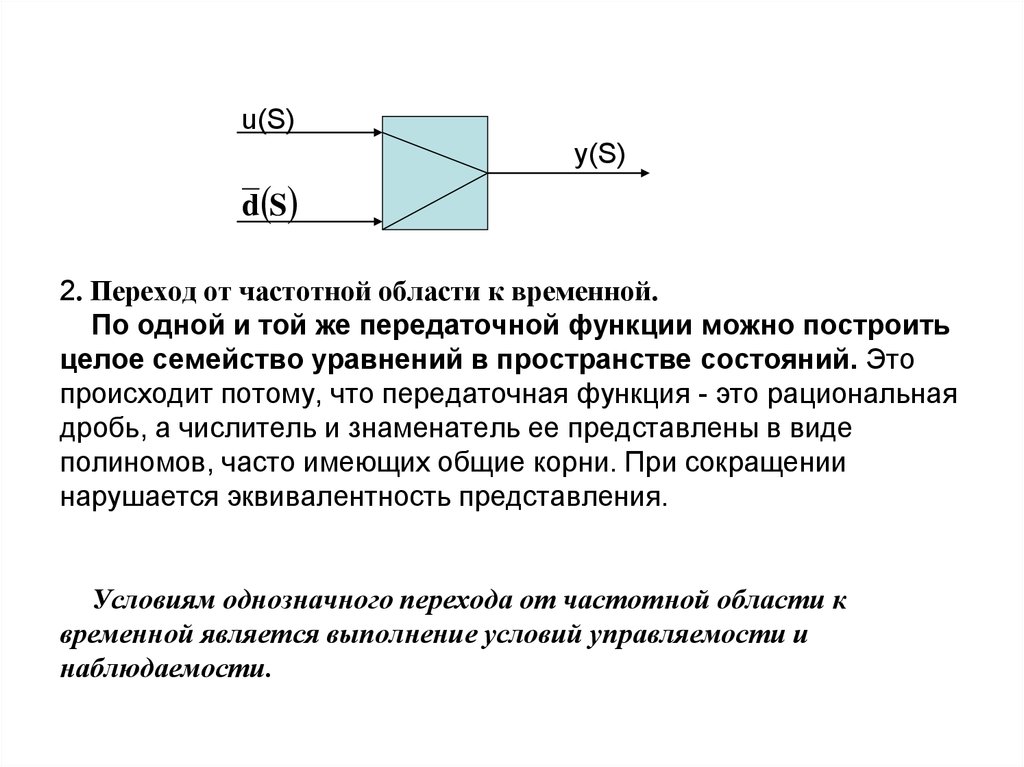

7. u(S) y(S) 2. Переход от частотной области к временной. По одной и той же передаточной функции можно построить целое семейство

u(S)y(S)

d S

2. Переход от частотной области к временной.

По одной и той же передаточной функции можно построить

целое семейство уравнений в пространстве состояний. Это

происходит потому, что передаточная функция - это рациональная

дробь, а числитель и знаменатель ее представлены в виде

полиномов, часто имеющих общие корни. При сокращении

нарушается эквивалентность представления.

Условиям однозначного перехода от частотной области к

временной является выполнение условий управляемости и

наблюдаемости.

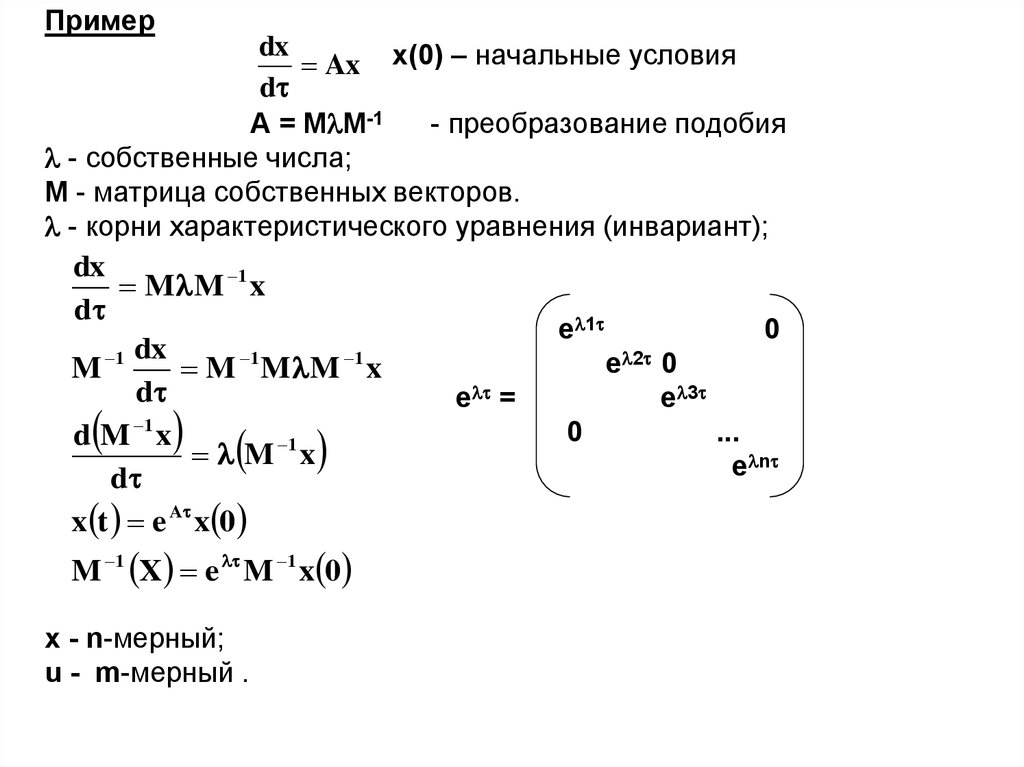

8. Пример x(0) – начальные условия A = MM-1 - преобразование подобия - собственные числа; M - матрица собственных векторов. -

Примерdx

Ax x(0) – начальные условия

d

A = M M-1

- преобразование подобия

- собственные числа;

M - матрица собственных векторов.

- корни характеристического уравнения (инвариант);

dx

M M 1 x

d

e 1

0

dx

e 2 0

M 1

M 1 M M 1 x

d

e =

e 3

0

...

d M 1 x

1

M x

e n

d

x t e A x 0

M 1 X e M 1 x 0

x - n-мерный;

u - m-мерный .

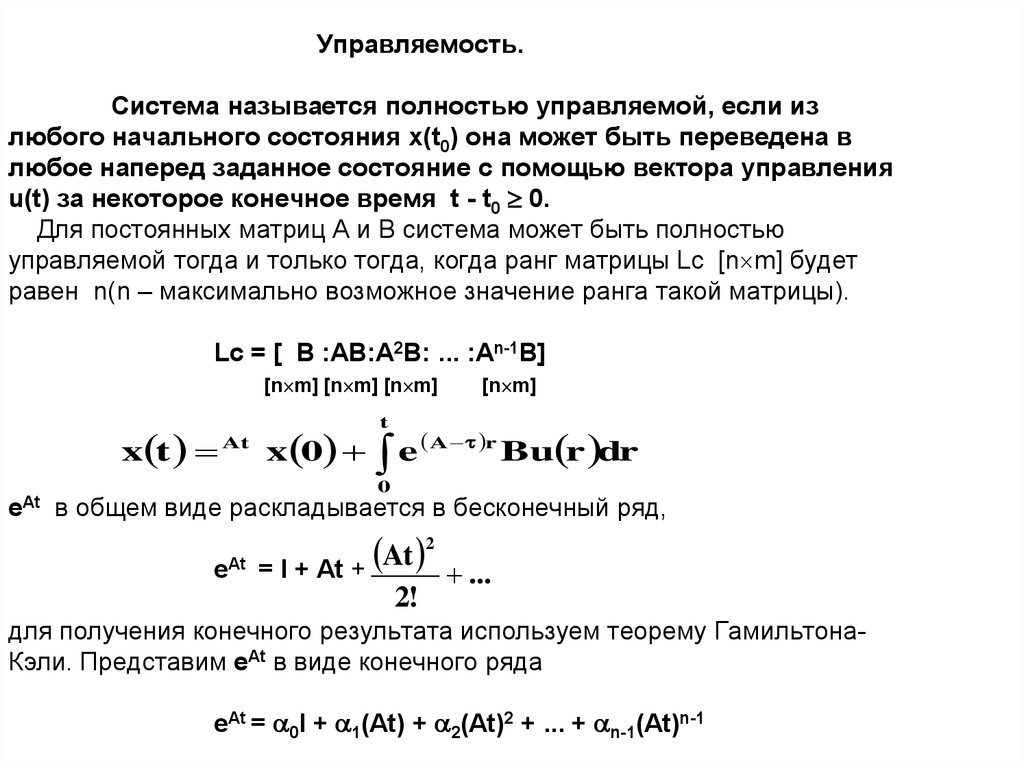

9. Управляемость. Система называется полностью управляемой, если из любого начального состояния x(t0) она может быть переведена в

любое наперед заданное состояние с помощью вектора управленияu(t) за некоторое конечное время t - t0 0.

Для постоянных матриц A и B система может быть полностью

управляемой тогда и только тогда, когда ранг матрицы Lc [n m] будет

равен n(n – максимально возможное значение ранга такой матрицы).

Lc = [ B :AB:A2B: ... :An-1B]

[n m] [n m] [n m]

x t

eAt

At

x 0

[n m]

t

A r

e

Bu r dr

0

в общем виде раскладывается в бесконечный ряд,

eAt

2

At

= I + At +

2!

...

для получения конечного результата используем теорему ГамильтонаКэли. Представим eAt в виде конечного ряда

eAt = 0I + 1(At) + 2(At)2 + ... + n-1(At)n-1

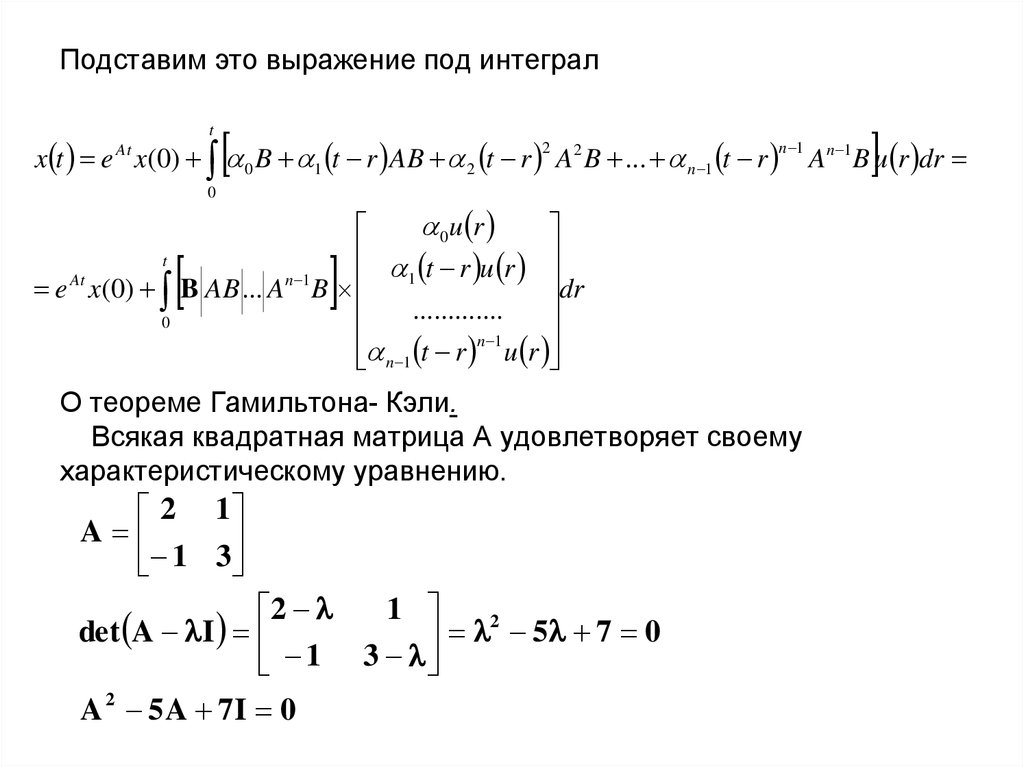

10. Подставим это выражение под интеграл О теореме Гамильтона- Кэли. Всякая квадратная матрица А удовлетворяет своему

Подставим это выражение под интегралt

x t e x(0) 0 B 1 t r AB 2 t r A2 B ... n 1 t r

At

2

n 1

0

0u r

t r u r

t

dr

e At x(0) B AB ... An 1 B 1

.............

0

n 1

t

r

u

r

n 1

О теореме Гамильтона- Кэли.

Всякая квадратная матрица А удовлетворяет своему

характеристическому уравнению.

2 1

A

1

3

1

2

2

det A I

5 7 0

1 3

A 2 5 A 7I 0

An 1 B u r dr

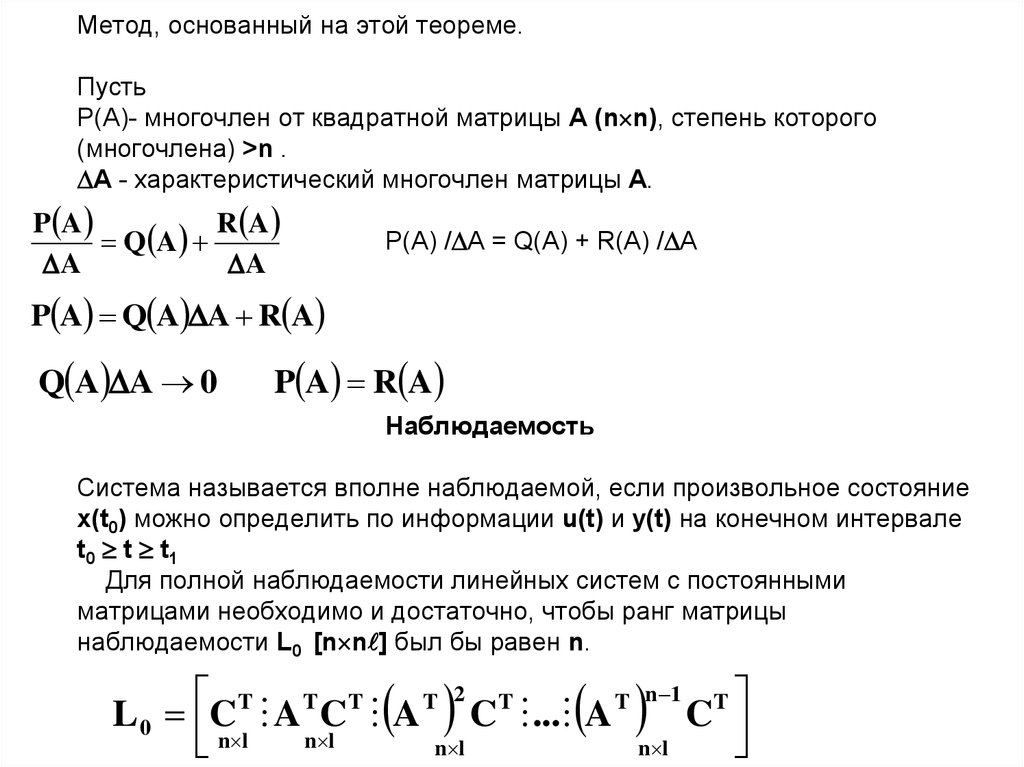

11. Метод, основанный на этой теореме. Пусть Р(А)- многочлен от квадратной матрицы А (nn), степень которого (многочлена) >n . А -

Метод, основанный на этой теореме.Пусть

Р(А)- многочлен от квадратной матрицы А (n n), степень которого

(многочлена) >n .

А - характеристический многочлен матрицы А.

P A

R A

Q A

A

A

Р(А) / А = Q(A) + R(A) / А

P A Q A A R A

Q A A 0

P A R A

Наблюдаемость

Система называется вполне наблюдаемой, если произвольное состояние

x(t0) можно определить по информации u(t) и y(t) на конечном интервале

t0 t t1

Для полной наблюдаемости линейных систем с постоянными

матрицами необходимо и достаточно, чтобы ранг матрицы

наблюдаемости L0 [n n ] был бы равен n.

T

T T

T 2

T

T n 1 T

L 0 C A C A C ... A

C

n l

n l

n l

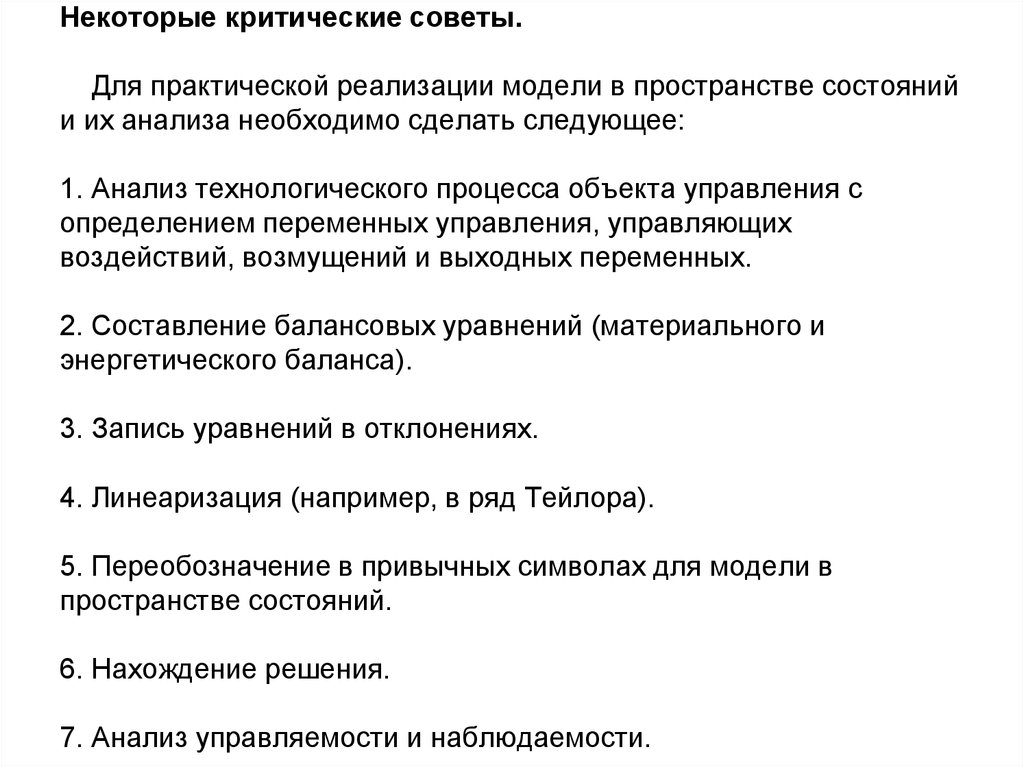

n l

12. Некоторые критические советы. Для практической реализации модели в пространстве состояний и их анализа необходимо сделать

следующее:1. Анализ технологического процесса объекта управления с

определением переменных управления, управляющих

воздействий, возмущений и выходных переменных.

2. Составление балансовых уравнений (материального и

энергетического баланса).

3. Запись уравнений в отклонениях.

4. Линеаризация (например, в ряд Тейлора).

5. Переобозначение в привычных символах для модели в

пространстве состояний.

6. Нахождение решения.

7. Анализ управляемости и наблюдаемости.

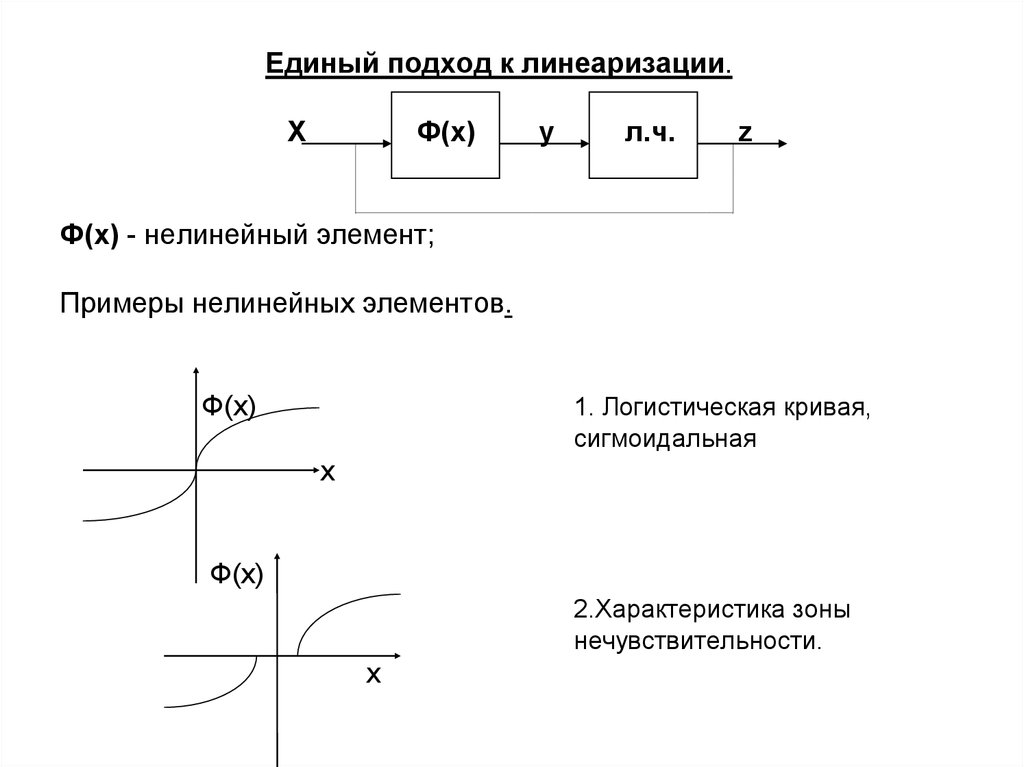

13. Единый подход к линеаризации. X Ф(x) y л.ч. z Ф(x) - нелинейный элемент; Примеры нелинейных элементов. Ф(x) 1. Логистическая

кривая,сигмоидальная

x

Ф(x)

2.Характеристика зоны

нечувствительности.

x

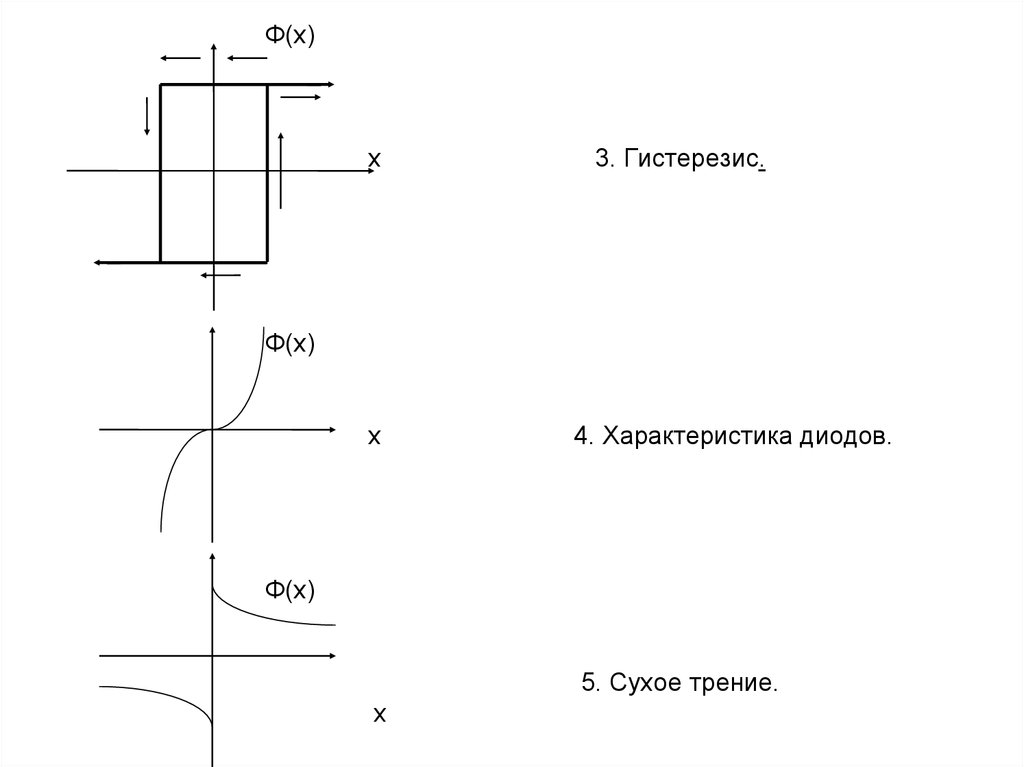

14. Ф(x) x 3. Гистерезис. Ф(x) x 4. Характеристика диодов. Ф(x) 5. Сухое трение. x

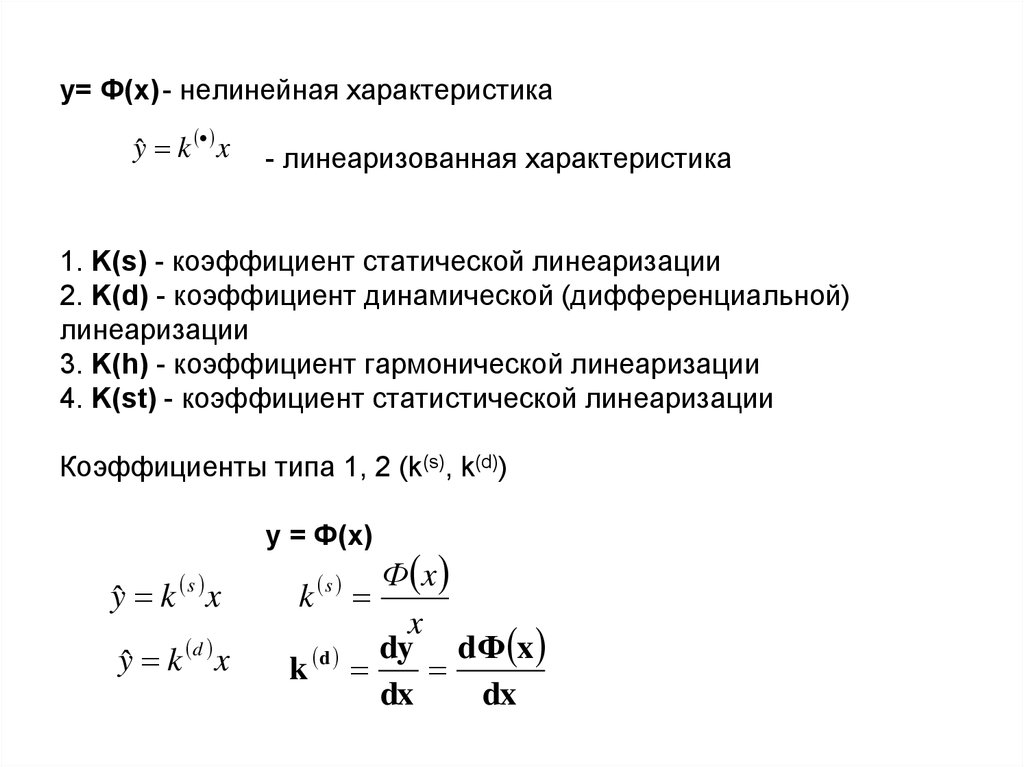

15. у= Ф(x) - нелинейная характеристика - линеаризованная характеристика 1. K(s) - коэффициент статической линеаризации 2. K(d) -

у= Ф(x) - нелинейная характеристикаyˆ k x

- линеаризованная характеристика

1. K(s) - коэффициент статической линеаризации

2. K(d) - коэффициент динамической (дифференциальной)

линеаризации

3. K(h) - коэффициент гармонической линеаризации

4. K(st) - коэффициент статистической линеаризации

Коэффициенты типа 1, 2 (k(s), k(d))

y = Ф(x)

s

s

yˆ k x

k

yˆ k d x

k d

Ф x

x

dy dФ x

dx

dx

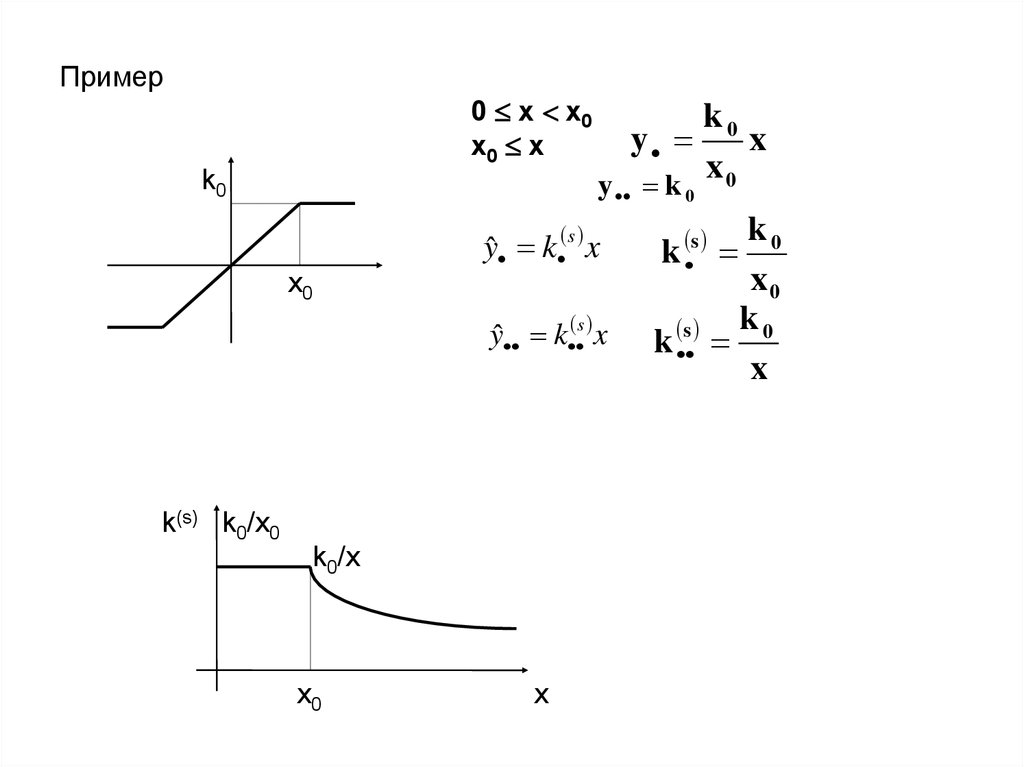

16. Пример 0 x x0 x0 x k0 x0 k(s) k0/x0 k0/x x0 x

Пример0 x x0

x0 x

k0

x0

k0

y

x

x

y k 0 0

k0

s

yˆ k s x

k

x0

yˆ k s x k s k 0

x

k(s) k0/x0

k0/x

x0

x

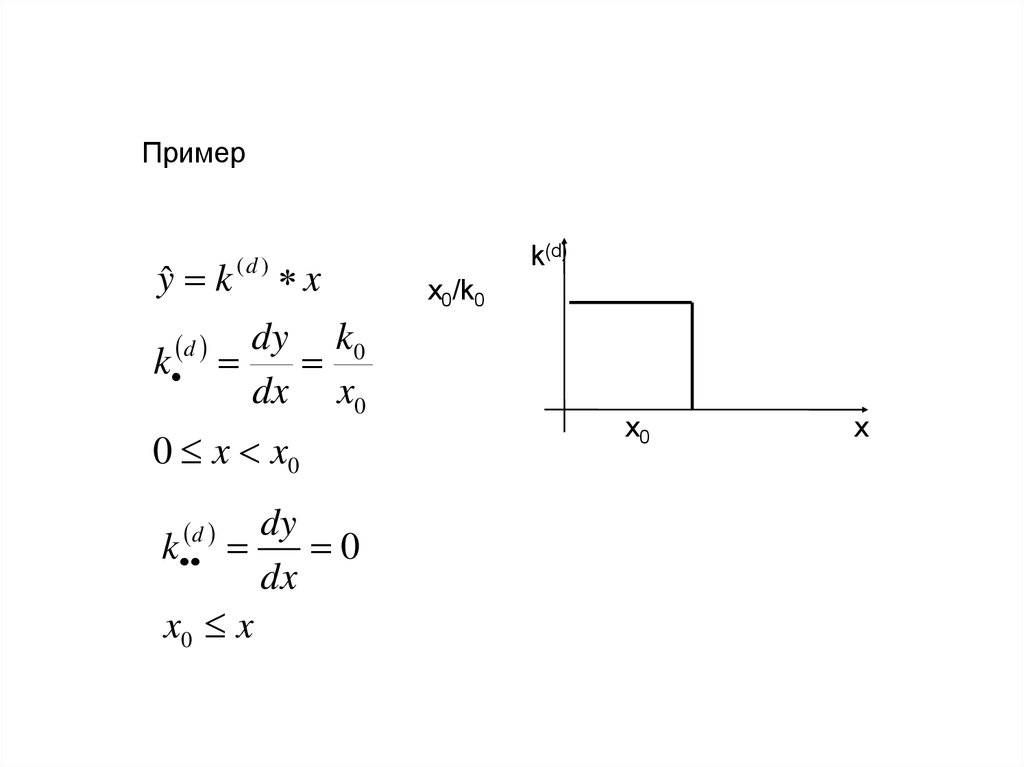

17. Пример k(d) x0/k0 x0 x

Примерyˆ k

d

k

(d )

x

dy k0

dx x0

0 x x0

dy

k

0

dx

x0 x

d

k(d)

x0/k0

x0

x

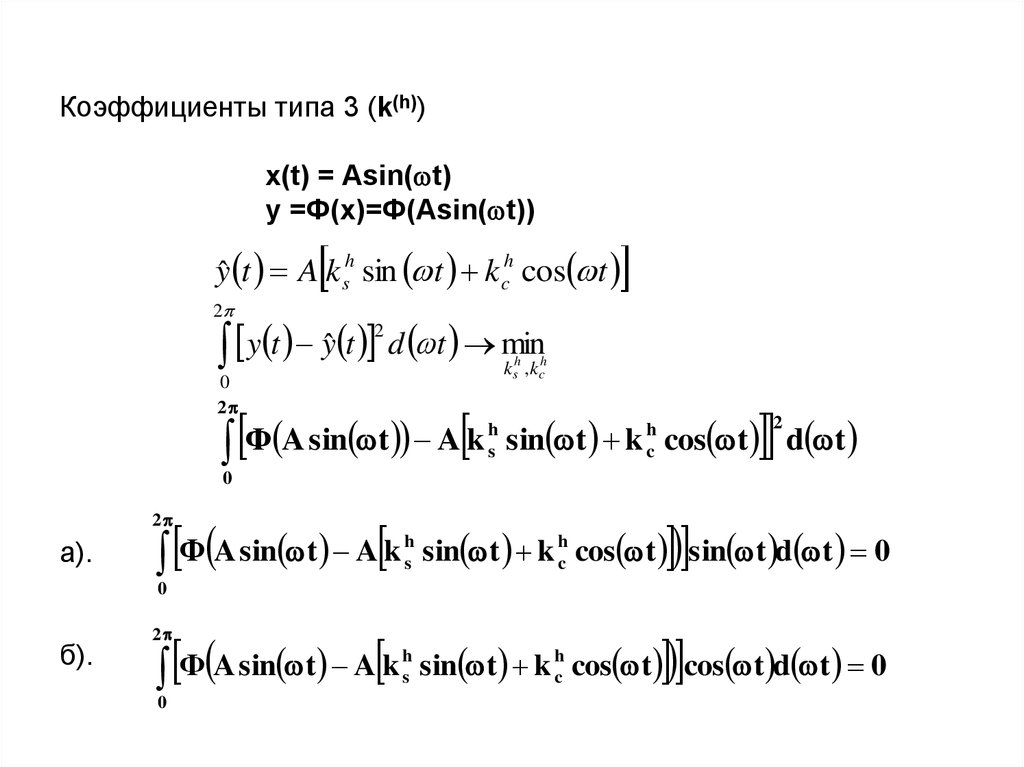

18. Коэффициенты типа 3 (k(h)) x(t) = Asin(t) y =Ф(x)=Ф(Asin(t)) a). б).

Коэффициенты типа 3 (k(h))x(t) = Asin( t)

y =Ф(x)=Ф(Asin( t))

yˆ t A k sh sin t kch cos t

2

2

y

t

y

t

d t min

ˆ

k ,k

h

s

0

2

Ф A sin t A k

h

s

h

c

sin t k cos t d t

2

h

c

0

2

a).

Ф A sin t A k

h

s

sin t k hc cos t sin t d t 0

h

s

sin t k hc cos t cos t d t 0

0

б).

2

Ф A sin t A k

0

19. a) б)

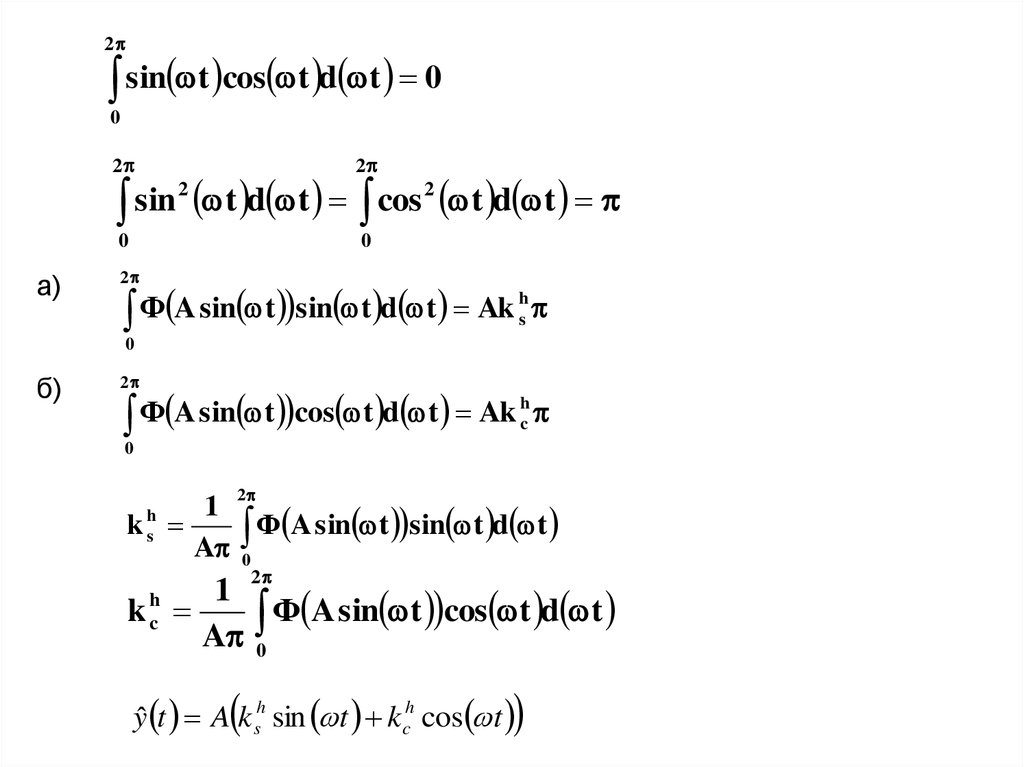

2sin t cos t d t 0

0

2

2

0

0

2

2

sin

t

d

t

cos

t d t

a)

2

h

Ф

A

sin

t

sin

t

d

t

Ak

s

0

б)

2

h

Ф

A

sin

t

cos

t

d

t

Ak

c

0

2

1

k

Ф A sin t sin t d t

A 0

h

s

2

1

h

kc

Ф A sin t cos t d t

A 0

yˆ t A k sh sin t kch cos t

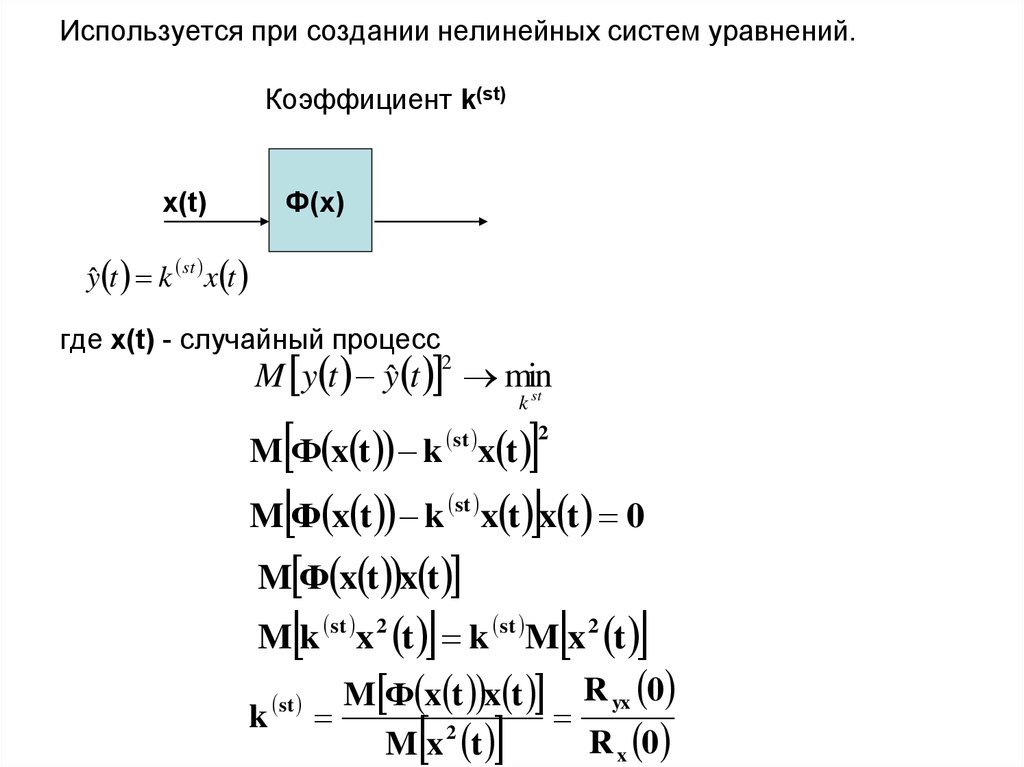

20. Используется при создании нелинейных систем уравнений. Коэффициент k(st) x(t) Ф(x) где x(t) - случайный процесс

Используется при создании нелинейных систем уравнений.Коэффициент k(st)

x(t)

Ф(x)

yˆ t k st x t

где x(t) - случайный процесс

M y t yˆ t min

st

2

k

x t

M Ф x t k x t x t 0

M Ф x t k

st

2

st

M Ф x t x t

M k st x 2 t k st M x 2 t

M Ф x t x t R yx 0

st

k

2

R x 0

M x t

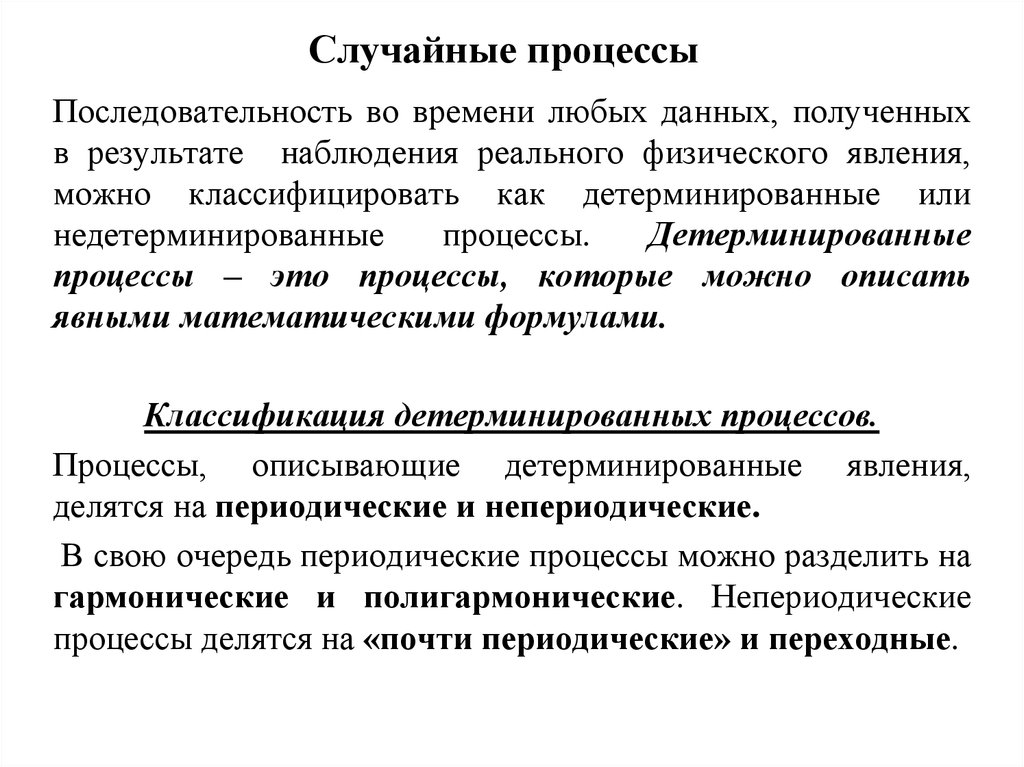

21. Случайные процессы

Последовательность во времени любых данных, полученныхв результате наблюдения реального физического явления,

можно классифицировать как детерминированные или

недетерминированные

процессы.

Детерминированные

процессы – это процессы, которые можно описать

явными математическими формулами.

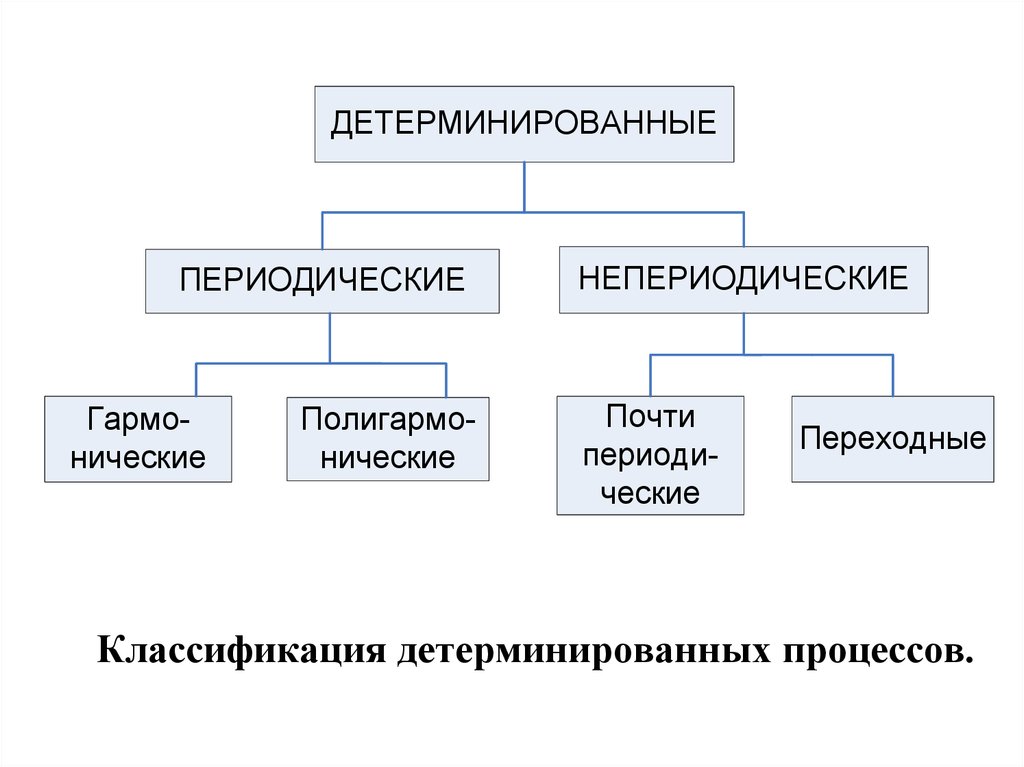

Классификация детерминированных процессов.

Процессы, описывающие детерминированные явления,

делятся на периодические и непериодические.

В свою очередь периодические процессы можно разделить на

гармонические и полигармонические. Непериодические

процессы делятся на «почти периодические» и переходные.

22.

ДЕТЕРМИНИРОВАННЫЕПЕРИОДИЧЕСКИЕ

Гармонические

Полигармонические

НЕПЕРИОДИЧЕСКИЕ

Почти

периодические

Переходные

Классификация детерминированных процессов.

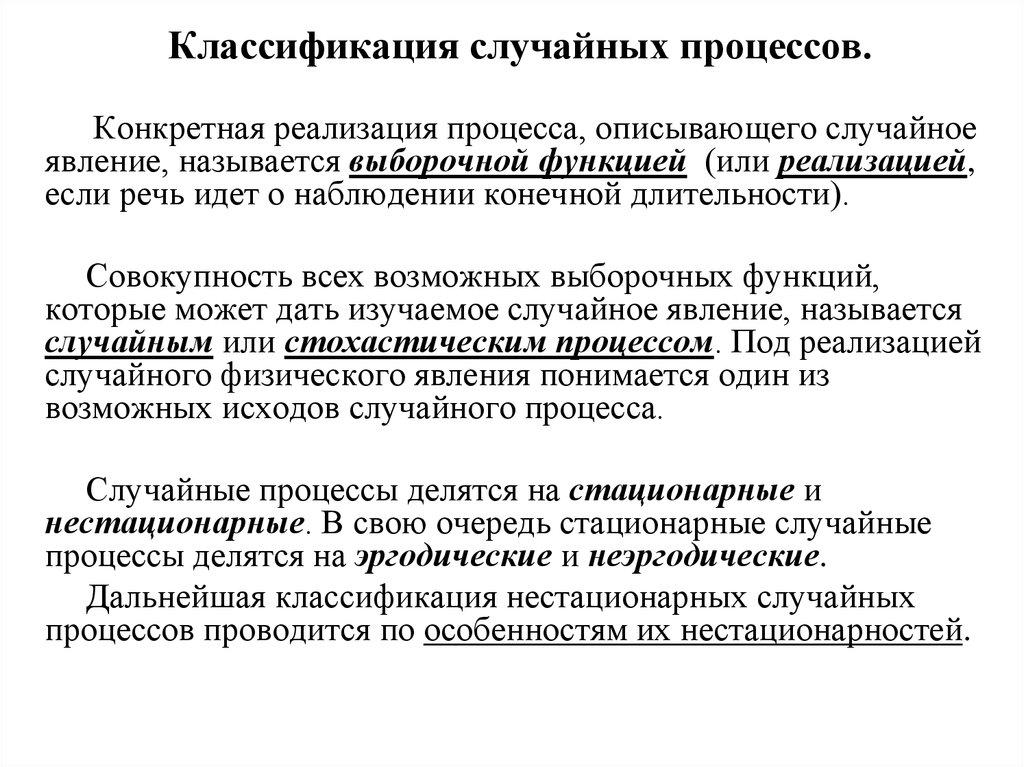

23. Классификация случайных процессов.

Конкретная реализация процесса, описывающего случайноеявление, называется выборочной функцией (или реализацией,

если речь идет о наблюдении конечной длительности).

Совокупность всех возможных выборочных функций,

которые может дать изучаемое случайное явление, называется

случайным или стохастическим процессом. Под реализацией

случайного физического явления понимается один из

возможных исходов случайного процесса.

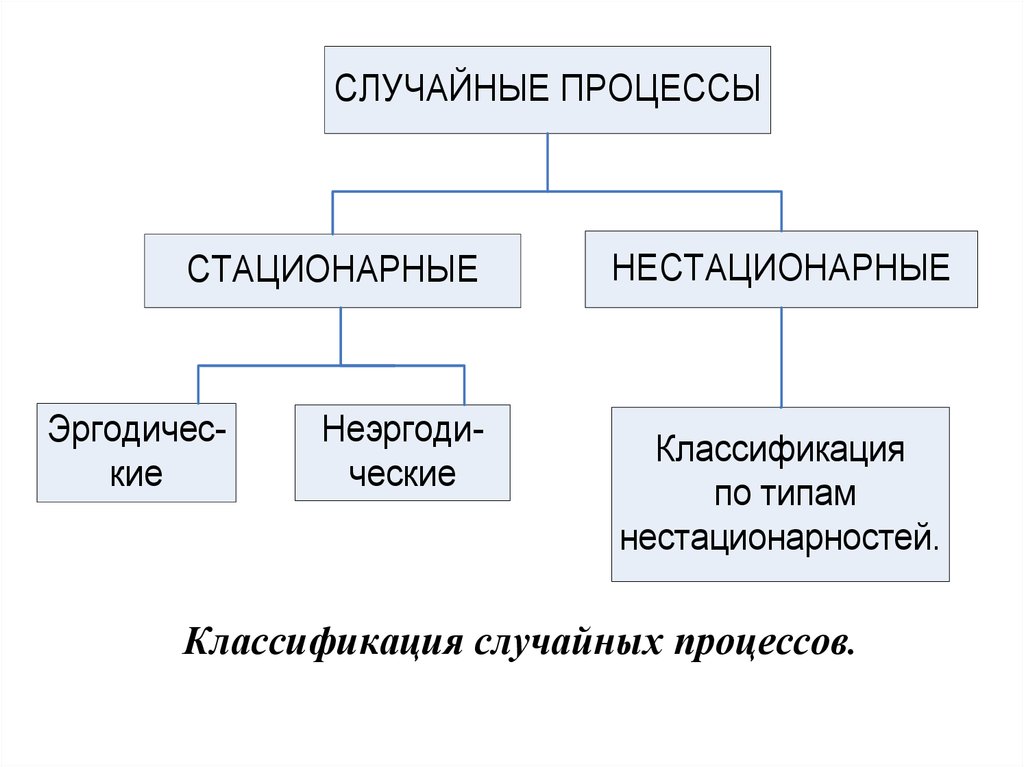

Случайные процессы делятся на стационарные и

нестационарные. В свою очередь стационарные случайные

процессы делятся на эргодические и неэргодические.

Дальнейшая классификация нестационарных случайных

процессов проводится по особенностям их нестационарностей.

24.

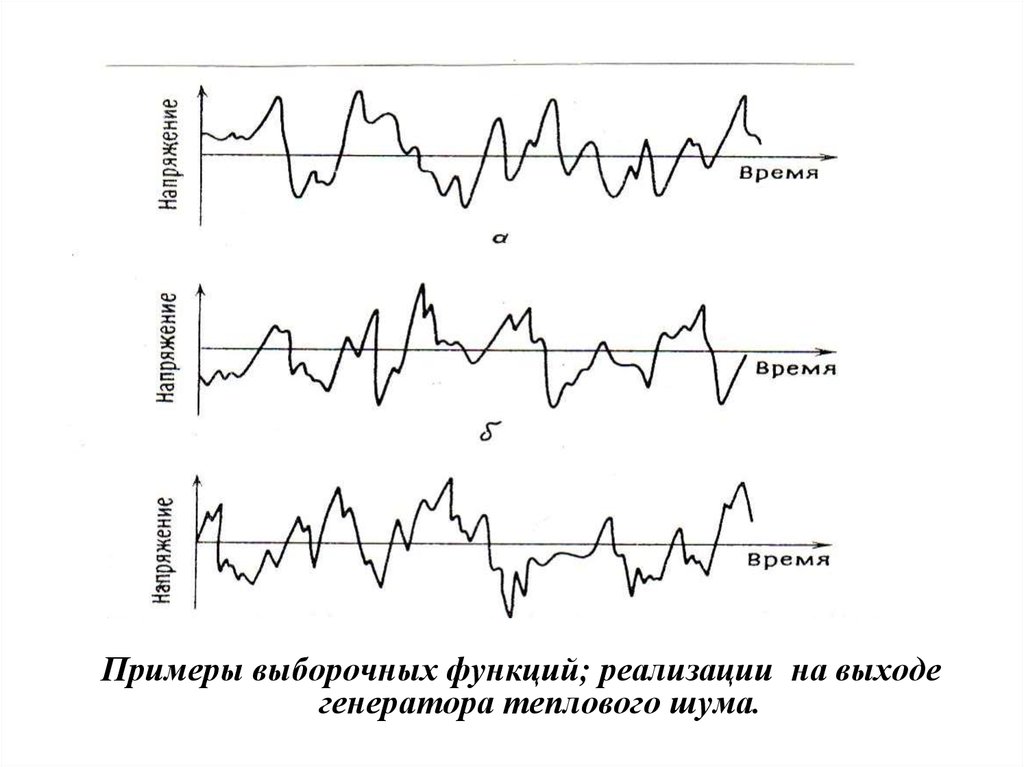

Примеры выборочных функций; реализации на выходегенератора теплового шума.

25.

СЛУЧАЙНЫЕ ПРОЦЕССЫСТАЦИОНАРНЫЕ

Эргодические

Неэргодические

НЕСТАЦИОНАРНЫЕ

Классификация

по типам

нестационарностей.

Классификация случайных процессов.

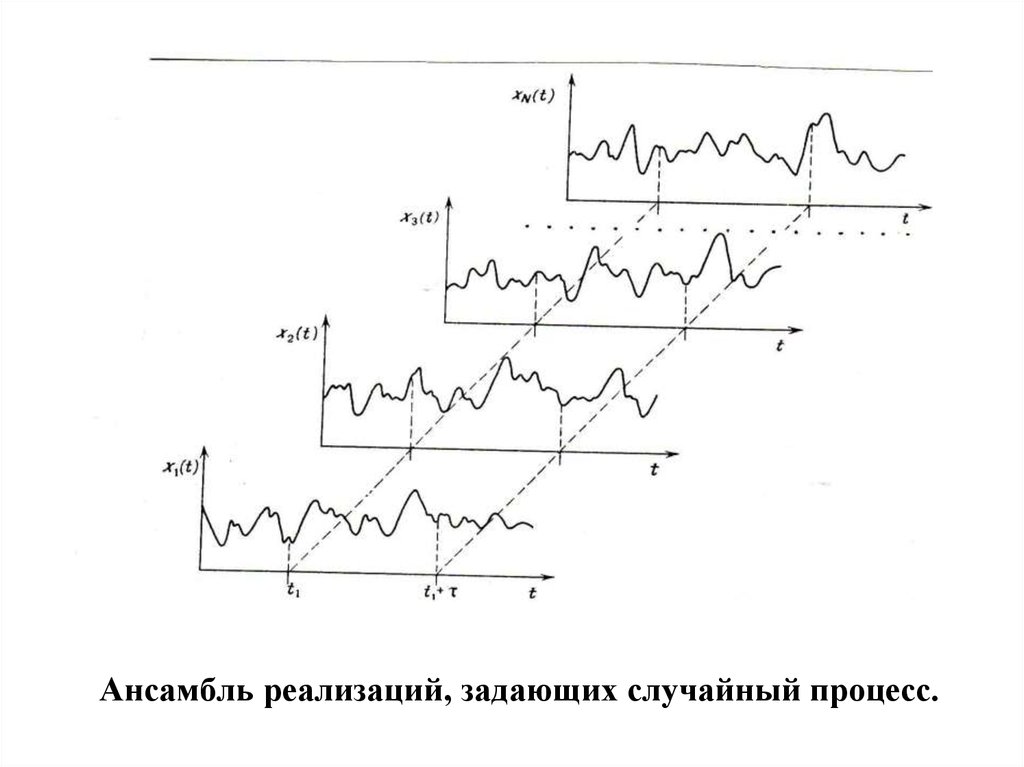

26. Стационарные случайные процессы

Если физическое явление описывается случайным процессом,то свойство этого явления можно оценить в любой момент

времени путем усреднения по совокупности выборочных

функций, образующих случайный процесс.

Рассмотрим, например, совокупность выборочных функций,

называемую также ансамблем.

Среднее значение (первый момент) этого случайного

процесса в момент времени t1 можно вычислить, взяв

мгновенные значения всех выборочных функций ансамбля в

момент времени t1 , сложив эти значения и разделив на число

выборочных функций.

Аналогичным образом вычисляем ковариацию (смешанный

момент) значений случайного процесса для двух различных

моментов времени. Эта величина называется ковариационной

функцией.

27.

Ансамбль реализаций, задающих случайный процесс.28.

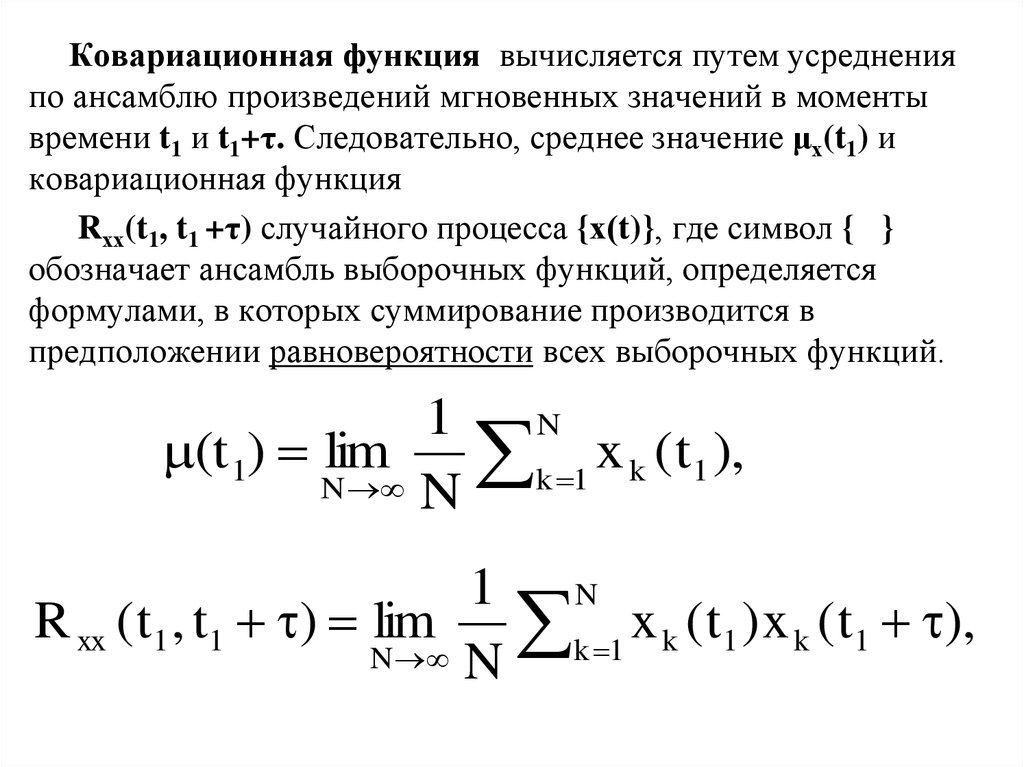

Ковариационная функция вычисляется путем усредненияпо ансамблю произведений мгновенных значений в моменты

времени t1 и t1+τ. Следовательно, среднее значение μх(t1) и

ковариационная функция

Rхх(t1, t1 +τ) случайного процесса {х(t)}, где символ { }

обозначает ансамбль выборочных функций, определяется

формулами, в которых суммирование производится в

предположении равновероятности всех выборочных функций.

1

N

(t 1) lim

x

(

t

),

k

1

k 1

N N

1 N

R xx ( t1 , t1 ) lim

x

(

t

)

x

(

t

)

,

k

1

k

1

k 1

N N

29.

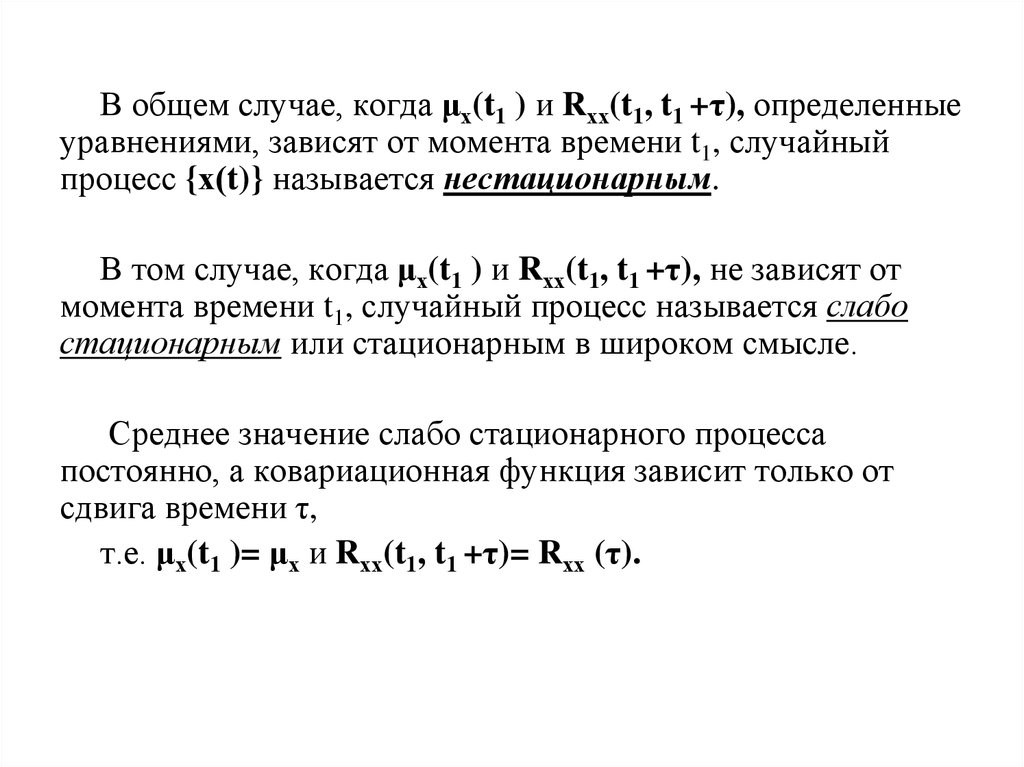

В общем случае, когда μх(t1 ) и Rхх(t1, t1 +τ), определенныеуравнениями, зависят от момента времени t1, случайный

процесс {х(t)} называется нестационарным.

В том случае, когда μх(t1 ) и Rхх(t1, t1 +τ), не зависят от

момента времени t1, случайный процесс называется слабо

стационарным или стационарным в широком смысле.

Среднее значение слабо стационарного процесса

постоянно, а ковариационная функция зависит только от

сдвига времени τ,

т.е. μх(t1 )= μх и Rхх(t1, t1 +τ)= Rхх (τ).

30.

Для определения полного набора функций распределения,задающих структуру случайного процесса {х(t)}, нужно

вычислить бесконечное число моментов и смешанных

моментов высших порядков.

В том случае, когда все моменты и смешанные

моменты инвариантны во времени, случайный процесс

{х(t)} называется строго стационарным или

стационарным в узком смысле (не рассматривается случай,

когда некоторые моменты распределения могут не

существовать).

Во многих приложениях проверка слабой стационарности

позволяет обосновать строгую стационарность.

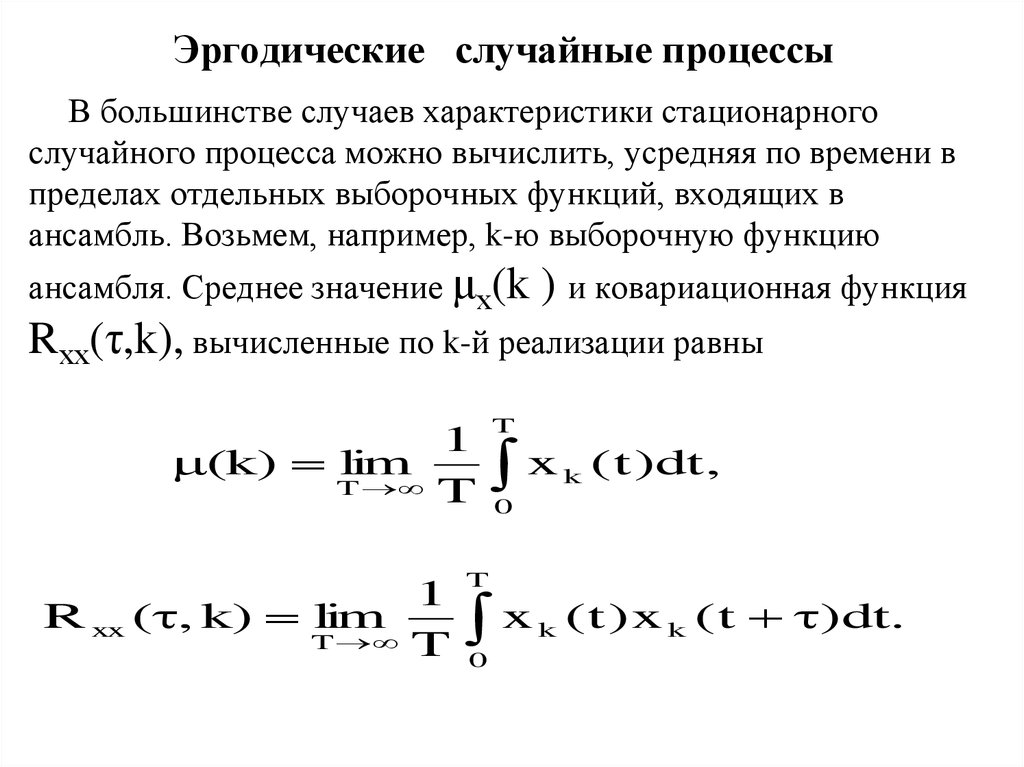

31. Эргодические случайные процессы

В большинстве случаев характеристики стационарногослучайного процесса можно вычислить, усредняя по времени в

пределах отдельных выборочных функций, входящих в

ансамбль. Возьмем, например, k-ю выборочную функцию

ансамбля. Среднее значение μх(k

) и ковариационная функция

Rхх(τ,k), вычисленные по k-й реализации равны

1

(k) lim

T T

1

R xx ( , k) lim

T T

T

x

k

( t )dt ,

0

T

x

0

k

( t ) x k ( t )dt.

32.

Если случайный процесс {х(t)}, стационарен, а μх(k) иRхх(τ,k), вычисленные по различным реализациям согласно

формулам, совпадают, то случайный процесс называется

эргодическим.

Для эргодических процессов средние значения и

ковариационные функции, полученные усреднением по

времени (как и другие характеристики, вычисленные

усреднением по времени), равны аналогичным

характеристикам, найденным усреднением по ансамблю,

т.е.

μх(k)= μх и Rхх(τ,k)= Rхх(τ).

Свойством эргодичности могут обладать только

стационарные процессы.

33.

Эргодические случайные процессы образуют оченьважный класс случайных процессов, поскольку все свойства

эргодических процессов можно определить

по единственной выборочной функции.

на практике стационарные случайные процессы обычно

оказываются эргодическими.

Именно по этой причине свойства стационарных

случайных явлений часто можно определить по одной

наблюдаемой реализации.

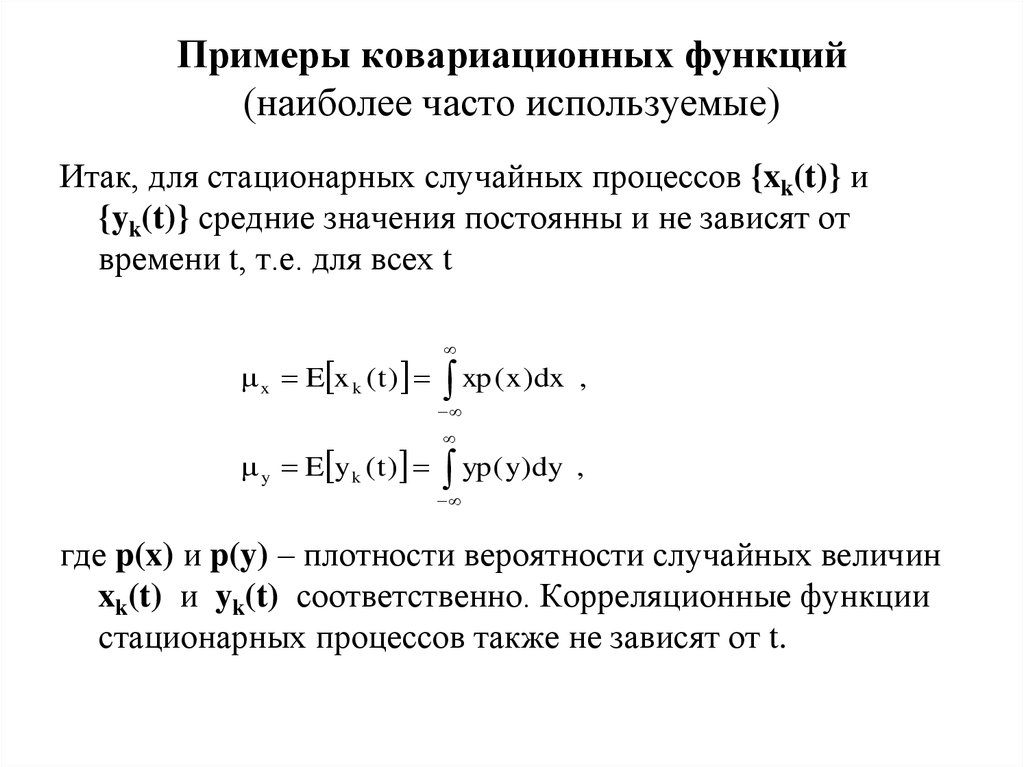

34. Примеры ковариационных функций (наиболее часто используемые)

Итак, для стационарных случайных процессов {xk(t)} и{yk(t)} средние значения постоянны и не зависят от

времени t, т.е. для всех t

x E x k ( t )

xp ( x )dx

,

y E y k ( t )

yp ( y)dy

,

где p(x) и p(y) – плотности вероятности случайных величин

xk(t) и yk(t) соответственно. Корреляционные функции

стационарных процессов также не зависят от t.

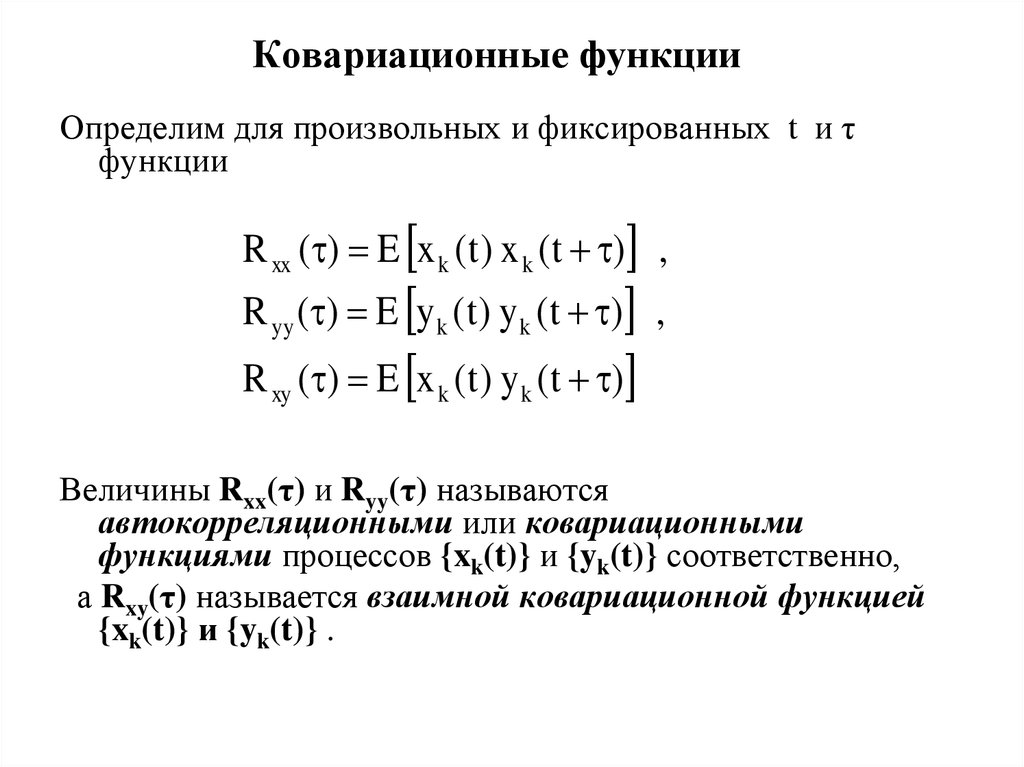

35. Ковариационные функции

Определим для произвольных и фиксированных t и τфункции

R xx ( ) E x k ( t ) x k ( t ) ,

R yy ( ) E y k ( t ) y k ( t ) ,

R xy ( ) E x k ( t ) y k ( t )

Величины Rxx(τ) и Ryy(τ) называются

автокорреляционными или ковариационными

функциями процессов {xk(t)} и {yk(t)} соответственно,

а Rxy(τ) называется взаимной ковариационной функцией

{xk(t)} и {yk(t)} .

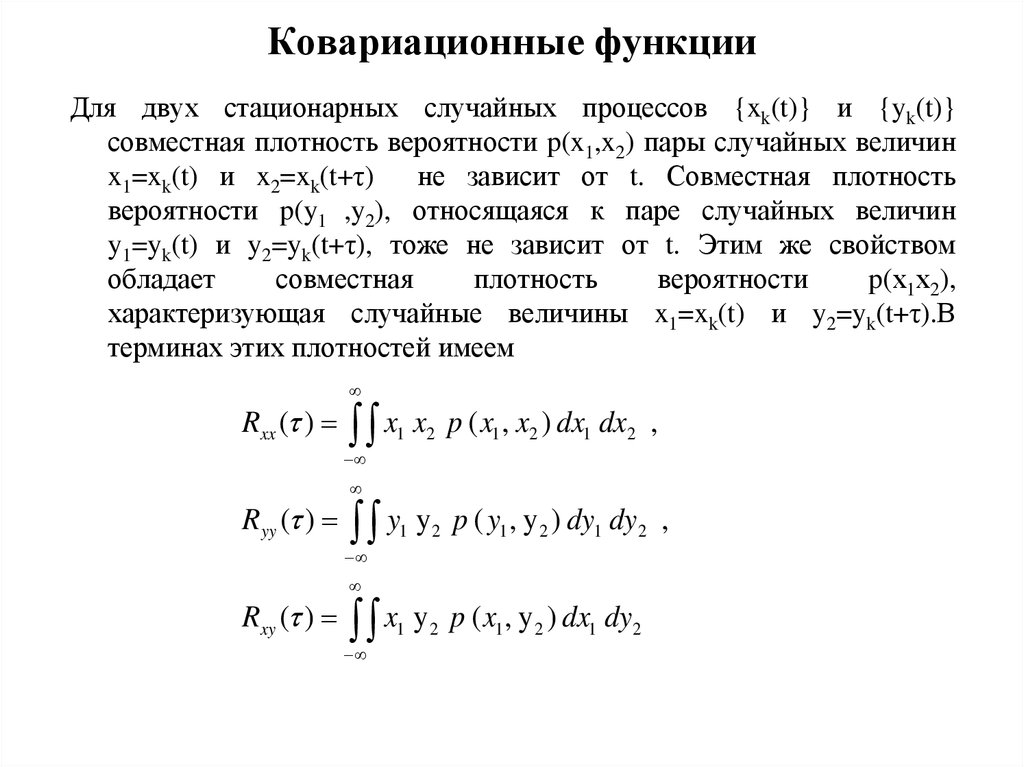

36. Ковариационные функции

Для двух стационарных случайных процессов {xk(t)} и {yk(t)}совместная плотность вероятности p(x1,x2) пары случайных величин

x1=xk(t) и x2=xk(t+τ)

не зависит от t. Совместная плотность

вероятности p(y1 ,y2), относящаяся к паре случайных величин

y1=yk(t) и y2=yk(t+τ), тоже не зависит от t. Этим же свойством

обладает

совместная

плотность

вероятности

p(х1х2),

характеризующая случайные величины x1=xk(t) и y2=yk(t+τ).В

терминах этих плотностей имеем

Rxx ( )

x

1

x2 p ( x1 , x2 ) dx1 dx2 ,

Ryy ( )

y

1

y 2 p ( y1 , y 2 ) dy1 dy2 ,

1

y 2 p ( x1 , y 2 ) dx1 dy2

Rxy ( )

x

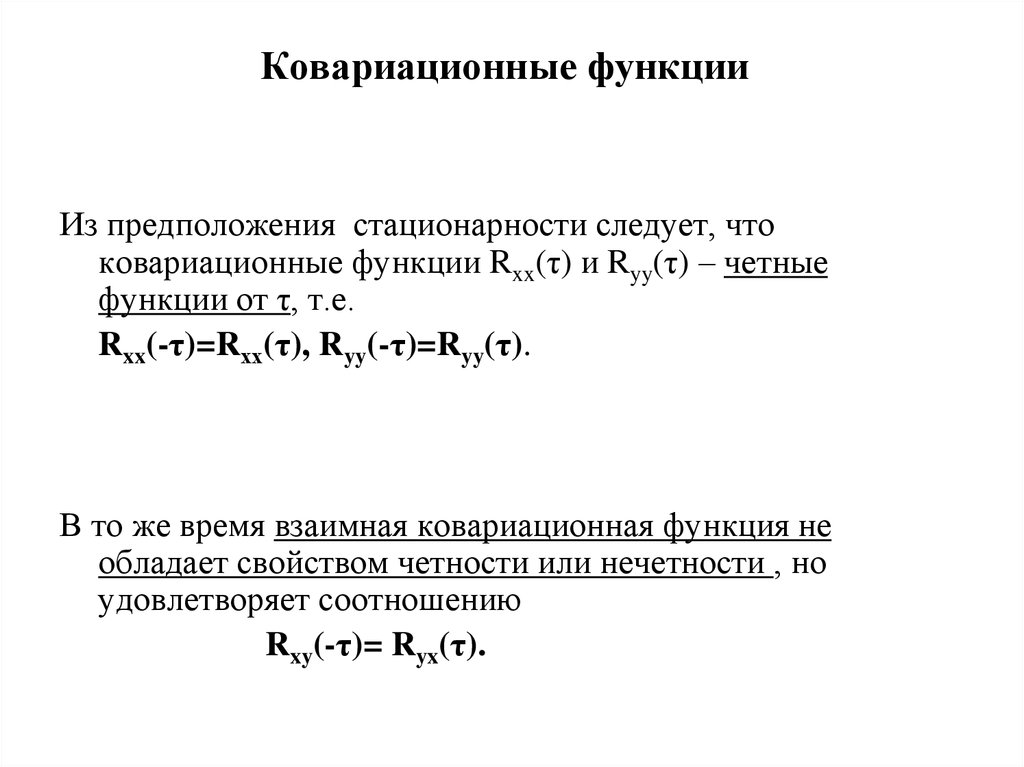

37. Ковариационные функции

Из предположения стационарности следует, чтоковариационные функции Rxx(τ) и Ryy(τ) – четные

функции от τ, т.е.

Rxx(-τ)=Rхх(τ), Ryy(-τ)=Ryy(τ).

В то же время взаимная ковариационная функция не

обладает свойством четности или нечетности , но

удовлетворяет соотношению

Rxy(-τ)= Ryx(τ).

38. Белый шум

Белый шум - стационарный шум, спектральные составляющие которого равномерно

распределены по всему диапазону задействованных частот (классический пример-шум

близкого водопада; отдаленный шум водопада - розовый так как высокочастотные составляющие звука

затухают в воздухе сильнее низкочастотных).

Название происходит от белого света. «Чисто» белый шум-идеализация.

Термин применяется к сигналу, имеющему автокорреляционную функцию,

математически описываемую дельта – функцией Дирака по всем измерениям

многомерного пространства, в котором этот сигнал рассматривается. Сигналы,

обладающие этим свойством, могут рассматриваться как белый шум и определяют основное

статистическое свойство.

Белый шум некоррелирован по времени (или по другому аргументу), не определяет

его значений во временной области . Наборы, принимаемые сигналом, могут быть

произвольными с точностью до главного статистического свойства (однако

постоянная составляющая такого сигнала должна быть равна нулю).

Пример - двоичный сигнал, который может принимать только значения, равные нулю или единице, будет

являться белым шумом только если последовательность нулей и единиц будет некоррелирована.

Дискретный белый шум — это просто последовательность независимых (то есть

статистически не связанных друг с другом) чисел. Генератор белого шума использует

метод псевдослучайных чисел (пакет Visual C++). Тогда , дискретный белый шум

можно получить так:

x[i] = 2 * ((rand()/((double)RAND_MAX)) — 0.5)

В данном случае x — массив дискретного белого шума (без нулевой частотной

составляющей), имеющего равномерное распределение от −1 до 1.

39. Белый шум

Гауссовский шум - шум с нормальным распределением по амплитуде, который не эквивалентен белому

шуму. Гауссовый шум предполагает распределение значений сигнала в виде нормального распределения,

тогда как термин «белый» имеет отношение к корреляции сигнала в два различных момента времени

(эта корреляция не зависит от распределения амплитуды шума).

(В электронной музыке белый шум используется как в качестве одного из инструментов музыкальной

аранжировки, так и в качестве входного сигнала для специальных фильтров, формирующих шумовые

сигналы других типов, в частности, для воссоздания звучания ударных инструментов , тарелки).

Белый шум используется для измерения частотных х-к различных линейных динамических систем таких

как усилители, электронные фильтры, дискретные системы управления, счетчики и т. д. При подаче на вход

такой системы белого шума, на выходе получаем сигнал, являющийся откликом системы на приложенное

воздействие. Ввиду того, что АФЧХ линейной системы есть отношение преобразования Фурье выходного

сигнала к преобразованию Фурье входного сигнала, получить эту характеристику математически достаточно

просто, причём для всех частот, для которых входной сигнал можно считать белым шумом.

Белый шум используется для генерирования случайных чисел и случайных

последовательностей. Вектор случайных чисел является последовательностью

отсчётов белого шума, когда его среднее значение и автокорреляционная

матрица удовлетворяют следующим равенствам:

Итак,имеем вектор случайных чисел с нулевым средним значением и автокорреляц.

матрицу в виде диагональной матрицы с дисперсиями по главной диагонали.

40. Белый случайный процесс (белый шум).

Непрерывный во времени случайный процесс

является белым шумом тогда и только тогда, когда математическое

ожидание

и автокорреляционная функция удовлетворяют следующим

равенствам соответственно:

Т.е. это - случайный процесс с нулевым математическим ожиданием,

имеющий автокорреляционную функцию, являющуюся дельта функцией – функцией Дирака.

Такая автокорреляционная функция предполагает следующую

спектральную плотность мощности:

так как преобразование Фурье дельта-функции равно единице на всех

частотах. Ввиду того, что спектральная плотность мощности одинакова

на всех частотах, белый шум и получил своё название (по аналогии с

частотным спектром белого света).

mathematics

mathematics