Similar presentations:

Мультиколлинеарность

1. Мультиколлинеарность

Лекция2. Цели лекции

1. Объяснить сущность проблемымультиколлинеарности

2. Изучить последствия мультиколлинеарности

3. Указать средства обнаружения

мультиколлинеарности

4. Обсудить проблему выбора средств борьбы

с мультиколлинеарностью

2

3. Коллинеарность и мультиколлинеарность

Термин «коллинеарность» характеризует линейнуюсвязь между двумя объясняющими переменными.

«Мультиколлинеарность» означает линейную

связь между более чем двумя объясняющими

переменными.

На практике всегда используется один термин –

мультиколлинеарность.

Термин «мультиколлинеарность» введен Рагнаром Фришем

3

4. Виды мультиколлинеарности. Строгая и нестрогая мультиколлинеарность

1. Строгая мультиколлинеарность – наличиелинейной функциональной связи между

объясняющими переменными (иногда также и

зависимой).

2. Нестрогая мультиколлинеарность – наличие

сильной линейной корреляционной связи между

между объясняющими переменными (иногда также и

зависимой).

4

5. Суть строгой мультиколлинеарности

Y 0 1 X 1 2 X 2 3 X 3 m X mX 1 0 1 X 2

0 1

X 2 X1

1 1

Y ( 0 1 0 ) ( 2 1 2 ) X 2 3 X 3 m X m

0

1

Y 0 2 1 2 X 1 3 X 3 m X m

1

1

Связь между объясняющими переменными – функциональная

5

6. Суть строгой мультиколлинеарности. Выводы

Строгая мультиколлинеарность не позволяетоднозначно определить коэффициенты регрессии и

разделить вклады объясняющих переменных Х1 и Х2 в

их влиянии на зависимую переменную Y.

6

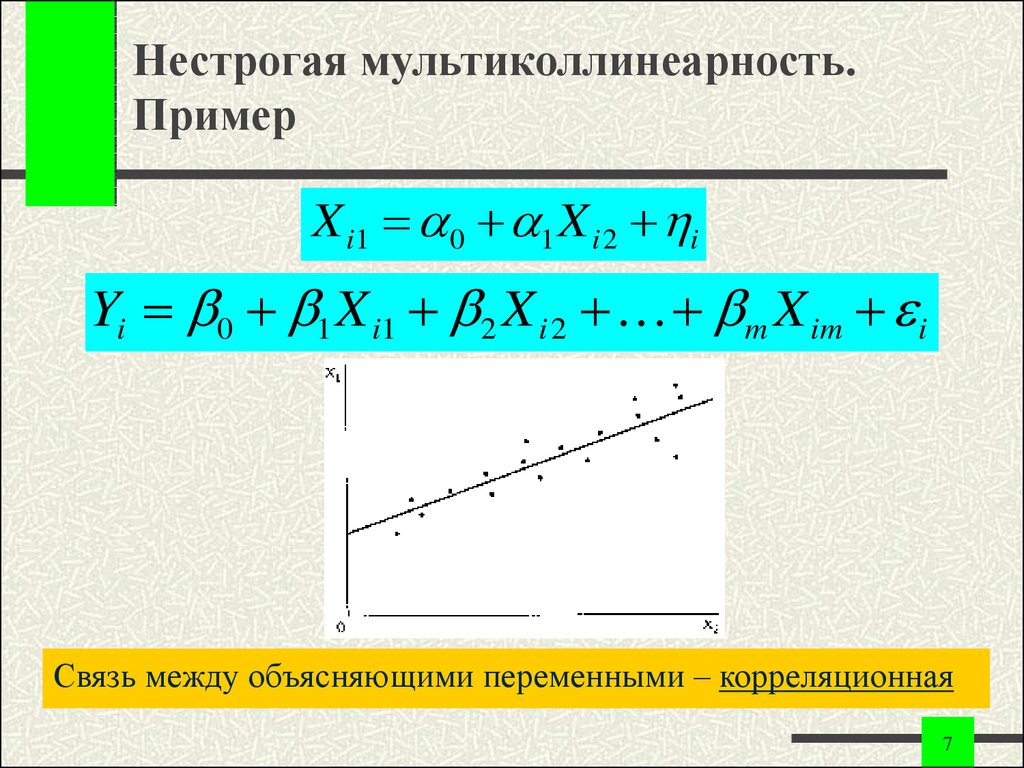

7. Нестрогая мультиколлинеарность. Пример

X i1 0 1 X i 2 iYi 0 1 X i1 2 X i 2 m X im i

Связь между объясняющими переменными – корреляционная

7

8. Сложность проблемы мультиколлинеарности

1. Корреляционные связи есть всегда. Проблемамультиколлинеарности – сила проявления

корреляционных связей.

2. Однозначных критериев мультиколлинеарности не

существует.

3. Строгая мультиколлинеарность нарушает предпосылку 50

теоремы Гаусса-Маркова и делает построение регрессии

невозможным. (Согласно теоремы Кронекера-Капелли

система уравнений имеет бесчисленное множество решений).

4. Нестрогая мультиколлинеарность затрудняет работу, но не

препятствует получению правильных выводов.

8

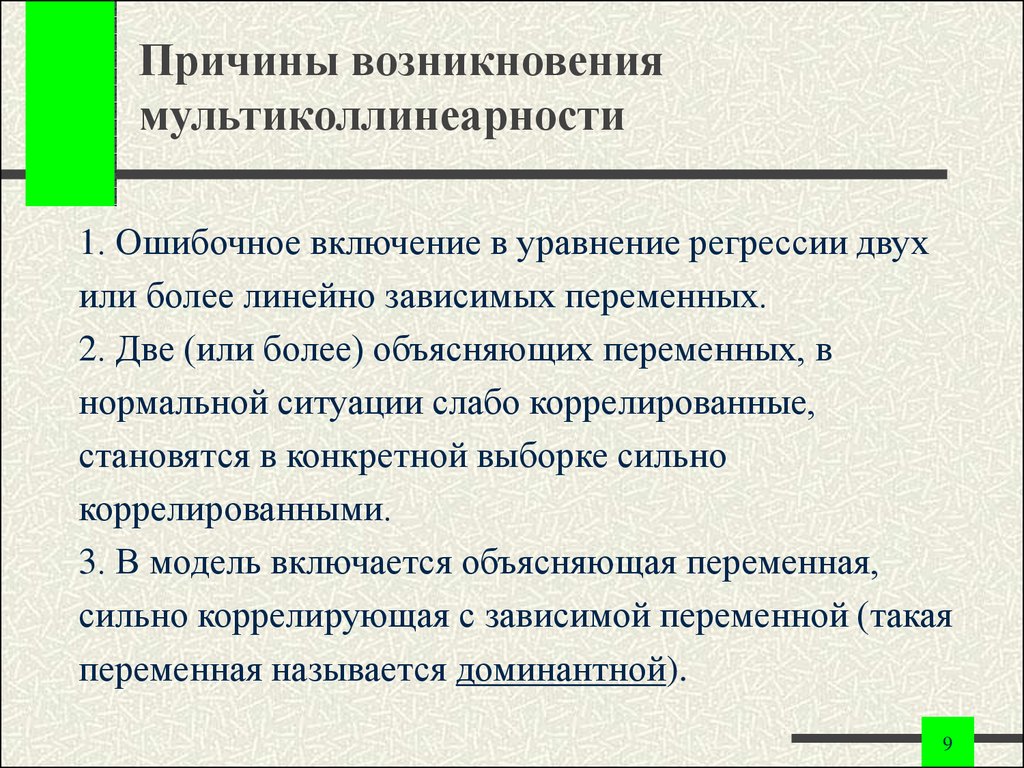

9. Причины возникновения мультиколлинеарности

1. Ошибочное включение в уравнение регрессии двухили более линейно зависимых переменных.

2. Две (или более) объясняющих переменных, в

нормальной ситуации слабо коррелированные,

становятся в конкретной выборке сильно

коррелированными.

3. В модель включается объясняющая переменная,

сильно коррелирующая с зависимой переменной (такая

переменная называется доминантной).

9

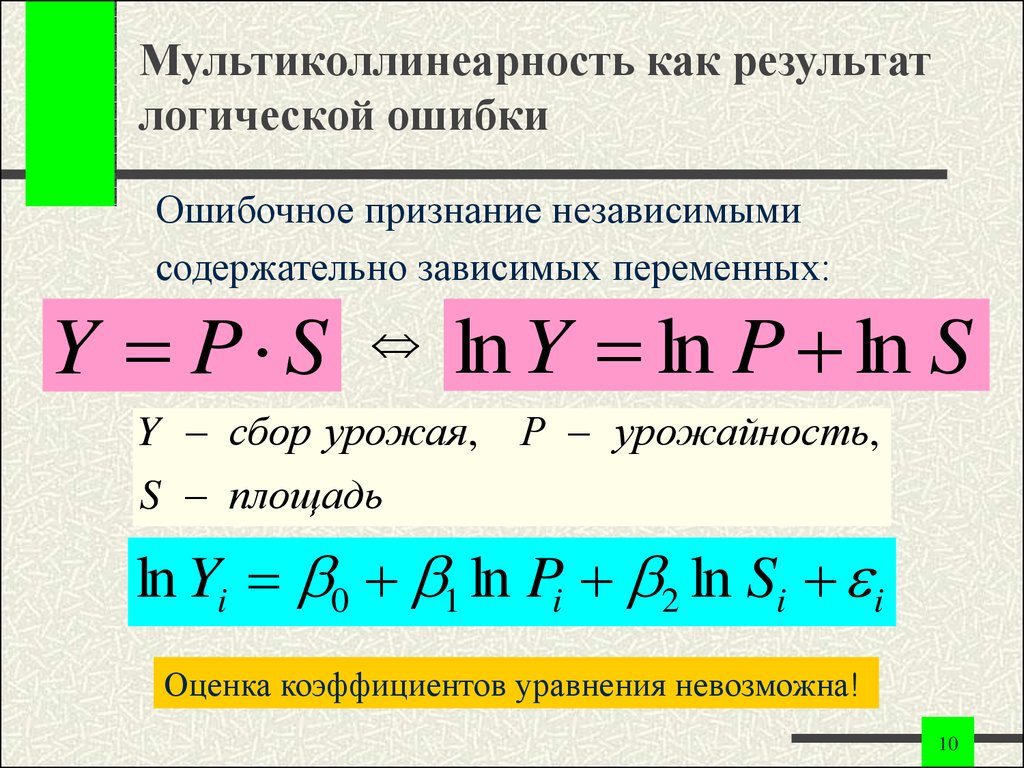

10. Мультиколлинеарность как результат логической ошибки

Ошибочное признание независимымисодержательно зависимых переменных:

Y P S

ln Y ln P ln S

Y сбор урожая, P урожайность,

S площадь

ln Yi 0 1 ln Pi 2 ln Si i

Оценка коэффициентов уравнения невозможна!

10

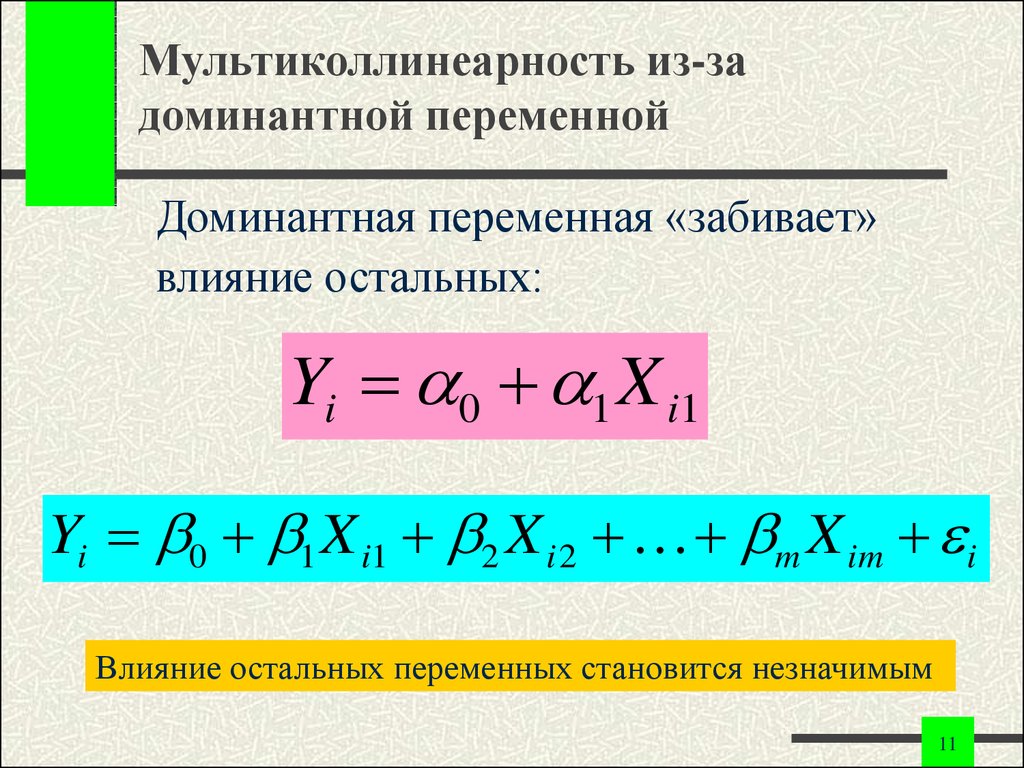

11. Мультиколлинеарность из-за доминантной переменной

Доминантная переменная «забивает»влияние остальных:

Yi 0 1 X i1

Yi 0 1 X i1 2 X i 2 m X im i

Влияние остальных переменных становится незначимым

11

12. Неизбежность мультиколлинеарности

1. Мультиколлинеарность – нормальное явление.Практически любая модель содержит

мультиколлинеарность.

2. Мы не обращаем внимания на

мультиколлинеарность до появления явных

симптомов.

3. Только чрезмерно сильные связи становятся

помехой.

12

13. Механизм действия мультиколлинеарности

Мультиколлинеарность проявляется в совместномдействии факторов:

1. Построить модель – значит определить вклад

каждого фактора.

2. Если два или более фактора изменяются только

совместно, их вклад по отдельности становится

невозможно различить.

3. Чем более сильно коррелированы переменные,

тем труднее различить их вклад.

13

14. Зависимость мультиколлинеарности от выборки

Мультиколлинеарность – явление, проявляющеесяна уровне выборки:

1. В одной выборке мультиколлинеарность может

быть сильной, в другой слабой.

2. Выборочные данные следует предварительно

всесторонне исследовать.

3. Полезен расчет выборочных коэффициентов

корреляции, ковариационной матрицы и ее

определителя.

14

15. Зависимость мультиколлинеарности от смысла задачи

Мультиколлинеарность может быть выявлена присодержательном анализе задачи и данных

Пример. Номинальная (in) и реальная величина (ir) процента

(inf – темп инфляции)

int irt inf t

Yt 0 1int 2irt m X tm i

При строгом контроле за ценами в некоторый период

возникает строгая мультиколлинеарность

int irt const

15

16. Истинная мультиколлинеарность при отсутствии парных зависимостей

Пример. Рассмотрим три ряда данных:X1 (1, 1, 1, 1, 1, 0, 0, 0, 0, 0)

X 2 (0, 0, 0, 0, 0, 1, 1, 1, 1, 1)

X 3 (1, 1, 1, 1, 1, 1, 1, 1, 1, 1)

В данной выборке существует строгая мультиколлинеарность

X 3 X1 X 2

но

1

1

r12 ; r13 r23

0,58

3

3

16

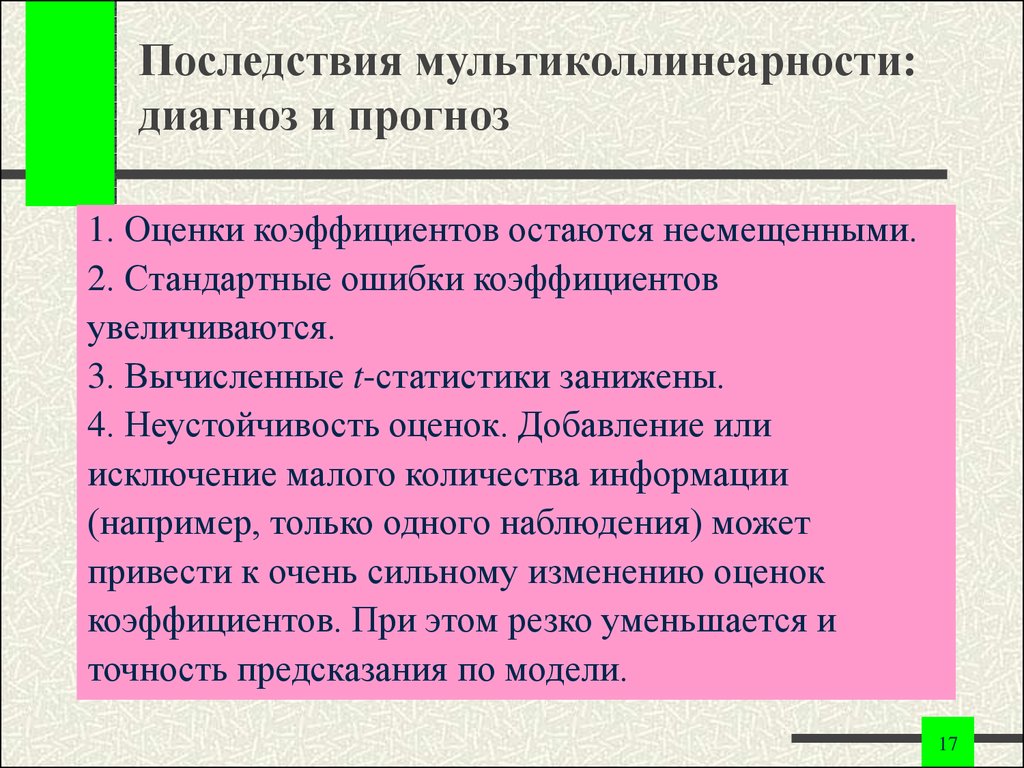

17. Последствия мультиколлинеарности: диагноз и прогноз

1. Оценки коэффициентов остаются несмещенными.2. Стандартные ошибки коэффициентов

увеличиваются.

3. Вычисленные t-статистики занижены.

4. Неустойчивость оценок. Добавление или

исключение малого количества информации

(например, только одного наблюдения) может

привести к очень сильному изменению оценок

коэффициентов. При этом резко уменьшается и

точность предсказания по модели.

17

18. Последствия мультиколлинеарности: диагноз и прогноз

5. Численная неустойчивость процедуры оценивания,вызванная ошибками машинного округления и

накоплением этих ошибок.

6. Высокая коррелированность коэффициентов лишает

смысла их интерпретацию.

7. Общее качество уравнения, а также оценки

переменных, не связанных мультиколлинеарностью,

Остаются незатронутыми.

8. Чем ближе мультиколлинеарность к строгой

(совершенной), тем серьезнее ее последствия.

18

19. Последствия мультиколлинеарности: увеличение стандартных ошибок коэффициентов

Для уравнения с объясняющими переменными X1 и X2Sb1

2

e

i /( n 3)

2

2

(

x

x

)

(

1

r

1i 1

12 )

19

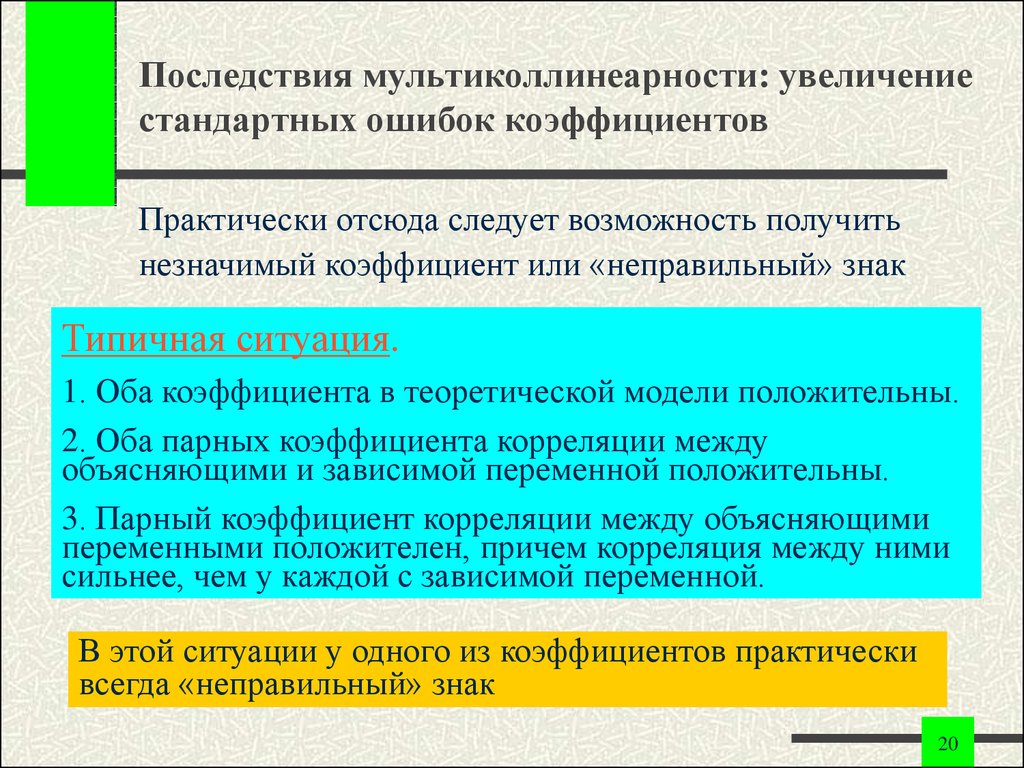

20. Последствия мультиколлинеарности: увеличение стандартных ошибок коэффициентов

Практически отсюда следует возможность получитьнезначимый коэффициент или «неправильный» знак

Типичная ситуация.

1. Оба коэффициента в теоретической модели положительны.

2. Оба парных коэффициента корреляции между

объясняющими и зависимой переменной положительны.

3. Парный коэффициент корреляции между объясняющими

переменными положителен, причем корреляция между ними

сильнее, чем у каждой с зависимой переменной.

В этой ситуации у одного из коэффициентов практически

всегда «неправильный» знак

20

21. Обнаружение мультиколлинеарности. Основной признак

Внешним признаком наличия мультиколлинеарности служатслишком большие значения элементов матрицы ( XT X ) 1

Основной признак мультиколлинеарности: определитель

корреляционной матрицы R близок к нулю:

R

1

r12

r1m

r21

1

r2 m

rm1 rm 2 1

0

Если все объясняющие переменные не коррелированы между собой,

то R 1 . В противном случае 0 R 1 .

21

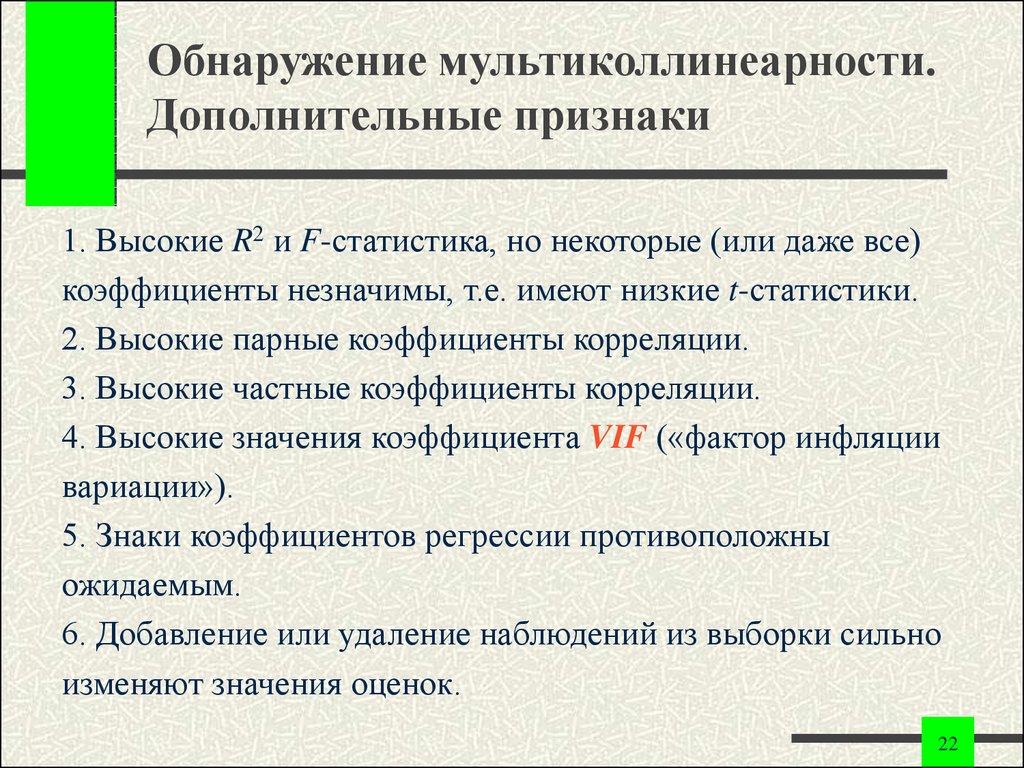

22. Обнаружение мультиколлинеарности. Дополнительные признаки

1. Высокие R2 и F-статистика, но некоторые (или даже все)коэффициенты незначимы, т.е. имеют низкие t-статистики.

2. Высокие парные коэффициенты корреляции.

3. Высокие частные коэффициенты корреляции.

4. Высокие значения коэффициента VIF («фактор инфляции

вариации»).

5. Знаки коэффициентов регрессии противоположны

ожидаемым.

6. Добавление или удаление наблюдений из выборки сильно

изменяют значения оценок.

22

23. Фактор инфляции вариации как оценка эффекта мультиколлинеарности

mYi 0 j X ij i

j 1

VIF ( X 1 )

m

X i1 0 j X ij i R12

j 2

1

1 R12

Если VIF > 10, то объясняющие переменные X i , i 1, m

считаются мультиколлинеарными.

23

24. Методы устранения мультиколлинеарности

1. Изменить или увеличить выборку.2. Исключить из модели одну или несколько переменных.

3. Преобразовать мультиколлинеарные переменные:

- использовать нелинейные формы;

- использовать агрегаты (линейные комбинации переменных);

- использовать первые разности вместо самих переменных.

4. Использовать при оценке коэффициентов метод главных

компонент или другие специальные процедуры расчета

коэффициентов при плохой обусловленности XT X .

5. Ничего не делать!

Самое главное – выбрать правильное средство

24

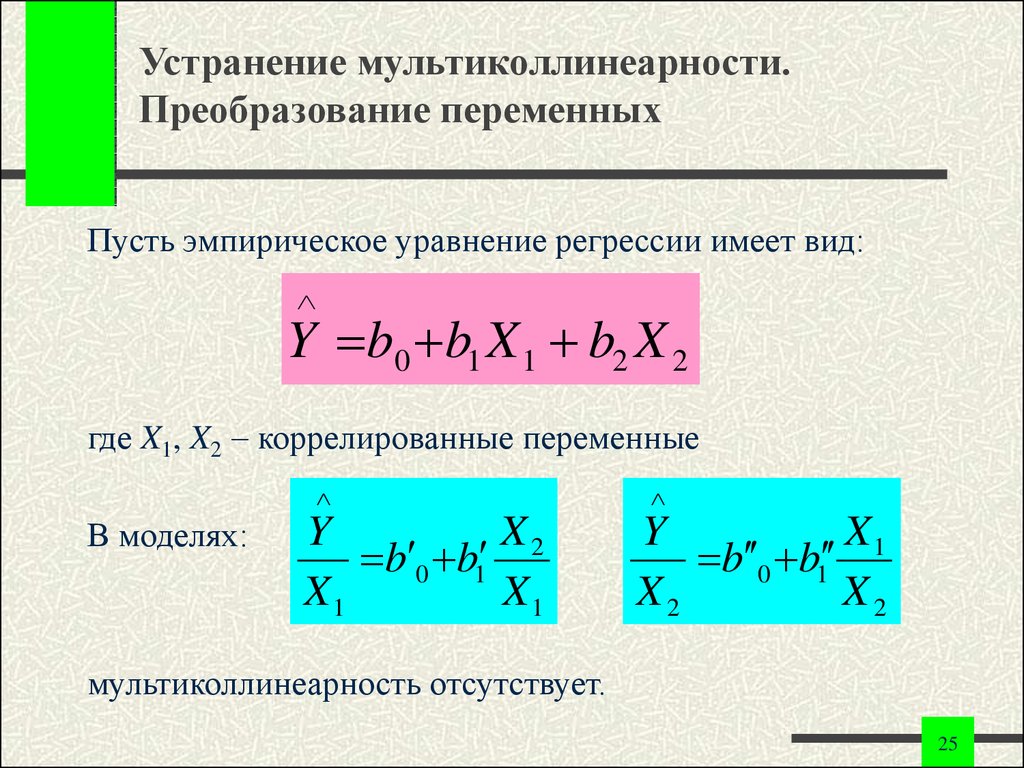

25. Устранение мультиколлинеарности. Преобразование переменных

Пусть эмпирическое уравнение регрессии имеет вид:Y b0 b1 X 1 b2 X 2

где X1, X2 коррелированные переменные

В моделях:

Y

X2

b 0 b1

X1

X1

Y

X1

b 0 b1

X2

X2

мультиколлинеарность отсутствует.

25

26.

Конец лекции26

mathematics

mathematics