Similar presentations:

Честность и оценки: может ли ИИ быть справедливым?

1.

Честность и оценки:может л и ИИ бы ть

справедл ив ы м?

Искусственный интеллект активно входит в сферу образования.

Оценка знаний и поведения — это не просто цифры, но и

вопрос справедливости. Можно ли доверять это машине?

AS

по Anas tas ia S alata

2.

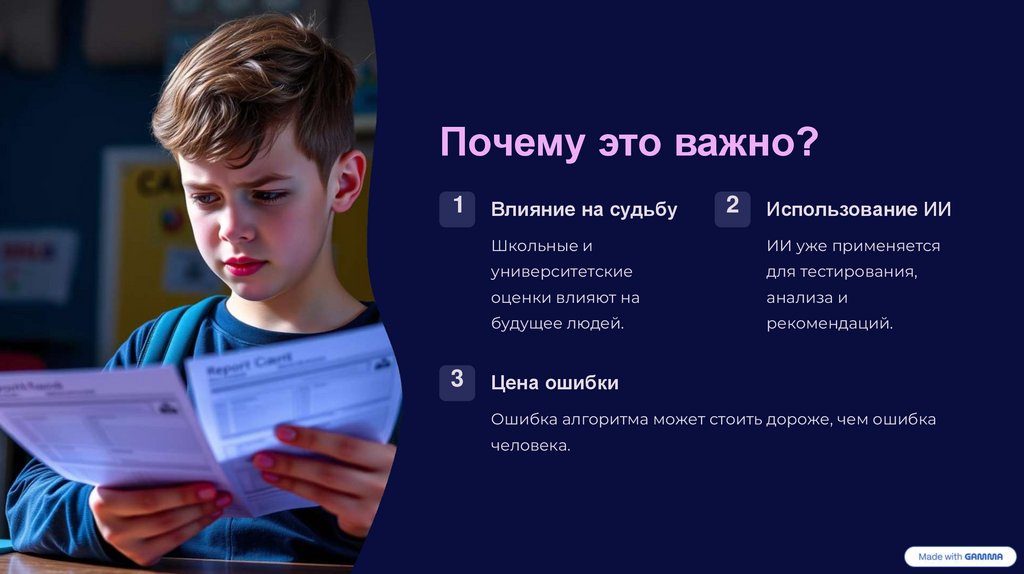

Почему это важно?1

3

Влияние на судьбу

2

Использование ИИ

Школьные и

ИИ уже применяется

университетские

для тестирования,

оценки влияют на

анализа и

будущее людей.

рекомендаций.

Цена ошибки

Ошибка алгоритма может стоить дороже, чем ошибка

человека.

3.

Аргументы «ЗА» ИИ: ОбъективностьОтсутств ие эмоций

Пример объ ектив ности

ИИ не испытывает эмоций и не устает.

Автоматическая проверка тестов: одинаковые

Нет личной предвзятости.

Одинаковое отношение ко всем учащимся.

критерии для всех.

Сравнение письменных работ без учёта «почерка».

4.

Персонал изированны йподход

Анал из динамики

ИИ анализирует динамику успеваемости ученика.

Настройка заданий

Задания адаптируются под уровень каждого

ученика.

В ы явление трудностей

Раннее выявление проблем в обучении.

5.

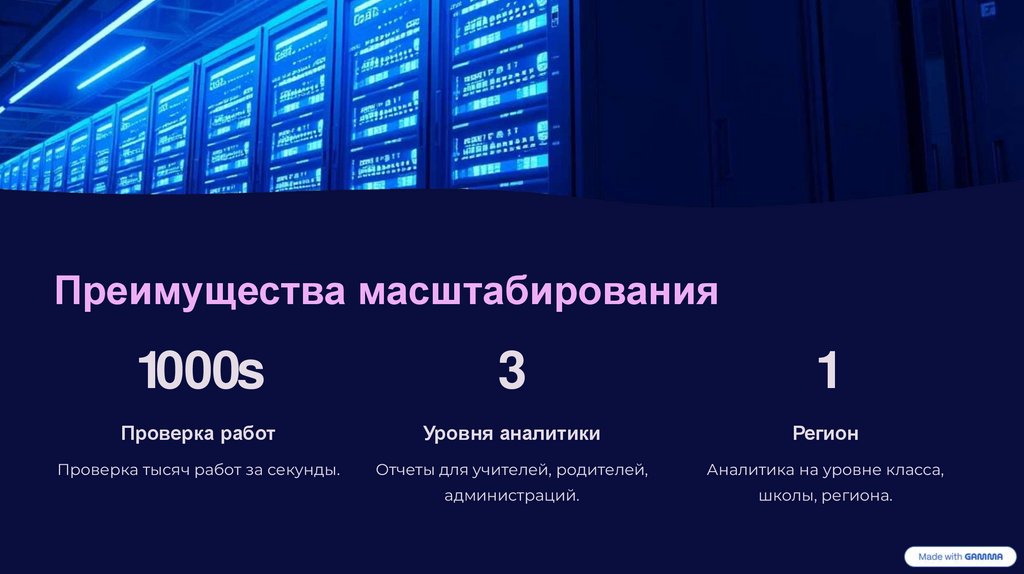

Преимущества масштабирования1000s

3

1

Проверка работ

Уровня аналитики

Регион

Проверка тысяч работ за секунды.

Отчеты для учителей, родителей,

Аналитика на уровне класса,

администраций.

школы, региона.

6.

Аргументы «ПРОТИВ»: Предвзятость данныхОбучение на данных

Предвзятость в данных

Стереотипы

Алгоритмы обучаются на

Возможна предвзятость в

Репликация социальных и

человеческих данных.

исходных наборах данных.

культурных стереотипов.

7.

Пример несправедливой оценкиТворческий ответ

Творческий ответ вне шаблона

— ошибка для алгоритма.

Нестандартный ответ

Ученик пишет нестандартно —

ИИ снижает балл.

Поведенческая аномалия

Поведенческая «аномалия»

интерпретируется как риск.

8.

Отсутствие эмпатии и контекстаМашина по формуле

Неучет стресса

Непонимание мотивации

ИИ не понимает мотивацию,

обстоятельства, эмоции.

Нельзя объяснить поступок

ученика или учесть стресс.

Человек сочувствует — машина

оценивает по формуле.

9.

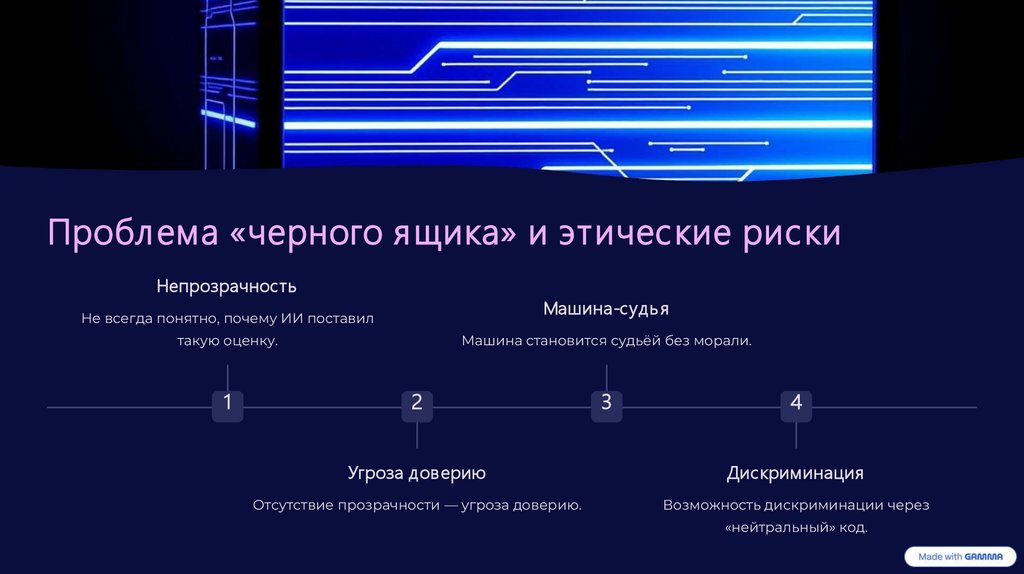

Проблема «черного ящика» и этические рискиНепрозрачность

Машина-судь я

Не всегда понятно, почему ИИ поставил

Машина становится судьёй без морали.

такую оценку.

1

2

3

4

Угроза доверию

Дискриминация

Отсутствие прозрачности — угроза доверию.

Возможность дискриминации через

«нейтральный» код.

10.

Вывод: ИИ как инструмент, а не судьяРешение — в контроле, корректировке и сочетании с человеческим участием. Нужно не заменить человека, а

усилить его возможности. ИИ может повысить точность, но не заменит справедливость. Только в

сотрудничестве с человеком технологии становятся этичными.

informatics

informatics