Similar presentations:

Основные понятия искусственных нейронных сетей. (Лекция 2)

1.

Лекция 2.Тема: “Основные понятия искусственных

нейронных сетей”

2.

Рис.2.1 – Структура искусственного нейрона3.

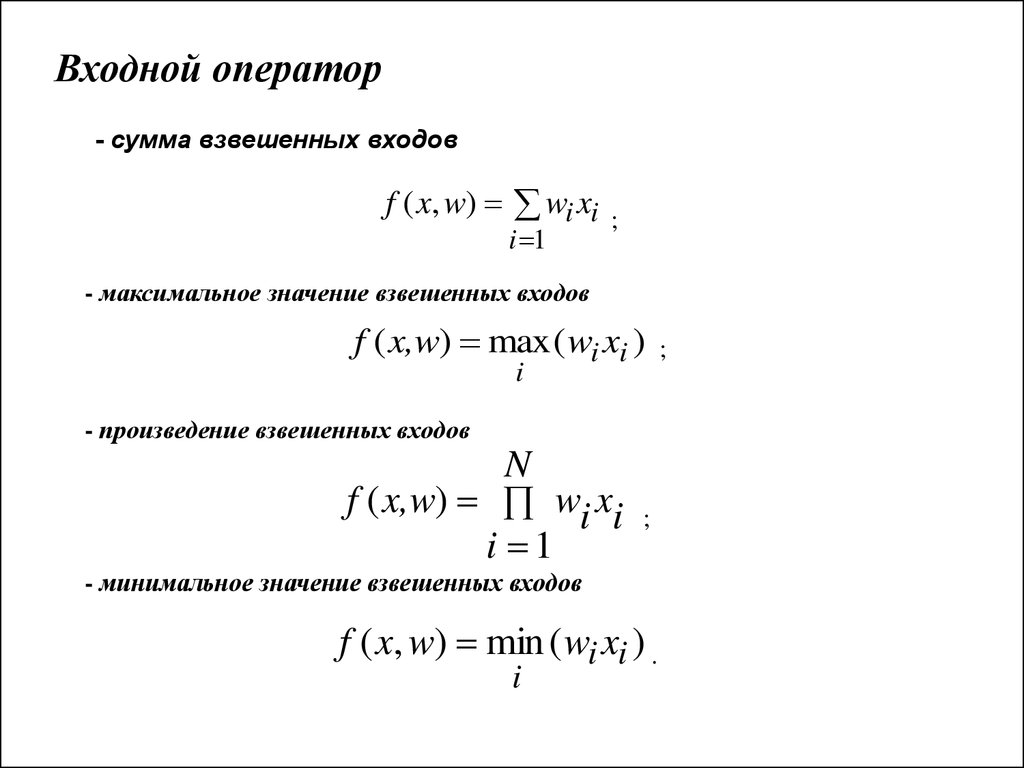

Входной оператор- сумма взвешенных входов

f ( x, w) wi xi

i 1

;

- максимальное значение взвешенных входов

f ( x,w) max ( wi xi )

i

- произведение взвешенных входов

N

f ( x,w) wi xi

i 1

;

- минимальное значение взвешенных входов

f ( x, w) min ( wi xi ) .

i

;

4.

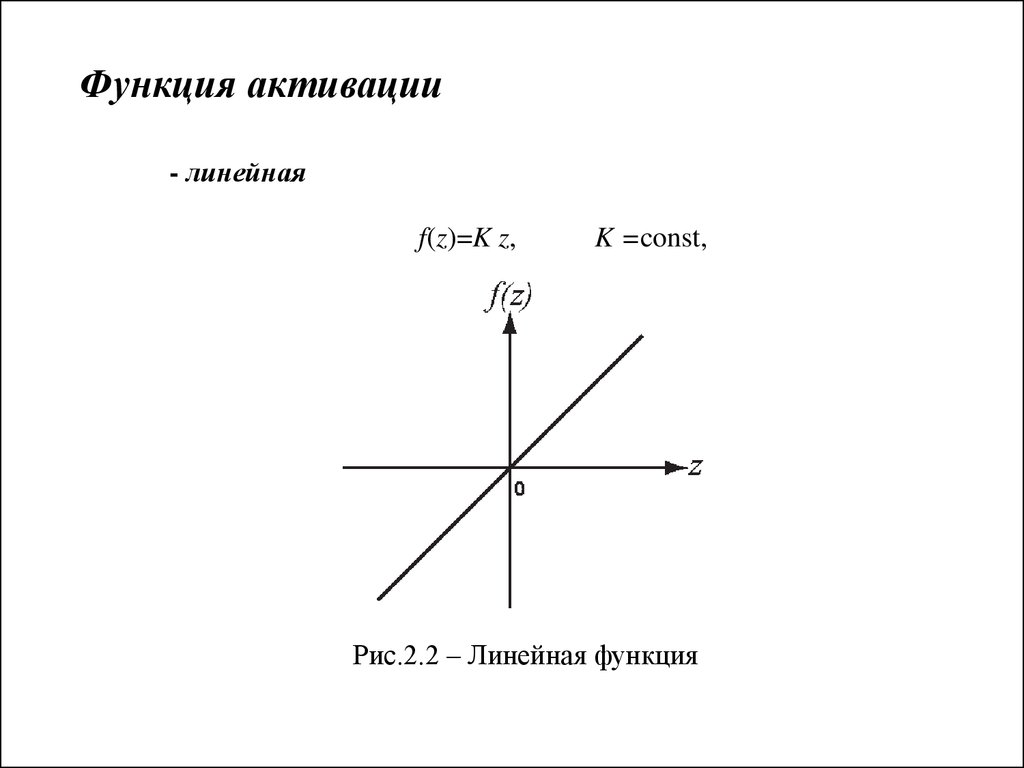

Функция активации- линейная

f(z)=K z,

K =const,

Рис.2.2 – Линейная функция

5.

- линейная биполярная с насыщениемz 2 ;

1 при

f ( z ) kz при 1 z 2 ;

1 при

z 1.

Рис.2.3 – Линейная с насыщением

6.

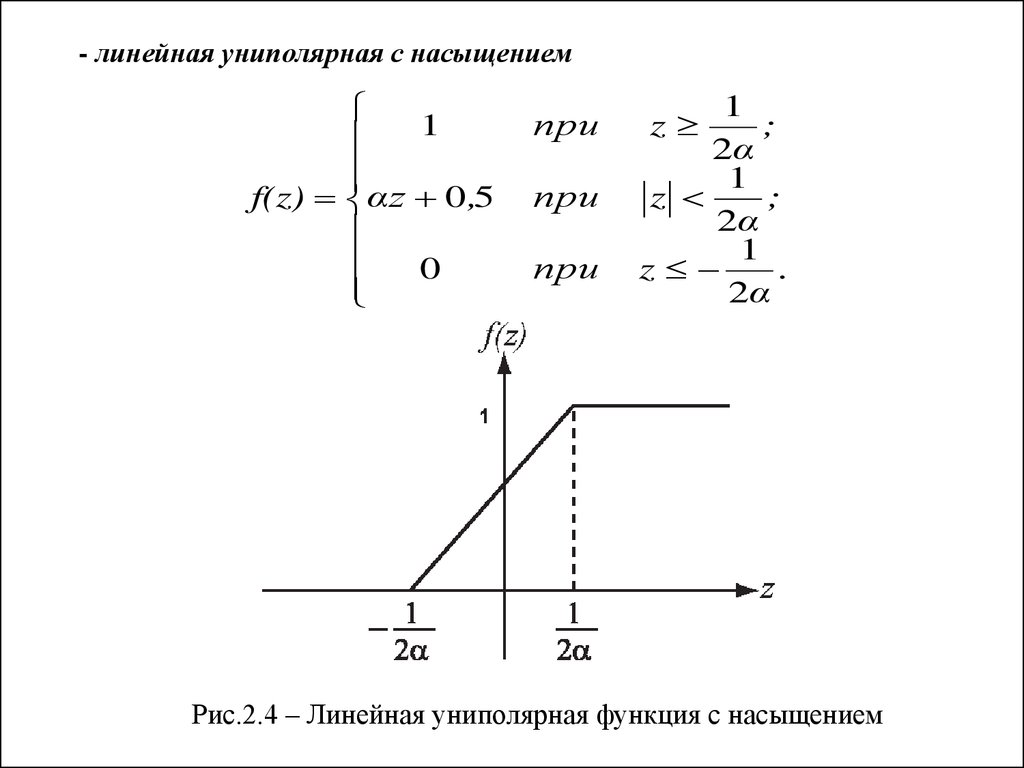

- линейная униполярная с насыщением1

f(z) αz 0 ,5

0

при

при

при

1

;

2α

1

z

;

2α

1

z

.

2α

z

Рис.2.4 – Линейная униполярная функция с насыщением

7.

– функция Хевисайда - униполярная пороговая функция1 при z ;

f ( z)

0 при z .

Рис.2.5 – Пороговая функция

8.

– биполярная пороговая функция1 при z ;

f ( z)

1 при z .

Рис.2.6 – Биполярная пороговая функция

9.

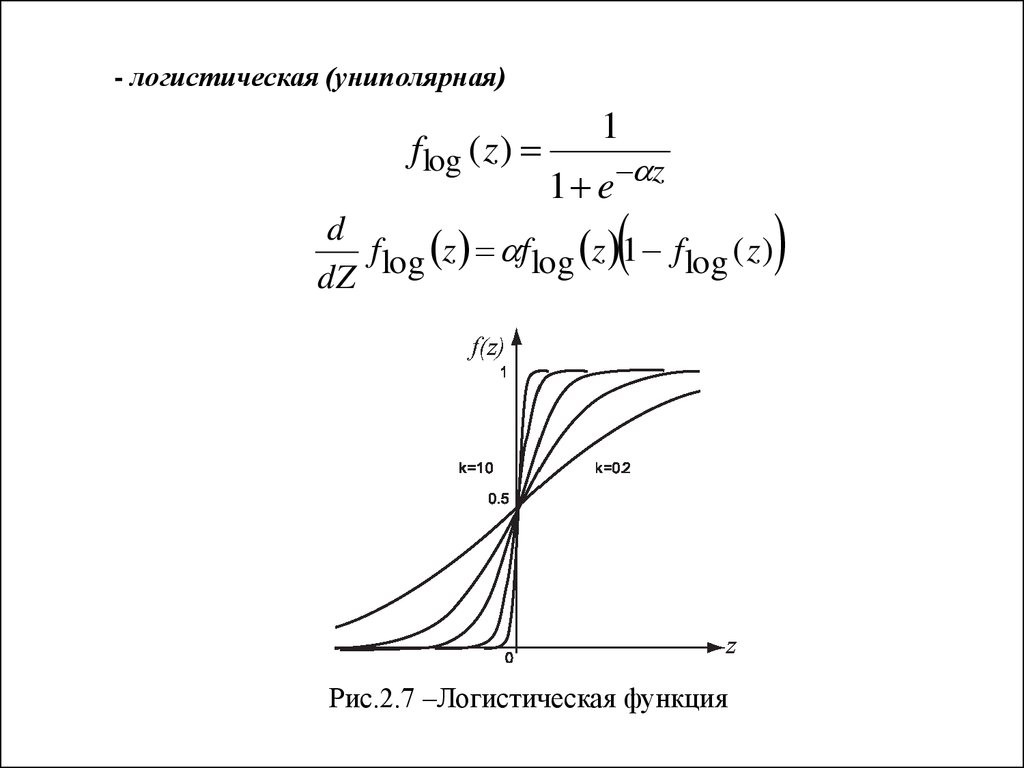

- логистическая (униполярная)f log ( z )

1

1 e z

d

f log z f log z 1 f log ( z )

dZ

Рис.2.7 –Логистическая функция

10.

-гиперболического тангенса (биполярная)fth z tanh z

e z e z

e z e z

d

fth z 1 tanh 2 ( z )

dz

,

Рис. 2.8 – Функция гиперболического тангенса

11.

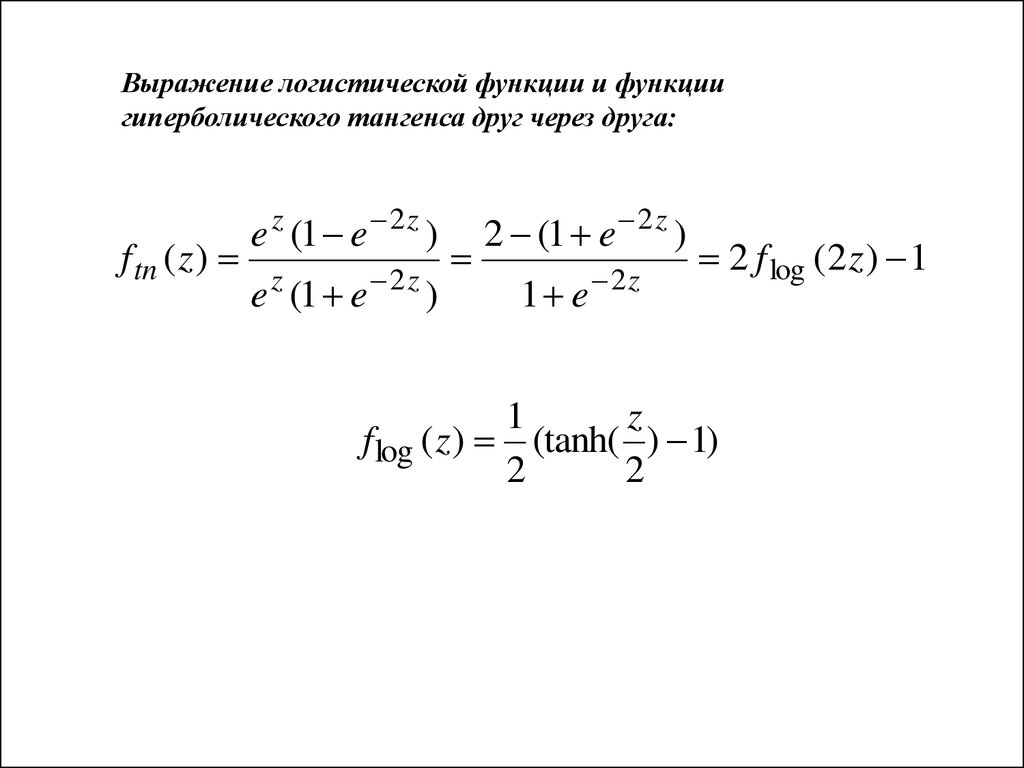

Выражение логистической функции и функциигиперболического тангенса друг через друга:

f tn ( z )

e z (1 e 2 z )

e (1 e

z

2z

)

2 (1 e 2 z )

1 e

2z

2 f log (2 z ) 1

1

z

f log ( z ) (tanh( ) 1)

2

2

12.

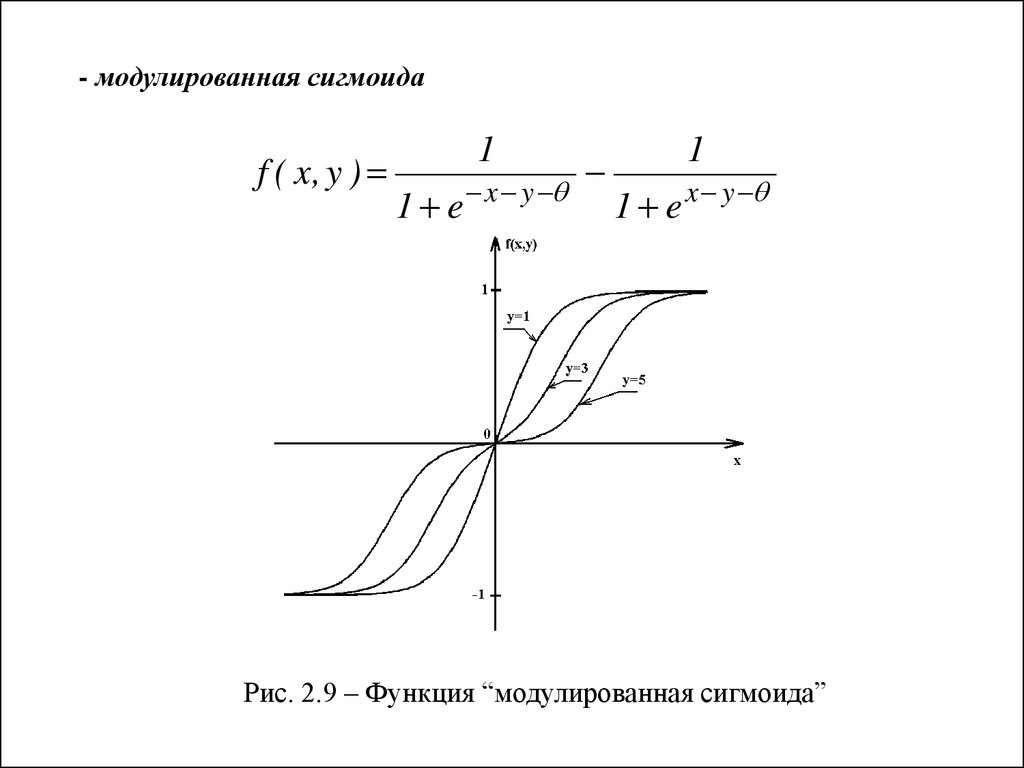

- модулированная сигмоидаf ( x, y )

1

1 e

x y

1

1 e x y

Рис. 2.9 – Функция “модулированная сигмоида”

13.

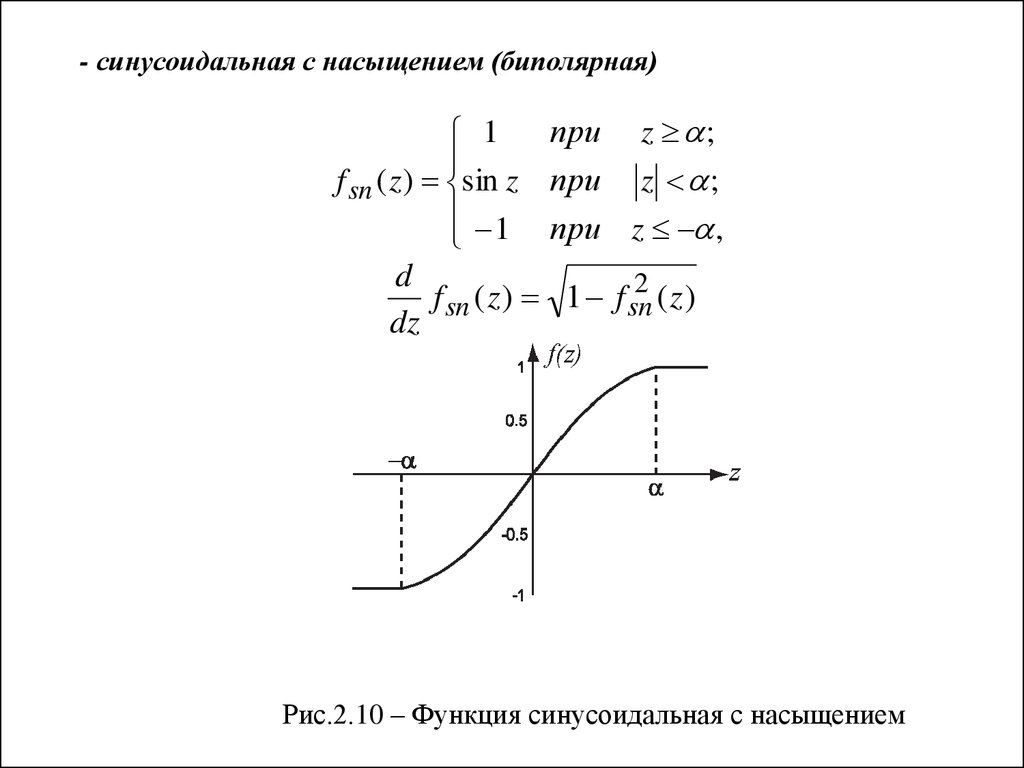

- синусоидальная с насыщением (биполярная)1

f sn ( z ) sin z

1

d

f sn ( z )

dz

при z ;

при z ;

при z ,

2

1 f sn

( z)

Рис.2.10 – Функция синусоидальная с насыщением

14.

- косинусоидальная с насыщением (униполярная)1

1

fCS ( z ) (1 cos(z ))

2

2

0

при z

при z

при z -

2

2

2

;

;

.

Рис.2.11 – Функция косинусоидальная с насыщением

15.

Топология ИНСРис.2.12 – Структура ИНС

16.

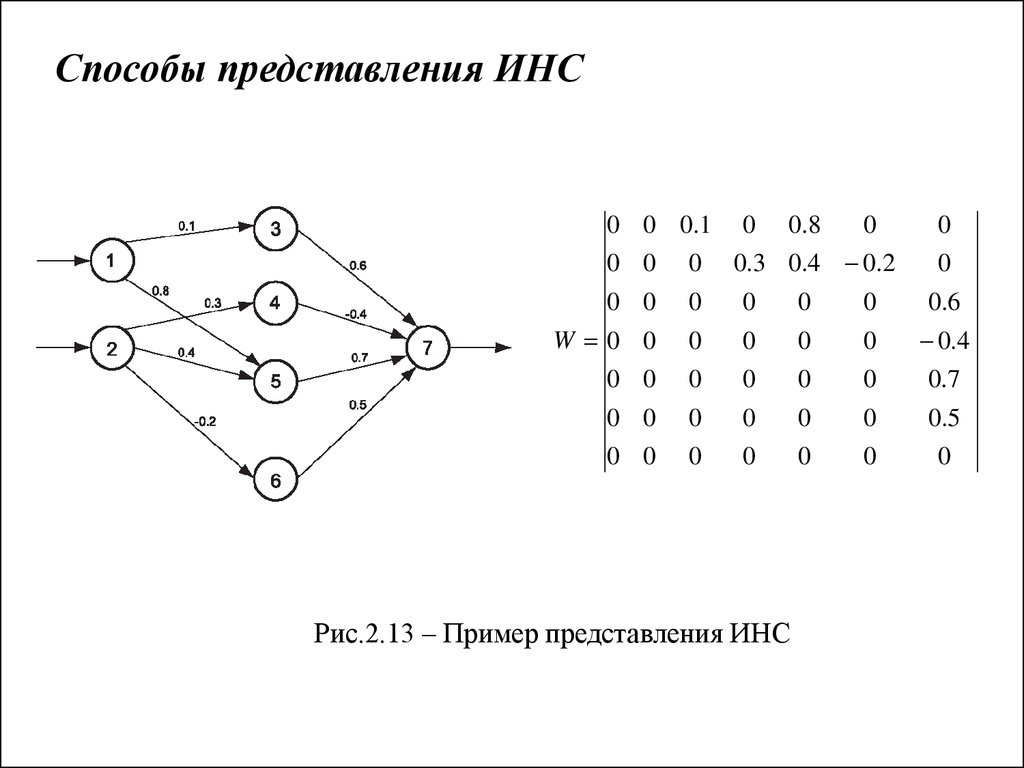

Способы представления ИНС0

0

0

W 0

0

0

0

0 0.1 0 0.8

0

0

0 0 0.3 0.4 0.2

0

0 0

0

0

0

0.6

0 0

0

0

0

0.4

0 0

0

0

0

0.7

0 0

0

0

0

0.5

0 0

0

0

0

0

Рис.2.13 – Пример представления ИНС

17.

Топологии ИНС:1. ИНС без обратных связей (прямого распространения, feed-forvard)

- первого порядка;

- второго порядка (c “shortcut connections”).

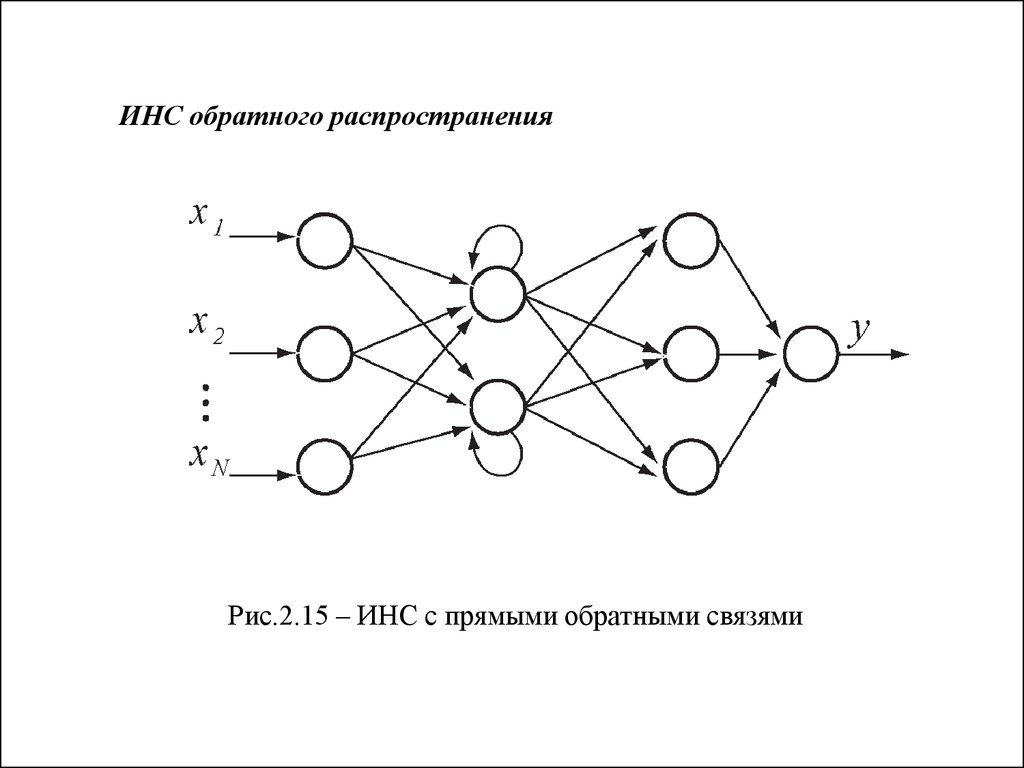

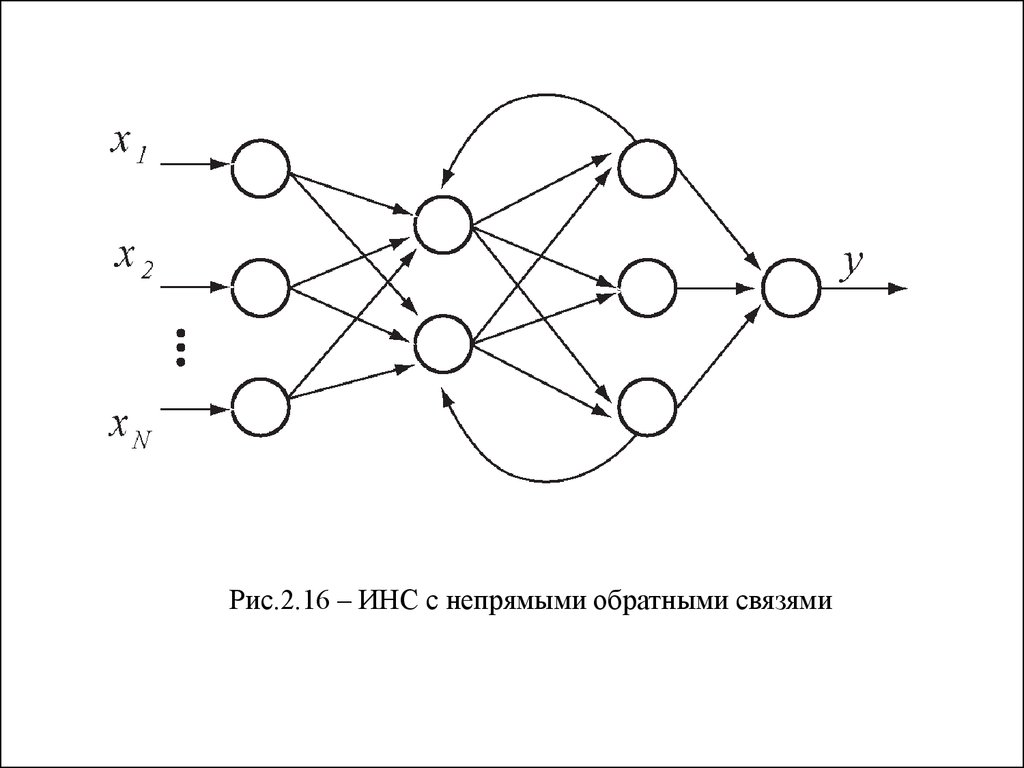

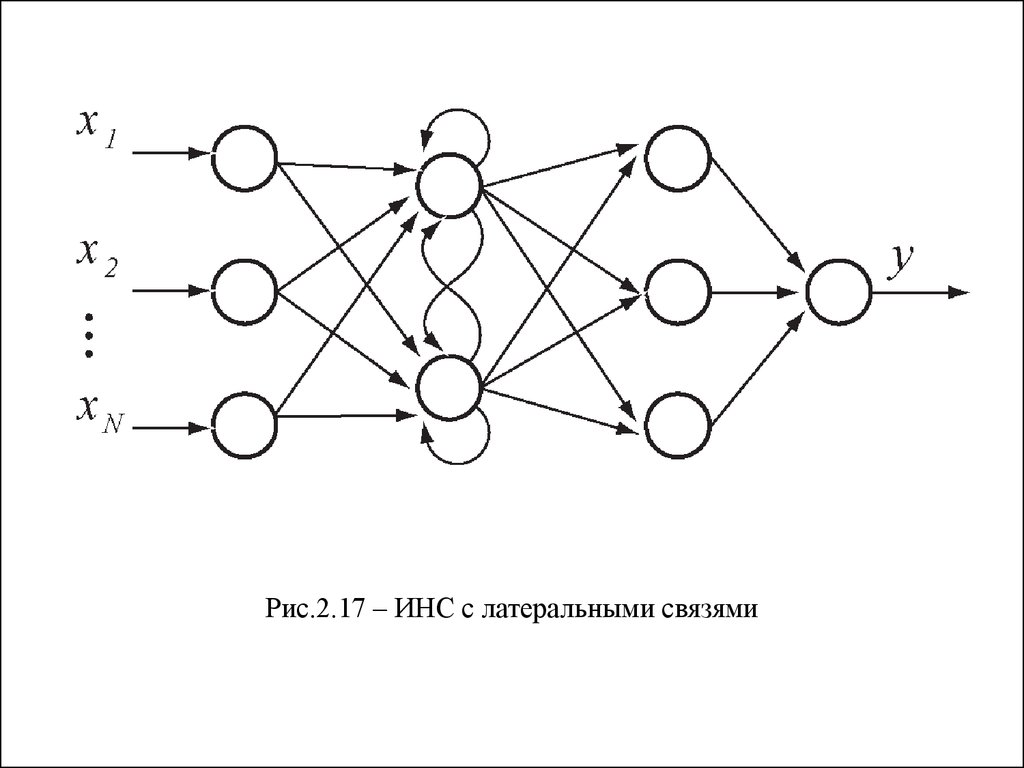

2. ИНС с обратными связями (обратного распространения,

рекуррентные, Feedback)

- с прямыми обратными связями (direct feedback);

- с непрямыми обратными связями (indirect feedback);

- с латеральными связями (lateral feedback);

- полносвязные.

18.

ИНС прямого распространенияРис. 2.14 – ИНС прямого распространения второго порядка

19.

ИНС обратного распространенияРис.2.15 – ИНС с прямыми обратными связями

20.

Рис.2.16 – ИНС с непрямыми обратными связями21.

Рис.2.17 – ИНС с латеральными связями22.

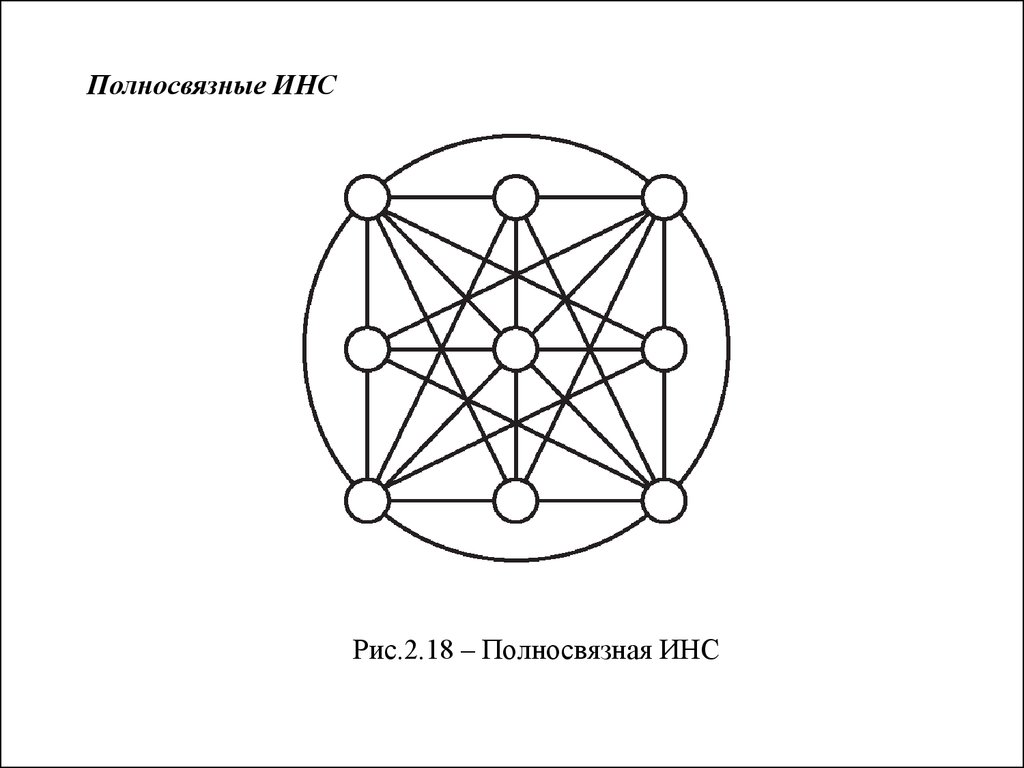

Полносвязные ИНСРис.2.18 – Полносвязная ИНС

23.

Подходы к обучению ИНС:- изменение конфигурации сети путем образования новых

или исключения некоторых существующих связей между

нейронами;

- изменение элементов матрицы связи (весов);

- изменение характеристик нейронов (вида и параметров

активационной функции и т.д.).

24.

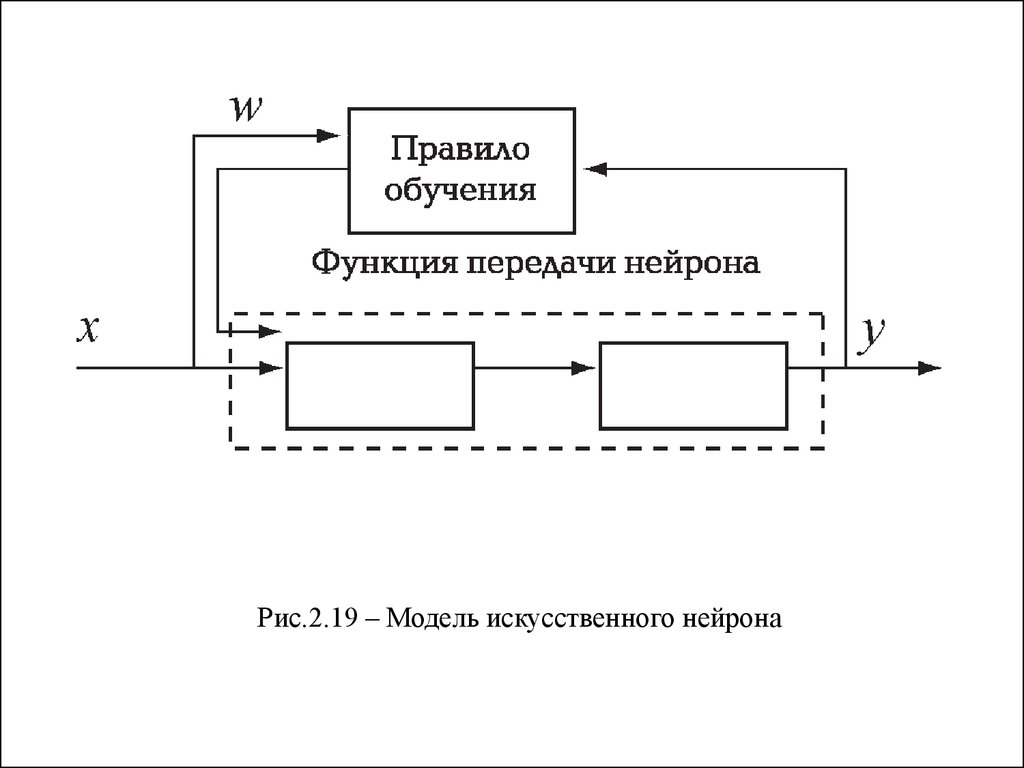

Рис.2.19 – Модель искусственного нейрона25.

Типы обучения ИНС:- Обучение с учителем;

- Обучение без учителя;

- Подкрепляемое обучение.

26.

Правило обучения Хэбба (коррелятивное,соотносительное обучение)

wij xi y j

,

В векторном виде данное правило может быть записано

следующим образом:

для непрерывного времени

для дискретного времени

w

xy

t

w(k 1) w(k ) x(k ) y(k )

.

27.

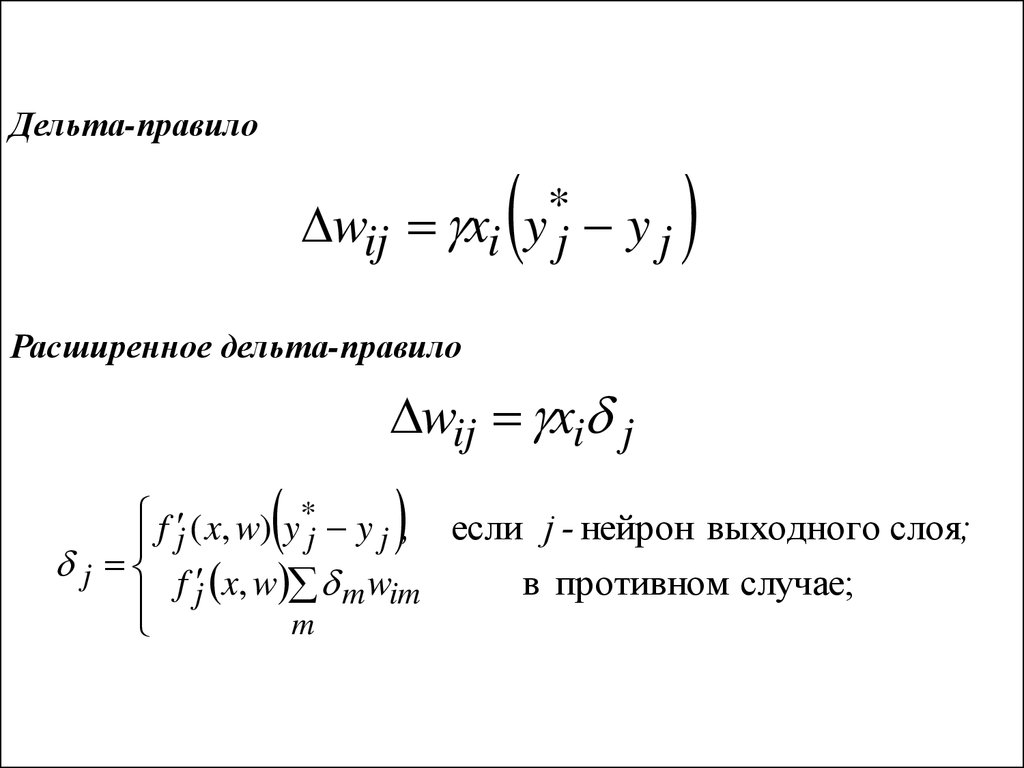

Дельта-правило*

wij xi y j y j

Расширенное дельта-правило

wij xi j

f ( x, w) y* y , если j - нейрон выходного слоя;

j

j

j

j f x, w w

в противном случае;

j

m

im

m

28.

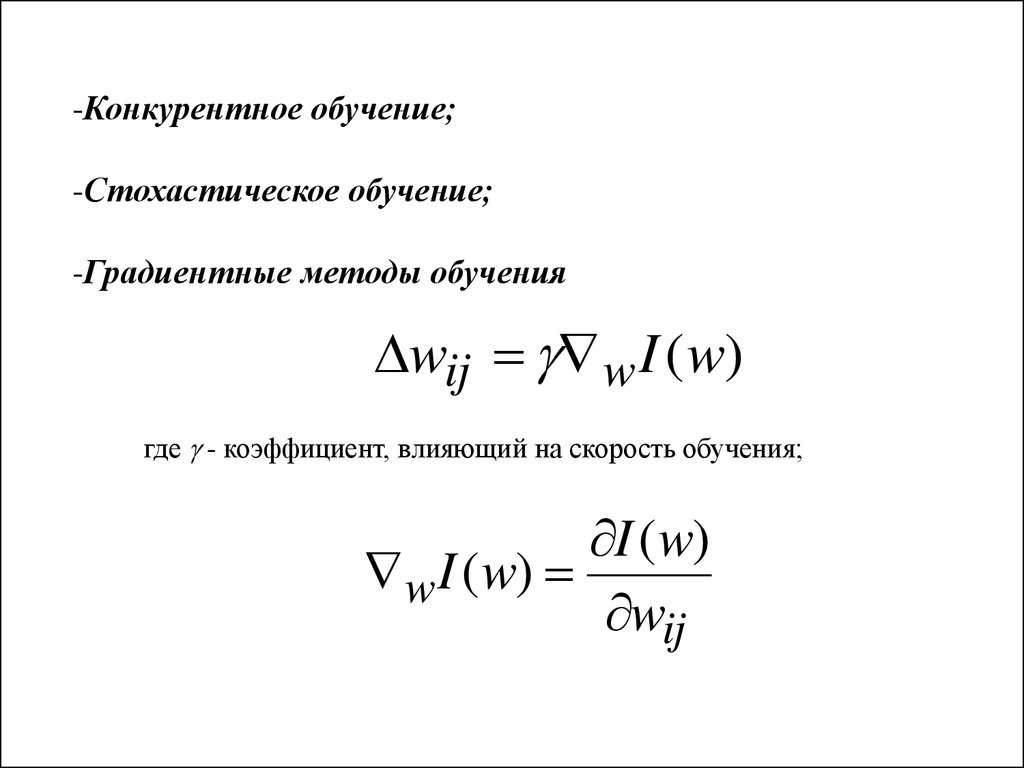

-Конкурентное обучение;-Стохастическое обучение;

-Градиентные методы обучения

wij w I (w)

где - коэффициент, влияющий на скорость обучения;

I ( w)

w I ( w)

wij

29.

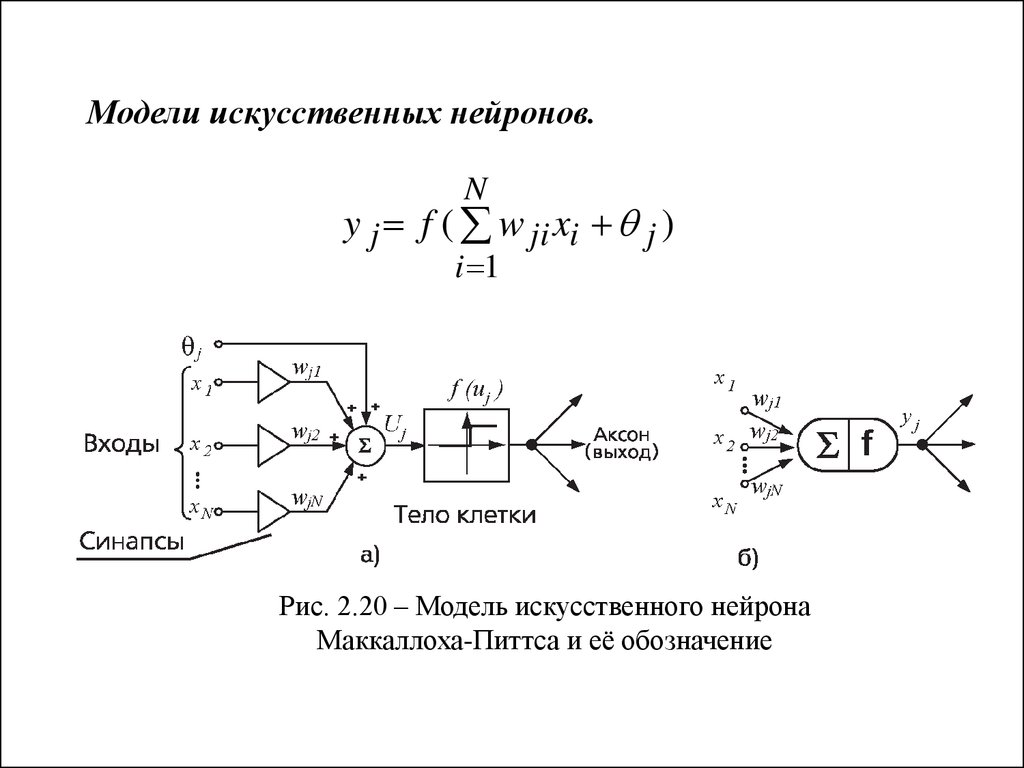

Модели искусственных нейронов.N

y j f ( w ji xi j )

i 1

Рис. 2.20 – Модель искусственного нейрона

Маккаллоха-Питтса и её обозначение

30.

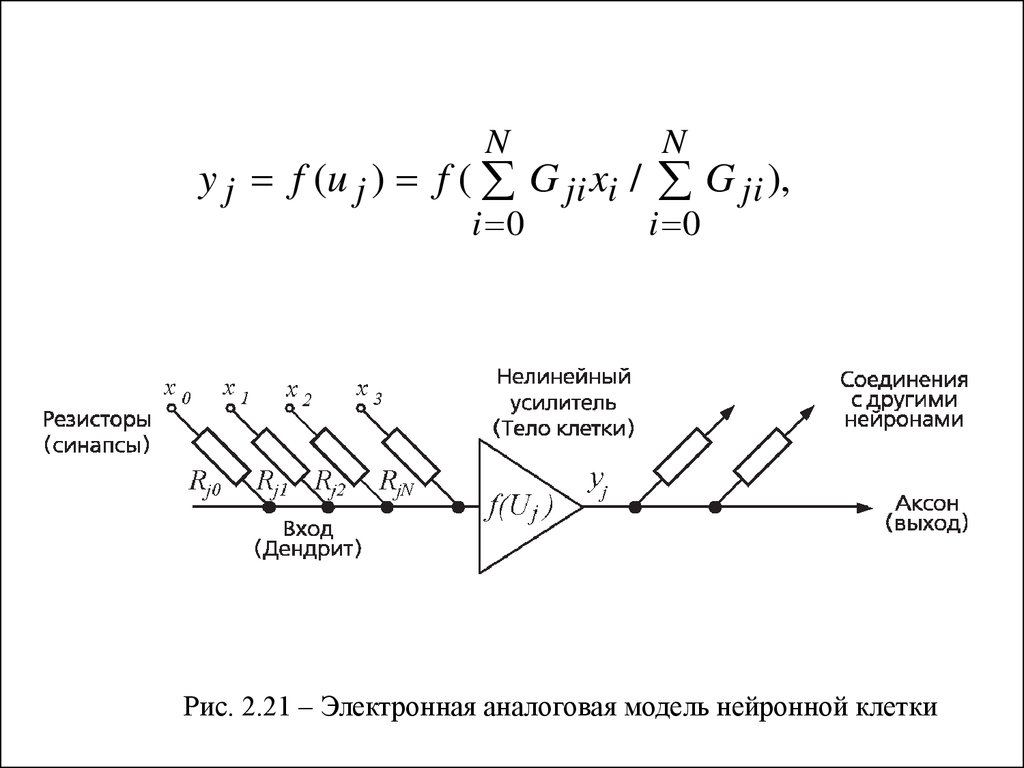

NN

i 0

i 0

y j f (u j ) f ( G ji xi / G ji ),

Рис. 2.21 – Электронная аналоговая модель нейронной клетки

31.

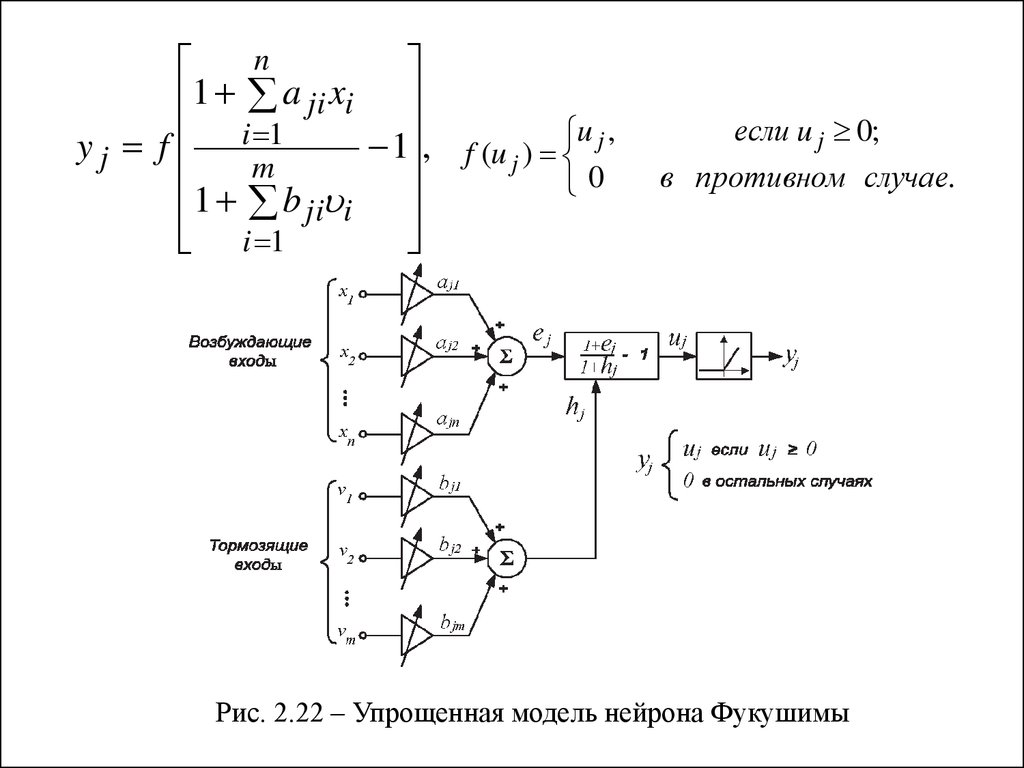

n1 a ji xi

y j f i 1

1 , f (u j ) u j ,

m

0

1 b ji i

i 1

если u j 0;

в противном случае.

Рис. 2.22 – Упрощенная модель нейрона Фукушимы

32.

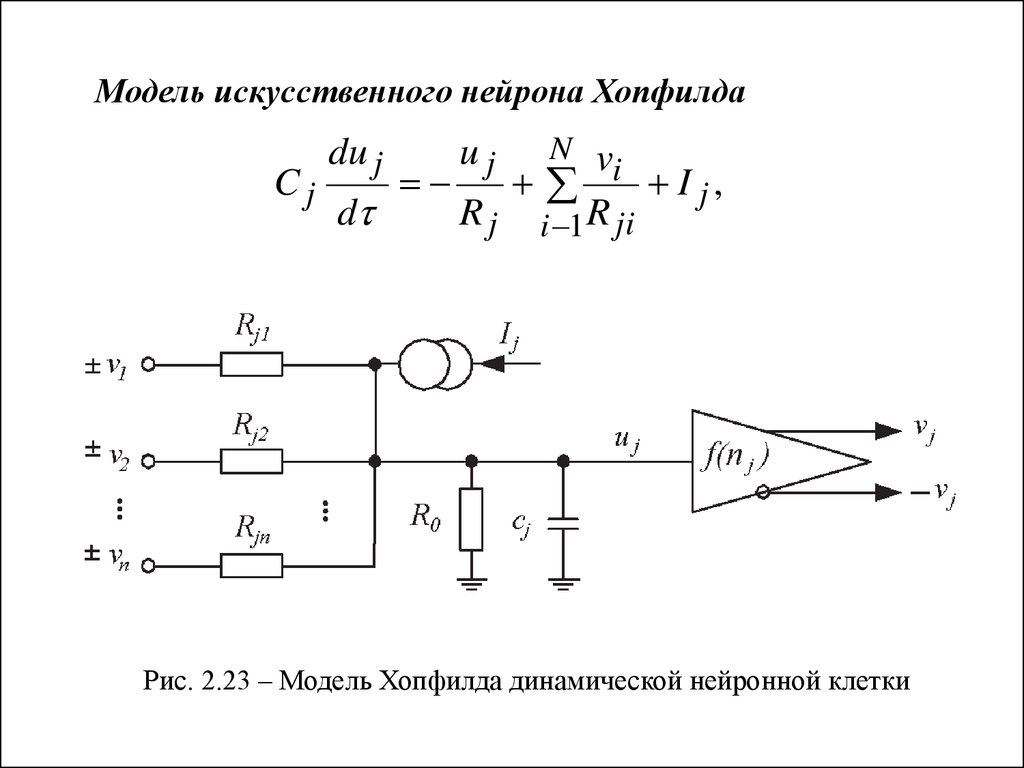

Модель искусственного нейрона ХопфилдаCj

du j

d

N v

i I j,

R j i 1 R ji

uj

Рис. 2.23 – Модель Хопфилда динамической нейронной клетки

33.

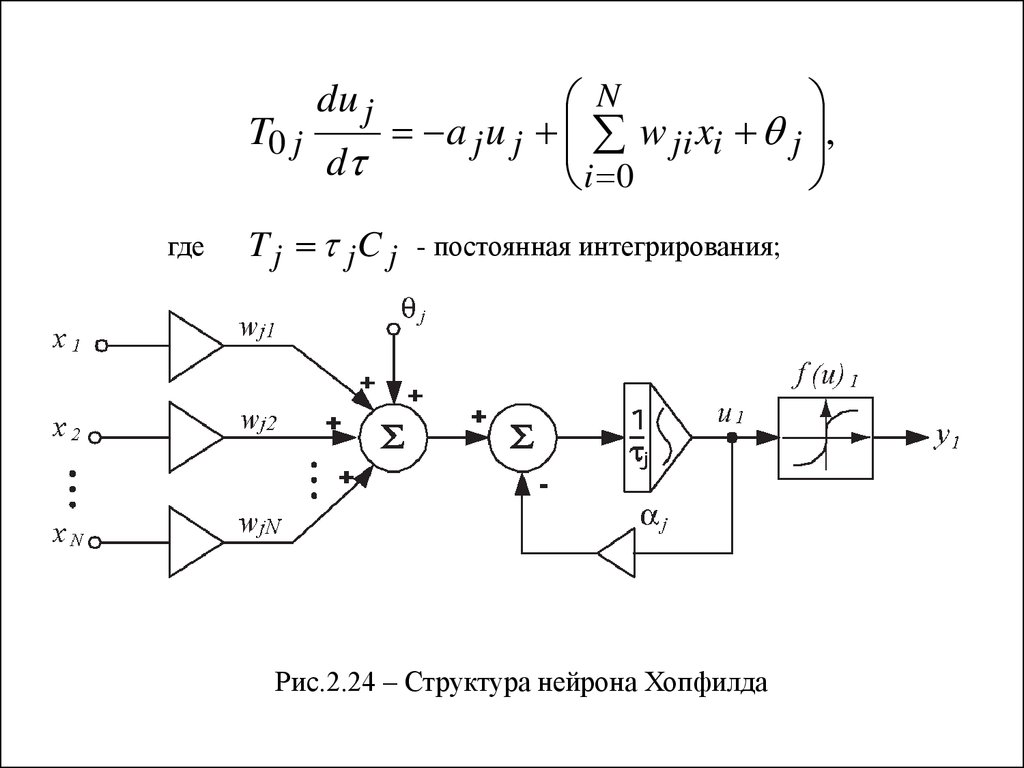

NT0 j

a j u j w ji xi j ,

d

i 0

du j

где

T j jC j

- постоянная интегрирования;

Рис.2.24 – Структура нейрона Хопфилда

34.

Модель Гроссбергаn

Tj

j u j ( j j u j ) w ji fi (ui ), fi (ui , j ) ,

d

i 1

du j

dw ji

d

ji w ji d ji fi (ui )hi (ui )

Рис.2.25 – Функциональная модель нейрона Гроссберга

35.

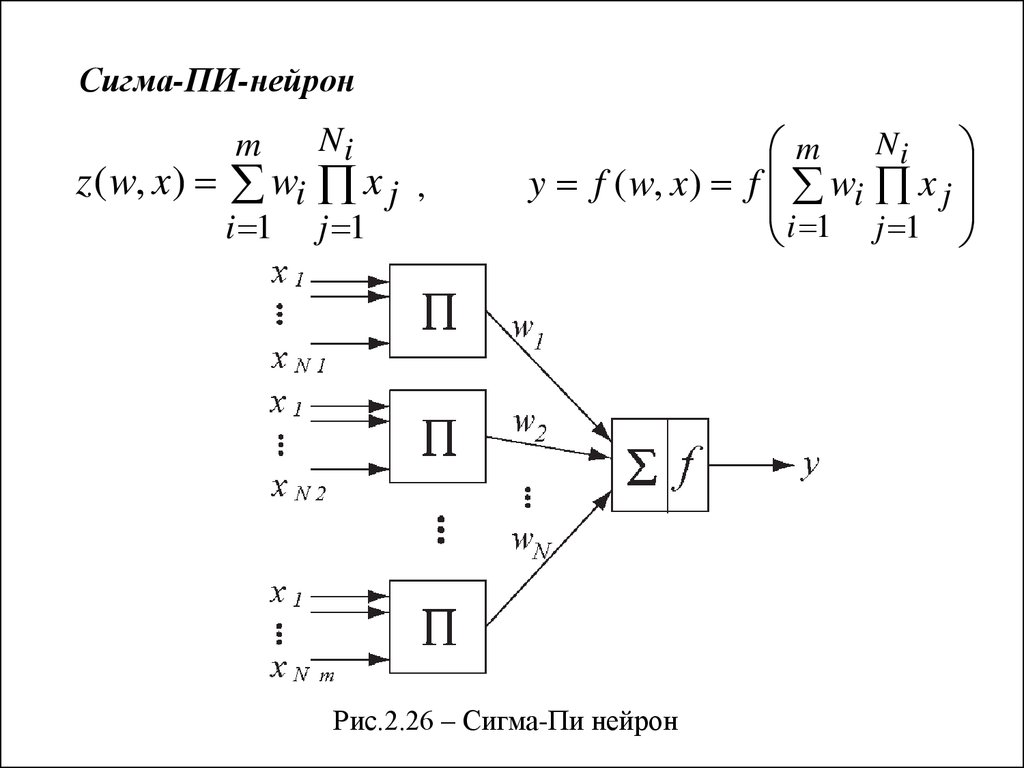

Сигма-ПИ-нейронm

Ni

i 1

j 1

z ( w, x) wi x j ,

m Ni

y f ( w, x) f wi x j

i 1 j 1

Рис.2.26 – Сигма-Пи нейрон

36.

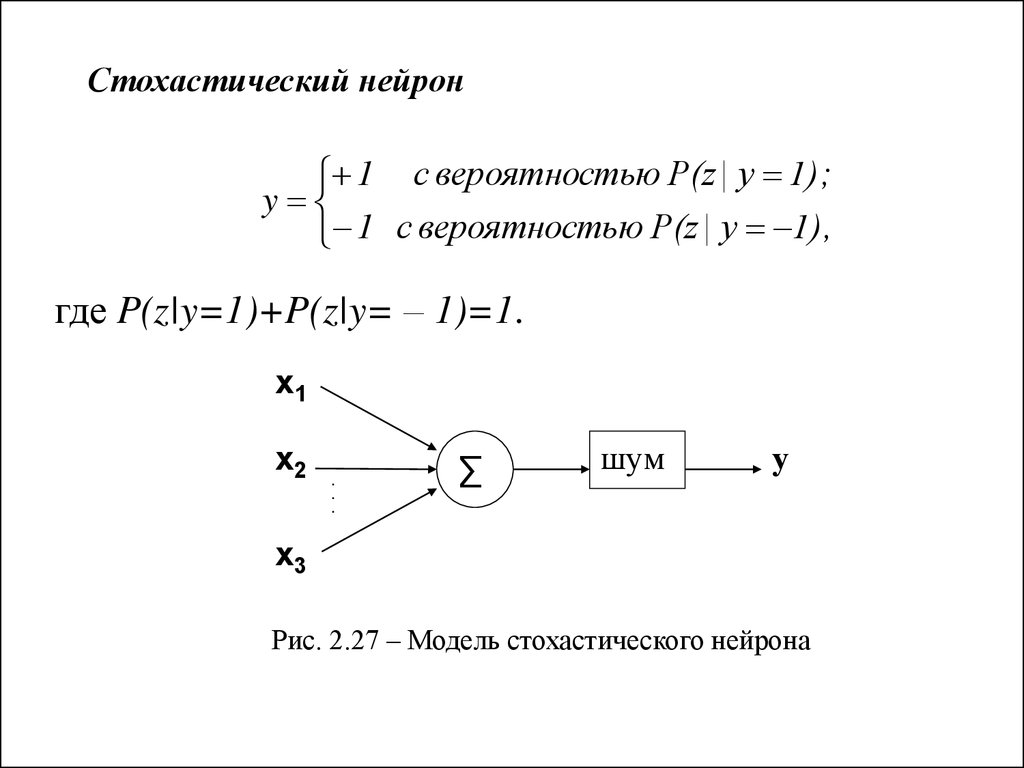

Стохастический нейрон1 с вероятностью P(z | y 1);

y

1 с вероятностью P(z | y 1),

где P(z|y=1)+P(z|y= – 1)=1.

x1

x2

.

.

.

∑

шум

у

x3

Рис. 2.27 – Модель стохастического нейрона

mathematics

mathematics biology

biology