Similar presentations:

Вычислительные возможности нейронных сетей

1. Вычислительные возможности нейронных сетей

М.Г.КузьминаИнститут прикладной математики им. М.В.Келдыша РАН

2. План

1. Предмет теория нейронных сетей. Искусственные нейронные сети.2. Биологический прототип: нейронные структуры мозга.

3. Сети из формальных нейронов. Типы сетевых архитектур.

Формальный нейрон МакКаллока и Питтса

Однослойный персептрон

Многослойный персептрон

Рекуррентные сети

Реализация произвольной функции трехслойной сетью

4. Сети ассоциативной памяти.

• Сети гетеро- и авто-ассоциативной памяти

• Подавление шумов сетями гетеро-ассоциативной памяти

5. Сеть Хопфилда. Связь со спиновыми системами.

6. Обучение нейронных сетей.

• Алгоритмы “delta-rule” и “back-propagation”

• Алгоритмы обучения для рекуррентных сетей

• Типичные трудности градиентных методов обучения

7. Динамические нейронные сети и нейроморфное моделирование.

8. Нейрокомпьютеры

9. Некоторые направления современных исследований

3. Теория нейронных сетей: предмет

Хорошо известно, что человеческий мозг по своим возможностям далеко превосходит обычные компьютерыпри решении многих задач. Кроме того, мозг обладает еще целым рядом особенностей, которые ставят его вне

конкуренции по сравнению с современными компьютерами, а также с лучшими приборами, созданными

человеком. Это следующие особенности, которые были выработаны биологическими нейронными сетями в

процессе биологической эволюции в течении 600 млн. лет:

надежность и устойчивость к повреждениям;

способность к адаптации и обучению;

способность иметь дело с неполной, избыточной, зашумленной информацией;

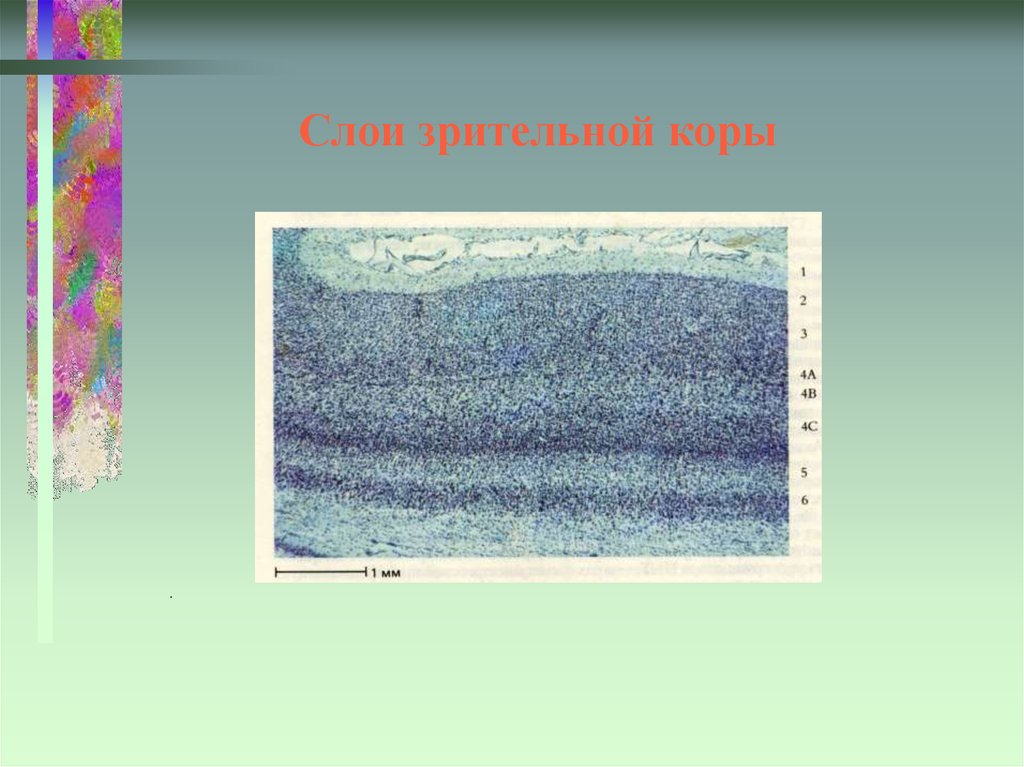

высокая степень параллельности при функционировании;

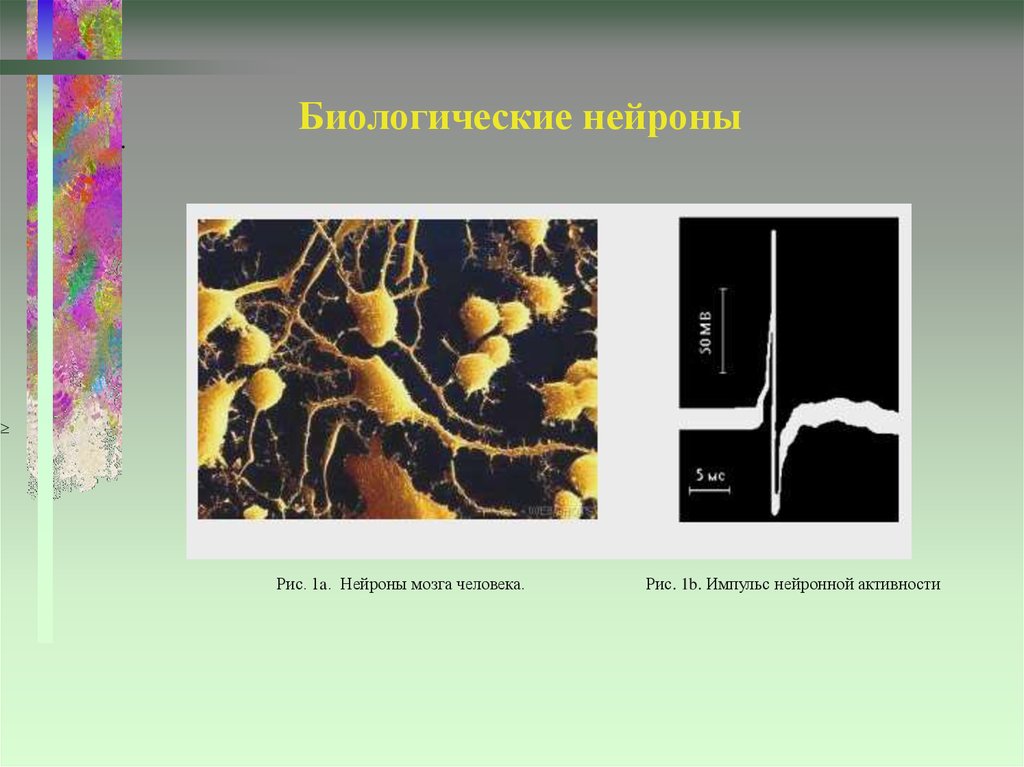

очень низкие энергетические затраты.

При этом все процессы обработки информации выполняются биологическими системами автоматически, без

какого-либо напряжения сознания или специального управления.

Мозг – высоко распараллеленная система, в которой информация передается в виде пространственно-временных

структур нервного возбуждения. Это значительно более гибкий и эффективный способ обработки информации,

чем тот, который используется в современных традиционных компьютерах (несмотря на то, что скорость работы

5

нейронов в 10 раз меньше, чем скорость работы транзисторов).

Способность к обучению – адаптации к условиям и возможностям в изменяющейся внешней среде – столь

важная особенность нейронных сетей, что теперь присоединена в качестве отдельного пункта к так называемому

«тесту Тьюринга», являющемуся операционным определением понятия интеллект.

Основные цели исследований в области теории нейронных сетей – выяснение принципов работы мозга, а

также изучение общих возможностей систем, осуществляющих параллельную распределенную обработку

информации. Основное средство – построение и изучение моделей искусственных нейронных сетей.

Одна из основных целей – создание нейрокомпьютеров.

4. Искусственные нейронные сети

Искусственная нейронная сеть – массивный параллельный распределенныйпроцессор, в котором заложены возможности для хранения и воспроизведения

информации, и который имеет сходство с мозгом в двух отношениях:

1) информация приобретается посредством процесса обучения;

2) хранение информации является распределенным и осуществляется в форме

распределения связей между элементами сети.

(S.Haykin, 1994)

Сеть состоит из большого числа простых активных элементов, каждый из которых оперирует

только локальной информацией. Вся сеть осуществляет параллельную обработку

информации.

Термин «нейронная» отражает тот факт, что объект возник под влиянием представления

о биологических нейронных сетях.

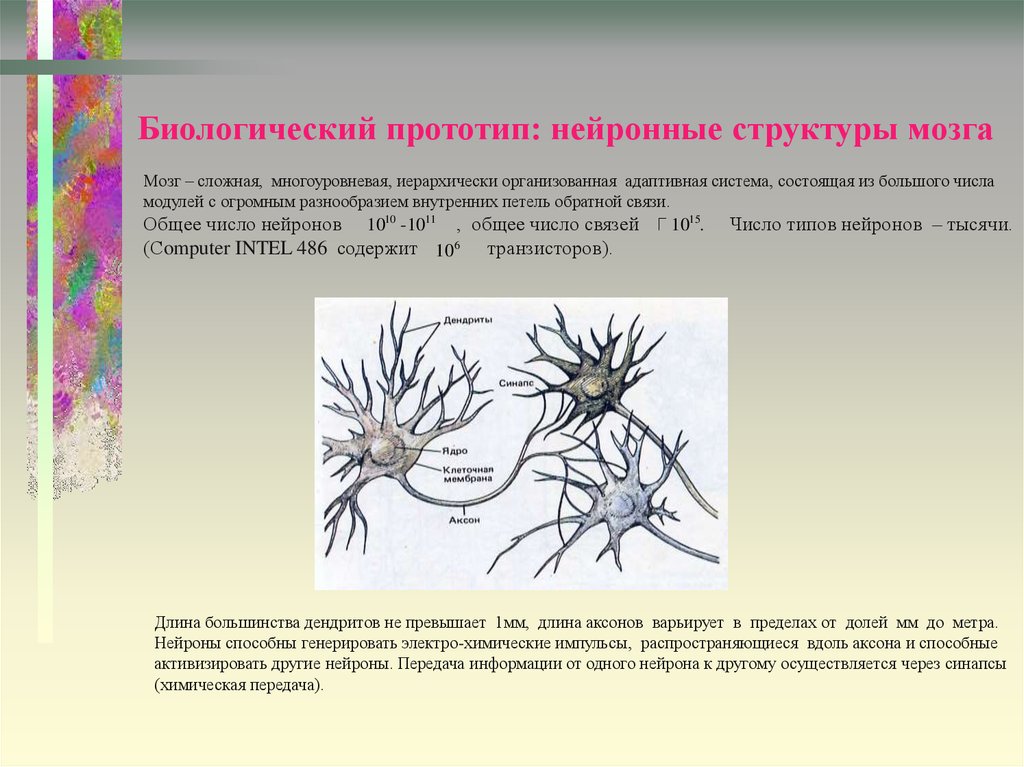

5. Биологический прототип: нейронные структуры мозга

Мозг – сложная, многоуровневая, иерархически организованная адаптивная система, состоящая из большого числамодулей с огромным разнообразием внутренних петель обратной связи.

1015. Число типов нейронов – тысячи.

Общее число нейронов 1010 -1011 , общее число связей

(Сomputer INTEL 486 содержит 106

транзисторов).

Длина большинства дендритов не превышает 1мм, длина аксонов варьирует в пределах от долей мм до метра.

Нейроны способны генерировать электро-химические импульсы, распространяющиеся вдоль аксона и способные

активизировать другие нейроны. Передача информации от одного нейрона к другому осуществляется через синапсы

(химическая передача).

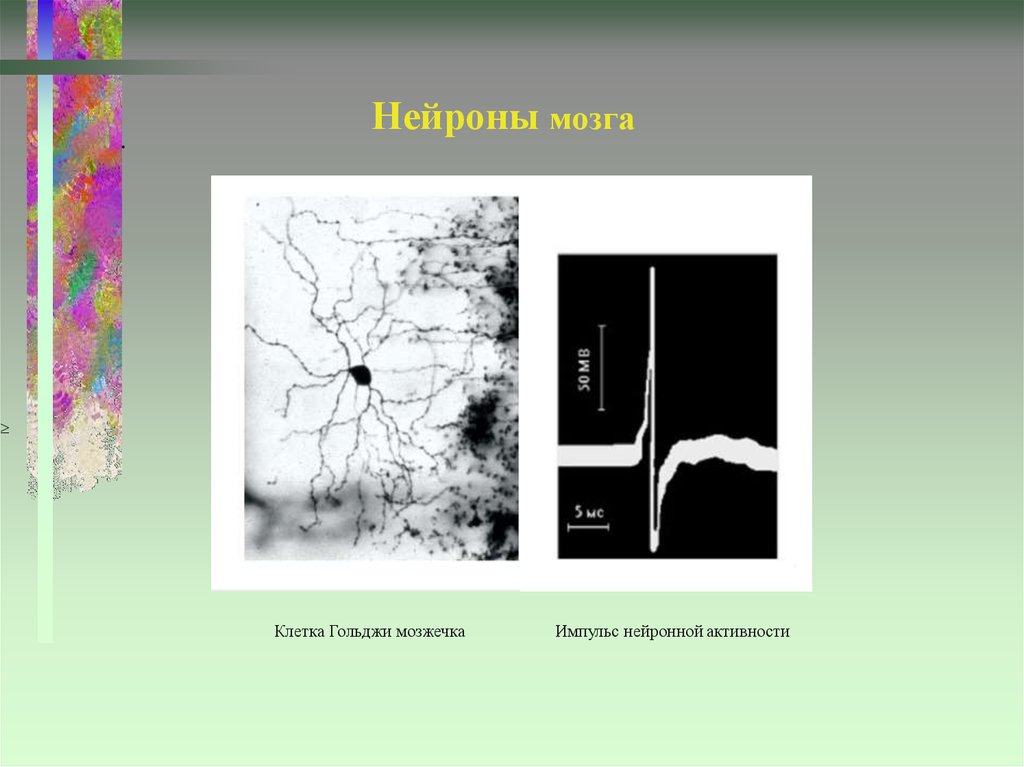

6. Нейроны мозга

.Нейроны мозга

Клетка Гольджи мозжечка

Импульс нейронной активности

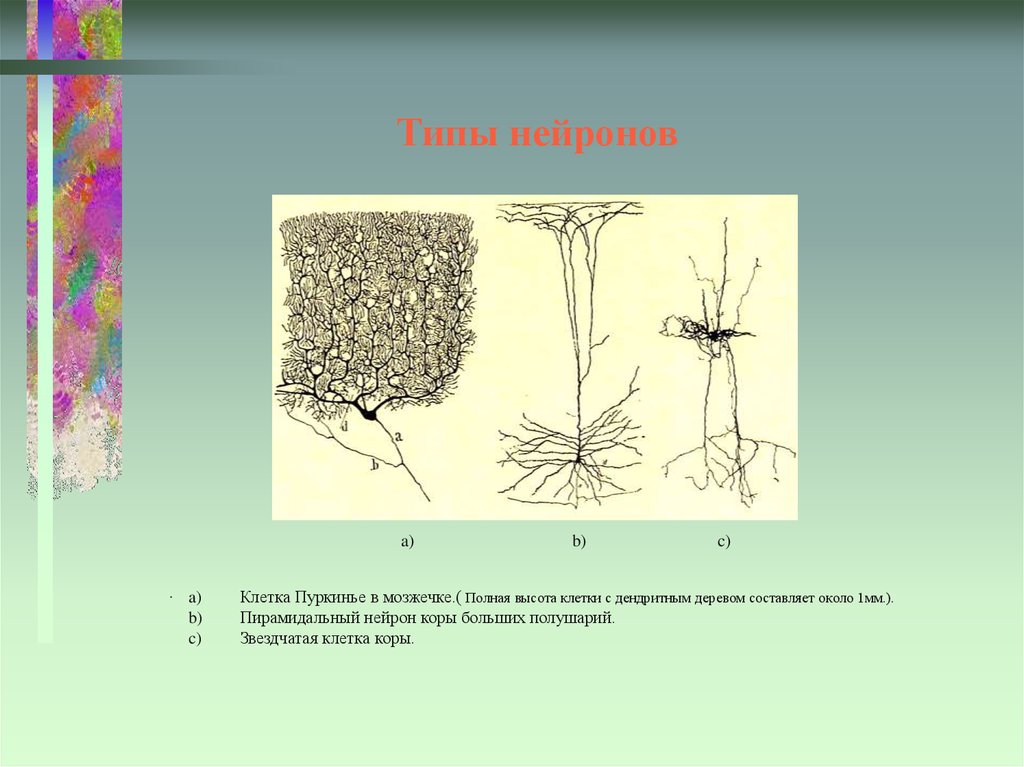

7. Типы нейронов

a).

a)

b)

c)

b)

c)

Клетка Пуркинье в мозжечке.( Полная высота клетки с дендритным деревом составляет около 1мм.).

Пирамидальный нейрон коры больших полушарий.

Звездчатая клетка коры.

8. Нейроны зрительной коры мозга

Пирамидальные нейроны первичной зрительной коры обезьяны (использована окраска по Гольджи,при которой видна лишь очень малая доля всех нервных клеток). Размер рисунка по вертикали на

левой половине рисунка соответствует 1мм.

На правой части рисунка на микрофотографию

наложено изображение типичного вольфрамового электрода, применяемого при внеклеточной

регистрации нейронной активности.

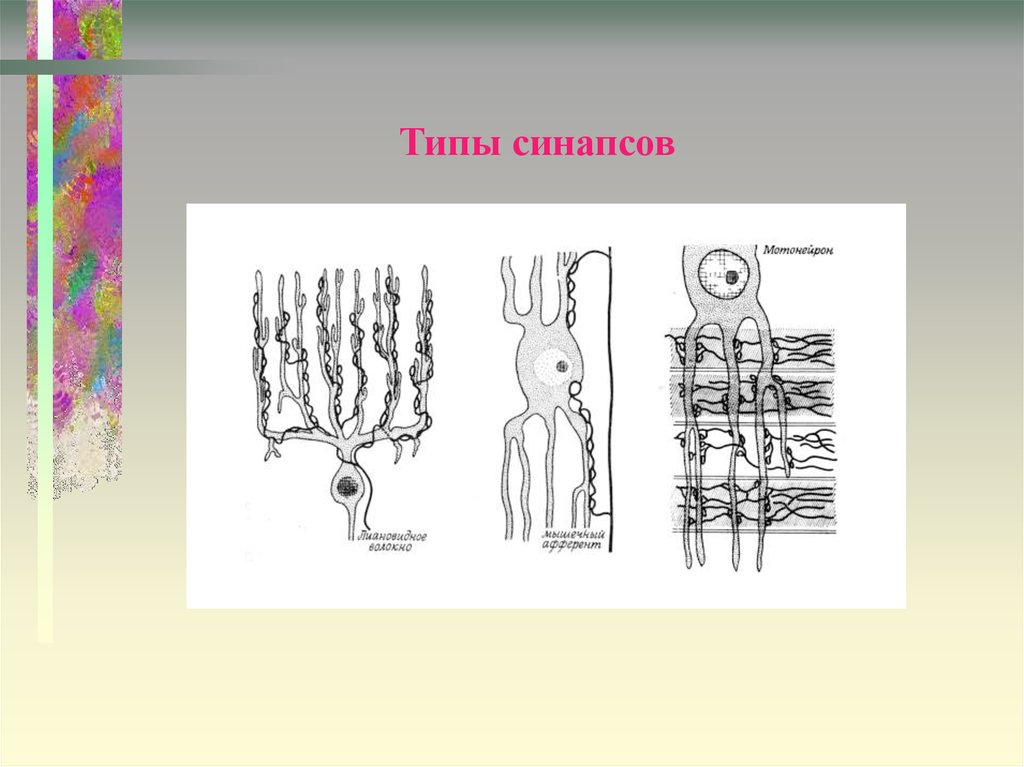

9. Типы синапсов

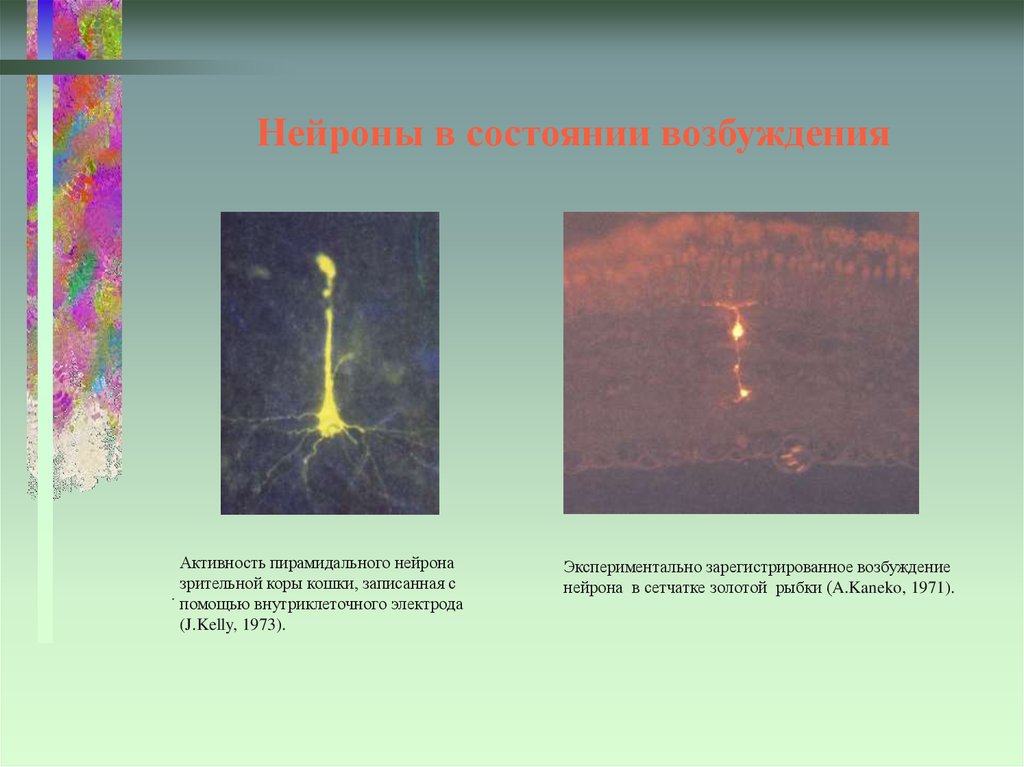

10. Нейроны в состоянии возбуждения

Активность пирамидального нейроназрительной коры кошки, записанная с

.

помощью внутриклеточного электрода

(J.Kelly, 1973).

Экспериментально зарегистрированное возбуждение

нейрона в сетчатке золотой рыбки (A.Kaneko, 1971).

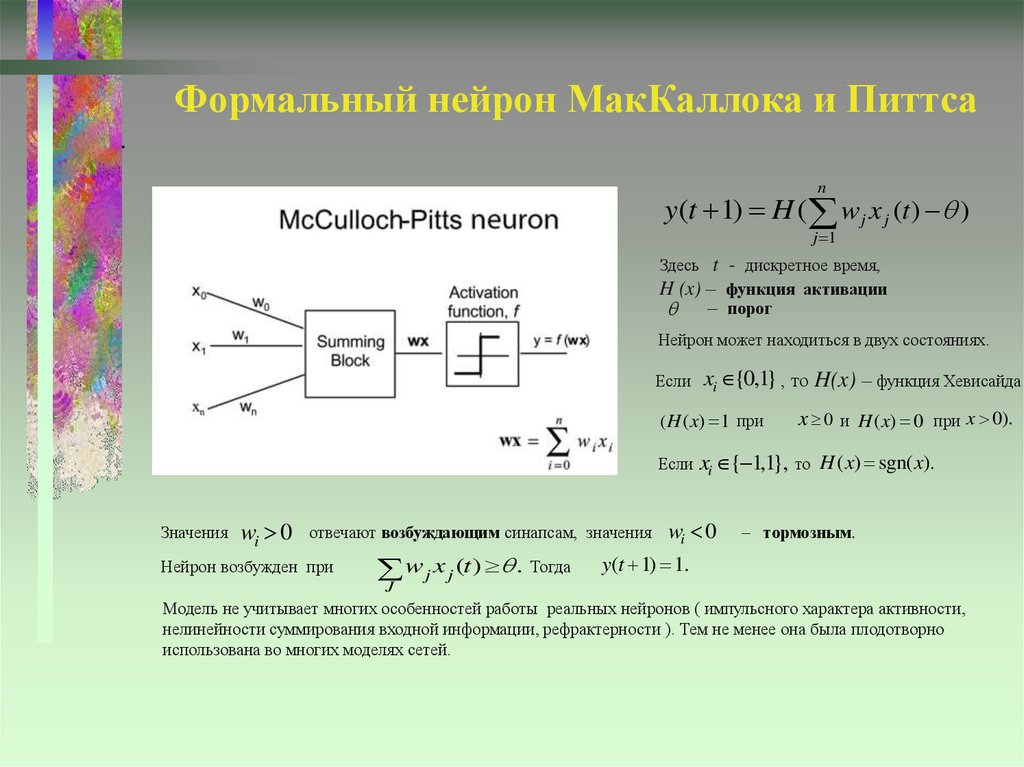

11. Формальный нейрон МакКаллока и Питтса

.n

y(t 1) H ( w j x j (t ) )

j 1

Здесь t - дискретное время,

H (x) – функция активации

– порог

Нейрон может находиться в двух состояниях.

Если

xi {0,1} , то H(x) – функция Хевисайда

( H ( x) 1 при

x 0 и H ( x) 0 при x 0).

Если xi { 1,1}, то H ( x) sgn( x).

Значения

wi 0

отвечают возбуждающим синапсам, значения

Нейрон возбужден при

w j x j (t ) . Тогда

J

wi 0

– тормозным.

y(t 1) 1.

Модель не учитывает многих особенностей работы реальных нейронов ( импульсного характера активности,

нелинейности суммирования входной информации, рефрактерности ). Тем не менее она была плодотворно

использована во многих моделях сетей.

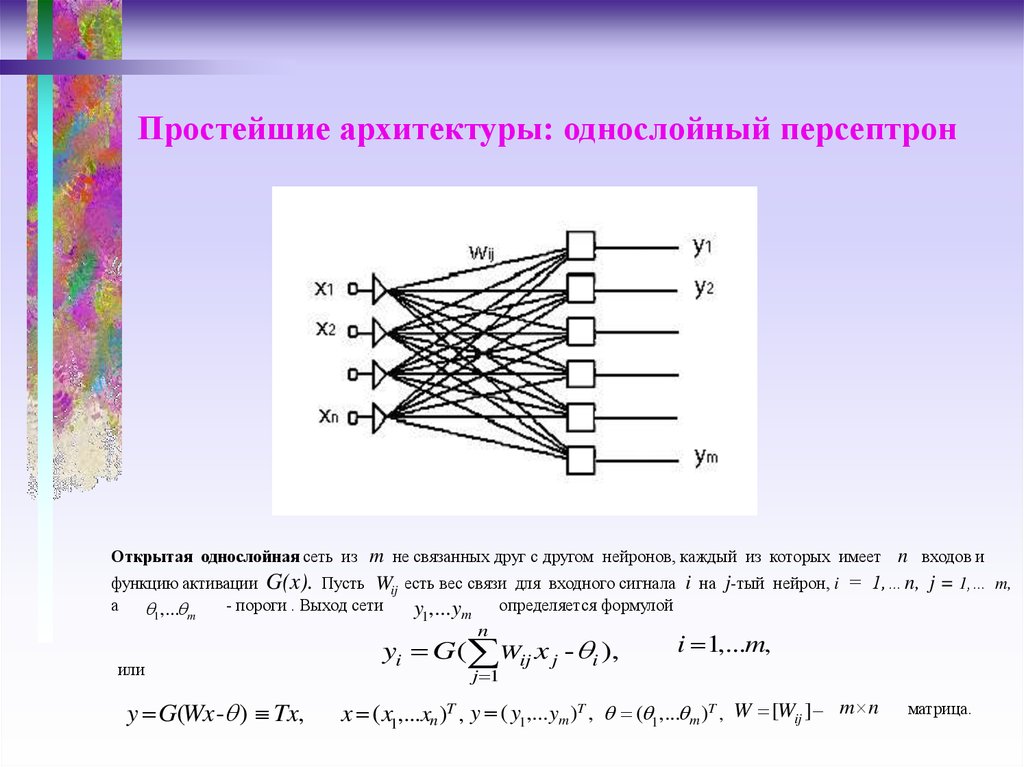

12. Простейшие архитектуры: однослойный персептрон

Открытая однослойная сеть из m не связанных друг с другом нейронов, каждый из которых имеет n входов ифункцию активации G(x). Пусть Wij есть вес связи для входного сигнала i на j-тый нейрон, i = 1,…n, j = 1,… m,

а

- пороги . Выход сети

y1,... ym определяется формулой

1,... m

n

или

y G(Wx - ) Tx,

yi G( Wij x j - i ),

i 1,...m,

j 1

x ( x1,...xn )T , y ( y1,... ym )T , ( 1,... m )T , W [Wij ] m n

матрица.

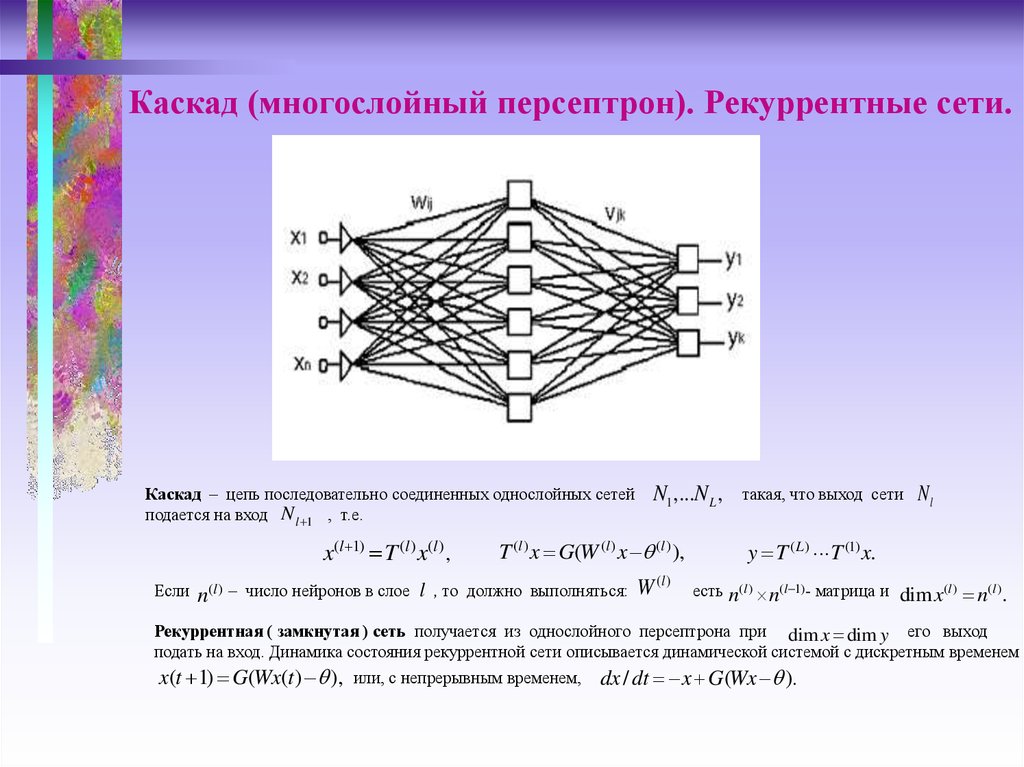

13. Каскад (многослойный персептрон). Рекуррентные сети.

Каскад – цепь последовательно соединенных однослойных сетейподается на вход N l 1 , т.е.

x(l 1) T (l ) x(l ) ,

Если

N1 ,...N L ,

T (l ) x G(W (l ) x (l ) ),

(l )

n(l ) – число нейронов в слое l , то должно выполняться: W

такая, что выход сети

Nl

y T ( L) T (1) x.

есть n(l ) n(l 1) - матрица и dim x(l ) n(l ) .

Рекуррентная ( замкнутая ) сеть получается из однослойного персептрона при dim x dim y его выход

подать на вход. Динамика состояния рекуррентной сети описывается динамической системой с дискретным временем

x(t 1) G(Wx(t ) ), или, с непрерывным временем, dx / dt x G(Wx ).

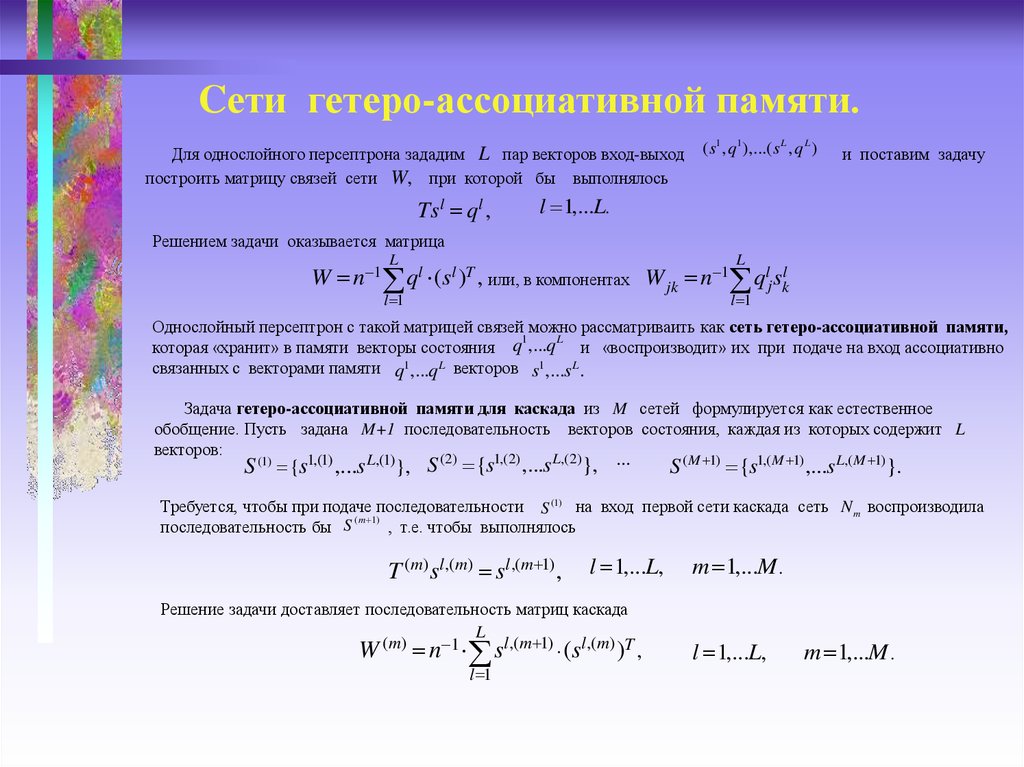

14. Cети гетеро-ассоциативной памяти.

Для однослойного персептрона зададим L пар векторов вход-выходпостроить матрицу связей сети W, при которой бы выполнялось

Tsl ql ,

(s1 , q1 ),...( s L , q L )

и поставим задачу

l 1,...L.

Решением задачи оказывается матрица

W

n 1

L

l 1

ql (sl )T ,

или, в компонентах

W jk

n 1

L

qlj skl

l 1

Однослойный персептрон с такой матрицей связей можно рассматриваить как сеть гетеро-ассоциативной памяти,

1

L

которая «хранит» в памяти векторы состояния q ,...q и «воспроизводит» их при подаче на вход ассоциативно

связанных с векторами памяти q1,...q L векторов s1,...s L .

Задача гетеро-ассоциативной памяти для каскада из M сетей формулируется как естественное

обобщение. Пусть задана M+1 последовательность векторов состояния, каждая из которых содержит L

векторов:

(2)

1,(2)

L,(2)

S (1) {s1,(1) ,...s L,(1)}, S

{s

,...s

}, ...

S ( M 1) {s1,( M 1) ,...s L,(M 1)}.

Требуется, чтобы при подаче последовательности S (1) на вход первой сети каскада сеть N m воспроизводила

( m 1)

последовательность бы S

, т.е. чтобы выполнялось

T (m) sl ,(m) sl ,(m 1) ,

l 1,...L,

Решение задачи доставляет последовательность матриц каскада

L

( m)

1

W n sl ,(m 1) (sl ,(m) )T ,

l 1

m 1,...M .

l 1,...L,

m 1,...M .

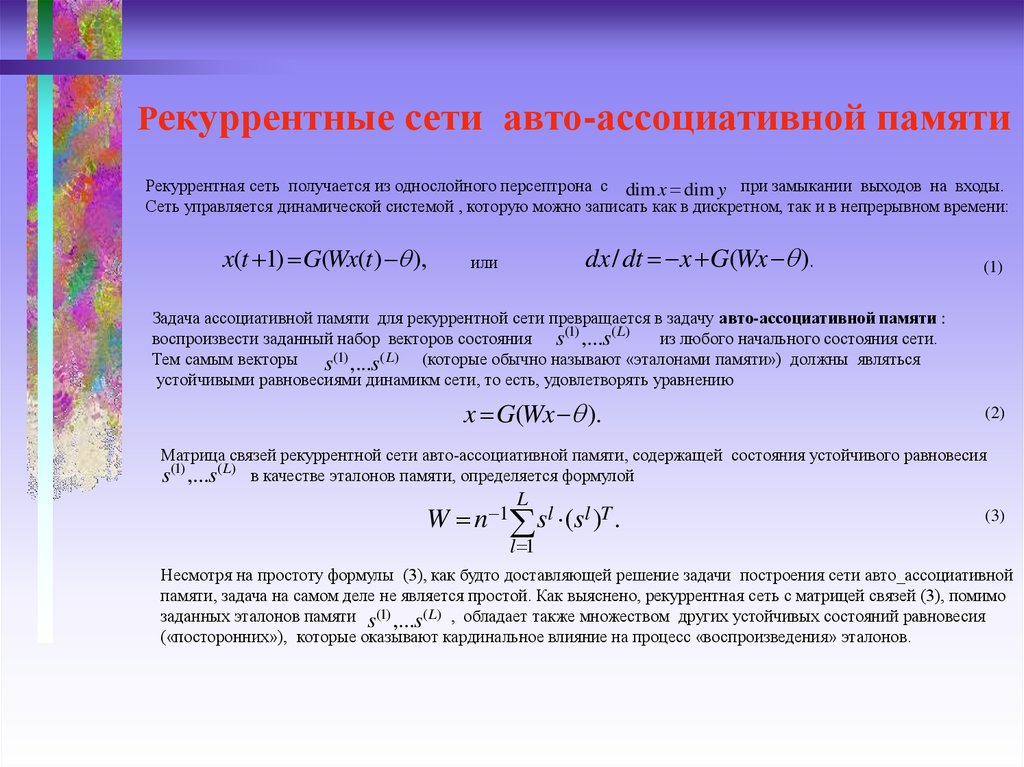

15. Рекуррентные сети авто-ассоциативной памяти

Рекуррентная сеть получается из однослойного персептрона с dim x dim y при замыкании выходов на входы.Сеть управляется динамической системой , которую можно записать как в дискретном, так и в непрерывном времени:

x(t 1) G(Wx(t) ),

dx / dt x G(Wx ).

или

(1)

Задача ассоциативной памяти для рекуррентной сети превращается в задачу авто-ассоциативной памяти :

воспроизвести заданный набор векторов состояния s(1) ,...s( L)

из любого начального состояния сети.

(1)

(

L

)

Тем самым векторы

(которые обычно называют «эталонами памяти») должны являться

s ,...s

устойчивыми равновесиями динамикм сети, то есть, удовлетворять уравнению

x G(Wx ).

(2)

Матрица связей рекуррентной сети авто-ассоциативной памяти, содержащей состояния устойчивого равновесия

s(1) ,...s( L) в качестве эталонов памяти, определяется формулой

W

L

sl (sl )T .

n 1

(3)

l 1

Несмотря на простоту формулы (3), как будто доставляющей решение задачи построения сети авто_ассоциативной

памяти, задача на самом деле не является простой. Как выяснено, рекуррентная сеть с матрицей связей (3), помимо

заданных эталонов памяти s(1) ,...s( L) , обладает также множеством других устойчивых состояний равновесия

(«посторонних»), которые оказывают кардинальное влияние на процесс «воспроизведения» эталонов.

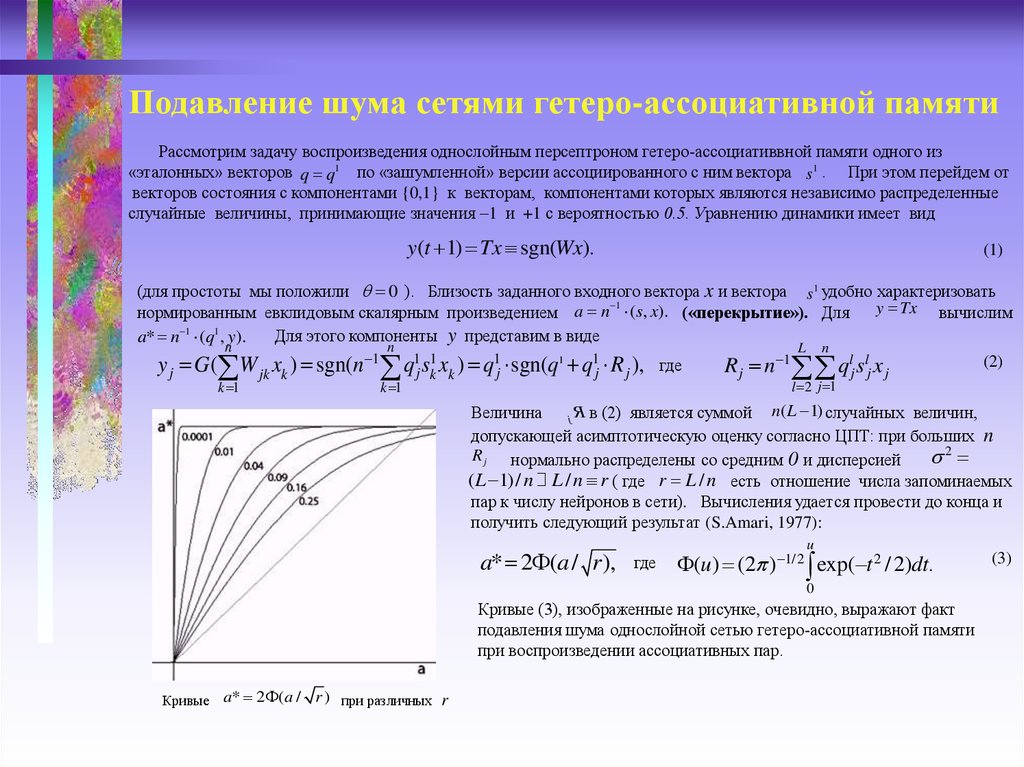

16. Подавление шума сетями гетеро-ассоциативной памяти

Рассмотрим задачу воспроизведения однослойным персептроном гетеро-ассоциативвной памяти одного из«эталонных» векторов q q1 по «зашумленной» версии ассоциированного с ним вектора s1 . При этом перейдем от

векторов состояния с компонентами {0,1} к векторам, компонентами которых являются независимо распределенные

случайные величины, принимающие значения –1 и +1 с вероятностью 0.5. Уравнению динамики имеет вид

y(t 1) Tx sgn(Wx).

(1)

(для простоты мы положили 0 ). Близость заданного входного вектора x и вектора s1 удобно характеризовать

1

y Tx вычислим

нормированным евклидовым скалярным произведением a n (s, x). («перекрытие»). Для

1

1

Для этого компоненты y представим в виде

a* n (q , y).

n

n

L n

1

(2)

y G( W x ) sgn(n

q1 s1 x ) q1 sgn(q1 q1 R ), где

R n 1

ql s l x

j

k 1

jk k

k 1

j k k

j

j

j

j

l 2 j 1

j j j

n( L 1) случайных величин,

Величина

j R в (2) является суммой

допускающей асимптотическую оценку согласно ЦПТ: при больших n

R j нормально распределены со средним 0 и дисперсией

2

(L 1) / n L / n r ( где r L / n есть отношение числа запоминаемых

пар к числу нейронов в сети). Вычисления удается провести до конца и

получить следующий результат (S.Amari, 1977):

a* 2 (a / r),

где

(u) (2 )

1/2

u

0 exp( t

2

/ 2)dt.

Кривые (3), изображенные на рисунке, очевидно, выражают факт

подавления шума однослойной сетью гетеро-ассоциативной памяти

при воспроизведении ассоциативных пар.

Кривые a* 2 (a /

r ) при различных r

(3)

17. Реализация произвольной функции трехслойной сетью

Можно показать, что двуслойный персептрон является системой, которая способна реализовать любую булеву функцию.С помощью же трехслойного персептрона можно вычислить любую непрерывную на основе теоремы Колмогорова:

Любая непрерывная функция многих переменных, заданная на компакте (замкнутом

ограниченном множестве) может быть представлена в виде суперпозиции конечного

числа функций одной переменной (теорема Колмогорова)

[*] А.Н.Колмогоров, ДАН СССР, 114, 953-956, (1957).

В случае, интересном с точки зрения нейронных сетей, когда функция определена на n-мерном вещественном

кубе [0,1]n, уточнение теоремы Колмогорова получено Д. Шпрехером (D.Sprecher) в 1965г.

Из результата Шпрехера следует теорема о нейросетевой реализации произвольной непрерывной функции многих

переменных, определенной на на единичном n-мерном кубе [0,1]n :

Теорема. Произвольная непрерывная функция m вещественных переменных, определенная на единичном

n –мерном кубе: y f ( x), f :[0,1]n R m , может быть реализована открытой трехслойной нейронной

сетью (трехслойным персептроном), имеющей n – мерный вход x, 2n+1 активных элементов в среднем

( скрытом ) слое и

1-ый слой:

m

активных элементов в выходном слое (с

n – мерный вход

n

2-ой слой:

3-ий слой

yi

gi ( zk ),

k 1

выходами).

x ( x1,...xn ).

zk (j k )h j ( x j k ),

j 1

2 n 1

m

k 1,...2n 1.

i 1,...m.

Как любая теорема существования, теорема Колмогорова не дает никаких рецептов построения

h j ( x)

функций

gi ( z )

и

Тем не менее, теорема Колмогорова гарантирует точное представление функции многих

переменных

трехслойной сетью.

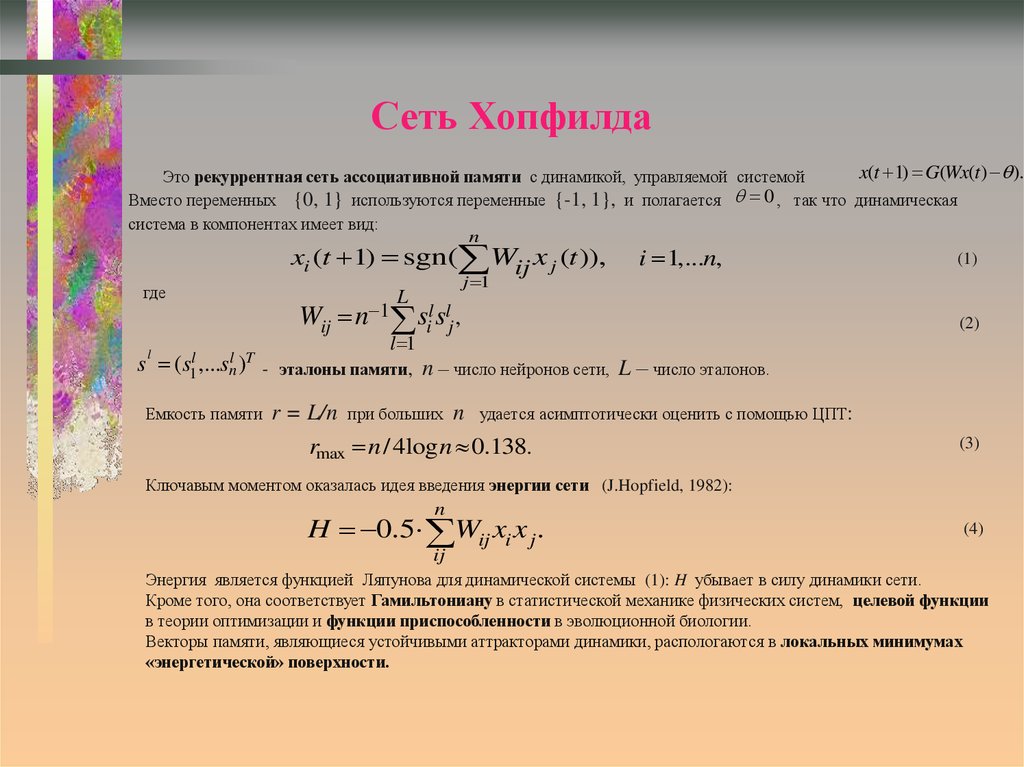

18. Сеть Хопфилда

x(t 1) G(Wx(t ) ).Это рекуррентная сеть ассоциативной памяти с динамикой, управляемой системой

Вместо переменных {0, 1} используются переменные {-1, 1}, и полагается 0 , так что динамическая

система в компонентах имеет вид:

n

(1)

xi (t 1) sgn( Wij x j (t )), i 1,...n,

j 1

где

L

Wij n 1 sil slj ,

s

l

(s1l ,...snl )T

l 1

- эталоны памяти, n – число нейронов сети, L – число эталонов.

Емкость памяти

r = L/n

при больших

n

(2)

удается асимптотически оценить с помощью ЦПТ:

rmax n / 4log n 0.138.

(3)

Ключавым моментом оказалась идея введения энергии сети (J.Hopfield, 1982):

n

H 0.5 Wij xi x j .

(4)

ij

Энергия является функцией Ляпунова для динамической системы (1): H убывает в силу динамики сети.

Кроме того, она соответствует Гамильтониану в статистической механике физических систем, целевой функции

в теории оптимизации и функции приспособленности в эволюционной биологии.

Векторы памяти, являющиеся устойчивыми аттракторами динамики, распологаются в локальных минимумах

«энергетической» поверхности.

19. Сеть Хопфилда: воспроизведение эталонов памяти

«Работа» сети состоит в релаксации сети из некоторого заданного начальногосостояния x 0 в одно из состояний устойчивого равновесия.

0

Если состояние x 0 представляет искаженную версию одного из эталонов

памяти и точка x фазового пространства динамической системы находится

в бассейне притяжения устойчивого аттрактора s l , сеть релаксирует в

l

состояние равновесия s , что и соответствует «воспроизведению» эталона.

Важной особенностью сети Хопфилда является существование множества

дополнительных устойчивых аттракторов динамики помимо s1,...s L

(так называемая «посторонняя» память, или spurious states). Свойства

посторонней памяти достаточно хорошо изучены. В частности, имеются

строгие результаты, свидетельствующие об экспоненциальном росте числа

«посторонних» аттракторов с ростом

L.

Стремительное увеличение числа дополнительных аттракторов при

возрастанииrL

является

основной причиной малой емкости памяти сети

max

Хопфилда (

0.138). При возрастании L происходит также быстрое

снижение качества воспроизведения эталонов в результате

a) сокращения бассейнов притяжения эталонов

b) уменьшения их устойчивости.

При r r* rmax происходит бифуркация в динамической системе сети,

аналогичная известному фазовому переходу в состояние «спинового стекла»,

характерному для изинговых спиновых систем.

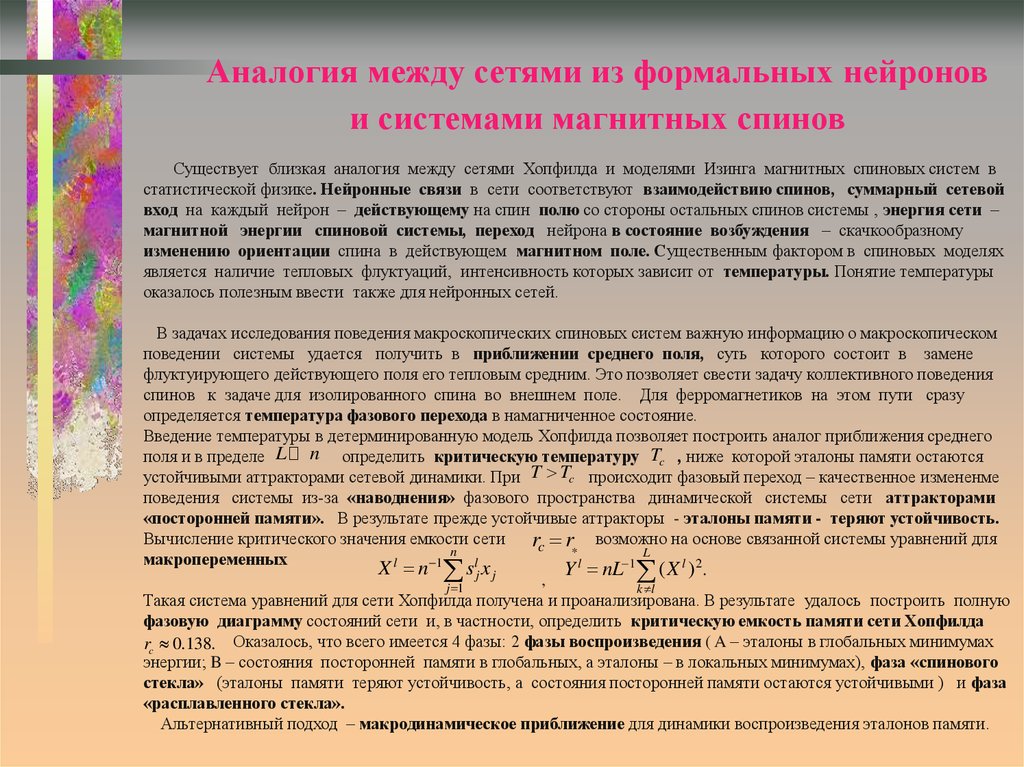

20. Аналогия между сетями из формальных нейронов и системами магнитных спинов

Существует близкая аналогия между сетями Хопфилда и моделями Изинга магнитных спиновых систем встатистической физике. Нейронные связи в сети соответствуют взаимодействию спинов, суммарный сетевой

вход на каждый нейрон – действующему на спин полю со стороны остальных спинов системы , энергия сети –

магнитной энергии спиновой системы, переход нейрона в состояние возбуждения – скачкообразному

изменению ориентации спина в действующем магнитном поле. Существенным фактором в спиновых моделях

является наличие тепловых флуктуаций, интенсивность которых зависит от температуры. Понятие температуры

оказалось полезным ввести также для нейронных сетей.

В задачах исследования поведения макроскопических спиновых систем важную информацию о макроскопическом

поведении системы удается получить в приближении среднего поля, суть которого состоит в замене

флуктуирующего действующего поля его тепловым средним. Это позволяет свести задачу коллективного поведения

спинов к задаче для изолированного спина во внешнем поле. Для ферромагнетиков на этом пути сразу

определяется температура фазового перехода в намагниченное состояние.

Введение температуры в детерминированную модель Хопфилда позволяет построить аналог приближения среднего

поля и в пределе L n определить критическую температуру Tc , ниже которой эталоны памяти остаются

устойчивыми аттракторами сетевой динамики. При T Tc происходит фазовый переход – качественное измененме

поведения системы из-за «наводнения» фазового пространства динамической системы сети аттракторами

«посторонней памяти». В результате прежде устойчивые аттракторы - эталоны памяти - теряют устойчивость.

Вычисление критического значения емкости сети

на основе связанной системы уравнений для

rc r* возможно

n

L

макропеременных

X l n 1 slj x j

Y l nL 1 ( X l )2 .

,

j 1

k l

Такая система уравнений для сети Хопфилда получена и проанализирована. В результате удалось построить полную

фазовую диаграмму состояний сети и, в частности, определить критическую емкость памяти сети Хопфилда

rc 0.138. Оказалось, что всего имеется 4 фазы: 2 фазы воспроизведения ( A – эталоны в глобальных минимумах

энергии; B – состояния посторонней памяти в глобальных, а эталоны – в локальных минимумах), фаза «спинового

стекла» (эталоны памяти теряют устойчивость, а состояния посторонней памяти остаются устойчивыми ) и фаза

«расплавленного стекла».

Альтернативный подход – макродинамическое приближение для динамики воспроизведения эталонов памяти.

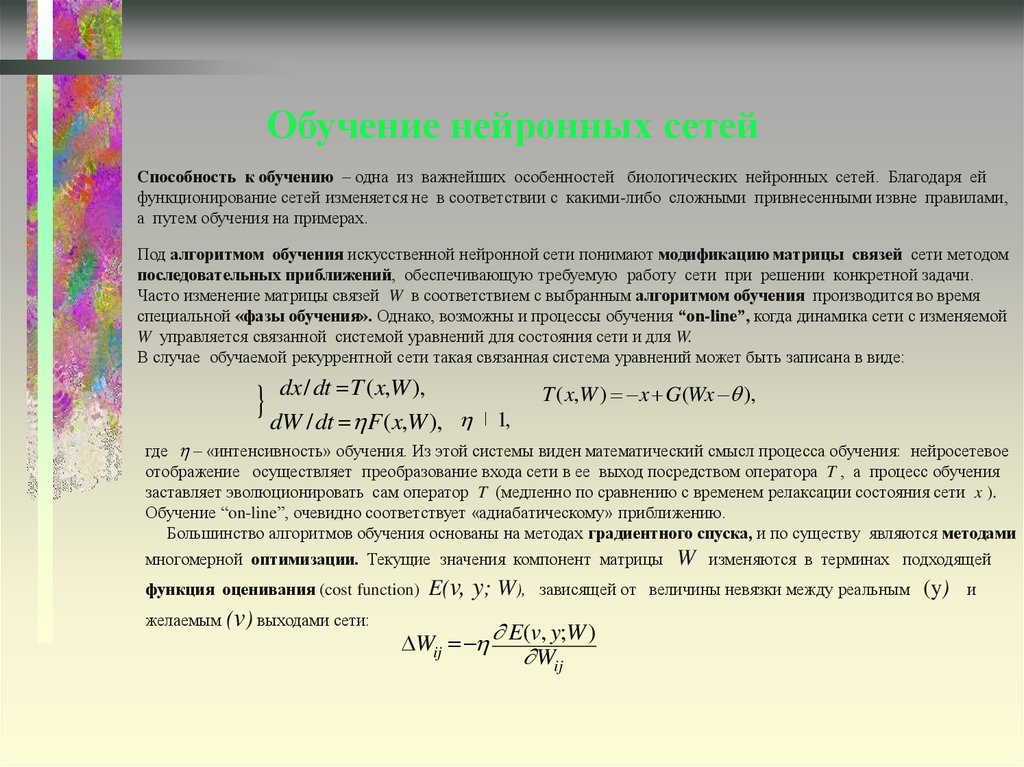

21. Обучение нейронных сетей

Способность к обучению – одна из важнейших особенностей биологических нейронных сетей. Благодаря ейфункционирование сетей изменяется не в соответствии с какими-либо сложными привнесенными извне правилами,

а путем обучения на примерах.

Под алгоритмом обучения искусственной нейронной сети понимают модификацию матрицы связей сети методом

последовательных приближений, обеспечивающую требуемую работу сети при решении конкретной задачи.

Часто изменение матрицы связей W в соответствием с выбранным алгоритмом обучения производится во время

специальной «фазы обучения». Однако, возможны и процессы обучения “on-line”, когда динамика сети с изменяемой

W управляется связанной системой уравнений для состояния сети и для W.

В случае обучаемой рекуррентной сети такая связанная система уравнений может быть записана в виде:

dx / dt T ( x,W ),

{ dW

/ dt F ( x,W ),

T ( x,W ) x G(Wx ),

1,

где – «интенсивность» обучения. Из этой системы виден математический смысл процесса обучения: нейросетевое

отображение осуществляет преобразование входа сети в ее выход посредством оператора T , а процесс обучения

заставляет эволюционировать сам оператор T (медленно по сравнению с временем релаксации состояния сети x ).

Обучение “on-line”, очевидно соответствует «адиабатическому» приближению.

Большинство алгоритмов обучения основаны на методах градиентного спуска, и по существу являются методами

многомерной оптимизации. Текущие значения компонент матрицы

функция оценивания (cost function)

желаемым (v) выходами сети:

E(v, y; W),

Wij

W

изменяются в терминах подходящей

зависящей от величины невязки между реальным

E(v, y;W )

Wij

(y)

и

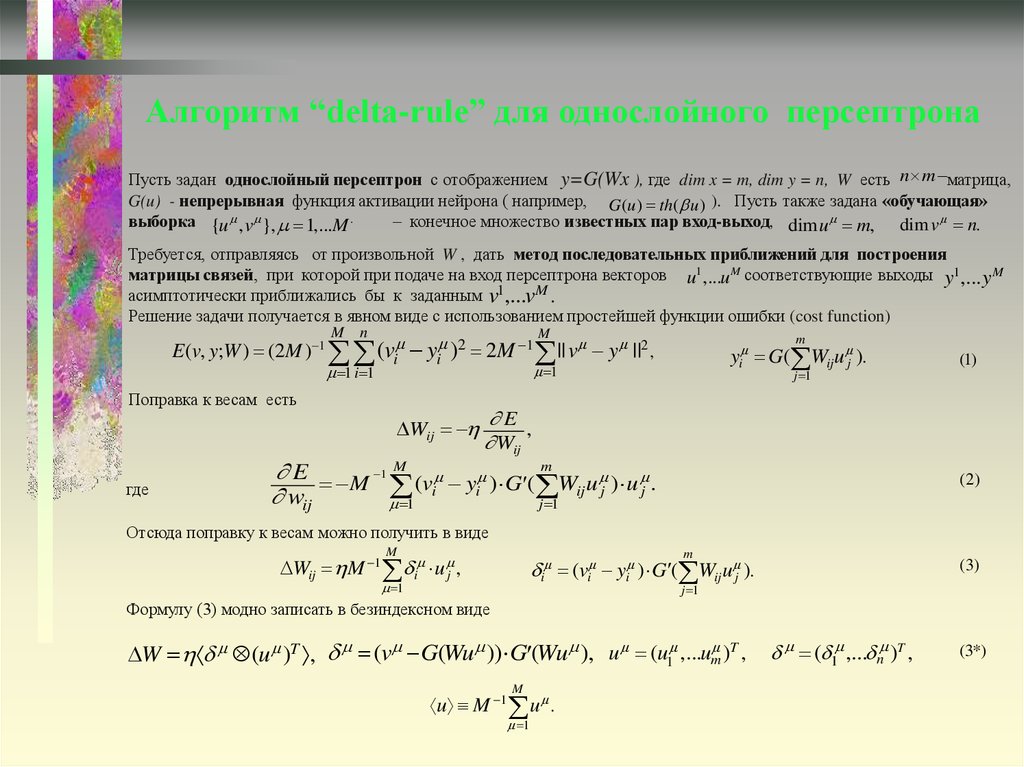

22. Алгоритм “delta-rule” для однослойного персептрона

Пусть задан однослойный персептрон с отображением y=G(Wx ), где dim x = m, dim y = n, W есть n m матрица,G(u) - непрерывная функция активации нейрона ( например, G (u ) th( u ) ). Пусть также задана «обучающая»

выборка {u , v }, 1,...M .

– конечное множество известных пар вход-выход, dim u m, dim v n.

Требуется, отправляясь от произвольной W , дать метод последовательных приближений для построения

матрицы связей, при которой при подаче на вход персептрона векторов u1,...u M соответствующие выходы y1,... y M

асимптотически приближались бы к заданным v1,...vM .

Решение задачи получается в явном виде с использованием простейшей функции ошибки (cost function)

M

n

M

E (v, y;W ) (2M ) 1 (vi yi )2 2M 1 || v y ||2 ,

1

1 i 1

Поправка к весам есть

Wij

где

m

yi G( Wiju j ).

j 1

(1)

E

,

Wij

E M 1 M (v y ) G ( m W u ) u .

i i

ij j

j

wij

1

j 1

(2)

Отсюда поправку к весам можно получить в виде

M

m

Wij M 1 i u j ,

i (vi yi ) G ( Wiju j ).

1

(3)

j 1

Формулу (3) модно записать в безиндексном виде

W (u )T , (v G(Wu )) G (Wu ), u (u1 ,...um )T ,

M

u M 1 u .

1

( 1 ,... n )T ,

(3*)

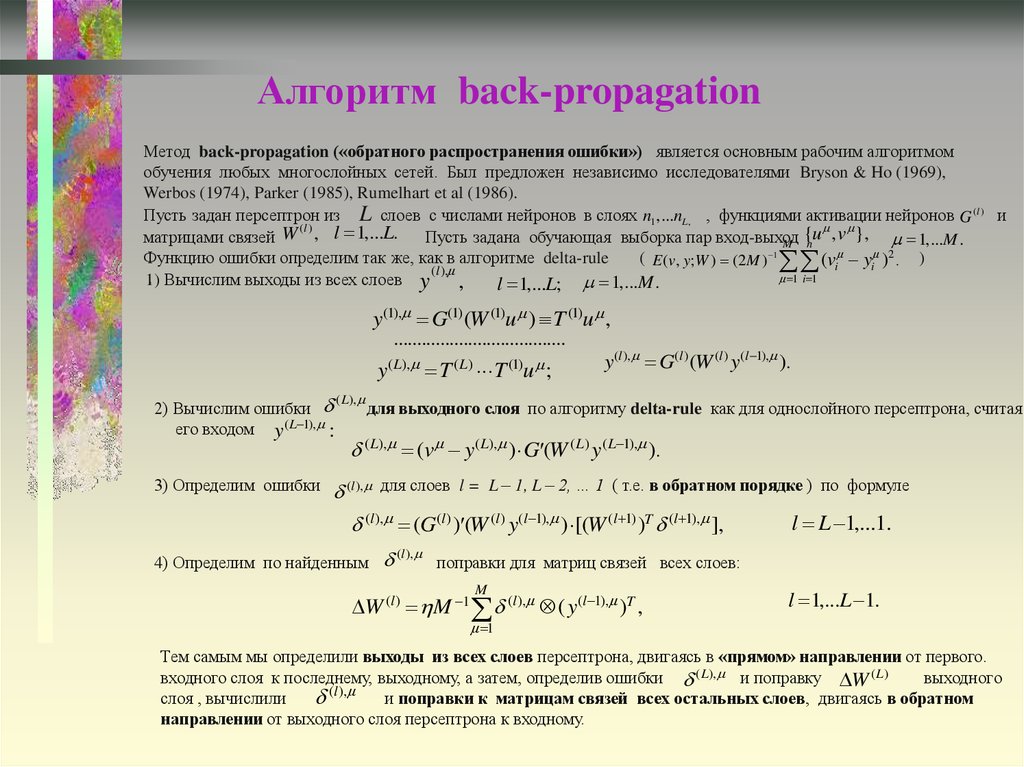

23. Алгоритм back-propagation

Метод back-propagation («обратного распространения ошибки») является основным рабочим алгоритмомобучения любых многослойных сетей. Был предложен независимо исследователями Bryson & Ho (1969),

Werbos (1974), Parker (1985), Rumelhart et al (1986).

Пусть задан персептрон из L слоев с числами нейронов в слоях n1 ,...nL , , функциями активации нейронов G ( l ) и

(l )

{u , v }, 1,...M .

матрицами связей W , l 1,...L.

Пусть задана обучающая выборка пар вход-выход

M n

Функцию ошибки определим так же, как в алгоритме delta-rule

( E (v, y;W ) (2M ) 1 (vi yi )2 . )

(l ),

1 i 1

. Вычислим выходы из всех слоев y

1)

,

l 1,...L; 1,...M .

y(1), G(1) (W (1)u ) T (1)u ,

.....................................

y( L), T ( L) T (1)u ;

2) Вычислим ошибки

его входом y( L 1), :

3) Определим ошибки

( L),

y(l ), G(l ) (W (l ) y(l 1), ).

для выходного слоя по алгоритму delta-rule как для однослойного персептрона, считая

( L), (v y( L), ) G (W ( L) y( L 1), ).

(l ),

для слоев l = L – 1, L – 2, … 1 ( т.е. в обратном порядке ) по формуле

(l ), (G(l ) ) (W (l ) y(l 1), ) [(W (l 1) )T (l 1), ],

4) Определим по найденным

(l ),

l L 1,...1.

поправки для матриц связей всех слоев:

M

W (l ) M 1 (l ), ( y(l 1), )T ,

l 1,...L 1.

1

Тем самым мы определили выходы из всех слоев персептрона, двигаясь в «прямом» направлении от первого.

входного слоя к последнему, выходному, а затем, определив ошибки ( L), и поправку W ( L)

выходного

(l ),

слоя , вычислили

и поправки к матрицам связей всех остальных слоев, двигаясь в обратном

направлении от выходного слоя персептрона к входному.

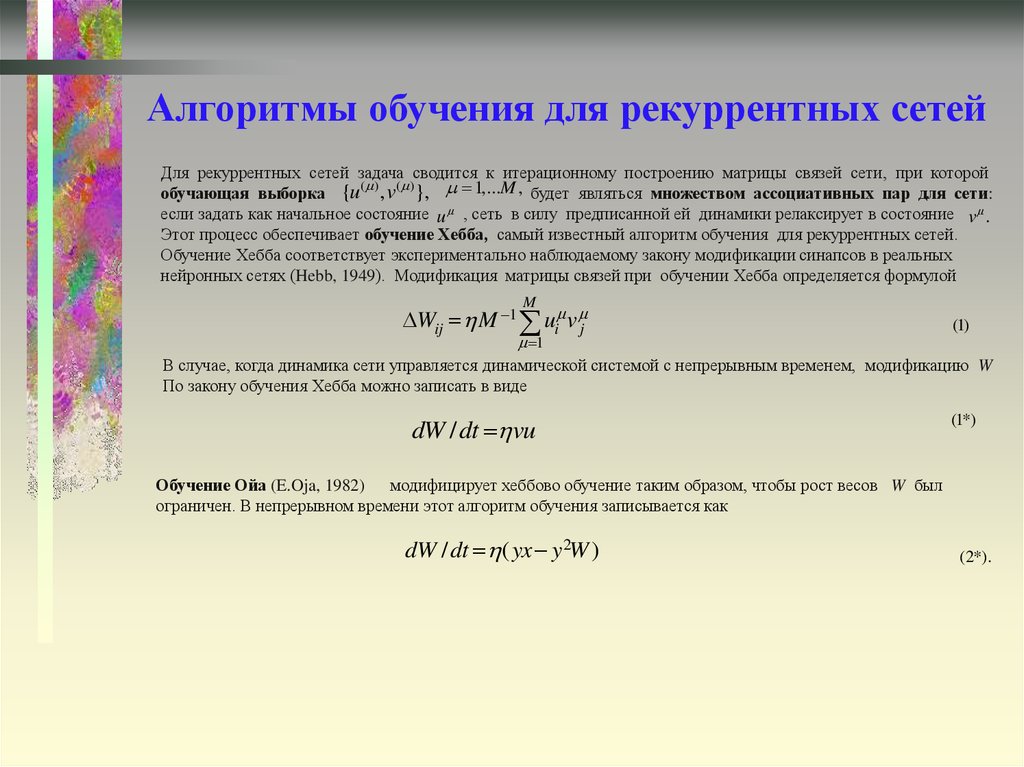

24. Алгоритмы обучения для рекуррентных сетей

Для рекуррентных сетей задача сводится к итерационному построению матрицы связей сети, при которойобучающая выборка {u( ) , v( )}, 1,...M , будет являться множеством ассоциативных пар для сети:

если задать как начальное состояние u , сеть в силу предписанной ей динамики релаксирует в состояние v .

Этот процесс обеспечивает обучение Хебба, самый известный алгоритм обучения для рекуррентных сетей.

Обучение Хебба соответствует экспериментально наблюдаемому закону модификации синапсов в реальных

нейронных сетях (Hebb, 1949). Модификация матрицы связей при обучении Хебба определяется формулой

M

Wij M 1 ui v j

(1)

1

В случае, когда динамика сети управляется динамической системой с непрерывным временем, модификацию W

По закону обучения Хебба можно записать в виде

dW / dt vu

(1*)

Обучение Ойа (E.Oja, 1982) модифицирует хеббово обучение таким образом, чтобы рост весов W был

ограничен. В непрерывном времени этот алгоритм обучения записывается как

dW / dt ( yx y 2W )

(2*).

25. Типичные трудности градиентных методов обучения

При выборе функции оценивания в квадратичной форме она соответствует некоторому параболоиду в многомерномПространстве весов связей. Но, хотя такая поверхность имеет единственный минимум, он как правило расположен на

дне длинного «оврага». При этом обучение становится неприемлемо медленным, а вблизи дна оврага возникают

осцилляции. Приходится вводить специальные меры для ускорения процесса сходимости (например, метод моментов).

Алгоритм обучения backpropagation открыл пути для широких применений нейросетевых подходов в приложениях.

Однако, в случае многослойных сетей он страдает от существования локальных минимумов. Это повлекло за

собой цикл строгих математических исследований, направленных на изучение общих свойств алгоритмов обучения,

таких как характер сходимости, асимптотическая скорость обучения, оптимальный выбор обучающей выборки и т.д.

На этом пути было получен ряд замечательных строгих результатов. Например, с применением подхода

информационной геометрии (изучения многомерных многообразий, возникающих в строгой теории вероятностей)

был выяснен характер так называемой универсальной кривой обучения, описывающей поведение обучаемой сети

при неограниченном возрастании обучающей выборки и доставляющий строгий информационный критерий

для сети (S.Amari, N.Murata, 1995-1995).

26. Нейрокомпьютеры

Некоторые характерные черты нейрокоппьютера, который есть надежда создать в будущем,можно указать уже теперь. Он будет:

• состоять из сетей, содержащих большое число паралледьно работающих активных элементов

6

8

( до 10 10 )

• использовать ассоциативную обработку информации (храня в памяти наборы эталонов и

сравнивая с ними поступающую информацию)

• использовать обучение вместо программирования (адаптивное управление параметрами

«нейронов» и архитектурой связей в сетях).

Пока же созданы отдельные специализированные «нейрочипы» (нейропроцессоры). (В России разработки также ведутся)

Сегодня программная эмуляция (компьютерное моделирование) пока является основным способом моделирования

нейронных сетей. Имеется целый ряд нейропакетов, созданных для моделирования разнообразных нейросетей.

Существуют универсальные и специализированные нейропакеты. Они предоставляют пользователю следующие

возможности:

— типа нейросети из набора стандартных;

— синтеза архитектуры сети;

— использования стандартных алгоритмов обучения ( типа delta-rule или backpropagation );

— включения нестандартных алгоритмов обучения ( с выбором нестандартных критериев обучения );

— использования различных вариантов визуализации результатов в процессе обучения и работы сети;

— включения программных модулей, написанных пользователем (реализовано лишь в некоторых нейропакетах).

Примерами универсальных нейропакетов являются:

1) NeuroSolution фирмы NeuroDimension Inc. (www.nd.com):NeuralWorksProfessionalфирмыNeuralWareInc. (www.neuralware.com)

2) NeuroShell 2 фирмы Ward Systems Group (www.wardsystems.com)

3) BrainMaker Pro фирмы California Scientific Software (www.calsci.com)

В России разработки нейропакетов также ведутся. Примером является пакет «Нейроимитатор», разработанный в МИРЭА.

27. Динамические нейронные сети

Сети из формальных нейронов вполне приемлемы для математического изучения вычислительных особенностейсистем из большого числа активных элементов, осуществляющих параллельную обработку информации.

Изучение аспектов функционирования биологических нейронных сетей требует следующего естественного шага –

построения моделей нейрона, воспроизводящих импульсный характер нейронной активности. Это привело к серии

моделей импульсных («спайковых») нейронов и изучению нейронных сетей из «спайковых» нейронов с импульсным

взаимодействием .

Далее, экспериментально было обнаружено, что при обработке информации целый ряд структур мозга при обработке

информации используют в качестве «рабочих инструментов» колебательную активность, синхронизацию и

резонанс. Примерами таких структур являются обонятельная система (обонятельная луковица и кора ), слуховая

система (улитка уха и слуховая кора ), зрительная система (сетчатка и зрительная кора).

Это стимулировало моделирование осцилляторных нейронных сетей. Активным элементом таких сетей

является нейронный осциллятор, образованный парой нейронов, связанных возбуждающей и тормозной связями.

Так были построены модели осцилляторных сетей для задач распознавания запахов, распознавания речи при наличии

смеси многих интерферирующих звуковых источников и распознавания зрительных изображений. Работа построенных

сетей порождает динамические методы обработки информации, основанные на синхронизации ансамблей

сетевых осцилляторов.

Были также построены модели искусственных осцилляторных сетей ассоциативной памяти, активными элементами

которых являются различные модели осцилляторов. Эталонами памяти в таких сетях являются не состояния

устойчивого равновесия, а предельные циклы – состояния устойчивых синхронизованных колебаний осцилляторной

сети. Воспроизведение эталонов осуществляется посредством синхронизации. Были даже предложены теоретические

модели оптических нейрокомпьютеров, построенных на осцилляторах, связанных через галографическую среду.

28. Некоторые направления современных исследований

• Математическиее аспекты( развиваются на пересечении с методами теоретико-вероятностной информационной

геометрии, статистического оценивания, регуляризации, многомерной оптимизации,

нелинейной фильтрации, методов нелинейного анализа смесей информационных

потоков (“blind signal separation”) и др.)

• Нейрокомпьютинг и интеллектуальные информационные системы

• Популяции автономных роботов с целенаправленным поведением (искусственная жизнь, генетические алгоритмы)

• Динамические нейронные сети и моделирование структур мозга ( в том

числе развитие подходов к

моделированию сознания)

• Нейроморфное моделирование и биоробототехника (

• Параллельные вычислительные алгоритмы

в том числе нейропротезирование )

( «нейроматематика» )

• Прикладные нейросетевые исследования ( технические системы с адаптивным управлением,

рынков, банки данных, маркетинг и др.)

• Квантовый

компьютинг и квантовые нейронные сети.

мониторинг, анализ

29. Теория нейронных сетей

30. Колонки зрительной коры

.31. Слои зрительной коры

.32. Биологические нейроны

.Биологические нейроны

Рис. 1a. Нейроны мозга человека.

Рис. 1b. Импульс нейронной активности

33. Многослойная структура коры мозжечка

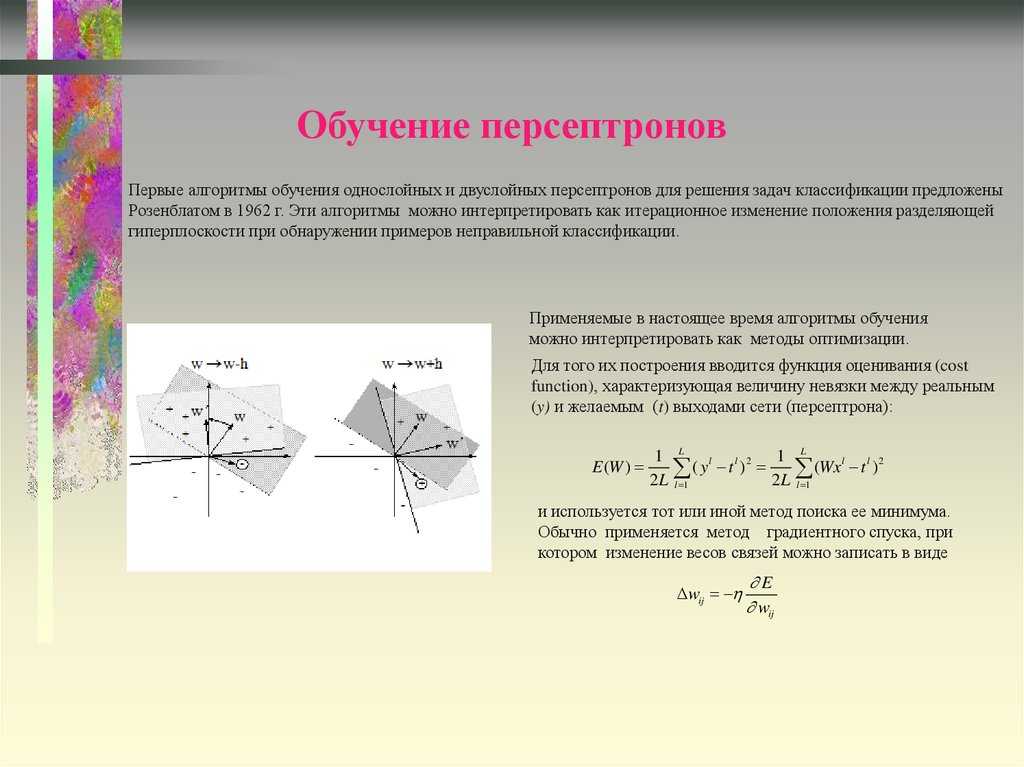

34. Обучение персептронов

Первые алгоритмы обучения однослойных и двуслойных персептронов для решения задач классификации предложеныРозенблатом в 1962 г. Эти алгоритмы можно интерпретировать как итерационное изменение положения разделяющей

гиперплоскости при обнаружении примеров неправильной классификации.

Применяемые в настоящее время алгоритмы обучения

можно интерпретировать как методы оптимизации.

Для того их построения вводится функция оценивания (cost

function), характеризующая величину невязки между реальным

(y) и желаемым (t) выходами сети (персептрона):

1 L l l 2 1 L

E (W )

(y t )

(Wx l t l ) 2

2 L l 1

2 L l 1

и используется тот или иной метод поиска ее минимума.

Обычно применяется метод градиентного спуска, при

котором изменение весов связей можно записать в виде

wij

E

wij

informatics

informatics