Similar presentations:

Нейронные сети для преобразования текста

1. Нейронные сети для преобразования текста

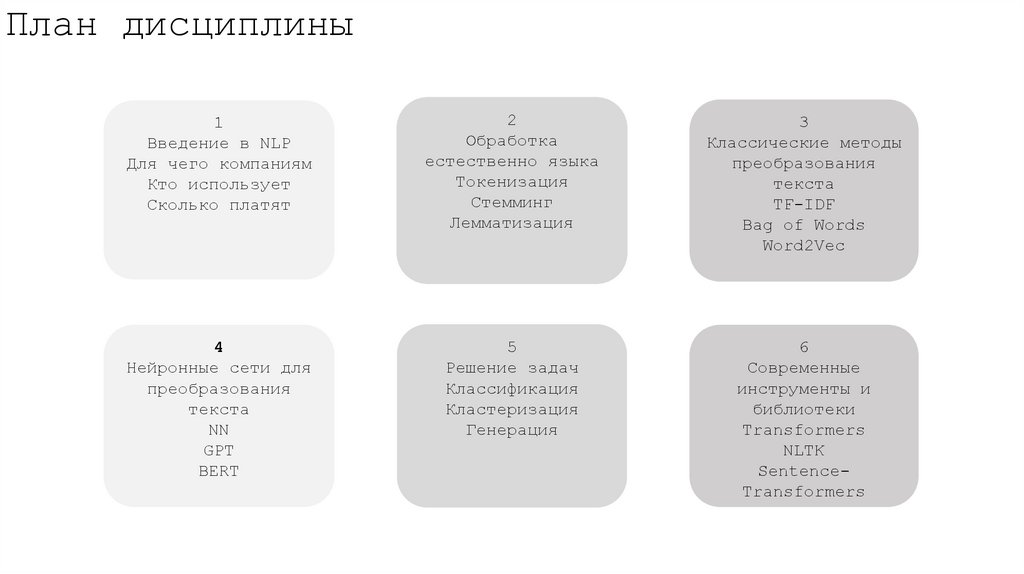

2. План дисциплины

1Введение в NLP

Для чего компаниям

Кто использует

Сколько платят

2

Обработка

естественно языка

Токенизация

Стемминг

Лемматизация

3

Классические методы

преобразования

текста

TF-IDF

Bag of Words

Word2Vec

4

Нейронные сети для

преобразования

текста

NN

GPT

BERT

5

Решение задач

Классификация

Кластеризация

Генерация

6

Современные

инструменты и

библиотеки

Transformers

NLTK

SentenceTransformers

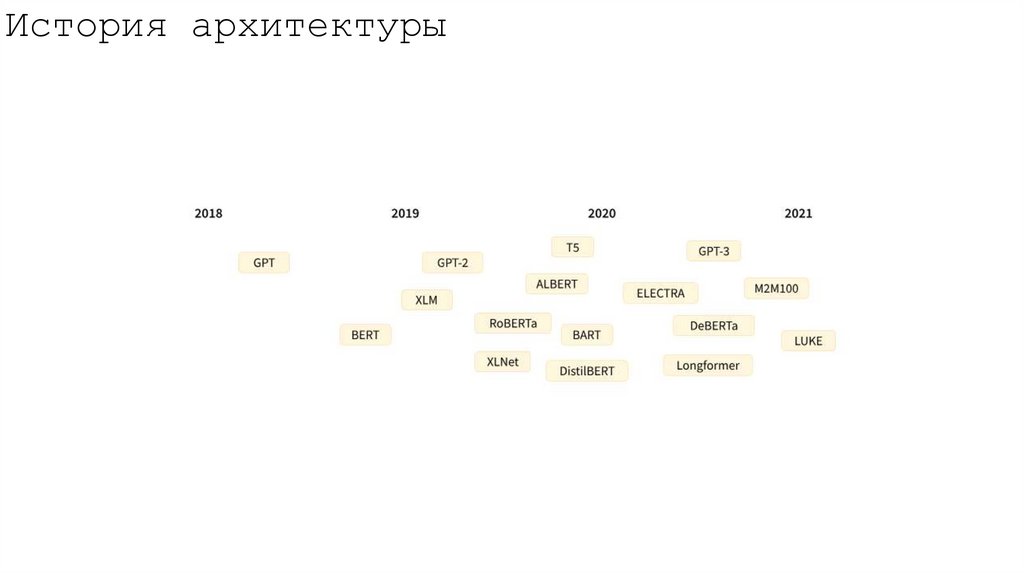

3. История архитектуры

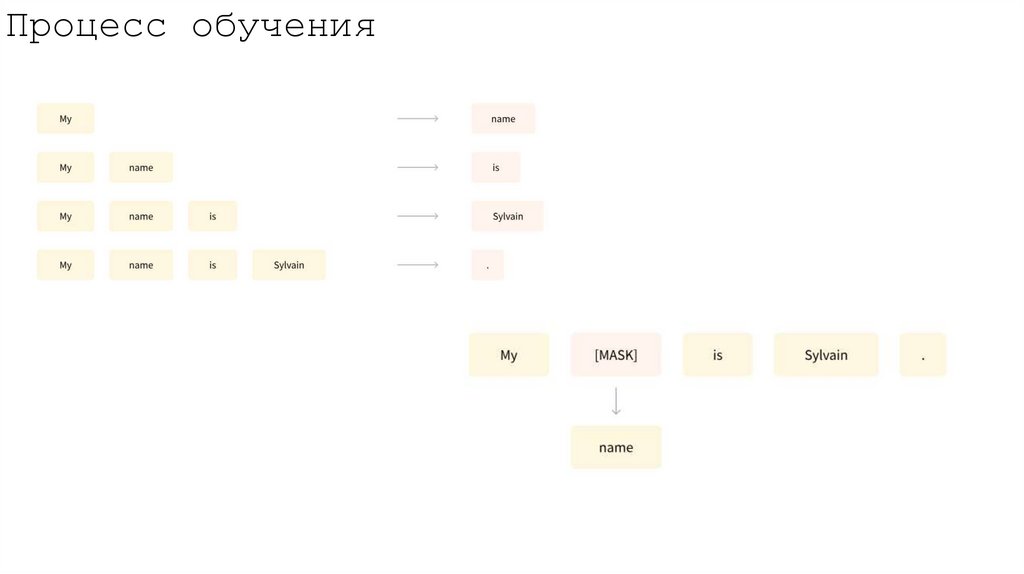

4. Процесс обучения

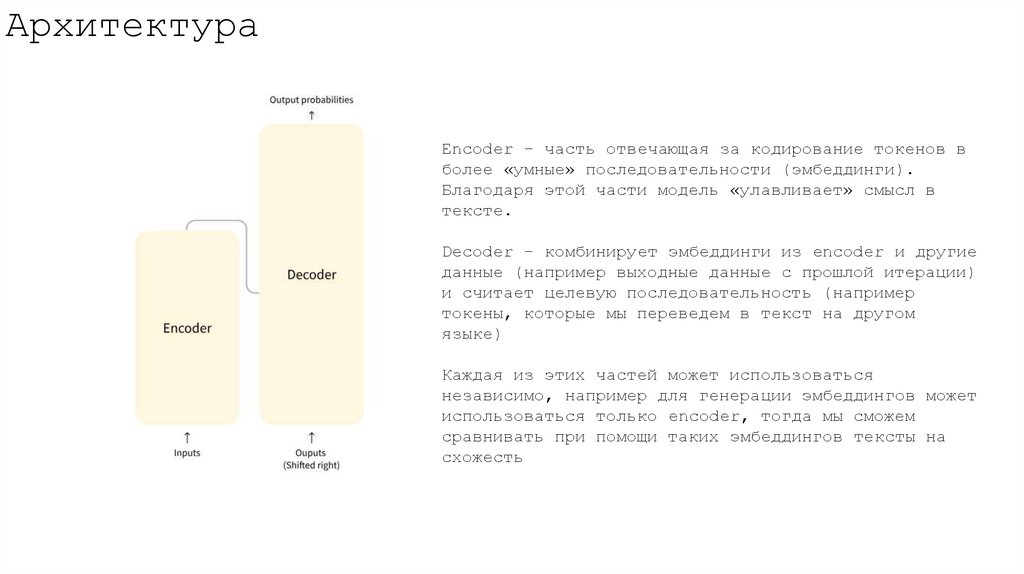

5. Архитектура

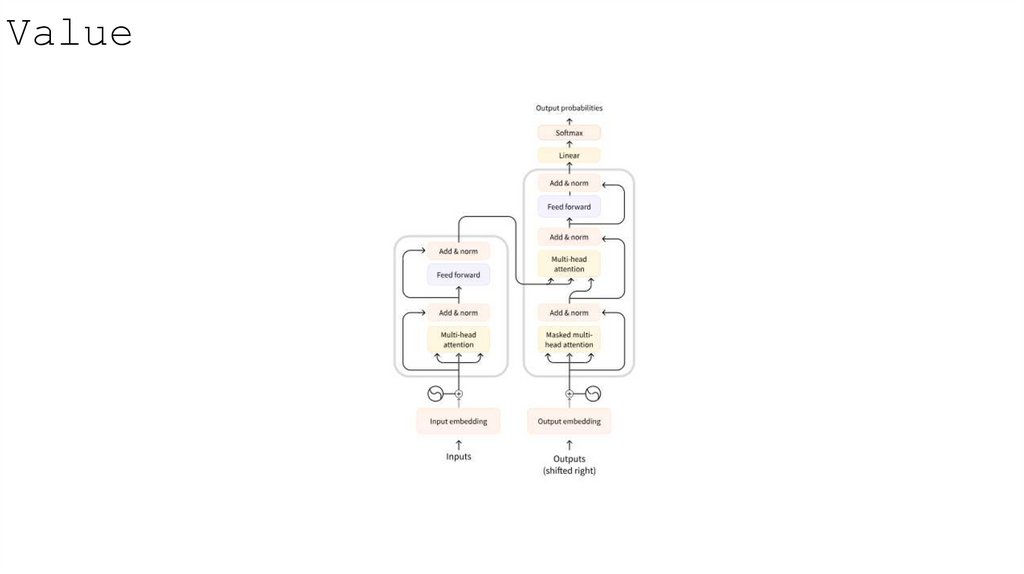

Encoder – часть отвечающая за кодирование токенов вболее «умные» последовательности (эмбеддинги).

Благодаря этой части модель «улавливает» смысл в

тексте.

Decoder – комбинирует эмбеддинги из encoder и другие

данные (например выходные данные с прошлой итерации)

и считает целевую последовательность (например

токены, которые мы переведем в текст на другом

языке)

Каждая из этих частей может использоваться

независимо, например для генерации эмбеддингов может

использоваться только encoder, тогда мы сможем

сравнивать при помощи таких эмбеддингов тексты на

схожесть

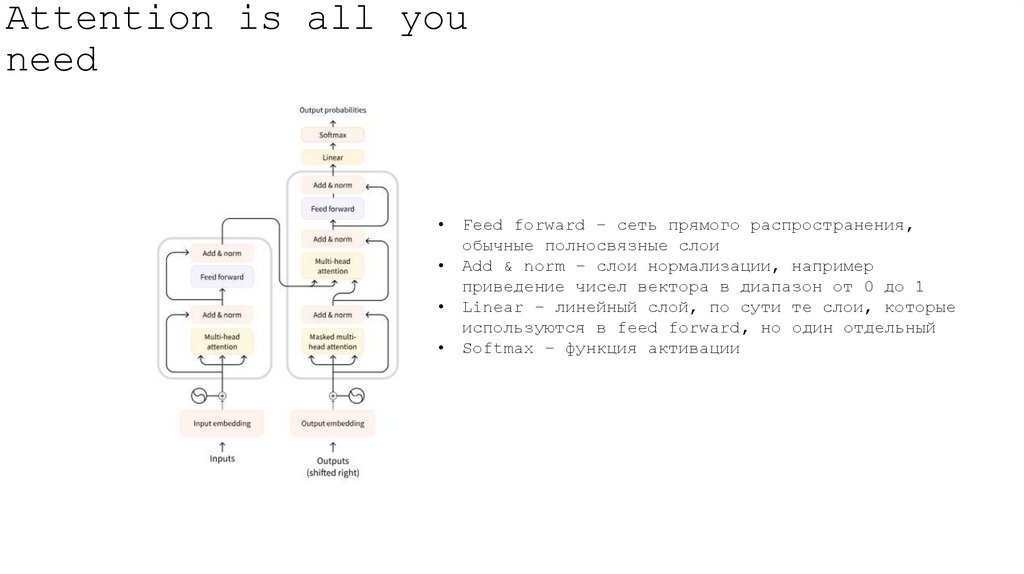

6. Attention is all you need

Feed forward – сеть прямого распространения,

обычные полносвязные слои

Add & norm – слои нормализации, например

приведение чисел вектора в диапазон от 0 до 1

Linear – линейный слой, по сути те слои, которые

используются в feed forward, но один отдельный

Softmax – функция активации

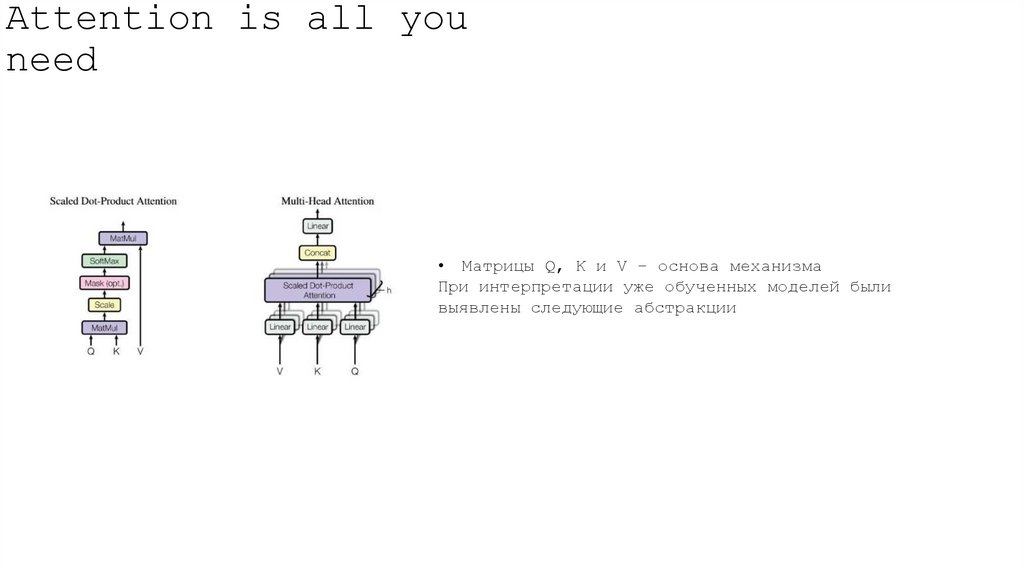

7. Attention is all you need

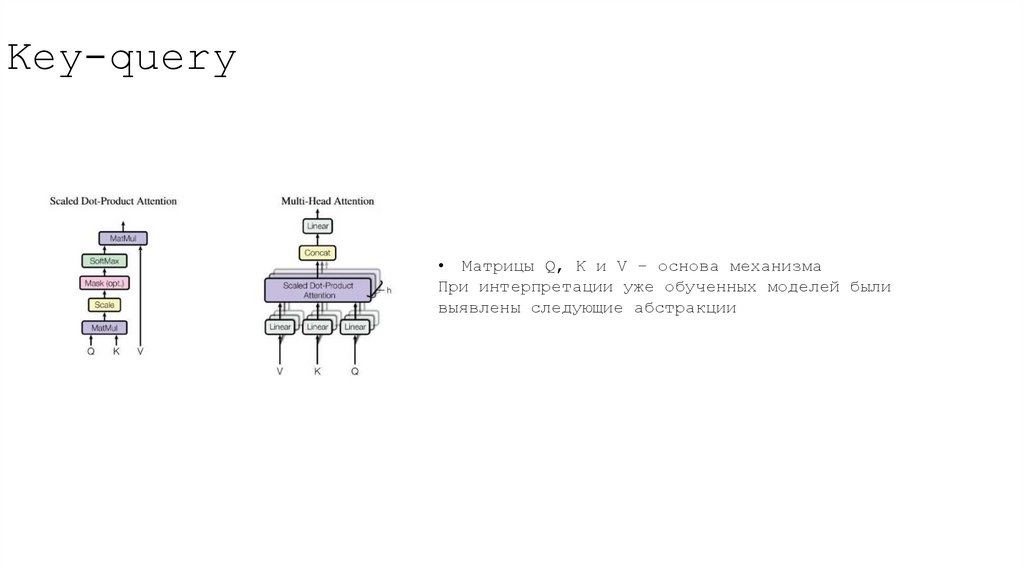

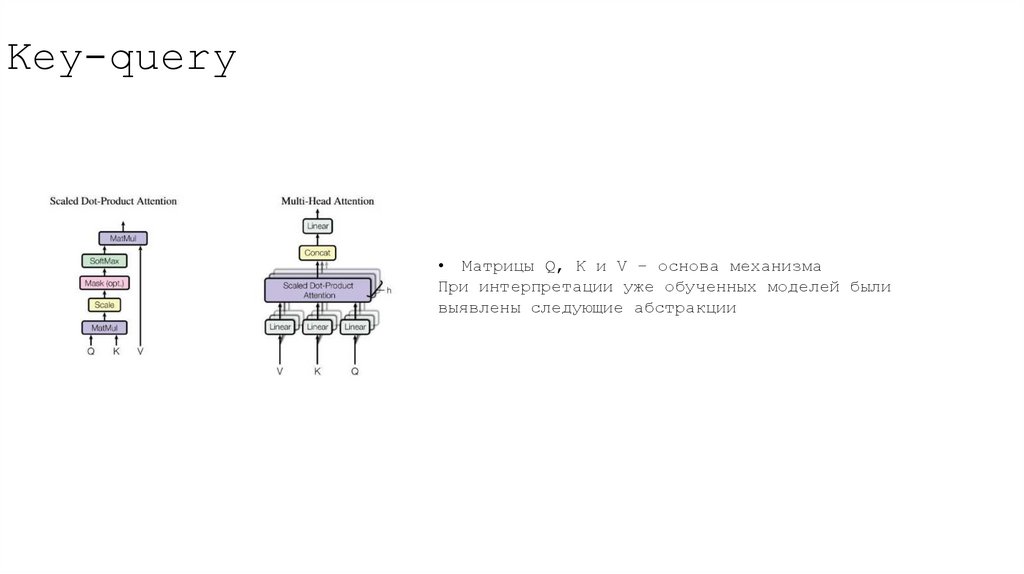

• Матрицы Q, K и V – основа механизмаПри интерпретации уже обученных моделей были

выявлены следующие абстракции

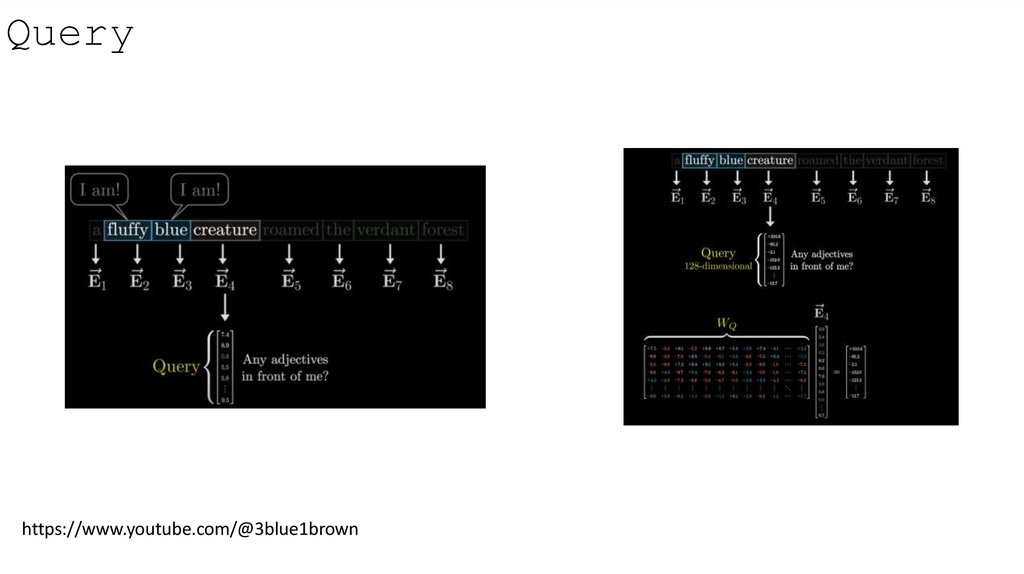

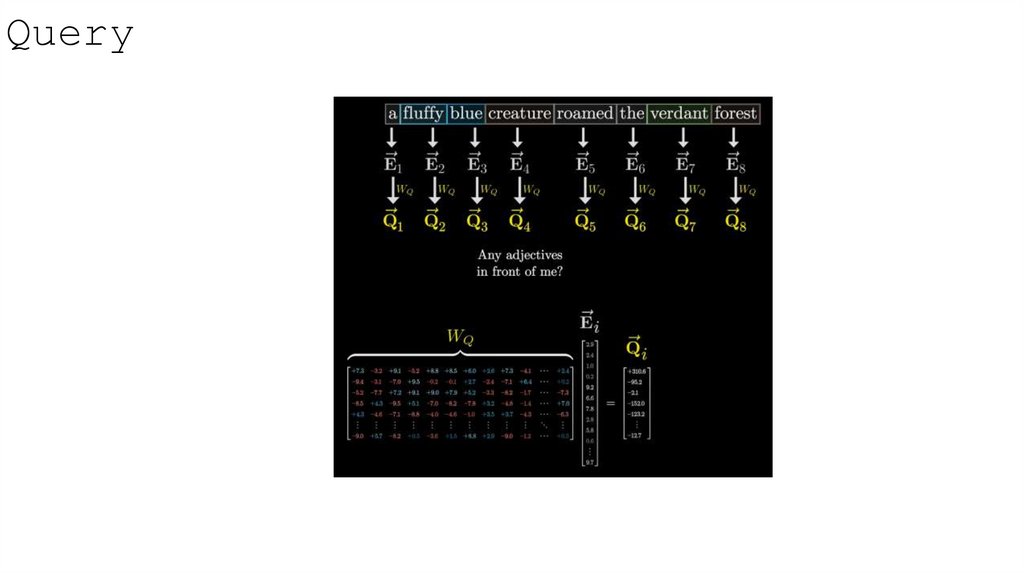

8. Query

https://www.youtube.com/@3blue1brown9. Query

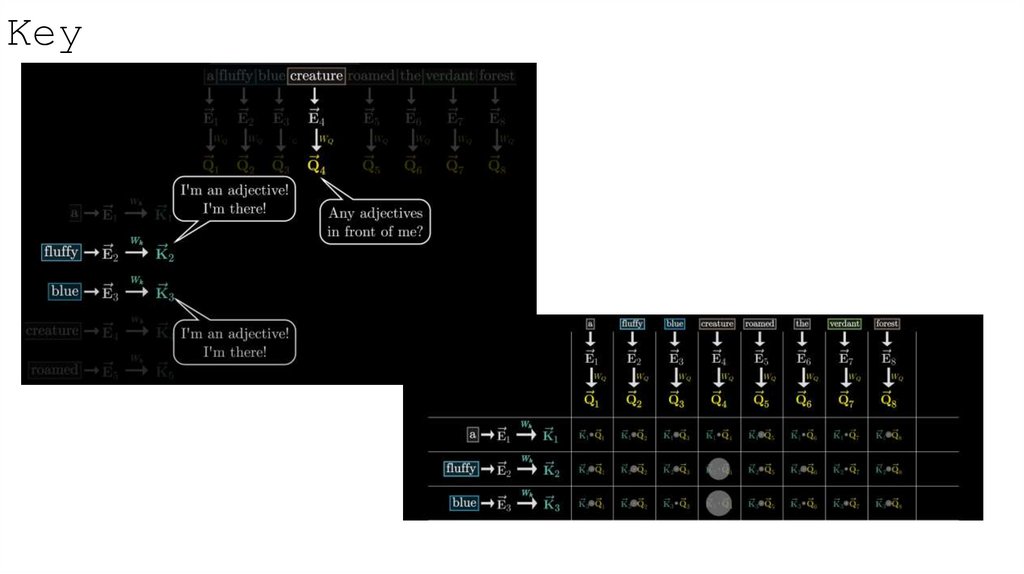

10. Key

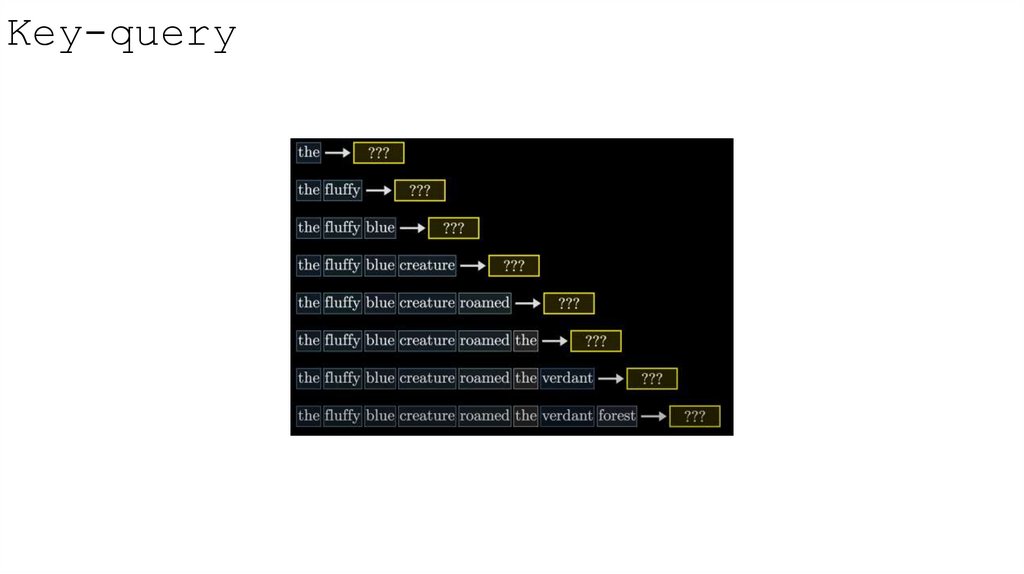

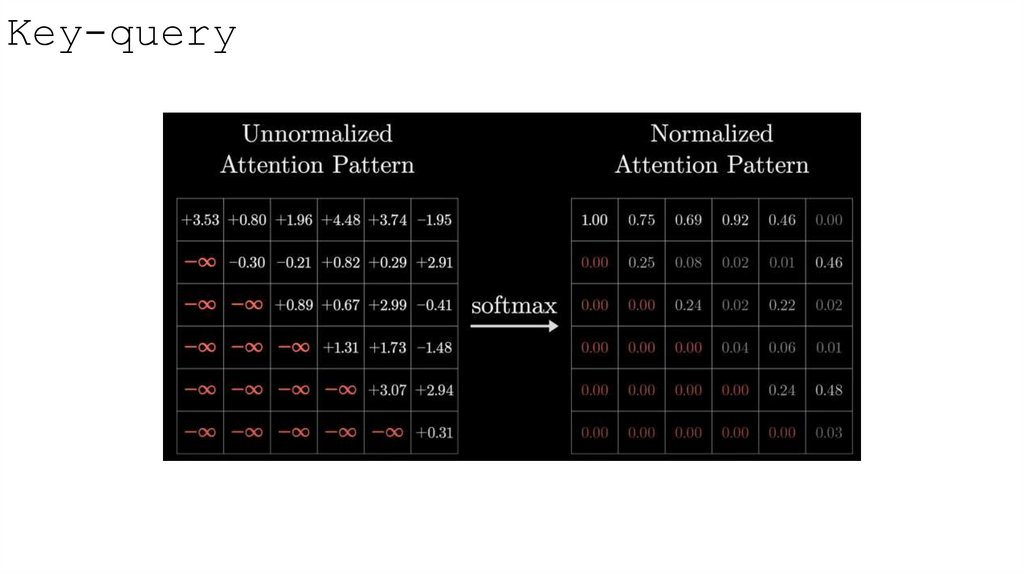

11. Key-query

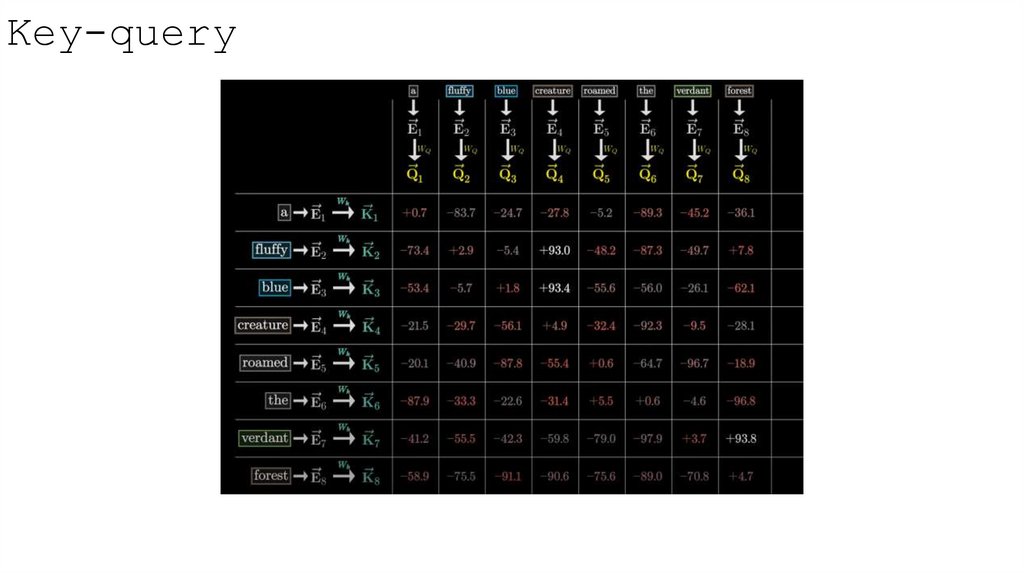

12. Key-query

• Матрицы Q, K и V – основа механизмаПри интерпретации уже обученных моделей были

выявлены следующие абстракции

13. Key-query

14. Key-query

15. Key-query

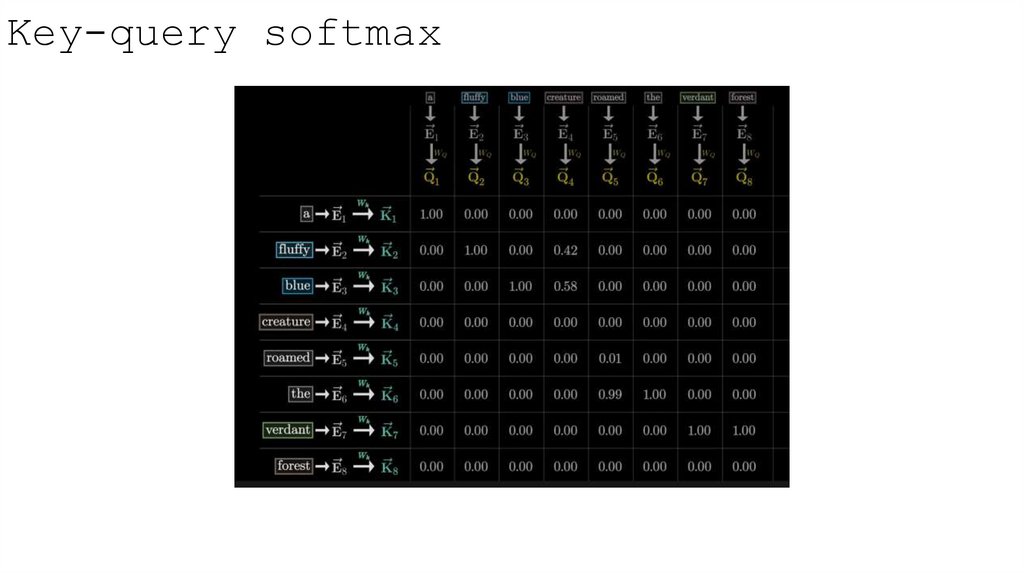

16. Key-query softmax

17. Key-query

• Матрицы Q, K и V – основа механизмаПри интерпретации уже обученных моделей были

выявлены следующие абстракции

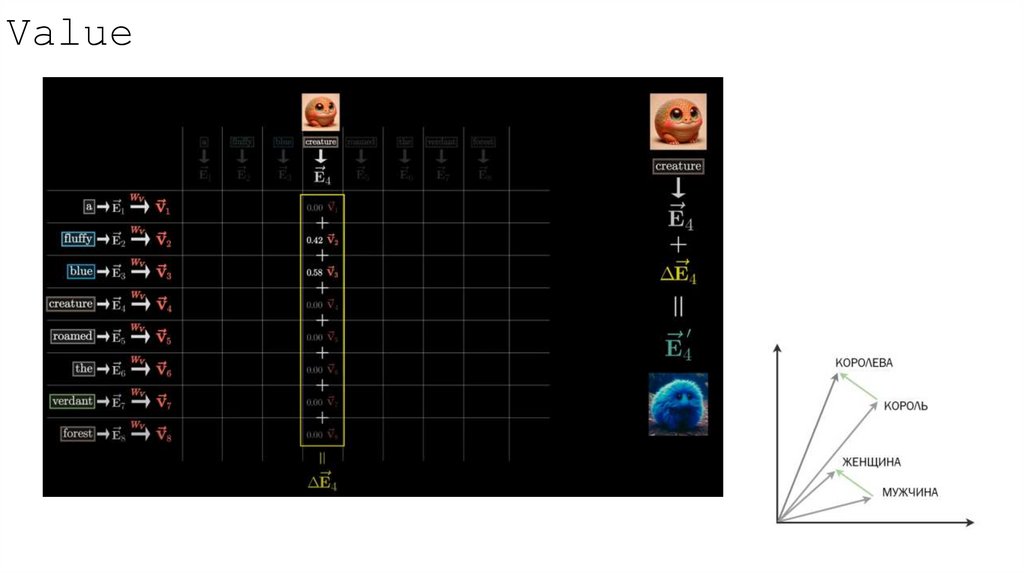

18. Value

19. Value

20. Value

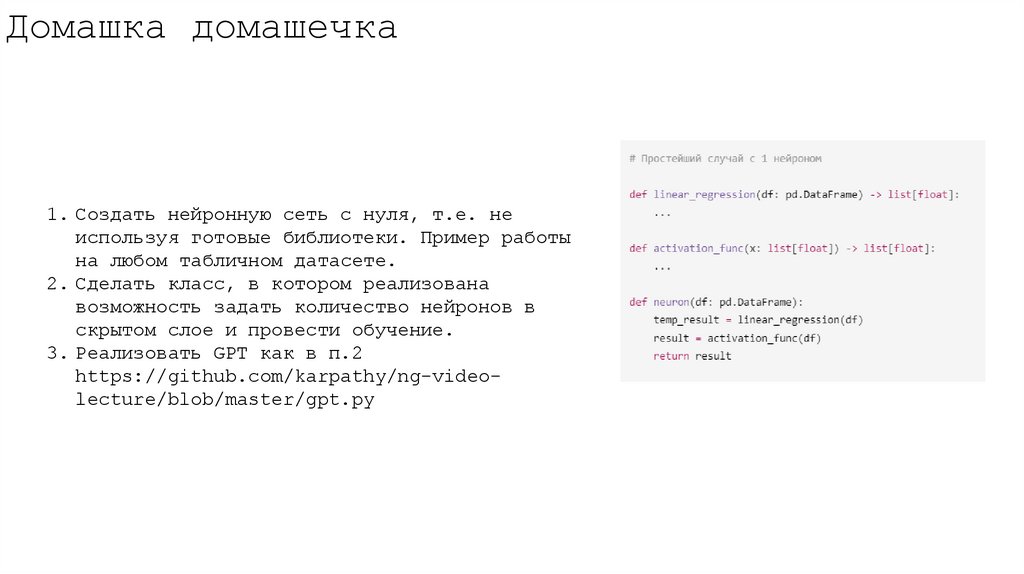

21. Домашка домашечка

1. Создать нейронную сеть с нуля, т.е. неиспользуя готовые библиотеки. Пример работы

на любом табличном датасете.

2. Сделать класс, в котором реализована

возможность задать количество нейронов в

скрытом слое и провести обучение.

3. Реализовать GPT как в п.2

https://github.com/karpathy/ng-videolecture/blob/master/gpt.py

informatics

informatics