Similar presentations:

Классическая линейная модель множественной регрессии. МНК. Лекция 2

1. Классическая линейная модель множественной регрессии. МНК

2. Постановка задачи регрессионного анализа

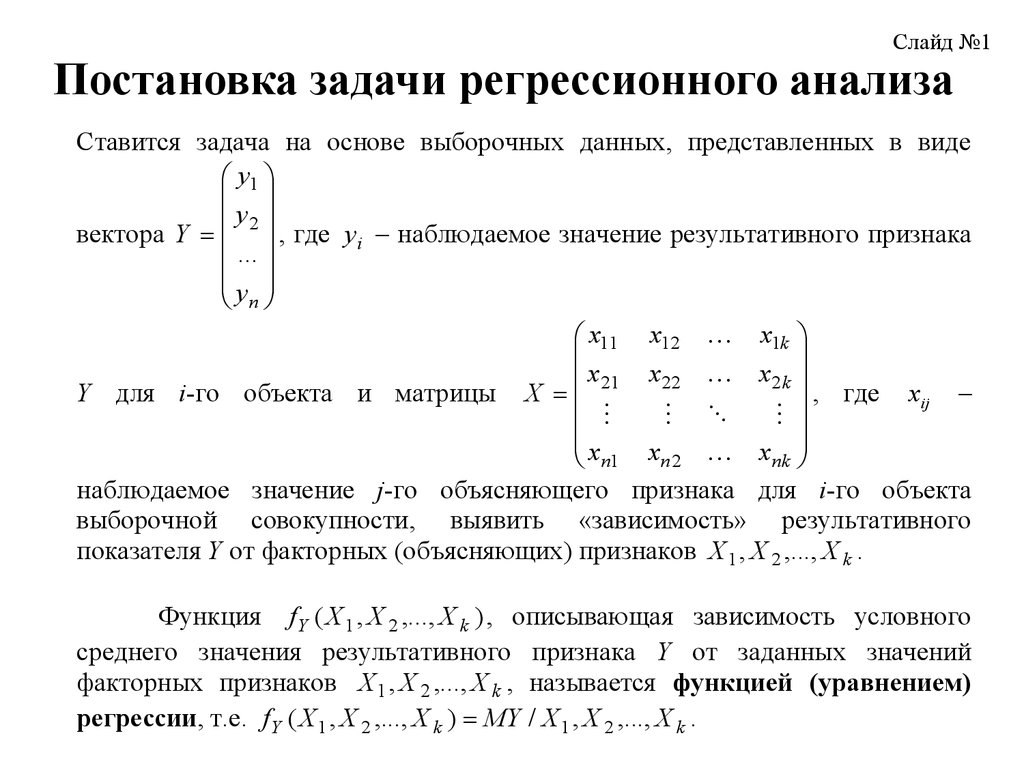

Слайд №1Постановка задачи регрессионного анализа

Ставится задача на основе выборочных данных, представленных в виде

y1

y

вектора Y 2 , где yi – наблюдаемое значение результативного признака

...

yn

x11 x12 x1k

x22 x 2 k

x

Y для i-го объекта и матрицы X 21

, где xij –

x n1 x n 2 xnk

наблюдаемое значение j-го объясняющего признака для i-го объекта

выборочной совокупности, выявить «зависимость» результативного

показателя Y от факторных (объясняющих) признаков X 1 , X 2 ,..., X k .

Функция f Y ( X 1 , X 2 ,..., X k ) , описывающая зависимость условного

среднего значения результативного признака Y от заданных значений

факторных признаков X 1 , X 2 ,..., X k , называется функцией (уравнением)

регрессии, т.е. f Y ( X 1 , X 2 ,..., X k ) МY / X 1 , X 2 ,..., X k .

3. Линейная модель множественной регрессии

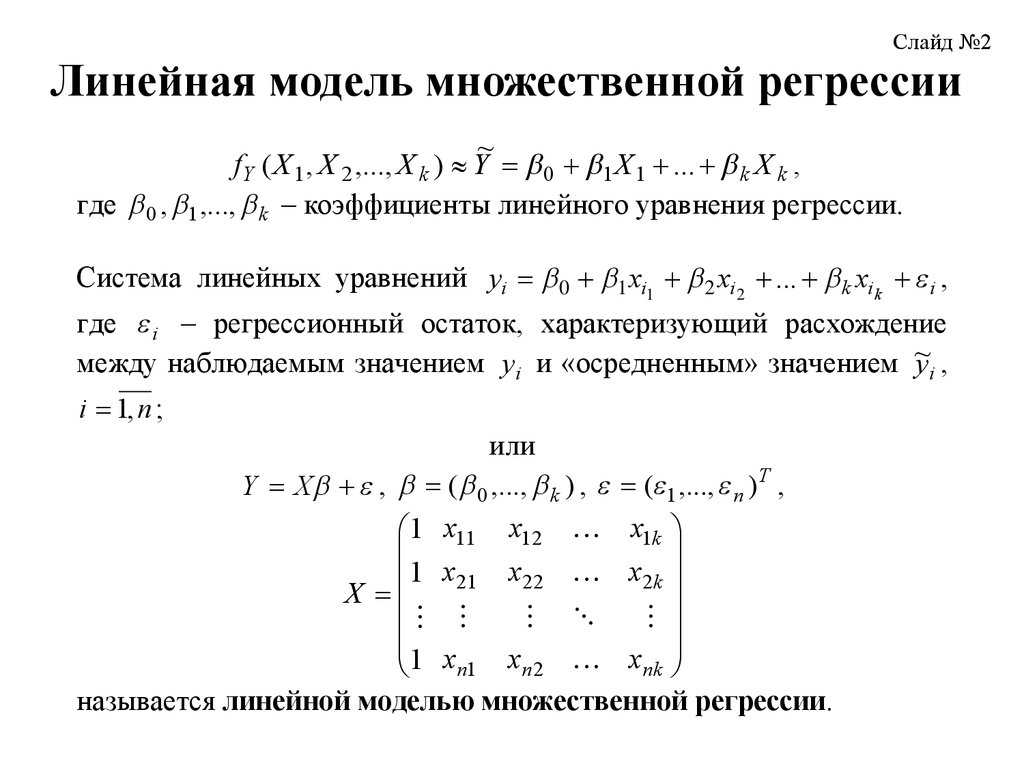

Слайд №2Линейная модель множественной регрессии

~

f Y ( X 1 , X 2 ,..., X k ) Y 0 1 X 1 ... k X k ,

где 0 , 1 ,..., k – коэффициенты линейного уравнения регрессии.

Система линейных уравнений yi 0 1 xi1 2 xi2 ... k xik i ,

где i – регрессионный остаток, характеризующий расхождение

между наблюдаемым значением y i и «осредненным» значением ~

yi ,

i 1, n ;

или

Y X , ( 0 ,..., k ) , ( 1 ,..., n ) T ,

1 x11 x12 x1k

1 x21 x22 x2k

X

1 xn1 x n 2 xnk

называется линейной моделью множественной регрессии.

4. Геометрическая интерпретация функции регрессии

Слайд №3Геометрическая интерпретация функции регрессии

y

~

y 0 1x1

yi

ei

~y

i

xi1

x

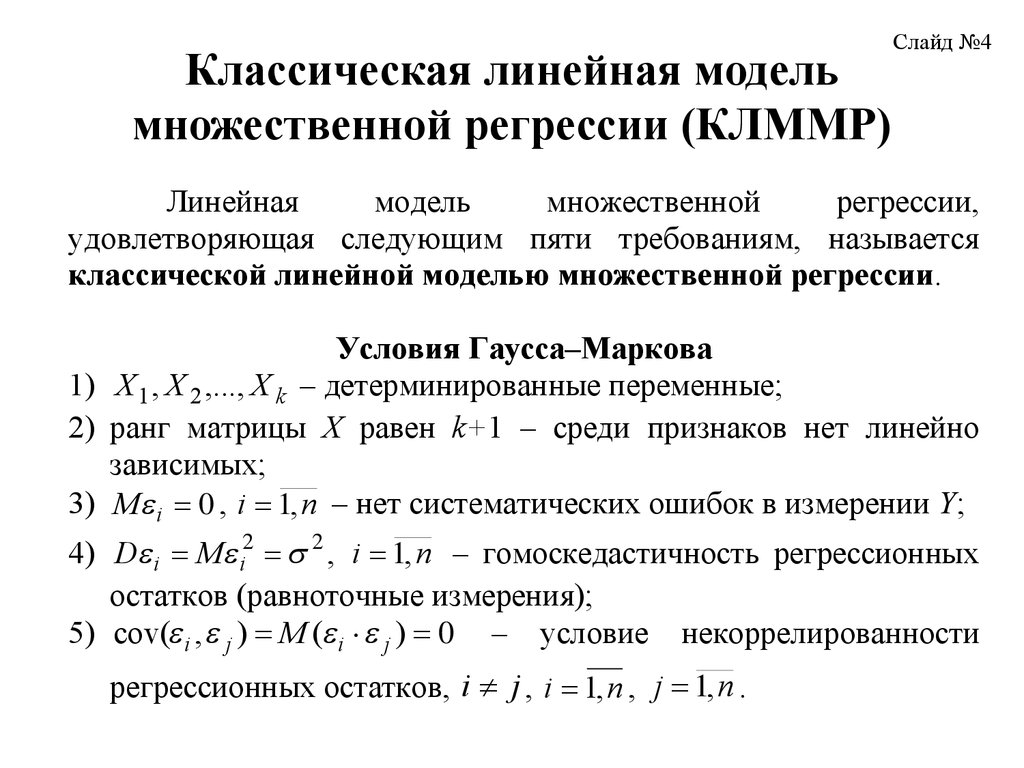

5. Классическая линейная модель множественной регрессии (КЛММР)

Слайд №4Линейная

модель

множественной

регрессии,

удовлетворяющая следующим пяти требованиям, называется

классической линейной моделью множественной регрессии.

Условия Гаусса–Маркова

1) X 1 , X 2 ,..., X k – детерминированные переменные;

2) ранг матрицы Х равен k+1 – среди признаков нет линейно

зависимых;

3) M i 0 , i 1, n – нет систематических ошибок в измерении Y;

4) D i M i2 2 , i 1, n – гомоскедастичность регрессионных

остатков (равноточные измерения);

5) cov( i , j ) M ( i j ) 0 – условие некоррелированности

регрессионных остатков, i j , i 1, n , j 1, n .

6. Методы оценки коэффициентов КЛММР

Слайд №5Методы оценки коэффициентов КЛММР

1. Минимума отклонения наблюдаемых значений

результативного признака от значений, полученных

n

по функции регрессии:

i 1

( yi ~

yi ) min .

2.

Минимум

сумму

абсолютных

величин

отклонения значений результативного признака от

значений, полученных по функции регрессии:

n

i 1

/ yi ~

y i / min .

3. Минимум суммы квадратов отклонений

наблюденных значений yi от "значений" функции

регрессии:

n

i 1

( yi ~

y i ) 2 min .

Критерий

положен

в

основу метода наименьших квадратов.

4. Метод максимального правдоподобия, который

может быть применен в тех случаях, когда с

точностью до неизвестных значений параметров

известен

общий

вид

закона

распределения

вероятностей имеющихся выборочных данных.

7. Метод наименьших квадратов

Слайд №6n

F ( y i b0 b1 x i1 b2 x i 2 ... bk x in ) 2 (Y X b ) T (Y X b )

i 1

Y T Y b T X T Y Y T X b b T X T X b Y T Y 2b T X T Y b T X T X b min

2 X T Xb 2 X T Y 0

В силу предположения о справедливости условий ГауссаМаркова, в частности (Х=k+1), матрица ХТХ – не вырождена и

получим МНК - оценки для вектора :

bМНК b ( X T X ) 1 X T Y

оценка уравнения регрессии:

yˆ b0 b1 x1 b2 x 2 ... bk x k

( Sb 0 )

( sb1 )

( Sb 2 )

( Sbk )

informatics

informatics