Similar presentations:

a75bf822-48c5-411a-8215-6d5589d2a0a5

1.

Обзор и ключевые темы:Энтропия в физике

Энтропия — основа термодинамики и

статистической физики, исследующая

порядок и хаос.

Зуев Максим

2.

Истоки и развитие понятия энтропииВ 1865 году Рудольф Клаузиус ввёл термин «энтропия», связывающий тепло и

изменение состояния. Позже Больцман дал микроскопическое объяснение через

статистику молекул.

2

3.

Формальное определение энтропииЭнтропия характеризует степень

беспорядка или хаоса в физической

системе и отражает её

микроскопическую неопределённость.

С точки зрения термодинамики,

энтропия определяется изменением

теплоты при обратимом процессе

через формулу S = Q/T.

В теории информации энтропия

измеряет среднюю неопределённость

или количество информации,

необходимой для описания

случайного события.

3

4.

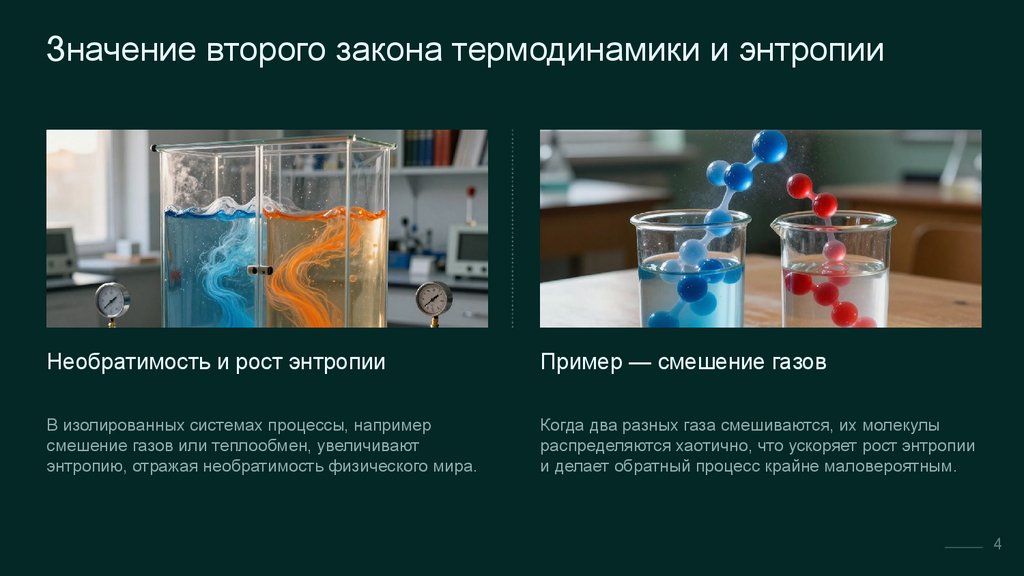

Значение второго закона термодинамики и энтропииНеобратимость и рост энтропии

Пример — смешение газов

В изолированных системах процессы, например

смешение газов или теплообмен, увеличивают

энтропию, отражая необратимость физического мира.

Когда два разных газа смешиваются, их молекулы

распределяются хаотично, что ускоряет рост энтропии

и делает обратный процесс крайне маловероятным.

4

5.

Ключевой вклад Больцмана— связь макроскопических

свойств с вероятностным

числом микросостояний.

5

6.

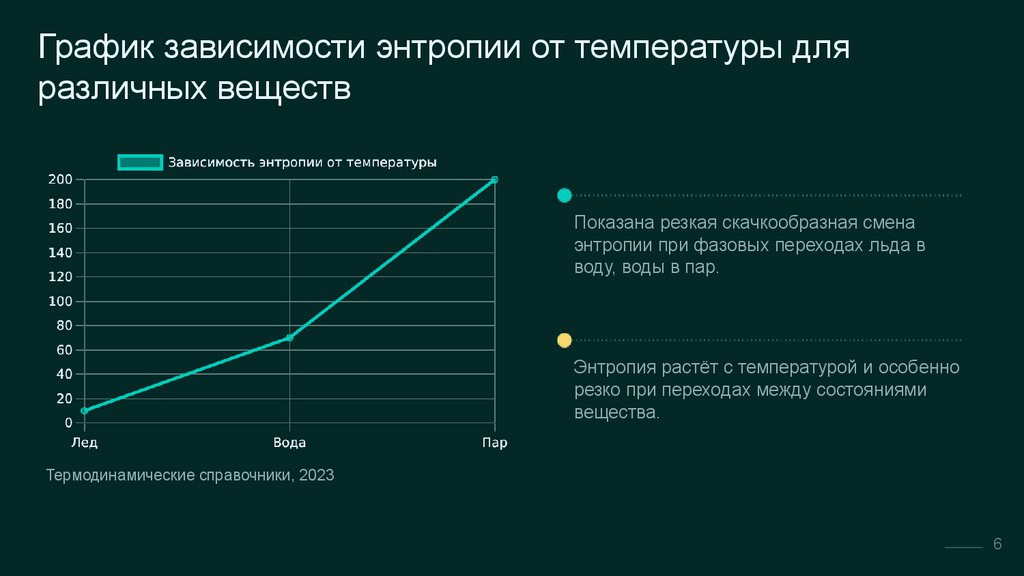

График зависимости энтропии от температуры дляразличных веществ

Показана резкая скачкообразная смена

энтропии при фазовых переходах льда в

воду, воды в пар.

Энтропия растёт с температурой и особенно

резко при переходах между состояниями

вещества.

Термодинамические справочники, 2023

6

7.

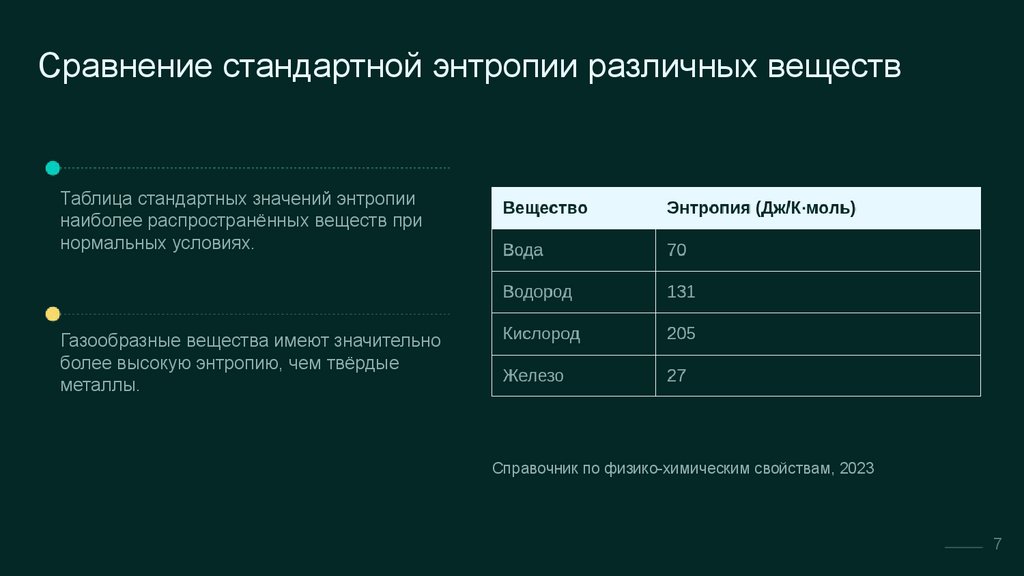

Сравнение стандартной энтропии различных веществТаблица стандартных значений энтропии

наиболее распространённых веществ при

нормальных условиях.

Газообразные вещества имеют значительно

более высокую энтропию, чем твёрдые

металлы.

Справочник по физико-химическим свойствам, 2023

7

8.

Энтропия в биологии и химииВ живых организмах энтропия локально

снижается благодаря потреблению энергии,

обеспечивая порядок и жизнедеятельность.

Во многих химических реакциях увеличение

числа или сложность продуктов

сопровождается возрастанием энтропии

системы в целом.

8

9.

Связь энтропии с теорией информацииКлод Шеннон ввёл понятие информационной энтропии

для количественной оценки неопределённости в

сообщениях.

Информационная энтропия измеряет среднее число

бит, необходимое для кодирования случайного

сообщения.

Это связывает физическое понятие энтропии с

вероятностным описанием информации и

коммуникаций.

Таким образом, энтропия объединяет представления о

беспорядке в природе и неопределённости в данных.

9

10.

Значение и современныеаспекты энтропии

Энтропия — ключевое понятие, объединяющее

физику, химию, биологию и информатику,

объясняющее необратимость и сложность

природных процессов.