Similar presentations:

Метрики в задачах ранжирования и матчинга

1.

Метрики в задачахранжирования и матчинга.

KARPOV.COURSES

2.

План лекции• метрики качества с точки зрения классификации

• особенности метрик качества для матчинга

• метрики качества с точки зрения ранжирования

3.

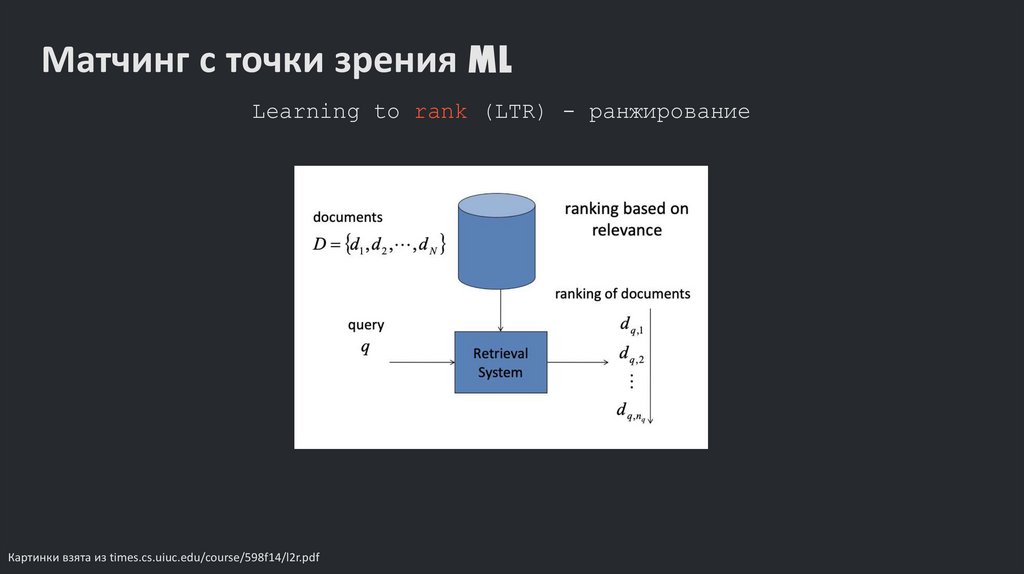

Матчинг с точки зрения MLLearning to rank (LTR) - ранжирование

Картинки взята из times.cs.uiuc.edu/course/598f14/l2r.pdf

4.

Что измерять в ранжировании?• Качество / Точность – насколько аккуратна система

ранжирования?

• Измеряем возможности системы ранжировать релевантные документы

выше нерелевантных

• Эффективность – насколько быстро выдается ответ?

Сколько ресурсов нужно для формирования ответа?

• Измеряем затраты на память и время формирования ответа

• Удобство использования – насколько полезна система

для решения задач?

• Пользовательские ощущения, UX

5.

Оценка качества ранжированияМетодология оценки Кранфилда (Cranfield Evaluation Methodology):

• Зафиксированный набор документов

• Зафиксированный набор запросов

• Оценки релевантности пар (в идеале оценки даются пользователями

системы)

• Наборы должны быть репрезентативными

6.

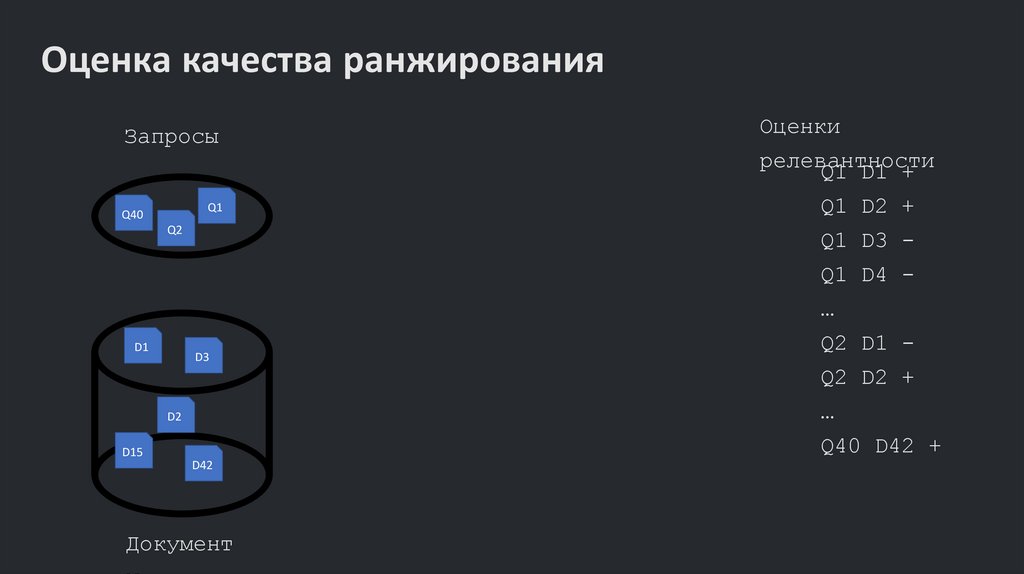

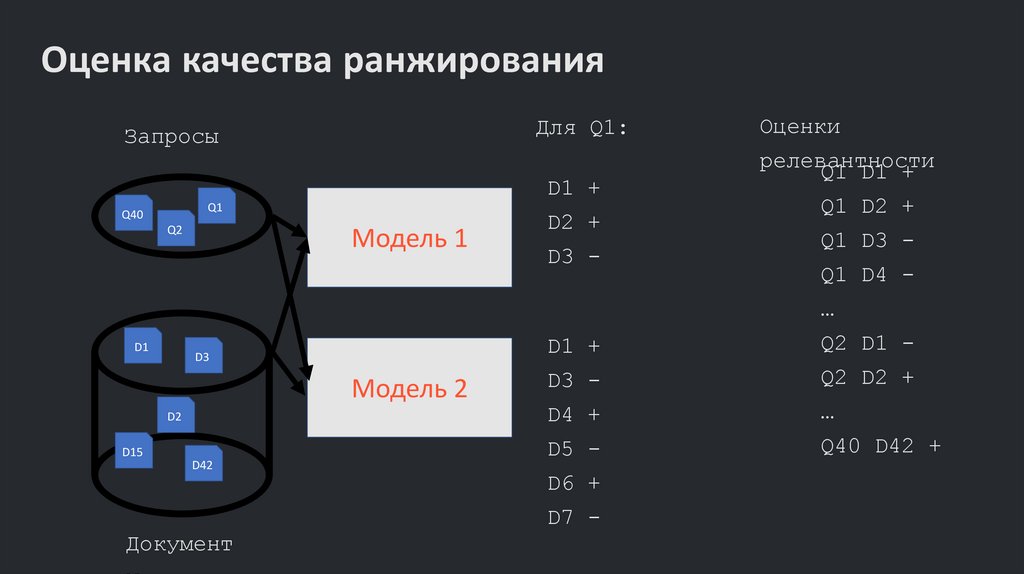

Оценка качества ранжированияЗапросы

Оценки

релевантности

Q1 D1 +

Q1

Q40

Q2

Q1 D2 +

Q1 D3 Q1 D4 …

D1

D3

Q2 D1 Q2 D2 +

…

D2

Q40 D42 +

D15

D42

Документ

7.

Оценка качества ранжированияДля Q1:

Запросы

D1 +

Q1

Q40

Q2

Модель 1

D2 +

D3 -

Оценки

релевантности

Q1 D1 +

Q1 D2 +

Q1 D3 Q1 D4 …

D1

D3

Модель 2

D2

D15

D42

D1 +

Q2 D1 -

D3 -

Q2 D2 +

D4 +

…

D5 -

Q40 D42 +

D6 +

D7 -

Документ

8.

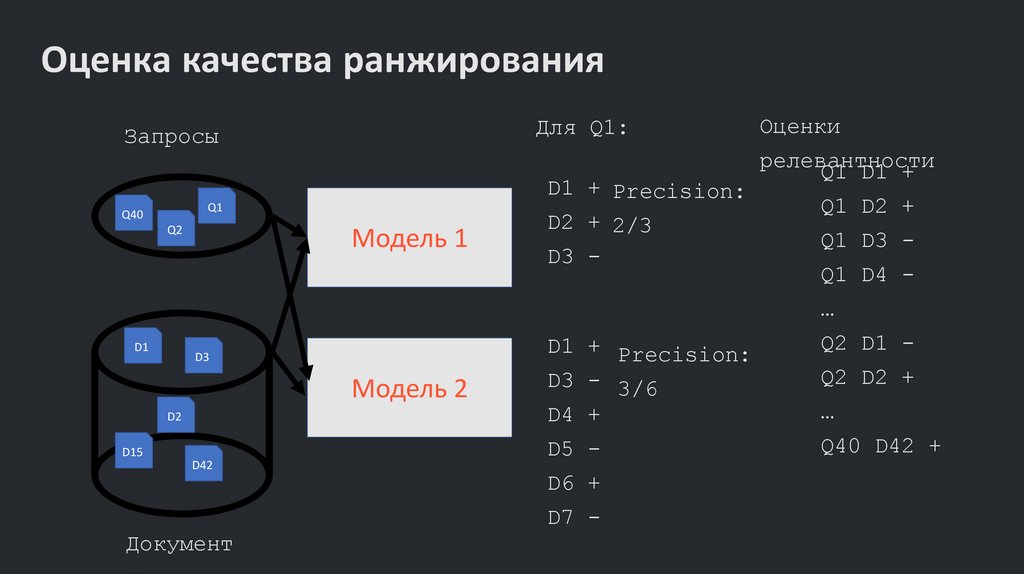

Оценка качества ранжированияДля Q1:

Запросы

Q1

Q40

Q2

Модель 1

D1 + Precision:

D2 + 2/3

D3 -

Оценки

релевантности

Q1 D1 +

Q1 D2 +

Q1 D3 Q1 D4 …

D1

D3

Модель 2

D2

D15

D42

D1 + Precision:

D3 - 3/6

Q2 D2 +

D4 +

…

D5 -

Q40 D42 +

D6 +

D7 -

Документ

Q2 D1 -

9.

Оценка качества ранжированияЗапросы

Всего

Для Q1:

релевантных 10

Q1

Q40

Q2

Модель 1

D1 + Precision:

D2 + 2/3

D3 - Recall:

2/10

D1

D3

Модель 2

D2

D15

D42

D1 + Precision:

D3 - 3/6

D4 + Recall:

D5 - 3/10

D6 +

D7 -

Документ

Оценки

релевантности

Q1 D1 +

Q1 D2 +

Q1 D3 Q1 D4 …

Q2 D1 Q2 D2 +

…

Q40 D42 +

10.

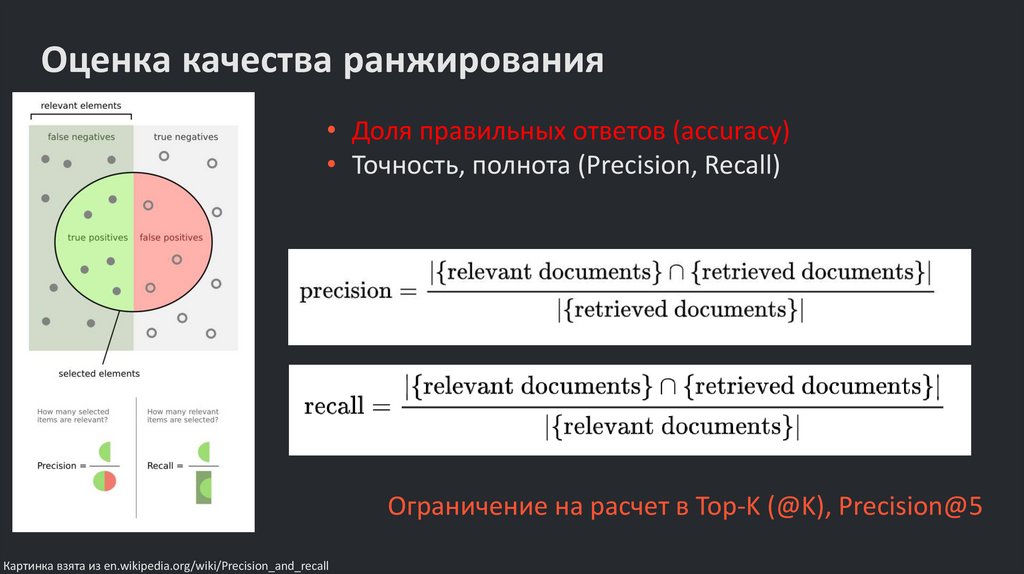

Оценка качества ранжирования• Доля правильных ответов (accuracy)

• Точность, полнота (Precision, Recall)

Ограничение на расчет в Top-K (@K), Precision@5

Картинка взята из en.wikipedia.org/wiki/Precision_and_recall

11.

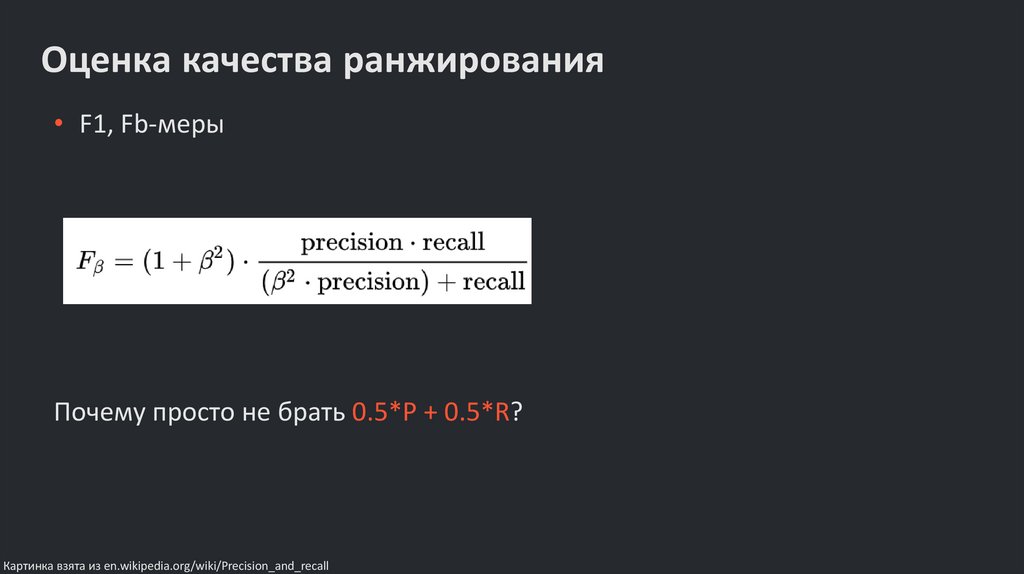

Оценка качества ранжирования• F1, Fb-меры

Почему просто не брать 0.5*P + 0.5*R?

Картинка взята из en.wikipedia.org/wiki/Precision_and_recall

12.

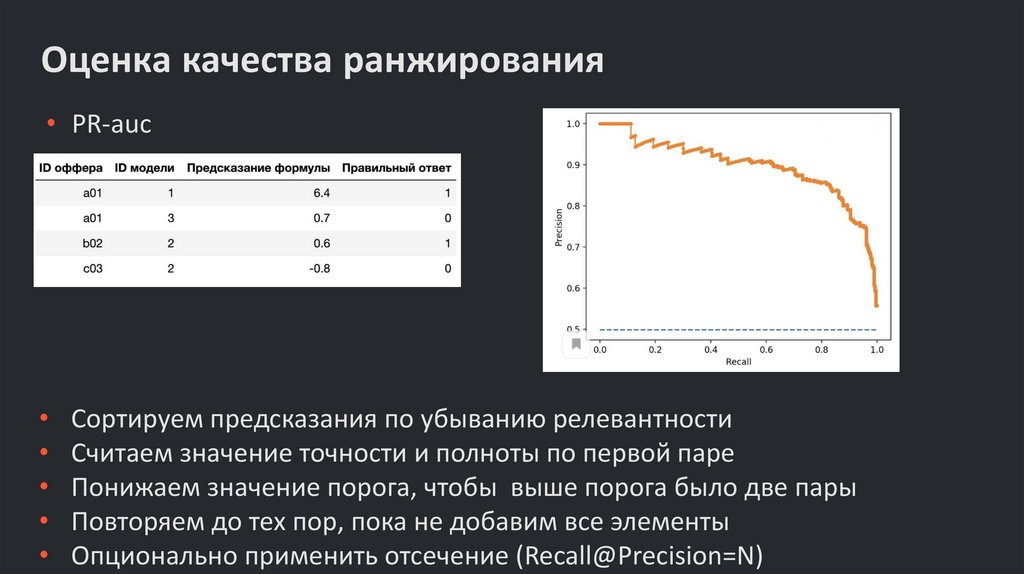

Оценка качества ранжирования• PR-auc

Сортируем предсказания по убыванию релевантности

Считаем значение точности и полноты по первой паре

Понижаем значение порога, чтобы выше порога было две пары

Повторяем до тех пор, пока не добавим все элементы

Опционально применить отсечение (Recall@Precision=N)

13.

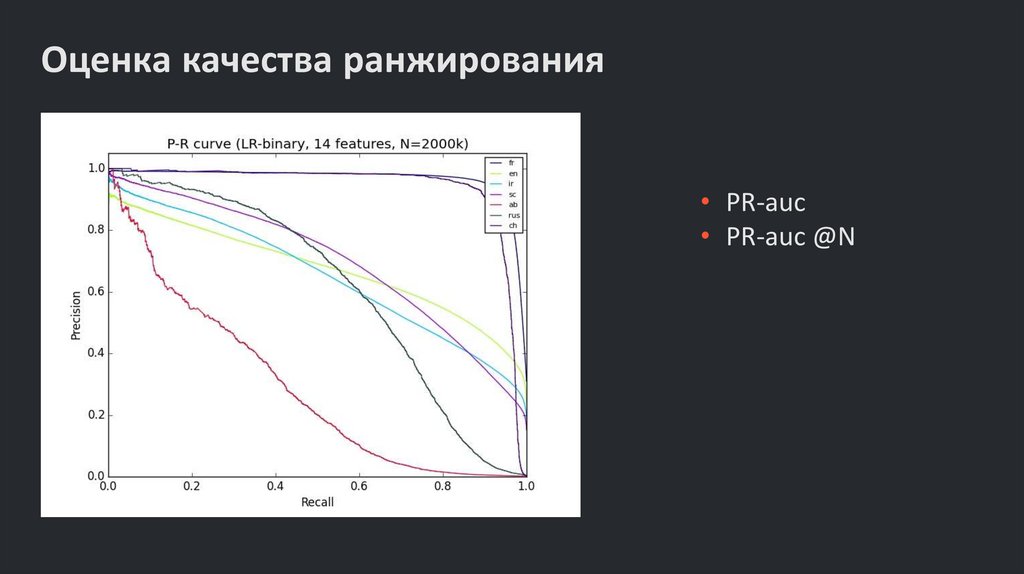

Оценка качества ранжирования• PR-auc

• PR-auc @N

14.

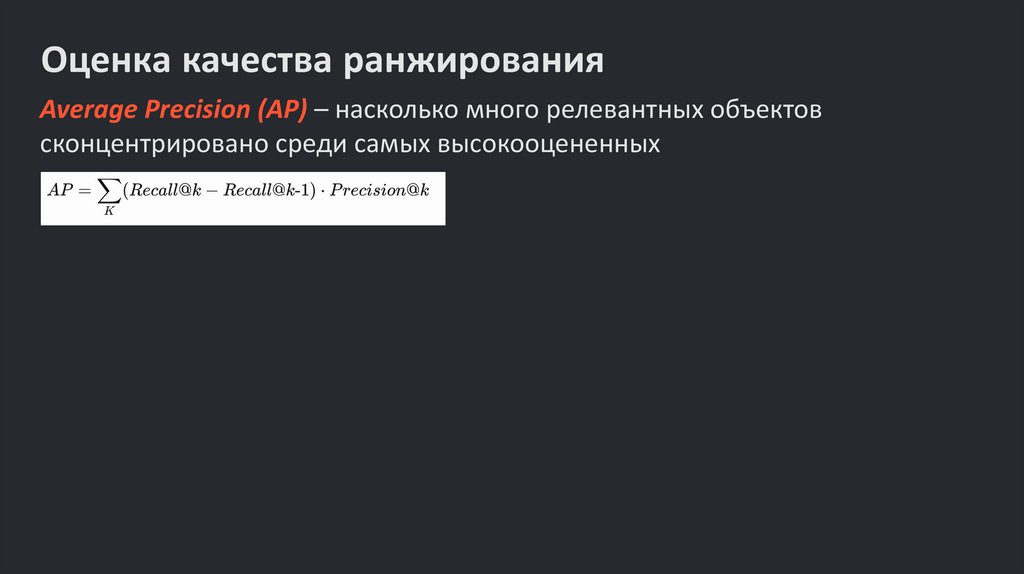

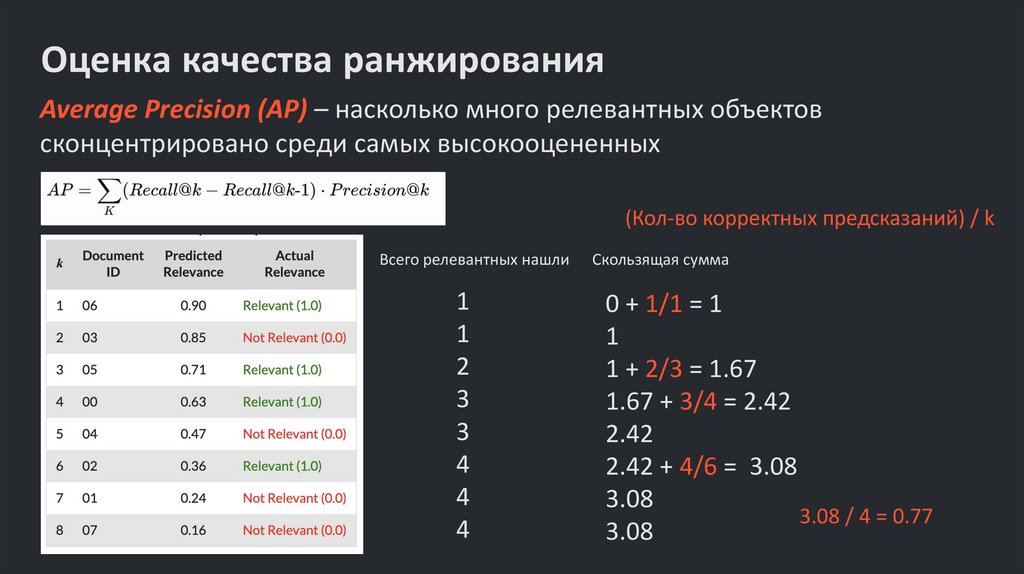

Оценка качества ранжированияAverage Precision (AP) – насколько много релевантных объектов

сконцентрировано среди самых высокооцененных

15.

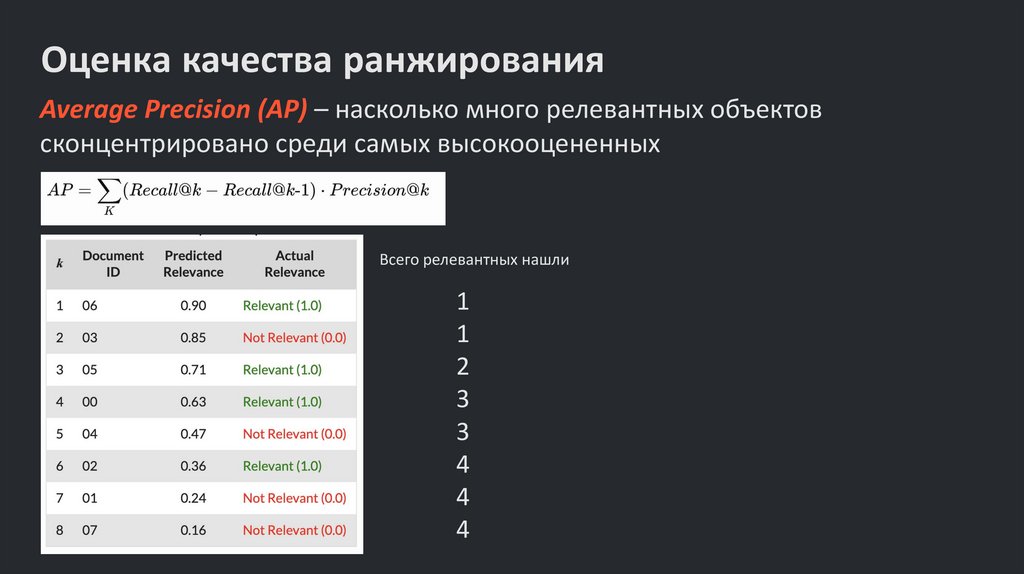

Оценка качества ранжированияAverage Precision (AP) – насколько много релевантных объектов

сконцентрировано среди самых высокооцененных

Всего релевантных нашли

1

1

2

3

3

4

4

4

16.

Оценка качества ранжированияAverage Precision (AP) – насколько много релевантных объектов

сконцентрировано среди самых высокооцененных

(Кол-во корректных предсказаний) / k

Всего релевантных нашли

1

1

2

3

3

4

4

4

Скользящая сумма

0 + 1/1 = 1

1

1 + 2/3 = 1.67

1.67 + 3/4 = 2.42

2.42

2.42 + 4/6 = 3.08

3.08

3.08 / 4 = 0.77

3.08

17.

Оценка качества ранжированияAverage Precision (AP) – насколько много релевантных объектов

сконцентрировано среди самых высокооцененных

18.

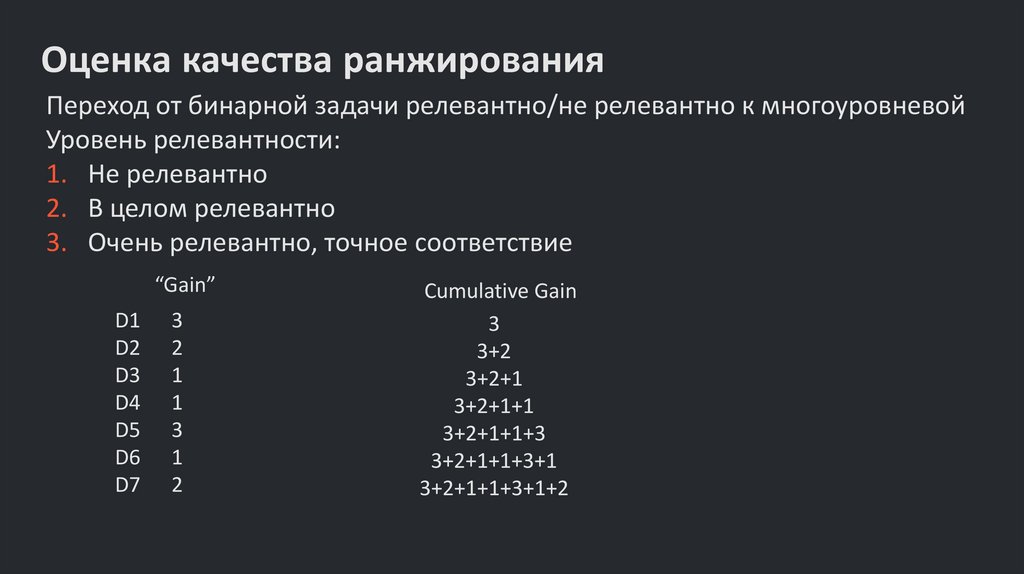

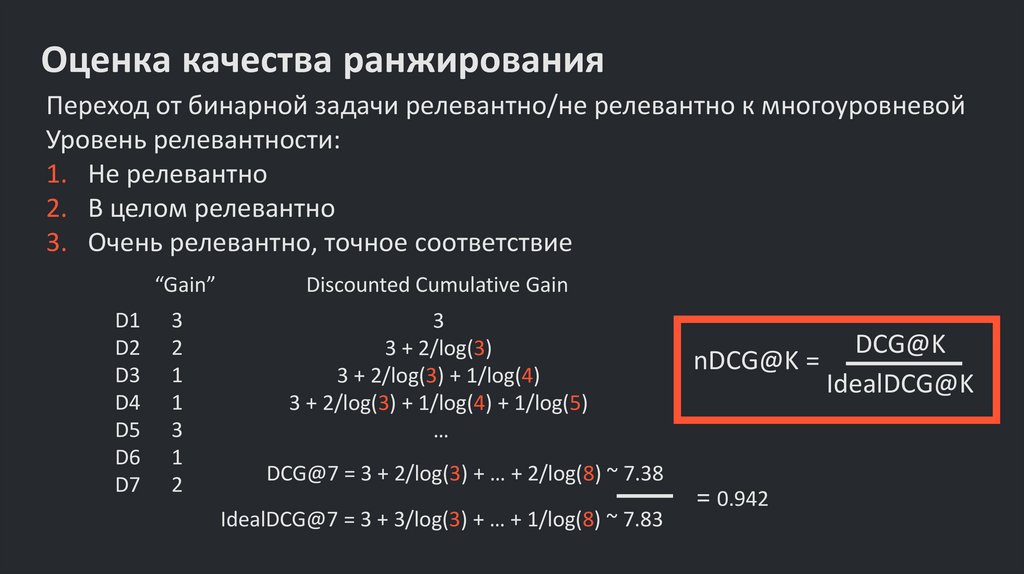

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

3. Очень релевантно, точное соответствие

19.

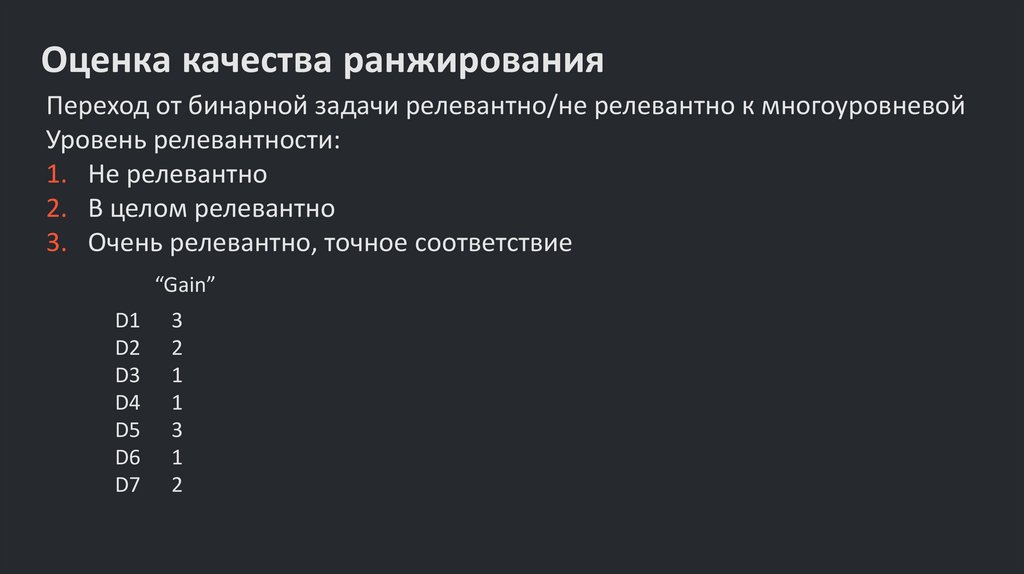

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

3. Очень релевантно, точное соответствие

“Gain”

D1

D2

D3

D4

D5

D6

D7

3

2

1

1

3

1

2

20.

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

3. Очень релевантно, точное соответствие

“Gain”

D1

D2

D3

D4

D5

D6

D7

3

2

1

1

3

1

2

Cumulative Gain

3

3+2

3+2+1

3+2+1+1

3+2+1+1+3

3+2+1+1+3+1

3+2+1+1+3+1+2

21.

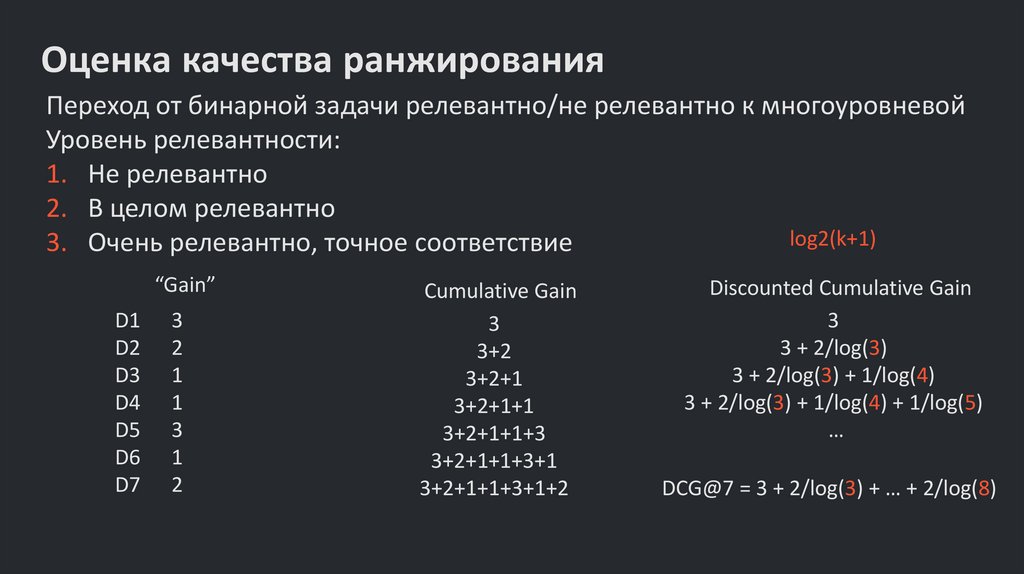

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

log2(k+1)

3. Очень релевантно, точное соответствие

“Gain”

D1

D2

D3

D4

D5

D6

D7

3

2

1

1

3

1

2

Cumulative Gain

3

3+2

3+2+1

3+2+1+1

3+2+1+1+3

3+2+1+1+3+1

3+2+1+1+3+1+2

Discounted Cumulative Gain

3

3 + 2/log(3)

3 + 2/log(3) + 1/log(4)

3 + 2/log(3) + 1/log(4) + 1/log(5)

…

DCG@7 = 3 + 2/log(3) + … + 2/log(8)

22.

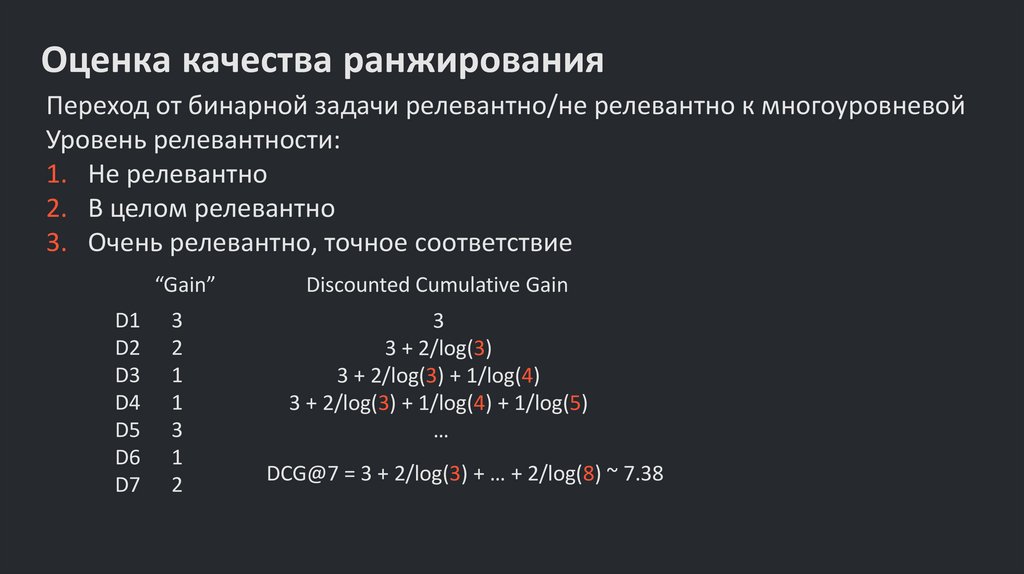

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

3. Очень релевантно, точное соответствие

“Gain”

D1

D2

D3

D4

D5

D6

D7

3

2

1

1

3

1

2

Discounted Cumulative Gain

3

3 + 2/log(3)

3 + 2/log(3) + 1/log(4)

3 + 2/log(3) + 1/log(4) + 1/log(5)

…

DCG@7 = 3 + 2/log(3) + … + 2/log(8) ~ 7.38

23.

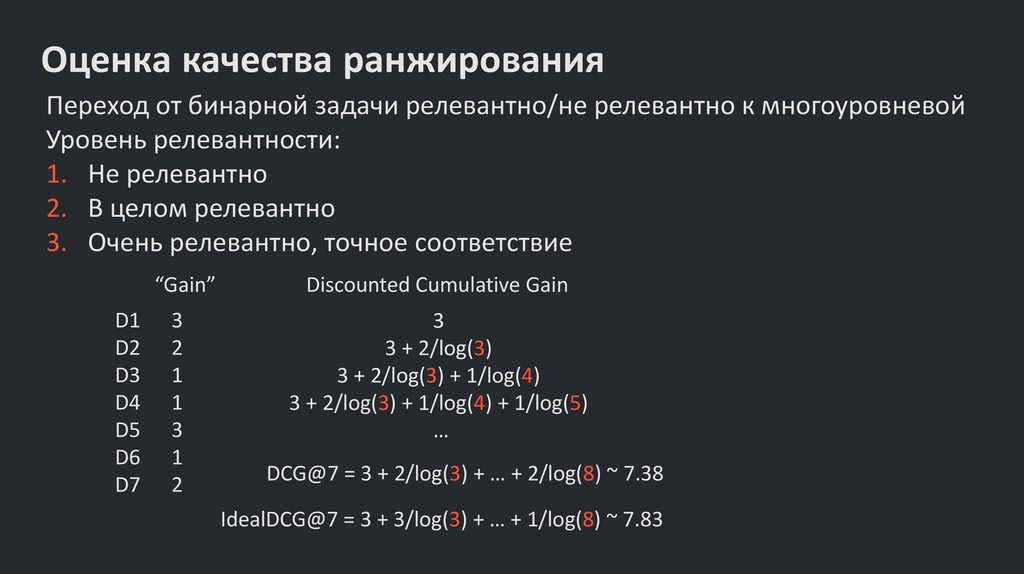

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

3. Очень релевантно, точное соответствие

“Gain”

D1

D2

D3

D4

D5

D6

D7

3

2

1

1

3

1

2

Discounted Cumulative Gain

3

3 + 2/log(3)

3 + 2/log(3) + 1/log(4)

3 + 2/log(3) + 1/log(4) + 1/log(5)

…

DCG@7 = 3 + 2/log(3) + … + 2/log(8) ~ 7.38

IdealDCG@7 = 3 + 3/log(3) + … + 1/log(8) ~ 7.83

24.

Оценка качества ранжированияПереход от бинарной задачи релевантно/не релевантно к многоуровневой

Уровень релевантности:

1. Не релевантно

2. В целом релевантно

3. Очень релевантно, точное соответствие

“Gain”

D1

D2

D3

D4

D5

D6

D7

3

2

1

1

3

1

2

Discounted Cumulative Gain

3

3 + 2/log(3)

3 + 2/log(3) + 1/log(4)

3 + 2/log(3) + 1/log(4) + 1/log(5)

…

DCG@7 = 3 + 2/log(3) + … + 2/log(8) ~ 7.38

IdealDCG@7 = 3 + 3/log(3) + … + 1/log(8) ~ 7.83

DCG@K

nDCG@K =

IdealDCG@K

= 0.942

25.

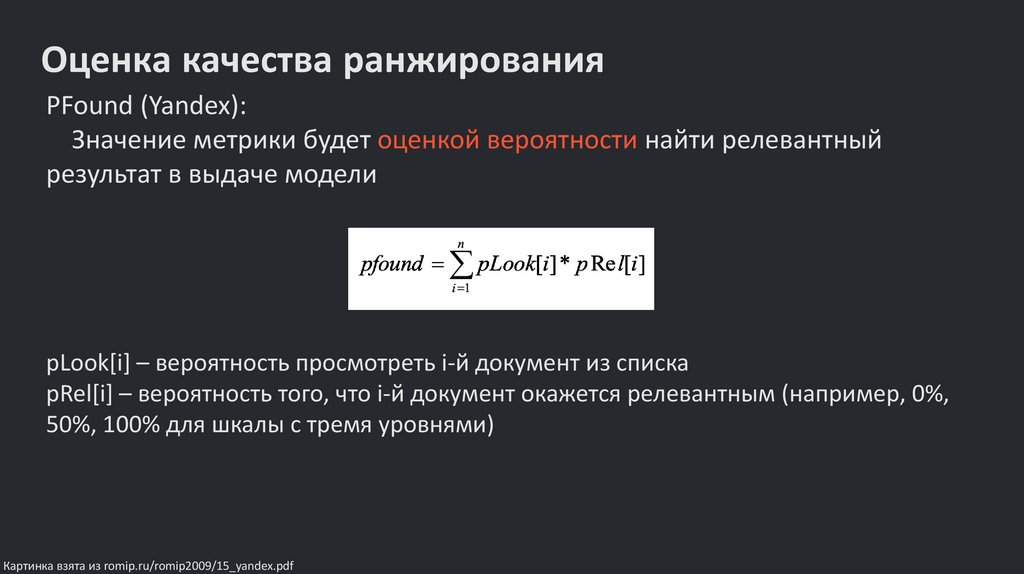

Оценка качества ранжированияPFound (Yandex):

Значение метрики будет оценкой вероятности найти релевантный

результат в выдаче модели

pLook[i] – вероятность просмотреть i-й документ из списка

pRel[i] – вероятность того, что i-й документ окажется релевантным (например, 0%,

50%, 100% для шкалы с тремя уровнями)

Картинка взята из romip.ru/romip2009/15_yandex.pdf

26.

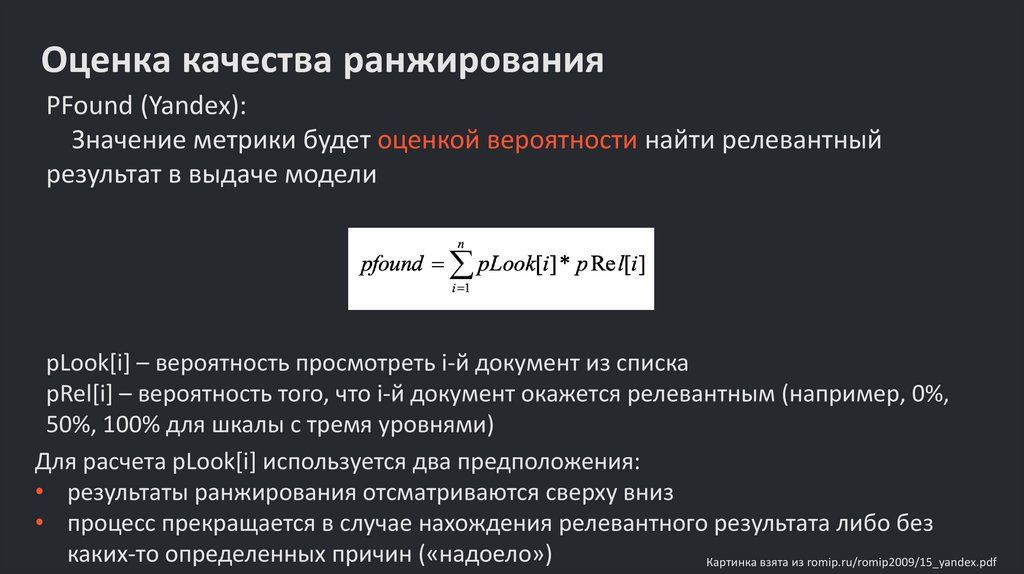

Оценка качества ранжированияPFound (Yandex):

Значение метрики будет оценкой вероятности найти релевантный

результат в выдаче модели

pLook[i] – вероятность просмотреть i-й документ из списка

pRel[i] – вероятность того, что i-й документ окажется релевантным (например, 0%,

50%, 100% для шкалы с тремя уровнями)

Для расчета pLook[i] используется два предположения:

• результаты ранжирования отсматриваются сверху вниз

• процесс прекращается в случае нахождения релевантного результата либо без

каких-то определенных причин («надоело»)

Картинка взята из romip.ru/romip2009/15_yandex.pdf

27.

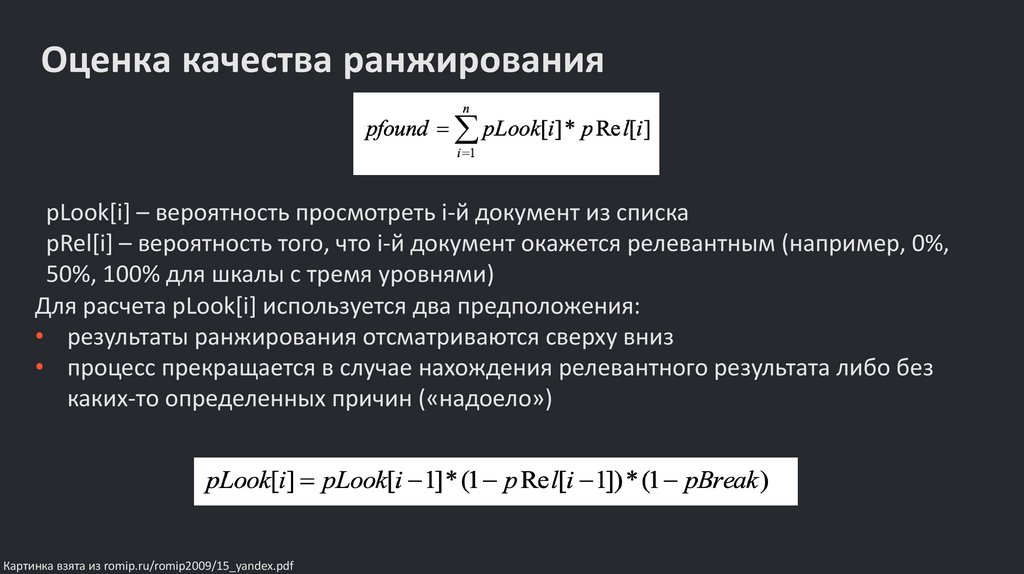

Оценка качества ранжированияpLook[i] – вероятность просмотреть i-й документ из списка

pRel[i] – вероятность того, что i-й документ окажется релевантным (например, 0%,

50%, 100% для шкалы с тремя уровнями)

Для расчета pLook[i] используется два предположения:

• результаты ранжирования отсматриваются сверху вниз

• процесс прекращается в случае нахождения релевантного результата либо без

каких-то определенных причин («надоело»)

Картинка взята из romip.ru/romip2009/15_yandex.pdf

28.

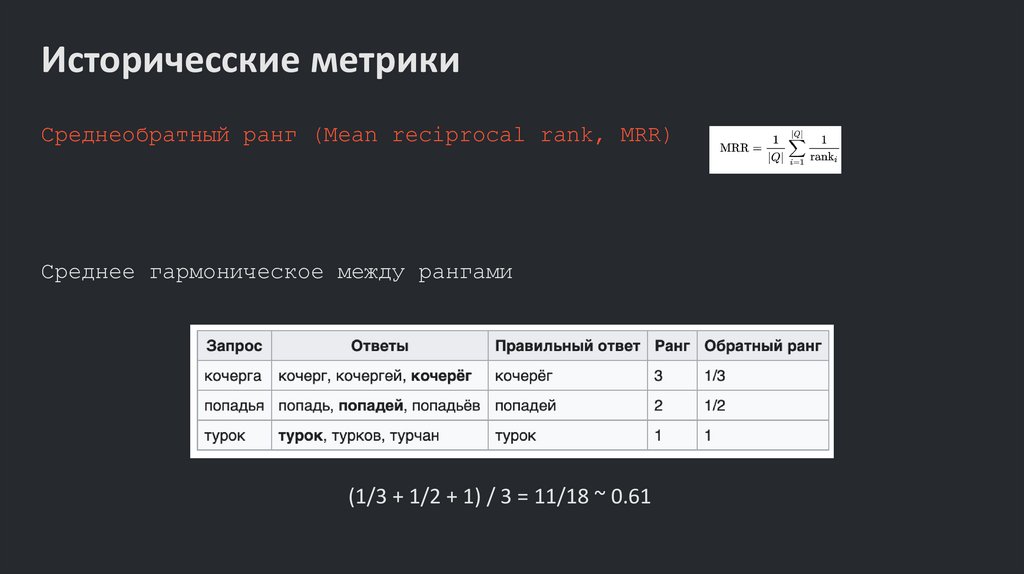

Историчесские метрикиСреднеобратный ранг (Mean reciprocal rank, MRR)

Среднее гармоническое между рангами

(1/3 + 1/2 + 1) / 3 = 11/18 ~ 0.61

29.

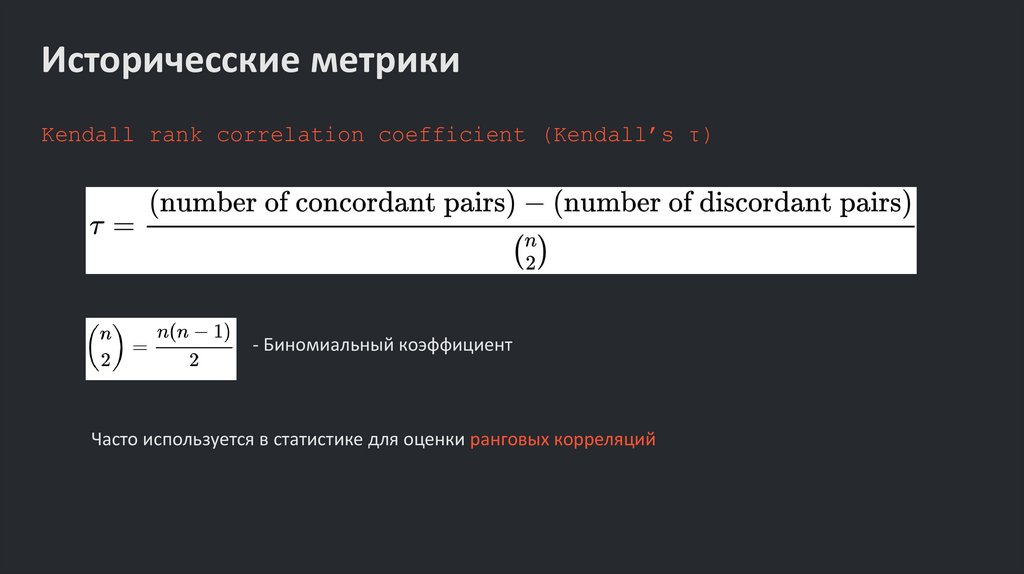

Историчесские метрикиKendall rank correlation coefficient (Kendall’s τ)

- Биномиальный коэффициент

Часто используется в статистике для оценки ранговых корреляций

30.

Матчинг и ранжированиеИмеем привилегию отказаться от выдачи

Важны только самые-самые первые результаты (1-3)

Огромный дисбаланс (от нуля до тысяч матчей)

Финальное решение можно предоставить классификатору

Отдельные метрики для разных этапов пайплайна

Метрики могут агрегироваться на уровне одного SKU

Различие прокси-метрик и бизнес-метрик

informatics

informatics