Similar presentations:

Интеллектуальные технологии анализа данных 2

1.

МИНОБРНАУКИ РОССИИФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕННОЕ БЮДЖЕТНОЕ ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ

ВЫСШЕГО ОБРАЗОВАНИЯ «ОРЕНБУРГСКИЙ ГОСУДАРСТВЕННЫЙ УНИВЕРСИТЕТ»

Современные нейросетевые

архитектуры

Искусственные нейронные сети. Многослойный

персептрон. Обучение нейросетей. Искусственный

нейрон. Функции активации. Обучение нейросетей.

Классификация

с

помощью

многослойного

персептрона.

Сверточные

нейронные

сети.

Классификация изображений. Глубокое обучение.

Перенос

обучения.

Современные

архитектуры

нейросетей для компьютерного зрения. Нейросети в

обработке текстов. Предобработка, векторизация,

классификация текстов. Рекуррентные нейронные сети

для классификации текстов. Нейросетевые методы

обработки текстов

Луговскова Юлия Петровна, к.ф.-м.н.

ОРЕНБУРГ, 2025

2.

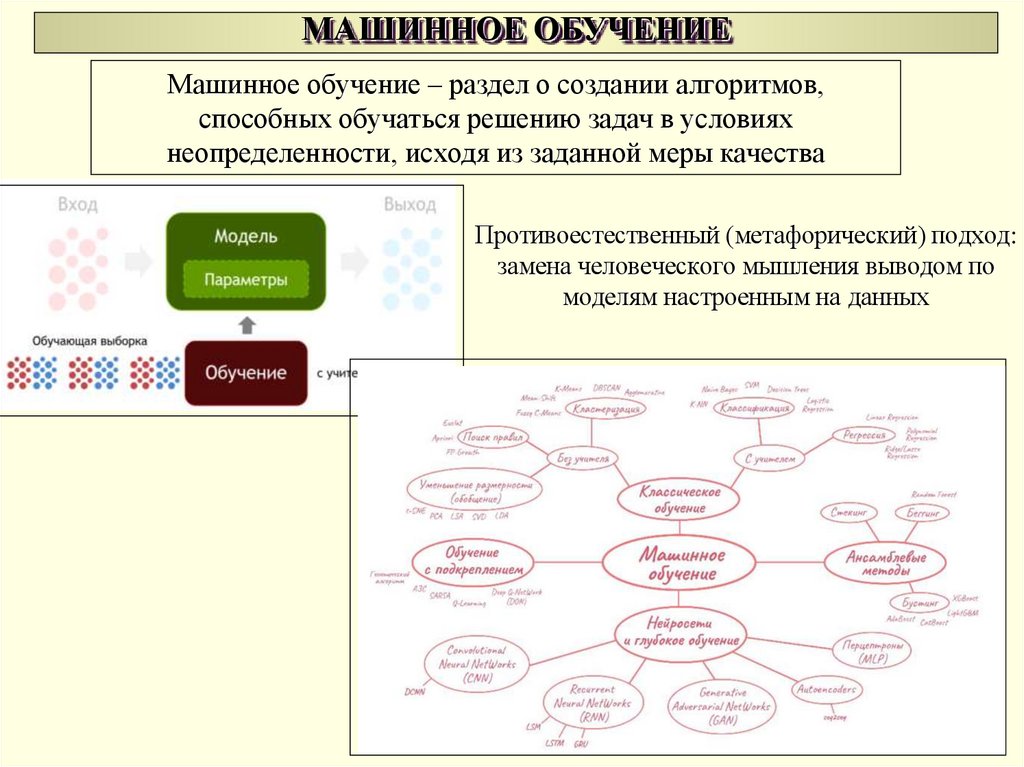

МАШИННОЕ ОБУЧЕНИЕМашинное обучение – раздел о создании алгоритмов,

способных обучаться решению задач в условиях

неопределенности, исходя из заданной меры качества

Противоестественный (метафорический) подход:

замена человеческого мышления выводом по

моделям настроенным на данных

3.

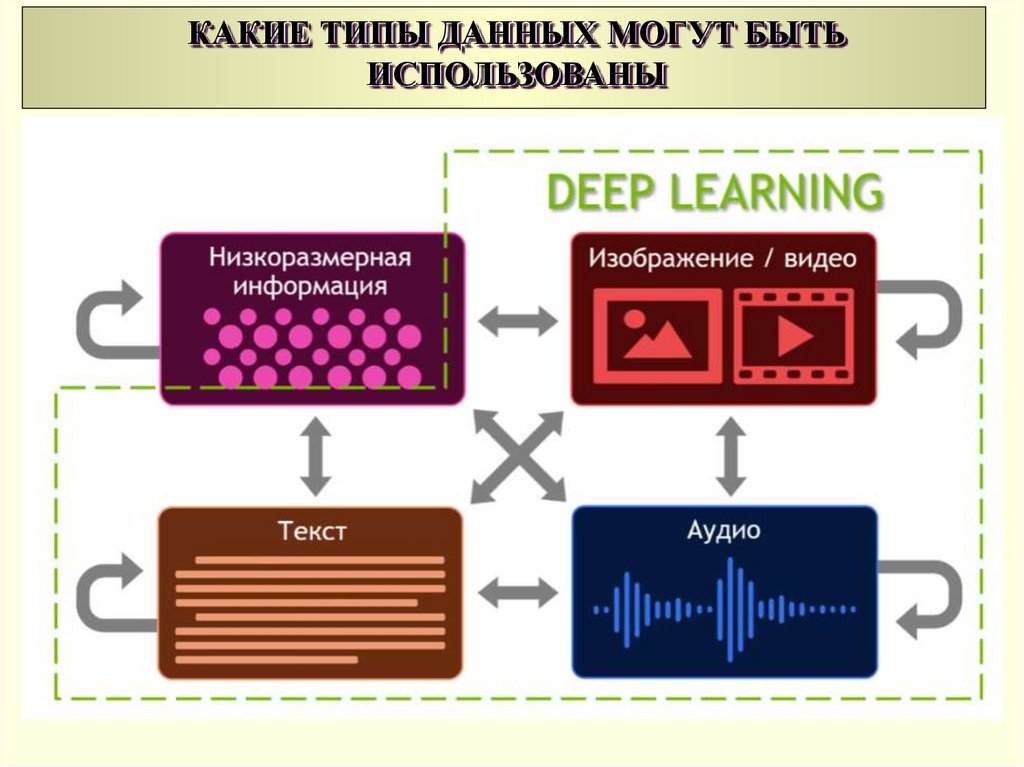

КАКИЕ ТИПЫ ДАННЫХ МОГУТ БЫТЬИСПОЛЬЗОВАНЫ

4.

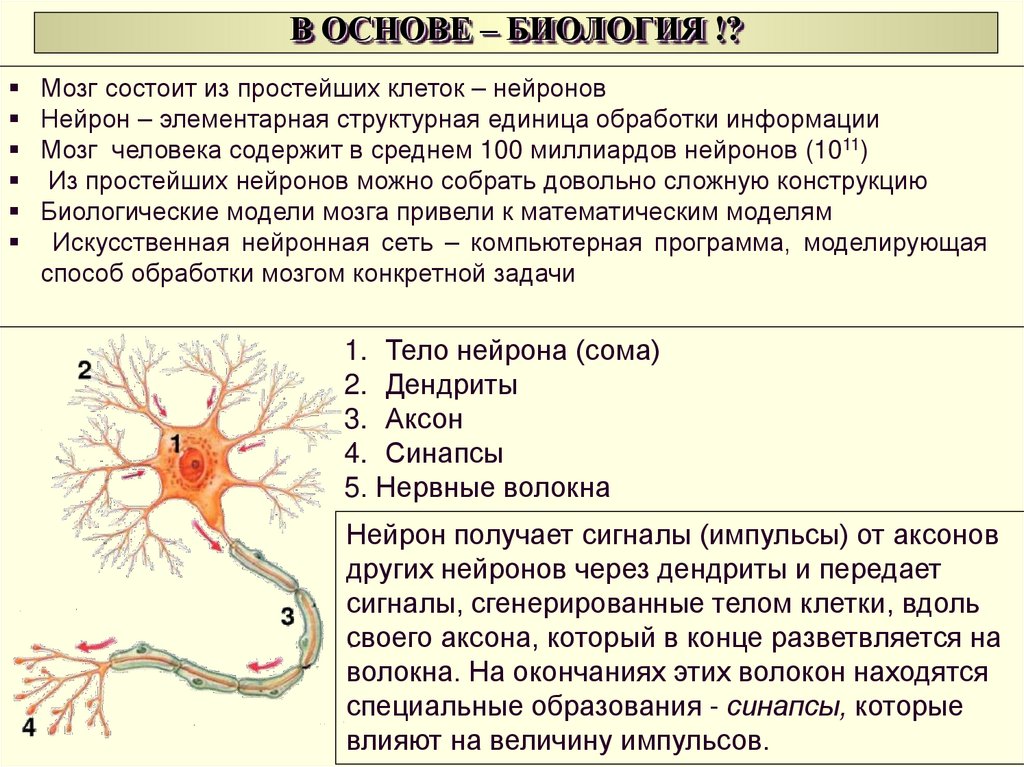

В ОСНОВЕ – БИОЛОГИЯ !?Мозг состоит из простейших клеток – нейронов

Нейрон – элементарная структурная единица обработки информации

Мозг человека содержит в среднем 100 миллиардов нейронов (1011)

Из простейших нейронов можно собрать довольно сложную конструкцию

Биологические модели мозга привели к математическим моделям

Искусственная нейронная сеть – компьютерная программа, моделирующая

способ обработки мозгом конкретной задачи

1. Тело нейрона (сома)

2. Дендриты

3. Аксон

4. Синапсы

5. Нервные волокна

Нейрон получает сигналы (импульсы) от аксонов

других нейронов через дендриты и передает

сигналы, сгенерированные телом клетки, вдоль

своего аксона, который в конце разветвляется на

волокна. На окончаниях этих волокон находятся

специальные образования - синапсы, которые

влияют на величину импульсов.

5.

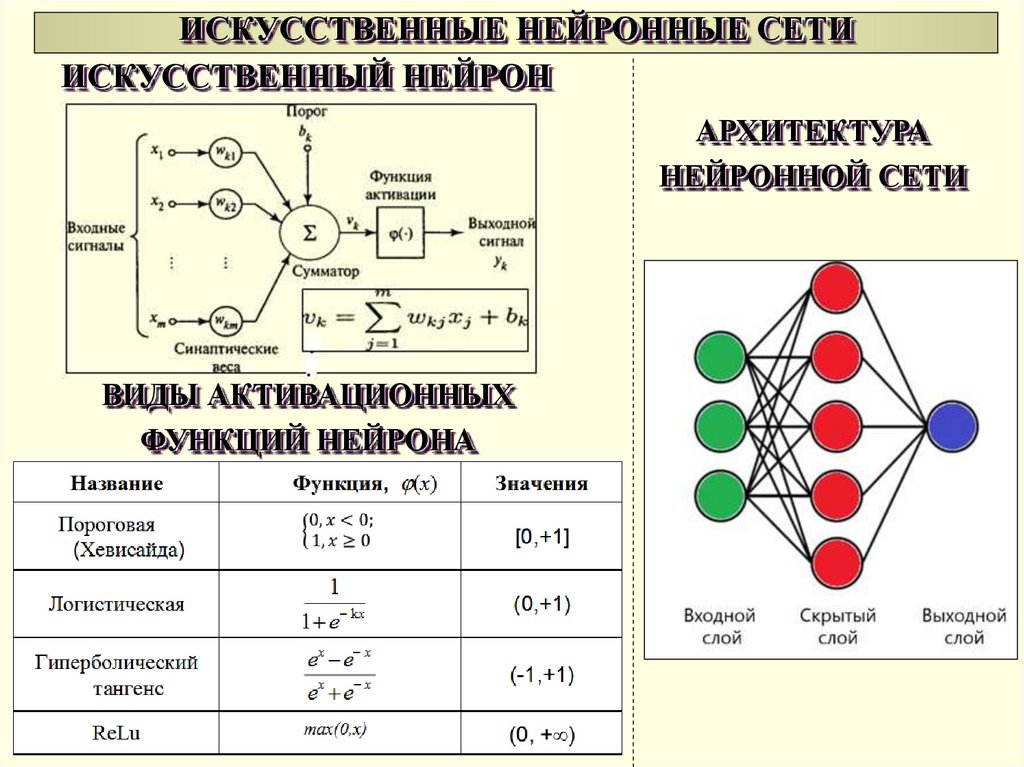

ИСКУССТВЕННЫЕ НЕЙРОННЫЕ СЕТИИСКУССТВЕННЫЙ НЕЙРОН

АРХИТЕКТУРА

НЕЙРОННОЙ СЕТИ

ВИДЫ АКТИВАЦИОННЫХ

ФУНКЦИЙ НЕЙРОНА

6.

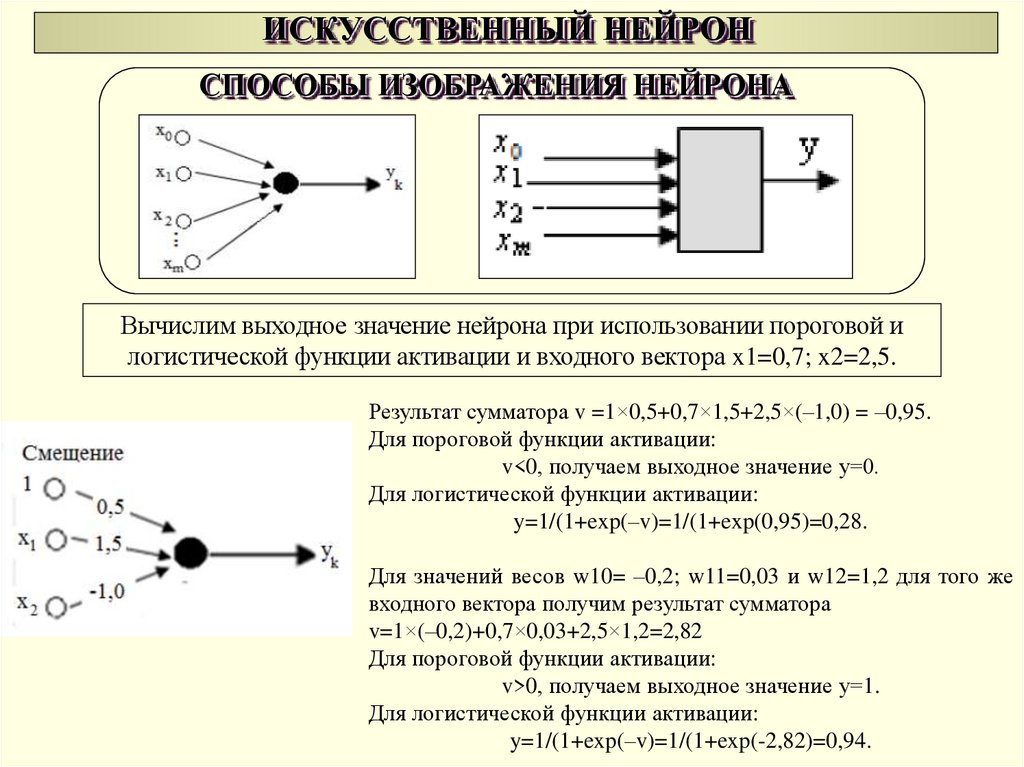

ИСКУССТВЕННЫЙ НЕЙРОНСПОСОБЫ ИЗОБРАЖЕНИЯ НЕЙРОНА

Вычислим выходное значение нейрона при использовании пороговой и

логистической функции активации и входного вектора x1=0,7; x2=2,5.

Результат сумматора v =1×0,5+0,7×1,5+2,5×(–1,0) = –0,95.

Для пороговой функции активации:

v<0, получаем выходное значение y=0.

Для логистической функции активации:

y=1/(1+exp(–v)=1/(1+exp(0,95)=0,28.

Для значений весов w10= –0,2; w11=0,03 и w12=1,2 для того же

входного вектора получим результат сумматора

v=1×(–0,2)+0,7×0,03+2,5×1,2=2,82

Для пороговой функции активации:

v>0, получаем выходное значение y=1.

Для логистической функции активации:

y=1/(1+exp(–v)=1/(1+exp(-2,82)=0,94.

7.

ИСКУССТВЕННЫЕ НЕЙРОННЫЕ СЕТИПод архитектурой понимаются общие принципы построения

нейронной сети для определенного класса задач, а под

конфигурацией – параметры конкретной нейросетевой модели.

У нейронных сетей выделяют два типа параметров: просто параметры (W)

и гиперпараметры.

Гиперпараметры — параметры системы, которые мы не обучаем, а

«создаём руками», как конструкторы проектируют нейронную сеть

(сколько нейронов в слое, сколько всего слоёв, какую функцию

активации использовать и так далее).

Параметры связи между нейронами и сдвиг получаются автоматически в

процессе обучения.

В математическом смысле нейронная сеть — это

универсальный аппроксиматор.

8.

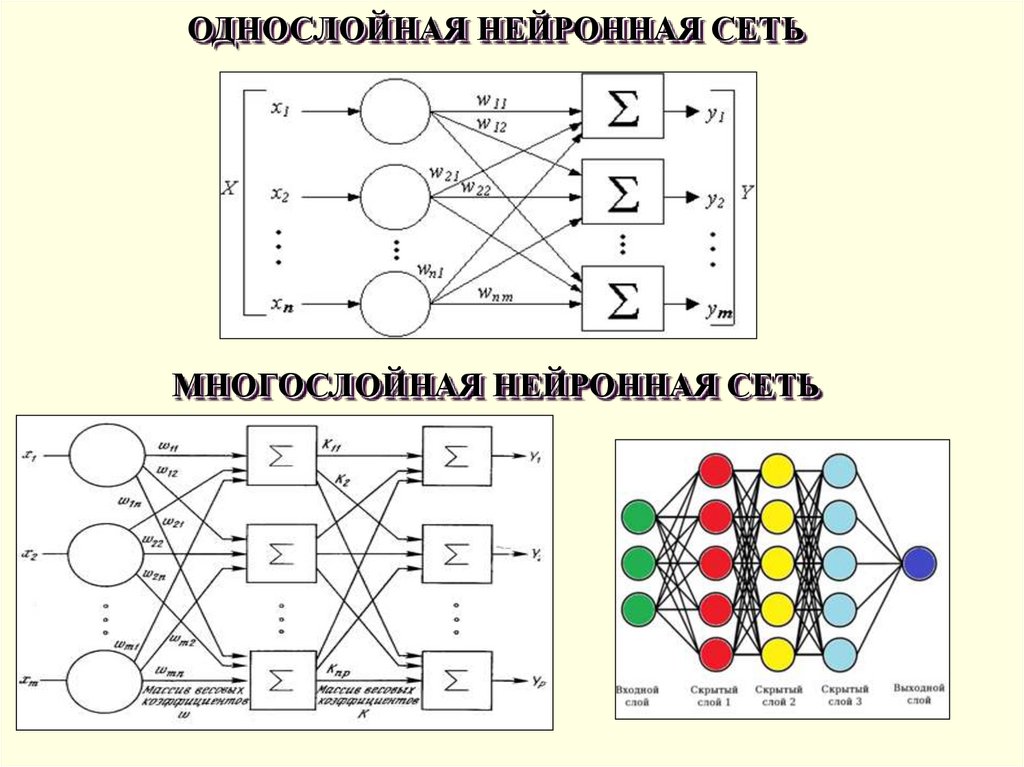

ОДНОСЛОЙНАЯ НЕЙРОННАЯ СЕТЬМНОГОСЛОЙНАЯ НЕЙРОННАЯ СЕТЬ

9.

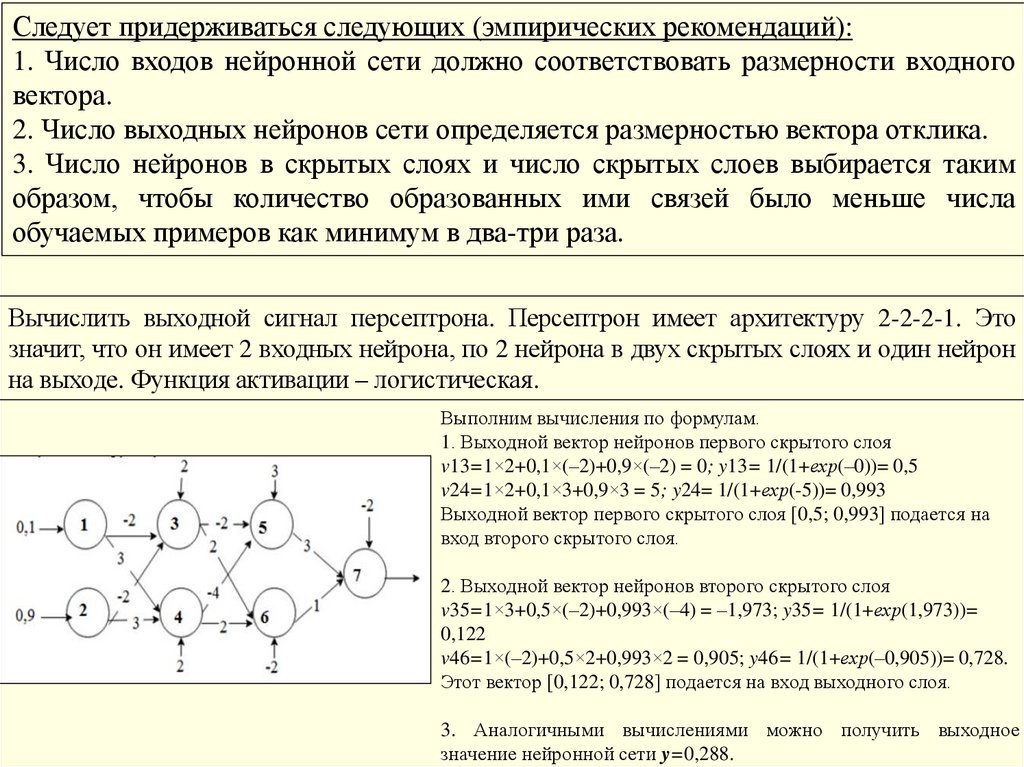

Следует придерживаться следующих (эмпирических рекомендаций):1. Число входов нейронной сети должно соответствовать размерности входного

вектора.

2. Число выходных нейронов сети определяется размерностью вектора отклика.

3. Число нейронов в скрытых слоях и число скрытых слоев выбирается таким

образом, чтобы количество образованных ими связей было меньше числа

обучаемых примеров как минимум в два-три раза.

Вычислить выходной сигнал персептрона. Персептрон имеет архитектуру 2-2-2-1. Это

значит, что он имеет 2 входных нейрона, по 2 нейрона в двух скрытых слоях и один нейрон

на выходе. Функция активации – логистическая.

Выполним вычисления по формулам.

1. Выходной вектор нейронов первого скрытого слоя

v13=1×2+0,1×(–2)+0,9×(–2) = 0; y13= 1/(1+ехр(–0))= 0,5

v24=1×2+0,1×3+0,9×3 = 5; y24= 1/(1+ехр(-5))= 0,993

Выходной вектор первого скрытого слоя [0,5; 0,993] подается на

вход второго скрытого слоя.

2. Выходной вектор нейронов второго скрытого слоя

v35=1×3+0,5×(–2)+0,993×(–4) = –1,973; y35= 1/(1+ехр(1,973))=

0,122

v46=1×(–2)+0,5×2+0,993×2 = 0,905; y46= 1/(1+ехр(–0,905))= 0,728.

Этот вектор [0,122; 0,728] подается на вход выходного слоя.

3. Аналогичными вычислениями можно получить выходное

значение нейронной сети y=0,288.

10.

ПОСТРОЕНИЕ ИСКУССТВЕННОЙ НЕЙРОННОЙ СЕТИПрименение

обученной

нейронной сети

к решению

задач

11.

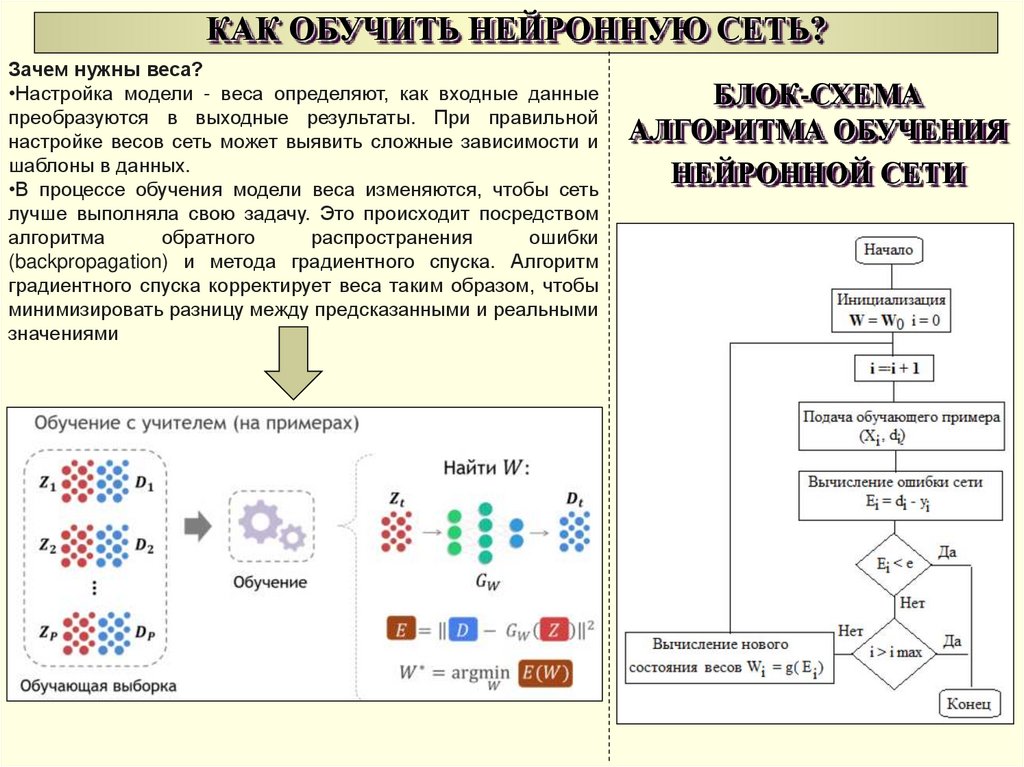

КАК ОБУЧИТЬ НЕЙРОННУЮ СЕТЬ?Зачем нужны веса?

•Настройка модели - веса определяют, как входные данные

преобразуются в выходные результаты. При правильной

настройке весов сеть может выявить сложные зависимости и

шаблоны в данных.

•В процессе обучения модели веса изменяются, чтобы сеть

лучше выполняла свою задачу. Это происходит посредством

алгоритма

обратного

распространения

ошибки

(backpropagation) и метода градиентного спуска. Алгоритм

градиентного спуска корректирует веса таким образом, чтобы

минимизировать разницу между предсказанными и реальными

значениями

БЛОК-СХЕМА

АЛГОРИТМА ОБУЧЕНИЯ

НЕЙРОННОЙ СЕТИ

12.

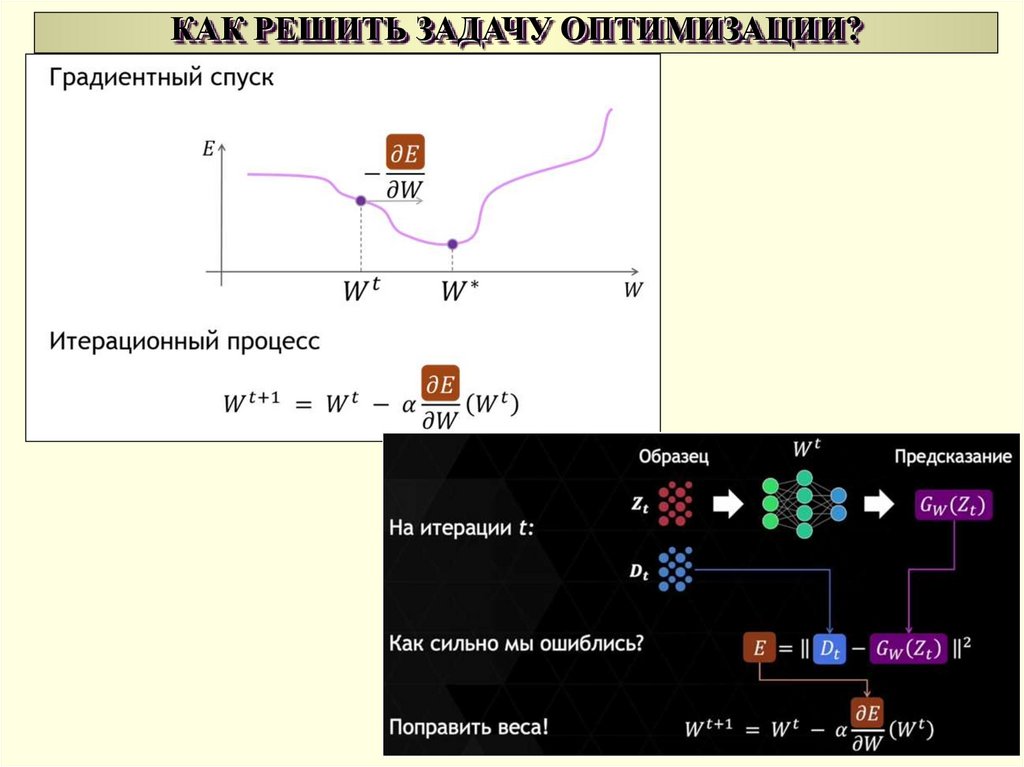

КАК РЕШИТЬ ЗАДАЧУ ОПТИМИЗАЦИИ?13.

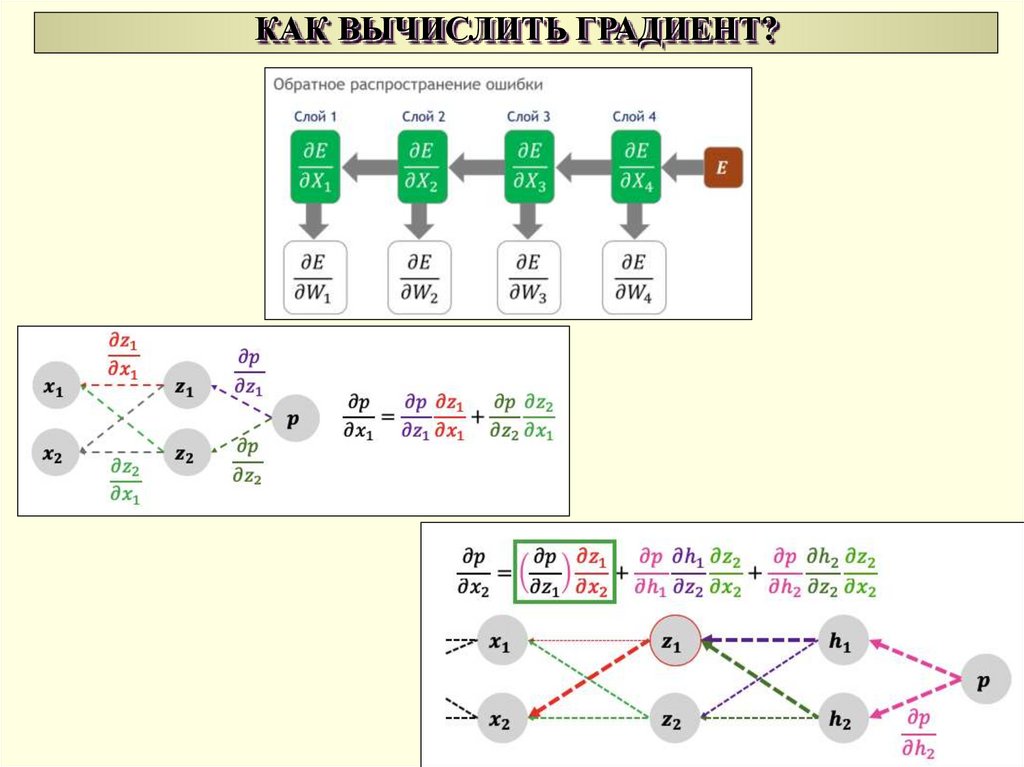

КАК ВЫЧИСЛИТЬ ГРАДИЕНТ?14.

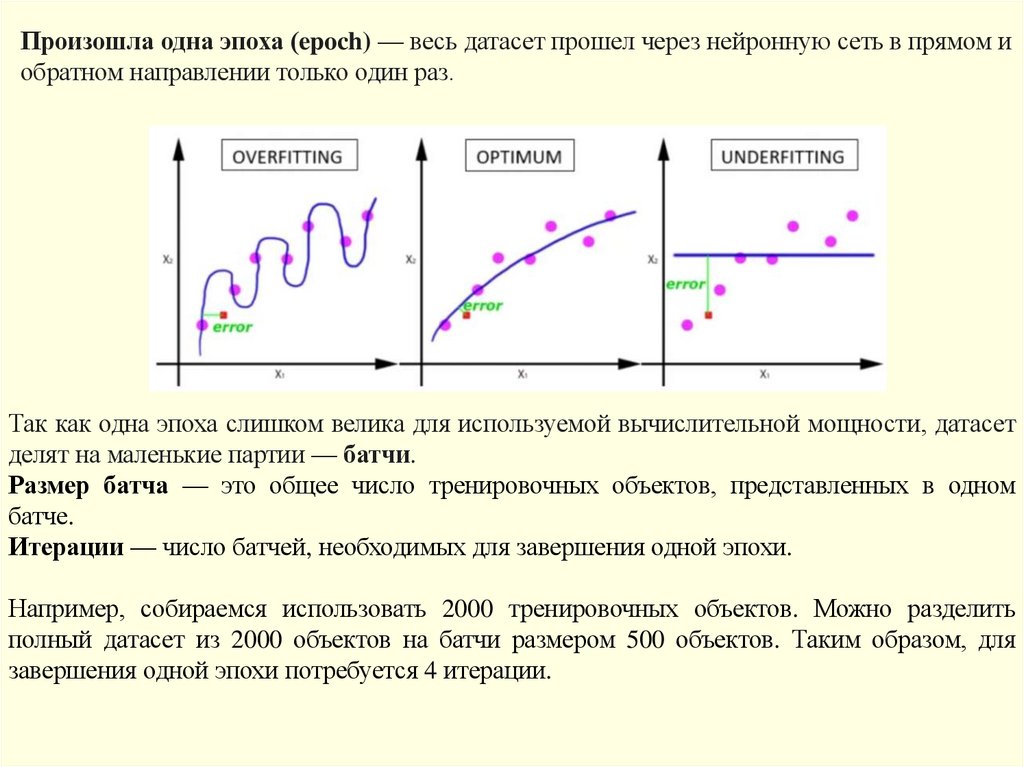

Произошла одна эпоха (epoch) — весь датасет прошел через нейронную сеть в прямом иобратном направлении только один раз.

Так как одна эпоха слишком велика для используемой вычислительной мощности, датасет

делят на маленькие партии — батчи.

Размер батча — это общее число тренировочных объектов, представленных в одном

батче.

Итерации — число батчей, необходимых для завершения одной эпохи.

Например, собираемся использовать 2000 тренировочных объектов. Можно разделить

полный датасет из 2000 объектов на батчи размером 500 объектов. Таким образом, для

завершения одной эпохи потребуется 4 итерации.

informatics

informatics