Similar presentations:

Теория вероятностей. Случайные события и вероятность

1. ТЕОРИЯ ВЕРОЯТНОСТЕЙ

2. Случайные события и вероятность

3.

Теоретико-вероятностные модели реальныхпроцессов и явлений, их применение при

решении прикладных задач

События в материальном мире можно разбить на три

категории – достоверные, невозможные и случайные.

Например, если подбросить игральную кость, то достоверно,

что число выпавших очков будет натуральным числом, не

возможно, чтобы это число равнялось 10, и возможно, что оно

будет равно 2. Однако, возможно также, что это число будет

равно 1,3,4,5,6.

Потребности практики привели математиков к

изучению случайных событий. Например, при организации

телефонной связи в некотором районе нужно знать число

вызовов в каждый момент времени, а оно случайным образом

изменяется с течением времени.

4.

При стрельбе из артиллерийского орудия надо знатьчисло снарядов, попавших в цель, а попадание в цель

является случайным событием. Методы теории вероятности

широко применяются в различных отраслях естествознания

и техники: в теории надежности, теории массового

обслуживания, в теоретической физике, геодезии, астрономии,

теории стрельбы, теории ошибок наблюдений, теории

автоматического управления, общей теории связи и во многих

других теоретических и прикладных науках. Теория

вероятностей служит также для обоснования математической

и прикладной статистики, которая в свою очередь

используется при планировании и организации производства,

при анализе технологических процессов, предупредительном

и приемочном контроле качества продукции.

5.

На первый взгляд может показаться, что в задачах ослучайных событиях ничего нельзя сказать об их исходе. И,

действительно, если бросить кость лишь один раз, то с

одинаковой вероятностью можно ожидать выпадения 1,2,3,4,5

или 6. Но при многократном повторении этого опыта

оказывается, что одни исходы будут появляться чаще, а

другие реже. Например, если подбросить кость 1200 раз, то

очень маловероятно, чтобы все время выпадало одно очко.

Гораздо вероятнее, что значения 1,2,3,4,5 и 6 будут появляться

примерно с одной и той же частотой.

Раздел математики, изучающий закономерности

случайных событий, называется теорией вероятностей. Эта

теория имеет дело не с отдельными событиями, а с

результатом проведения достаточно большого числа

испытаний, то есть с закономерностями массовых случайных

явлений.

6.

Основные понятия теории вероятностей.Аксиомы Колмогорова и их следствия.

I.Случайные события и случайные

величины.

1.Случайные события и их вероятности.

1.1.Случайный эксперимент. Случайные

события. Отношения между событиями.

7.

Определение.Случайный эксперимент S (опыт) – эксперимент,

результат которого не может быть точно

предсказан.

Определение.

Случайное событие (А, В, С и т.п.) – результат

случайного эксперимента. Это событие, которое

при заданном комплексе условий может как

произойти, так и не произойти.

Например, если брошена монета, то она может

упасть так, что сверху будет либо герб, либо

решка. Поэтому событие « при бросании монеты

выпал герб» - это случайное событие.

8.

Рассмотрим множество Ω всех возможныхвзаимно исключающих друг друга исходов

некоторого испытания ( эксперимента). Это

множество будем называть пространством

элементарных исходов. Число исходов, входящих в

Ω, может быть конечным или бесконечным.

Случайное событие А- некоторое подмножество

множества Ω.

Пример. Стрелок стреляет по мишени, разделенной

на 4 равные области. Выстрел – это случайный

эксперимент. Попадание в определенную область

мишени – это случайное событие.

Ω = {A,B,C,D,F}, где F – стрелок не

А В

С

попал в мишень

D

9.

Определение.Достоверное событие U – событие, которое в

данных условиях обязательно произойдет.

Невозможное событие V – событие, которое в

данных условиях никогда не произойдет.

Пример. В сосуде находится вода при нормальном

атмосферном давлении и температуре 200. В этом

случае событие « вода находится в жидком

состоянии» - достоверное событие, а событие «

вода находится в твердом состоянии» невозможное событие

10.

Определение. События А и В называютсянесовместными, если их совместное появление в

данном опыте невозможно, т.е. АВ=V, или,

другими словами, наступление одного из событий

исключает возможность наступления другого.

Примеры. 1. При бросании монеты появление

герба исключает появление решки, следовательно,

события « появился герб» и « появилась решка» несовместные события.

2. Бросаем кубик. События « число очков,

выпавших на кубике четное » и « число очков,

выпавших на кубике равно 4 » - совместные

события.

11.

Определение. Произведением (совмещением) двухсобытий А и В называется общая часть множеств

исходов, составляющих события А и В. Или

другими словами, совмещением двух событий А и

В называется новое событие АВ (или А В), в

результате которого происходит как событие А ,

так и событие В.

Определение. Суммой двух событий А и В

называется событие А+В (или А В) , состоящее в

наступлении хотя бы одного из этих событий: или

А, или В, или А и В вместе.

12.

Пример. Из ящика с деталями ( стандартные,нестандартные, окрашенные, неокрашенные)

наудачу извлекают деталь. Событие А – деталь

стандартная, событие В – деталь окрашенная.

Тогда событие А+В – деталь либо стандартная,

либо окрашенная, а событие АВ - деталь

стандартная и окрашенная.

Определение. Произведением нескольких

событий называется новое событие, состоящее в

совместном наступлении всех этих событий.

Определение. Суммой нескольких событий А1,

А2, …,Аn называется событие, соответствующее

объединению множеств А1, А2, …,Аn ( произойдет

хотя бы одно из указанных событий).

13.

Пример. Бросаем монету три раза. СобытияА - появление герба при первом бросании,

В - появление герба при втором бросании,

С - появление герба при третьем бросании.

Тогда АВС - появление герба при всех трех

бросаниях.

Определение. События А1, А2,..., Аn образуют

полную группу событий, если в результате

испытания обязательно должно произойти одно и

только одно из них. Это значит, что данные

события попарно несовместны и в сумме

образуют достоверное событие, т.е.,

АiАj = V (i j),

А1+ А2+... Аn = U.

14.

Пример. Стрелок произвел выстрел по мишени.Событие А- стрелок попал в цель, событие В –

промахнулся. Эти два события несовместны и в

результате

испытания

обязательно

какое-то

из

этих

A A U , A A V

событий произойдет. Ω={А,В}. События А и В

образуют полную группу.

Определение. События А и Ā называются

противоположными, если они образуют полную

группу событий, т.е. А+Ā=U, АĀ= V.

(Другими словами, событие Ā состоит в

n

n

ненаступлении

события

А).

A

A

;

i

i

i 1

i 1

В предыдущем

примере:

А- попадание, Ā=В –

промах.

15.

Для любых n событий имеют место формулыдвойственности: n

n

A A

i 1

i

i

i 1

A A U , A A V

Определение.

События называются равновозможными, если есть

основание считать, что одно из них не является

более возможным, чем другое.

Например, появление герба и появление решки при

бросании монеты – равновозможные события, так

как предполагается, что монета изготовлена из

однородного материала, имеет правильную

огранку и наличие чеканки не влияет на выпадение

той или иной стороны монеты.

16.

1.2.Вероятность события.Пример. Случайный эксперимент S – однократное

подбрасывание игральной кости. Пусть Х число

выпавших очков. А={Х=1}, В={Х-четно},

U={Х 6}, V={X>6}. События А и В –

несовместные события, А+В={1,2,4,6}, АВ=V.

Очевидно, что возможность того, что при бросании

игральной кости произойдет событие В больше,

чем возможность того, что произойдет событие А.

Встает вопрос: можно ли охарактеризовать эту

возможность каким- либо числом. Оказывается

можно. Это число и называют вероятностью

события.

17.

Таким образом, вероятность – есть число,характеризующее степень возможности появления

события.

Обозначение: P(A) – вероятность события A.

Найдем вероятности событий А и В. Каждый из

возможных результатов испытания ( испытание

состоит из в бросании игральной кости)

называется элементарным исходом. Элементарные

исходы обозначим w1, w2,…, wn. У нас 6

элементарных исходов: w1={X=1}, w2={X=2},

w3={X=3} , w4={X=4}, w5={X=5}, w6={X=6}.

18.

Легко видеть, что эти исходы образуютполную группу событий (они попарно

несовместны, в результате испытания одно из

событий обязательно произойдет), и

равновозможные. Те элементарные исходы, в

которых интересующее нас событие наступает,

назовем благоприятствующими. В нашем случае,

благоприятствующие исходы событию А w1={X=1} (один исход) и благоприятствующие

исходы событию В - w2={X=2}, w4={X=4},

w6={X=6}( 3 исхода).

Тогда P(A)=1/6, P(B)=3/6=1/2.

19.

Классическая модель.Пусть проводится эксперимент, который может

окончиться одним из n равновозможных

элементарных исходов. В этом эксперименте

может наступить интересующее нас событие А. Те

m элементарных исходов эксперимента, в которых

событие А наступает, называют

благоприятствующими этому событию.

20.

Определение. Вероятностью события Аназывают отношение числа благоприятствующих

этому событию элементарных исходов

эксперимента N A к их общему числу N, т.е.

NA

P(A)= N A/ N.

В этом определении предполагается, что

элементарные исходы несовместные,

равновозможные и образуют полную группу (т.е.

эксперимент заканчивается одним и только одним

исходом).

21.

Свойства.1)Вероятность достоверного события равна 1.

Действительно, если событие достоверно, то

каждый элементарный исход испытания

NA

благоприятствует событию U.

P(U)=NA/N=N/N=1.

2)Вероятность невозможного события равна 0.

Действительно, если событие невозможное, то

ни один из элементарных исходов испытания не

благоприятствует событию V.

P(V)=0/N=0.

3)Вероятность случайного события есть

положительное число, меньшее 1.

0<P(A)<1

22.

Действительно, случайному событиюблагоприятствует лишь часть из общего числа

элементарных исходов испытания. В этом случае

0<NA<N. Следовательно, 0<P(A)=NA/N<1.

NA

Итак, вероятность любого события удовлетворяет

неравенству:

0 P( A) 1

Построенная таким образом модель называется

классической моделью. Недостаток классической

модели – неприменима к испытаниям с

бесконечным числом исходов и в том случае, когда

исходы не равновозможные.

23.

Статистическая вероятность.Статистический подход к определению

вероятности применяется тогда, когда эксперимент

можно неоднократно повторить в неизменных

условиях.

Пусть проводится эксперимент S, в ходе

которого может произойти или не произойти

событие А.

Пусть n – число повторений эксперимента, nAчисло появлений события А в серии из n опытов.

Тогда nA/n – относительная частота появления

события А в серии из n опытов.

24.

Рассмотрим новую достаточно длиннуюсерию из n опытов примерно в тех же условиях и

снова найдем отношение nA/n и так несколько

серий. Если частота мало отличается от серии к

серии, колеблясь около некоторого числа p, то это

число принимают за вероятность события А.

Пример. Замечено, что при изготовлении деталей

на отлаженном станке в каждой партии из 1000

деталей от 2 до 4 бракованных. Тогда можно

утверждать что вероятность брака p=3/1000. Если

же в одних партиях 2-3 бракованных детали, а в

других 30-40, то о вероятности брака ничего

сказать нельзя( либо меняются условия работы,

либо станок не отлажен)

25.

Определение. Относительной частотой событияназывают отношение числа испытаний, в которых

это событие появилось, к общему числу фактически

проведенных испытаний.

Длительные наблюдения показали, что если в

одинаковых условиях производят опыты, в каждом

из которых число испытаний достаточно велико, то

относительная частота обнаруживает свойство

устойчивости.

26.

Это свойство состоит в том, что в различныхопытах относительная частота меняется мало (тем

меньше, чем больше произведено испытаний),

колеблясь около некоторого постоянного числа.

Это постоянное число есть вероятность события.

Итак, в качестве статистической

вероятности события принимают

относительную частоту или число, близкое к ней.

27.

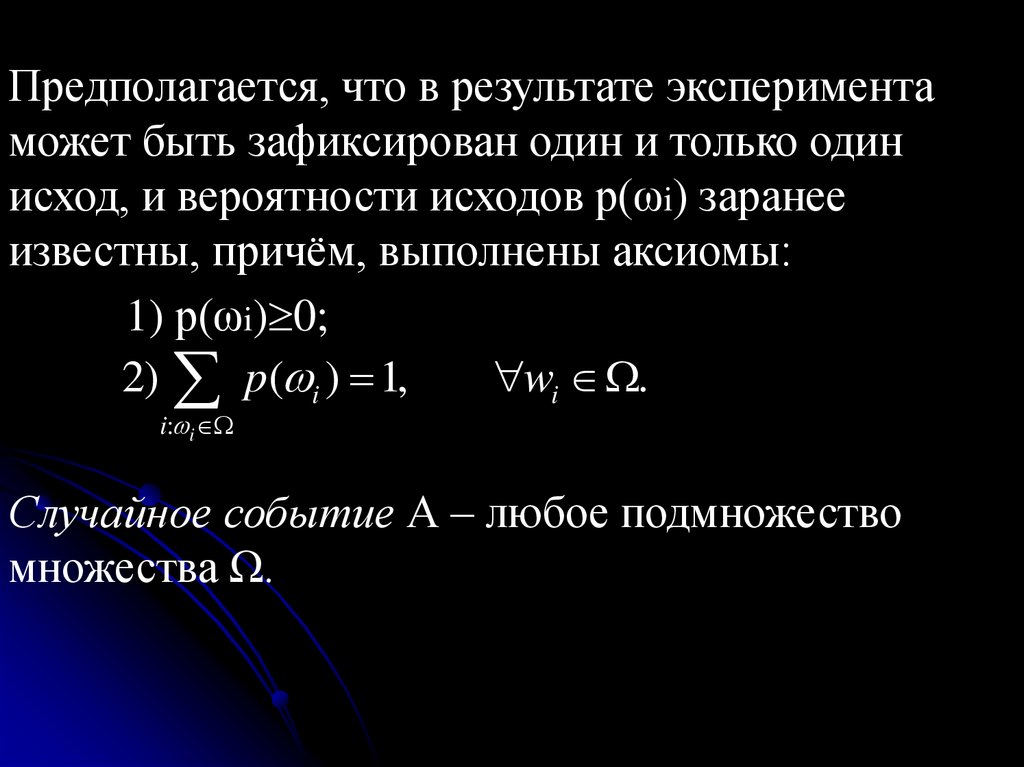

Общая дискретная модель.Пусть эксперимент S имеет конечное или

счётное число исходов ω1, ω2, … , ωn, …

Эти исходы называются элементарными

событиями. Совокупность всех элементарных

событий, связанных с данным экспериментом,

называют дискретным пространством

элементарных событий или пространством

исходов и обозначают Ω.

Ω = { ω1, ω2, … , ωn, …}

28.

Предполагается, что в результате экспериментаможет быть зафиксирован один и только один

исход, и вероятности исходов р(ωi) заранее

известны, причём, выполнены аксиомы:

1) р(ωi) 0;

2) p( i ) 1,

wi .

i: i

Случайное событие А – любое подмножество

множества Ω.

29.

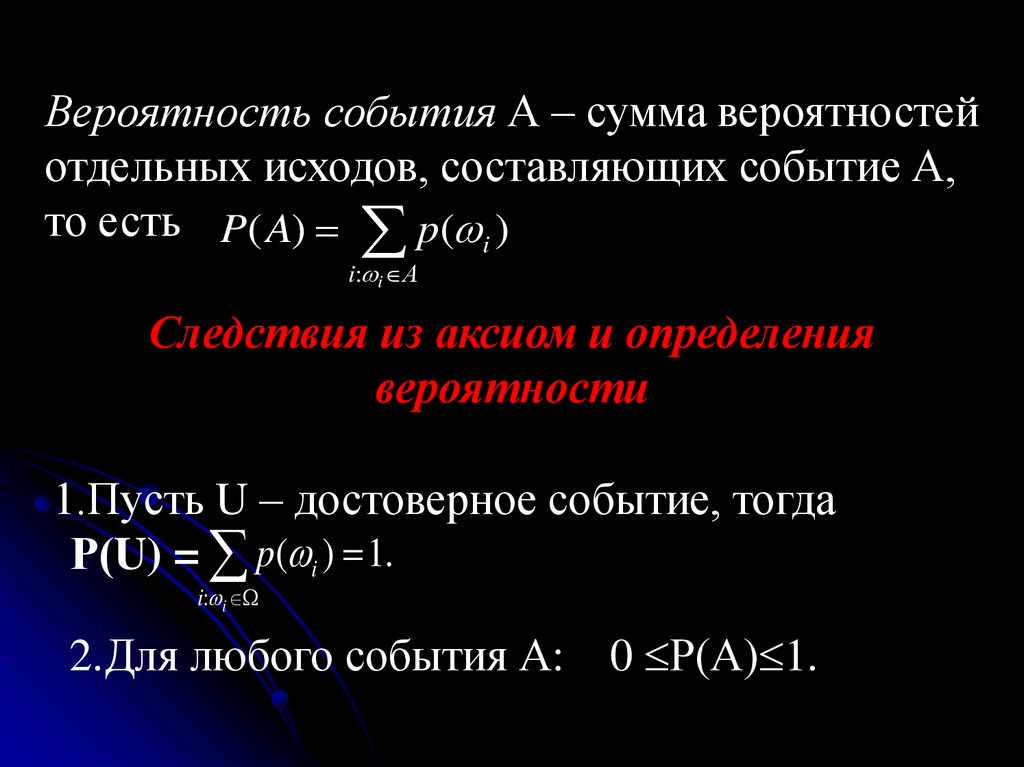

Вероятность события А – сумма вероятностейотдельных исходов, составляющих событие А,

то есть P( A) p( i )

i: i А

Следствия из аксиом и определения

вероятности

1.Пусть U – достоверное событие, тогда

Р(U) = p( i ) 1.

i: i

2.Для любого события А: 0 Р(А) 1.

30.

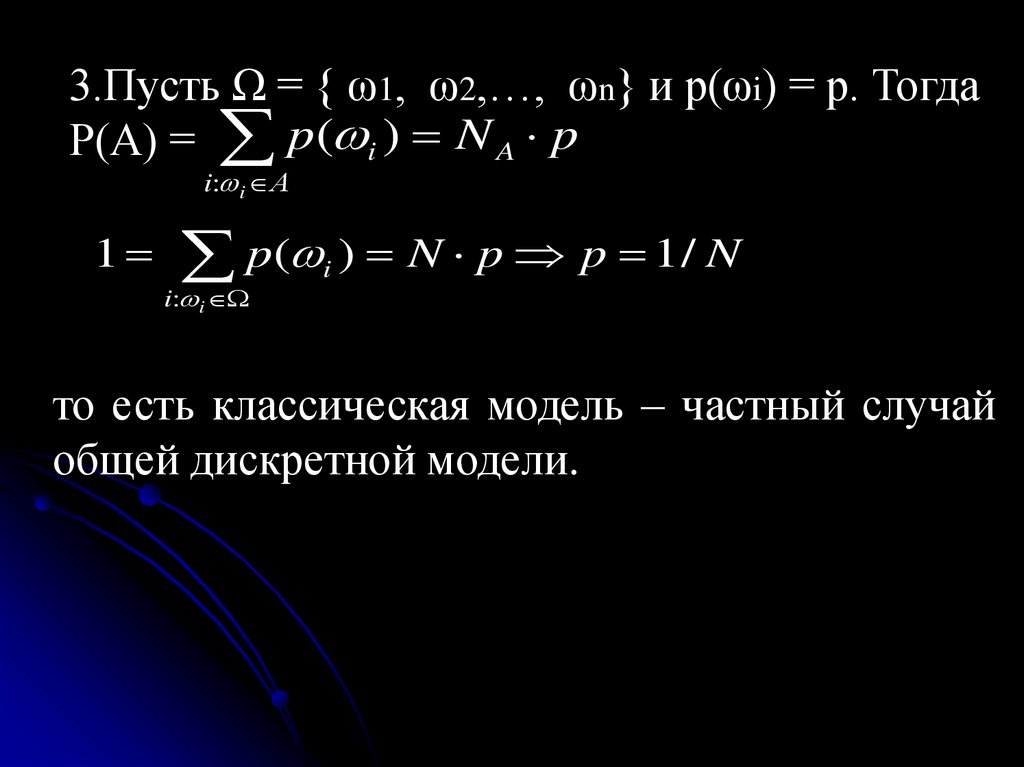

3.Пусть Ω = { ω1, ω2,…, ωn} и р(ωi) = р. ТогдаР(А) = p( i ) N A p

i: i А

1 p( i ) N p p 1 / N

i: i

то есть классическая модель – частный случай

общей дискретной модели.

31.

Геометрическая модель.Многие практические задачи приводят к

вопросам теории вероятности, которые не

укладываются в разобранную выше схему

конечного числа попарно несовместных исходов

испытаний. Пусть, например, стержень наудачу

разламывается на три части. Какова вероятность

того, что из получившихся отрезков можно будет

построить треугольник?

В этой задаче мы имеем бесконечное

множество исходов, так как разлом может попасть

на любую точку стержня. Здесь мы будем

пользоваться иным определением вероятности,

которое назовем геометрическим.

32.

Рассмотрим следующую модель. Пусть наотрезок АВ бросают наудачу точку. Назовем

вероятностью попадания этой точки на часть этого

отрезка отношение длины этой части к длине всего

отрезка ( если часть состоит из нескольких кусков,

то надо сложить длины этих кусков). Вместо

отрезка АВ можно взять некоторую

геометрическую фигуру, имеющую конечную

площадь и считать вероятностью попасть в часть X

этой фигуры отношение площадей указанной

части и всей фигуры.

33.

Итак, геометрическая вероятность – этовероятность попадания точки в некоторую область.

(отрезок, часть плоскости, шар, и т.д.)

Пусть Ω – область на плоскости, D Ω. μ(Ω), μ(D) –

площади этих областей.

В Ω наудачу бросается случайная точка ω.

Вероятность попадания в любую подобласть

области Ω зависит только от её площади. Тогда

P{ω D} = μ(D) / μ(Ω).

34.

Замечания.1.Такой подход распространяется и на n-мерный

случай

2.Геометрическая модель имеет ограниченную

область применения ввиду требования

равновозможности отдельных точек.

Пример 1. Вернемся к задаче о разламывании

стержня. Пусть на отрезок длины 1 бросают

наудачу две точки. Они разбивают отрезок на три

отрезка. Какова вероятность, что из полученных

трех отрезков можно сложить треугольник?

Заданный отрезок рассматриваем как отрезок [0,1]

числовой прямой. Тогда наудачу брошенные точки

имеют координаты – числа x и y, принадлежащие

35.

отрезку [0,1]. Но любую пару чисел можнорассматривать как координаты точки на

плоскости. Поскольку 0≤x≤1, 0≤y≤1, то эти точки

(x,y) наудачу брошены в квадрат со стороной 1.

Посмотрим теперь какую фигуру образуют точки,

координаты которых удовлетворяют условию

примера.

Для того, чтобы из этих трех отрезков можно

было построить треугольник, необходимо и

достаточно, чтобы длины этих отрезков

удовлетворяли неравенству треугольника.

36.

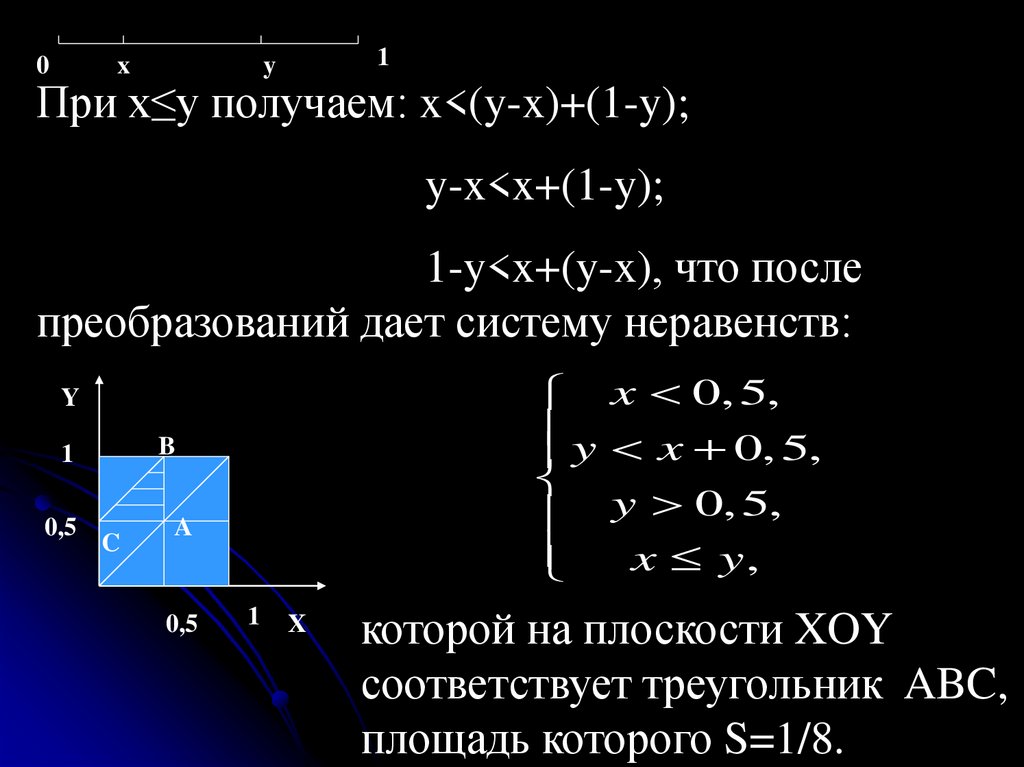

0x

1

y

При x≤y получаем: x<(y-x)+(1-y);

y-x<x+(1-y);

1-y<x+(y-x), что после

преобразований дает систему неравенств:

x 0, 5,

y x 0, 5,

y 0, 5,

x y,

Y

B

1

0,5

C

A

0,5

1

X

которой на плоскости XOY

соответствует треугольник ABC,

площадь которого S=1/8.

37.

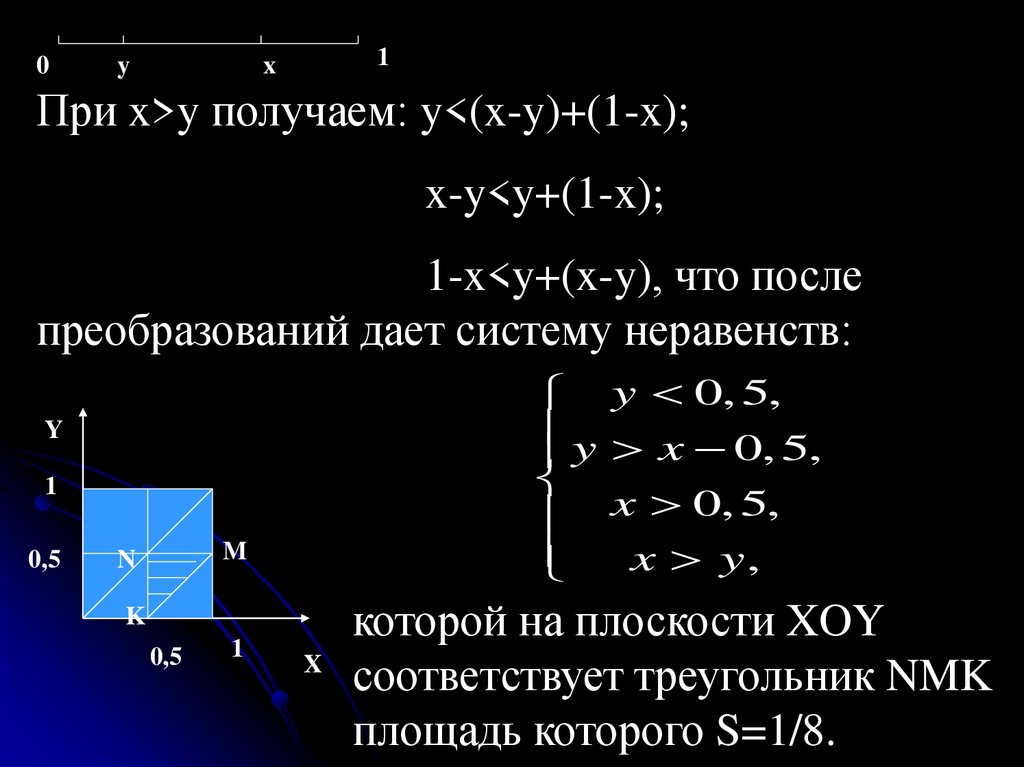

0y

x

1

При x>y получаем: y<(x-y)+(1-x);

x-y<y+(1-x);

1-x<y+(x-y), что после

преобразований дает систему неравенств:

Y

1

0,5

M

N

K

0,5

1

y 0, 5,

y x 0, 5,

x 0, 5,

x y,

которой на плоскости XOY

X

соответствует треугольник NMK

площадь которого S=1/8.

38.

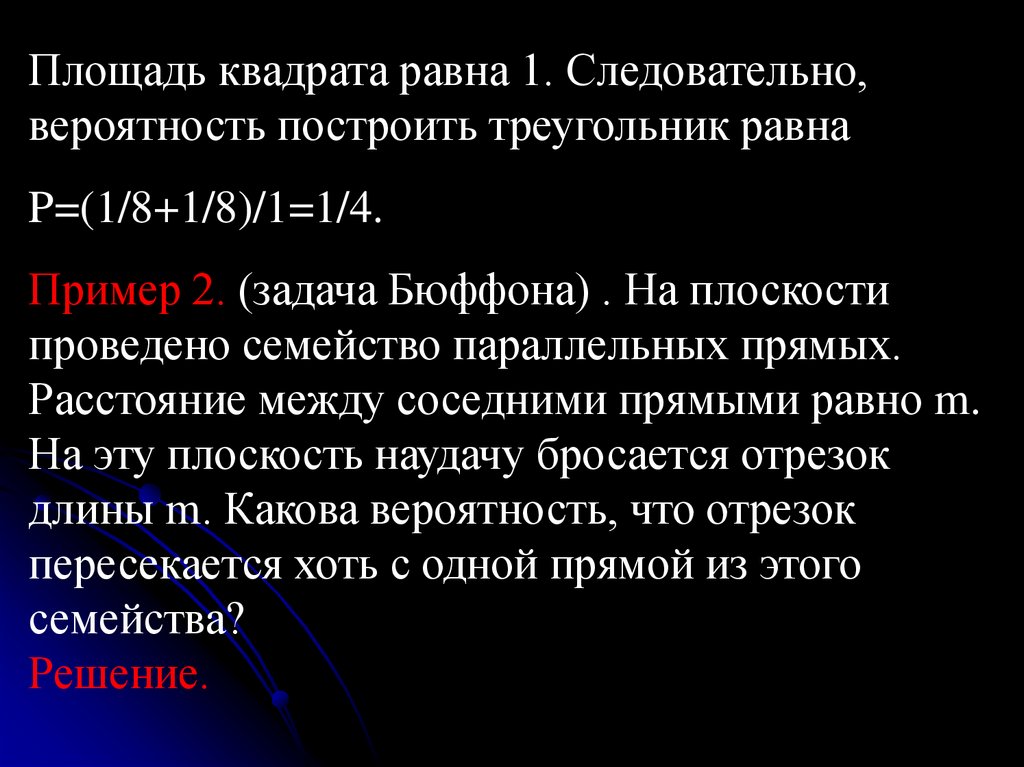

Площадь квадрата равна 1. Следовательно,вероятность построить треугольник равна

P=(1/8+1/8)/1=1/4.

Пример 2. (задача Бюффона) . На плоскости

проведено семейство параллельных прямых.

Расстояние между соседними прямыми равно m.

На эту плоскость наудачу бросается отрезок

длины m. Какова вероятность, что отрезок

пересекается хоть с одной прямой из этого

семейства?

Решение.

39.

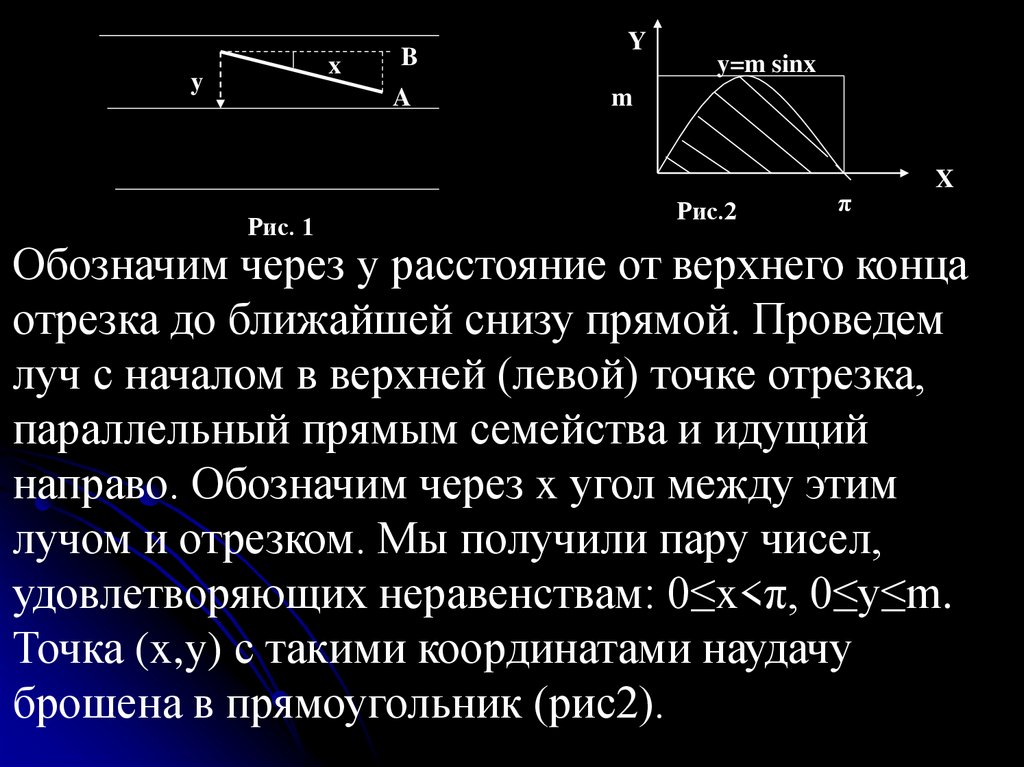

xy

B

A

Рис. 1

Y

y=m sinx

m

Рис.2

π

X

Обозначим через y расстояние от верхнего конца

отрезка до ближайшей снизу прямой. Проведем

луч с началом в верхней (левой) точке отрезка,

параллельный прямым семейства и идущий

направо. Обозначим через x угол между этим

лучом и отрезком. Мы получили пару чисел,

удовлетворяющих неравенствам: 0≤x<π, 0≤y≤m.

Точка (x,y) с такими координатами наудачу

брошена в прямоугольник (рис2).

40.

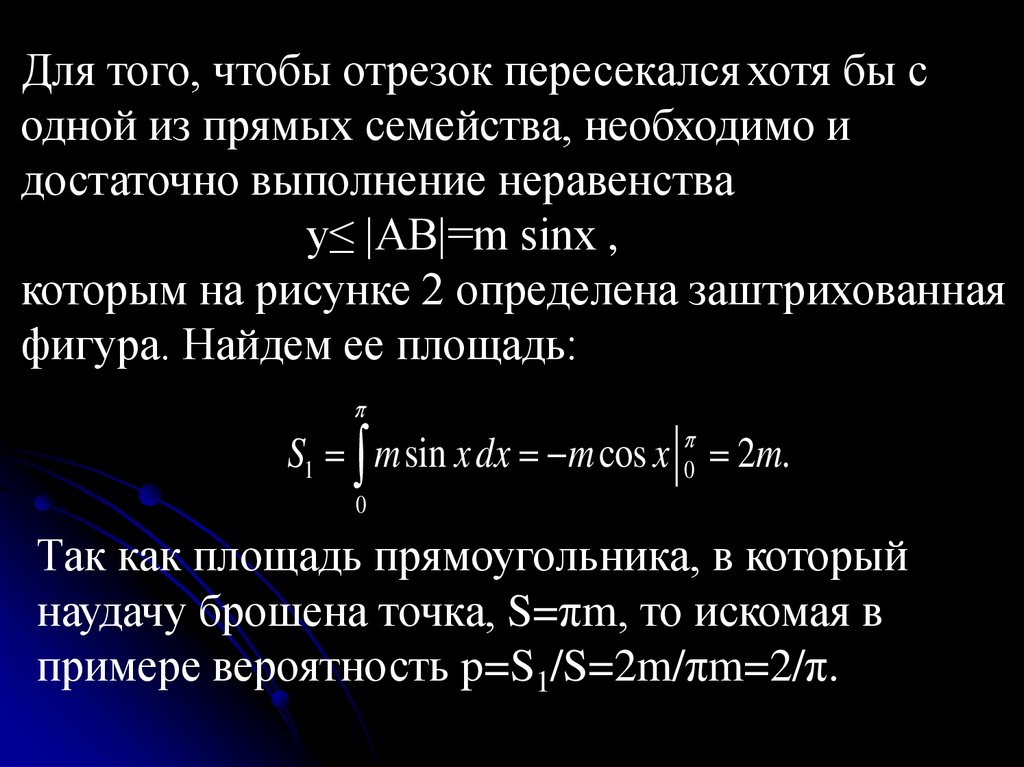

Для того, чтобы отрезок пересекался хотя бы содной из прямых семейства, необходимо и

достаточно выполнение неравенства

y≤ |AB|=m sinx ,

которым на рисунке 2 определена заштрихованная

фигура. Найдем ее площадь:

S1 m sin x dx m cos x 2m.

0

0

Так как площадь прямоугольника, в который

наудачу брошена точка, S=πm, то искомая в

примере вероятность p=S1/S=2m/πm=2/π.

41.

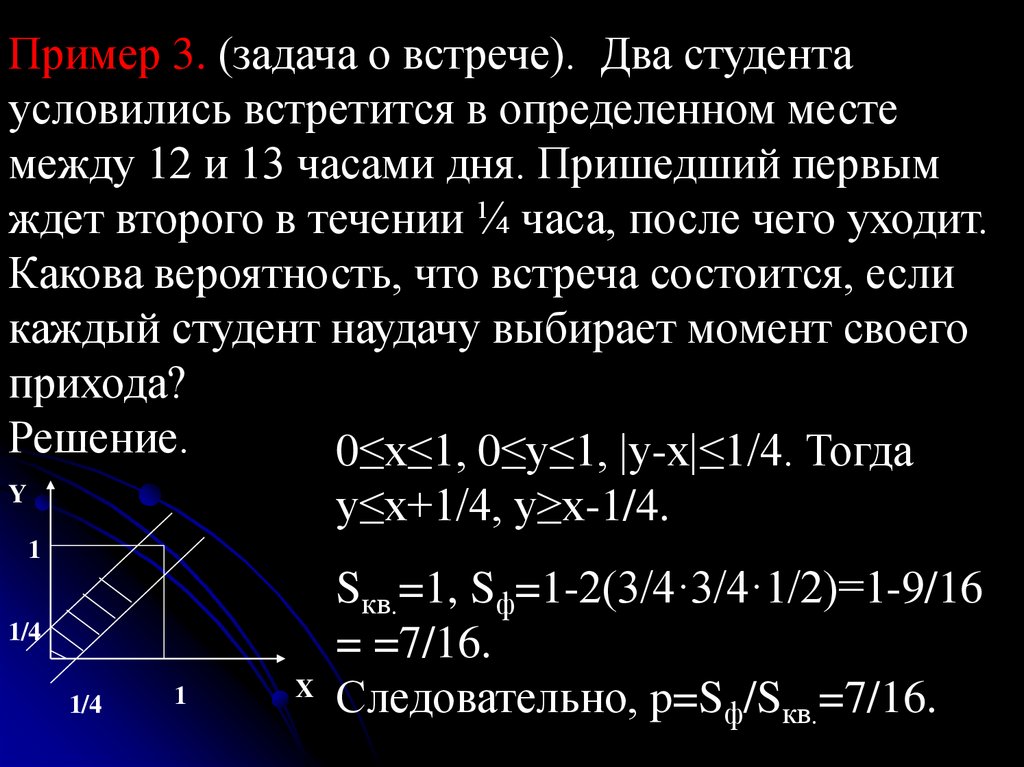

Пример 3. (задача о встрече). Два студентаусловились встретится в определенном месте

между 12 и 13 часами дня. Пришедший первым

ждет второго в течении ¼ часа, после чего уходит.

Какова вероятность, что встреча состоится, если

каждый студент наудачу выбирает момент своего

прихода?

Решение.

0≤x≤1, 0≤y≤1, |y-x|≤1/4. Тогда

Y

y≤x+1/4, y≥x-1/4.

1

1/4

1/4

1

Sкв.=1, Sф=1-2(3/4·3/4·1/2)=1-9/16

= =7/16.

X

Следовательно, p=Sф/Sкв.=7/16.

42.

1.3. Элементы комбинаторики. Задачи нанепосредственный подсчет вероятностей

Комбинаторика изучает количество комбинаций

(подчиненное определенным условиям), которое

можно составить из элементов некоторого

заданного конечного множества.

Определение. Размещением называются

комбинации, составленные из n различных по m

элементов, которые отличаются либо составом

элементов, либо их порядком.

Пусть {a1,a2,…,an} – множество из n элементов.

Тогда любое упорядоченное его подмножество из

m элементов называется размещением из n

элементов по m.

43.

Например, рассмотрим множество A={1,2,3,,,,4,5}.Пусть m=3. Тогда можно рассмотреть следующие

размещения из 5 элементов по 3: (1,3,5), (5,3,1),

(4,2,1) и т.д.

Найдем число размещений без повторений из n

элементов некоторого множества по m. Первым

элементом x1 может стать любой элемент из n

элементов заданного множества, то есть получаем n

возможностей выбора. Если элемент x1 уже выбран,

то второй элемент x2 можно выбрать уже n-1

способом, так как повторение первого элемента не

допускается. Аналогично, при выбранных x1и x2,

третий элемент x 3 можно выбрать n-2 способами и

т.д. вплоть до элемента x , который можно выбрать

44.

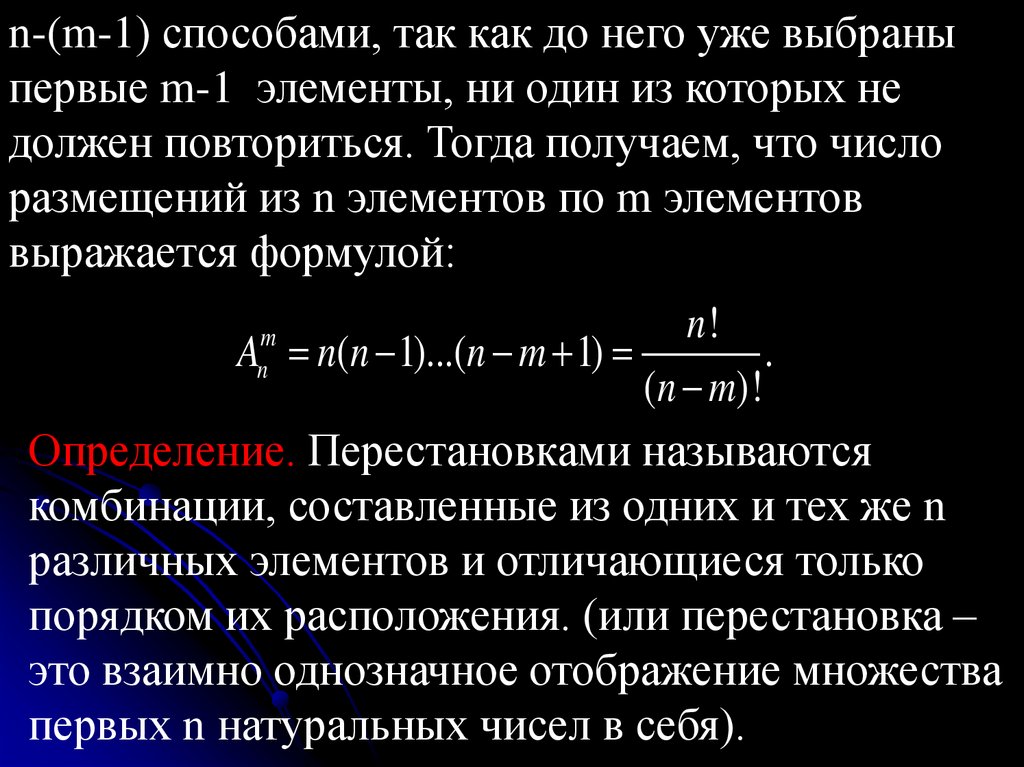

n-(m-1) способами, так как до него уже выбраныпервые m-1 элементы, ни один из которых не

должен повториться. Тогда получаем, что число

размещений из n элементов по m элементов

выражается формулой:

n!

A n(n 1)...(n m 1)

.

(n m)!

Определение. Перестановками называются

комбинации, составленные из одних и тех же n

различных элементов и отличающиеся только

порядком их расположения. (или перестановка –

это взаимно однозначное отображение множества

первых n натуральных чисел в себя).

m

n

45.

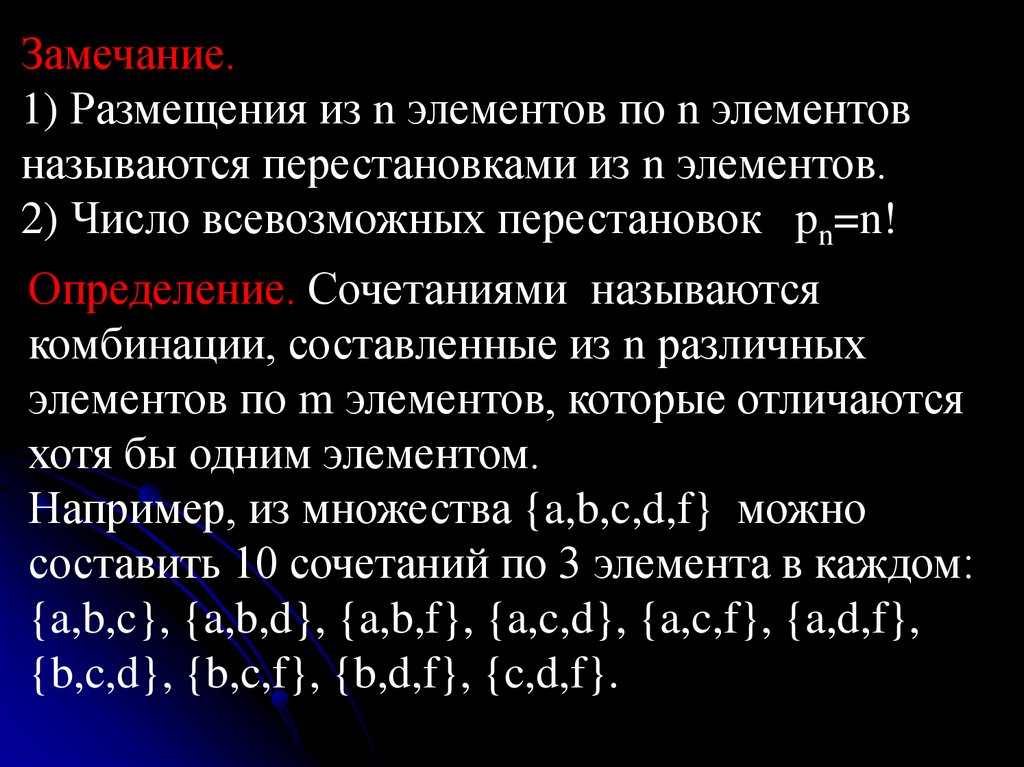

Замечание.1) Размещения из n элементов по n элементов

называются перестановками из n элементов.

2) Число всевозможных перестановок pn=n!

Определение. Сочетаниями называются

комбинации, составленные из n различных

элементов по m элементов, которые отличаются

хотя бы одним элементом.

Например, из множества {a,b,c,d,f} можно

составить 10 сочетаний по 3 элемента в каждом:

{a,b,c}, {a,b,d}, {a,b,f}, {a,c,d}, {a,c,f}, {a,d,f},

{b,c,d}, {b,c,f}, {b,d,f}, {c,d,f}.

46.

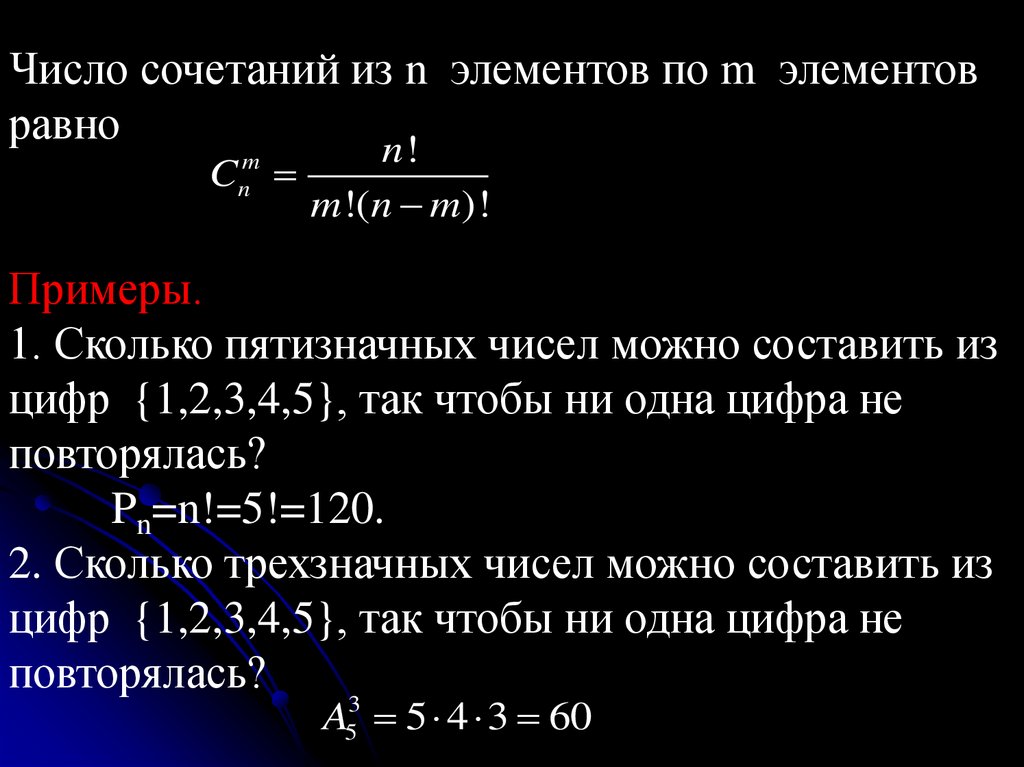

Число сочетаний из n элементов по m элементовравно

n!

C

m !(n m)!

m

n

Примеры.

1. Сколько пятизначных чисел можно составить из

цифр {1,2,3,4,5}, так чтобы ни одна цифра не

повторялась?

Pn=n!=5!=120.

2. Сколько трехзначных чисел можно составить из

цифр {1,2,3,4,5}, так чтобы ни одна цифра не

повторялась?

A 5 4 3 60

3

5

47.

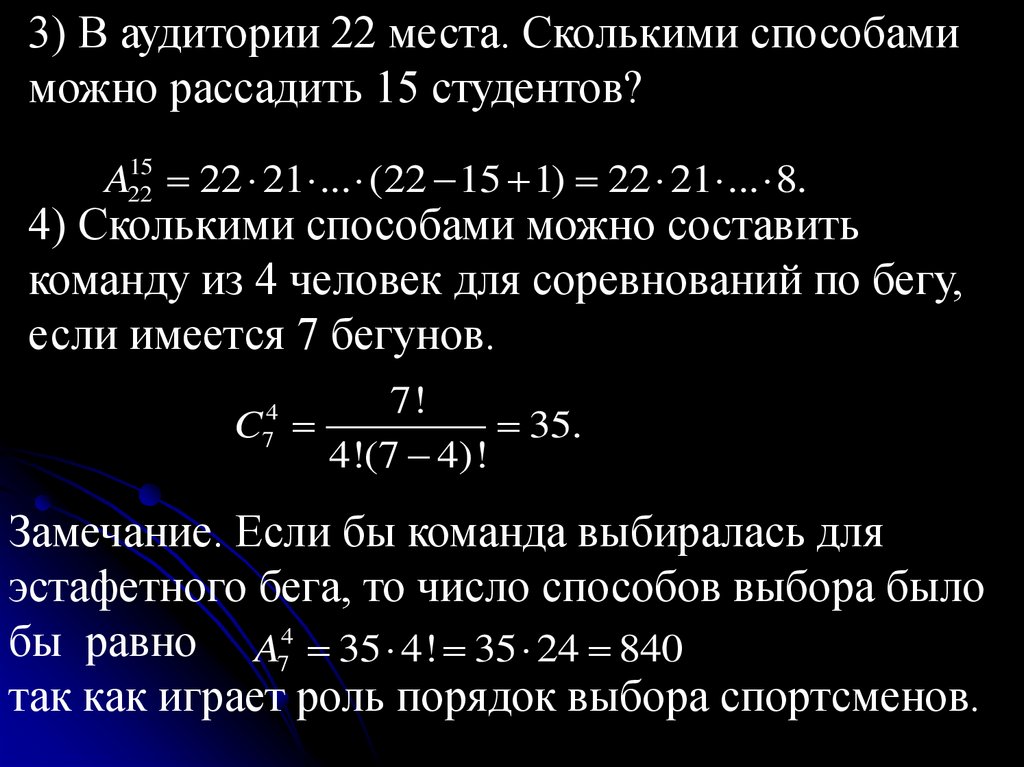

3) В аудитории 22 места. Сколькими способамиможно рассадить 15 студентов?

15

A22

22 21 ... (22 15 1) 22 21 ... 8.

4) Сколькими способами можно составить

команду из 4 человек для соревнований по бегу,

если имеется 7 бегунов.

7!

C

35.

4!(7 4)!

4

7

Замечание. Если бы команда выбиралась для

эстафетного бега, то число способов выбора было

бы равно A74 35 4! 35 24 840

так как играет роль порядок выбора спортсменов.

48.

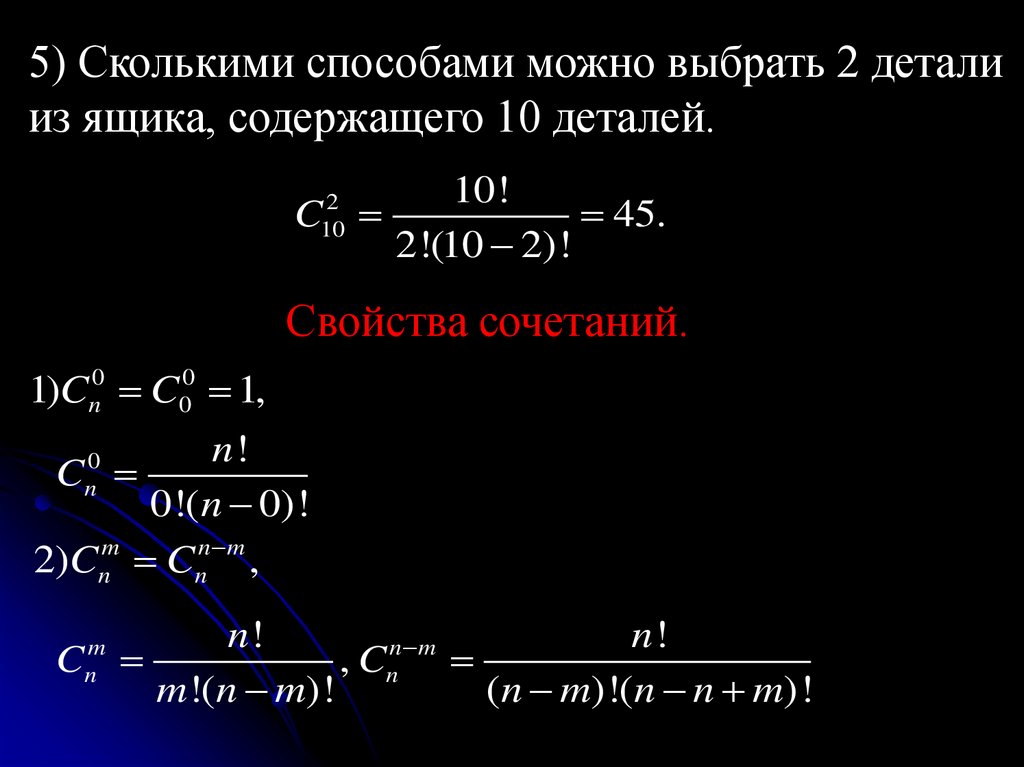

5) Сколькими способами можно выбрать 2 деталииз ящика, содержащего 10 деталей.

10!

C

45.

2!(10 2)!

2

10

Свойства сочетаний.

1)Cn0 C00 1,

n!

0

Cn

0!(n 0)!

2)Cnm Cnn m ,

n!

n!

n m

C

, Cn

m !(n m)!

(n m)!(n n m)!

m

n

49.

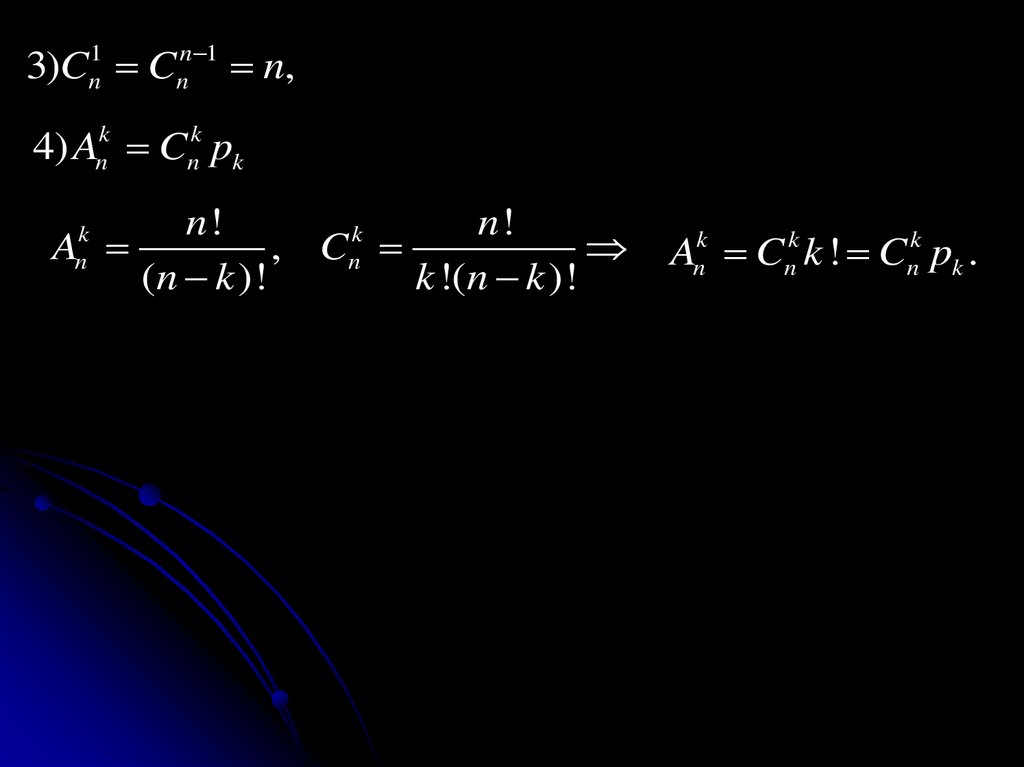

n 1n

3)C C

1

n

n,

4) Ank Cnk pk

n!

n!

k

A

, Cn

(n k )!

k !(n k )!

k

n

Ank Cnk k ! Cnk pk .

50.

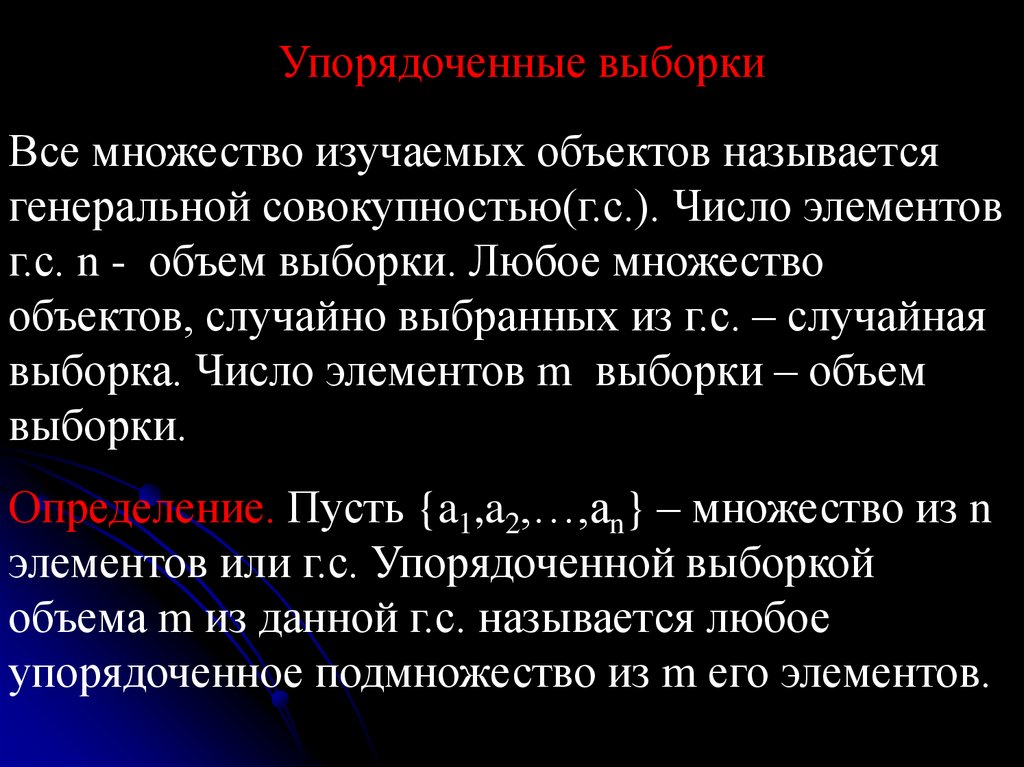

Упорядоченные выборкиВсе множество изучаемых объектов называется

генеральной совокупностью(г.с.). Число элементов

г.с. n - объем выборки. Любое множество

объектов, случайно выбранных из г.с. – случайная

выборка. Число элементов m выборки – объем

выборки.

Определение. Пусть {a1,a2,…,an} – множество из n

элементов или г.с. Упорядоченной выборкой

объема m из данной г.с. называется любое

упорядоченное подмножество из m его элементов.

51.

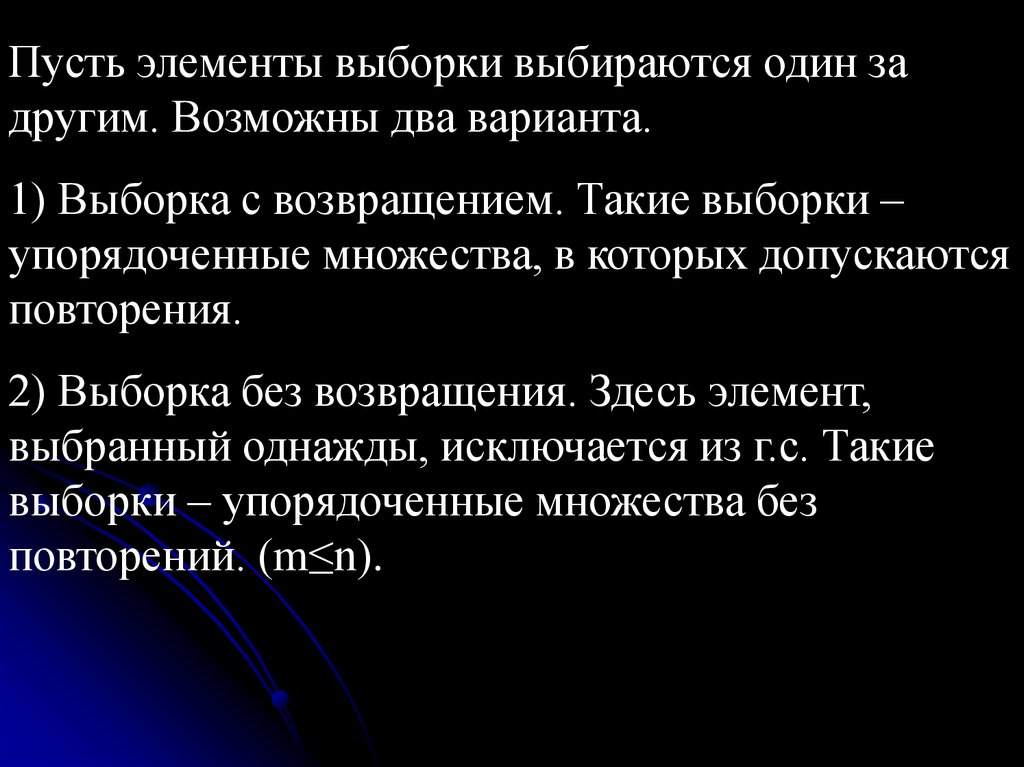

Пусть элементы выборки выбираются один задругим. Возможны два варианта.

1) Выборка с возвращением. Такие выборки –

упорядоченные множества, в которых допускаются

повторения.

2) Выборка без возвращения. Здесь элемент,

выбранный однажды, исключается из г.с. Такие

выборки – упорядоченные множества без

повторений. (m≤n).

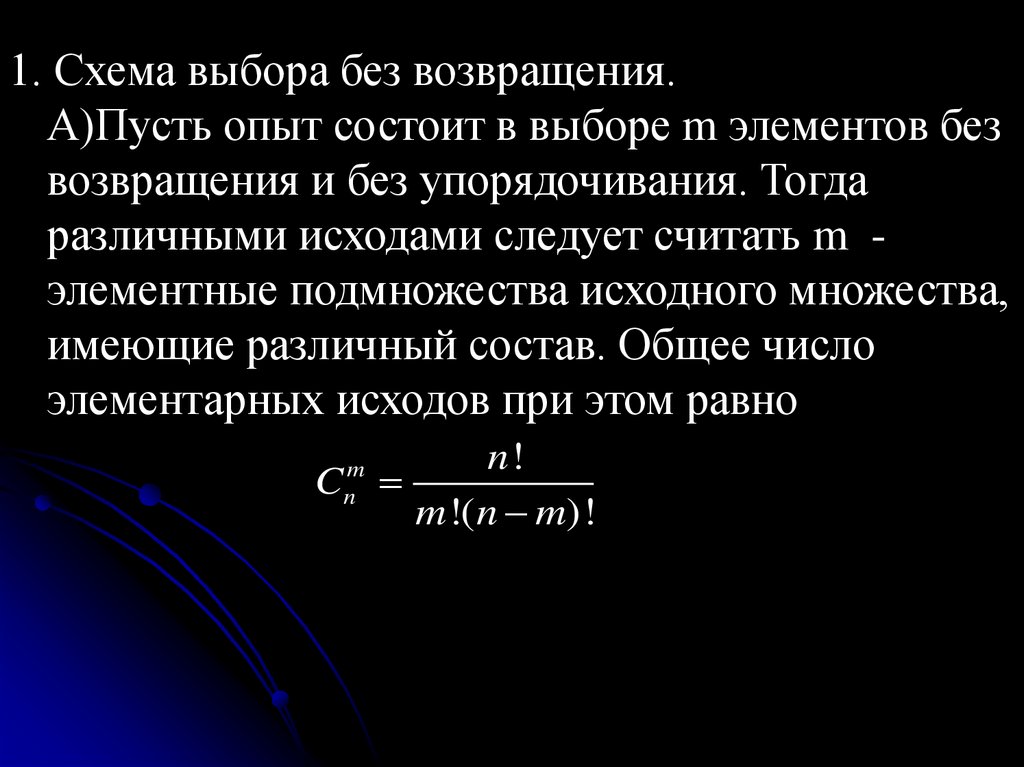

52.

1. Схема выбора без возвращения.А)Пусть опыт состоит в выборе m элементов без

возвращения и без упорядочивания. Тогда

различными исходами следует считать m элементные подмножества исходного множества,

имеющие различный состав. Общее число

элементарных исходов при этом равно

n!

C

m !(n m)!

m

n

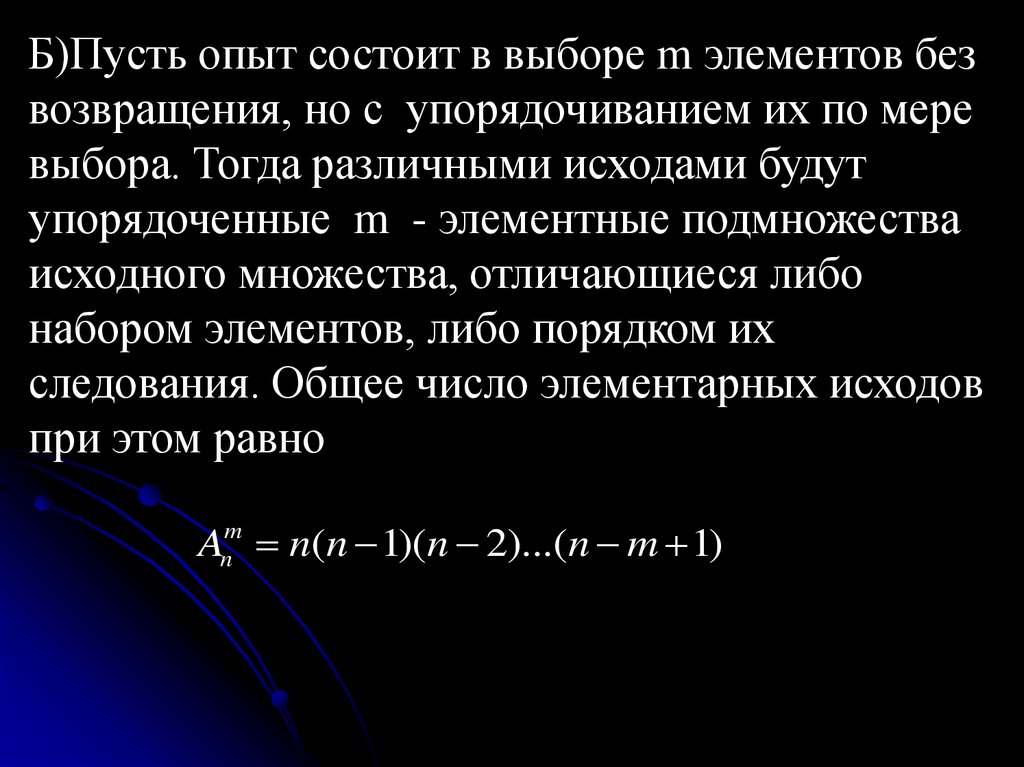

53.

Б)Пусть опыт состоит в выборе m элементов безвозвращения, но с упорядочиванием их по мере

выбора. Тогда различными исходами будут

упорядоченные m - элементные подмножества

исходного множества, отличающиеся либо

набором элементов, либо порядком их

следования. Общее число элементарных исходов

при этом равно

Anm n(n 1)(n 2)...(n m 1)

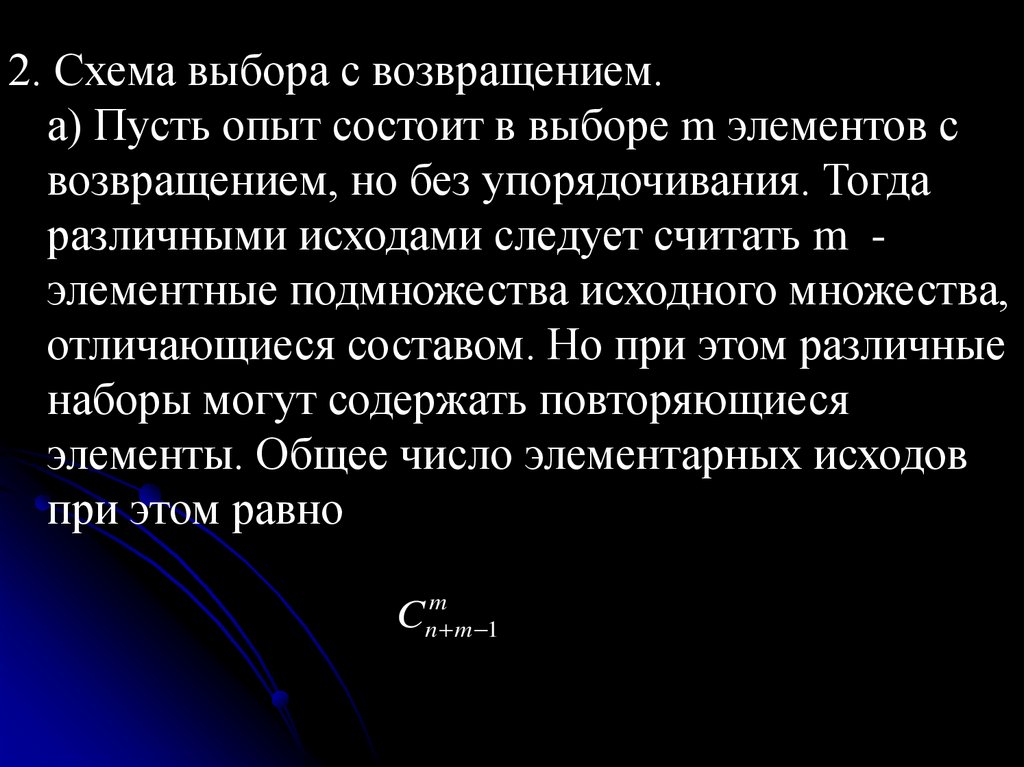

54.

2. Схема выбора с возвращением.а) Пусть опыт состоит в выборе m элементов с

возвращением, но без упорядочивания. Тогда

различными исходами следует считать m элементные подмножества исходного множества,

отличающиеся составом. Но при этом различные

наборы могут содержать повторяющиеся

элементы. Общее число элементарных исходов

при этом равно

C

m

n m 1

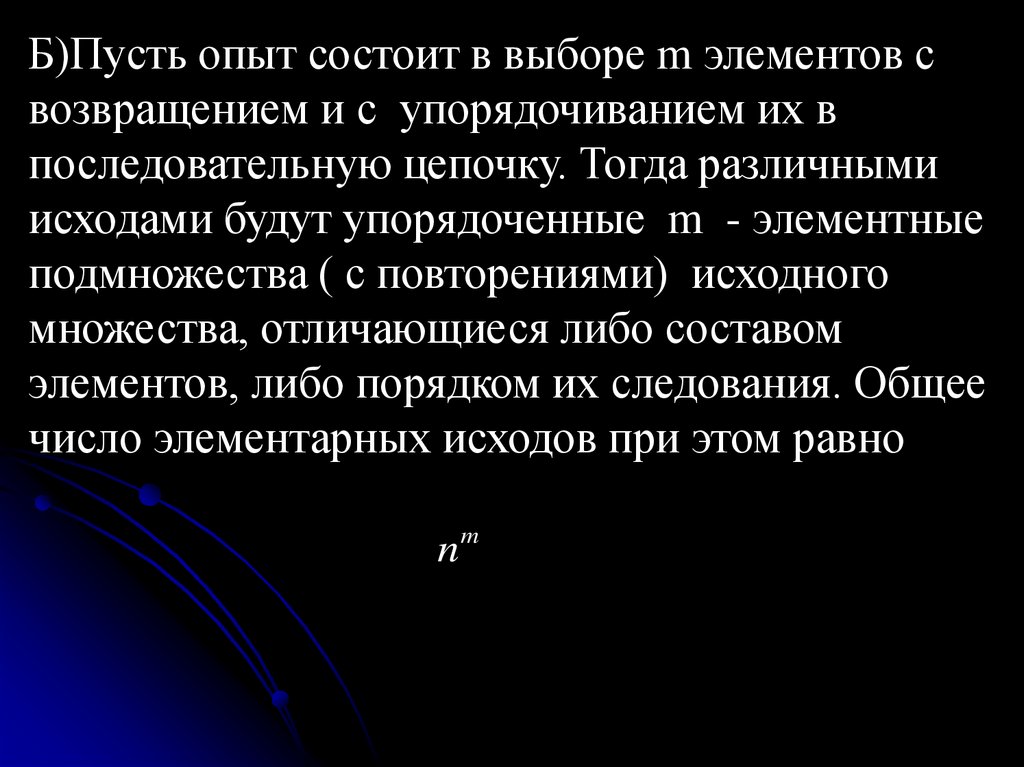

55.

Б)Пусть опыт состоит в выборе m элементов свозвращением и с упорядочиванием их в

последовательную цепочку. Тогда различными

исходами будут упорядоченные m - элементные

подмножества ( с повторениями) исходного

множества, отличающиеся либо составом

элементов, либо порядком их следования. Общее

число элементарных исходов при этом равно

nm

56.

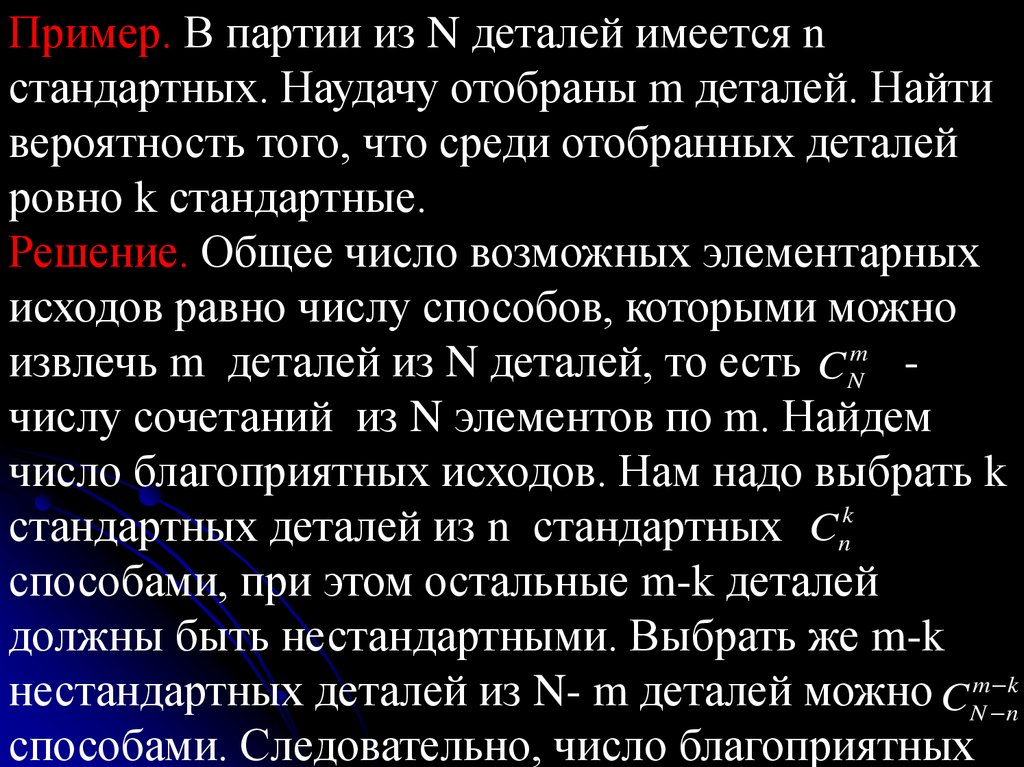

Пример. В партии из N деталей имеется nстандартных. Наудачу отобраны m деталей. Найти

вероятность того, что среди отобранных деталей

ровно k стандартные.

Решение. Общее число возможных элементарных

исходов равно числу способов, которыми можно

извлечь m деталей из N деталей, то есть C Nm числу сочетаний из N элементов по m. Найдем

число благоприятных исходов. Нам надо выбрать k

k

C

стандартных деталей из n стандартных n

способами, при этом остальные m-k деталей

должны быть нестандартными. Выбрать же m-k

нестандартных деталей из N- m деталей можно C Nm nk

способами. Следовательно, число благоприятных

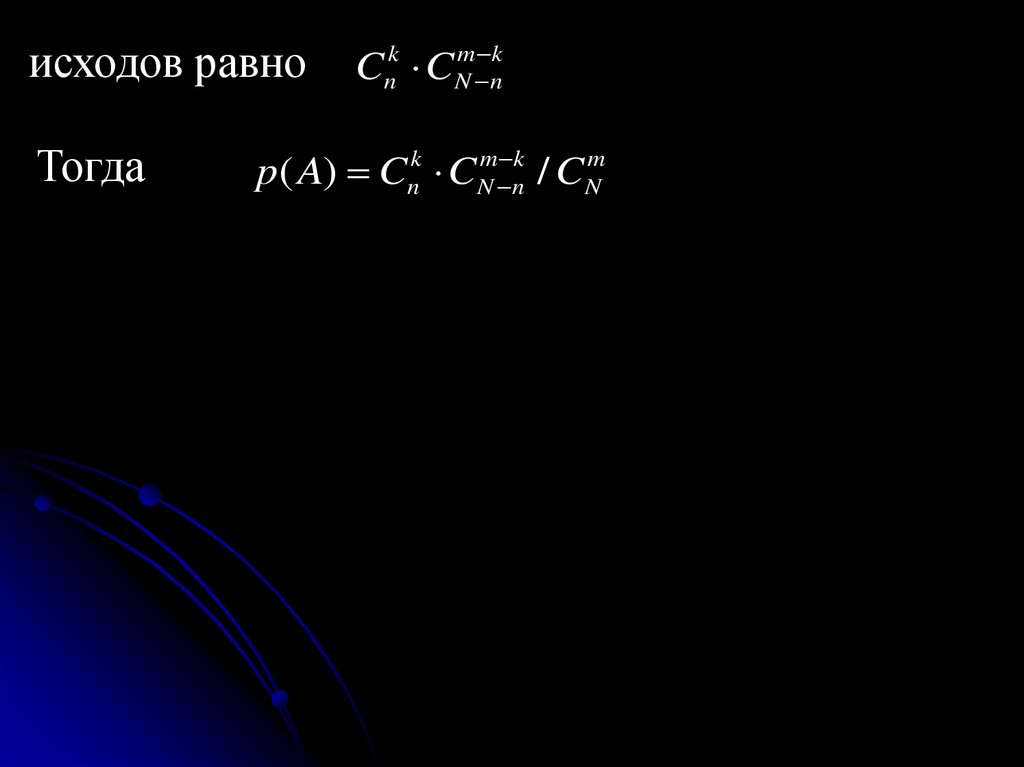

57.

исходов равноТогда

C C

k

n

m k

N n

p( A) Cnk CNm nk / CNm

58.

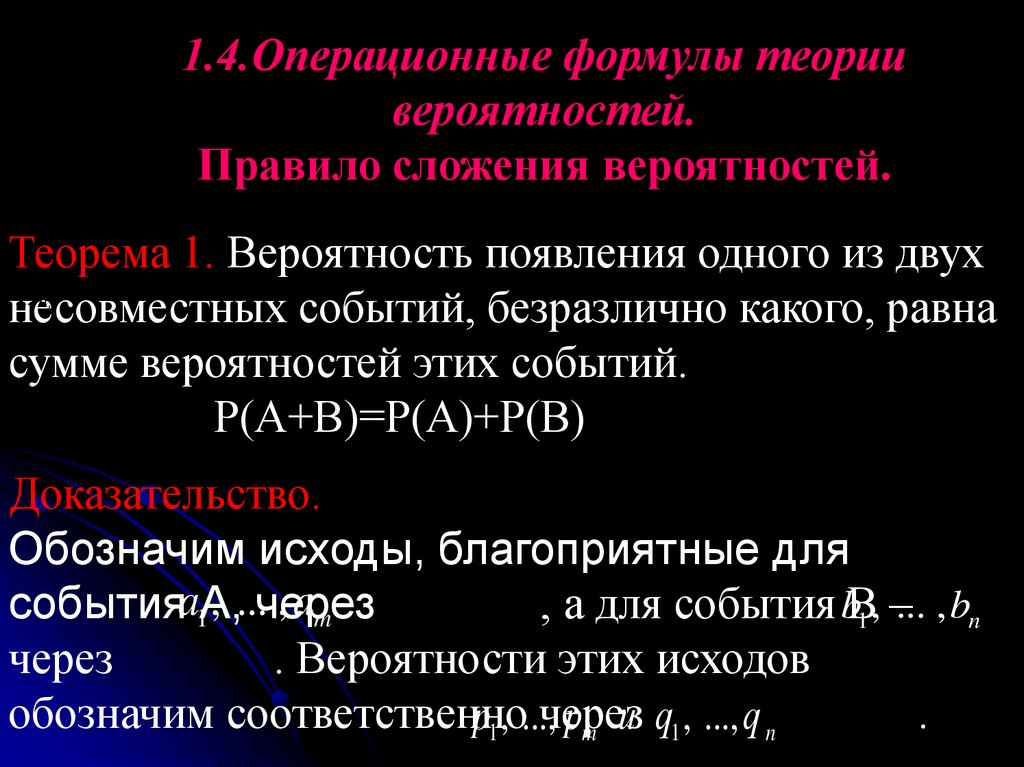

1.4.Операционные формулы теориивероятностей.

Правило сложения вероятностей.

Теорема 1. Вероятность появления одного из двух

несовместных событий, безразлично какого, равна

сумме вероятностей этих событий.

Р(А+В)=Р(А)+Р(В)

a1 , ... am

b1 , ... bn

Доказательство.

Обозначим исходы, благоприятные для

, ...через

, am

событияa1А,

, а для события bВ1 , –... , bn

через

. Вероятности этих исходов

обозначим соответственно

.

p1 , ...,через

pm и q1 , ..., q n

b1 , ... bn

59.

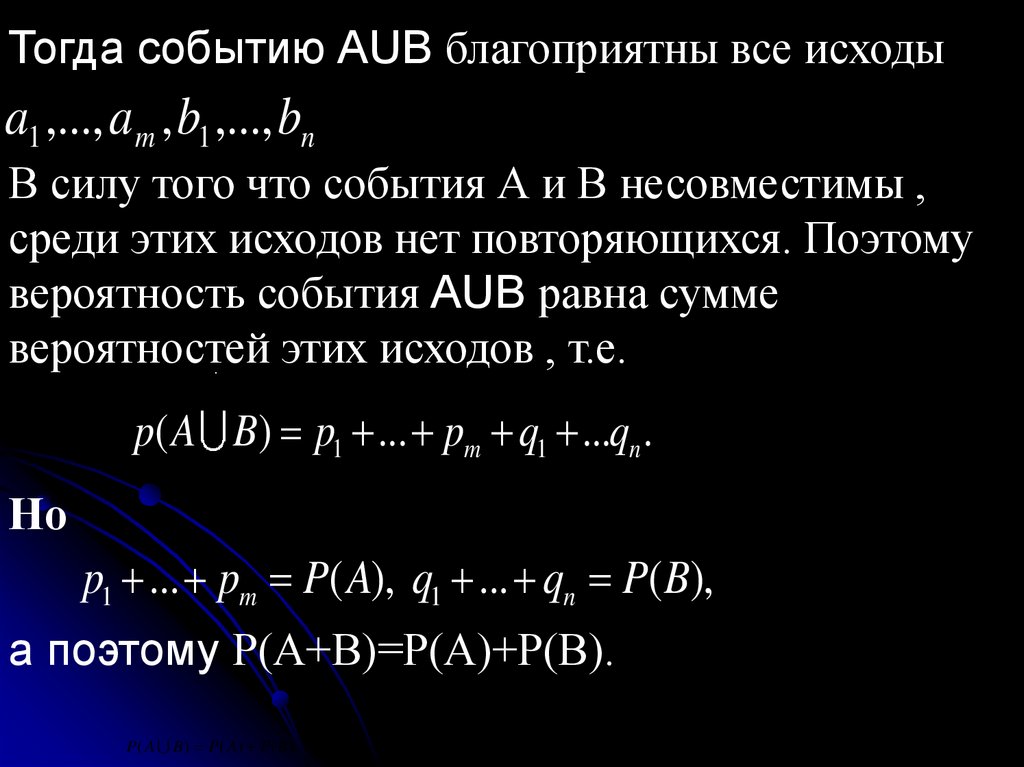

Тогда событию АUВ благоприятны все исходыa1 ,..., am , b1 ,..., bn

В силу того что события А и В несовместимы ,

среди этих исходов нет повторяющихся. Поэтому

вероятность события АUВ равна сумме

вероятностей этих исходов , т.е.

A B

a1 ,..., a m , b1 ,..., bn

.

A B

p( A B) p1 ... pm q1 ...qn .

Но

p1 ... pm P( A), q1 ... qn P( B),

а поэтому Р(А+В)=Р(А)+Р(В).

P( A B) P( A) P( B).

60.

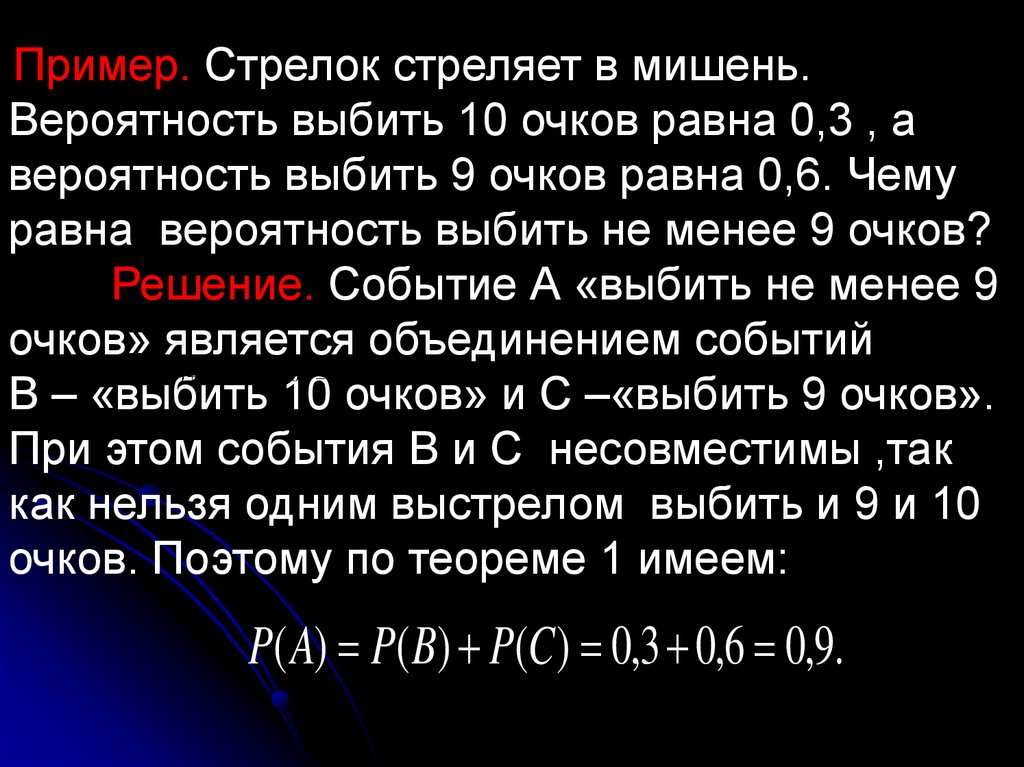

Пример. Стрелок стреляет в мишень.Вероятность выбить 10 очков равна 0,3 , а

вероятность выбить 9 очков равна 0,6. Чему

равна вероятность выбить не менее 9 очков?

Решение. Событие А «выбить не менее 9

очков» является объединением событий

В – «выбить 10 очков» и С –«выбить 9 очков».

При этом события В и С несовместимы ,так

как нельзя одним выстрелом выбить и 9 и 10

очков. Поэтому по теореме 1 имеем:

P( A) P( B) P(C ) 0,3 0,6 0,9.

P( A) P( B) P(C ) 0,3 0,6 0,9.

61.

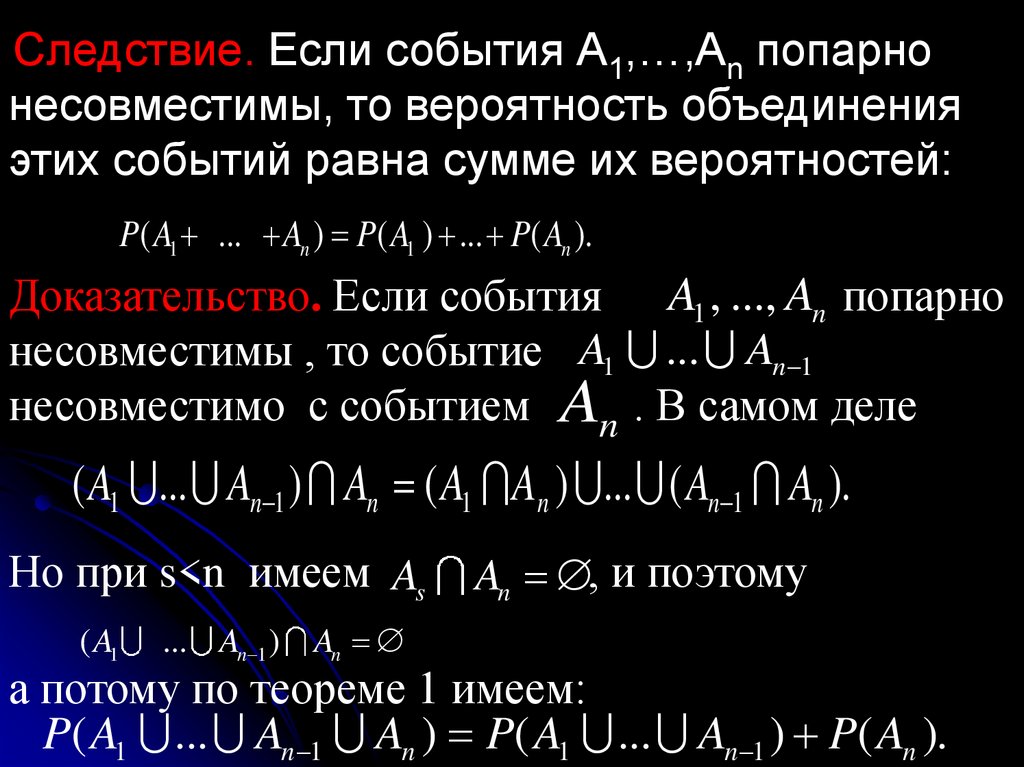

Следствие. Если события А1,…,Аn попарнонесовместимы, то вероятность объединения

этих событий равна сумме их вероятностей:

P( A1 ... An ) P( A1 ) ... P( An ).

P( A1 ... An ) P( A1 ) ... P( An ).

Доказательство. Если события A1 , ..., An попарно

несовместимы , то событие A1 ... An 1

несовместимо с событием An . В самом деле

( A1 ... An 1 ) An ( A1 An ) ... ( An 1 An ).

A1 ... An 1

Но при s<n имеем As

( A1

... An 1 )

An

An , и поэтому

а потому по теореме 1 имеем:

P( A1 ... An 1 An ) P( A1 ... An 1 ) P( An ).

( A1 ... An 1 ) An

62.

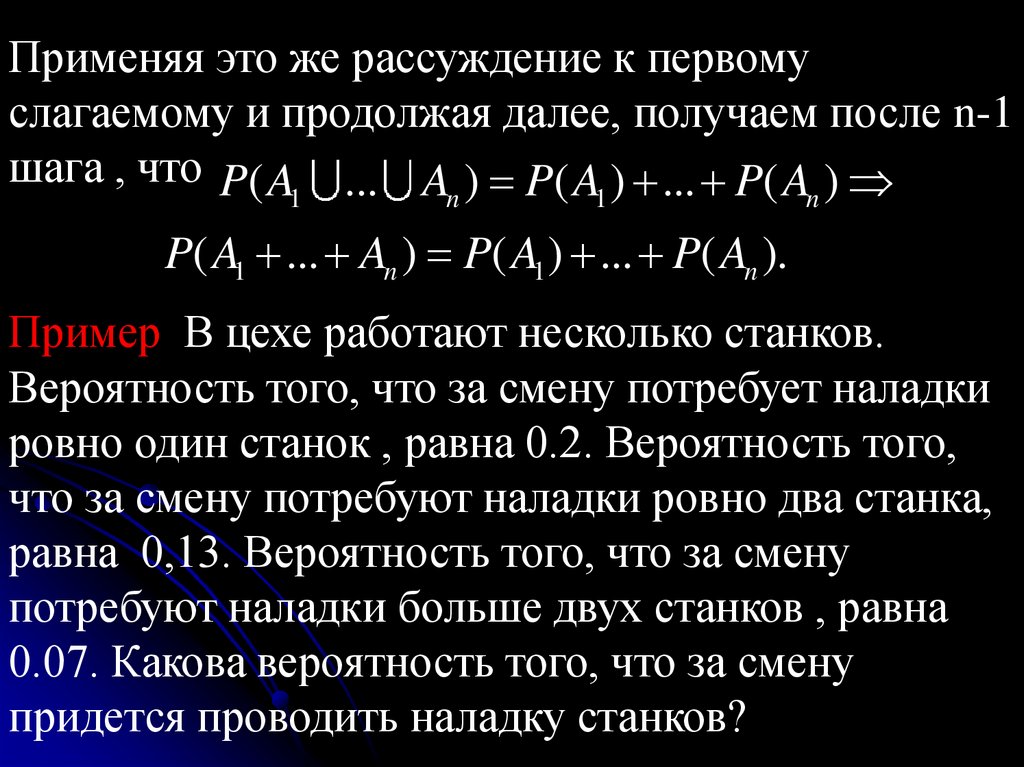

Применяя это же рассуждение к первомуслагаемому и продолжая далее, получаем после n-1

шага , что P( A ... A ) P( A ) ... P( A )

1

n

1

n

P( A1 ... An ) P( A1 ) ... P( An ).

Пример В цехе работают несколько станков.

Вероятность того, что за смену потребует наладки

ровно один станок , равна 0.2. Вероятность того,

что за смену потребуют наладки ровно два станка,

равна 0,13. Вероятность того, что за смену

потребуют наладки больше двух станков , равна

0.07. Какова вероятность того, что за смену

придется проводить наладку станков?

63.

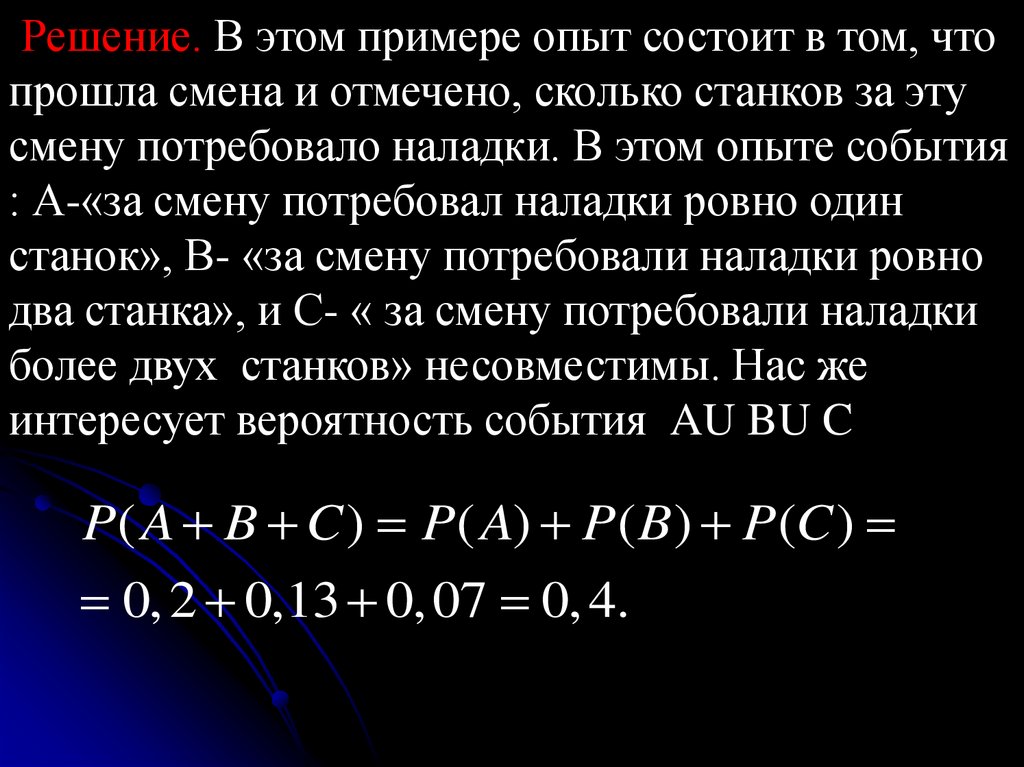

Решение. В этом примере опыт состоит в том, чтопрошла смена и отмечено, сколько станков за эту

смену потребовало наладки. В этом опыте события

: А-«за смену потребовал наладки ровно один

станок», В- «за смену потребовали наладки ровно

два станка», и С- « за смену потребовали наладки

более двух станков» несовместимы. Нас же

интересует вероятность события AU BU C

P( A B C ) P( A) P( B) P(C )

0, 2 0,13 0, 07 0, 4.

64.

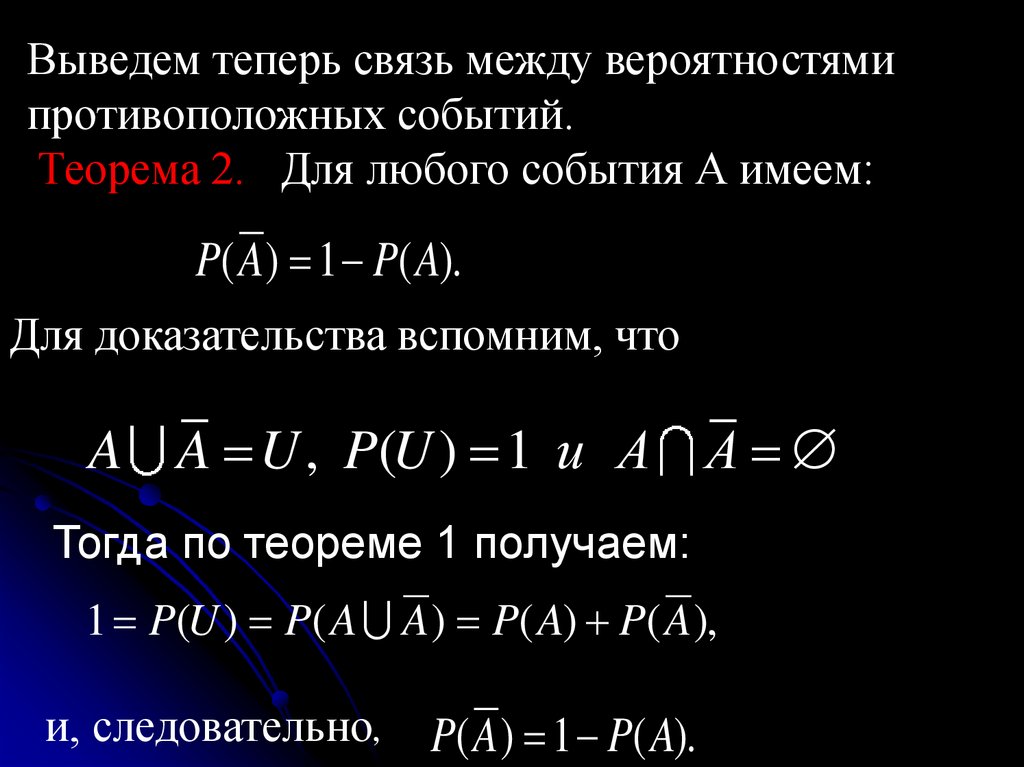

Выведем теперь связь между вероятностямипротивоположных событий.

Теорема 2. Для любого события А имеем:

P( A ) 1 P( A).

Для доказательства вспомним, что

A A U , P(U ) 1 и A A

Тогда по теореме 1 получаем:

1 P(U ) P( A A ) P( A) P( A ),

и, следовательно,

P( A ) 1 P( A).

65.

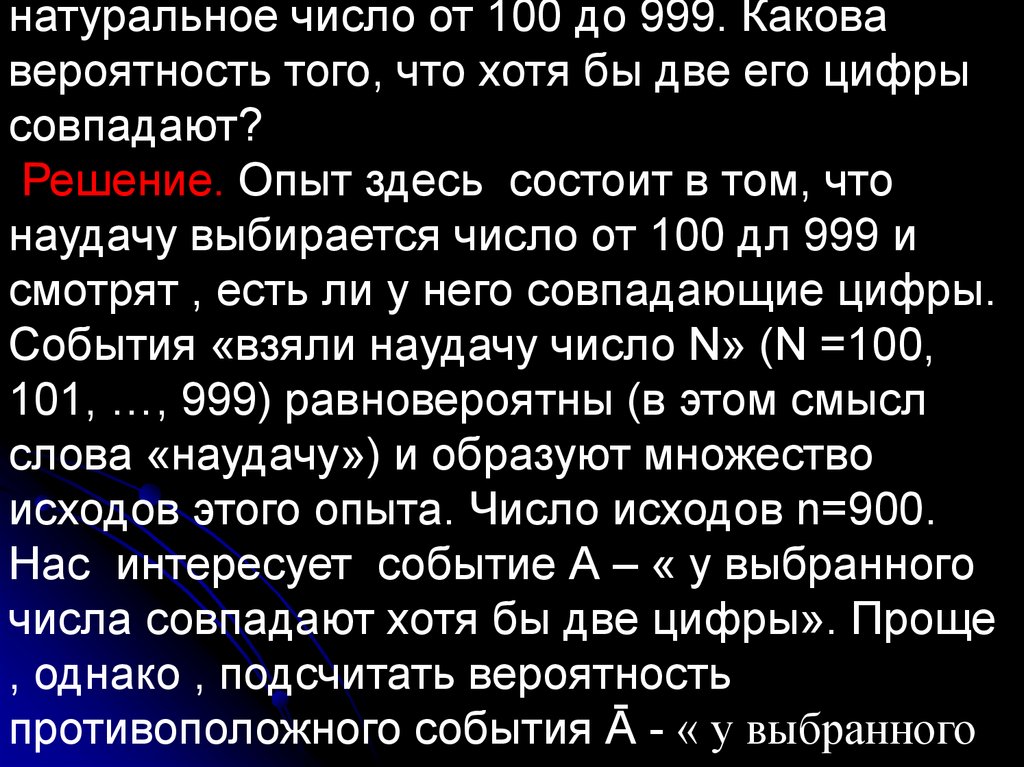

натуральное число от 100 до 999. Каковавероятность того, что хотя бы две его цифры

совпадают?

Решение. Опыт здесь состоит в том, что

наудачу выбирается число от 100 дл 999 и

смотрят , есть ли у него совпадающие цифры.

События «взяли наудачу число N» (N =100,

101, …, 999) равновероятны (в этом смысл

слова «наудачу») и образуют множество

исходов этого опыта. Число исходов n=900.

Нас интересует событие А – « у выбранного

числа совпадают хотя бы две цифры». Проще

, однако , подсчитать вероятность

противоположного события Ā - « у выбранного

À

66.

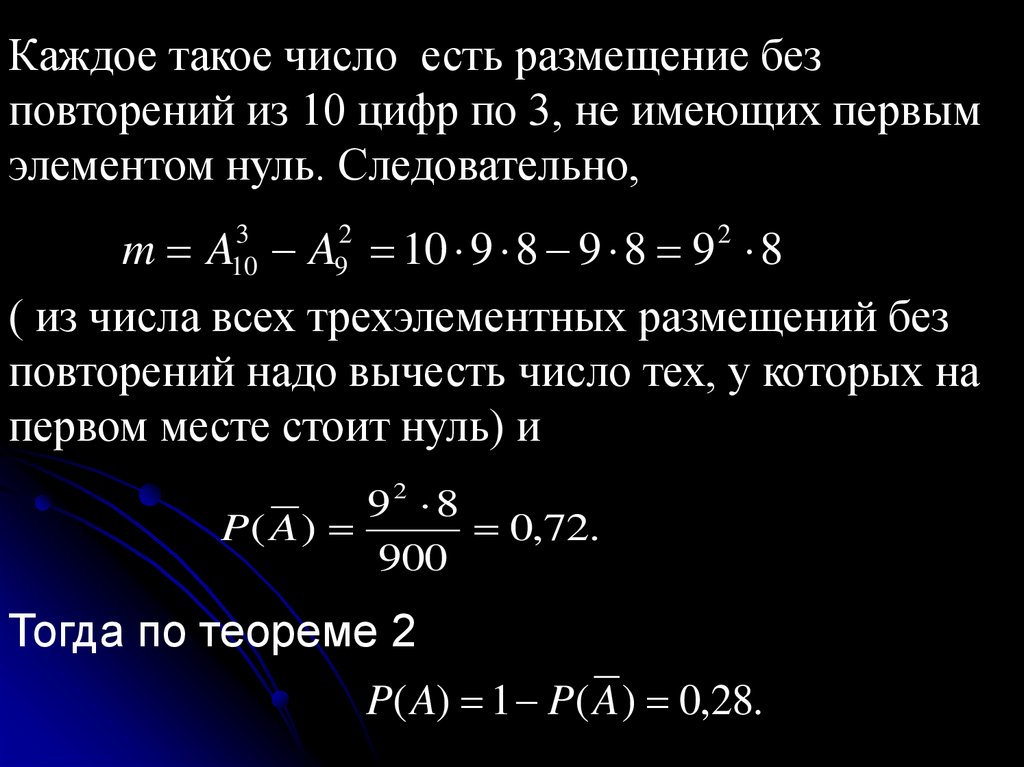

Каждое такое число есть размещение безповторений из 10 цифр по 3, не имеющих первым

элементом нуль. Следовательно,

m A A 10 9 8 9 8 9 8

( из числа всех трехэлементных размещений без

повторений надо вычесть число тех, у которых на

первом месте стоит нуль) и

3

10

2

9

2

92 8

P( A )

0,72.

900

Тогда по теореме 2

P( A) 1 P( A ) 0,28.

67.

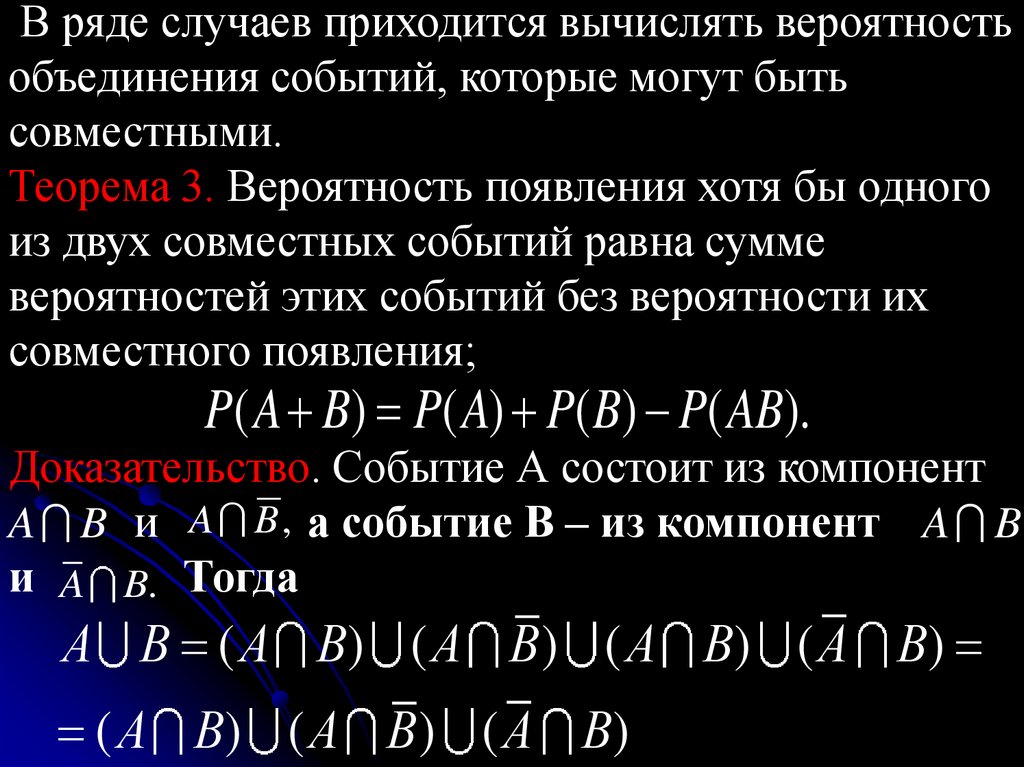

В ряде случаев приходится вычислять вероятностьобъединения событий, которые могут быть

совместными.

Теорема 3. Вероятность появления хотя бы одного

из двух совместных событий равна сумме

вероятностей этих событий без вероятности их

совместного появления;

P( A B) P( A) P( B) P( AB).

Доказательство. Событие А состоит из компонент

A B и A B , а событие В – из компонент A B

и A B. Тогда

A B,

А В ( А В) ( А В ) ( А В) ( А В)

( А В) ( А В ) ( А В)

68.

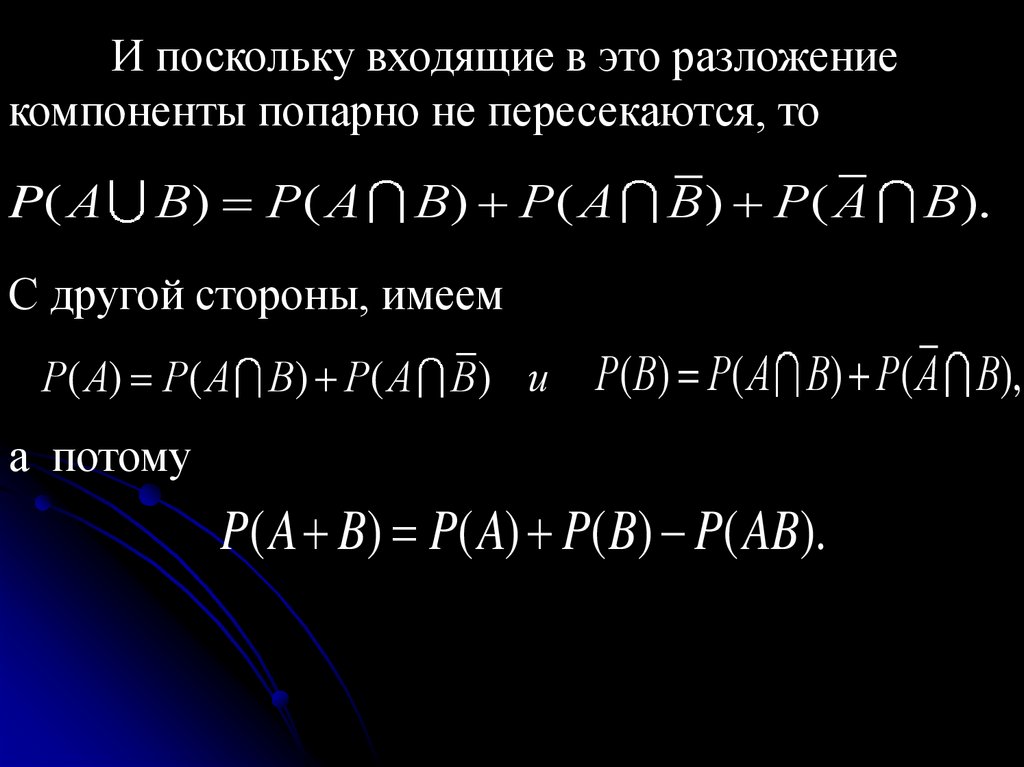

И поскольку входящие в это разложениекомпоненты попарно не пересекаются, то

P( А

В) P( А

В) P( А

В ) P( А

В).

С другой стороны, имеем

Р( А) Р( А В) Р( А В ) и

Р( В) P( А В) Р( А В),

Ð( Â) Ð( À Â) Ð( À Â),

а потому

P( A B) P( A) P( B) P( AB).

69.

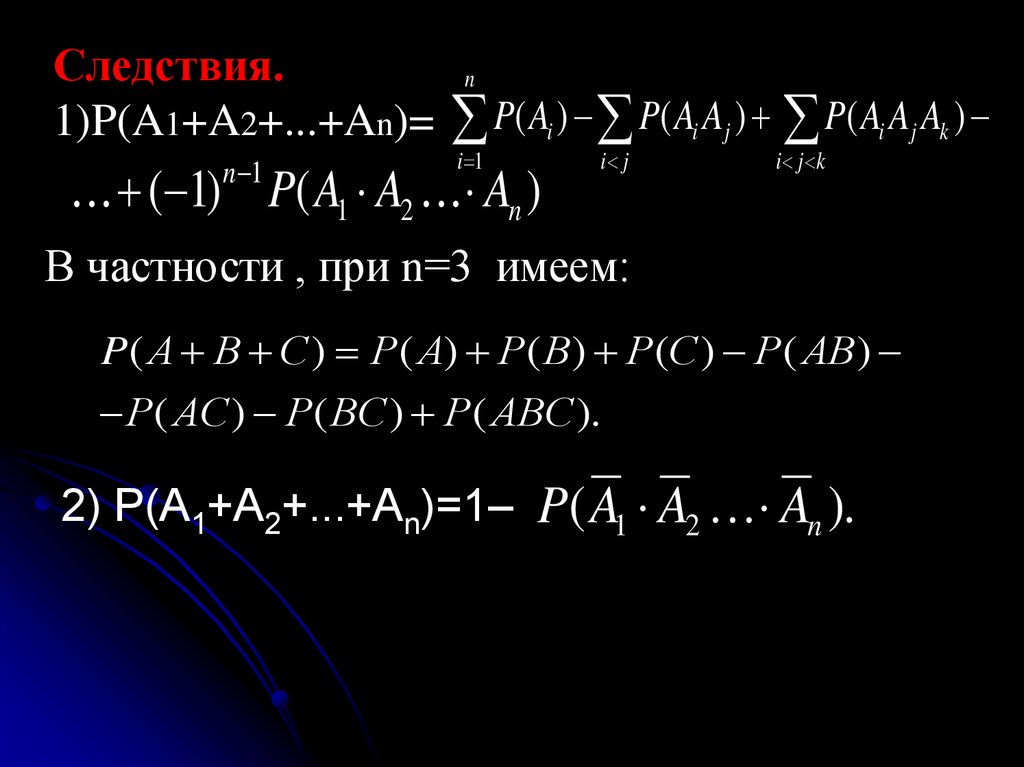

Следствия.n

1)P(A1+A2+...+An)= P( Ai ) P( Ai Aj ) P( Ai Aj Ak )

n 1

i 1

( 1) P( A1 A2 An )

i j

i j k

В частности , при n=3 имеем:

P( А В С ) Р( А) Р( В) Р(С ) Р( АВ )

Р( АС ) Р( ВС ) Р( АВС ).

2) P(A1+A2+...+An)=1– P( A1 A2 An ).

70.

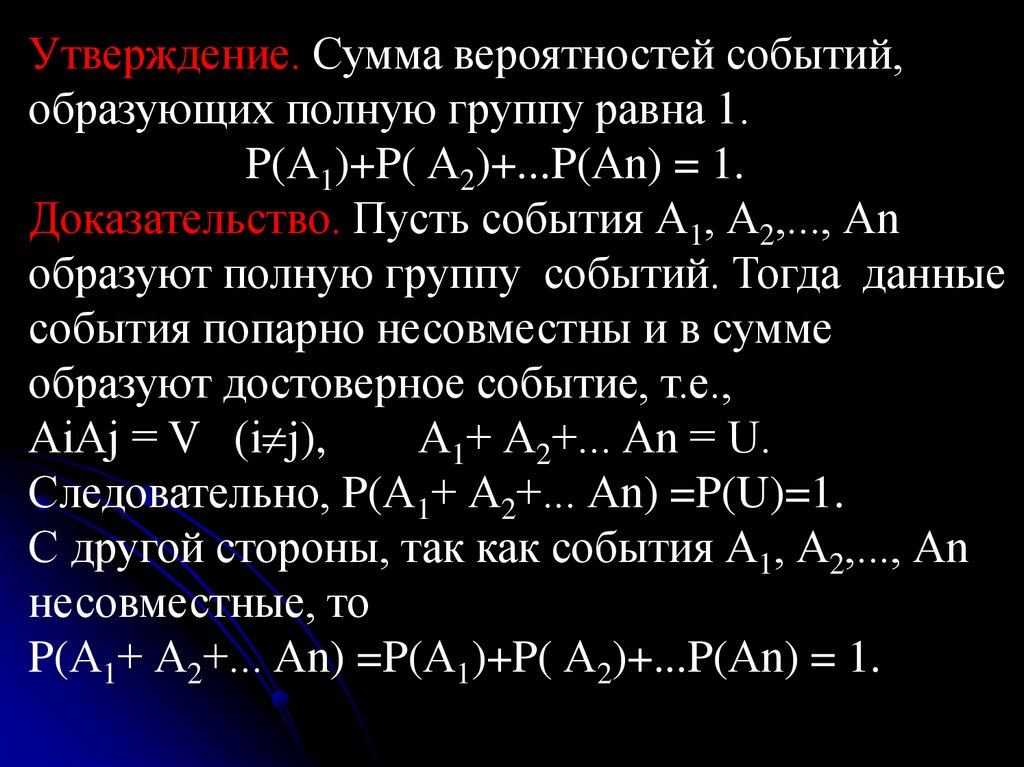

Утверждение. Сумма вероятностей событий,образующих полную группу равна 1.

P(А1)+P( А2)+...P(Аn) = 1.

Доказательство. Пусть события А1, А2,..., Аn

образуют полную группу событий. Тогда данные

события попарно несовместны и в сумме

образуют достоверное событие, т.е.,

АiАj = V (i j),

А1+ А2+... Аn = U.

Следовательно, P(А1+ А2+... Аn) =P(U)=1.

С другой стороны, так как события А1, А2,..., Аn

несовместные, то

P(А1+ А2+... Аn) =P(А1)+P( А2)+...P(Аn) = 1.

71.

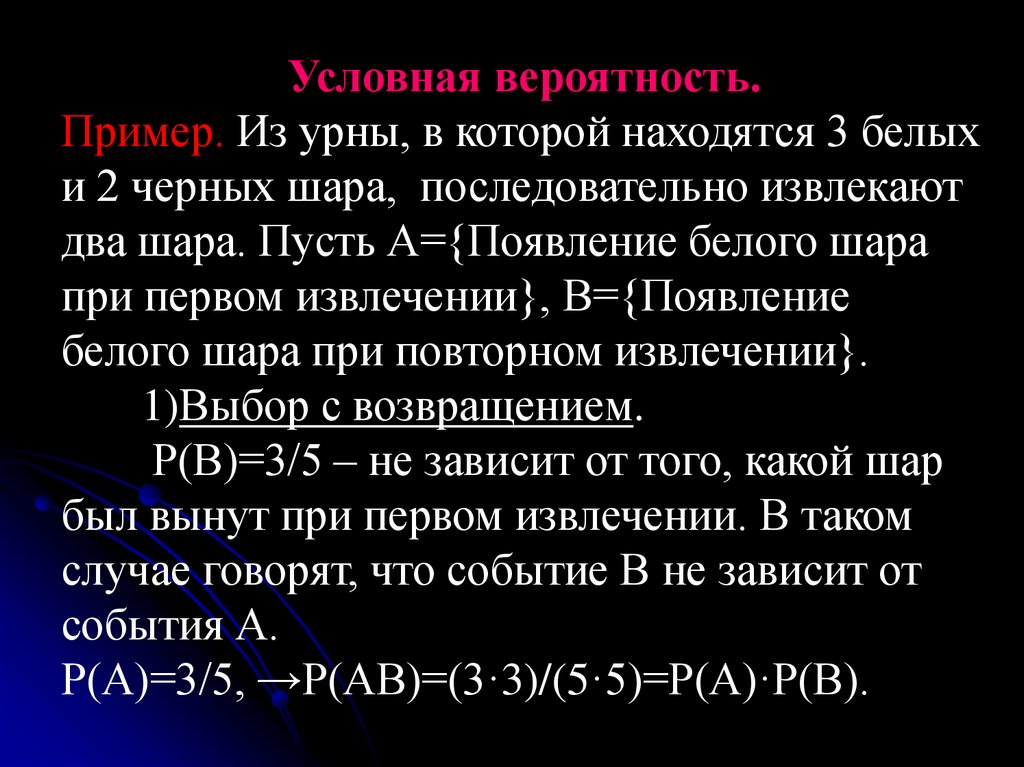

Условная вероятность.Пример. Из урны, в которой находятся 3 белых

и 2 черных шара, последовательно извлекают

два шара. Пусть А={Появление белого шара

при первом извлечении}, В={Появление

белого шара при повторном извлечении}.

1)Выбор с возвращением.

Р(В)=3/5 – не зависит от того, какой шар

был вынут при первом извлечении. В таком

случае говорят, что событие В не зависит от

события А.

Р(А)=3/5, →Р(АВ)=(3·3)/(5·5)=Р(А)·Р(В).

72.

2)Выбор без возвращения.Обозначим Р(В/А) - вероятность

события В при условии, что произошло

событие А. Такая вероятность называется

условной вероятностью. Аналогично

введем Р(В/Ā).

Очевидно Р(В/А)=2/4=1/2, Р(В/Ā)= 3/4 .

Т.е. в этом случае вероятность события В зависит

от того, произошло или нет событие А.

Р(АВ)=(3·2)/(5·4)=3/10=Р(А)·Р(В/А).

).

73.

Перейдем к определению условной вероятностиР(В/А).Применим статистический подход. Пусть

опыт S повторен N раз, при этом событие А

наблюдалось NА раз, событие АВ – NAB раз.

Условная частота появления события АВ в серии

из NA опытов равна

NAB /NA=(NAB/N)/(NA/N) P(AB)/P(A).

С другой стороны, при больших NA,

NAB /NA Р(В/А). Поэтому естественно принять

по определению

Р(В/А)=Р(АВ)/Р(А).

74.

Правило умножения вероятностей.Вероятность совместного появления двух событий

равна произведению вероятности одного из них на

условную вероятность другого, вычисленную в

предположении, что первое событие уже

наступило.

Р(АВ)= Р(А)Р(В/А)

Следствия:

1)Р(А)Р(В/А)=Р(В)Р(А/В);

2)P(A1A2...An)=Р(А1)Р(А2/А1)Р(А3/А1А2)...

Р(Аn/ A1A2...An-1).

75.

Статистическая независимость.Пусть событие В не зависит от события А

(появление события А не изменяет вероятность

появления события В) Тогда имеет место

равенство:

Р(В/А)=Р(В) .

Так как P(AB)= P(A)P(B/A) =P(BA)=P(B)P(A/B), то

P(A)P(B) =P(B)P(A/B), P(A)=P(A/B), то есть

условная вероятность события А в предположении,

что наступило событие В, равна безусловной

вероятности события А.

76.

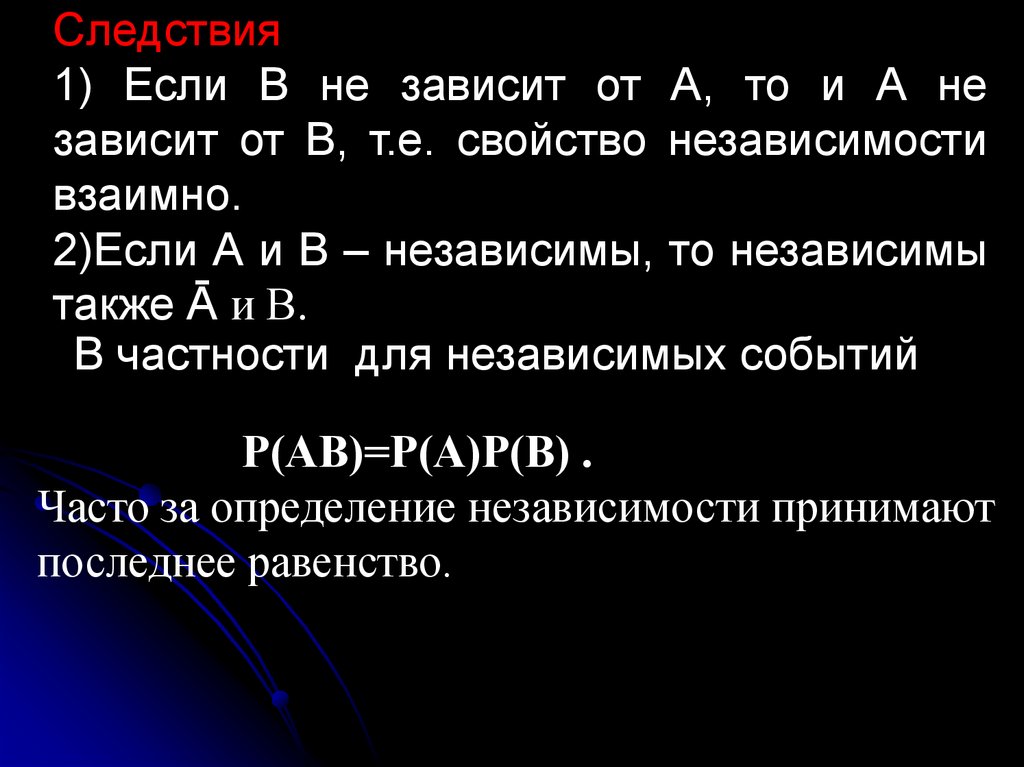

Следствия1) Если В не зависит от А, то и А не

зависит от В, т.е. свойство независимости

взаимно.

2)Если А и В – независимы, то независимы

также Ā и В.

В частности для независимых событий

Р(АВ)=Р(А)Р(В) .

Часто за определение независимости принимают

последнее равенство.

77.

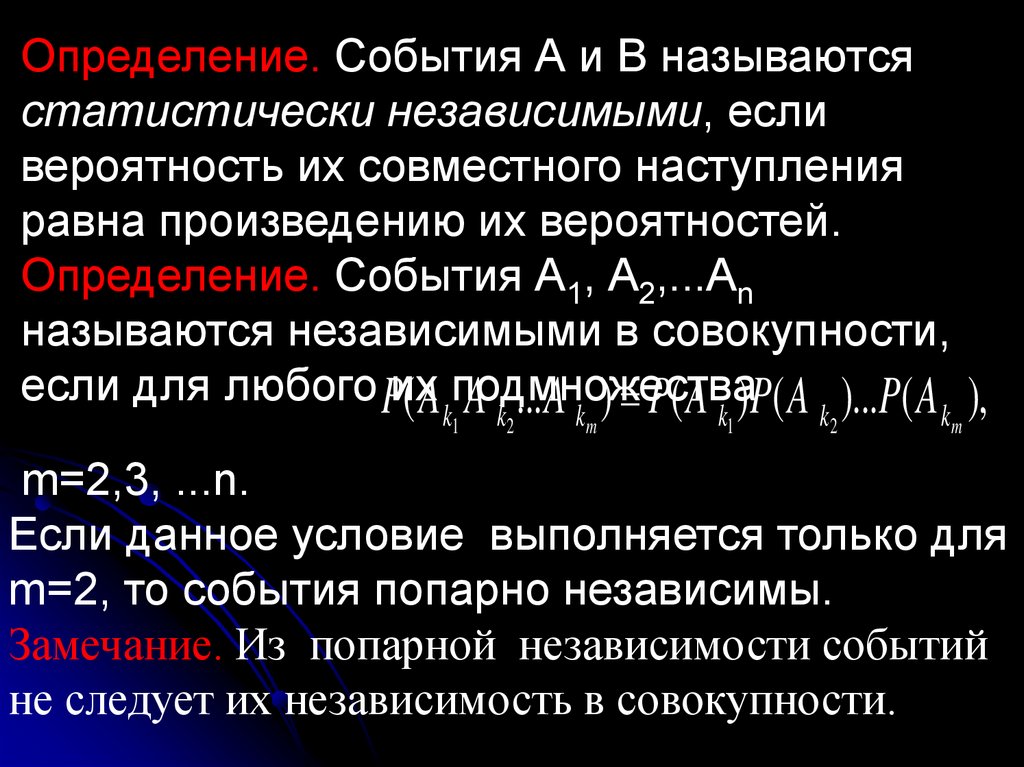

Определение. События А и В называютсястатистически независимыми, если

вероятность их совместного наступления

равна произведению их вероятностей.

Определение. События А1, А2,...Аn

называются независимыми в совокупности,

если для любого Pих

( A подмножества

A ...A ) P( A ) P( A )...P( A ),

k1

k2

km

k1

k2

km

m=2,3, ...n.

Если данное условие выполняется только для

m=2, то события попарно независимы.

Замечание. Из попарной независимости событий

не следует их независимость в совокупности.

78.

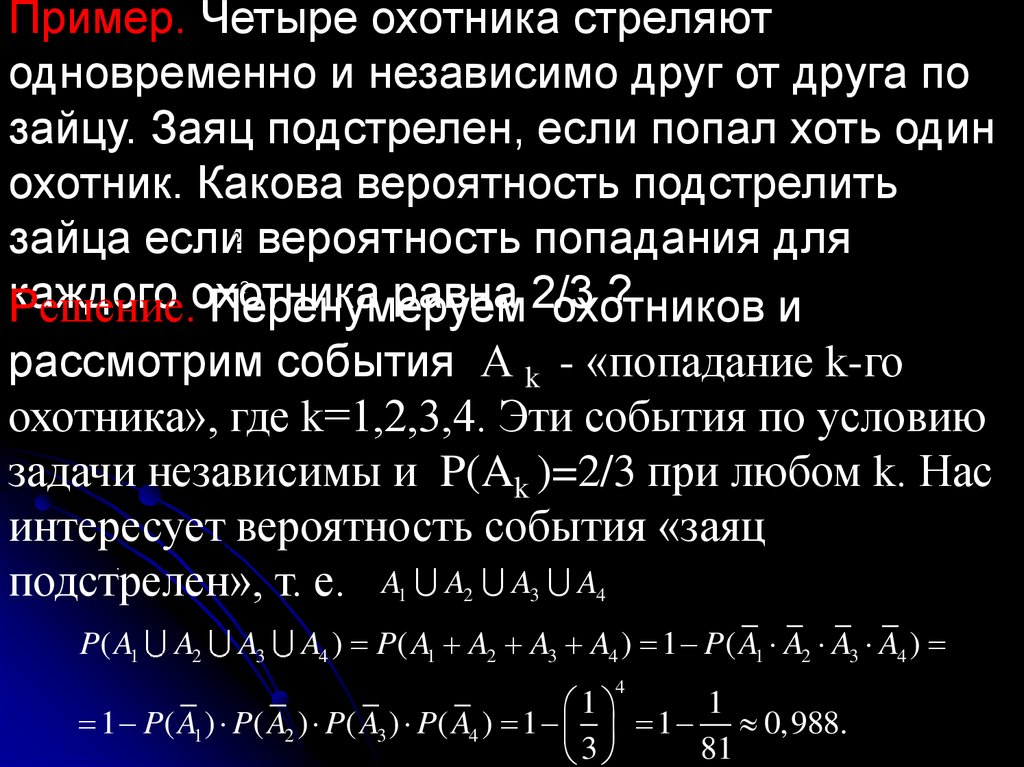

Пример. Четыре охотника стреляютодновременно и независимо друг от друга по

зайцу. Заяц подстрелен, если попал хоть один

охотник. Какова вероятность подстрелить

зайца если вероятность попадания для

каждого

равна 2/3

?

Решение.охотника

Перенумеруем

охотников

и

2

3

?

рассмотрим события А k - «попадание k-го

охотника», где k=1,2,3,4. Эти события по условию

задачи независимы и P(Ak )=2/3 при любом k. Нас

интересует вероятность события «заяц

подстрелен», т. е. A1 A2 A3 A4

Ak

P ( Ak )

2

3

A1 A2 A3 A4

:

P( A1

A2

A3

A4 ) P( A1 A2 A3 A4 ) 1 P( A1 A2 A3 A4 )

4

1

1

1 P( A1 ) P( A2 ) P( A3 ) P( A4 ) 1 1 0,988.

81

3

79.

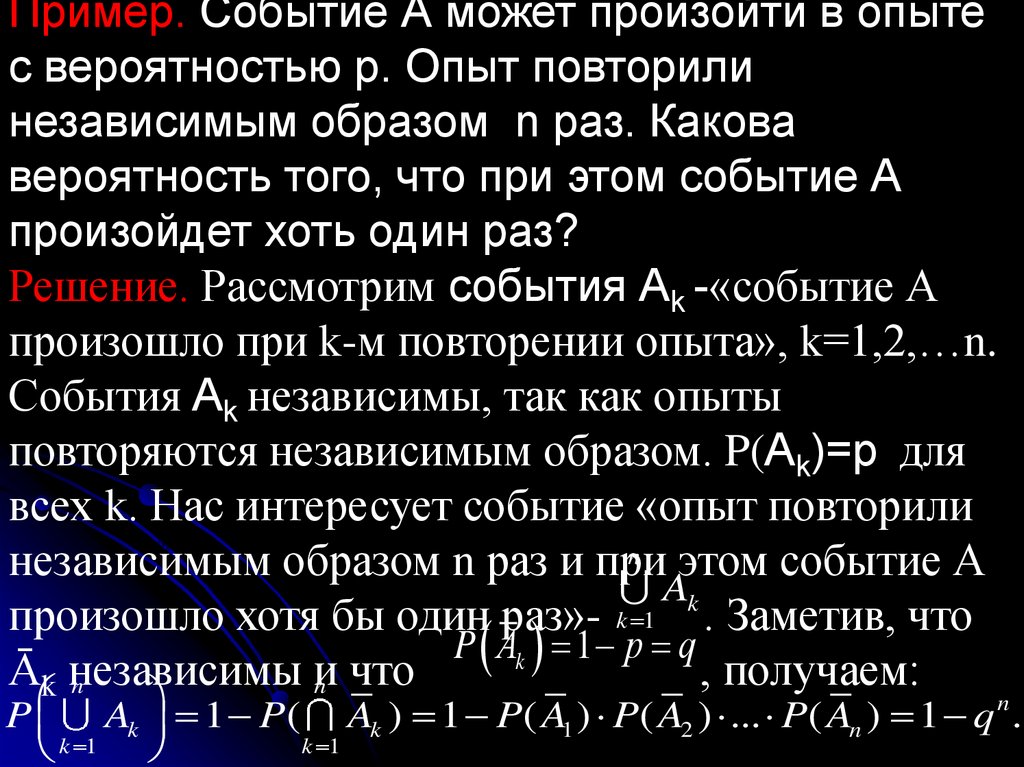

Пример. Событие А может произойти в опытес вероятностью p. Опыт повторили

независимым образом n раз. Какова

вероятность того, что при этом событие А

произойдет хоть один раз?

Решение. Рассмотрим события Аk -«событие А

произошло при k-м повторении опыта», k=1,2,…n.

События Аk независимы, так как опыты

повторяются независимым образом. P(Аk)=p для

всех k. Нас интересует событие «опыт повторили

n

независимым образом n раз и при

этом событие А

Ak

произошло хотя бы один раз»- k 1 . Заметив, что

P Аk 1 p q

Āk независимы

и

, получаем:

n

n что

Ak

Ak

P( Ak ) p

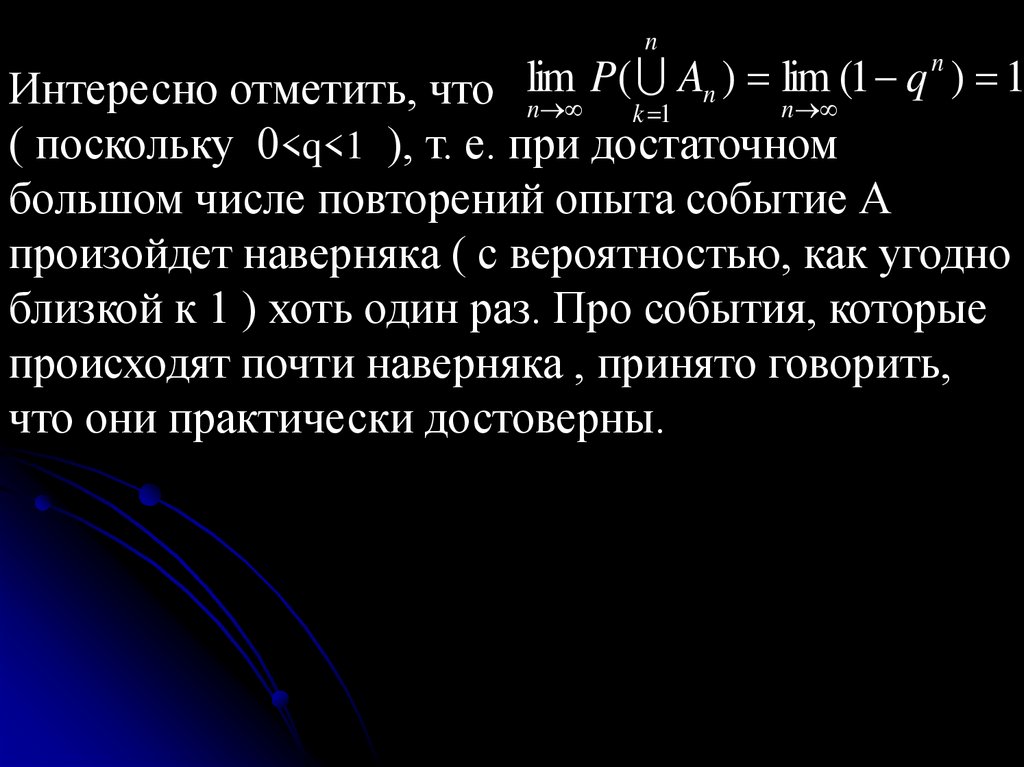

n

Ak

k 1

Ak

P Ak 1 P( Ak ) 1 P( A1 ) P( A2 ) ... P( An ) 1 q n .

k 1

k 1

80.

nP( An ) lim (1 q ) 1

Интересно отметить, что lim

n

n

k 1

( поскольку 0<q<1 ), т. е. при достаточном

большом числе повторений опыта событие А

произойдет наверняка ( с вероятностью, как угодно

близкой к 1 ) хоть один раз. Про события, которые

происходят почти наверняка , принято говорить,

что они практически достоверны.

n

81.

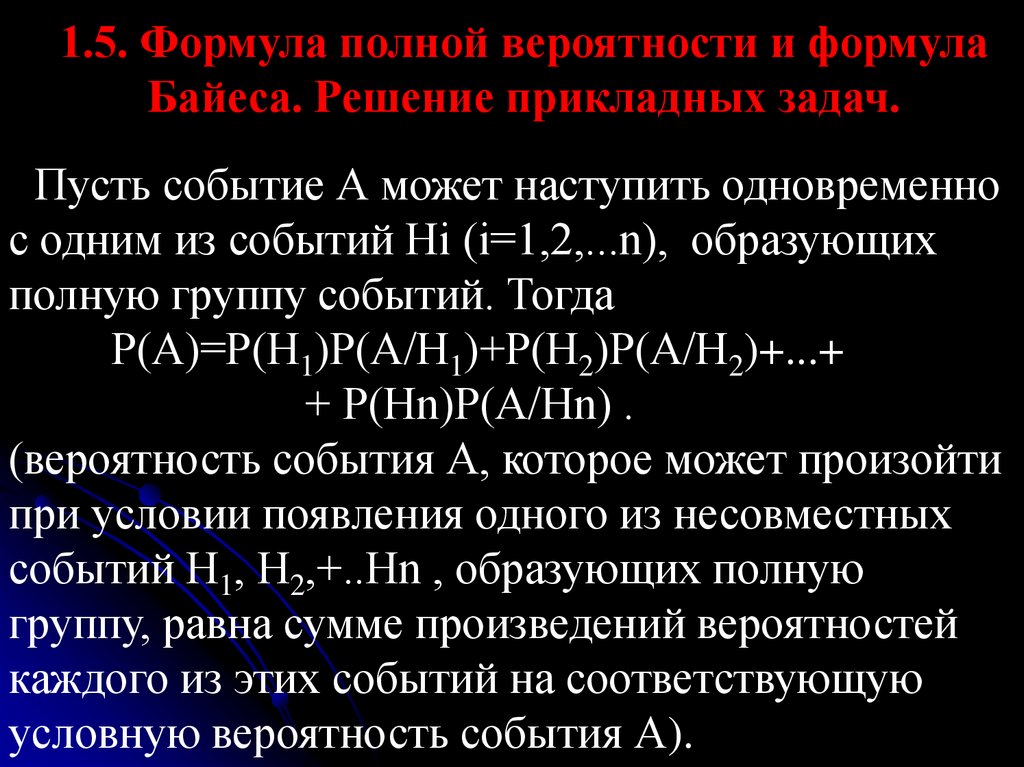

1.5. Формула полной вероятности и формулаБайеса. Решение прикладных задач.

Пусть событие А может наступить одновременно

с одним из событий Hi (i=1,2,...n), образующих

полную группу событий. Тогда

Р(А)=Р(Н1)Р(А/Н1)+Р(Н2)Р(А/Н2)+...+

+ Р(Нn)Р(А/Hn) .

(вероятность события А, которое может произойти

при условии появления одного из несовместных

событий Н1, Н2,+..Нn , образующих полную

группу, равна сумме произведений вероятностей

каждого из этих событий на соответствующую

условную вероятность события А).

82.

Доказательство.А=АН1 + АН2 + … + АНn ,

причём, события АНi попарно несовместны. Тогда

Р(А) = P(АН1 + АН2 + … + АНn )=Р(АН1 )+Р(АН2 )+

… + Р(АНn) = Р(Н1) Р(А/Н1) + Р(Н2) Р(А/Н2)+ … +

Р(Нn) Р(А/Нn)

Замечание. События Нi называются гипотезами,

разбивающими событие А на частные случаи.

83.

Пример 1. В трёх одинаковых урнах находятсябелые и чёрные шары: в первой урне 1 ч, 2 б, во

второй – 1 ч, 3 б, в третьей – 2 ч, 2 б. Наудачу

выбирается урна, а из нее – один шар. Найти

вероятность того, что вынутый шар белый.

Решение.

А = {появление белого шара при однократном

вынимании}, Нi = {выбрана i – ая урна}

Р(А) =

=Р(Н1)·Р(А/Н1) + Р(Н2)·Р(А/Н2)+ Р(Н3)·Р(А/Н3)=

=1/3·2/3+1/3·3/4+1/3·1/2=23/36.

84.

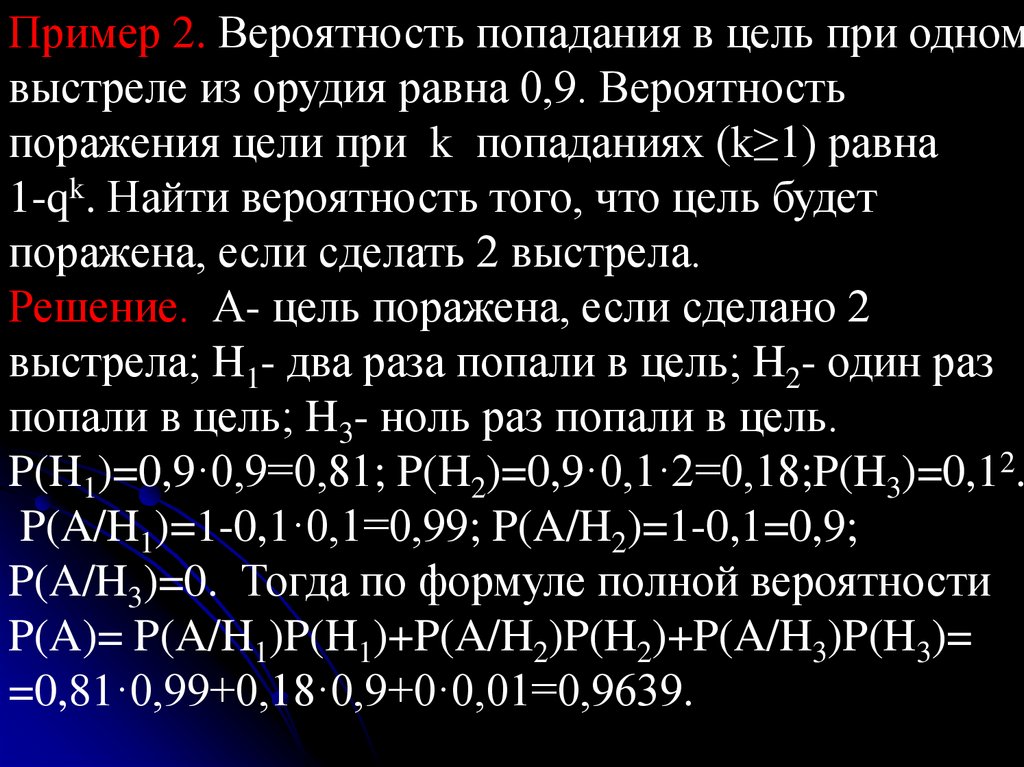

Пример 2. Вероятность попадания в цель при одномвыстреле из орудия равна 0,9. Вероятность

поражения цели при k попаданиях (k≥1) равна

1-qk. Найти вероятность того, что цель будет

поражена, если сделать 2 выстрела.

Решение. А- цель поражена, если сделано 2

выстрела; H1- два раза попали в цель; H2- один раз

попали в цель; H3- ноль раз попали в цель.

P(H1)=0,9·0,9=0,81; P(H2)=0,9·0,1·2=0,18;P(H3)=0,12.

P(A/H1)=1-0,1·0,1=0,99; P(A/H2)=1-0,1=0,9;

P(A/H3)=0. Тогда по формуле полной вероятности

P(A)= P(A/H1)P(H1)+P(A/H2)P(H2)+P(A/H3)P(H3)=

=0,81·0,99+0,18·0,9+0·0,01=0,9639.

85.

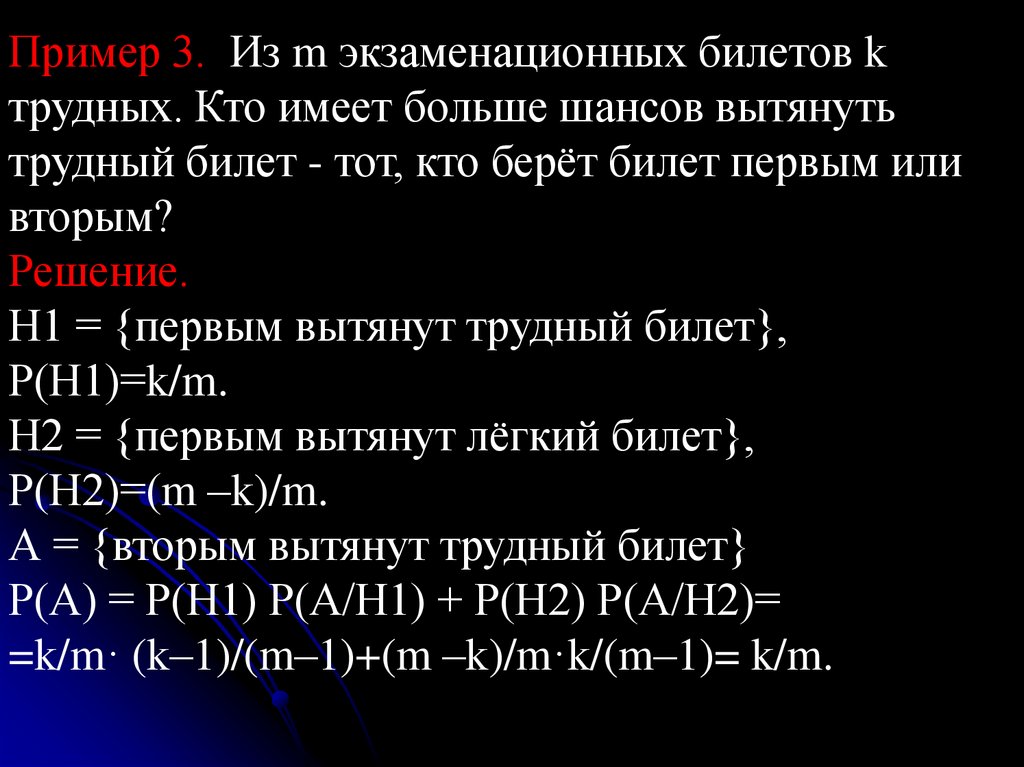

Пример 3. Из m экзаменационных билетов kтрудных. Кто имеет больше шансов вытянуть

трудный билет - тот, кто берёт билет первым или

вторым?

Решение.

Н1 = {первым вытянут трудный билет},

Р(Н1)=k/m.

Н2 = {первым вытянут лёгкий билет},

Р(Н2)=(m –k)/m.

А = {вторым вытянут трудный билет}

Р(А) = Р(Н1) Р(А/Н1) + Р(Н2) Р(А/Н2)=

=k/m· (k–1)/(m–1)+(m –k)/m·k/(m–1)= k/m.

86.

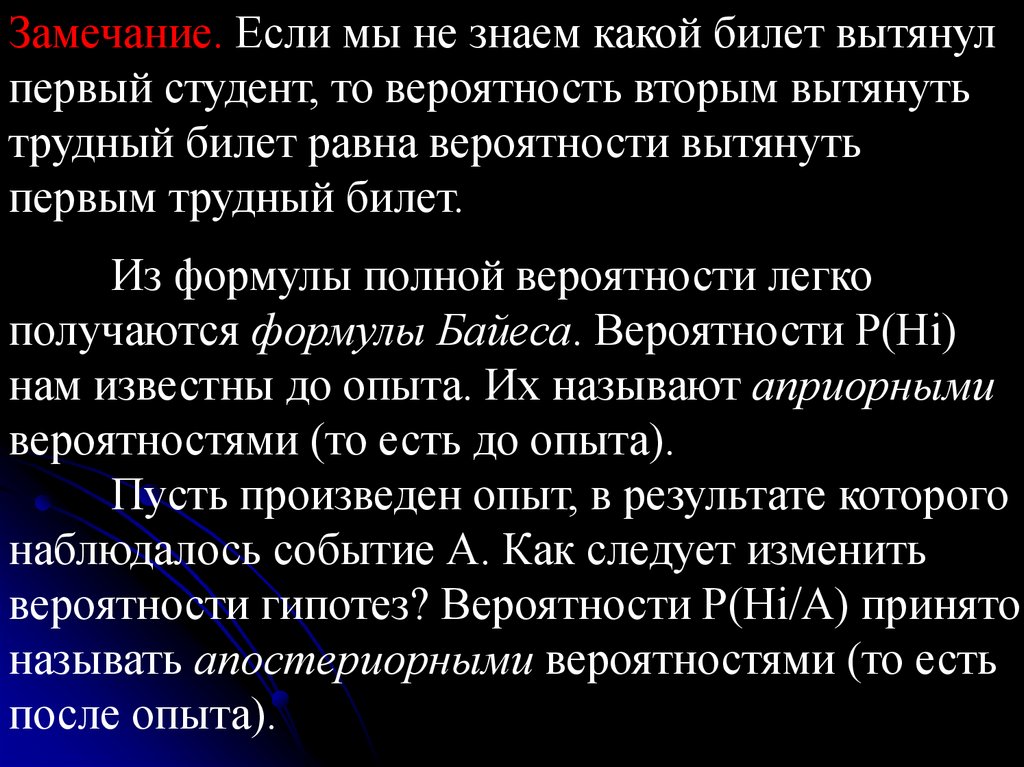

Замечание. Если мы не знаем какой билет вытянулпервый студент, то вероятность вторым вытянуть

трудный билет равна вероятности вытянуть

первым трудный билет.

Из формулы полной вероятности легко

получаются формулы Байеса. Вероятности Р(Нi)

нам известны до опыта. Их называют априорными

вероятностями (то есть до опыта).

Пусть произведен опыт, в результате которого

наблюдалось событие А. Как следует изменить

вероятности гипотез? Вероятности Р(Нi/А) принято

называть апостериорными вероятностями (то есть

после опыта).

87.

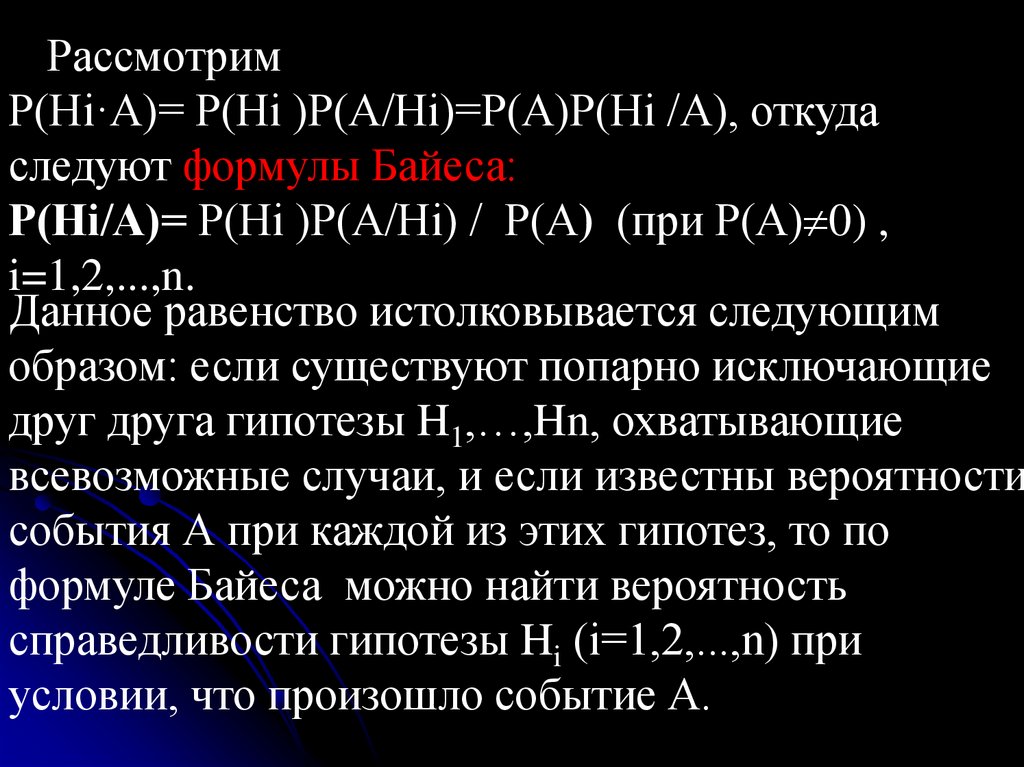

РассмотримР(Нi·А)= Р(Нi )Р(А/Нi)=Р(А)Р(Нi /А), откуда

следуют формулы Байеса:

Р(Нi/А)= Р(Нi )Р(А/Нi) / Р(А) (при Р(А) 0) ,

i=1,2,...,n.

Данное равенство истолковывается следующим

образом: если существуют попарно исключающие

друг друга гипотезы H1,…,Hn, охватывающие

всевозможные случаи, и если известны вероятности

события А при каждой из этих гипотез, то по

формуле Байеса можно найти вероятность

справедливости гипотезы Hi (i=1,2,...,n) при

условии, что произошло событие А.

88.

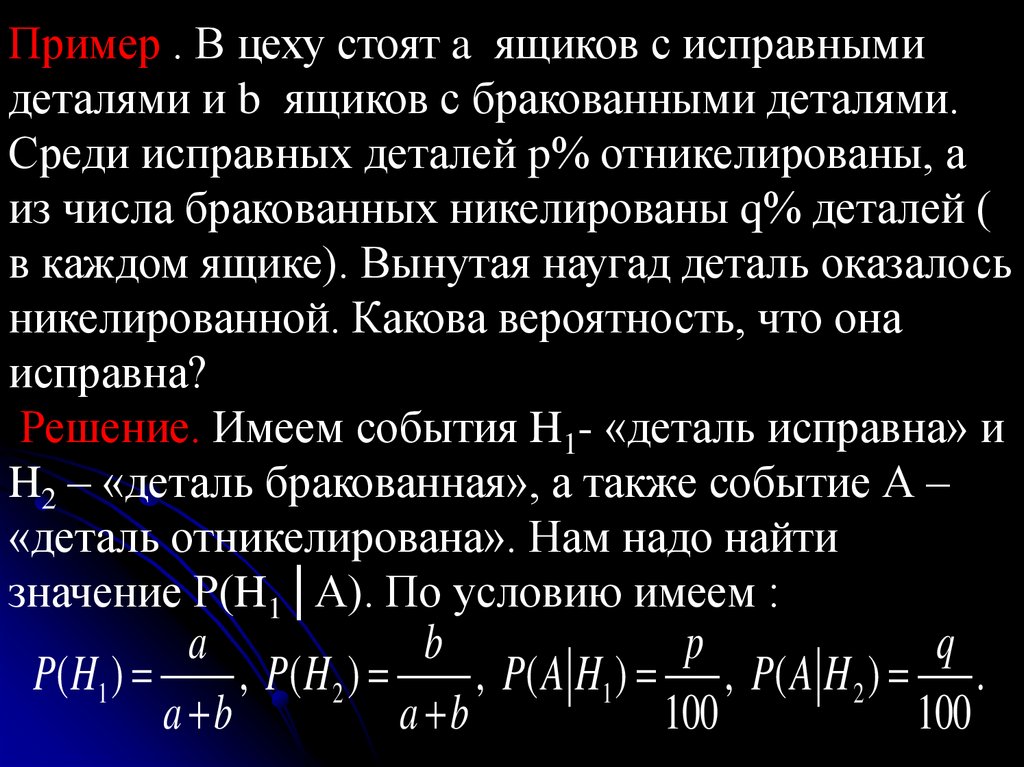

Пример . В цеху стоят a ящиков с исправнымидеталями и b ящиков с бракованными деталями.

Среди исправных деталей p% отникелированы, а

из числа бракованных никелированы q% деталей (

в каждом ящике). Вынутая наугад деталь оказалось

никелированной. Какова вероятность, что она

исправна?

Решение. Имеем события H1- «деталь исправна» и

H2 – «деталь бракованная», а также событие А –

«деталь отникелирована». Нам надо найти

значение Р(H1│А). По условию имеем :

a

b

p

q

P ( H1 )

, P( H 2 )

, P ( A H1 ) , P ( A H 2 ) .

a b

a b

100

100

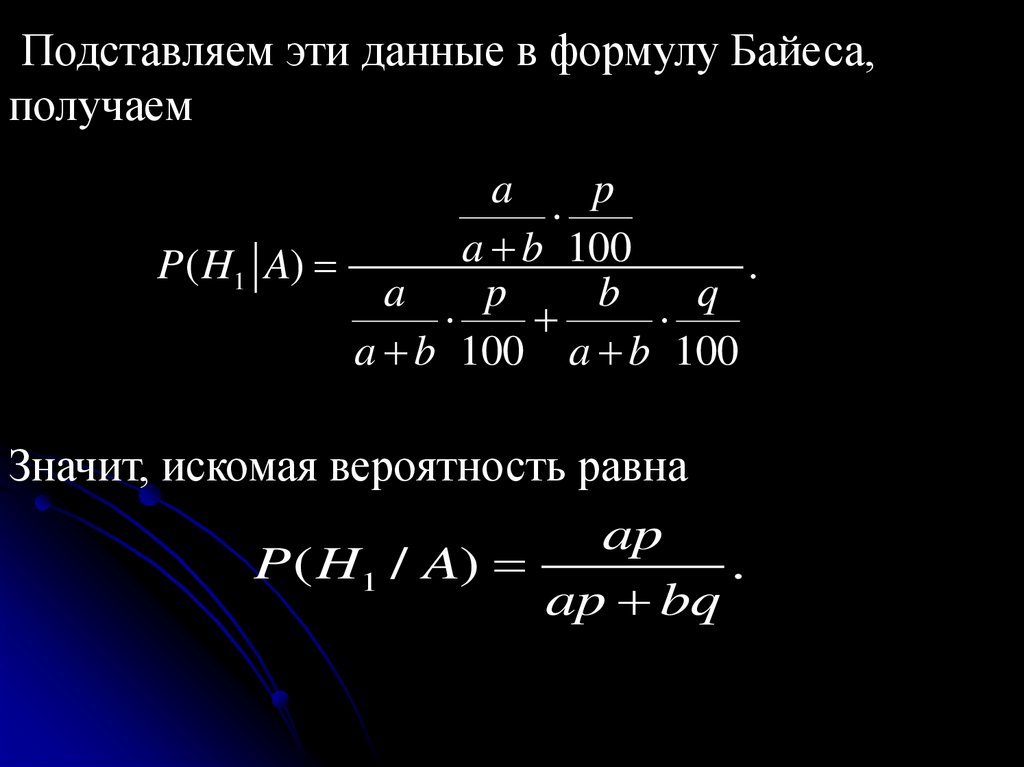

89.

Подставляем эти данные в формулу Байеса,получаем

a

p

a b 100

P( H1 A)

.

a

p

b

q

a b 100 a b 100

Значит, искомая вероятность равна

ap

P( H1 / A)

.

ap bq

90.

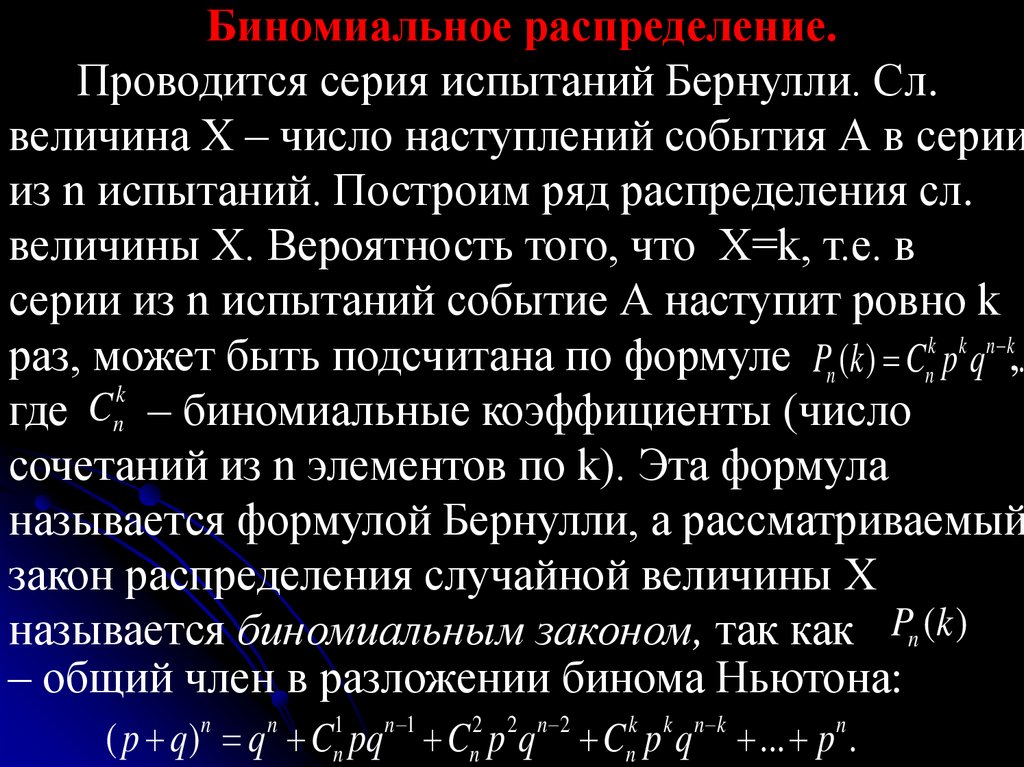

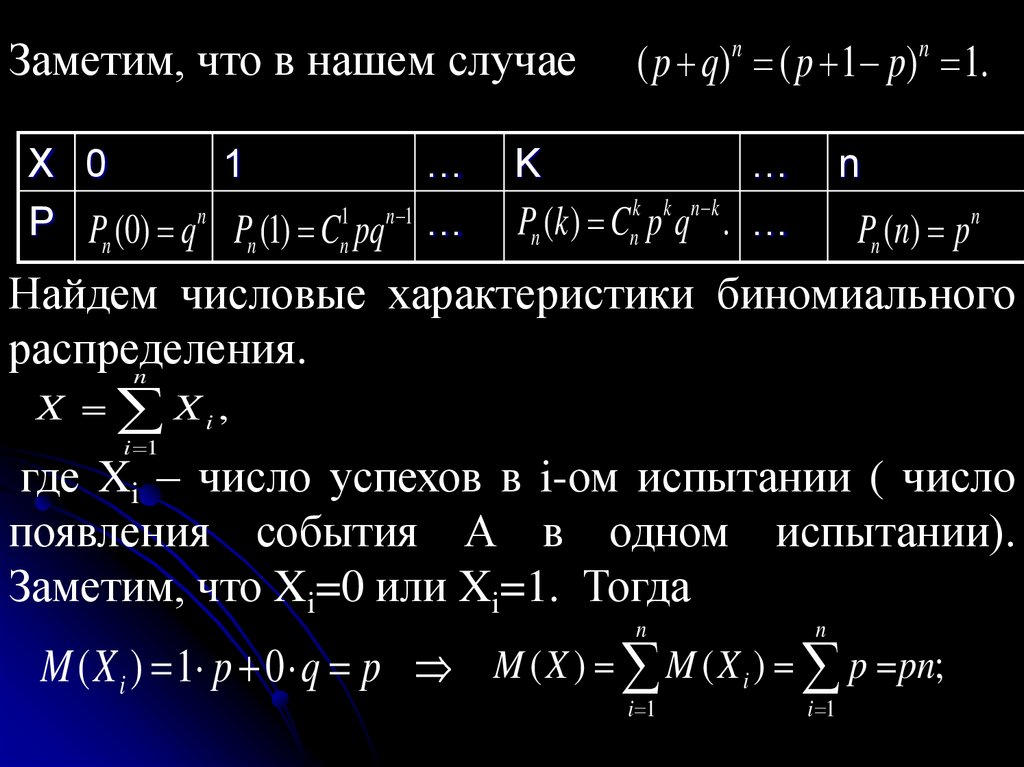

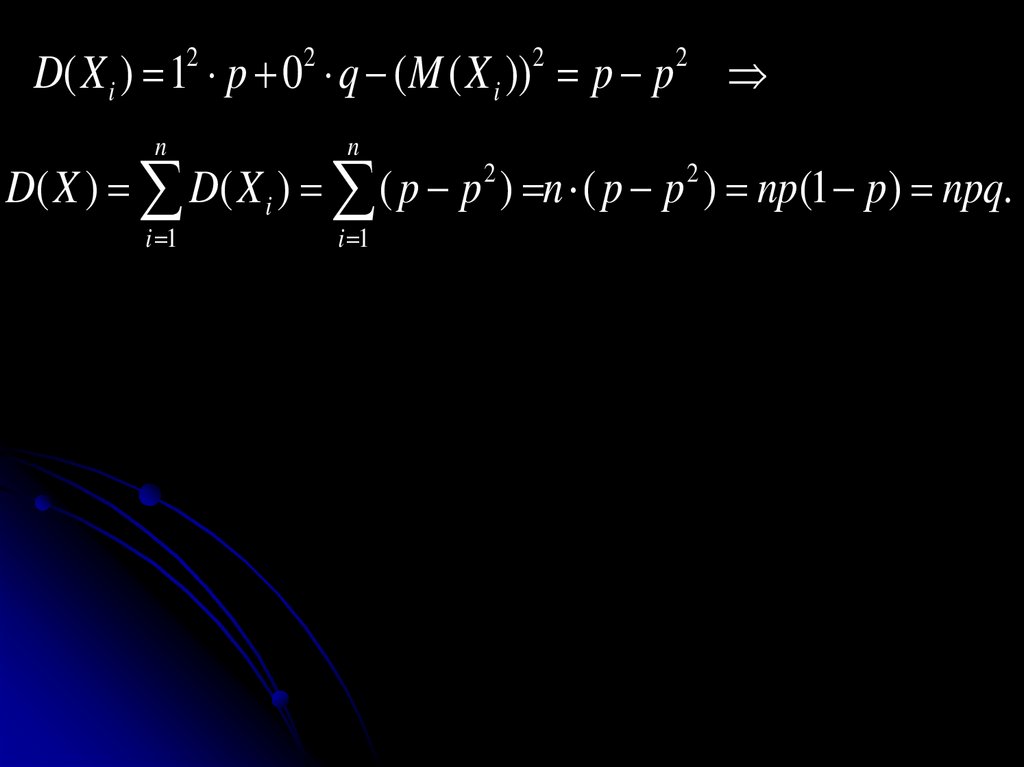

1.6. Формула Бернулли. Закон больших чисел.При введении понятия вероятности

отмечалось, что если вероятность некоторого

события А равна р, то вероятнее всего, что при

повторении испытания много раз относительная

частота благоприятных этому событию исходов

будет мало отличаться от значения р. Это

утверждение, называемое в теории вероятностей

законом больших чисел, лежит в основе всех

практических приложений этой теории – оно

позволяет с помощью вычисленных вероятностей

предсказывать частоту наступления данного

события в длинной серии независимых испытаний.

91.

Пусть производится n независимых испытаний, вкаждом из которых событие А может появиться

либо не появиться. Вероятность появления

события А в каждом испытании одна и та же и

равна p. Тогда вероятность ненаступления события

А в каждом испытании также постоянна и равна

q=1-p. Требуется найти вероятность того, что при n

испытаниях событие А появится ровно m раз и ,

следовательно, не произойдет событие А n-m раз.

Причем, не требуется, чтобы событие А

повторилось ровно m раз в определенном порядке.

92.

Выведем формулу Бернулли, позволяющуювычислить вероятность того, что в серии из n

независимых испытаний событие А , имеющее

вероятность р, встретиться m раз. Результат серии

из n испытаний можно записать в виде ряда из

букв А и Ā, имеющего длину n. Например, если

проведено семь испытаний, причем событие А

произошло во втором , третьем и пятом

испытаниях, то запишем результат данной серии в

виде ĀААĀАĀĀ.

93.

Так как испытания данной серии независимы другот друга, то для вычисления вероятности данного

исхода испытаний надо заменить в записи этой

серии каждую букву А ее вероятностью p , а

каждую букву Ā ее вероятностью 1-p и

перемножить эти числа.

Пример 1. Проводится серия из 8 независимых

испытаний. Событие А имеет вероятность р=0,7.

Чему равна вероятность того, что получиться

исход вида ААĀАAĀAĀ. ?

Решение. Заменяем каждую букву А на 0,7, а

каждую букву Ā на 1-0,7=0,3. Получаем

0,7×0,7×0,3×0,7×0,7×0,3×0,7×0,3=0,750,33.

À

0,7 5 0,33

94.

Вообще, если событие А имеет вероятность р, товероятность появления конкретной серии из n

испытаний, в которой это событие произошло m

раз, равна pmqn-m, где q=1-p

Теорема. Пусть вероятность события А равна р, и

пусть P n (m)- это вероятность того, что в серии из

n независимых испытаний это событие произойдет

ровно m раз. Тогда справедлива теорема Бернулли

n m

Pn (m) Cn p q .

Доказательство. Вероятность одного события,

состоящего в том, что в n испытаниях событие А

наступит ровно m раз и не наступит n-m раз, по

теореме умножения вероятностей равна pmqn-m.

m

m

95.

Число таких событий равно числу сочетаний из nm

элементов по m элементов, то есть Cn . Так как

события несовместные, то по теореме сложения

вероятностей несовместных событий искомая

вероятность равна сумме вероятностей всех

возможных событий:

Pn (m) Cn p q

m

m

n m

.

96.

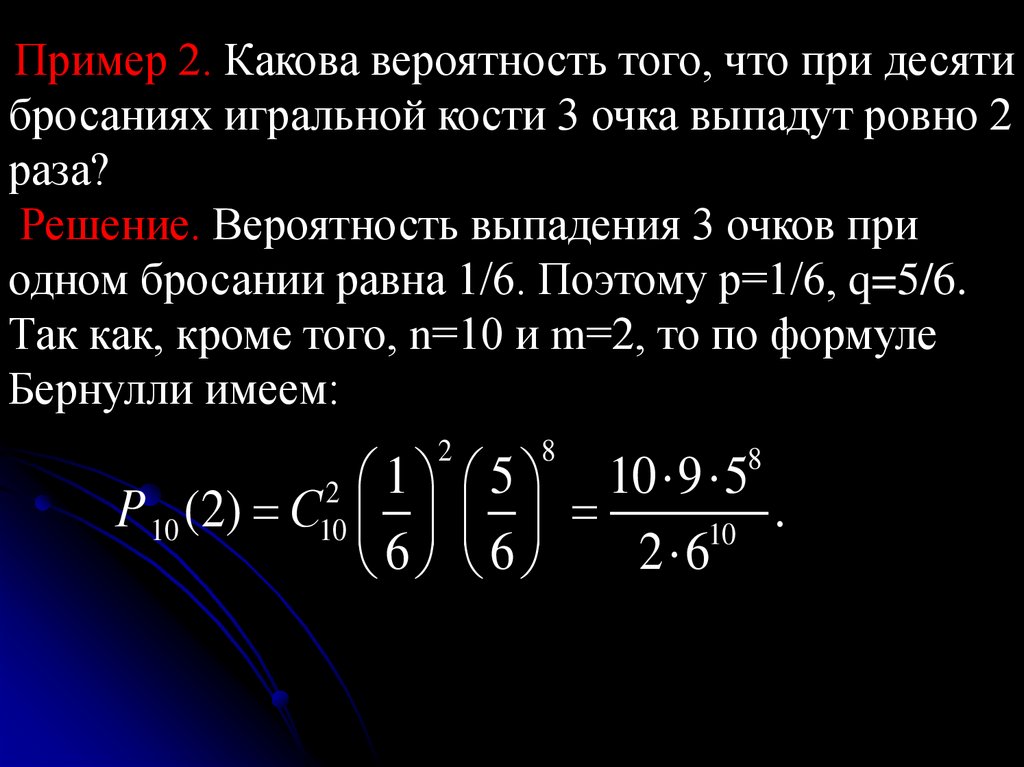

Пример 2. Какова вероятность того, что при десятибросаниях игральной кости 3 очка выпадут ровно 2

раза?

Решение. Вероятность выпадения 3 очков при

одном бросании равна 1/6. Поэтому р=1/6, q=5/6.

Так как, кроме того, n=10 и m=2, то по формуле

Бернулли имеем:

1 5 10 9 5

Р 10 (2) С

.

10

2 6

6 6

2

2

10

8

8

97.

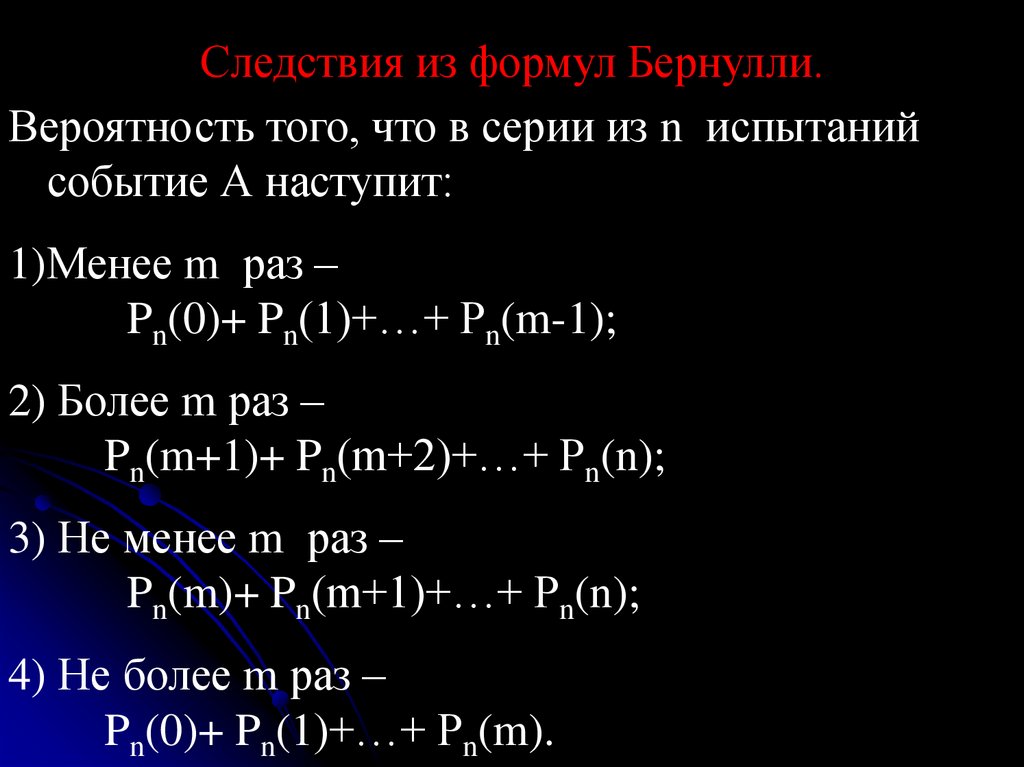

Следствия из формул Бернулли.Вероятность того, что в серии из n испытаний

событие А наступит:

1)Менее m раз –

Pn(0)+ Pn(1)+…+ Pn(m-1);

2) Более m раз –

Pn(m+1)+ Pn(m+2)+…+ Pn(n);

3) Не менее m раз –

Pn(m)+ Pn(m+1)+…+ Pn(n);

4) Не более m раз –

Pn(0)+ Pn(1)+…+ Pn(m).

98.

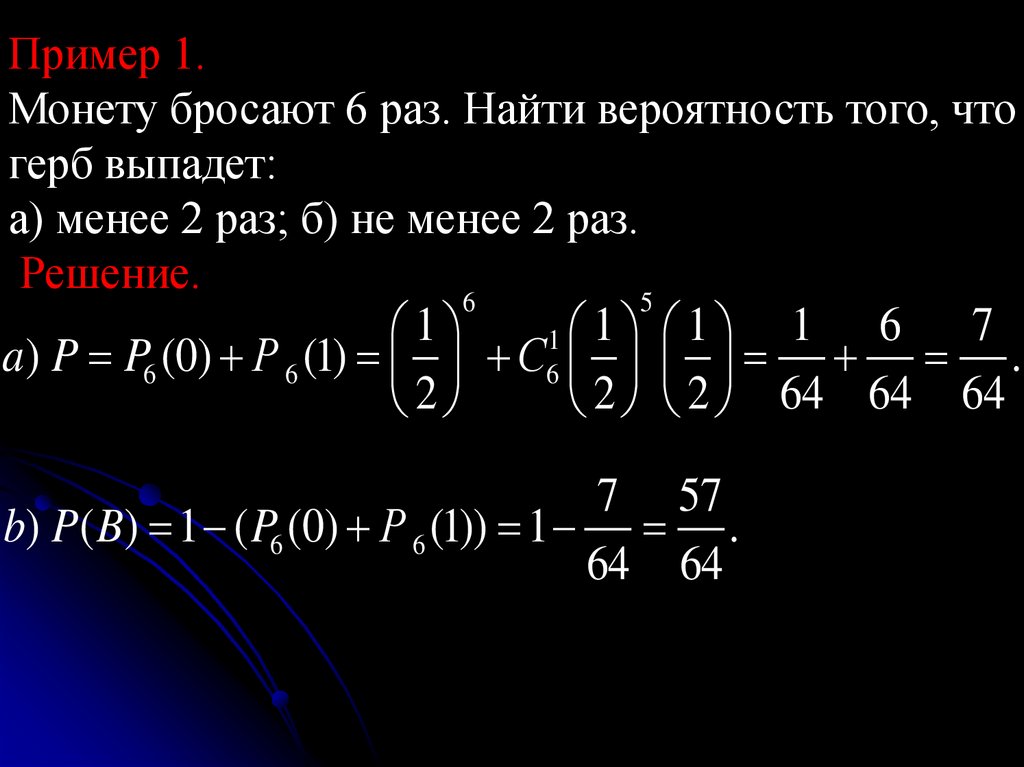

Пример 1.Монету бросают 6 раз. Найти вероятность того, что

герб выпадет:

а) менее 2 раз; б) не менее 2 раз.

Решение.

6

5

1 6 7

1

1 1 1

a) P P6 (0) Р 6 (1) С6 .

2

2 2 64 64 64

7 57

b) P( B) 1 ( P6 (0) Р 6 (1)) 1 .

64 64

99.

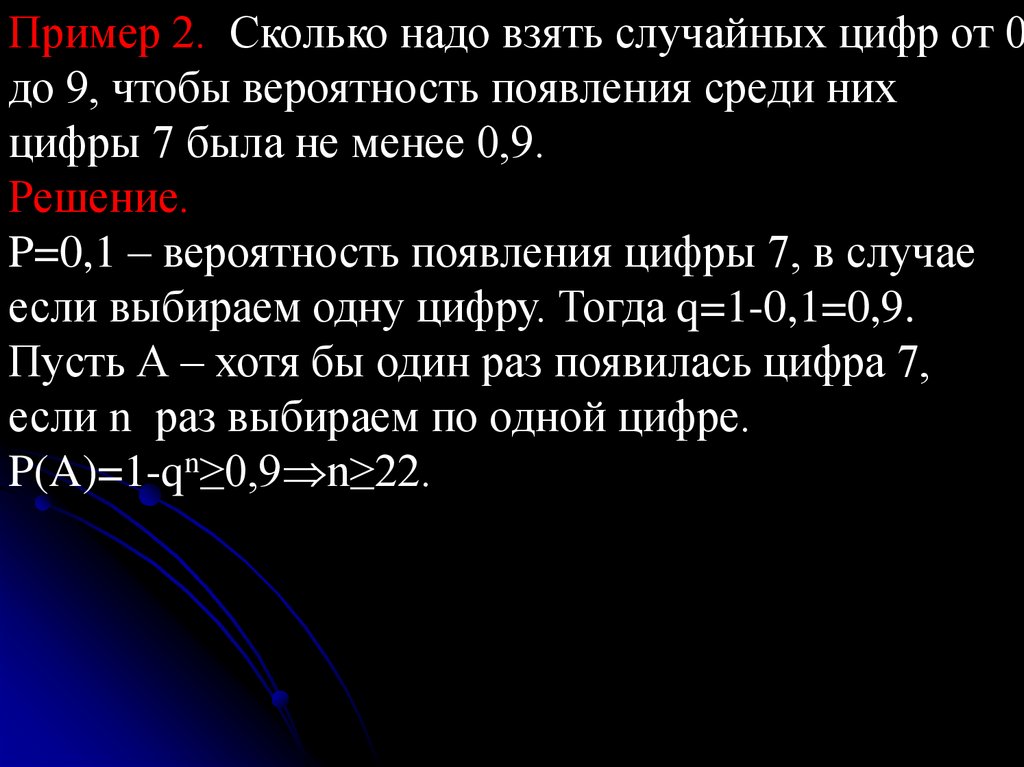

Пример 2. Сколько надо взять случайных цифр от 0до 9, чтобы вероятность появления среди них

цифры 7 была не менее 0,9.

Решение.

P=0,1 – вероятность появления цифры 7, в случае

если выбираем одну цифру. Тогда q=1-0,1=0,9.

Пусть А – хотя бы один раз появилась цифра 7,

если n раз выбираем по одной цифре.

P(A)=1-qn≥0,9 n≥22.

100.

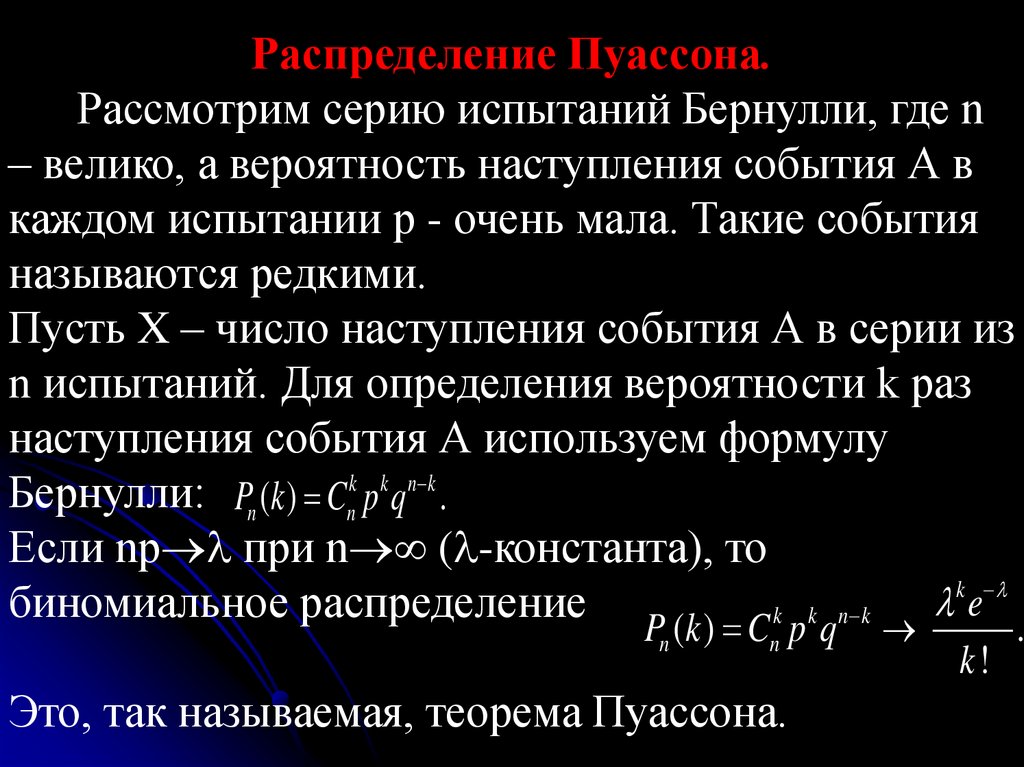

Формулы для приближенного вычислениявероятностей при испытаниях Бернулли.

Вычисления по формуле Бернулли при больших m

и n затруднительны. В математике установлены

приближенные формулы, позволяющие находить

приближенные значения для Pn(m) и, что еще

важнее для практики, суммы значений Pn(m) ,

таких, что дробь m/n (относительная частота

появления события А ) лежит в данных границах.

По формуле Бернулли вероятность того, что в

серии из 100 подбрасываний монеты все 100 раз

выпадет герб, равна (1/2)100. Не столь мала, но все

же так же ничтожна вероятность и того, что цифра

выпадет не более 10 раз.

101.

Наиболее вероятно, что число выпадений гербабудет мало отличаться от 50.

Вообще, при большом числе испытаний

относительная частота появления события, как

правило мало отличается от вероятности этого

события. Математическую формулировку этого

утверждения дает принадлежащий Я.Бернулли

закон больших чисел, который в уточненной

редакции П.Л.Чебышевым форме гласит:

102.

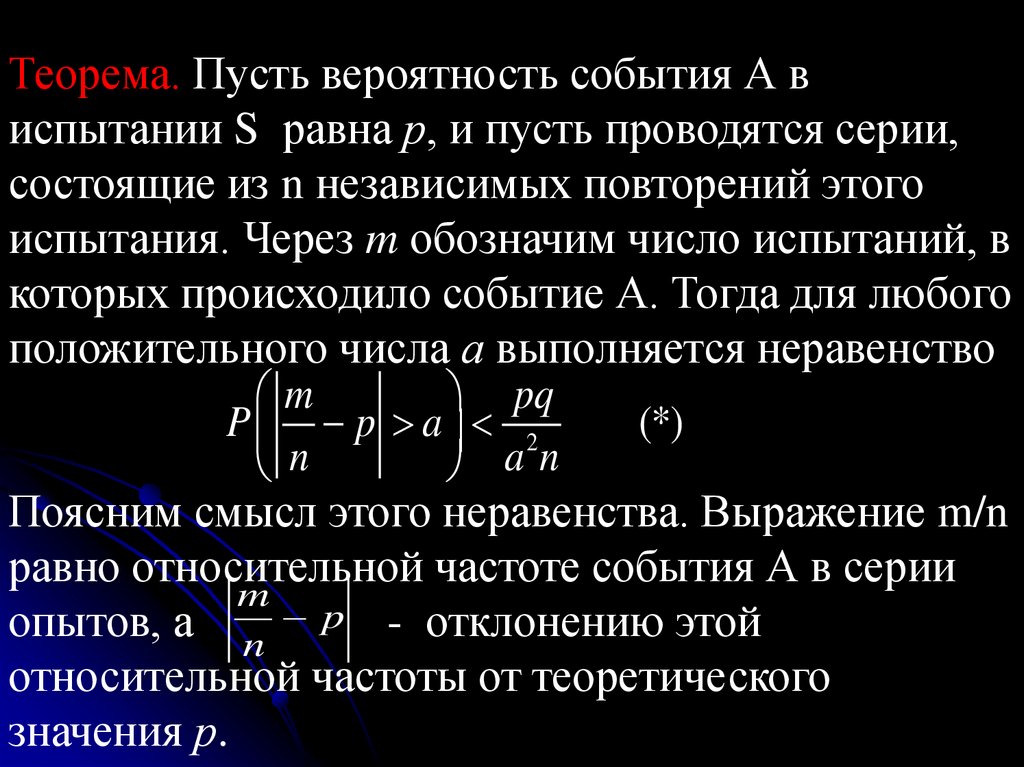

Теорема. Пусть вероятность события А виспытании S равна р, и пусть проводятся серии,

состоящие из n независимых повторений этого

испытания. Через m обозначим число испытаний, в

которых происходило событие А. Тогда для любого

положительного числа а выполняется неравенство

m

pq

P p a 2

(*)

n

an

Поясним смысл этого неравенства. Выражение m/n

равно относительной частоте события А в серии

m

опытов, а n p - отклонению этой

относительной частоты от теоретического

значения р.

103.

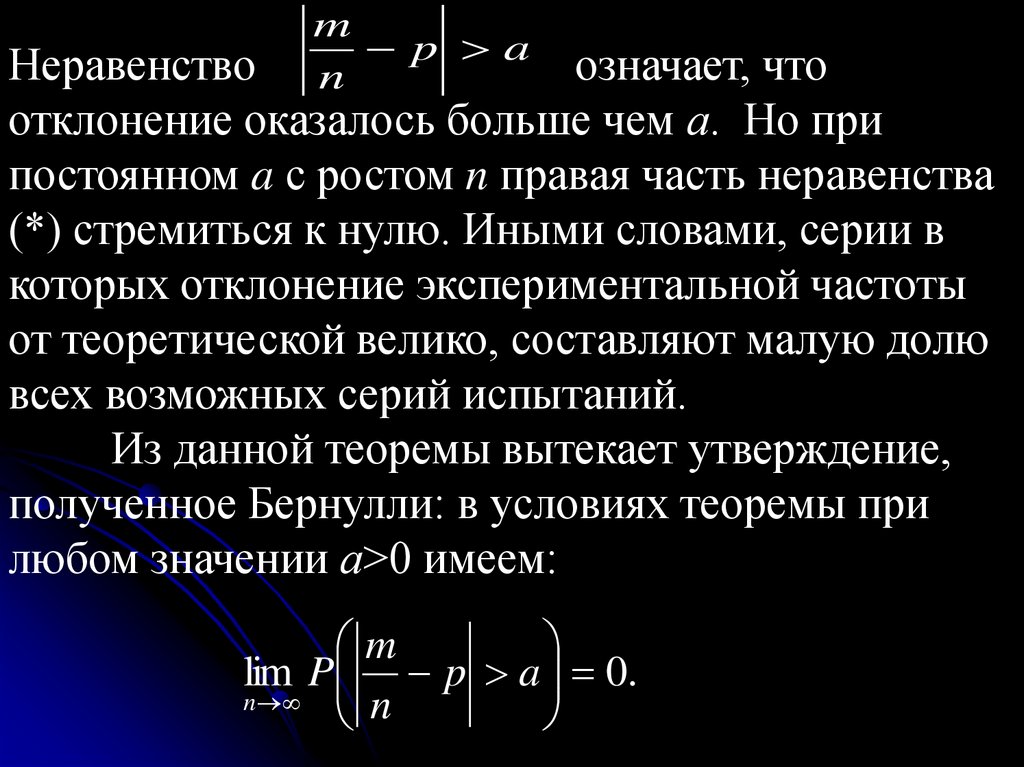

mp a

n

Неравенство

означает, что

отклонение оказалось больше чем а. Но при

постоянном a с ростом n правая часть неравенства

(*) стремиться к нулю. Иными словами, серии в

которых отклонение экспериментальной частоты

от теоретической велико, составляют малую долю

всех возможных серий испытаний.

Из данной теоремы вытекает утверждение,

полученное Бернулли: в условиях теоремы при

любом значении а>0 имеем:

m

lim P p a 0.

n

n

104.

Для доказательства достаточно заметить, чтоpq

lim 2 0.

n a n

Пример . Сколько достаточно провести опытов, что

бы из них получить вероятность события с

точностью до 0,1 и чтобы р≈m/n с этой точностью

и с вероятностью 0,9?

Для решения достаточно найти такое n, чтобы

было выполнено неравенство pq2 0,1.

0,1 n

А так как q=1-p, то pq=p(1-p)≤1/4 и потому

достаточно указать n, удовлетворяющее

1

неравенству

0,1 , отсюда n≥250 .

4 0,12 n

105.

Как видим, даже получение вероятности событияиз опыта с такой незначительной точностью

требует большого числа экспериментов. Правда,

более глубокие теоремы показывают, что можно

ограничиться и меньшим числом опытов.

106. Случайные величины и случайные векторы, их числовые характеристики. Основные предельные теоремы.

107.

2. Случайные величины, связанные сданным вероятностным пространством.

2.1. Понятие случайной величины.

Случайной называют величину, которая в

результате испытания примет одно и только одно

возможное значение, заранее неизвестное и

зависящее от случайных причин, которые заранее

не могут быть учтены.

108.

Пример 1. В урне 2 белых и 3 чёрных шара.Последовательно вынимаем 2 шара. Пусть Х –

число вынутых белых шаров. С этим опытом

связаны следующие элементарные события:

ω1={чб}, ω2={бч}, ω3={чч}, ω4={бб}

Очевидно, Х – функция от элементарного события:

Х(ω1)=1, Х(ω2)=1, Х(ω3)=0, Х(ω4)=2.

Исход опыта является случайным, поэтому Х –

случайная величина. Функция Х(ωi) – случайная

величина, определённая на множестве

элементарных событий

Ω = { ω1, ω2, ω3, ω4}

109.

Пример 2.Опыт состоит в определении времени безотказной

работы прибора. Известно, что прибор заведомо

откажет за время t [0,T]. Введём элементарные

события

ωt = {прибор проработал время t, а затем отказал}.

Пусть Х – случайный момент отказа прибора.

Х=Х(ωt) = t – функция от элементарного события,

определённая на множестве элементарных

событий Ω = { ωt : t [0,T]}.

110.

Определение. Случайной величиной называетсяфункция Х=Х(ω), определённая на множестве

элементарных событий Ω.

Будем обозначать случайные величины

буквами X, Y, Z , и т.п., а их возможные значения

соответствующими строчными буквами x, y, z.

Определение.

Дискретной называют случайную величину, которая

принимает отдельные, изолированные возможные

значения с определенными вероятностями.

Число возможных значений дискретной величины

может быть конечным или бесконечным (счётным).

111.

Определение. Непрерывной называют случайнуювеличину, которая может принимать все значения

из некоторого конечного или бесконечного

промежутка.

Число

возможных

значений

непрерывной случайной величины бесконечно.

112.

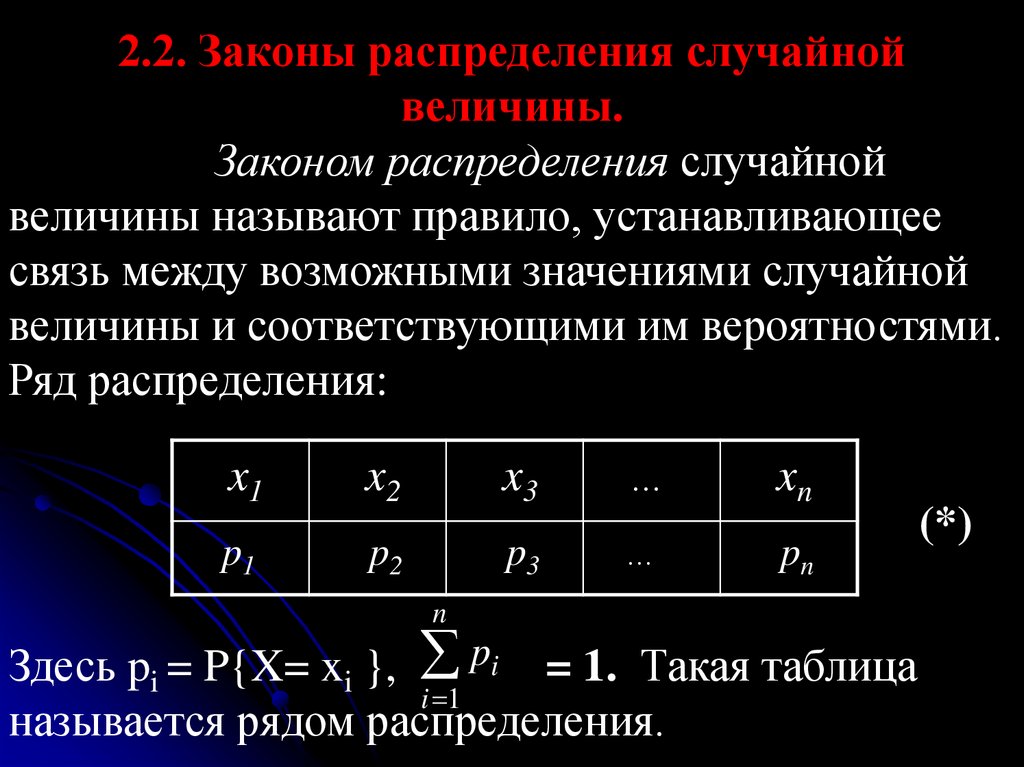

2.2. Законы распределения случайнойвеличины.

Законом распределения случайной

величины называют правило, устанавливающее

связь между возможными значениями случайной

величины и соответствующими им вероятностями.

Ряд распределения:

x1

x2

x3

…

p1

p2

p3

…

n

xn

pn

Здесь pi = P{X= xi }, pi = 1. Такая таблица

i 1

называется рядом распределения.

(*)

113.

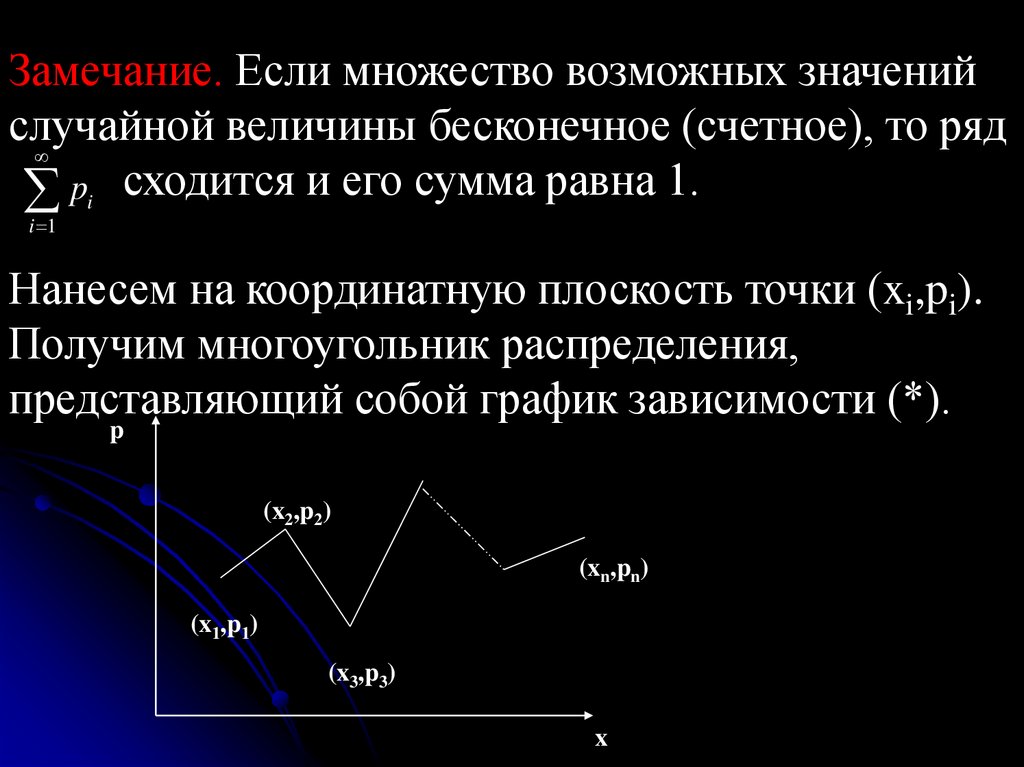

Замечание. Если множество возможных значенийслучайной величины бесконечное (счетное), то ряд

pi сходится и его сумма равна 1.

i 1

Нанесем на координатную плоскость точки (xi,pi).

Получим многоугольник распределения,

представляющий собой график зависимости (*).

p

(x2,p2)

(xn,pn)

(x1,p1)

(x3,p3)

x

114.

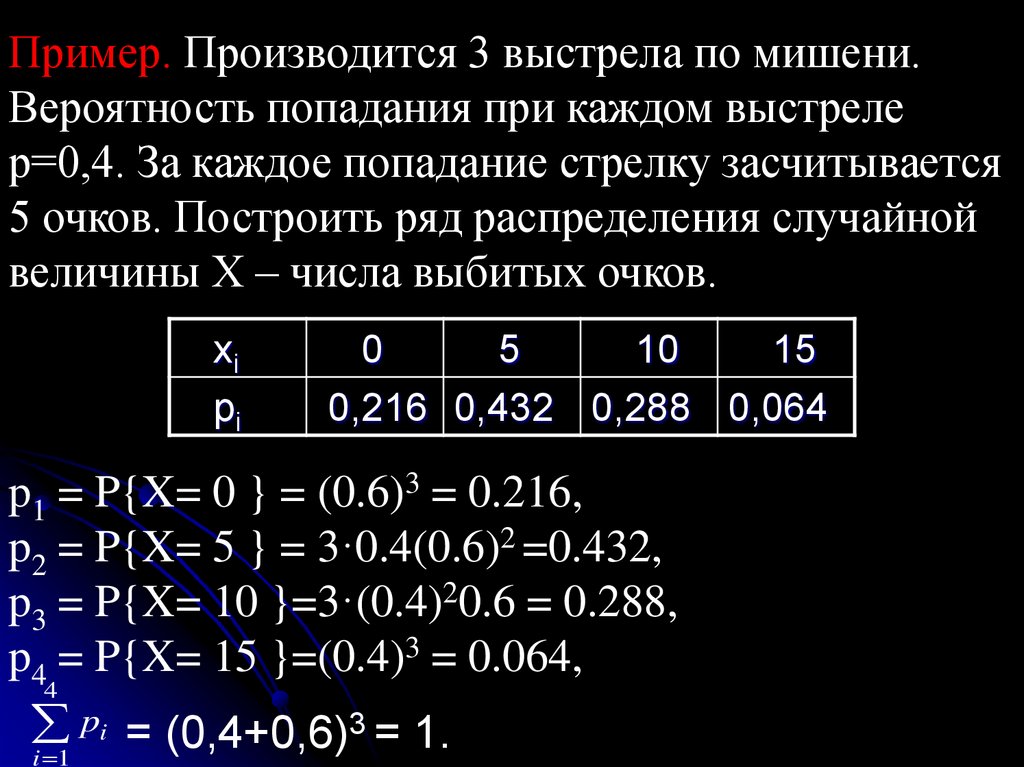

Пример. Производится 3 выстрела по мишени.Вероятность попадания при каждом выстреле

р=0,4. За каждое попадание стрелку засчитывается

5 очков. Построить ряд распределения случайной

величины Х – числа выбитых очков.

xi

pi

0

5

10

15

0,216 0,432 0,288 0,064

p1 = P{X= 0 } = (0.6)3 = 0.216,

p2 = P{X= 5 } = 3·0.4(0.6)2 =0.432,

p3 = P{X= 10 }=3·(0.4)20.6 = 0.288,

p4 = P{X= 15 }=(0.4)3 = 0.064,

4

pi = (0,4+0,6)3 = 1.

i 1

115.

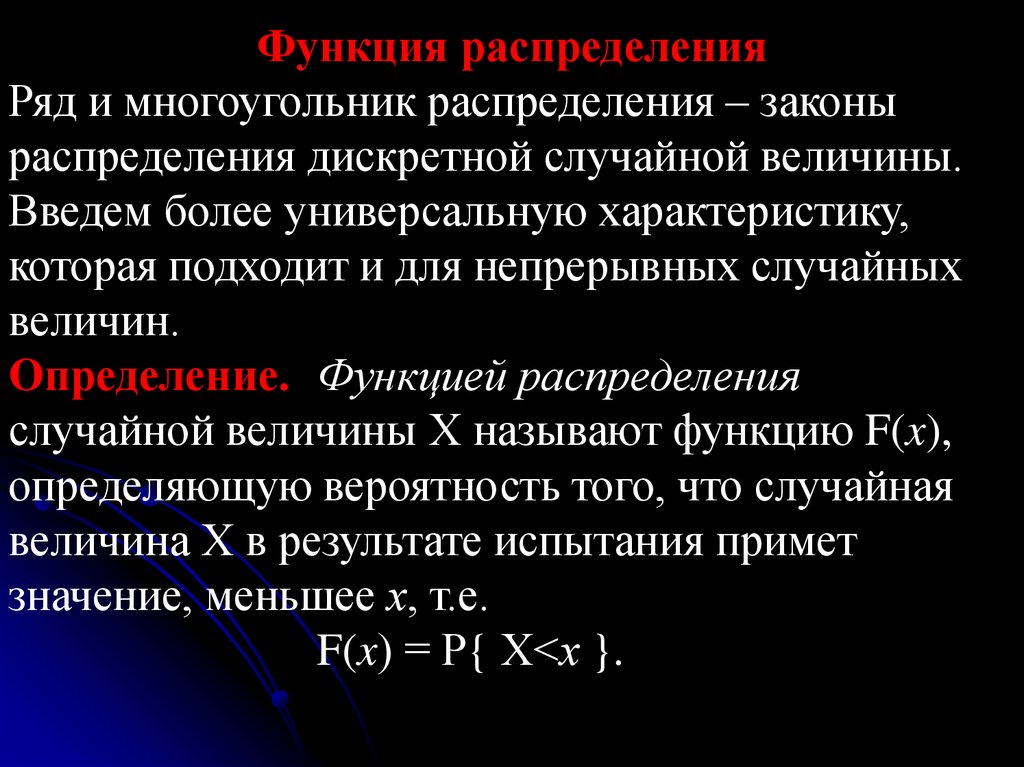

Функция распределенияРяд и многоугольник распределения – законы

распределения дискретной случайной величины.

Введем более универсальную характеристику,

которая подходит и для непрерывных случайных

величин.

Определение. Функцией распределения

случайной величины Х называют функцию F(x),

определяющую вероятность того, что случайная

величина Х в результате испытания примет

значение, меньшее х, т.е.

F(x) = Р{ Х<х }.

116.

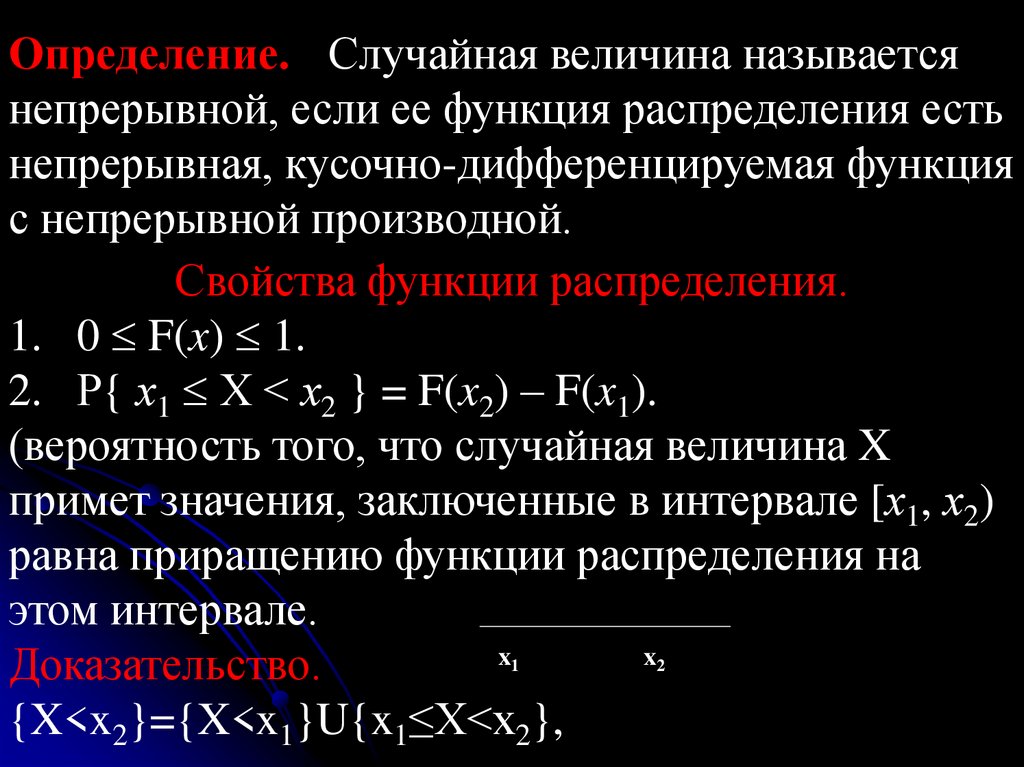

Определение. Случайная величина называетсянепрерывной, если ее функция распределения есть

непрерывная, кусочно-дифференцируемая функция

с непрерывной производной.

Свойства функции распределения.

1. 0 F(x) 1.

2. Р{ х1 Х < х2 } = F(x2) – F(x1).

(вероятность того, что случайная величина X

примет значения, заключенные в интервале [х1, х2)

равна приращению функции распределения на

этом интервале.

x

x

Доказательство.

{X<x2}={X<x1}U{x1≤X<x2},

1

2

117.

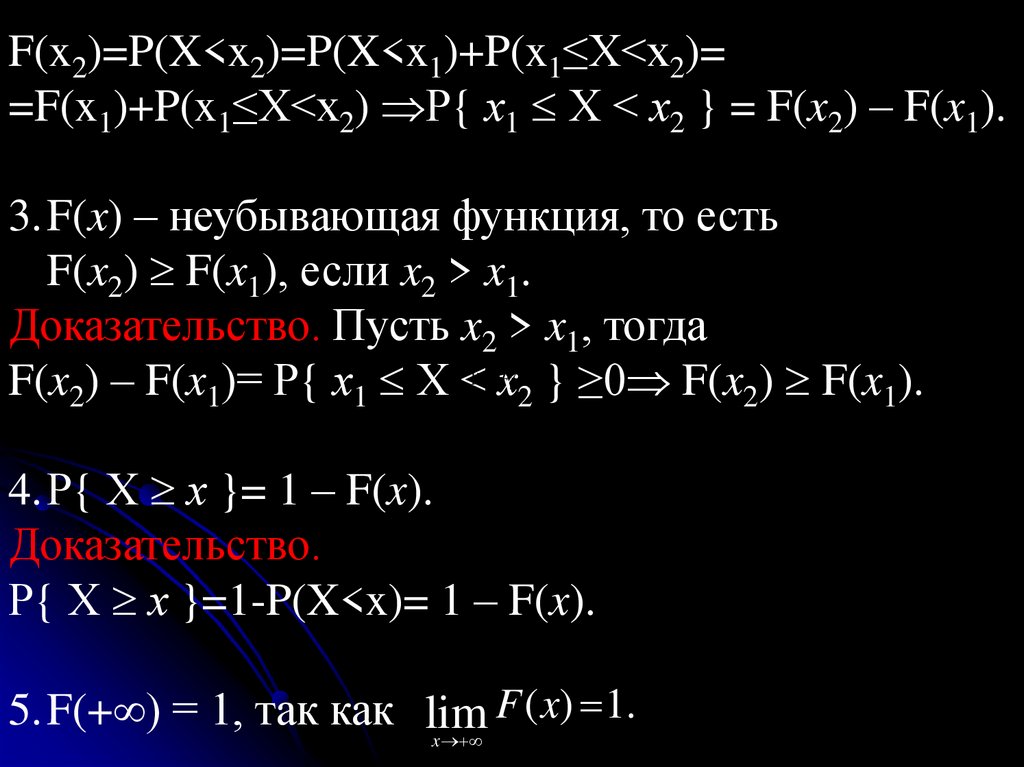

F(x2)=P(X<x2)=P(X<x1)+P(x1≤X<x2)==F(x1)+P(x1≤X<x2) Р{ х1 Х < х2 } = F(x2) – F(x1).

3.F(x) – неубывающая функция, то есть

F(x2) F(x1), если x2 > x1.

Доказательство. Пусть x2 > x1, тогда

F(x2) – F(x1)= Р{ х1 Х < х2 } ≥0 F(x2) F(x1).

lim Fl( x) 1

x

4.Р{ Х х }= 1 – F(x).

Доказательство.

Р{ Х х }=1-P(X<x)= 1 – F(x).

F ( x) 1.

5.F(+ ) = 1, так как lim

x

118.

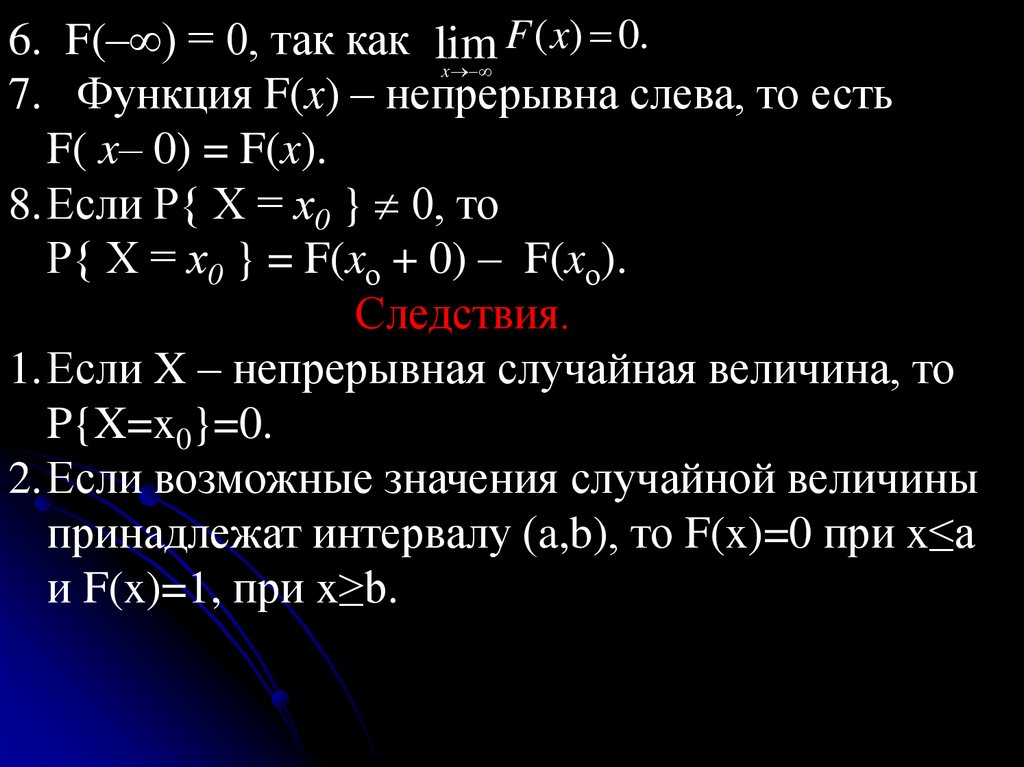

6. F(– ) = 0, так как lim F ( x) 0.x

7. Функция F(x) – непрерывна слева, то есть

F( x– 0) = F(x).

8.Если Р{ Х = х0 } 0, то

Р{ Х = х0 } = F(xо + 0) – F(xо).

Следствия.

1.Если X – непрерывная случайная величина, то

P{X=x0}=0.

2.Если возможные значения случайной величины

принадлежат интервалу (a,b), то F(x)=0 при x≤a

и F(x)=1, при x≥b.

119.

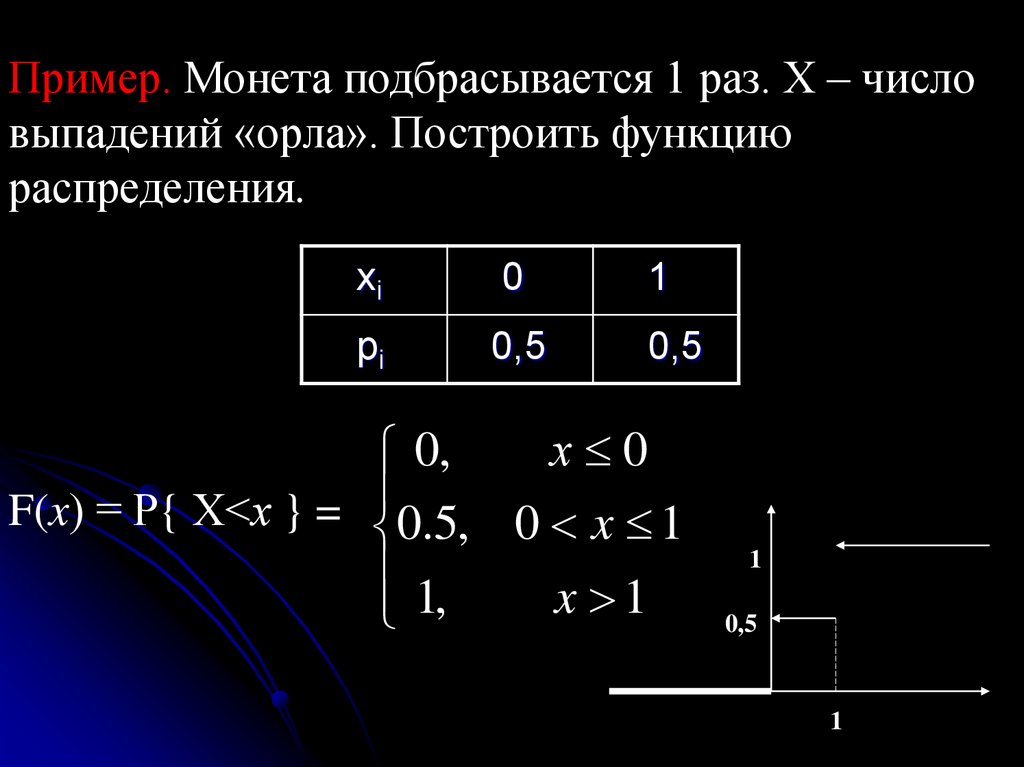

Пример. Монета подбрасывается 1 раз. Х – числовыпадений «орла». Построить функцию

распределения.

xi

0

1

pi

0,5

0,5

х 0

0,

F(x) = Р{ Х<х } =

0.5, 0 x 1

1,

x 1

1

0,5

1

120.

Замечания.1)График функции распределения случайной

величины расположен в полосе, ограниченной

прямыми y=0 и y=1.

2)График функции распределения дискретной

случайной величины имеет ступенчатый вид.

121.

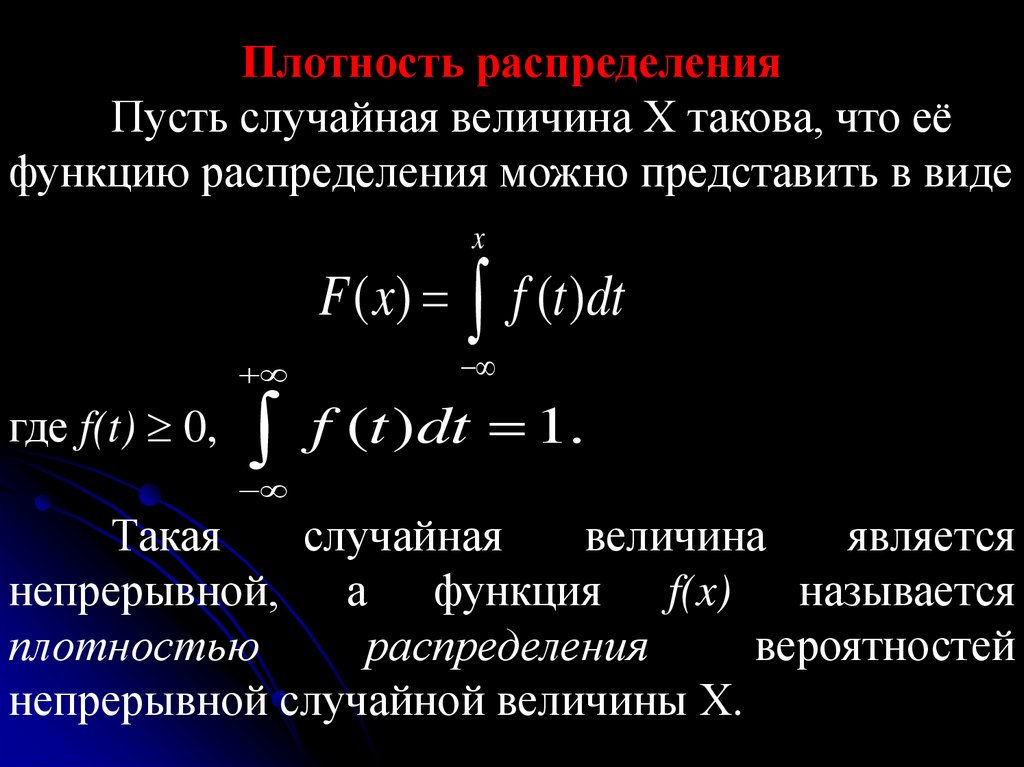

Плотность распределенияПусть случайная величина Х такова, что её

функцию распределения можно представить в виде

x

где f(t) 0,

F ( x) f (t )dt

f

(

t

)

dt

1.

Такая

случайная

величина

является

непрерывной, а функция f(x) называется

плотностью

распределения

вероятностей

непрерывной случайной величины Х.

122.

Если F(x) – дифференцируемая функция, тоf(x) = F’(x).

Замечание. Функция распределения определена и

для дискретных, и для непрерывных случайных

величин. Плотность распределения неприменима

для

описания

распределения

дискретных

f (t )dt

случайных величин.

х2

х1

.

123.

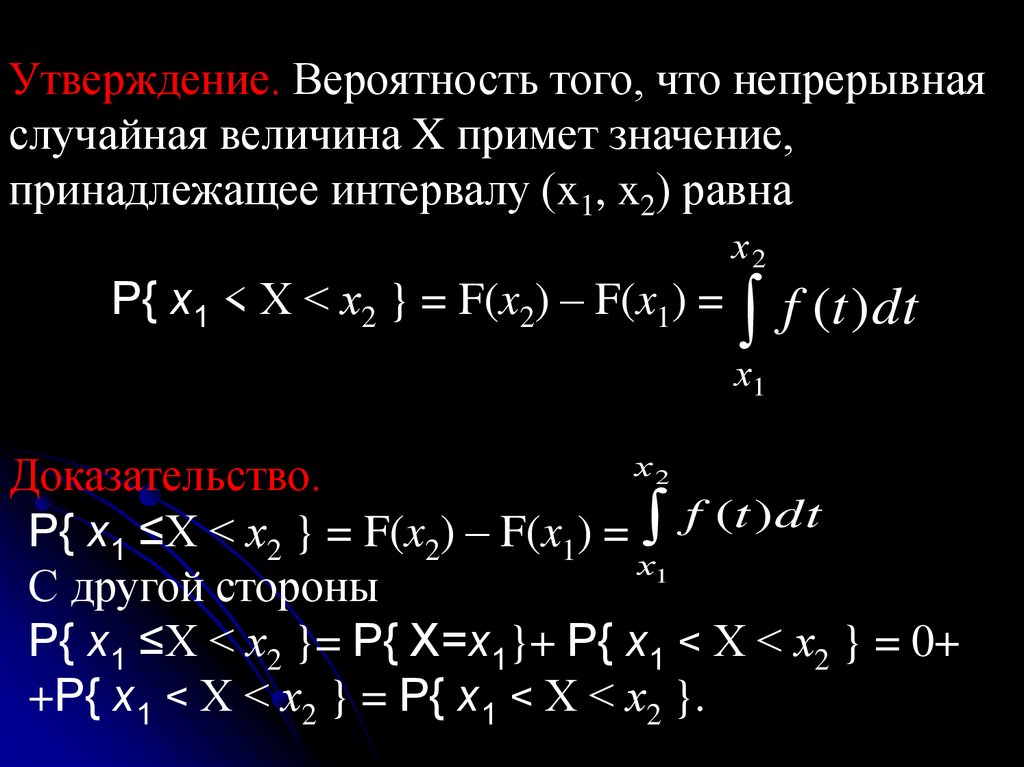

Утверждение. Вероятность того, что непрерывнаяслучайная величина X примет значение,

принадлежащее интервалу (x1, x2) равна

Р{ х1 < Х < х2 } = F(x2) – F(x1) =

х2

f (t )dt

х1

х2

Доказательство.

f (t )dt

f

(

t

)

dt

Р{ х1 ≤Х < х2 } = F(x2) – F(x1) =

х1

С другой стороны

Р{ х1 ≤Х < х2 }= Р{ X=х1}+ Р{ х1 < Х < х2 } = 0+

+Р{ х1 < Х < х2 } = Р{ х1 < Х < х2 }.

х2

х1

.

124.

Геометрический смысл: вероятность того, чтонепрерывная случайная величина принимает

значение, принадлежащее интервалу (x1, x2) равна

площади криволинейной трапеции, ограниченной

осью OX, кривой распределения f(x) и прямыми

y=x1 и y= x2.

125.

Вероятностный смысл плотности распределения.F ( x x) F ( x)

f ( x) lim

x 0

x

Разность F(x+ Δx) – F(x) определяет вероятность

того, что случайная величина X примет значение,

принадлежащее интервалу (x, x+Δx) . Тогда предел

отношения вероятности того, что непрерывная

случайная величина X примет значение,

принадлежащее интервалу (x, x+Δx), к длине этого

интервала, при условии, что длина данного

интервала стремится к нулю, равен значению

плотности распределения в точке x .

126.

2.3.Числовые характеристики случайныхвеличин.

2.3.1.Характеристика центра распределения

случайной величины – математическое

ожидание.

Определение и статистический смысл мат.

ожидания.

Закон

распределения

полностью

характеризует случайную величину. Однако часто

закон распределения неизвестен и приходится

ограничиваться меньшими сведениями.

127.

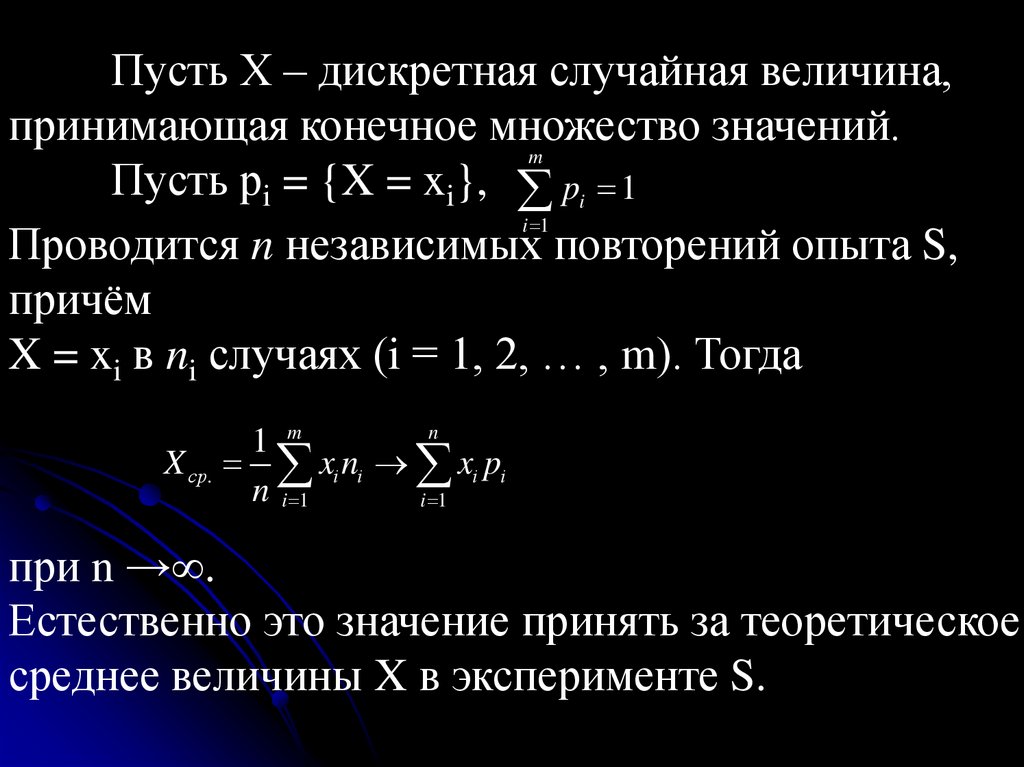

Пусть Х – дискретная случайная величина,принимающая конечное множество значений.

m

Пусть рi = {X = xi}, pi 1

i 1

Проводится n независимых повторений опыта S,

причём

X = xi в ni случаях (i = 1, 2, … , m). Тогда

n

1 m

X ср. xi ni xi pi

n i 1

i 1

при n → .

Естественно это значение принять за теоретическое

среднее величины X в эксперименте S.

128.

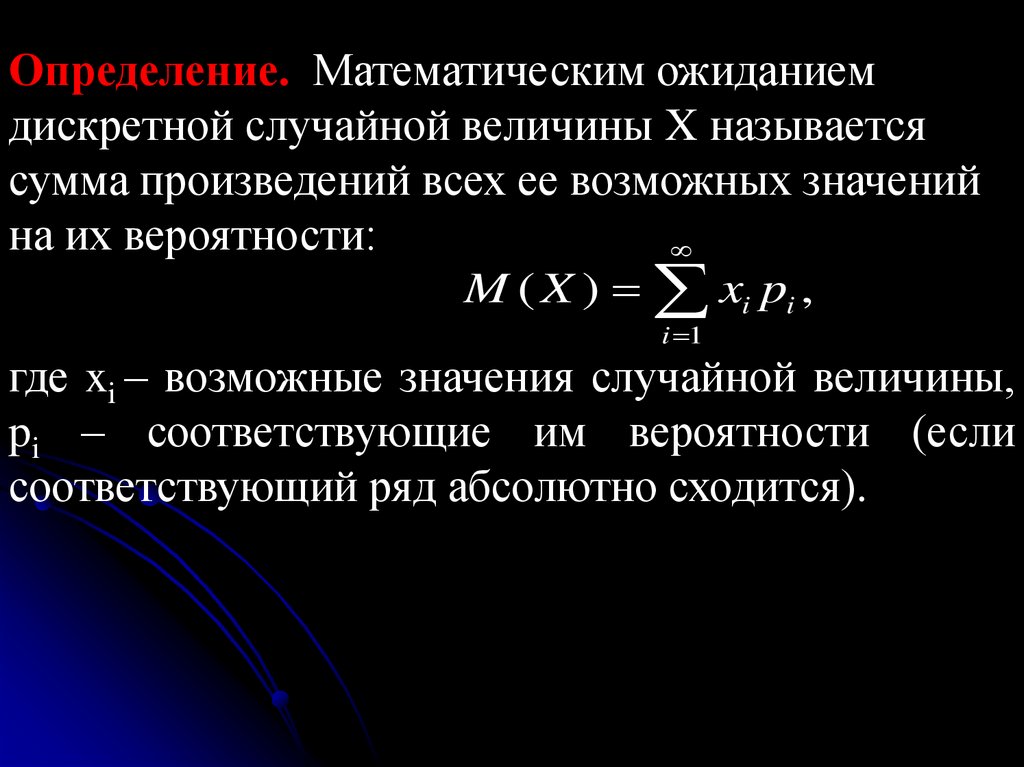

Определение. Математическим ожиданиемдискретной случайной величины X называется

сумма произведений всех ее возможных значений

на их вероятности:

M ( X ) xi pi ,

i 1

где xi – возможные значения случайной величины,

pi – соответствующие им вероятности (если

соответствующий ряд абсолютно сходится).

129.

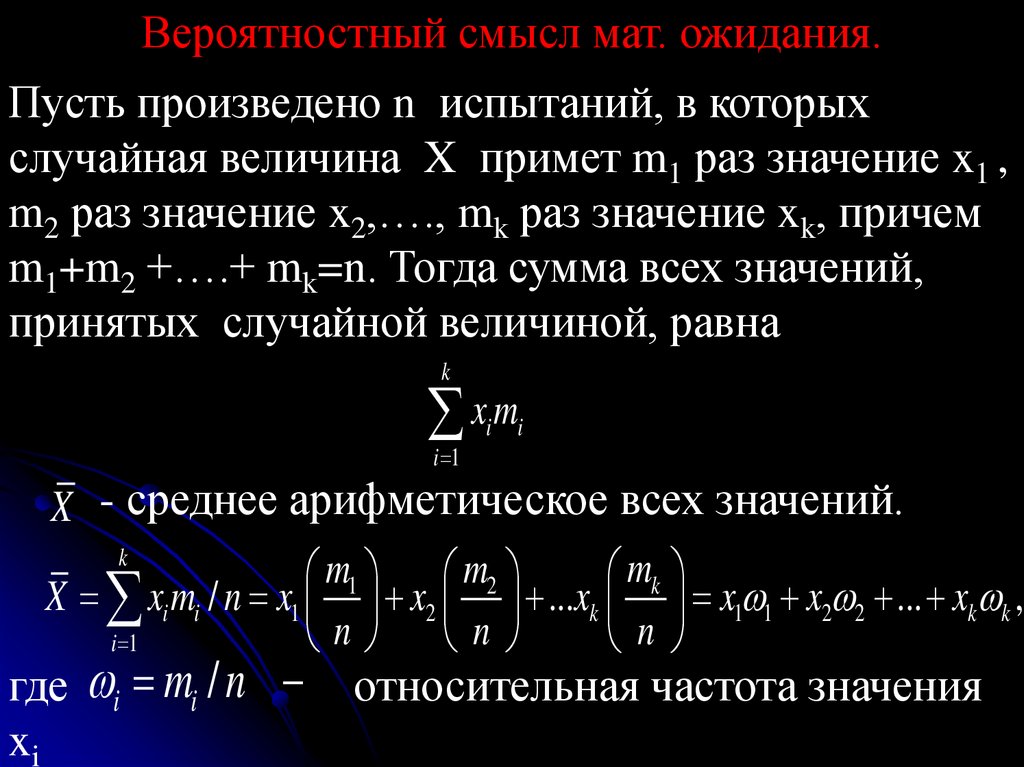

Вероятностный смысл мат. ожидания.Пусть произведено n испытаний, в которых

случайная величина X примет m1 раз значение x1 ,

m2 раз значение x2,…., mk раз значение xk, причем

m1+m2 +….+ mk=n. Тогда сумма всех значений,

принятых случайной величиной, равна

k

xm

i 1

i

i

X - среднее арифметическое всех значений.

k

mk

m1 m2

X xi mi / n x1 x2 ...xk x1 1 x2 2 ... xk k ,

n n

n

i 1

где i mi / n относительная частота значения

xi

130.

Если число испытаний достаточно велико, то i pi(относительная частота появления события xi

приближенно равна вероятности появления этого

события).

Таким образом, мат. ожидание приближенно равно

среднему арифметическому наблюдаемых

значений случайной величины.

131.

Замечания.1) Из определения следует, что м. о. дискретной

случайной величины есть неслучайная величина.

2) Мат. ожидание больше наименьшего и меньше

наибольшего из возможных значений случайной

величины, то есть на числовой оси возможные

значения располагаются слева и справа от мат.

ожидания. В этом смысле м.о. характеризует

расположение распределения случайной величины

и поэтому называется центром распределения.

3) М. о. – число около которого группируется

среднее арифметическое в большой серии

измерений.

132.

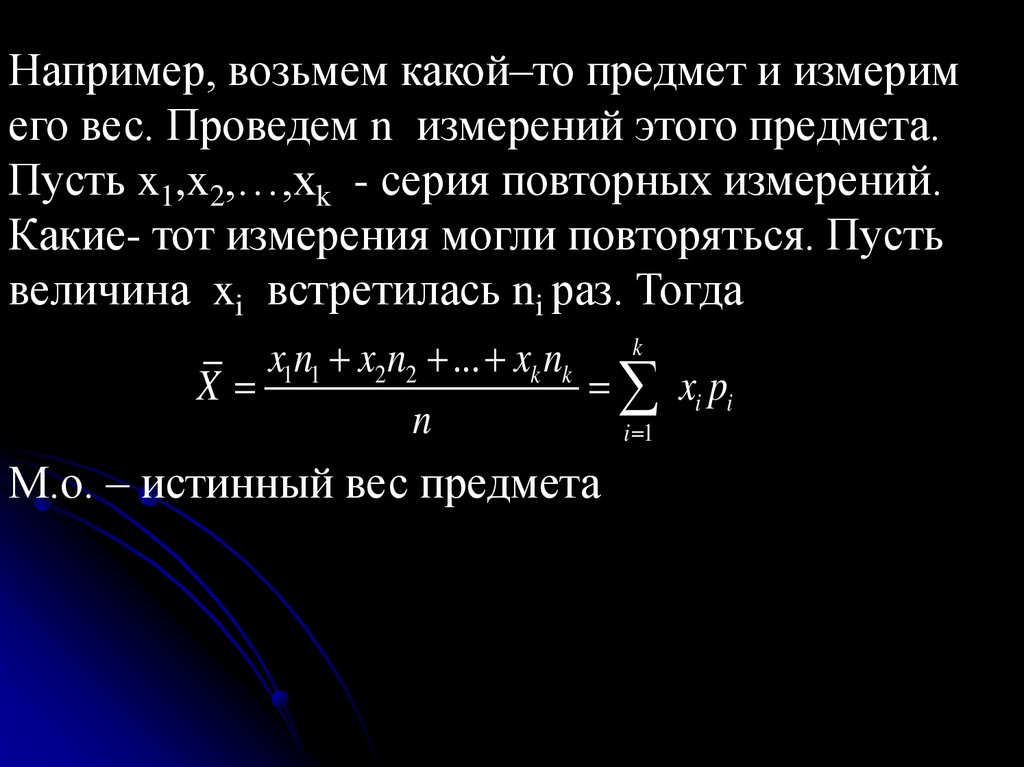

Например, возьмем какой–то предмет и измеримего вес. Проведем n измерений этого предмета.

Пусть x1,x2,…,xk - серия повторных измерений.

Какие- тот измерения могли повторяться. Пусть

величина xi встретилась ni раз. Тогда

x1n1 x2 n2 ... xk nk k

X

xi pi

n

i 1

М.о. – истинный вес предмета

133.

Свойства математического ожидания.1). Если β – неслучайная величина, то М(β) = β.

Доказательство.

М(β)= β·1= β.

(рассматриваем постоянную величину как

дискретную случайную величину, принимающую

одно и то же значение β и принимает его с

вероятностью P =1).

134.

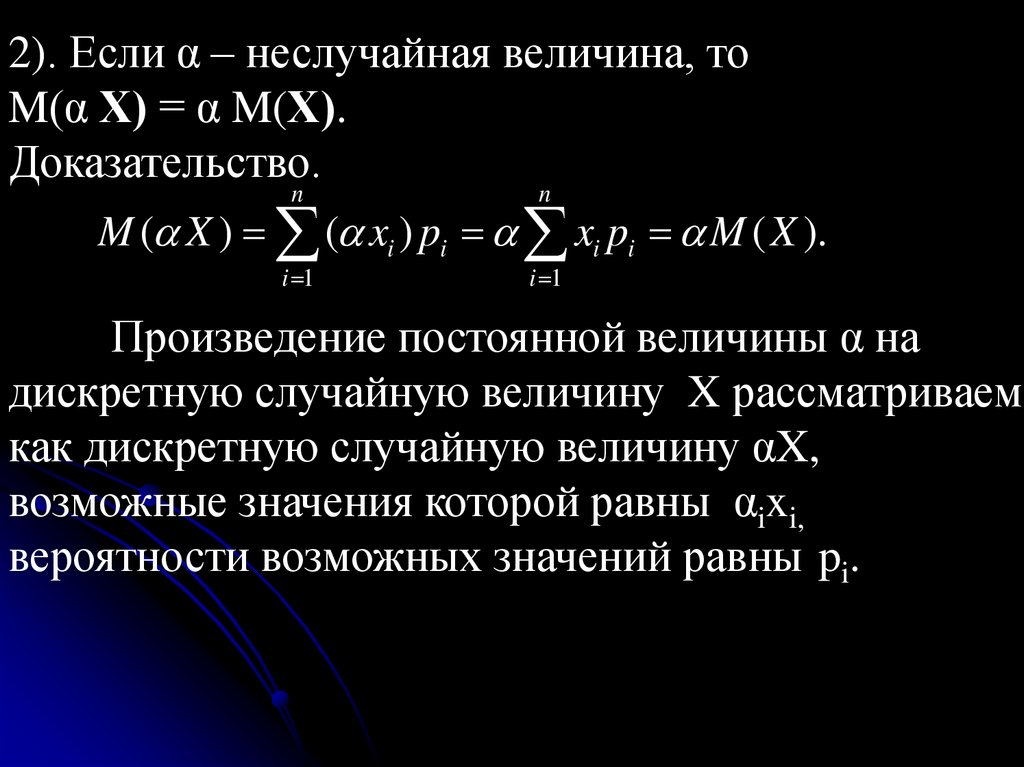

2). Если α – неслучайная величина, тоM(α Х) = α M(Х).

Доказательство.

n

n

M ( X ) ( xi ) pi xi pi M ( X ).

i 1

i 1

Произведение постоянной величины α на

дискретную случайную величину X рассматриваем

как дискретную случайную величину αX,

возможные значения которой равны αixi,

вероятности возможных значений равны pi.

135.

3).Математическое ожидание суммы двухслучайных величин равно сумме математических

ожиданий слагаемых: М(Х+Y) = М(Х)+M(Y).

Доказательство.

Пусть сл. величина X принимает значения xi

(i=1,…,n) c вероятностью pi, а сл. величина Y

принимает значения yi (i=1,…,k) c вероятностью qi.

Событие, состоящее в том, что сл. величина X

примет значения xi (i=1,2,…,n) c вероятностью pi ,

влечет за собой событие, которое состоит в том, что

сл. величина X+Y примет значения xi+y1, …,xi+yk

(i=1,2,…,n) вероятность которого по теореме

сложения вероятностей равна pi1+…+pik= pi .

136.

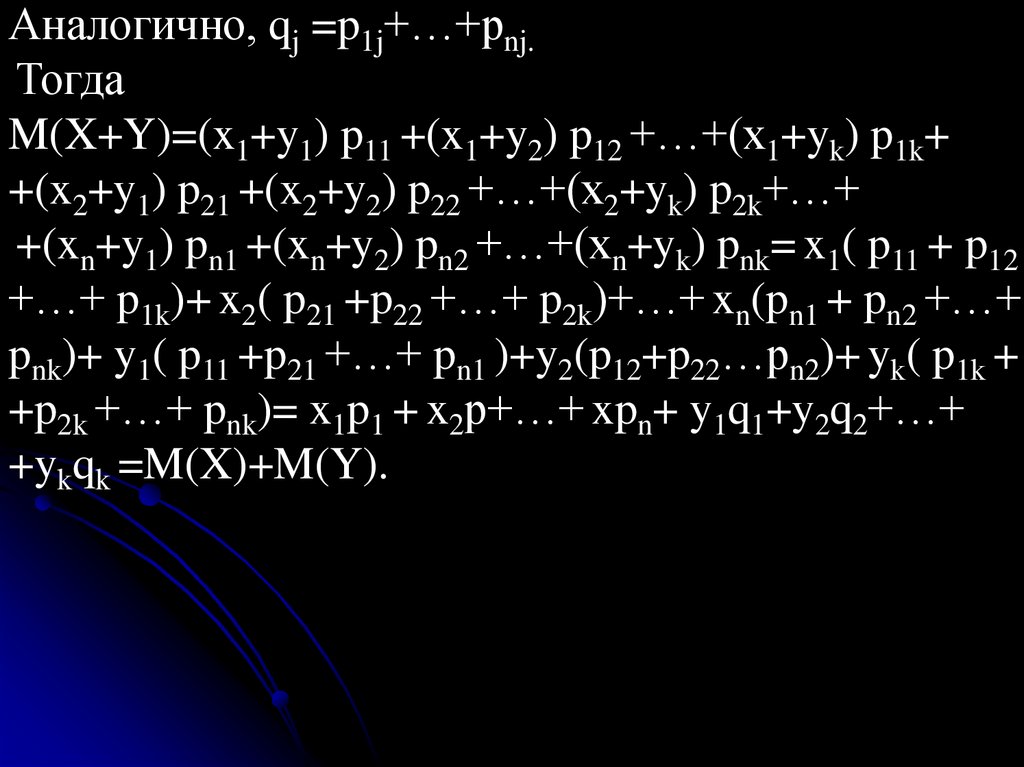

Аналогично, qj =p1j+…+pnj.Тогда

M(X+Y)=(x1+y1) p11 +(x1+y2) p12 +…+(x1+yk) p1k+

+(x2+y1) p21 +(x2+y2) p22 +…+(x2+yk) p2k+…+

+(xn+y1) pn1 +(xn+y2) pn2 +…+(xn+yk) pnk= x1( p11 + p12

+…+ p1k)+ x2( p21 +p22 +…+ p2k)+…+ xn(pn1 + pn2 +…+

pnk)+ y1( p11 +p21 +…+ pn1 )+y2(p12+p22…pn2)+ yk( p1k +

+p2k +…+ pnk)= x1p1 + x2p+…+ xpn+ y1q1+y2q2+…+

+ykqk =M(X)+M(Y).

137.

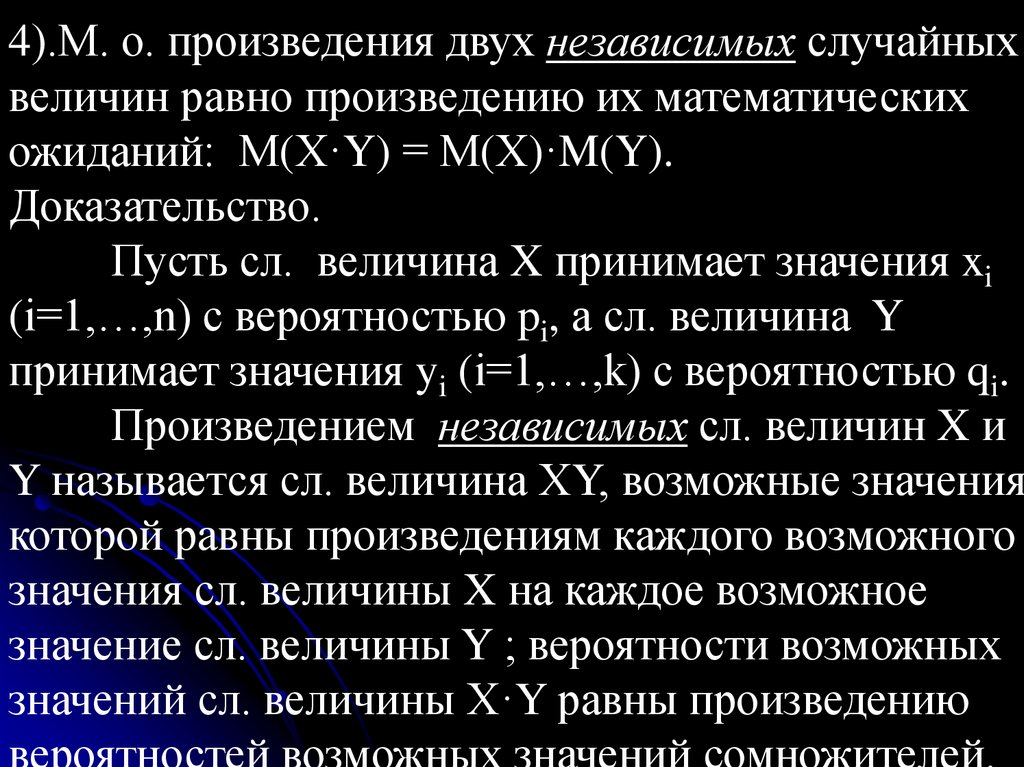

4).М. о. произведения двух независимых случайныхвеличин равно произведению их математических

ожиданий: М(Х·Y) = М(Х)·M(Y).

Доказательство.

Пусть сл. величина X принимает значения xi

(i=1,…,n) c вероятностью pi, а сл. величина Y

принимает значения yi (i=1,…,k) c вероятностью qi.

Произведением независимых сл. величин X и

Y называется сл. величина ХY, возможные значения

которой равны произведениям каждого возможного

значения сл. величины X на каждое возможное

значение сл. величины Y ; вероятности возможных

значений сл. величины Х·Y равны произведению

вероятностей возможных значений сомножителей.

138.

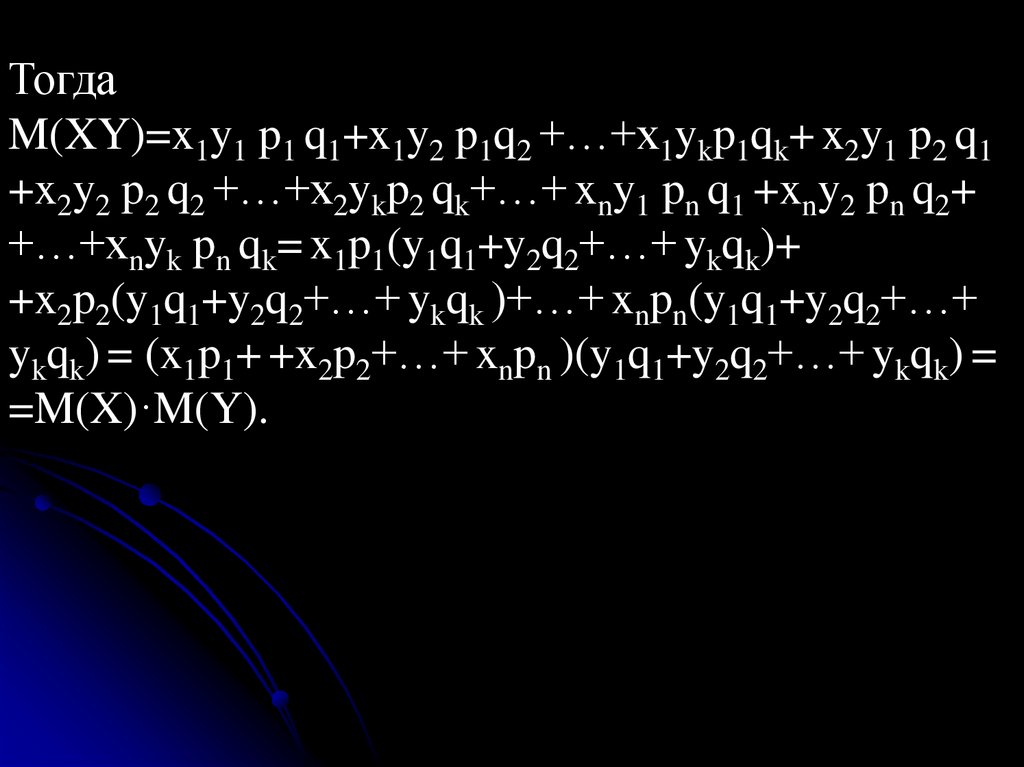

ТогдаM(XY)=x1y1 p1 q1+x1y2 p1q2 +…+x1ykp1qk+ x2y1 p2 q1

+x2y2 p2 q2 +…+x2ykp2 qk+…+ xny1 pn q1 +xny2 pn q2+

+…+xnyk pn qk= x1p1(y1q1+y2q2+…+ ykqk)+

+x2p2(y1q1+y2q2+…+ ykqk )+…+ xnpn(y1q1+y2q2+…+

ykqk) = (x1p1+ +x2p2+…+ xnpn )(y1q1+y2q2+…+ ykqk) =

=M(X)·M(Y).

139.

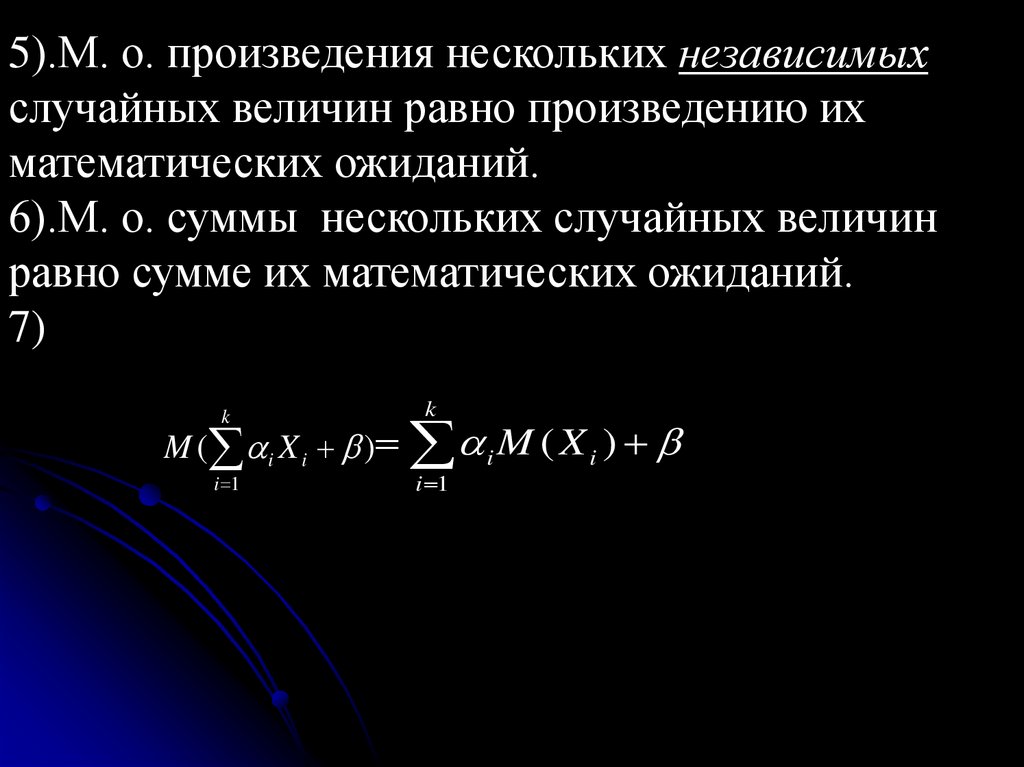

5).М. о. произведения нескольких независимыхслучайных величин равно произведению их

математических ожиданий.

6).М. о. суммы нескольких случайных величин

равно сумме их математических ожиданий.

7)

k

M ( i X i )

i 1

k

M ( X )

i 1

i

i

140.

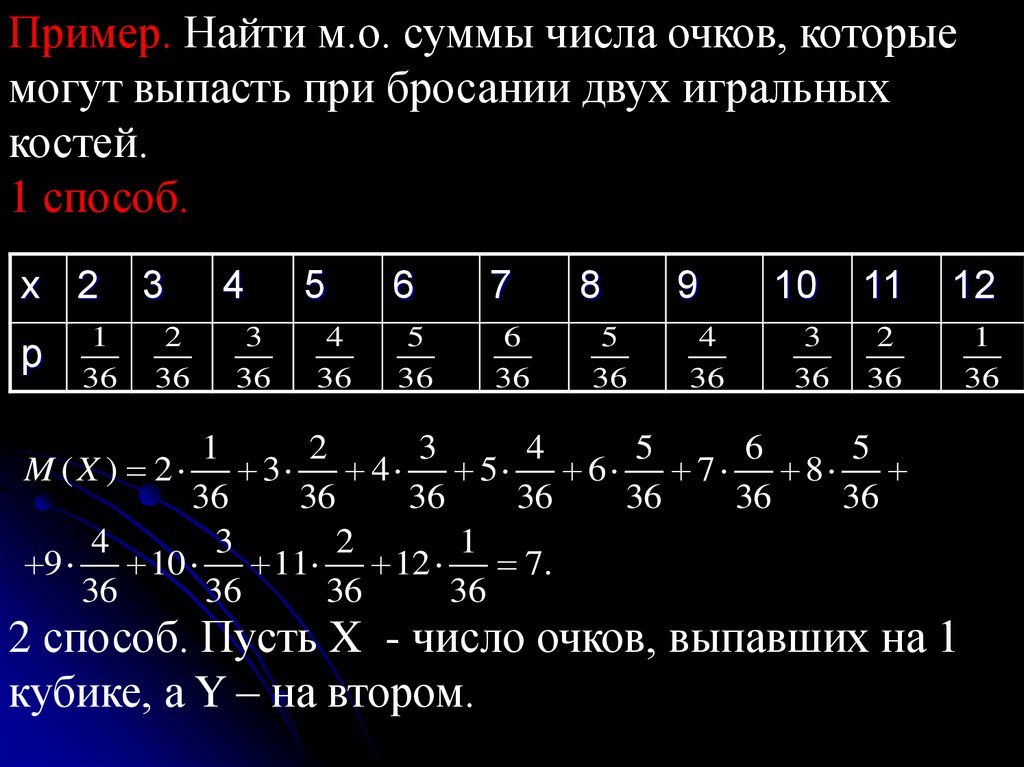

Пример. Найти м.о. суммы числа очков, которыемогут выпасть при бросании двух игральных

костей.

1 способ.

x 2

p

1

36

3

4

5

6

7

8

9

10

11

12

2

36

3

36

4

36

5

36

6

36

5

36

4

36

3

36

2

36

1

36

1

2

3

4

5

6

5

M ( X ) 2 3 4 5 6 7 8

36

36

36

36

36

36

36

4

3

2

1

9 10 11 12

7.

36

36

36

36

2 способ. Пусть X - число очков, выпавших на 1

кубике, а Y – на втором.

141.

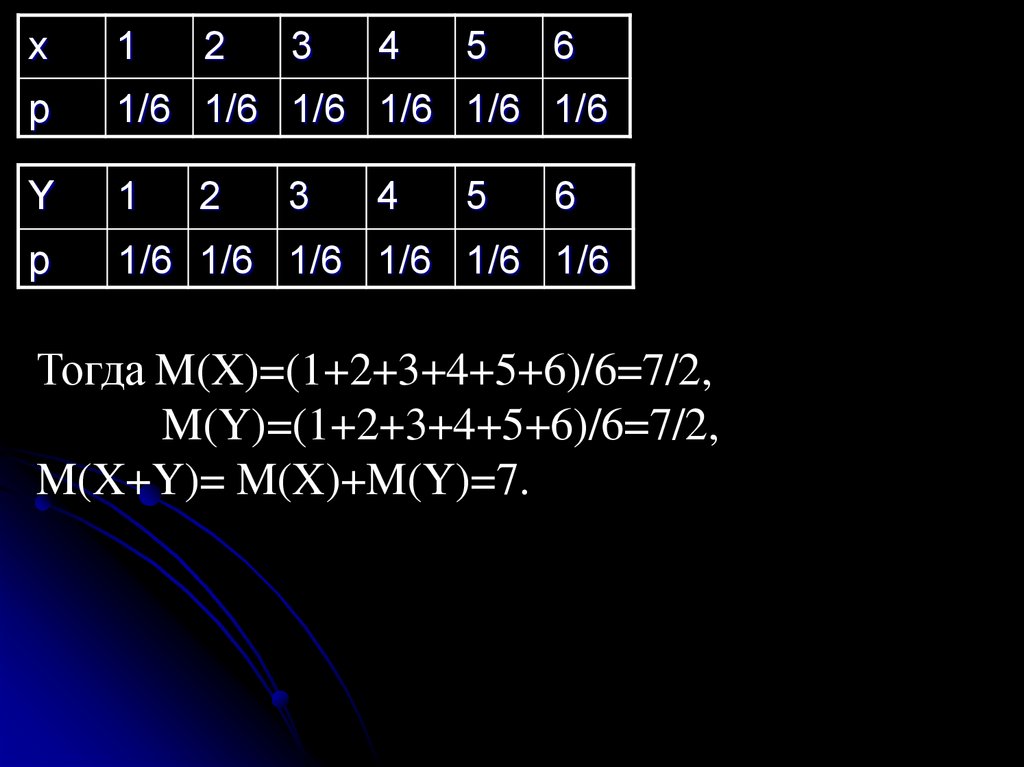

x1

2

p

1/6 1/6 1/6 1/6 1/6 1/6

Y

1

p

1/6 1/6 1/6 1/6 1/6 1/6

2

3

3

4

4

5

5

6

6

Тогда M(X)=(1+2+3+4+5+6)/6=7/2,

M(Y)=(1+2+3+4+5+6)/6=7/2,

M(X+Y)= M(X)+M(Y)=7.

142.

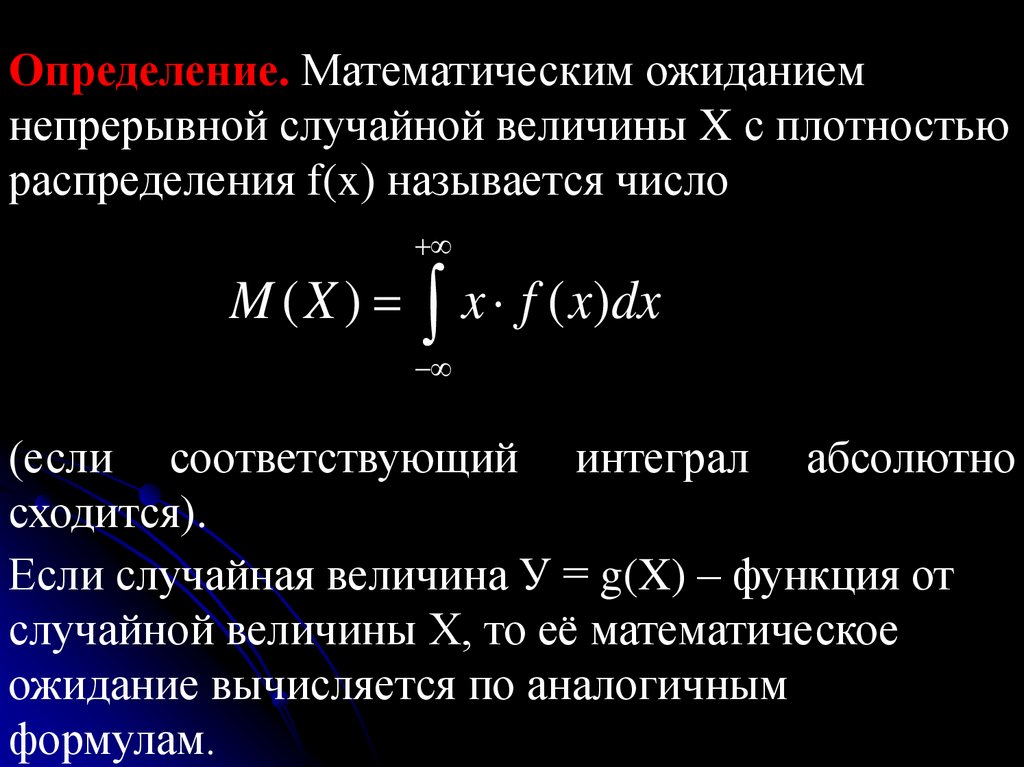

Определение. Математическим ожиданиемнепрерывной случайной величины X с плотностью

распределения f(x) называется число

M ( X ) x f ( x)dx

(если соответствующий интеграл абсолютно

сходится).

Если случайная величина У = g(X) – функция от

случайной величины Х, то её математическое

ожидание вычисляется по аналогичным

формулам.

143.

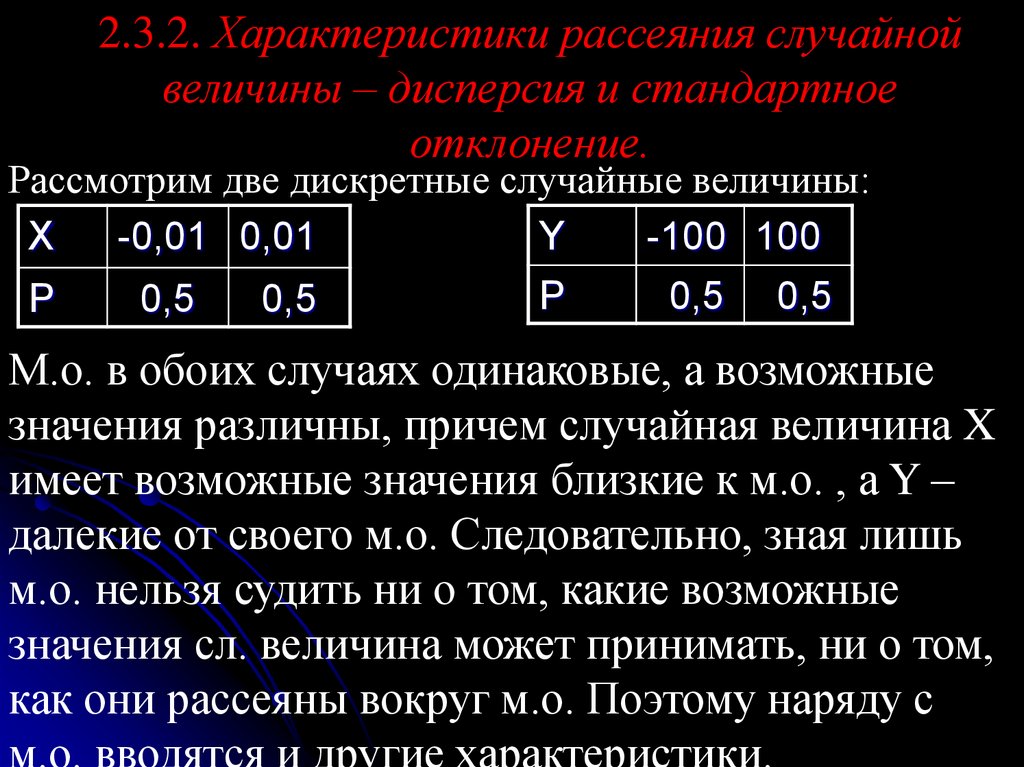

2.3.2. Характеристики рассеяния случайнойвеличины – дисперсия и стандартное

отклонение.

Рассмотрим две дискретные случайные величины:

X

-0,01 0,01

Y

-100 100

P

0,5 0,5

P

0,5

0,5

М.о. в обоих случаях одинаковые, а возможные

значения различны, причем случайная величина X

имеет возможные значения близкие к м.о. , а Y –

далекие от своего м.о. Следовательно, зная лишь

м.о. нельзя судить ни о том, какие возможные

значения сл. величина может принимать, ни о том,

как они рассеяны вокруг м.о. Поэтому наряду с

м.о. вводятся и другие характеристики.

144.

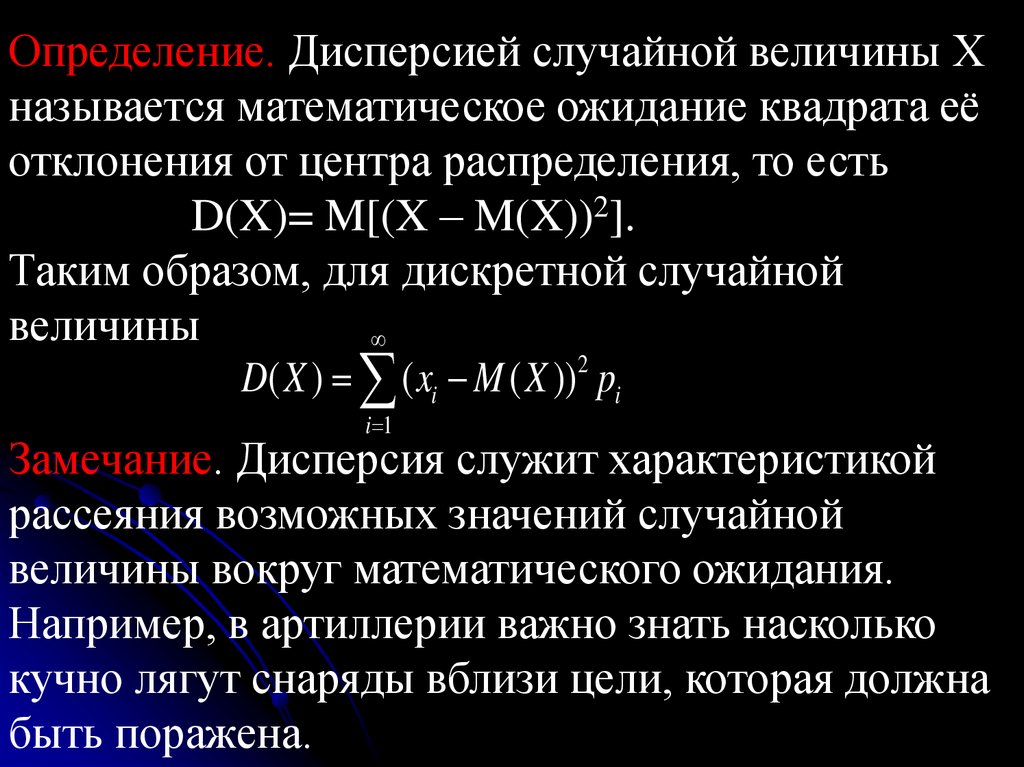

Определение. Дисперсией случайной величины Хназывается математическое ожидание квадрата её

отклонения от центра распределения, то есть

D(X)= M[(X – M(X))2].

Таким образом, для дискретной случайной

величины

D( X ) ( xi M ( X ))2 pi

i 1

Замечание. Дисперсия служит характеристикой

рассеяния возможных значений случайной

величины вокруг математического ожидания.

Например, в артиллерии важно знать насколько

кучно лягут снаряды вблизи цели, которая должна

быть поражена.

145.

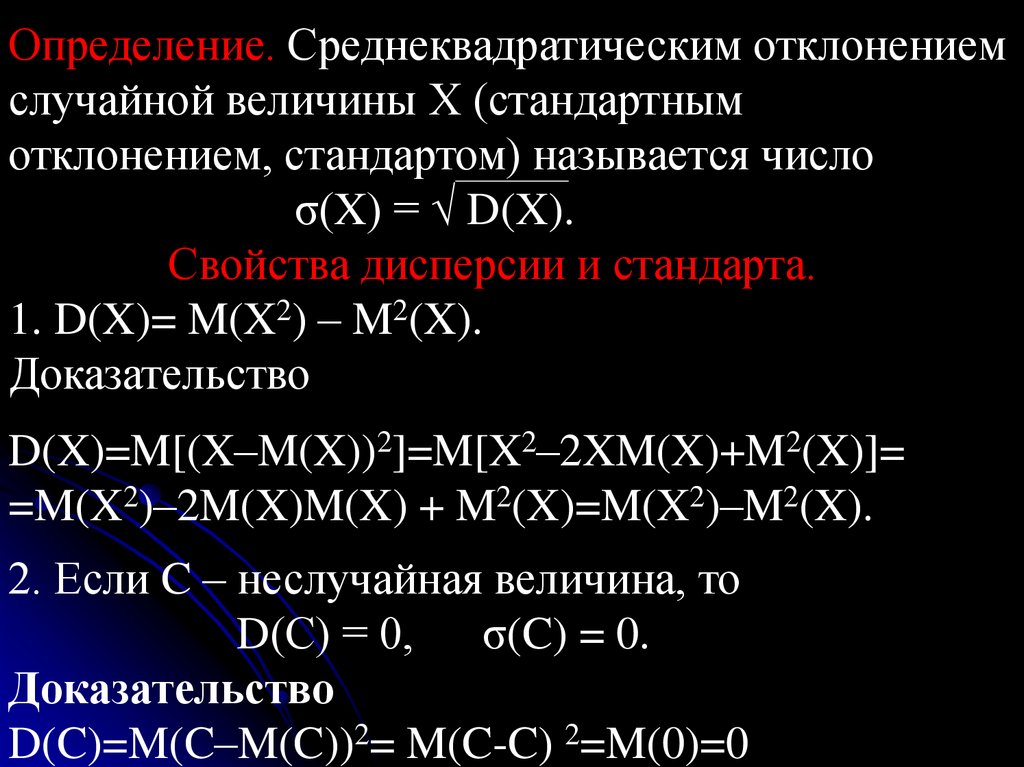

Определение. Среднеквадратическим отклонениемслучайной величины Х (стандартным

отклонением, стандартом) называется число

σ(X) = √ D(X).

Свойства дисперсии и стандарта.

1. D(X)= M(X2) – M2(X).

Доказательство

D(X)=M[(X–M(X))2]=M[X2–2XM(X)+M2(X)]=

=M(X2)–2M(X)M(X) + M2(X)=M(X2)–M2(X).

2. Если C – неслучайная величина, то

D(С) = 0, σ(C) = 0.

Доказательство

D(C)=M(C–M(C))2= M(C-C) 2=M(0)=0

146.

3. Если C – неслучайная величина, тоD(СX) = С2 D(X), σ(CX) = |C|σ(X) .

Доказательство

D(CX)= M(C2X2) – M2(CX) = C2 (M(X2) – M2(X))

4. Если C – неслучайная величина, то

D(X +C) = D(X), σ(X+C) = σ(X)

Доказательство

D(X+C)=M[(X+C–M(X+C))2]= M[(X+C–M(X) – C)2]

= D(X).

147.

5.Дисперсия суммы двух независимых случайныхвеличин равна сумме дисперсий этих величин:

D(Х+Y) = D(Х) + D(Y).

Доказательство

D(Х+Y) = M((Х+Y)2)– M2(Х+Y) =M(Х2+2ХY +Y2) – (M(Х) + M(Y))2 =M(Х2 )+M(2ХY)+M(Y2) –

- (M2(Х)+ 2M(Х)·M(Y)+ M 2(Y))=M(Х2 ) - M 2(Х) +

+2M(Х)M(Y)+M(Y2) – M 2(Y) - 2M(Х)· M(Y)=

= D(Х) + D(Y).

6.Дисперсия разности двух независимых случайных

величин равна сумме их дисперсий:

D(Х–Y) = D(Х) + D(Y).

Доказательство

D(Х–Y) = D(Х) + D(–Y)= D(Х)+ D(Y) .

148.

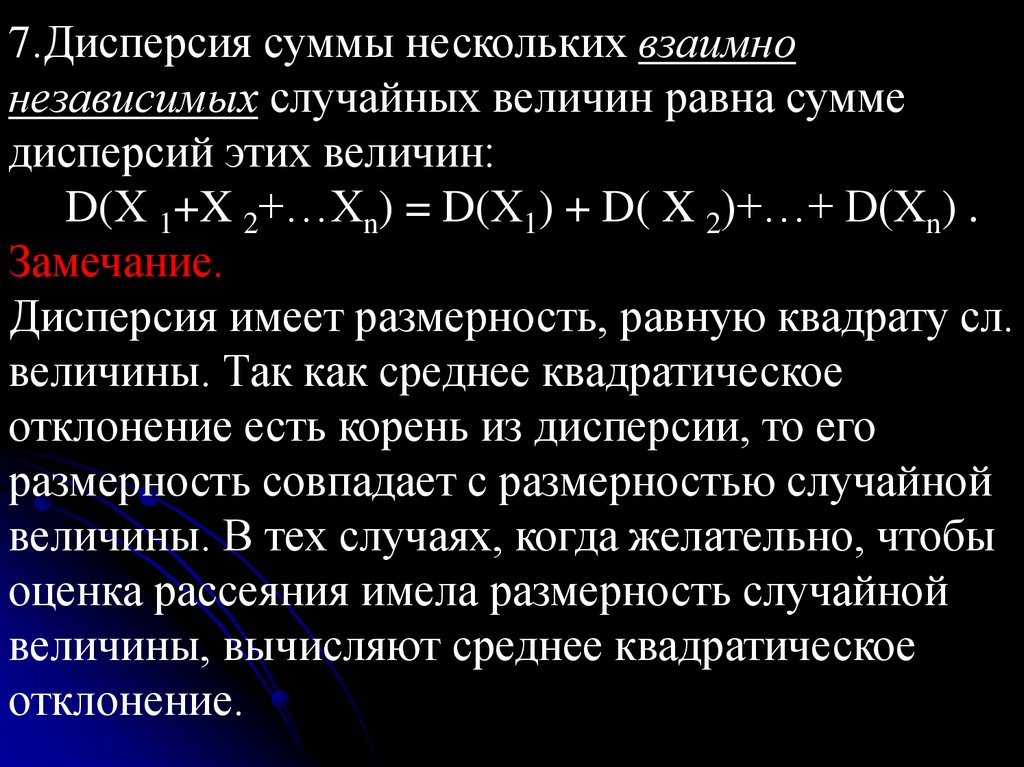

7.Дисперсия суммы нескольких взаимнонезависимых случайных величин равна сумме

дисперсий этих величин:

D(Х 1+X 2+…Xn) = D(Х1) + D( X 2)+…+ D(Xn) .

Замечание.

Дисперсия имеет размерность, равную квадрату сл.

величины. Так как среднее квадратическое

отклонение есть корень из дисперсии, то его

размерность совпадает с размерностью случайной

величины. В тех случаях, когда желательно, чтобы

оценка рассеяния имела размерность случайной

величины, вычисляют среднее квадратическое

отклонение.

149.

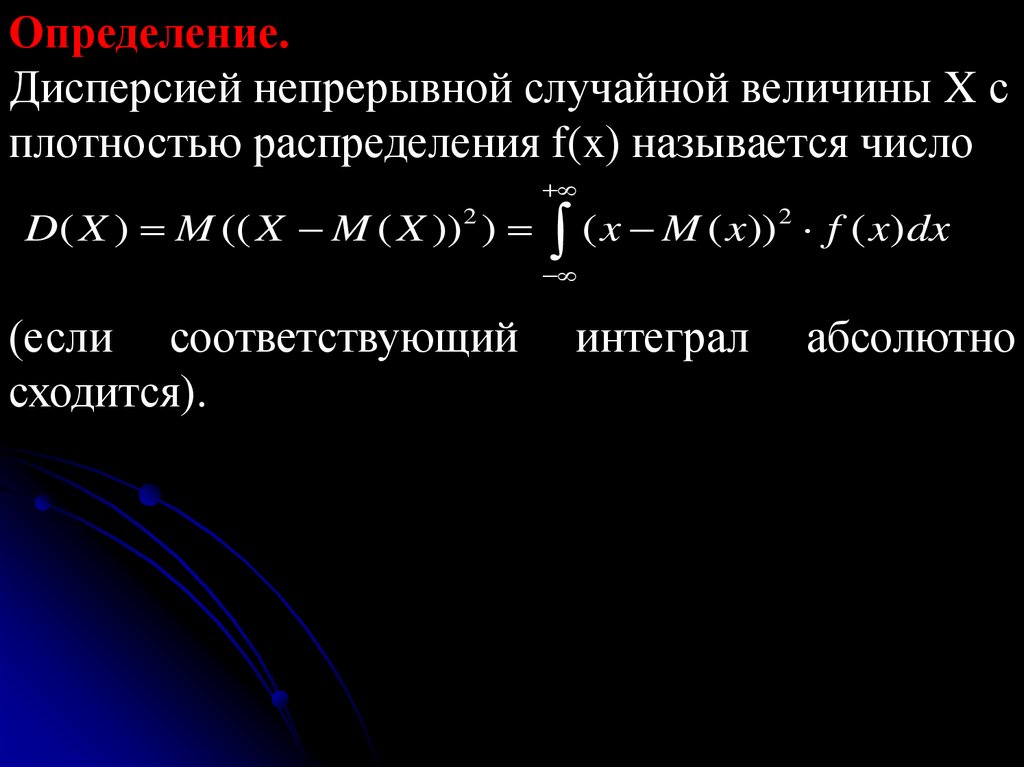

Определение.Дисперсией непрерывной случайной величины X с

плотностью распределения f(x) называется число

D( X ) M (( X M ( X )) 2 ) ( x M ( x)) 2 f ( x) dx

(если соответствующий

сходится).

интеграл

абсолютно

150.

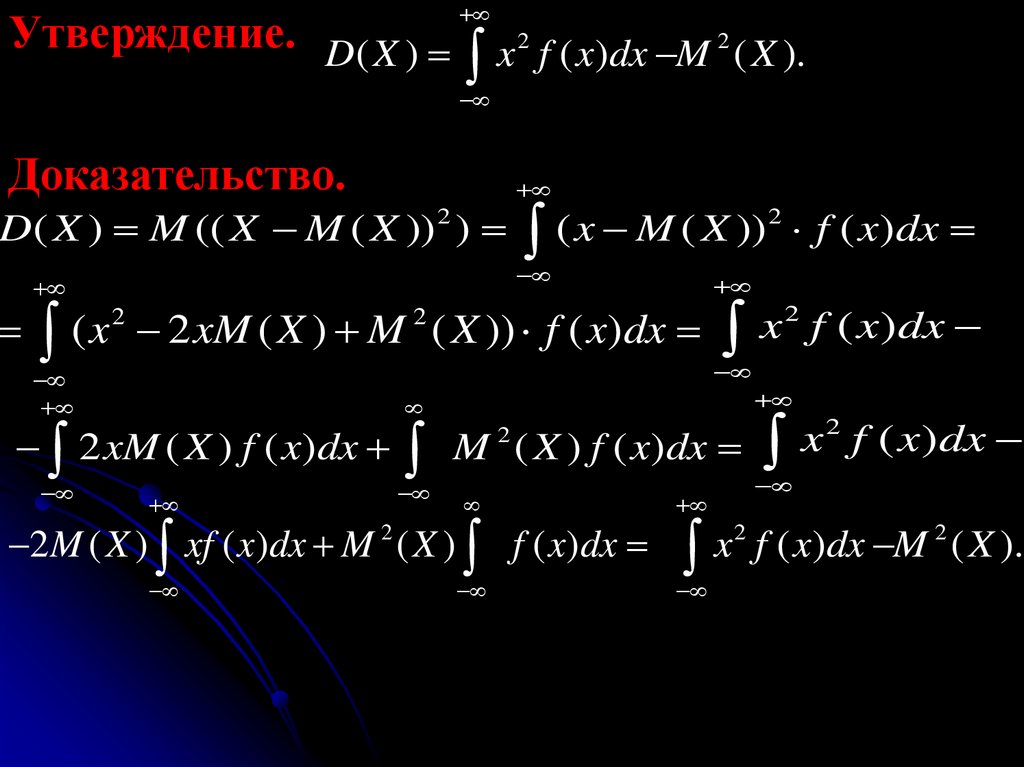

Утверждение. D( X )2

2

x

f

(

x

)

dx

M

( X ).

Доказательство.

D( X ) M (( X M ( X )) 2 ) ( x M ( X )) 2 f ( x)dx

2

x

f ( x )dx

( x 2 xM ( X ) M ( X )) f ( x)dx

2

2

2 xM ( X ) f ( x)dx

2

x

f ( x )dx

M ( X ) f ( x)dx

2

2M ( X ) xf ( x)dx M 2 ( X ) f ( x)dx

2

2

x

f

(

x

)

dx

M

( X ).

151.

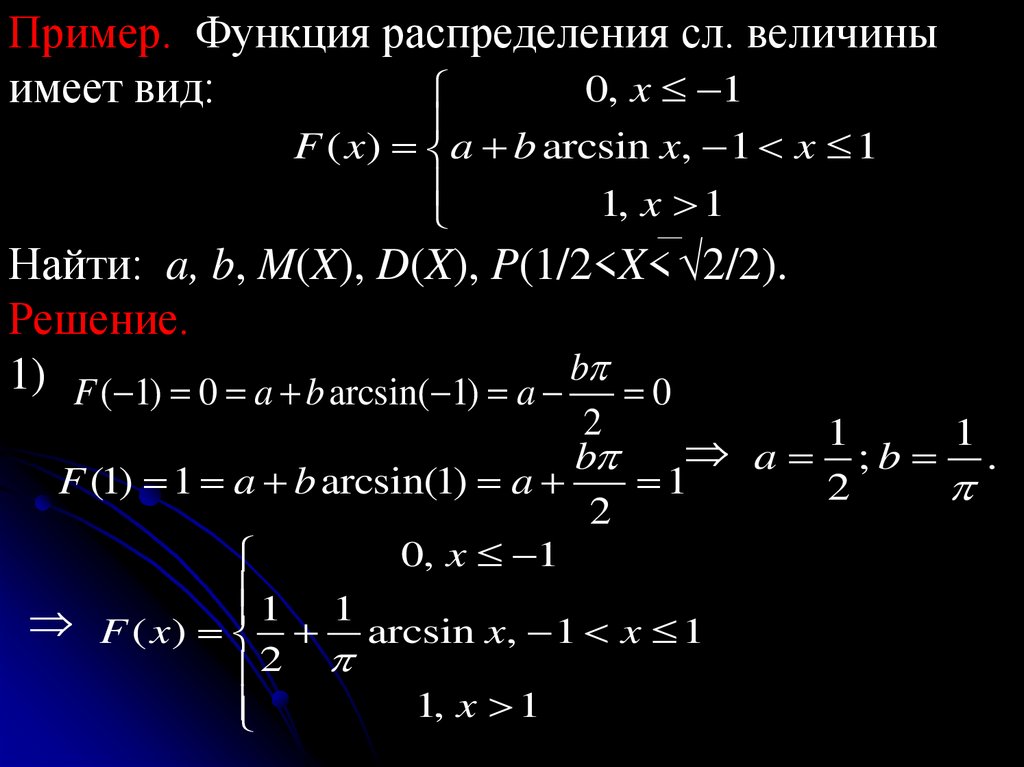

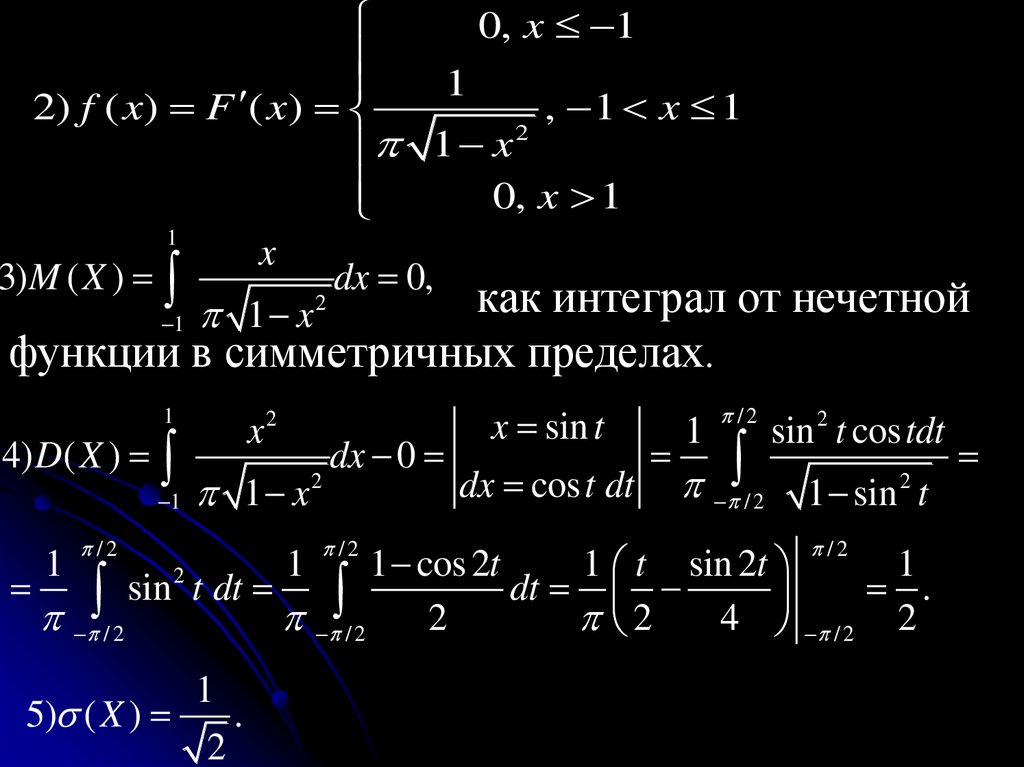

Пример. Функция распределения сл. величины0, x 1

имеет вид:

F ( x) a b arcsin x, 1 x 1

1, x 1

Найти: a, b, M(X), D(X), P(1/2<X< √2/2).

Решение.

1) F ( 1) 0 a b arcsin( 1) a b 0

2

1

1

b

a ;b .

F (1) 1 a b arcsin(1) a

1

2

2

0, x 1

1 1

F ( x) arcsin x, 1 x 1

2

1, x 1

152.

0, x 11

2) f ( x) F ( x)

, 1 x 1

2

1 x

0, x 1

1

x

3) M ( X )

dx 0,

2

как

интеграл

от

нечетной

1

x

1

функции в симметричных пределах.

/2

x sin t

1

sin 2 t cos tdt

4) D( X )

dx 0

2

2

dx cos t dt / 2 1 sin t

1 1 x

1

/2

x2

/2

/2

1 cos 2t

1 t sin 2t

1

sin t dt

dt

.

/ 2

/ 2

2

2

4 / 2 2

1

2

1

5) ( X )

.

2

1

153.

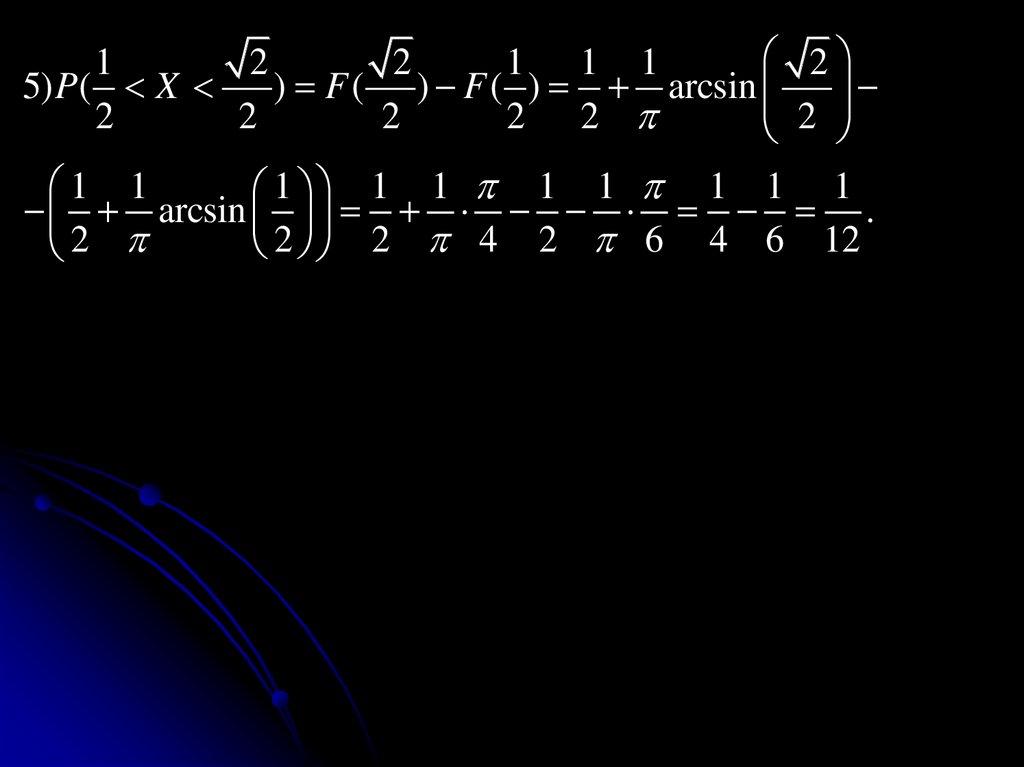

21

2

2

1 1 1

5) P( X

) F ( ) F ( ) arcsin

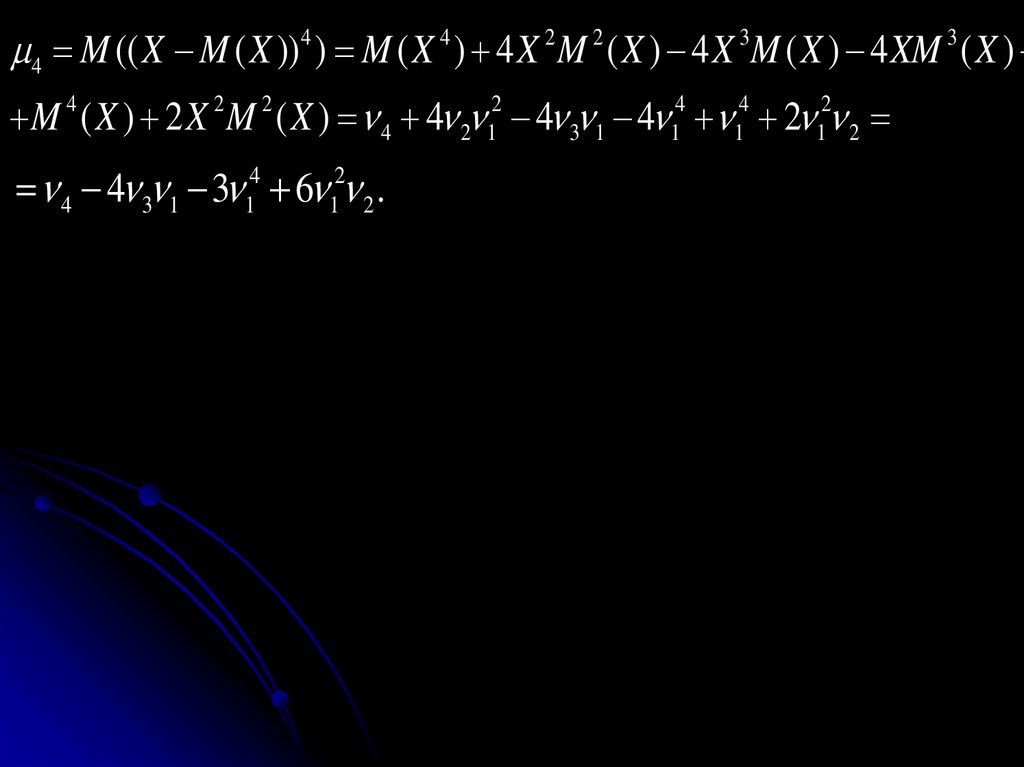

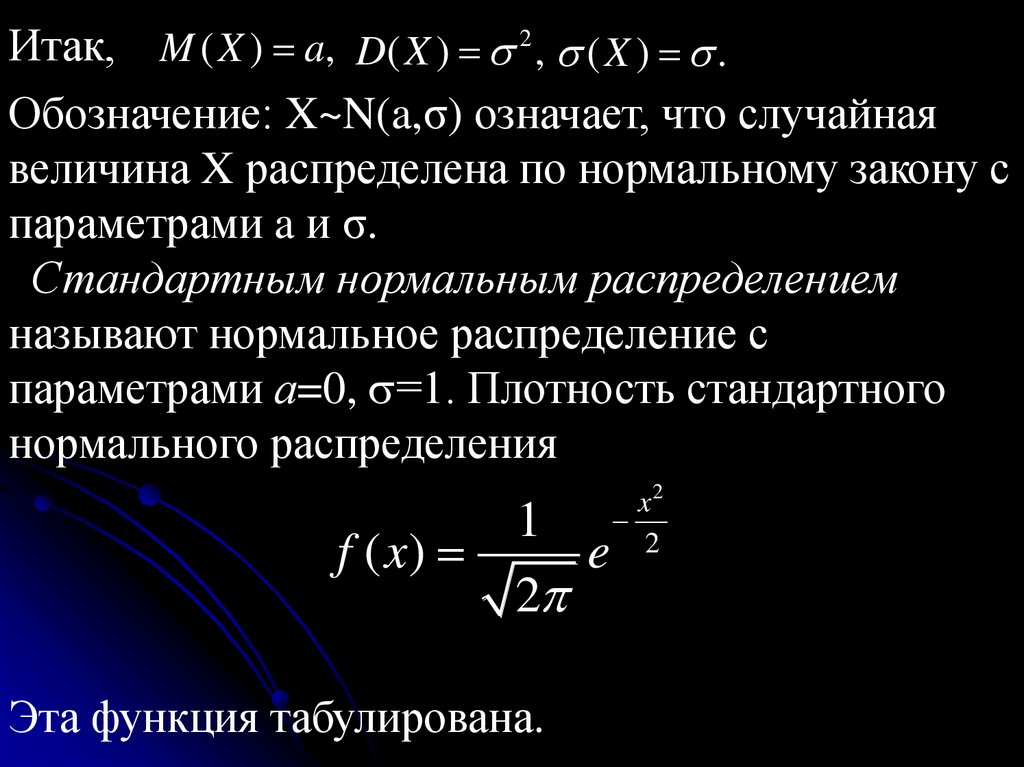

2

2

2

2 2

2

1 1

1 1 1 1 1 1 1 1

arcsin .

2 2 4 2 6 4 6 12

2

154.

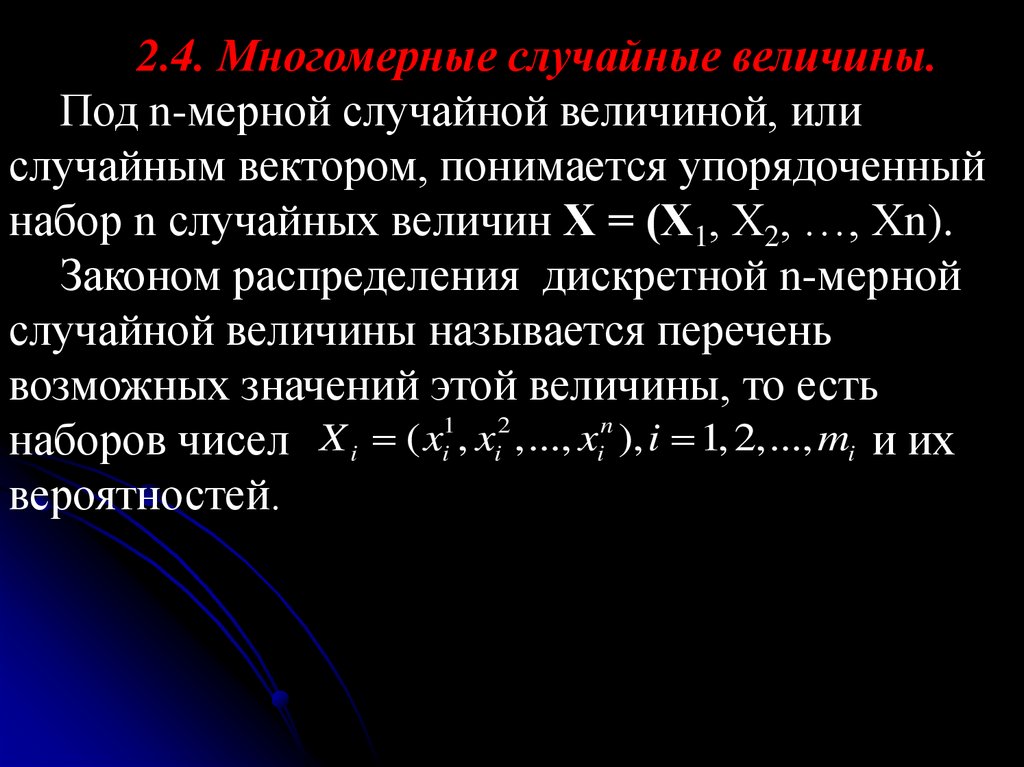

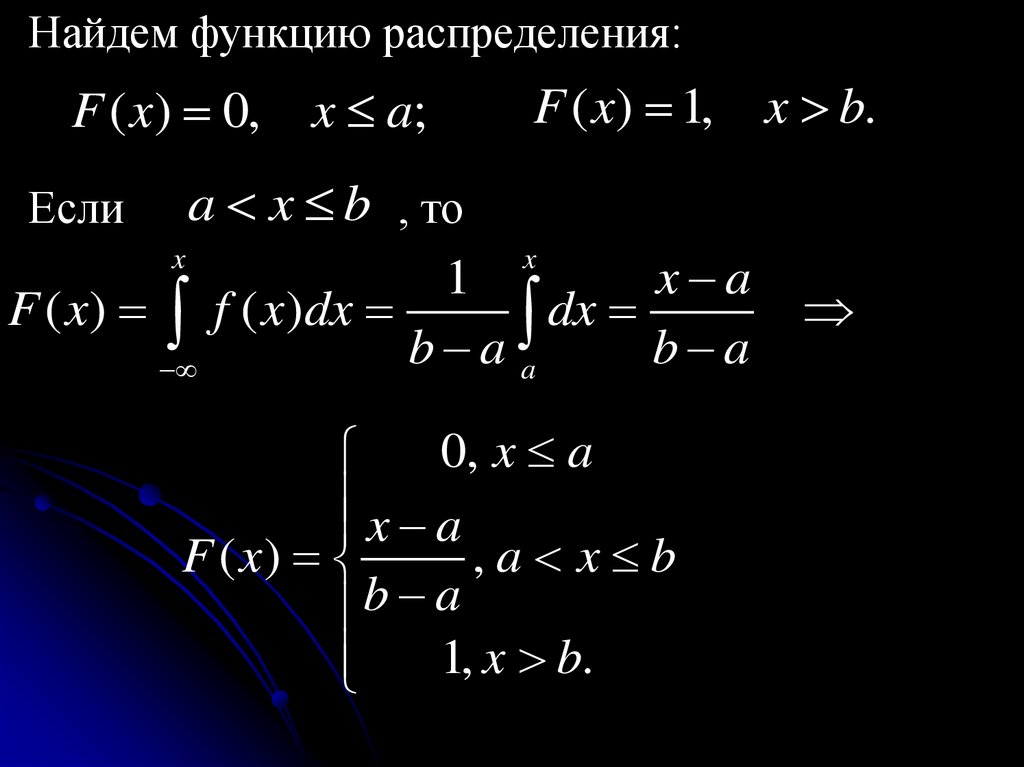

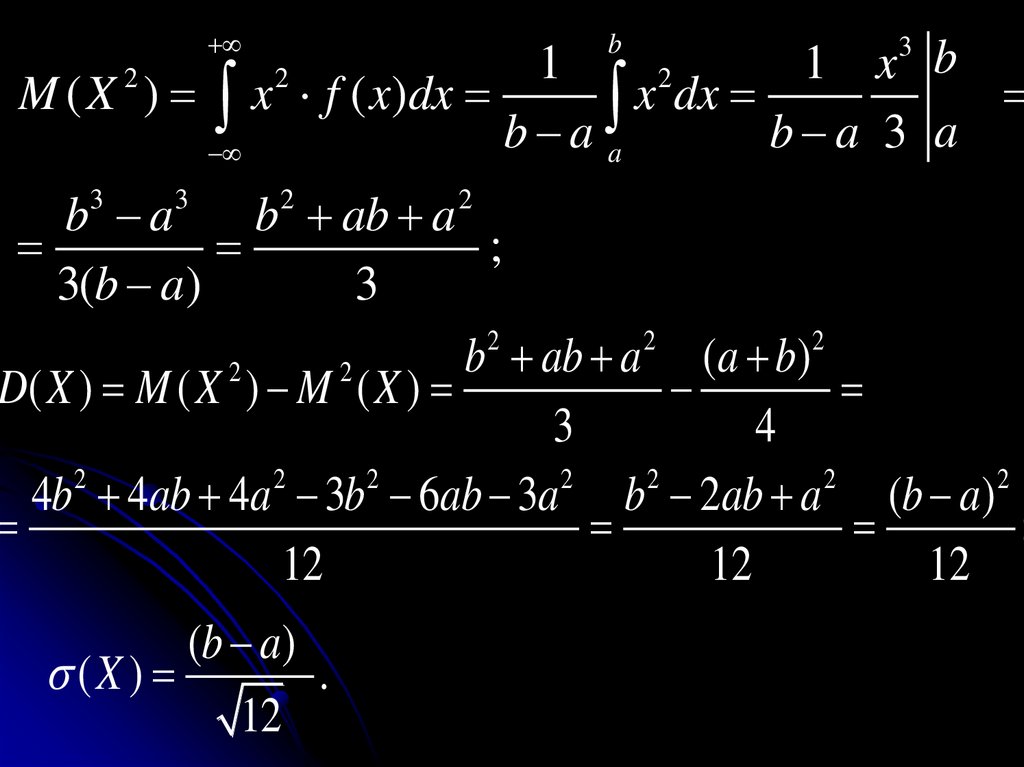

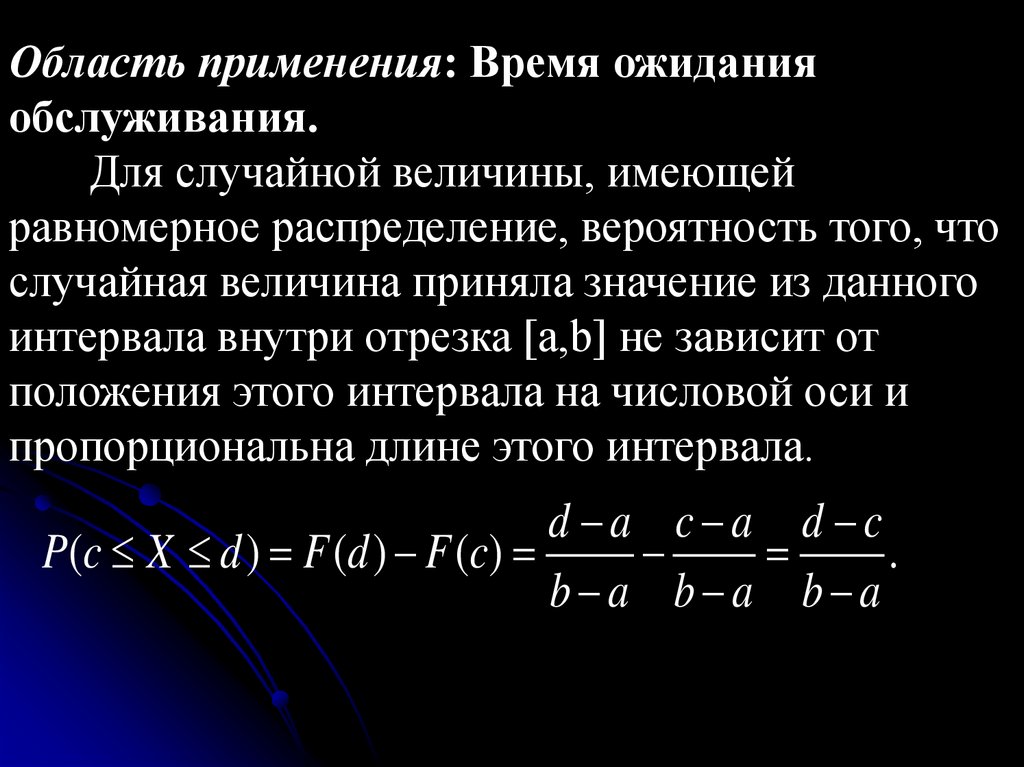

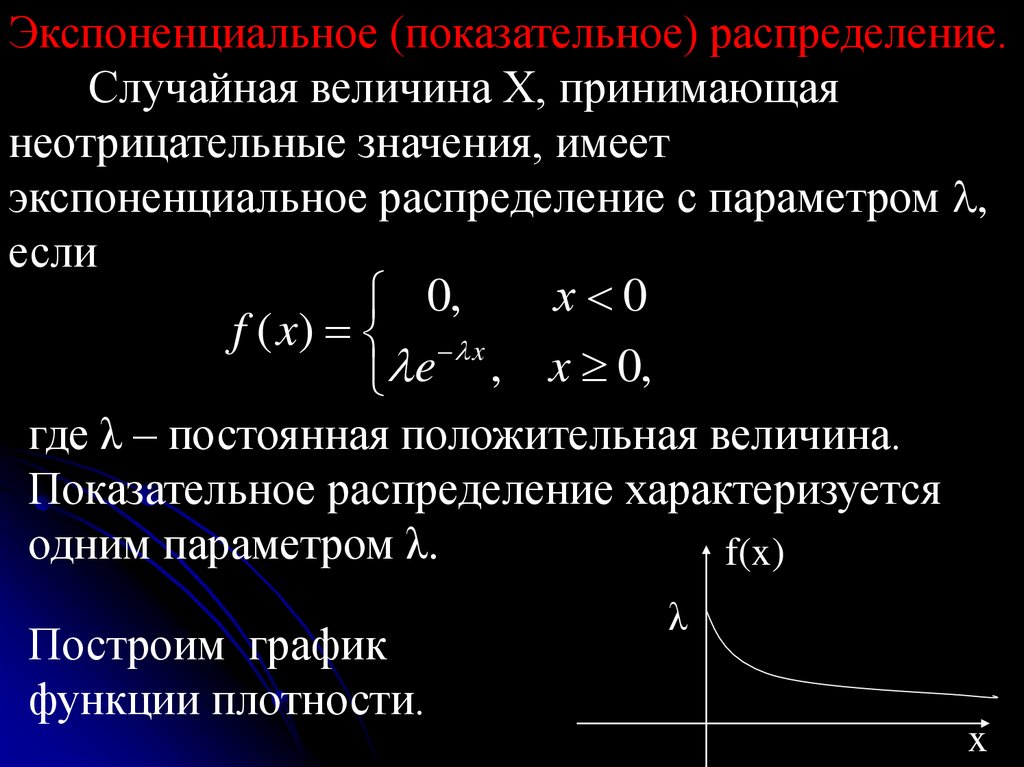

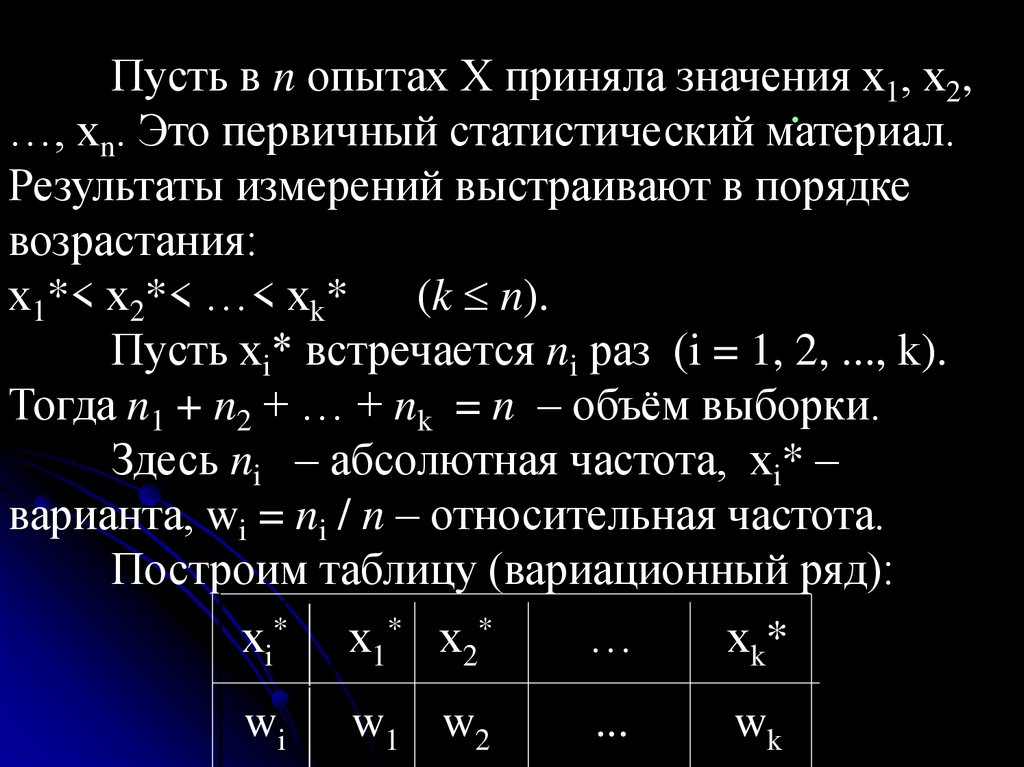

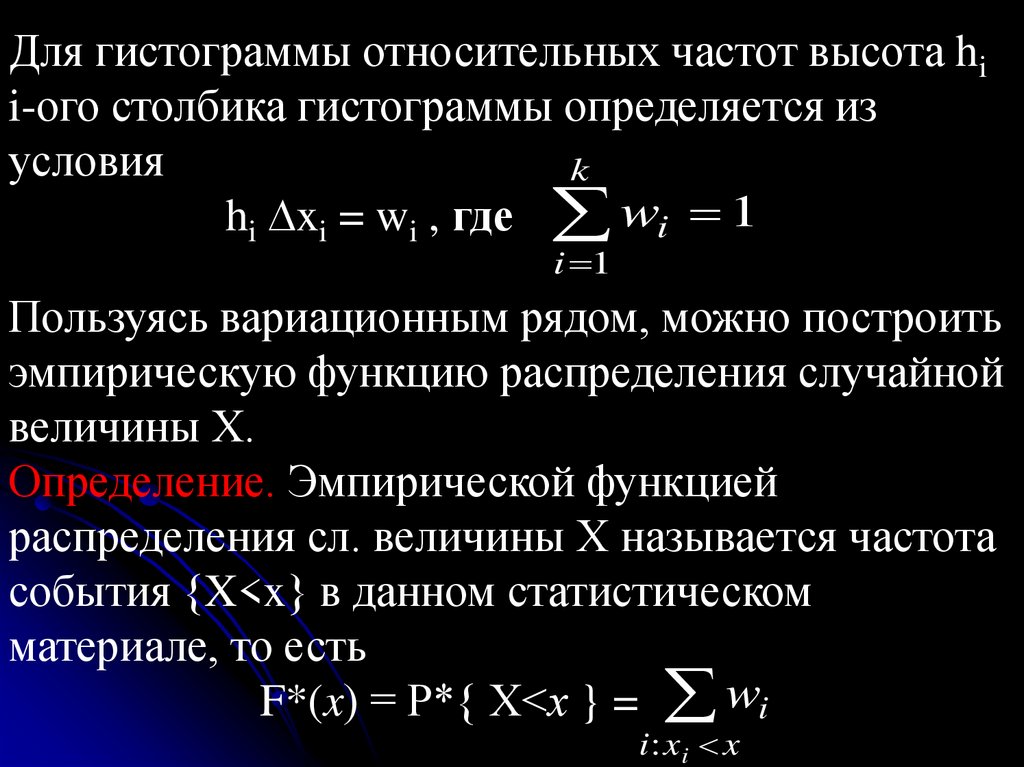

2.4. Многомерные случайные величины.Под n-мерной случайной величиной, или

случайным вектором, понимается упорядоченный

набор n случайных величин Х = (Х1, Х2, …, Хn).

Законом распределения дискретной n-мерной

случайной величины называется перечень

возможных значений этой величины, то есть

наборов чисел X i ( xi1 , xi2 ,..., xin ), i 1, 2,..., mi и их

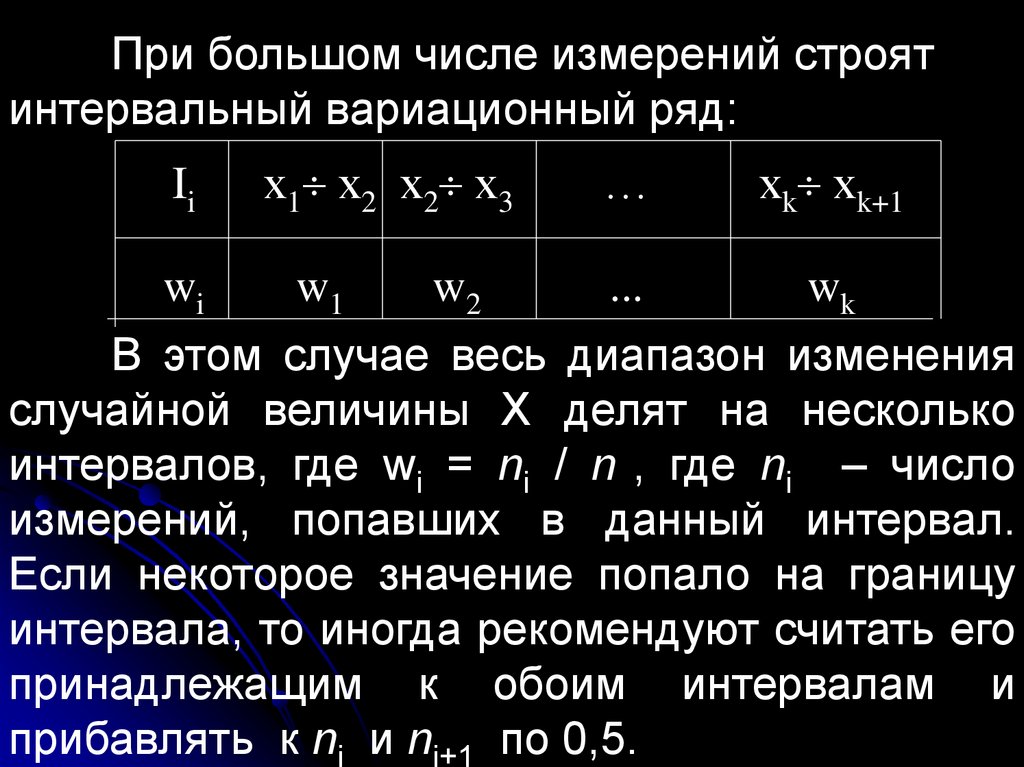

вероятностей.

155.

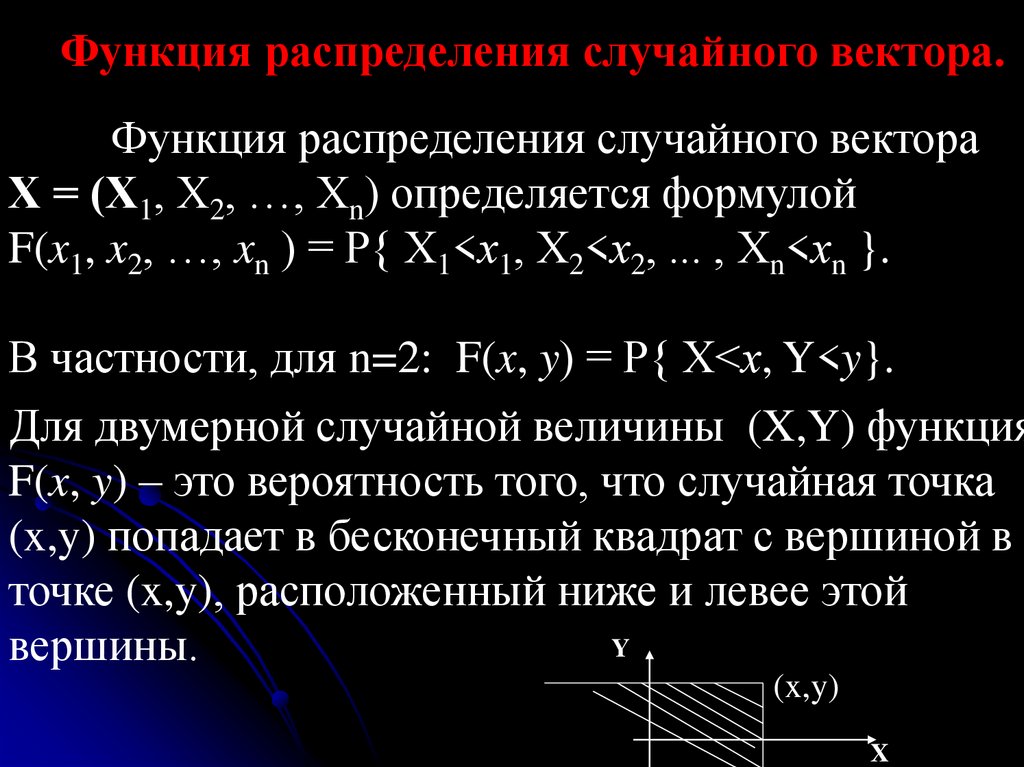

Функция распределения случайного вектора.Функция распределения случайного вектора

Х = (Х1, Х2, …, Хn) определяется формулой

F(x1, x2, …, xn ) = Р{ Х1<х1, Х2<х2, ... , Хn<хn }.

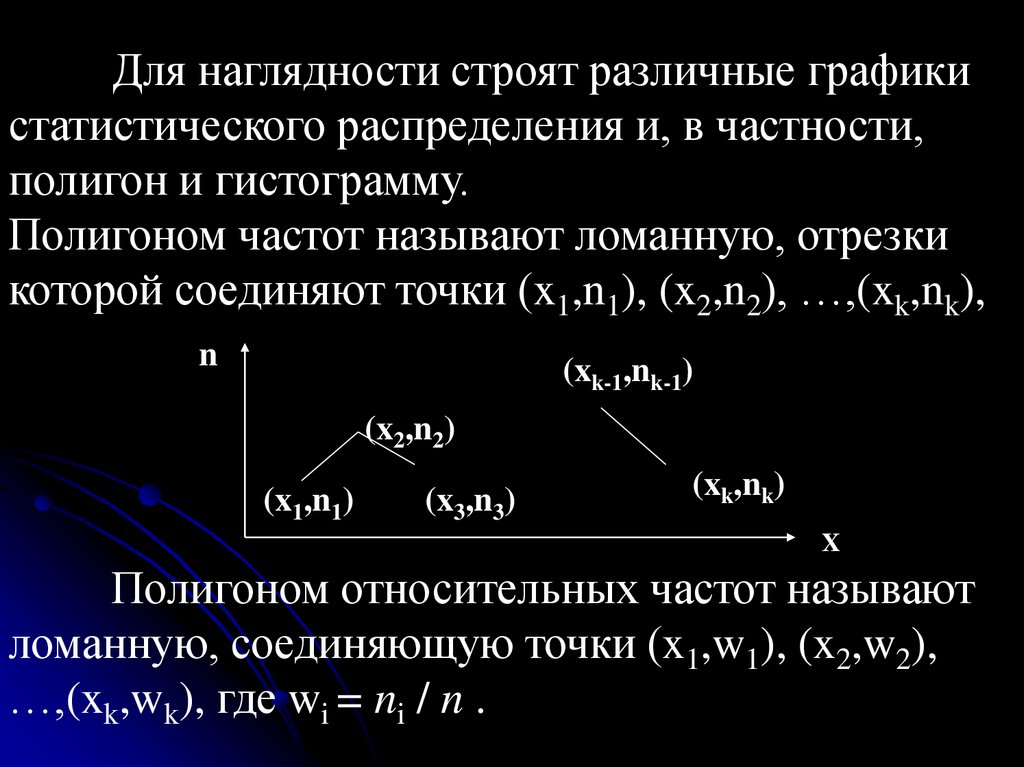

В частности, для n=2: F(x, y) = Р{ Х<х, Y<y}.

Для двумерной случайной величины (X,Y) функция

F(x, y) – это вероятность того, что случайная точка

(x,y) попадает в бесконечный квадрат с вершиной в

точке (x,y), расположенный ниже и левее этой

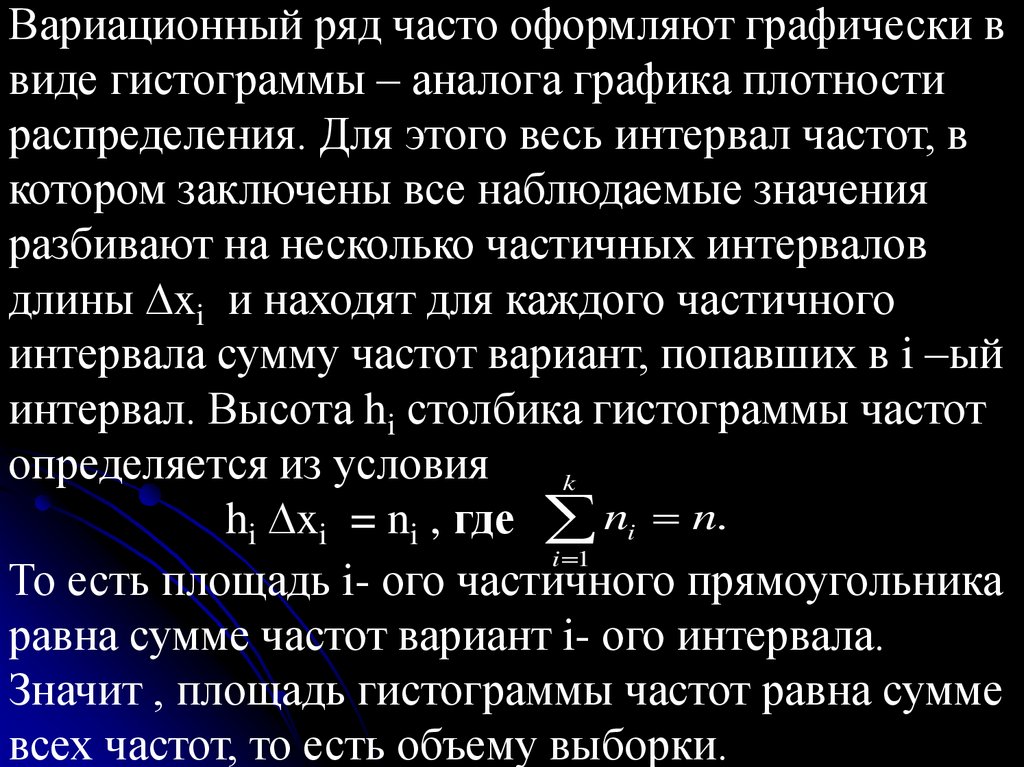

Y

вершины.

(x,y)

X

156.

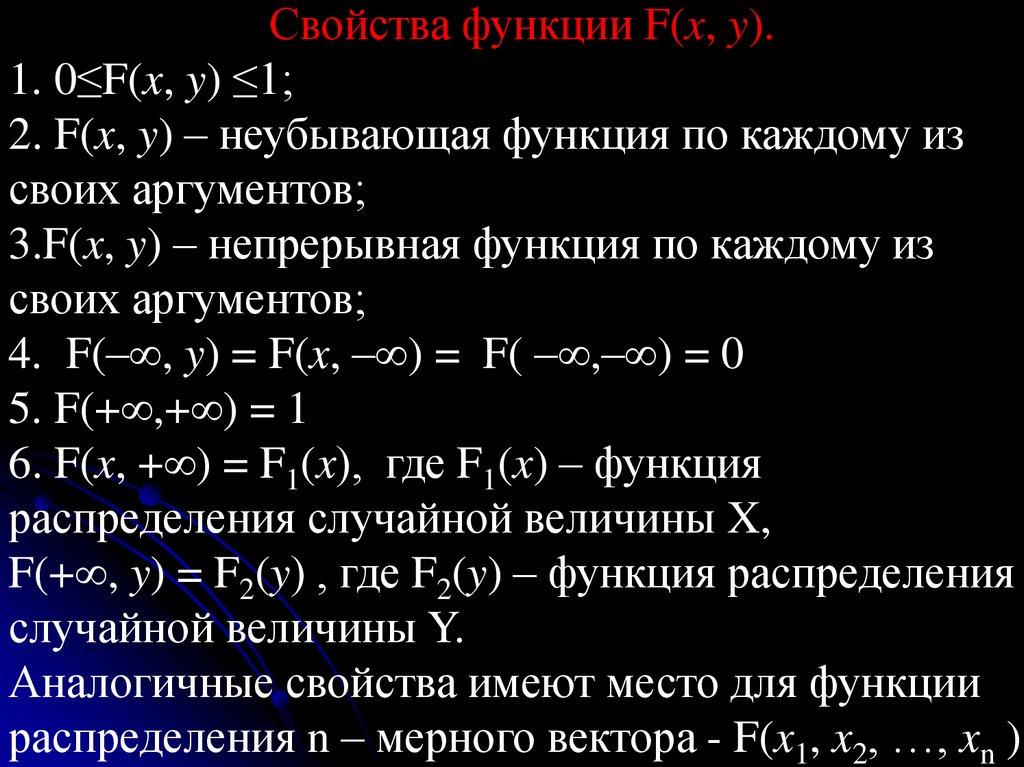

Свойства функции F(x, y).1. 0≤F(x, y) ≤1;

2. F(x, y) – неубывающая функция по каждому из

своих аргументов;

3.F(x, y) – непрерывная функция по каждому из

своих аргументов;

4. F(– , y) = F(x, – ) = F( – ,– ) = 0

5. F(+ ,+ ) = 1

6. F(x, + ) = F1(x), где F1(x) – функция

распределения случайной величины X,

F(+ , y) = F2(y) , где F2(y) – функция распределения

случайной величины Y.

Аналогичные свойства имеют место для функции

распределения n – мерного вектора - F(x1, x2, …, xn ).

157.

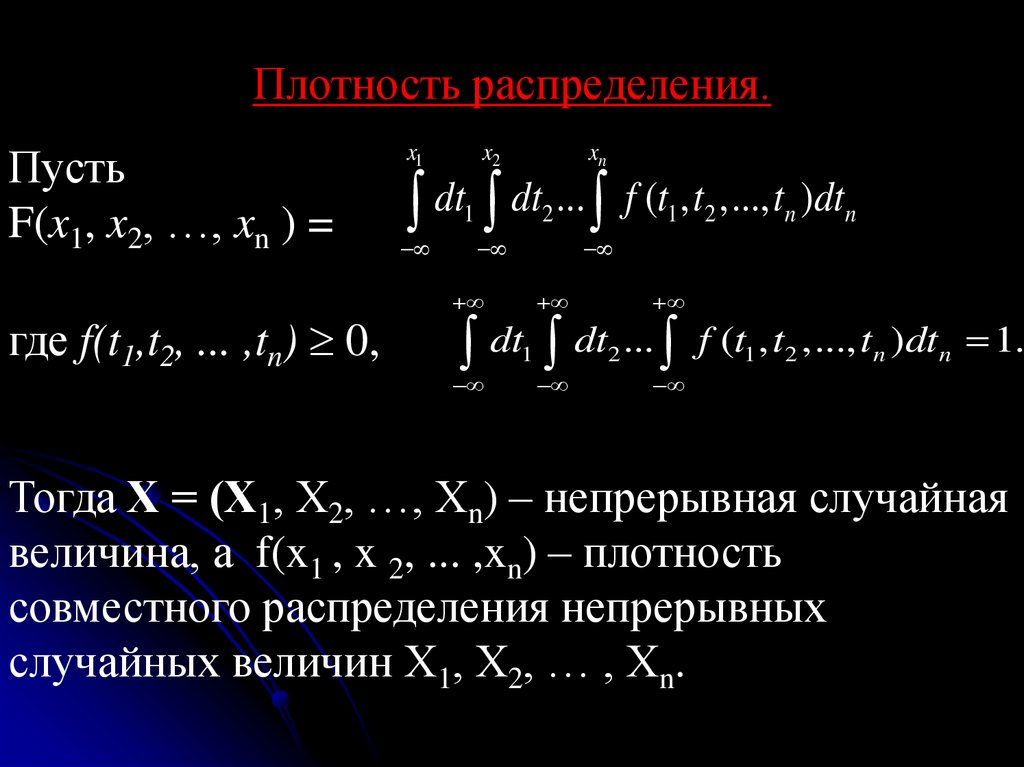

Плотность распределения.Пусть

F(x1, x2, …, xn ) =

где f(t1,t2, ... ,tn) 0,

x1

xn

x2

dt dt ... f (t , t ,..., t )dt

1

2

1

2

n

n

dt dt ... f (t , t ,..., t )dt 1.

1

2

1

2

n

n

Тогда Х = (Х1, Х2, …, Хn) – непрерывная случайная

величина, а f(x1 , x 2, ... ,xn) – плотность

совместного распределения непрерывных

случайных величин Х1, Х2, … , Хn.

158.

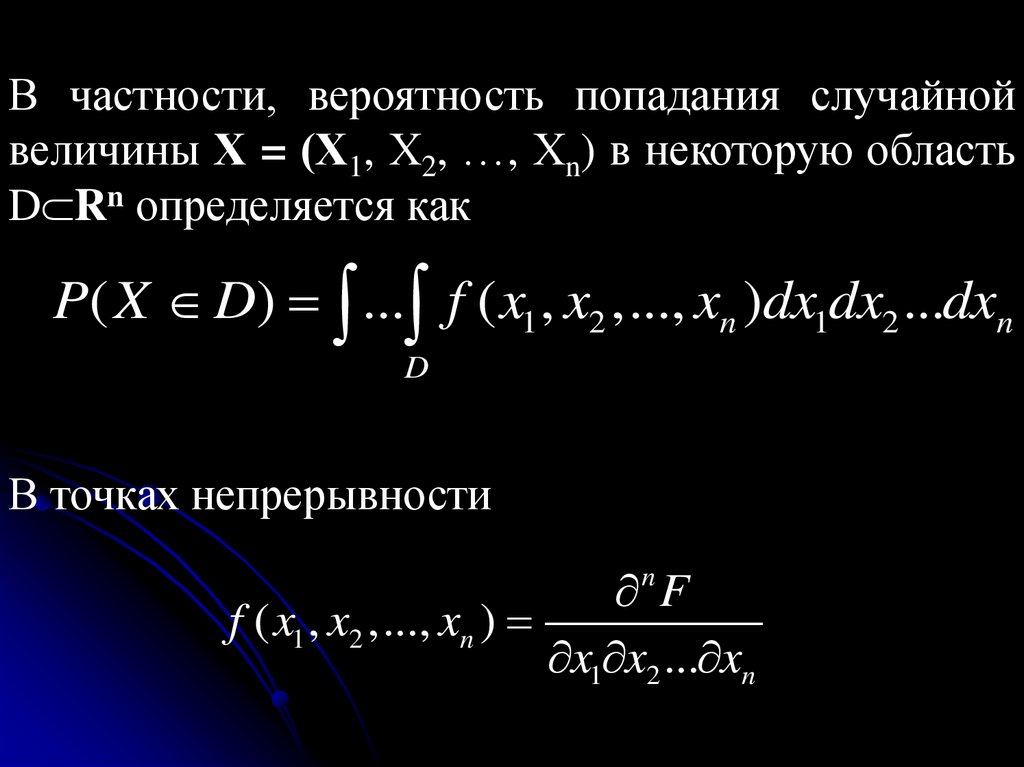

В частности, вероятность попадания случайнойвеличины Х = (Х1, Х2, …, Хn) в некоторую область

D Rn определяется как

P( X D) ... f ( x1 , x2 ,..., xn )dx1dx2 ...dxn

D

В точках непрерывности

F

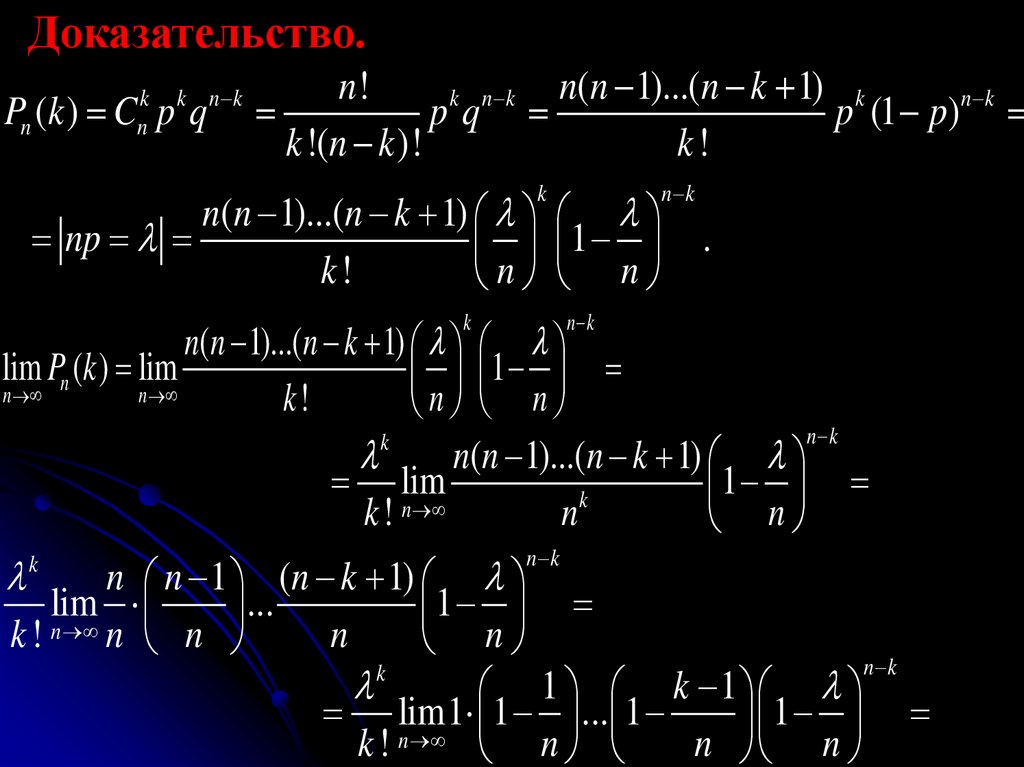

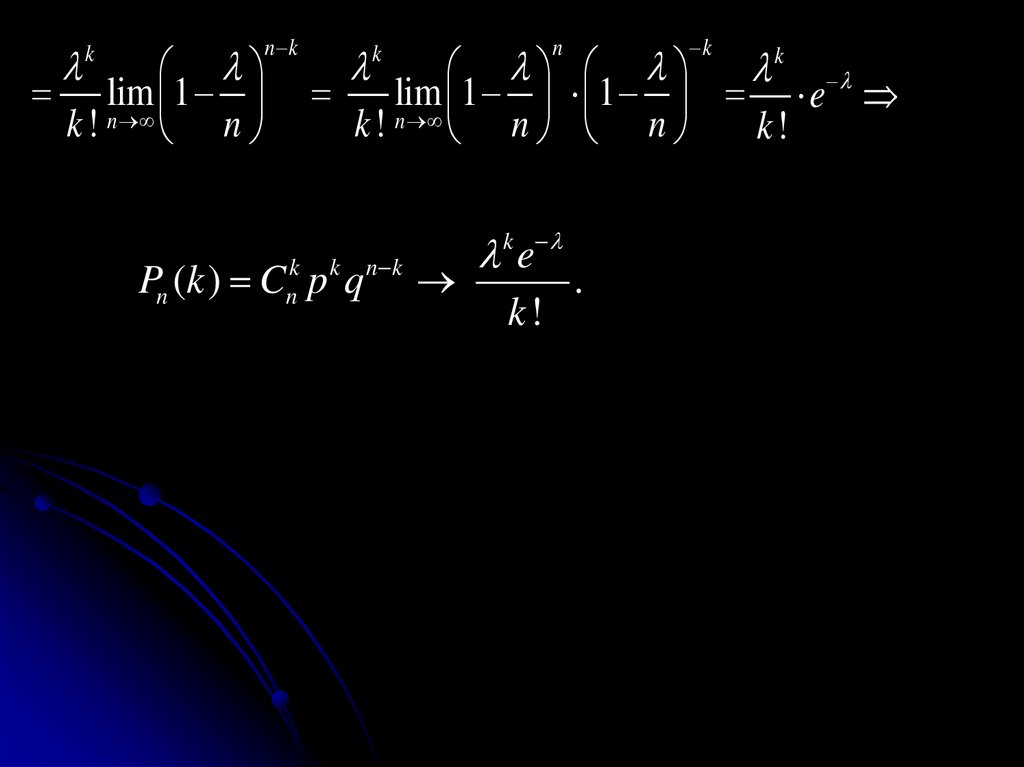

f ( x1 , x2 ,..., xn )

x1 x2 ... xn

n

159.

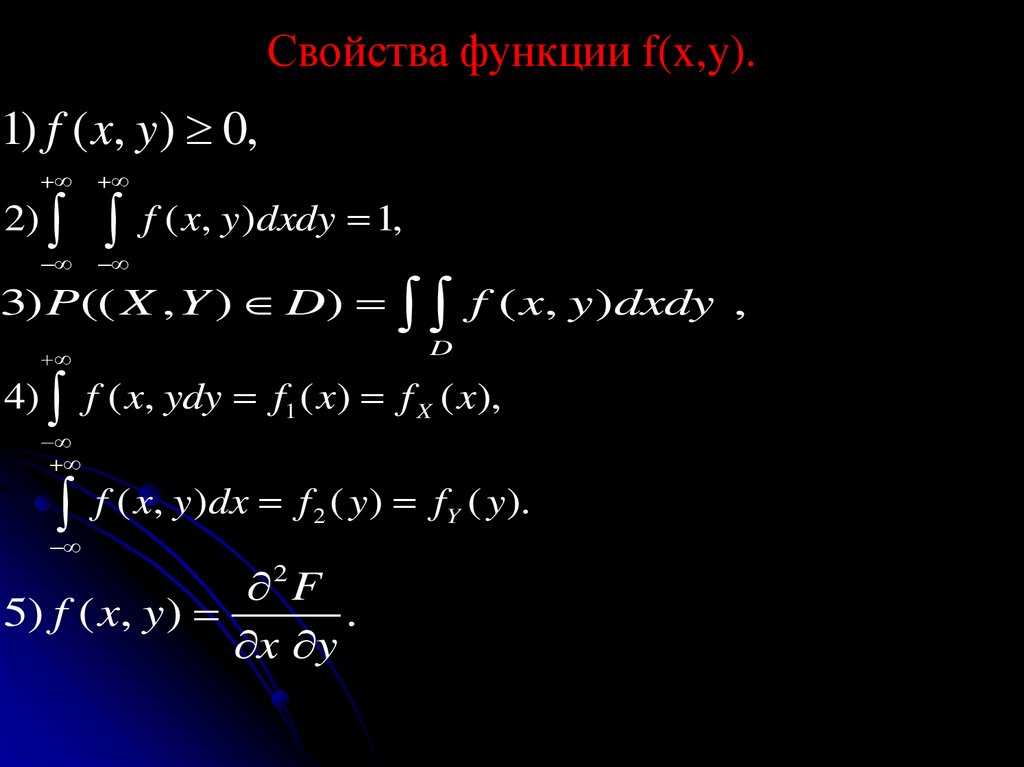

Свойства функции f(x,y).1) f ( x, y) 0,

2)

f ( x, y)dxdy 1,

3) P(( X , Y ) D) f ( x, y )dxdy ,

D

4) f ( x, ydy f1 ( x) f X ( x),

f ( x, y)dx f ( y) f ( y).

2

2 F

5) f ( x, y )

.

x y

Y

160.

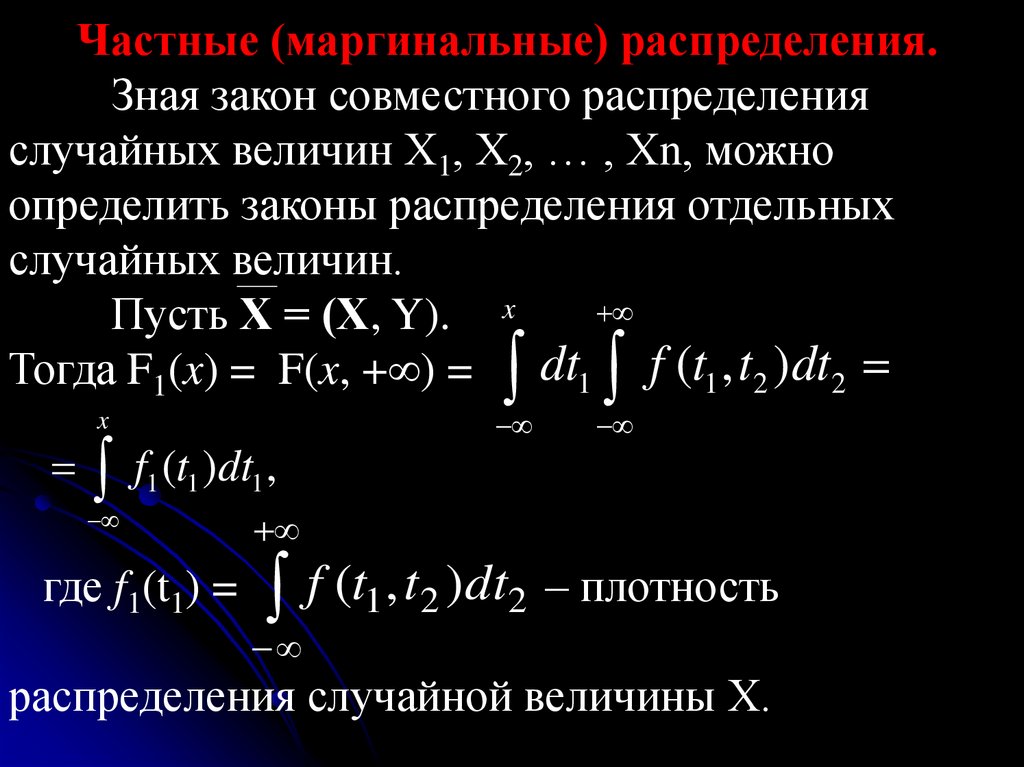

Частные (маргинальные) распределения.Зная закон совместного распределения

случайных величин Х1, Х2, … , Хn, можно

определить законы распределения отдельных

случайных величин.

Пусть Х = (Х, Y). x

Тогда F1(x) = F(x, + ) = dt1 f (t1 , t2 )dt2

x

f1 (t1 )dt1 ,

где f1(t1) = f (t1 , t 2 )dt2 – плотность

распределения случайной величины Х.

161.

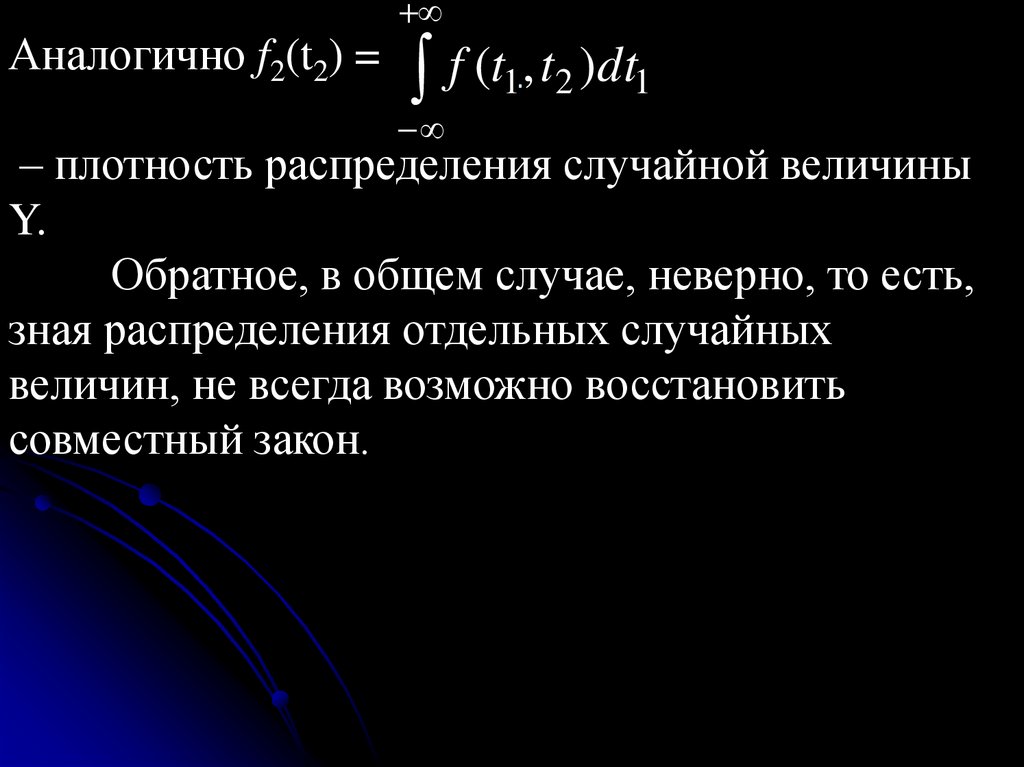

Аналогично f2(t2) =f (t1, t2 )dt1

.

– плотность распределения случайной величины

Y.

Обратное, в общем случае, неверно, то есть,

зная распределения отдельных случайных

величин, не всегда возможно восстановить

совместный закон.

162.

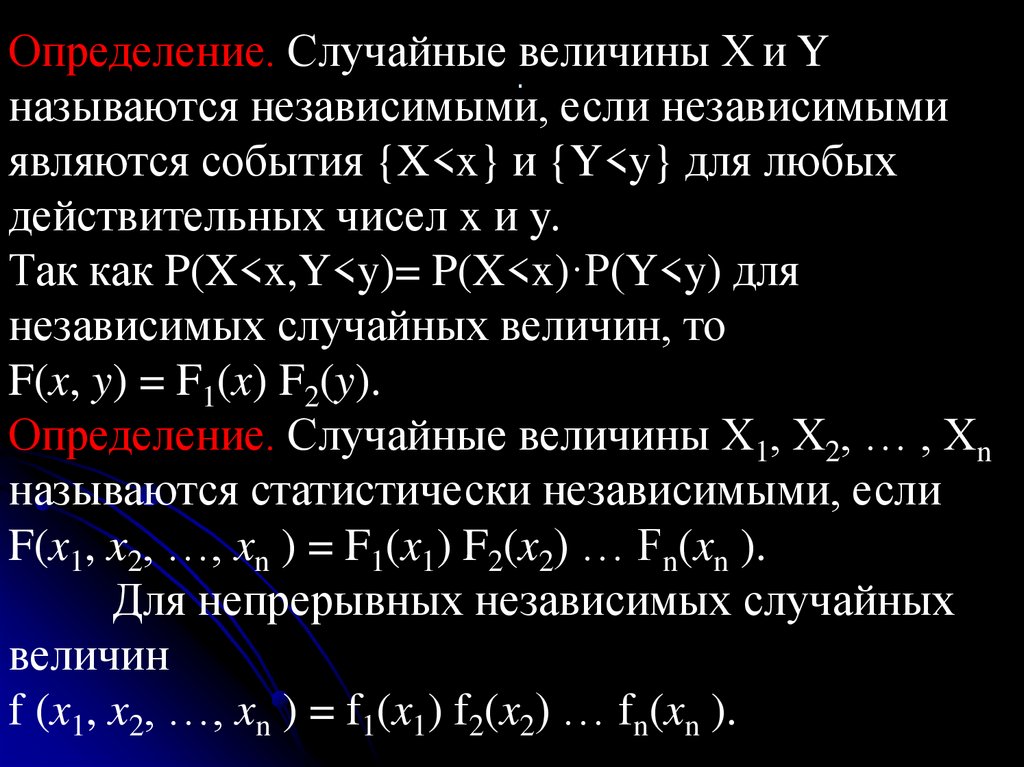

Определение. Случайные .величины Х и Yназываются независимыми, если независимыми

являются события {X<x} и {Y<y} для любых

действительных чисел x и y.

Так как P(X<x,Y<y)= P(X<x)·P(Y<y) для

независимых случайных величин, то

F(x, y) = F1(x) F2(y).

Определение. Случайные величины Х1, Х2, … , Хn

называются статистически независимыми, если

F(x1, x2, …, xn ) = F1(x1) F2(x2) … Fn(xn ).

Для непрерывных независимых случайных

величин

f (x1, x2, …, xn ) = f1(x1) f2(x2) … fn(xn ).

163.

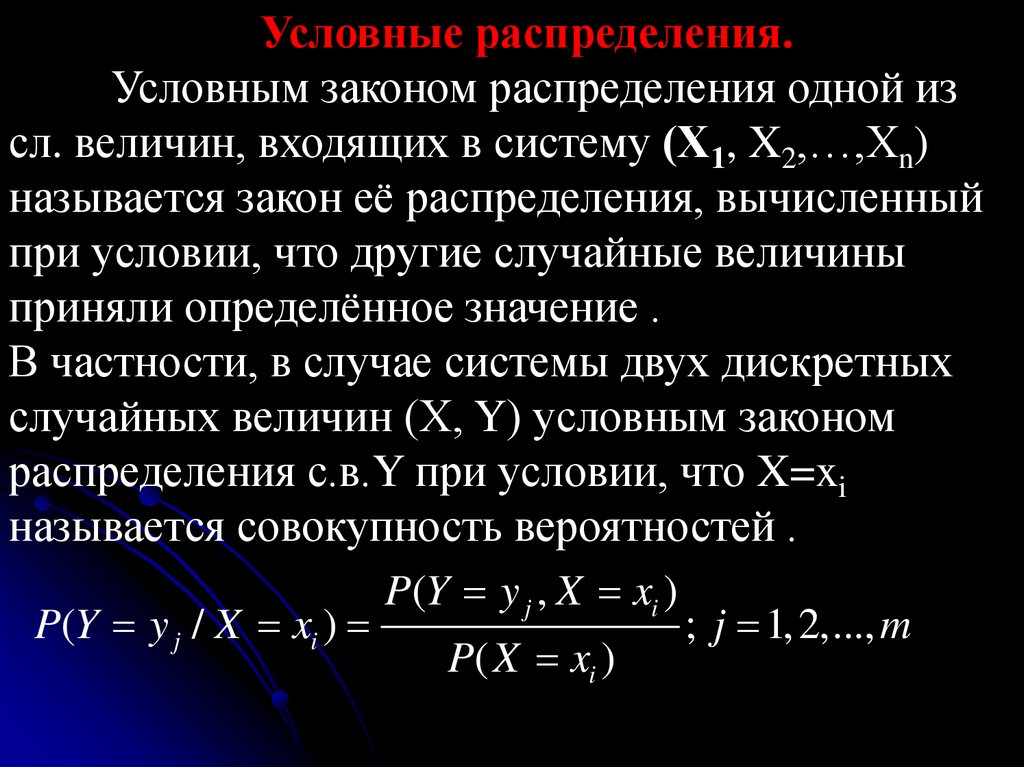

Условные распределения.Условным законом распределения одной из

сл. величин, входящих в систему (Х1, X2,…,Xn)

называется закон её распределения, вычисленный

при условии, что другие случайные величины

приняли определённое значение .

В частности, в случае системы двух дискретных

случайных величин (Х, Y) условным законом

распределения с.в.Y при условии, что X=xi

называется совокупность вероятностей .

P(Y y j , X xi )

P(Y y j / X xi )

; j 1, 2,..., m

P( X xi )

164.

Аналогично,P( X xi / Y y j )

P( X xi , Y y j )

P(Y y j )

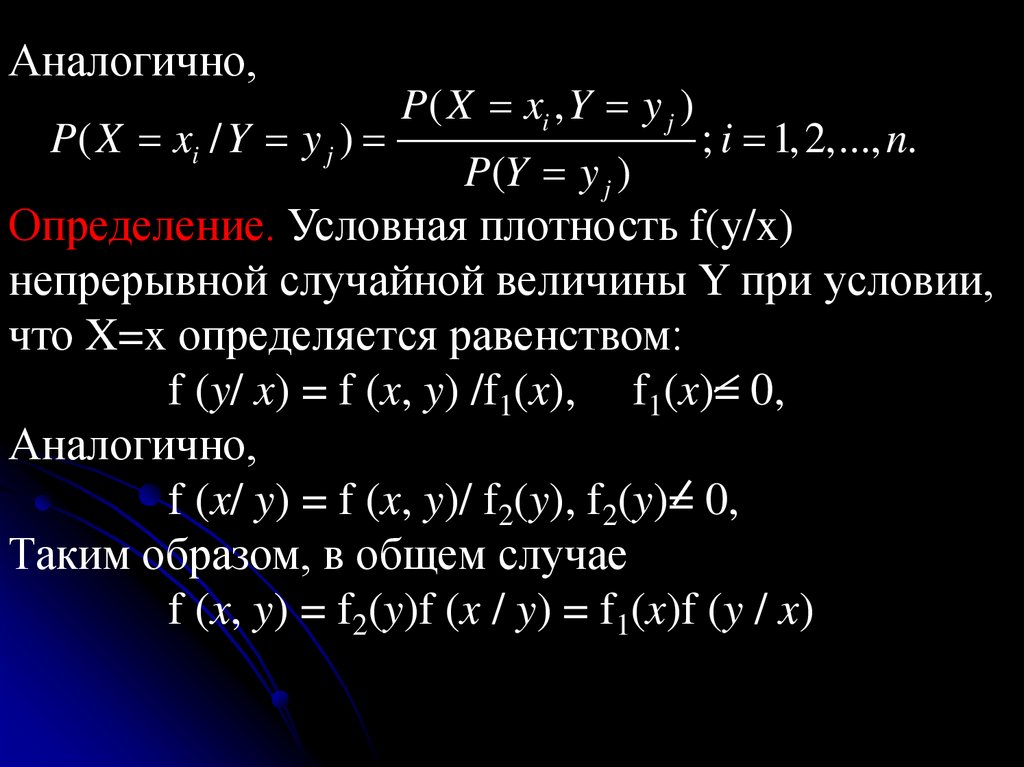

; i 1, 2,..., n.

Определение. Условная плотность f(y/x)

непрерывной случайной величины Y при условии,

что X=x определяется равенством:

f (y/ x) = f (x, y) /f1(x), f1(x)= 0,

Аналогично,

f (x/ y) = f (x, y)/ f2(y), f2(y)= 0,

Таким образом, в общем случае

f (x, y) = f2(y)f (x / y) = f1(x)f (y / x)

165.

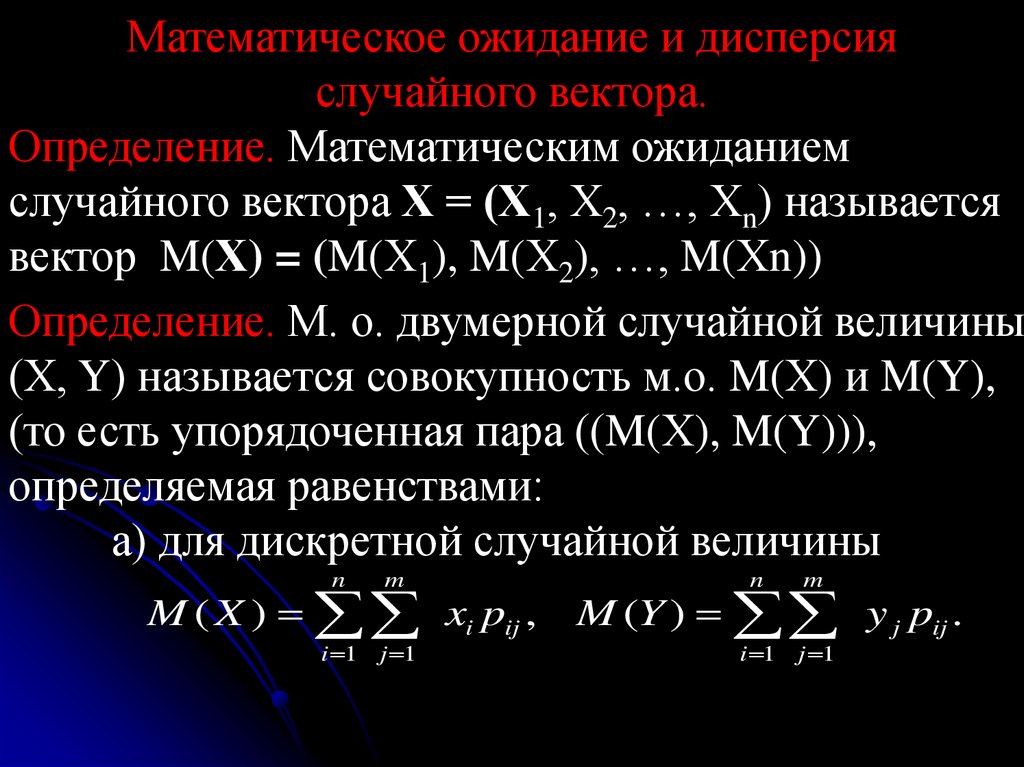

Математическое ожидание и дисперсияслучайного вектора.

Определение. Математическим ожиданием

случайного вектора Х = (Х1, Х2, …, Хn) называется

вектор M(Х) = (M(Х1), M(Х2), …, M(Хn))

Определение. М. о. двумерной случайной величины

(Х, Y) называется совокупность м.о. M(Х) и M(Y),

(то есть упорядоченная пара ((M(Х), M(Y))),

определяемая равенствами:

а) для дискретной случайной величины

n

m

M ( X ) xi pij ,

i 1 j 1

n

m

M (Y ) y j pij .

i 1 j 1

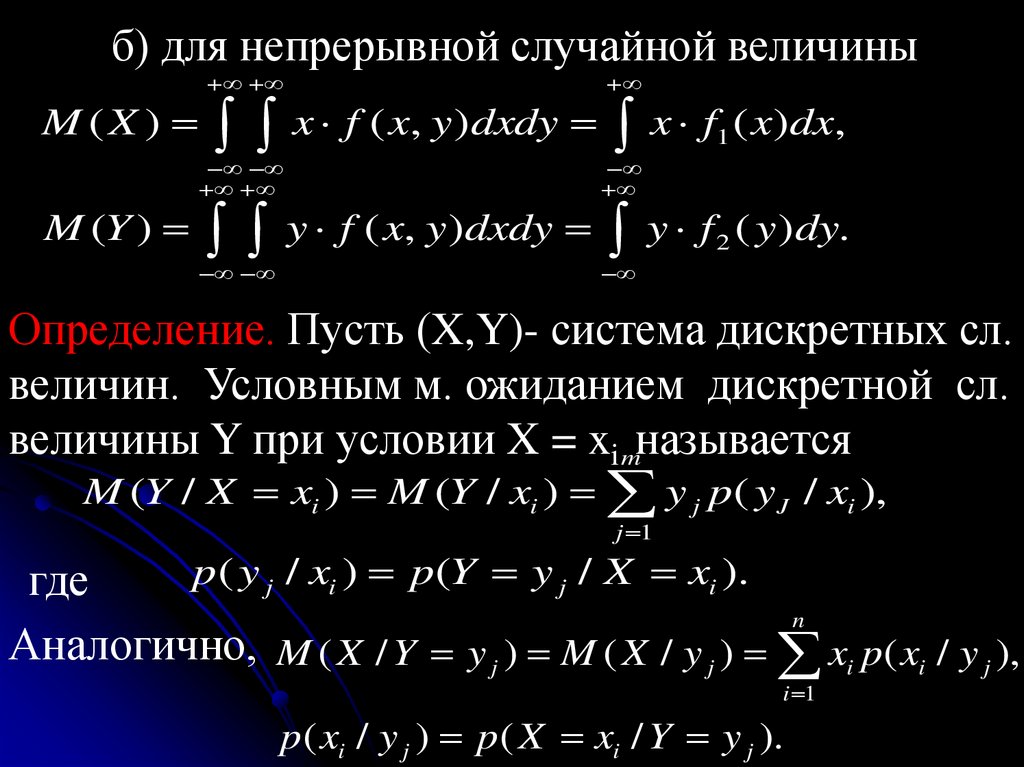

166.

б) для непрерывной случайной величиныM ( X ) x f ( x, y )dxdy x f1 ( x)dx,

M (Y ) y f ( x, y )dxdy y f 2 ( y )dy.

Определение. Пусть (X,Y)- система дискретных сл.

величин. Условным м. ожиданием дискретной сл.

величины Y при условии X = ximназывается

M (Y / X xi ) M (Y / xi ) y j p( y J / xi ),

j 1

p( y j / xi ) p(Y y j / X xi ).

где

n

Аналогично, M ( X / Y y j ) M ( X / y j ) xi p( xi / y j ),

i 1

p ( xi / y j ) p ( X xi / Y y j ).

167.

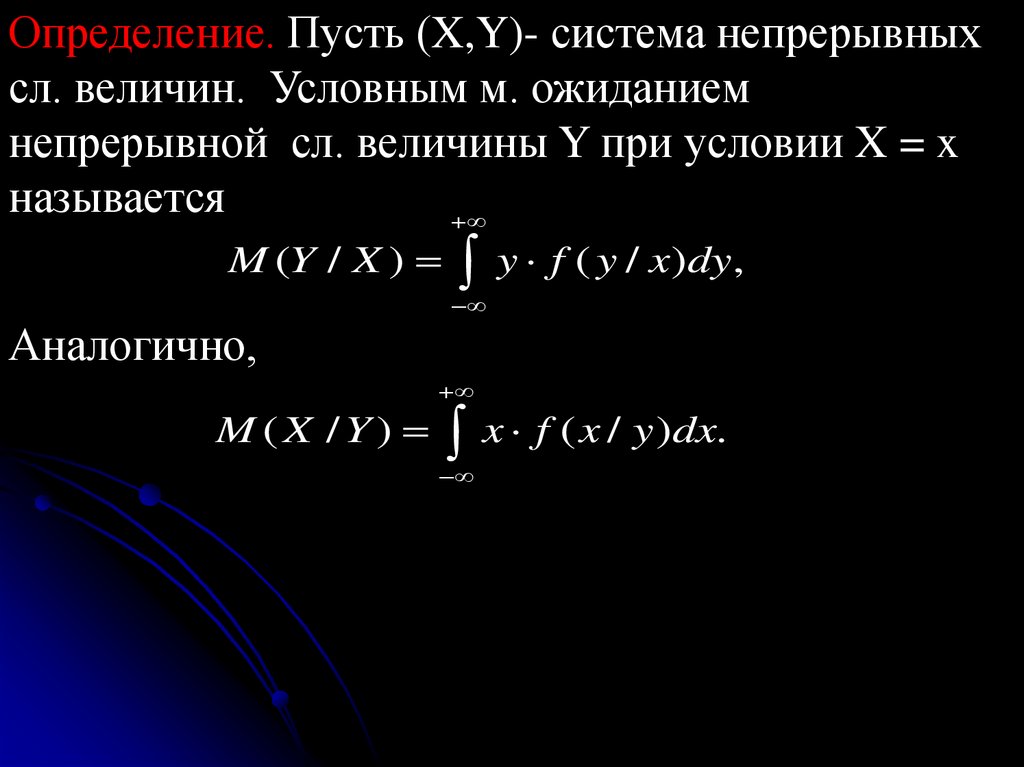

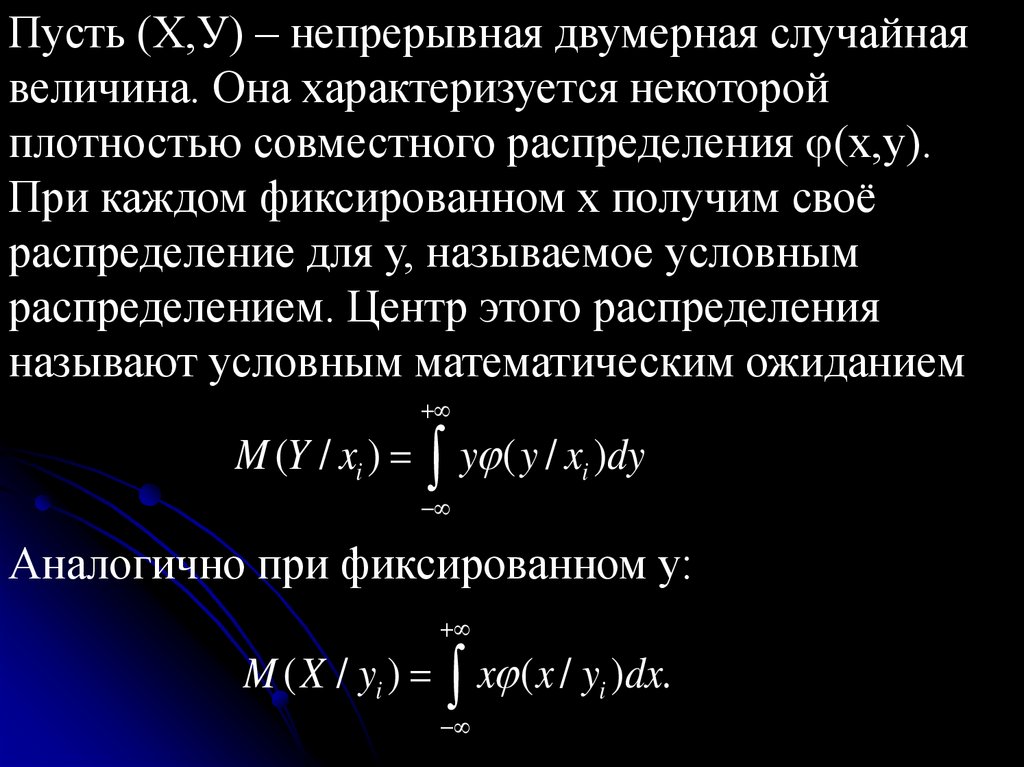

Определение. Пусть (X,Y)- система непрерывныхсл. величин. Условным м. ожиданием

непрерывной сл. величины Y при условии X = x

называется

M (Y / X ) y f ( y / x)dy,

Аналогично,

M ( X / Y ) x f ( x / y )dx.

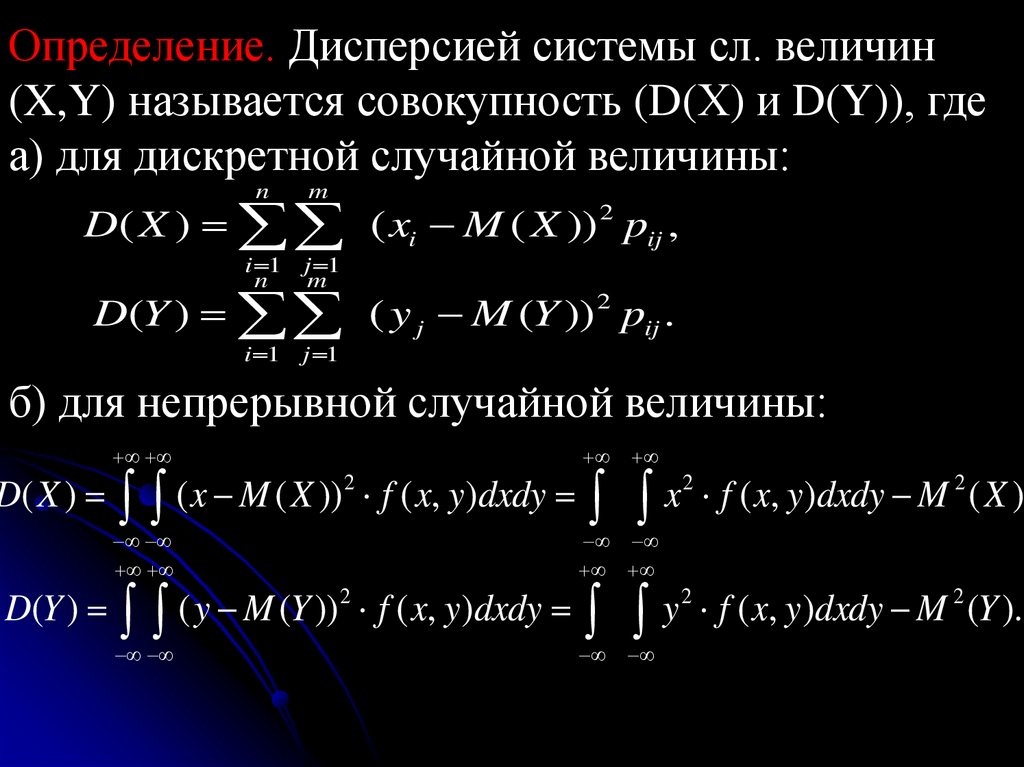

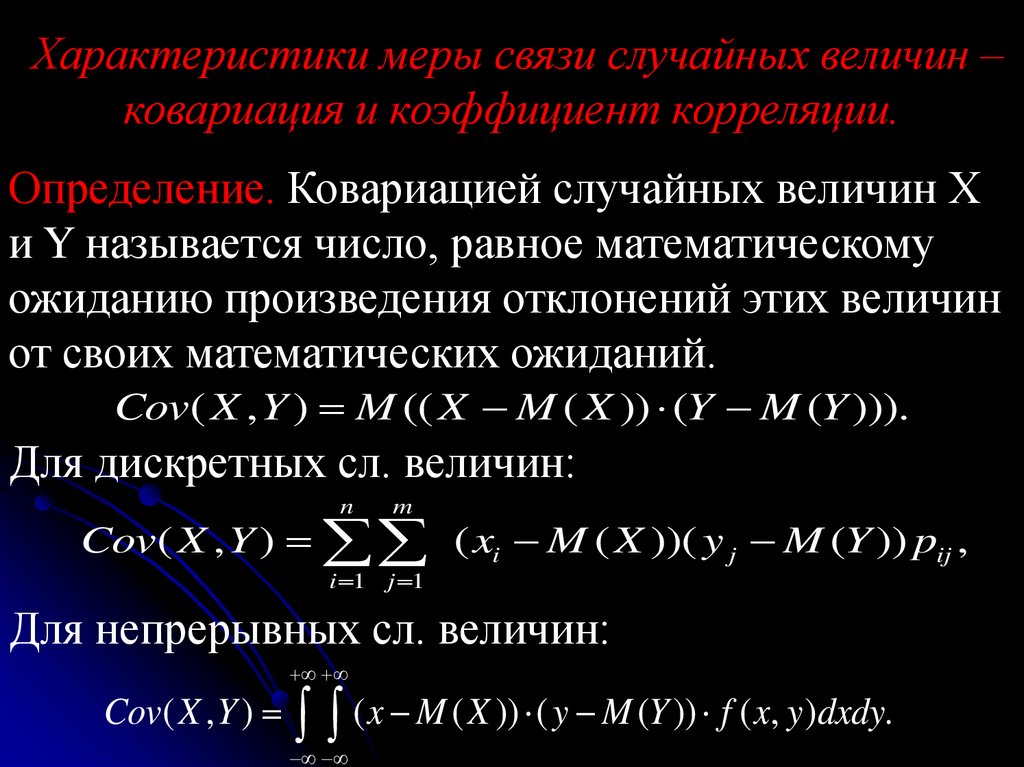

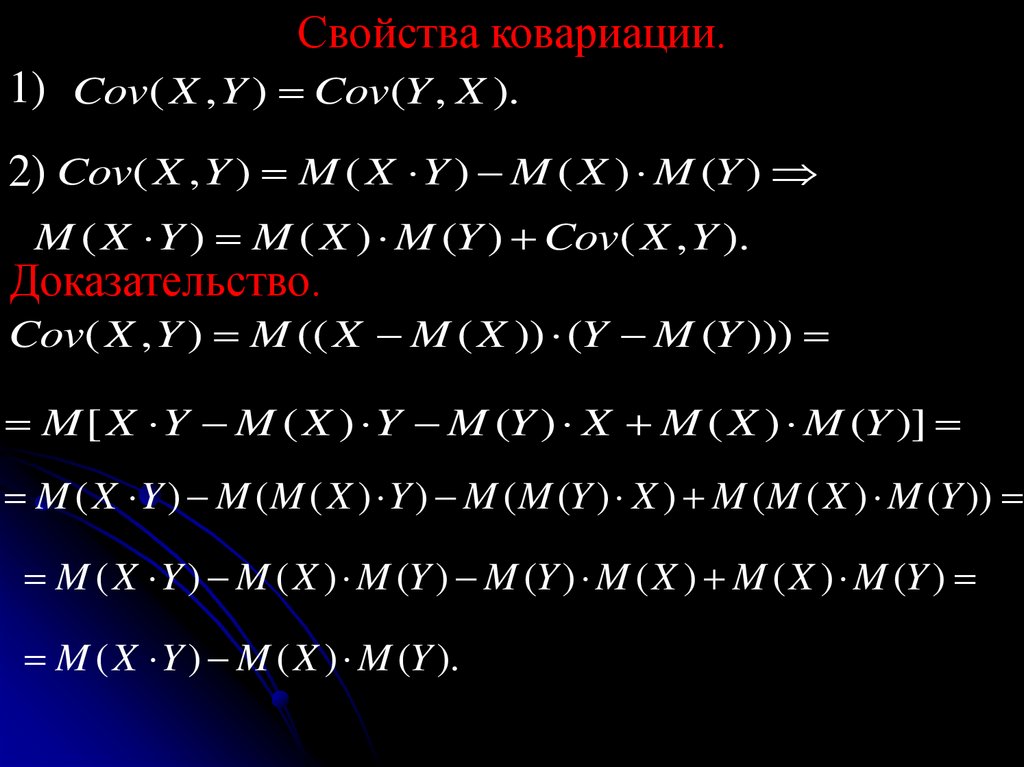

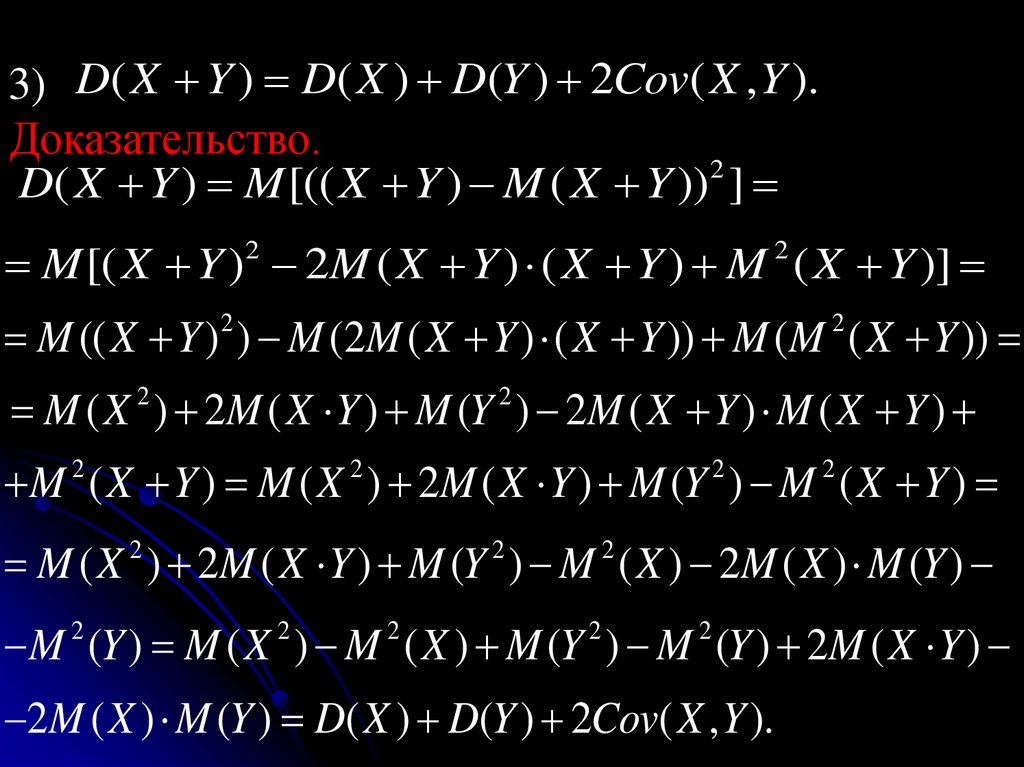

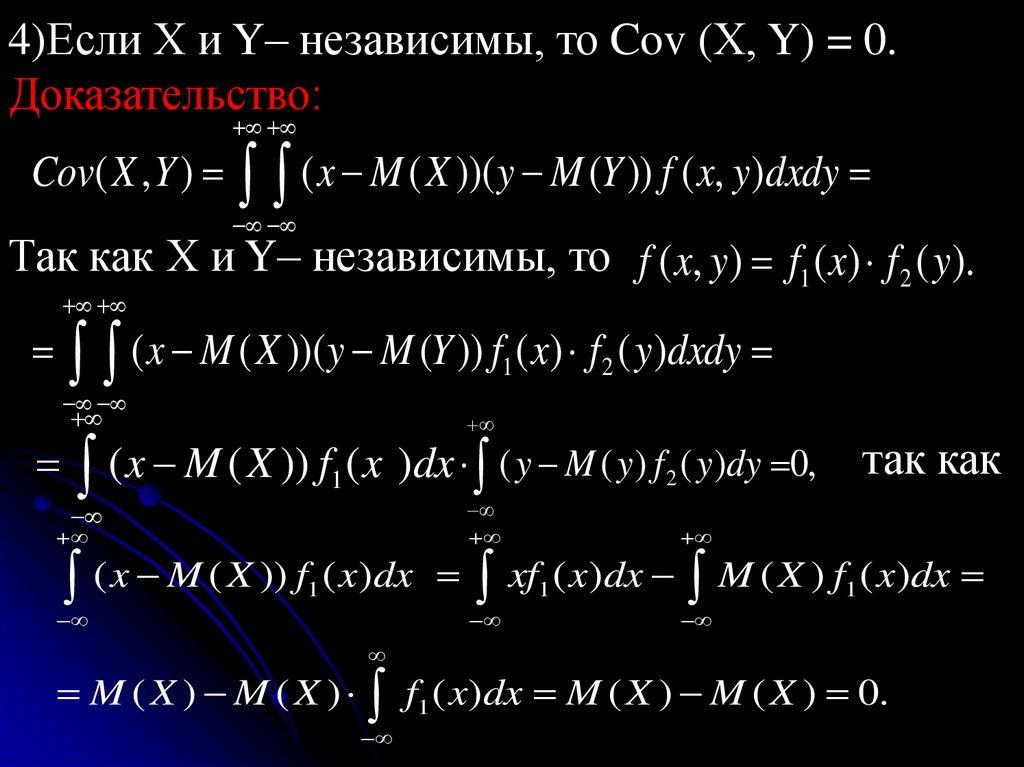

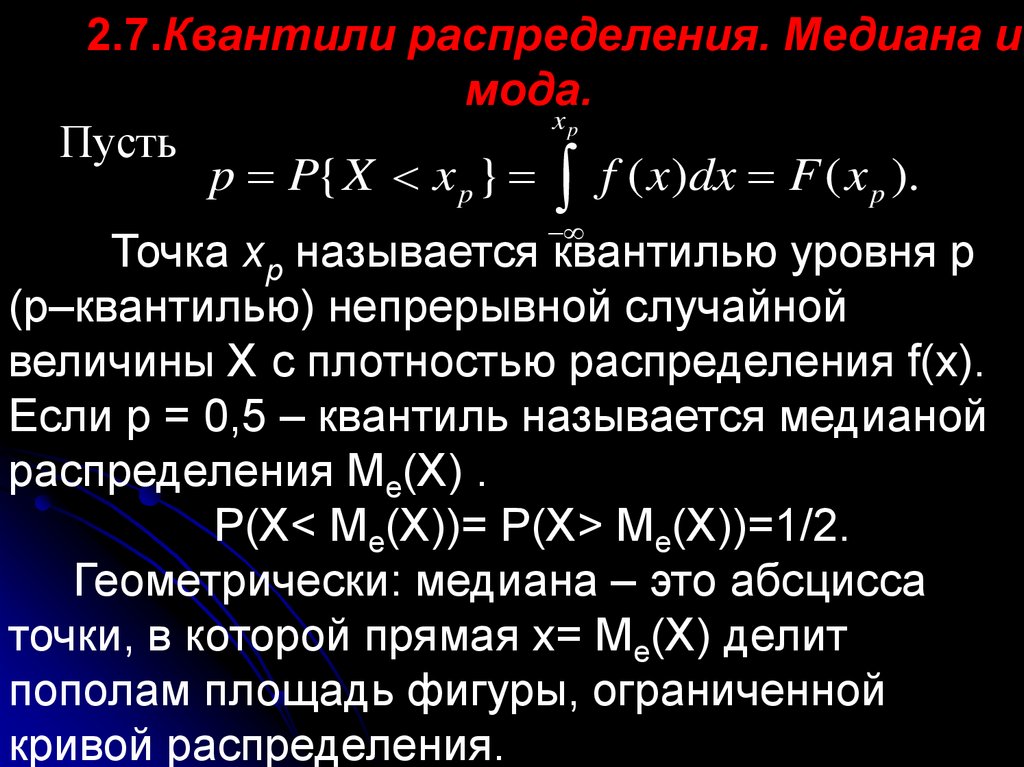

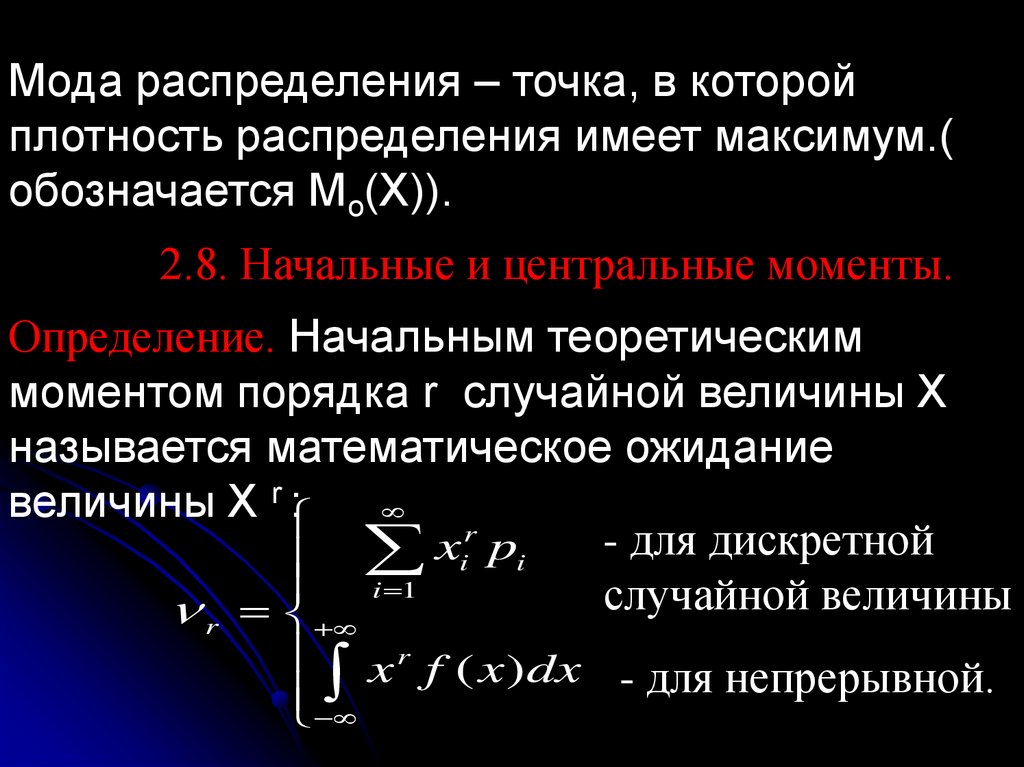

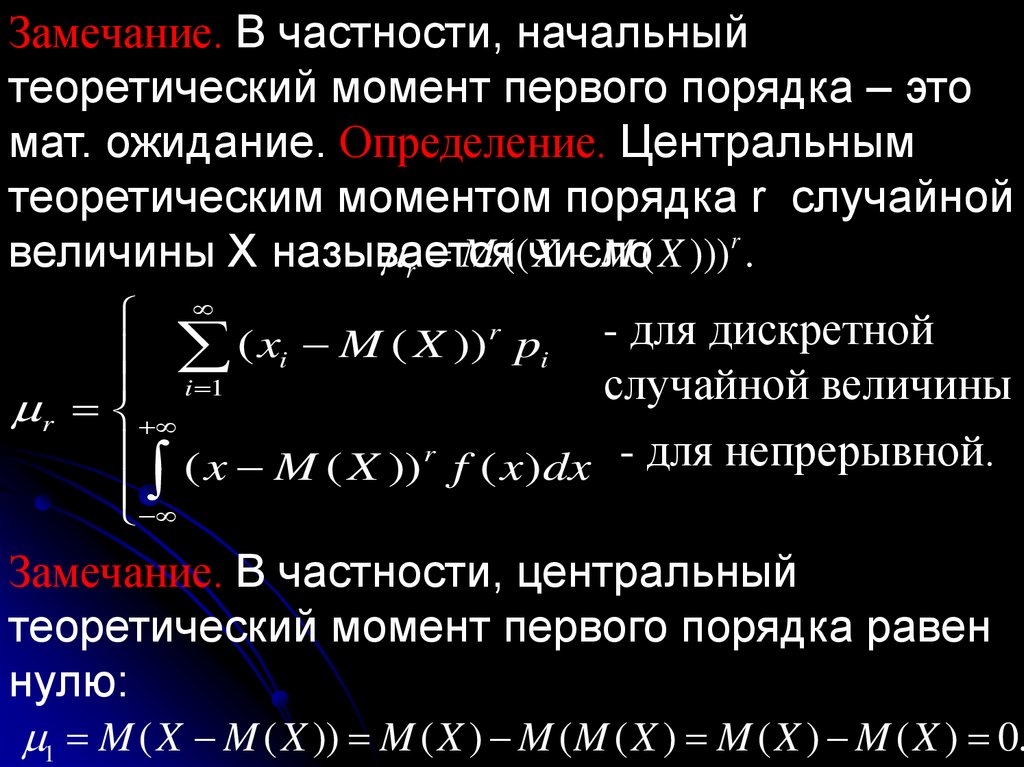

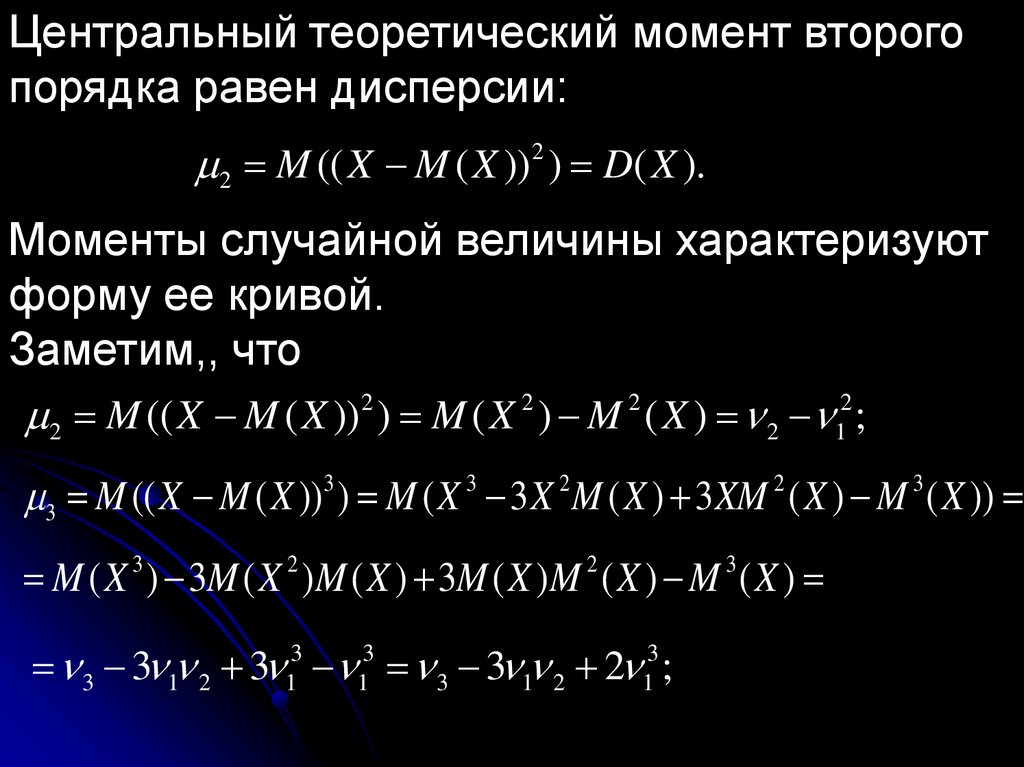

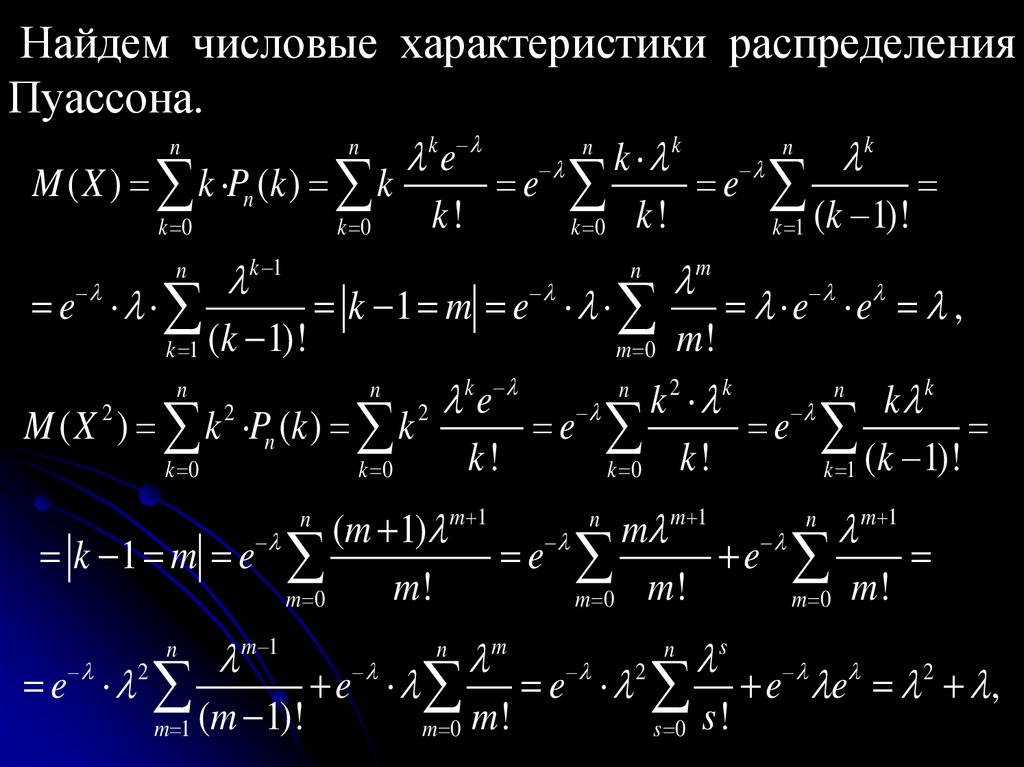

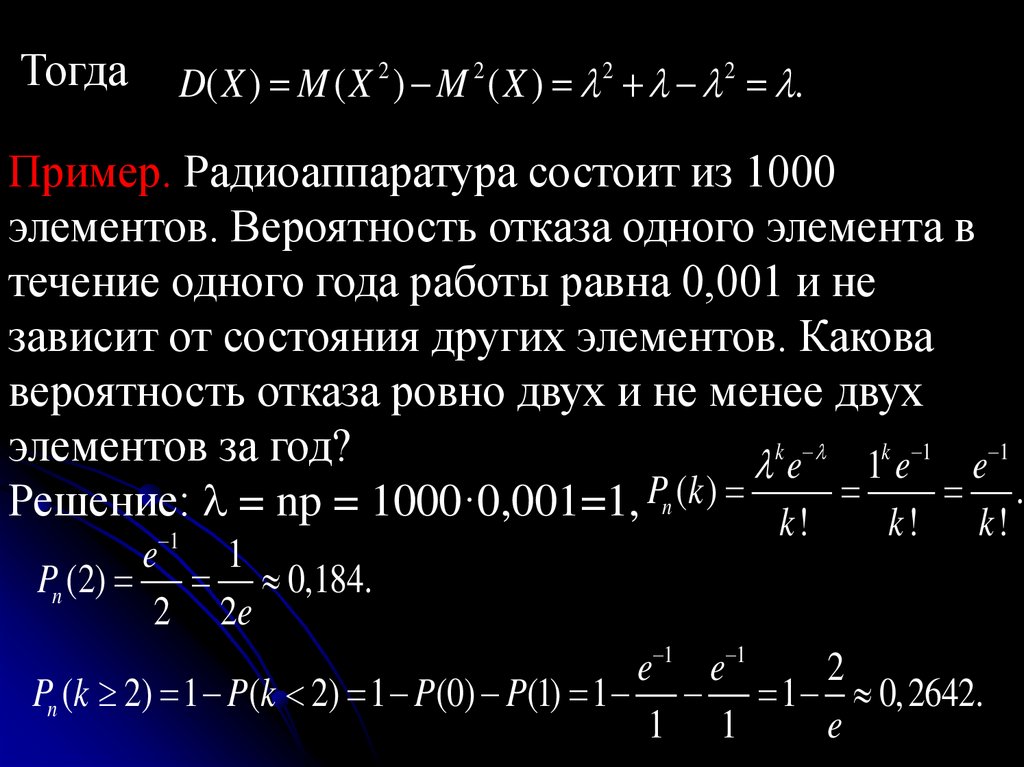

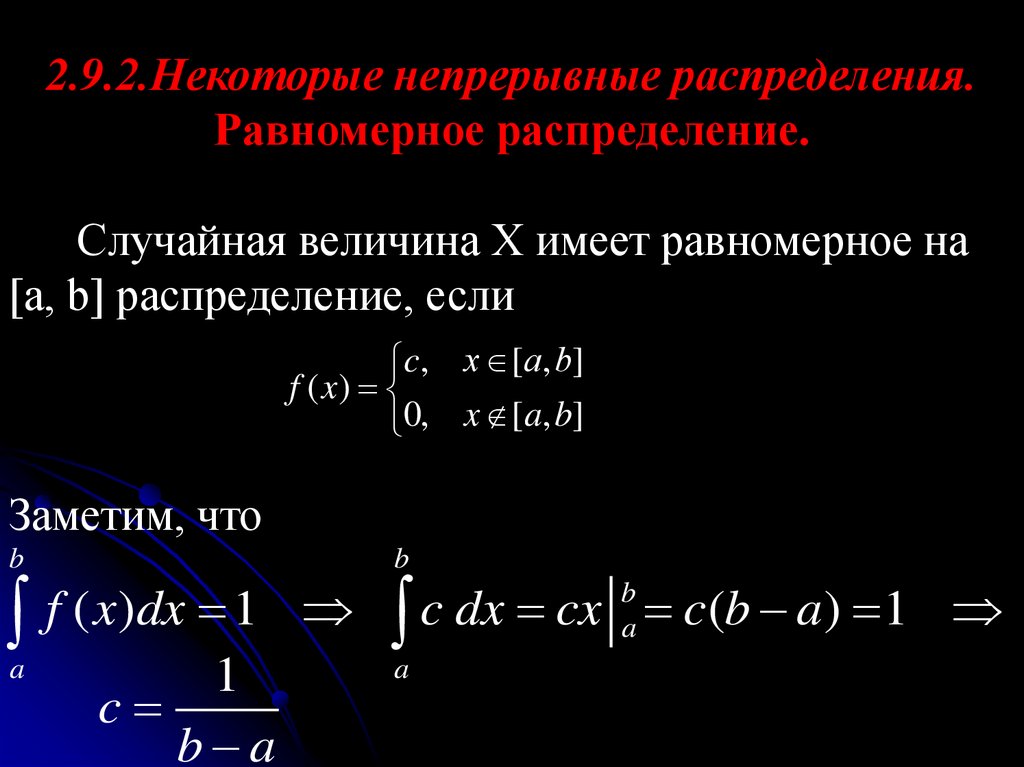

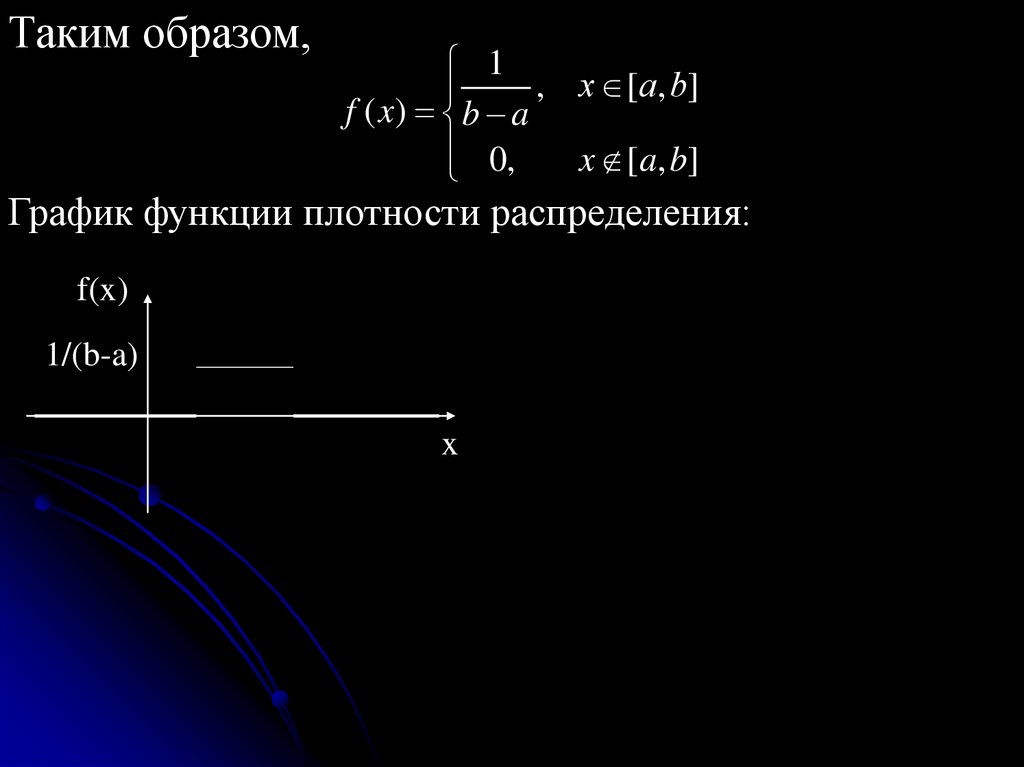

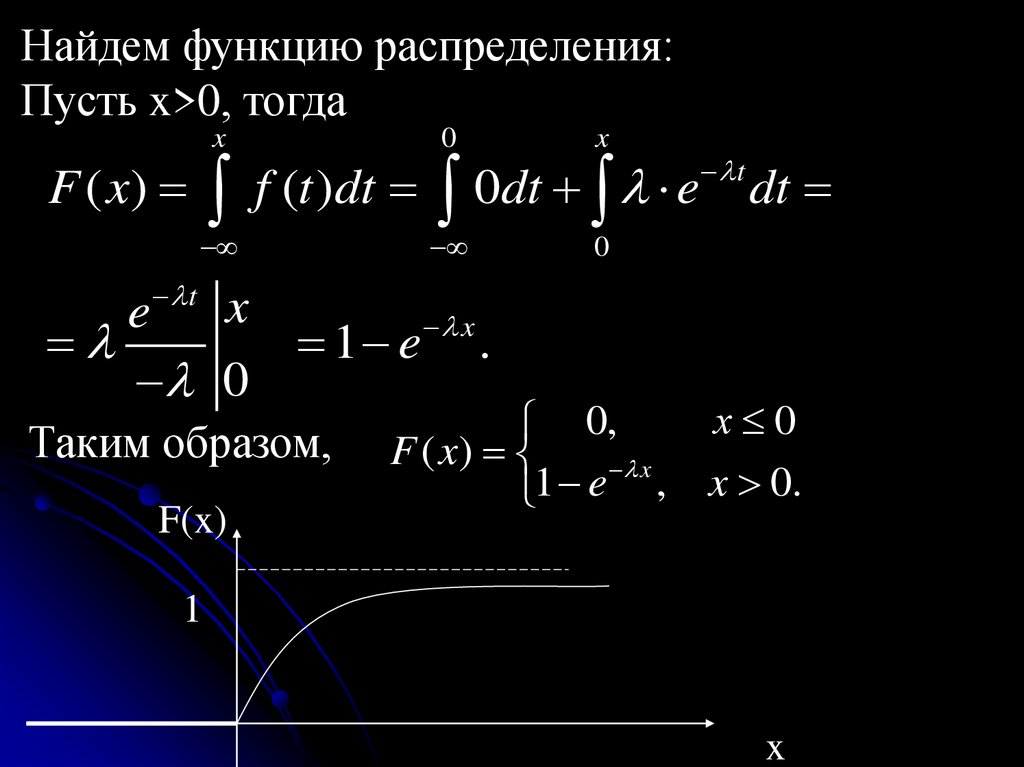

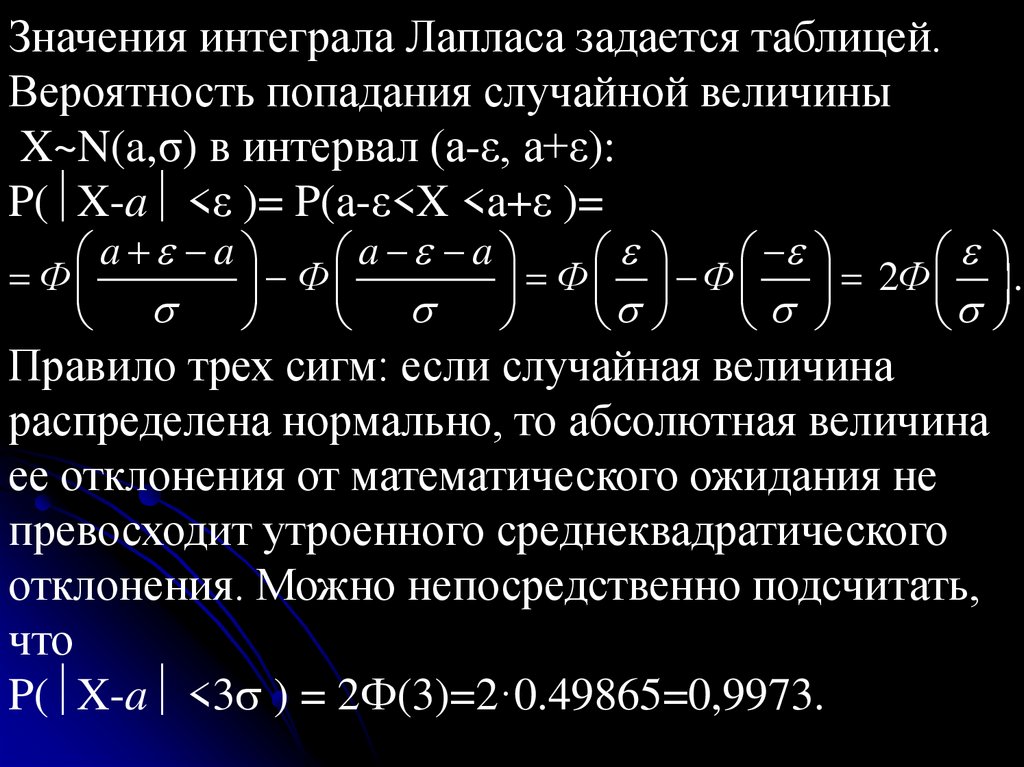

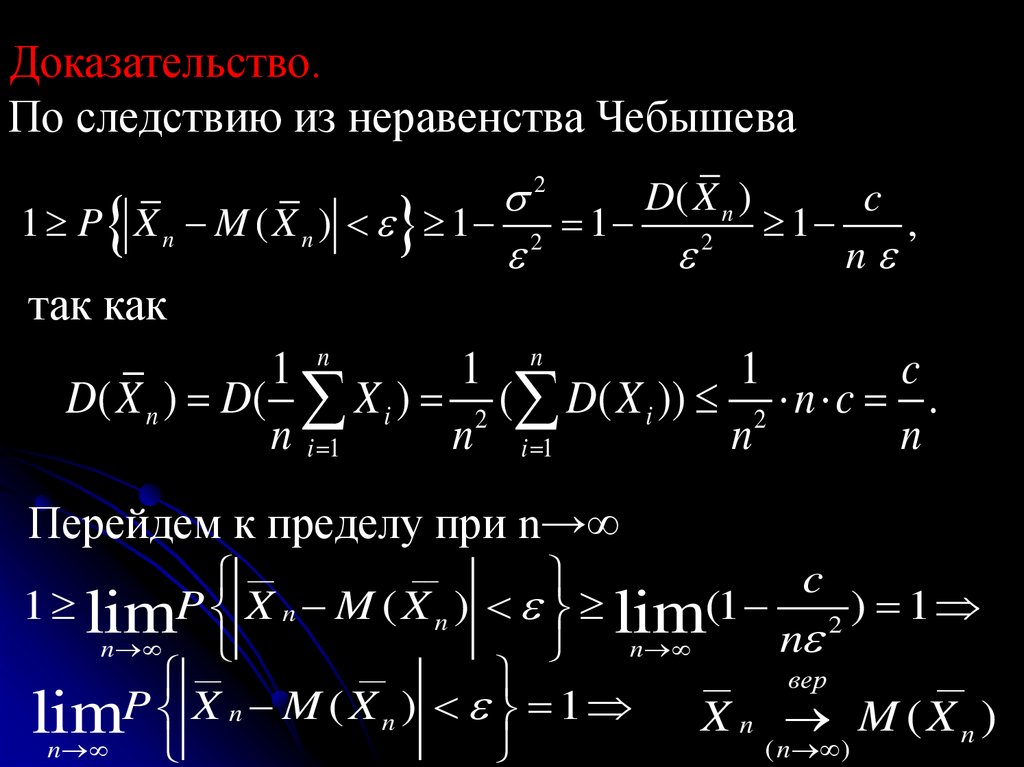

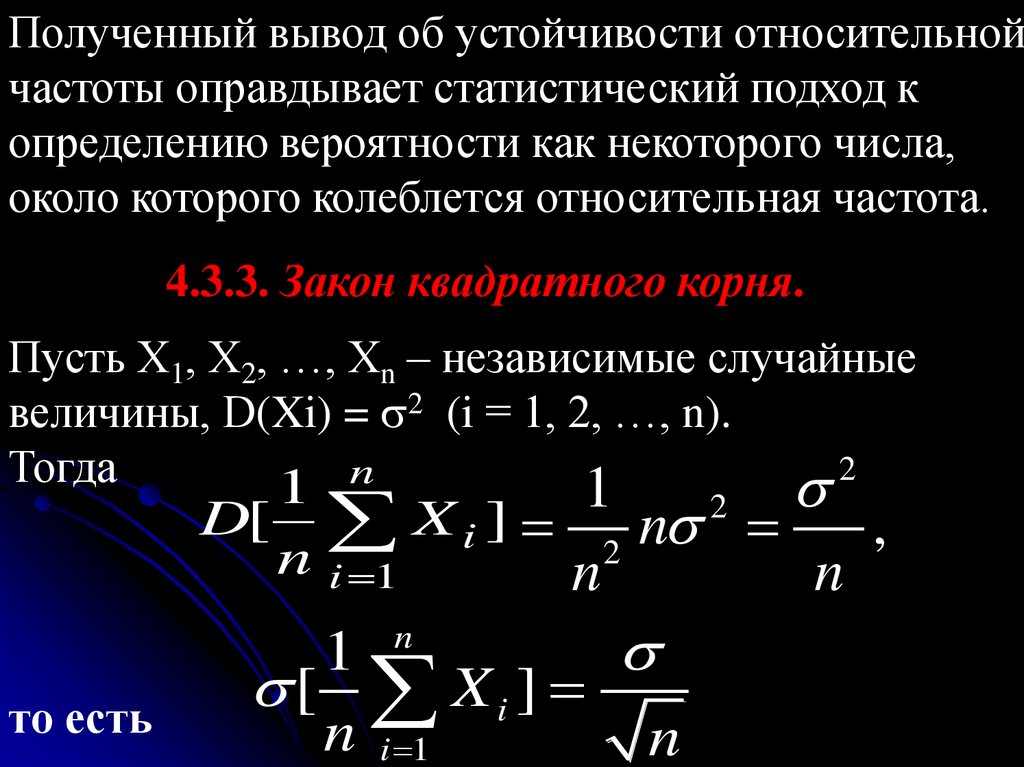

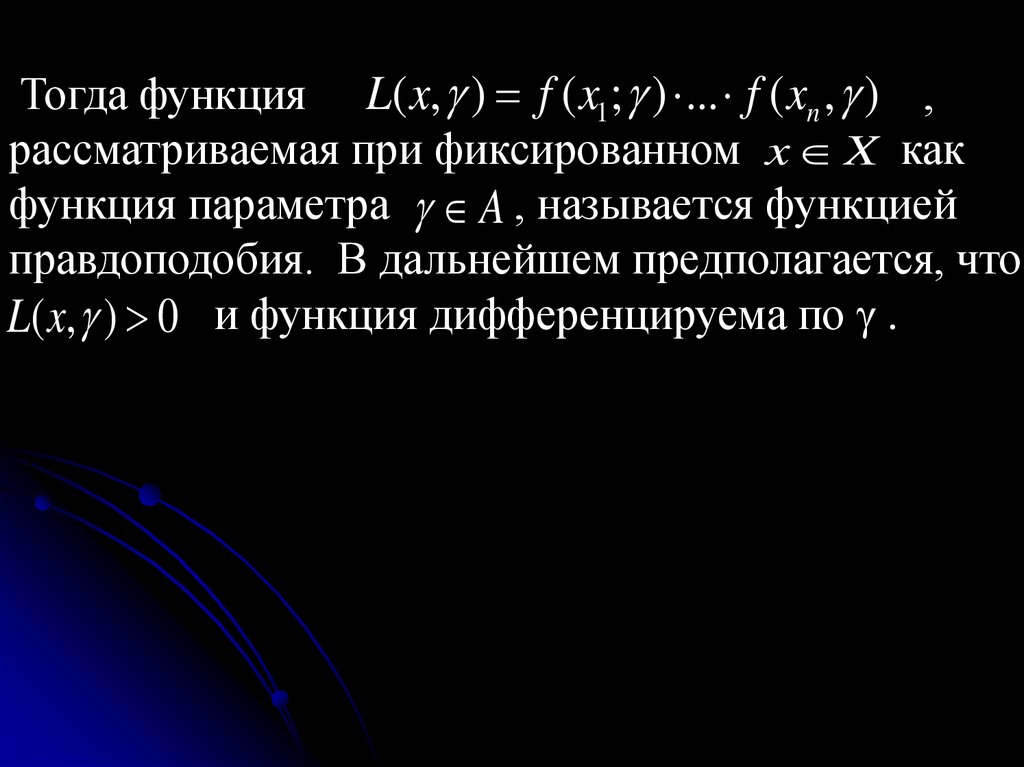

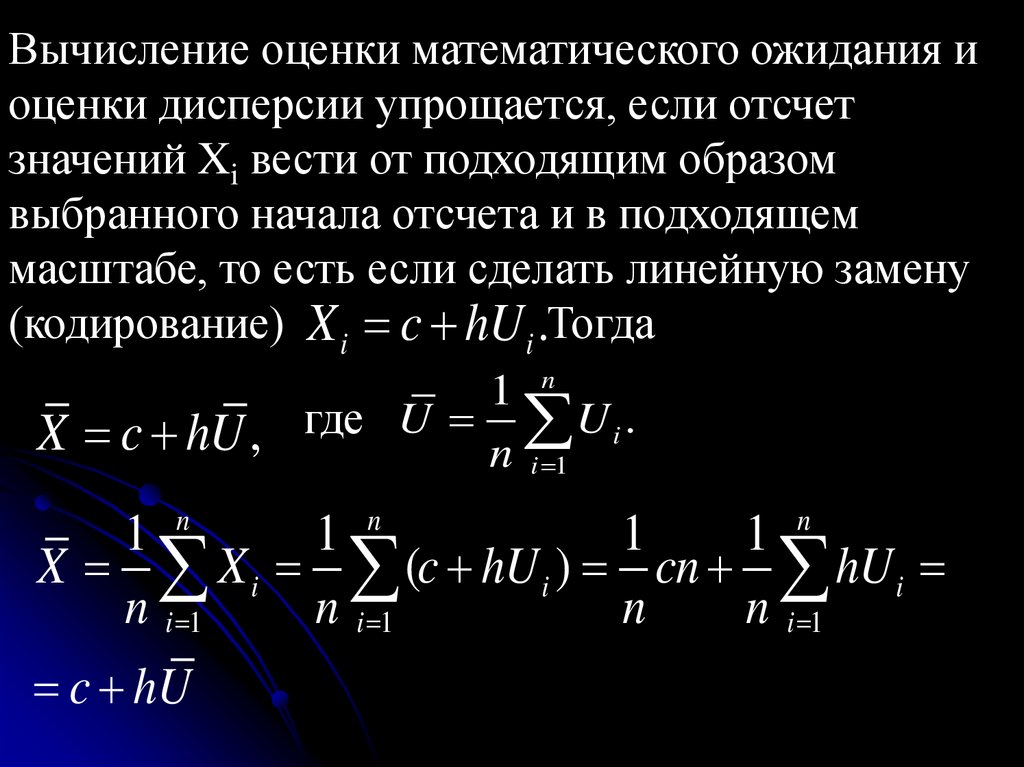

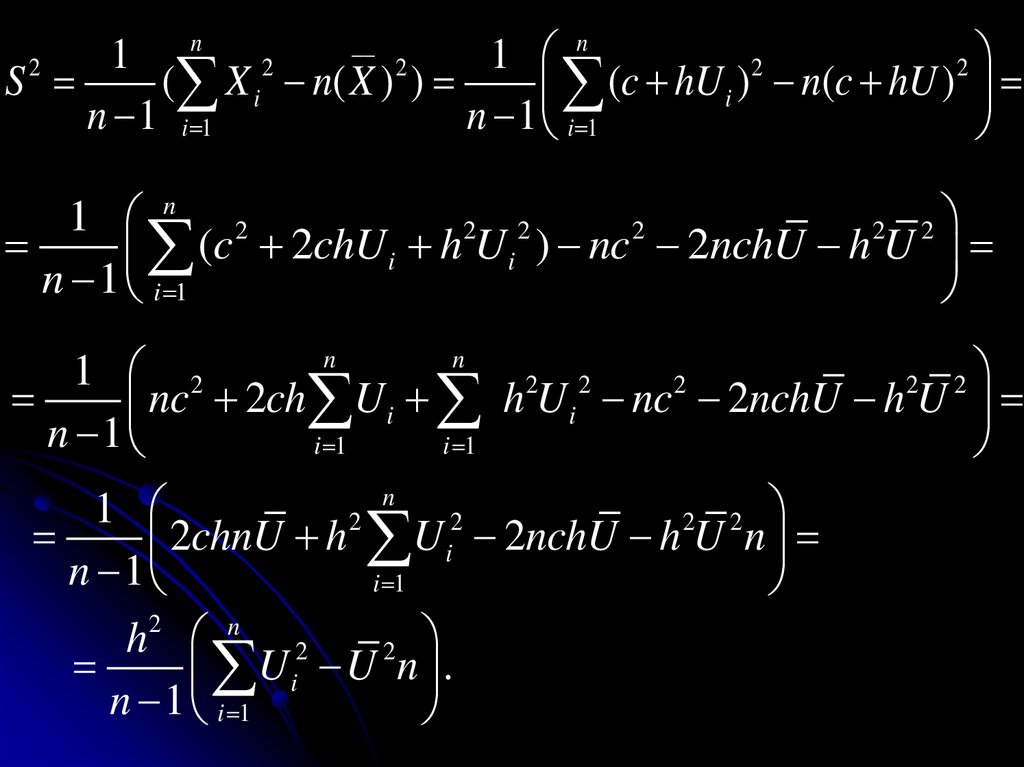

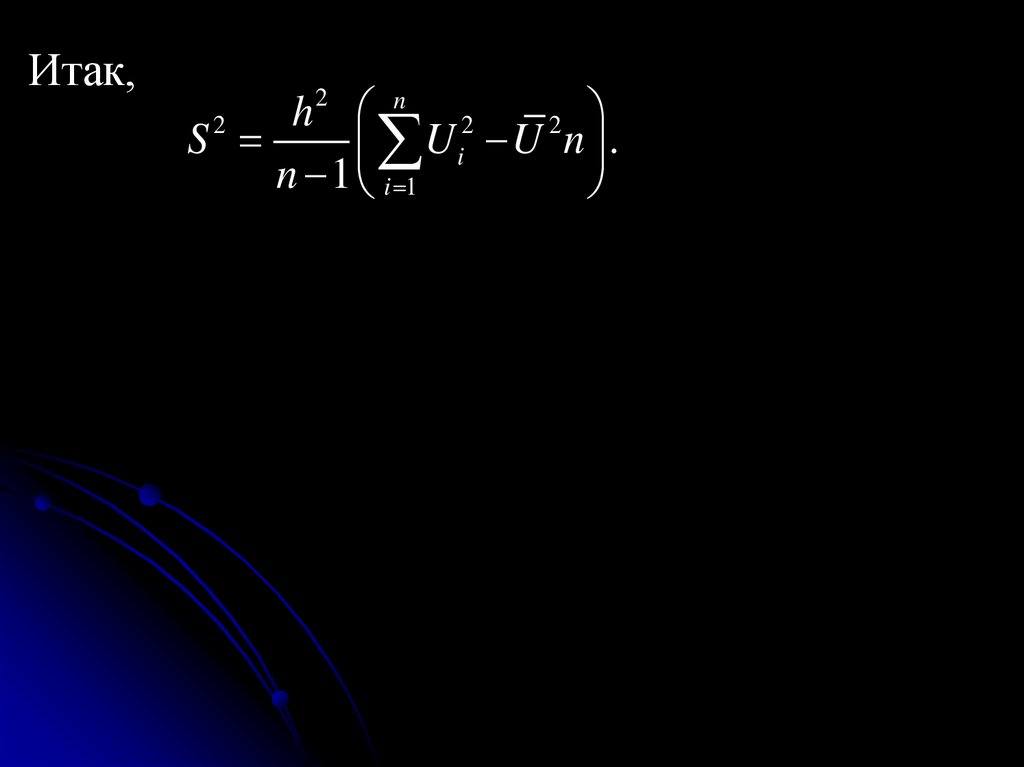

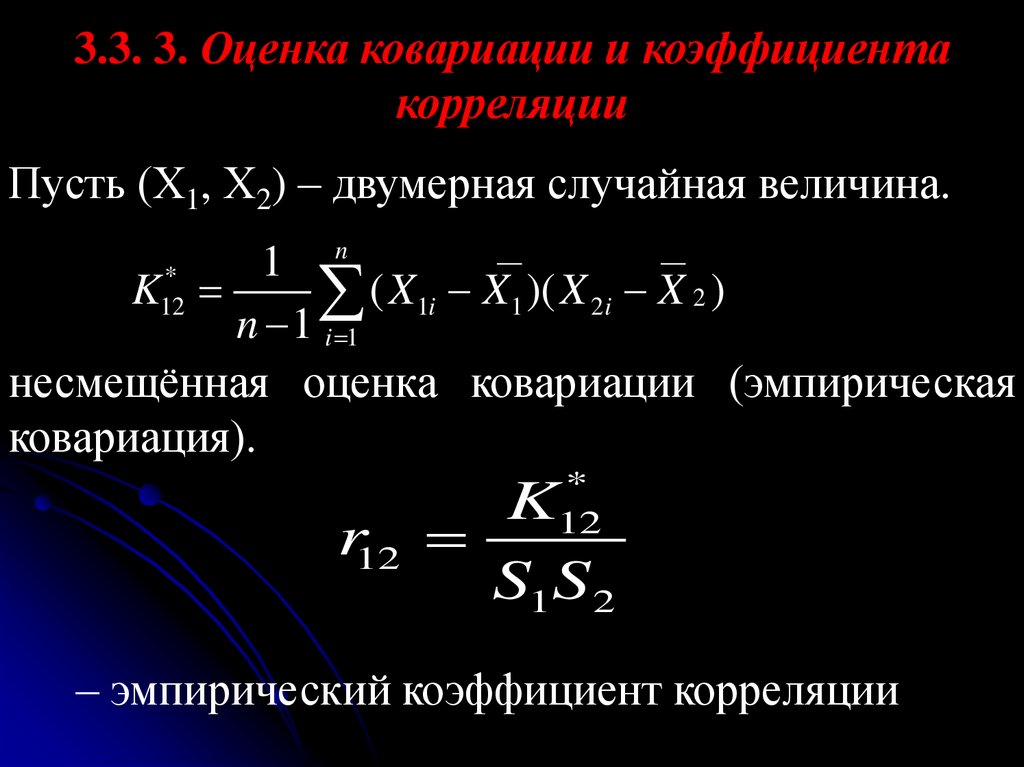

168.