Similar presentations:

Глубокое обучение в задачах классификации

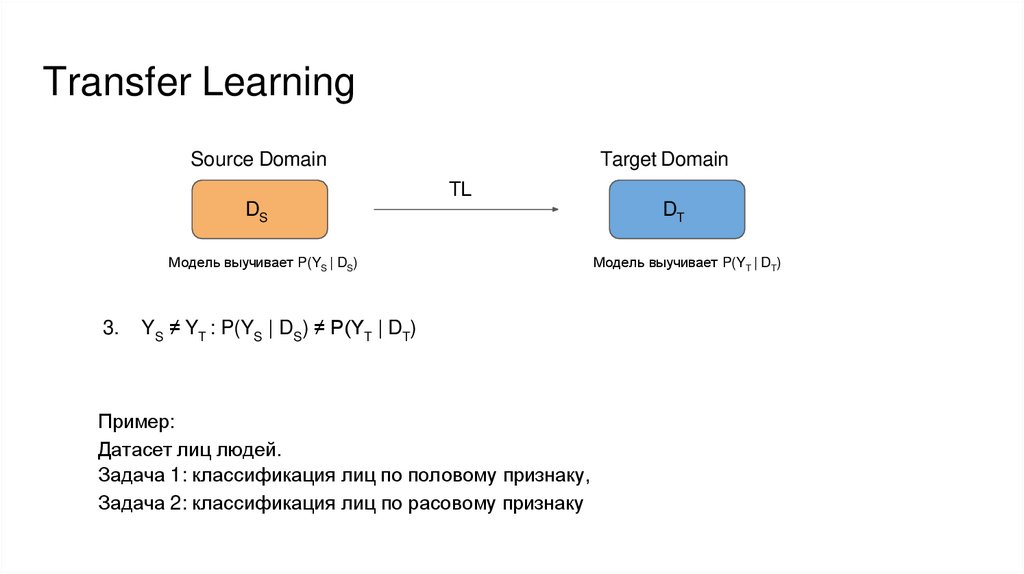

1.

Глубокое обучение в задачах классификацииКульгильдин Булат Наилевич

Инженер 2 категории, лаборатории 3050

ФГУП «Государственный научно-исследовательский

институт авиационных систем»

2.

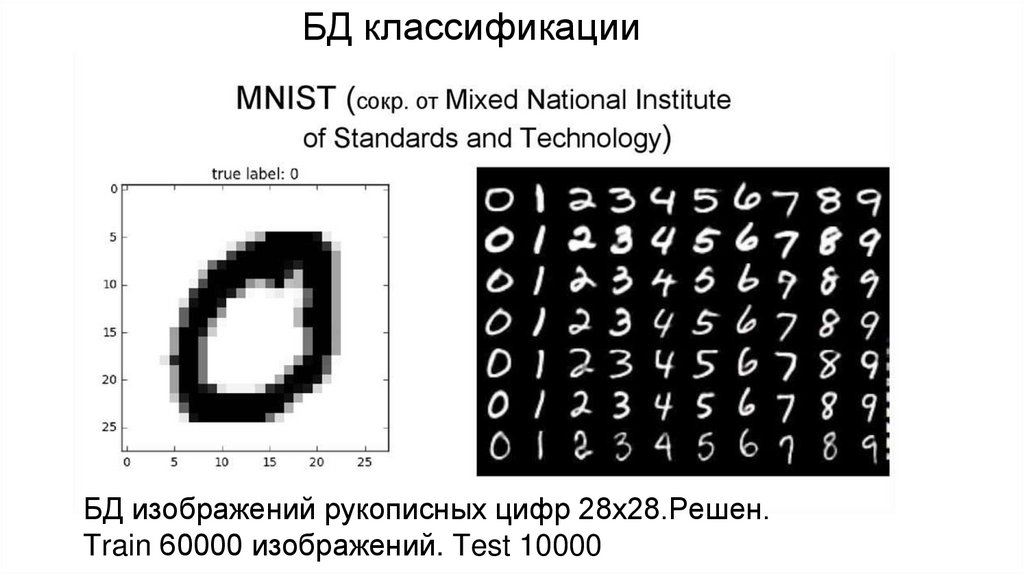

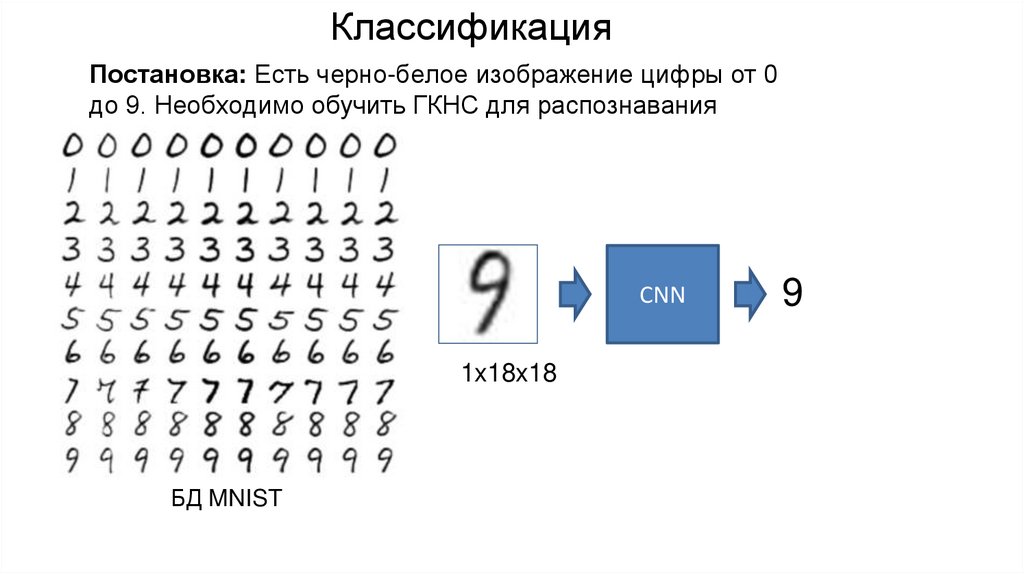

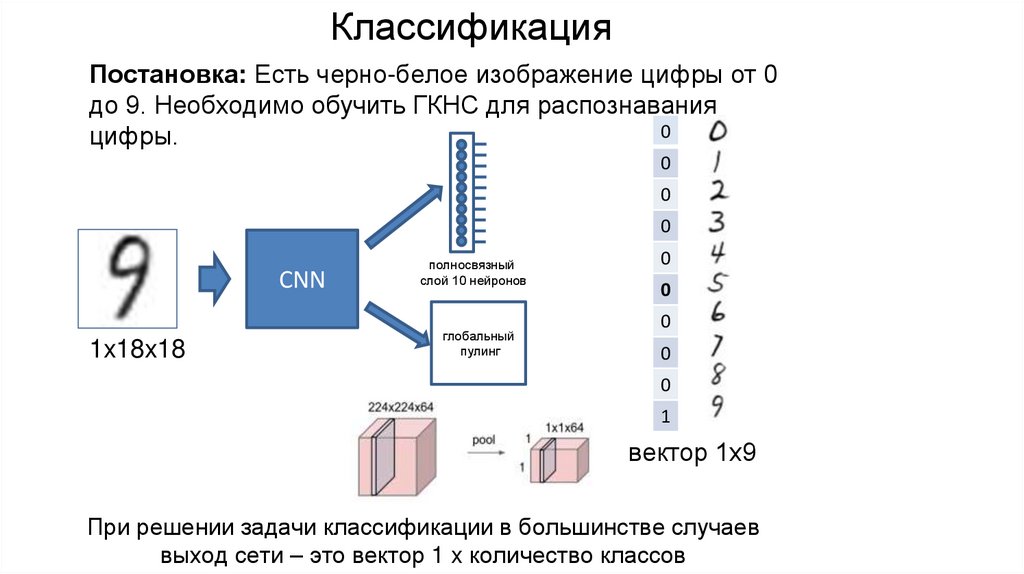

КлассификацияПример постановки: Есть черно-белое изображение

цифры от 0 до 9. Необходимо обучить ГКНС для

распознавания цифры.

10

0,04

-20

0,01

15

0,02

7

0,01

18

0.016

33

0.023

16

0.015

0

0.01

12

0.017

94

0.25

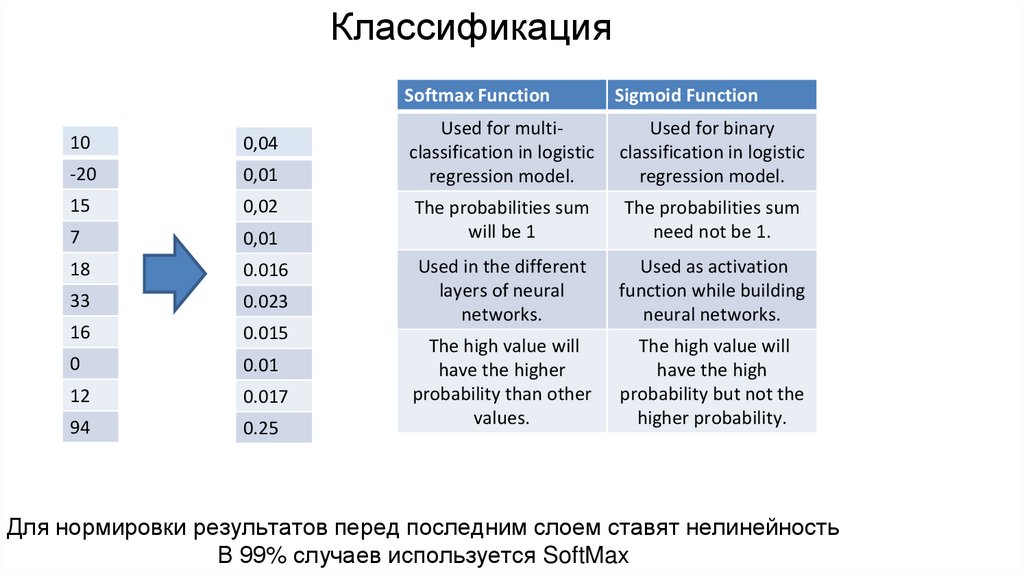

Для нормировки результатов перед последним слоем ставят нелинейность

3.

Классификация10

0,04

-20

0,01

15

0,02

7

0,01

18

0.016

33

0.023

16

0.015

0

0.01

12

0.017

94

0.25

Softmax Function

Sigmoid Function

Used for multiclassification in logistic

regression model.

Used for binary

classification in logistic

regression model.

The probabilities sum

will be 1

The probabilities sum

need not be 1.

Used in the different

layers of neural

networks.

Used as activation

function while building

neural networks.

The high value will

have the higher

probability than other

values.

The high value will

have the high

probability but not the

higher probability.

Для нормировки результатов перед последним слоем ставят нелинейность

В 99% случаев используется SoftMax

4.

Классификация0

0.1

0

0.1

0

0.09

0

0.05

CNN

0

0.09

0

0.02

0

0.05

0

0.05

0

0.05

1.0

0.4

Правильный ответ

Выход ГКНС

Кросс-энтропийная функция потерь

5.

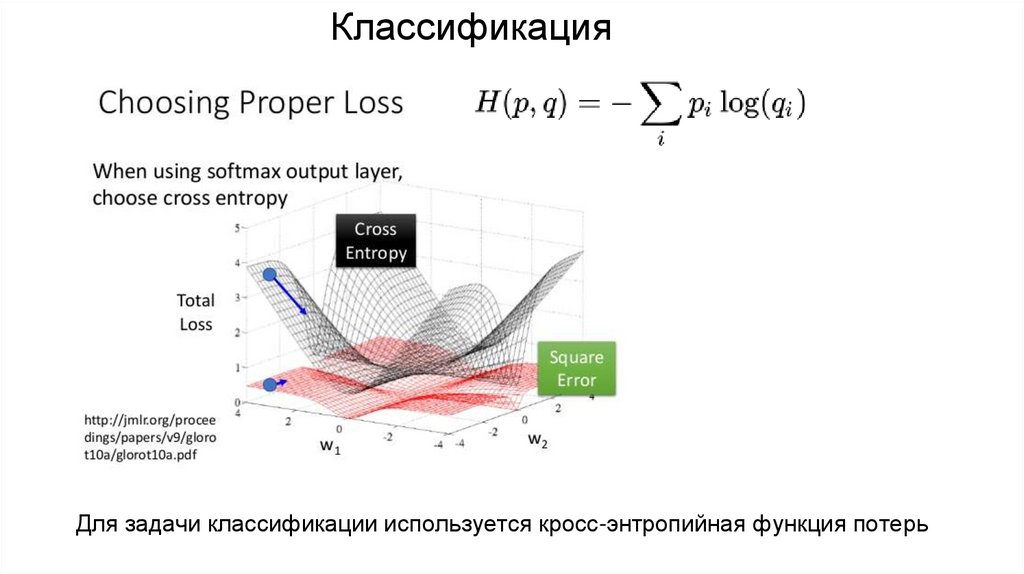

КлассификацияДля задачи классификации используется кросс-энтропийная функция потерь

6.

Обучение ГКНС1. Выбрать БД

2. Выбрать архитектуру ГКНС

3. Провести обучение ГКНС

1. Провести тестирование ГКНС

7.

Обучение ГКНС3

индекс класса

изображение

БД изображений и ответов

8.

Обучение ГКНС1

индекс класса

изображение

БД изображений и ответов

9.

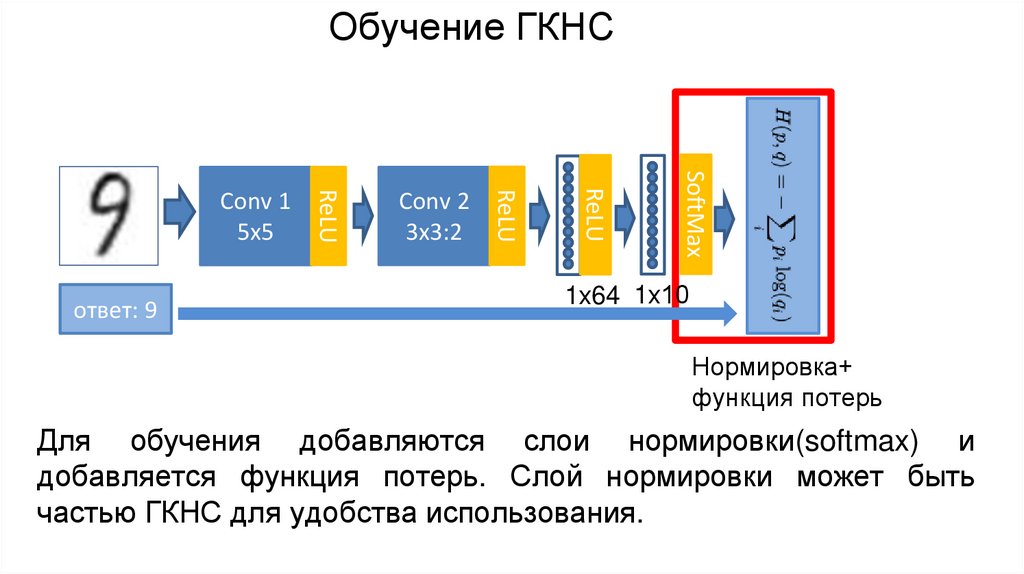

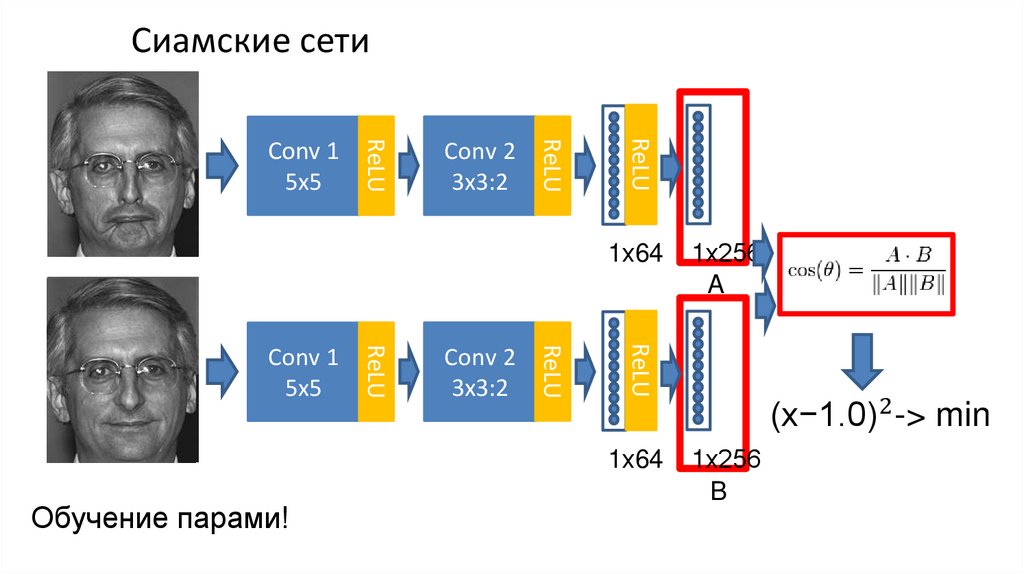

Обучение ГКНСReLU

Conv 2

3x3:2

ReLU

ReLU

Conv 1

5x5

1х64

1х10

Архитектура может быть любой но она должна заканчивается слоем,

выходом которого является вектор 1 х число классов

10.

Обучение ГКНСSoftMax

ReLU

Conv 2

3x3:2

ReLU

ответ: 9

ReLU

Conv 1

5x5

1х64 1х10

Нормировка+

функция потерь

Для обучения добавляются слои нормировки(softmax) и

добавляется функция потерь. Слой нормировки может быть

частью ГКНС для удобства использования.

11.

Обучение ГКНС1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

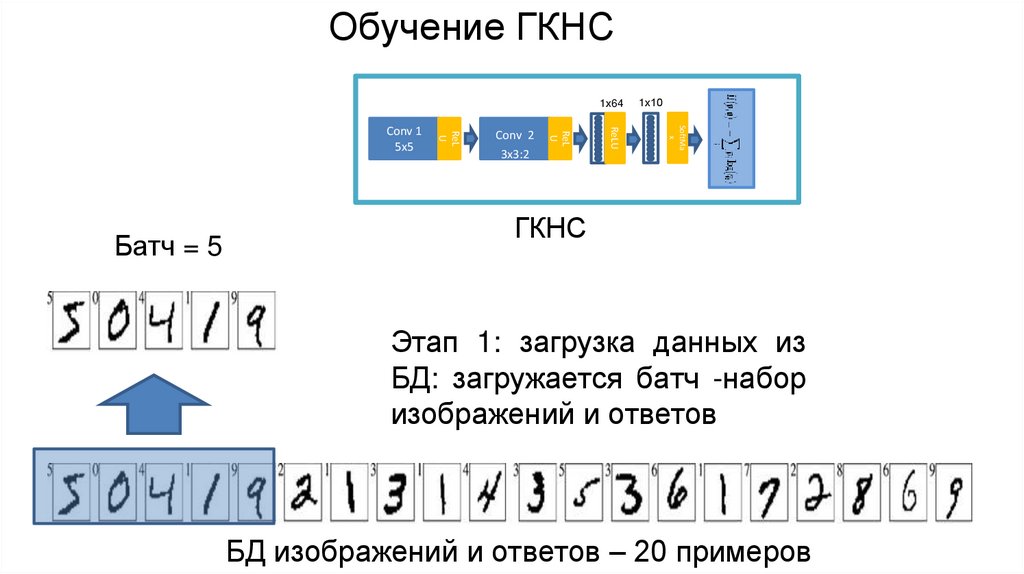

Батч = 5

ReL

U

Conv 1

5x5

1х10

ГКНС

Этап 1: загрузка данных из

БД: загружается батч -набор

изображений и ответов

БД изображений и ответов – 20 примеров

12.

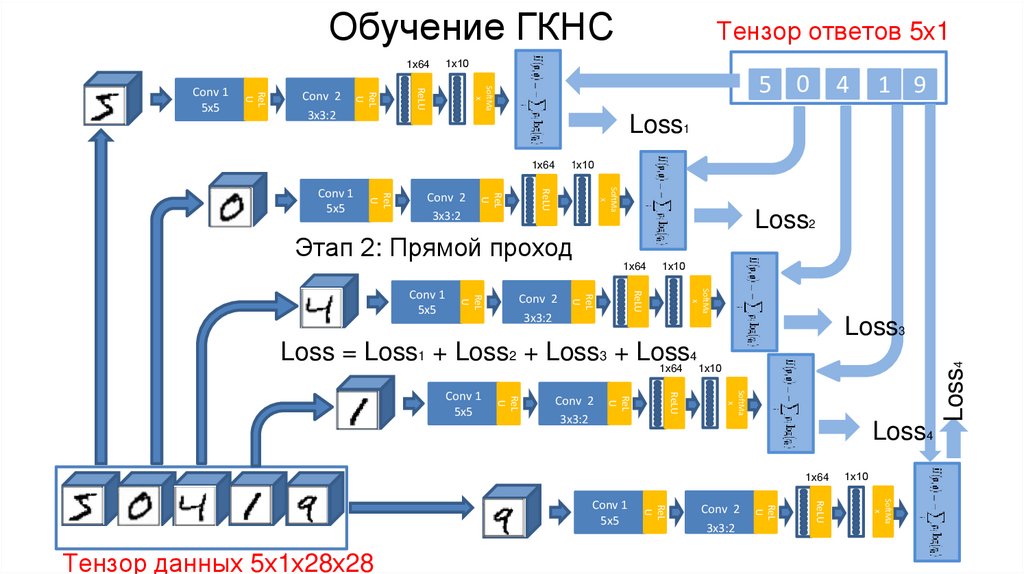

Обучение ГКНСТензор ответов 5х1

5 0 4 1 9

1х10

SoftMa

x

Conv 2

3x3:2

ReL

U

изображения

Conv 1

5x5

ReL

U

5

1х64

ReLU

Тензор данных 5х1х28х28

ГКНС

0

4

1

ответы

9

Этап 2: формирование батча

из БД: предобработка +

трансформация в тензор

БД изображений и ответов – 20 примеров

13.

Обучение ГКНС1х64

1х10

5 0

SoftMa

x

ReLU

1 9

Loss1

1х10

1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

4

Loss2

Этап 2: Прямой проход

1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

1х10

Loss3

Loss = Loss1 + Loss2 + Loss3 + Loss

4

1х64 1х10

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

Loss4

1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

Тензор данных 5х1х28х28

ReL

U

Conv 1

5x5

1х10

Loss4

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

Тензор ответов 5х1

14.

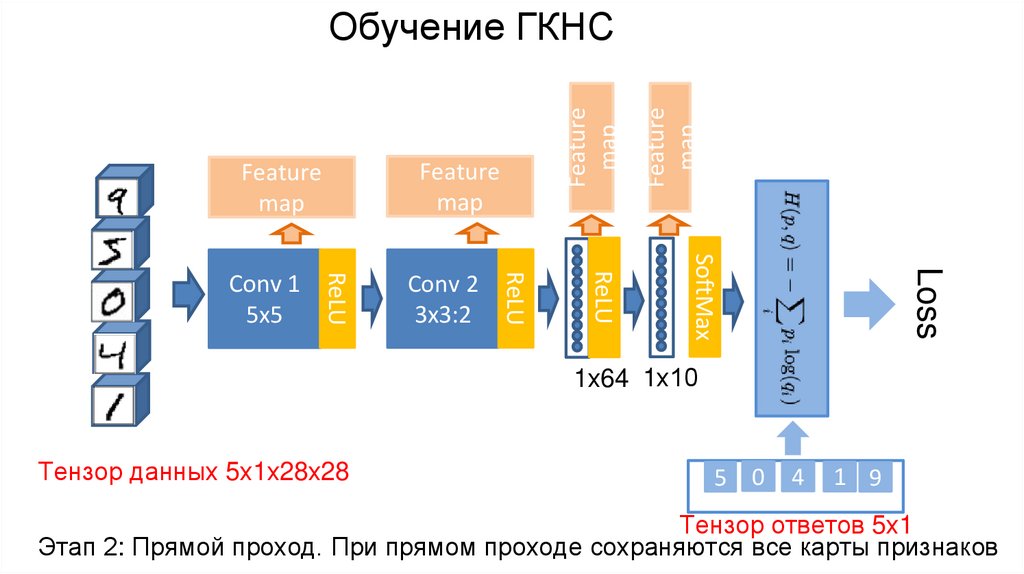

Featuremap

Loss

SoftMax

Conv 2

3x3:2

ReLU

ReLU

Conv 1

5x5

ReLU

Feature

map

Feature

map

Feature

map

Обучение ГКНС

1х64 1х10

Тензор данных 5х1х28х28

5 0

4

1 9

Тензор ответов 5х1

Этап 2: Прямой проход. При прямом проходе сохраняются все карты признаков

15.

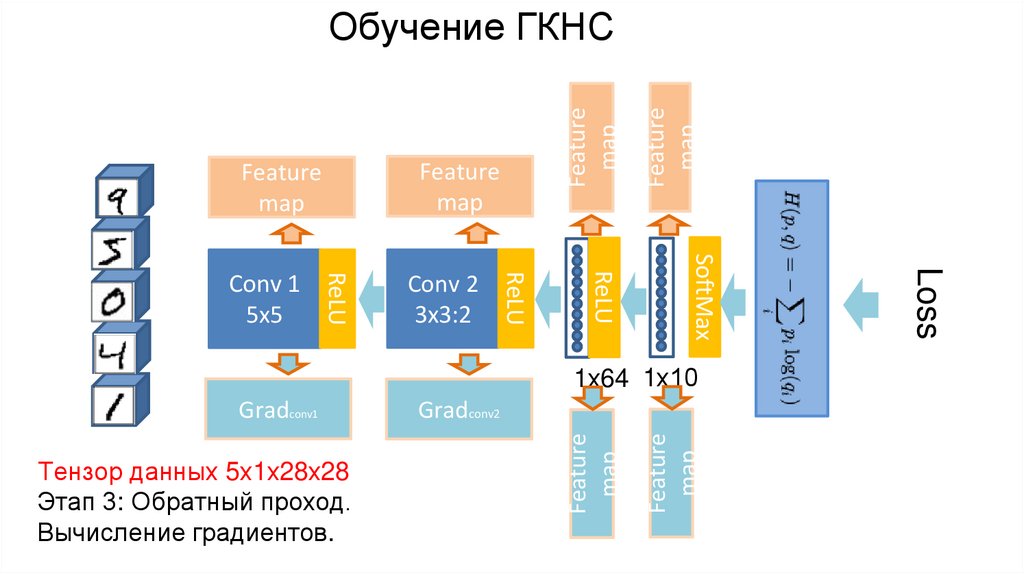

Featuremap

1х64 1х10

Feature

map

Тензор данных 5х1х28х28

Этап 3: Обратный проход.

Вычисление градиентов.

Gradconv2

Feature

map

Gradconv1

Loss

SoftMax

Conv 2

3x3:2

ReLU

ReLU

Conv 1

5x5

ReLU

Feature

map

Feature

map

Feature

map

Обучение ГКНС

16.

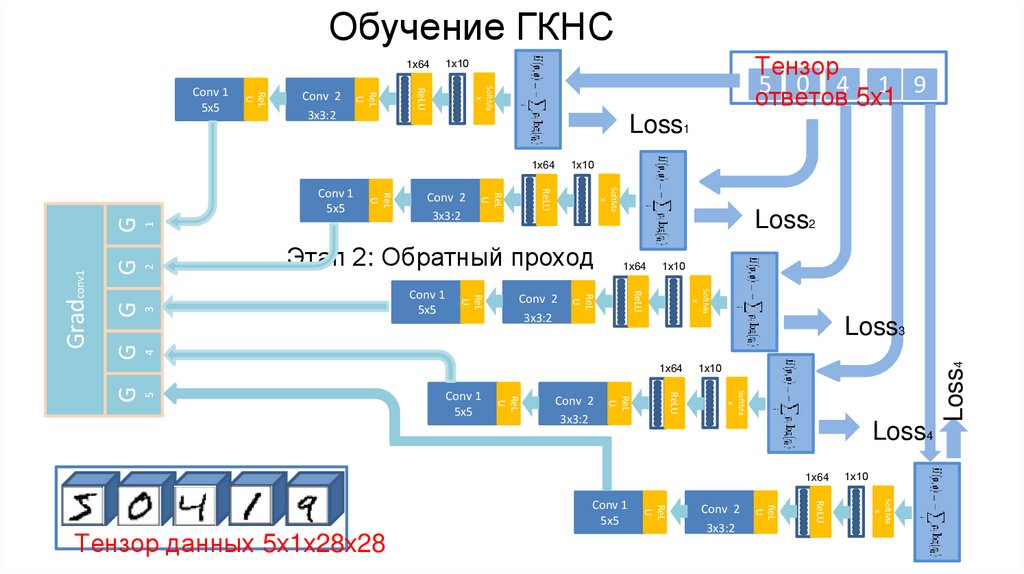

Обучение ГКНС1х64

SoftMa

x

ReLU

Loss1

1х10

1х64

1

G

2

3

G

G

1х10

SoftMa

x

4

1х64

ReLU

Conv 2

3x3:2

Loss2

ReL

U

Conv 1

5x5

ReL

U

G

Этап 2: Обратный проход

ReL

U

Conv 2

3x3:2

ReL

U

Gradconv1

SoftMa

x

ReLU

Conv 1

5x5

Loss3

5

1х10

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

Conv 1

5x5

ReL

U

G

1х64

Loss4

1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

Тензор данных 5х1х28х28

ReL

U

Conv 1

5x5

1х10

Loss4

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

Тензор

1 9

5 0 4 5х1

ответов

1х10

17.

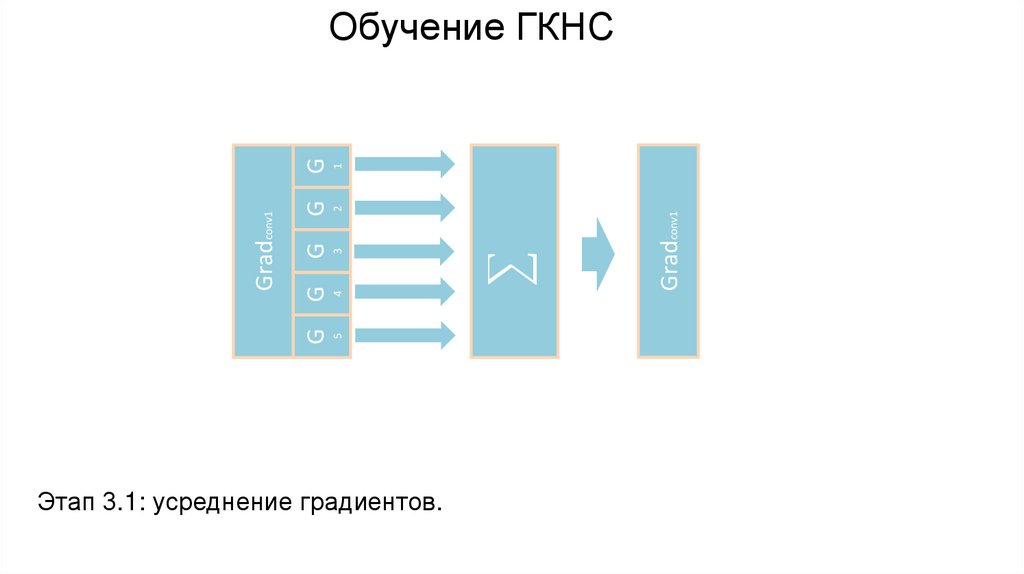

Этап 3.1: усреднение градиентов.

Gradconv1

1

2

4

5

3

G

G

G

G

Gradconv1

G

Обучение ГКНС

18.

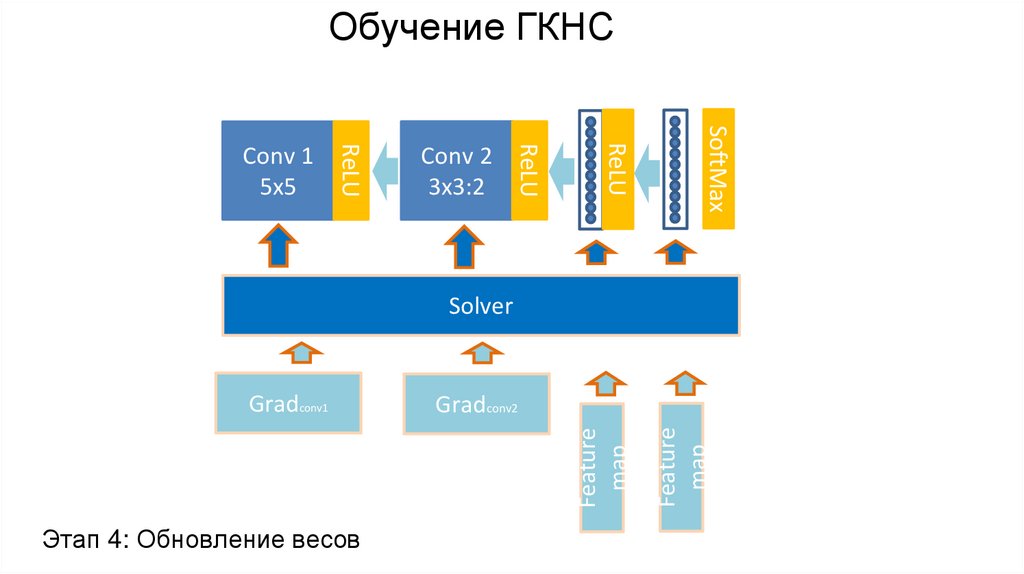

ReLUSoftMax

Feature

map

Conv 2

3x3:2

ReLU

ReLU

Conv 1

5x5

Feature

map

Обучение ГКНС

Solver

Gradconv1

Этап 4: Обновление весов

Gradconv2

19.

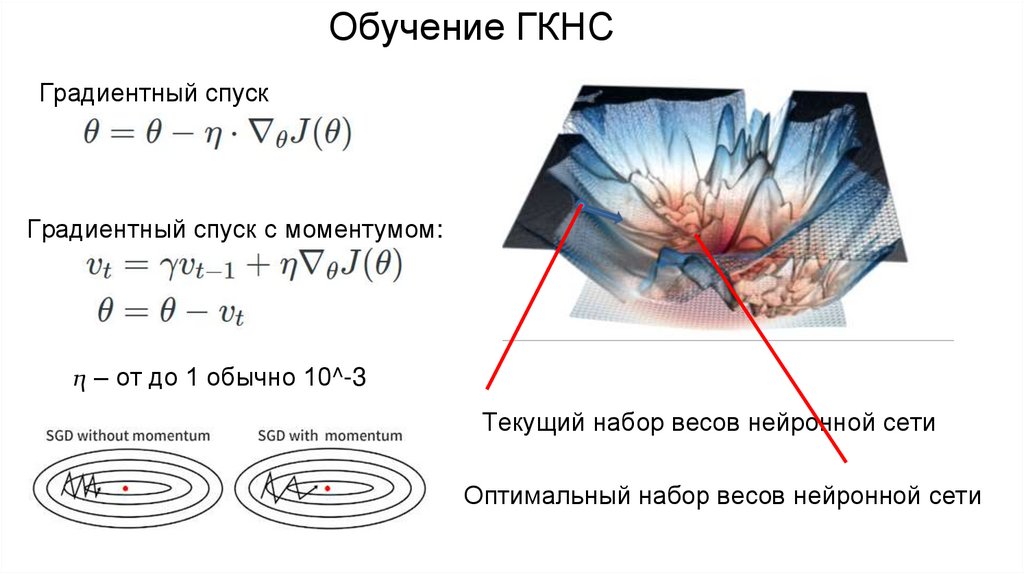

Обучение ГКНСГрадиентный спуск

Градиентный спуск с моментумом:

ⴄ – от до 1 обычно 10^-3

Текущий набор весов нейронной сети

Оптимальный набор весов нейронной сети

20.

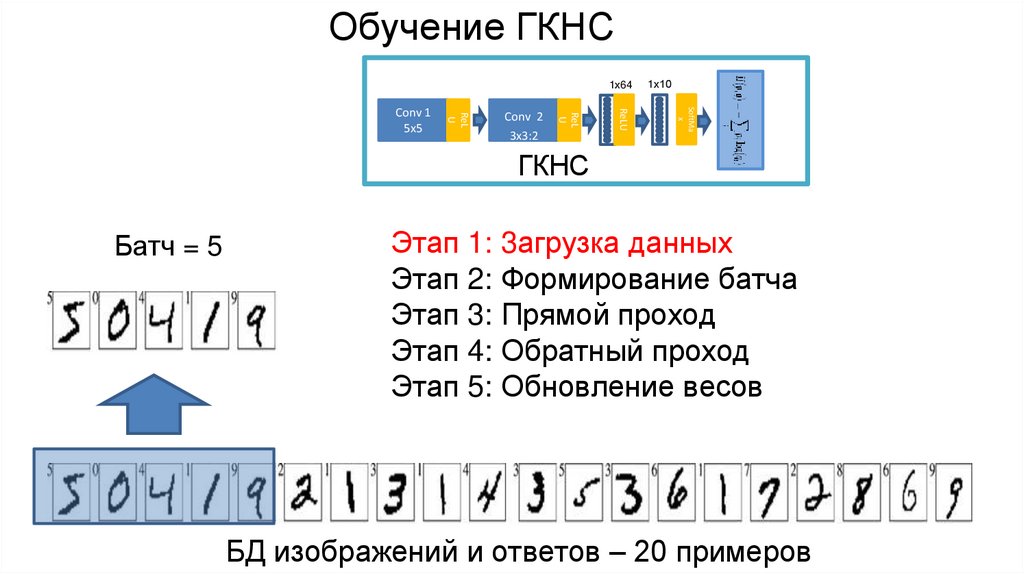

Обучение ГКНС1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

1х10

ГКНС

Батч = 5

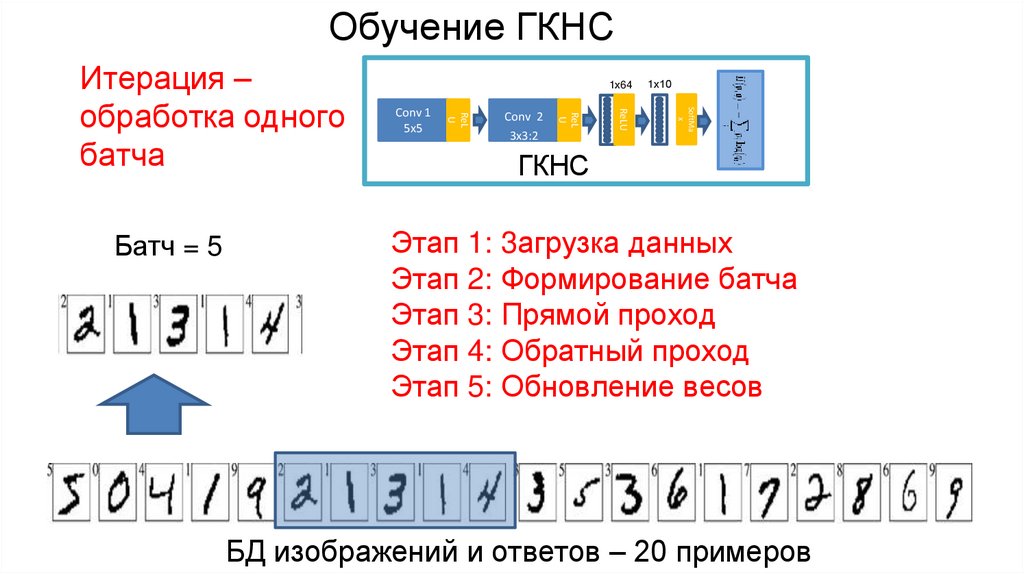

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

21.

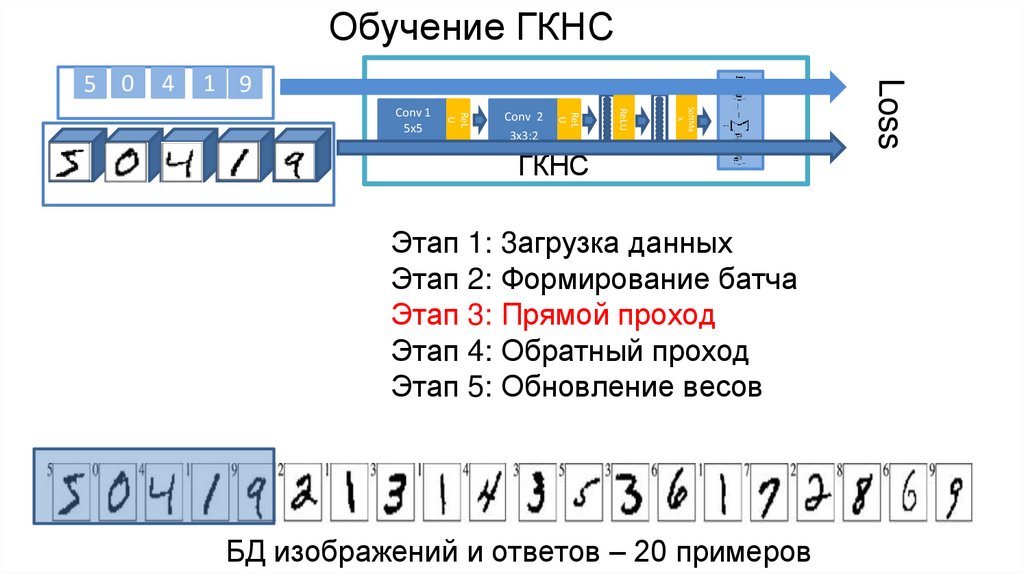

Обучение ГКНС5 0

4

1 9

1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

1х10

ГКНС

5

изображения

0

4

1

ответы

9

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

22.

Обучение ГКНС4

1 9

1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

1х10

ГКНС

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

Loss

5 0

23.

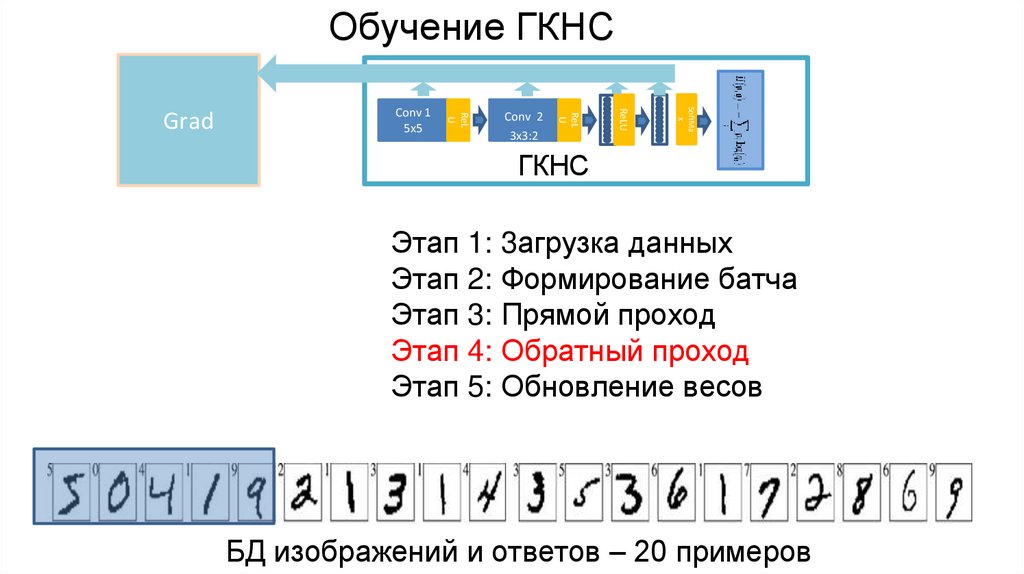

Обучение ГКНСSoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

Conv 1

5x5

ReL

U

Grad

ГКНС

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

24.

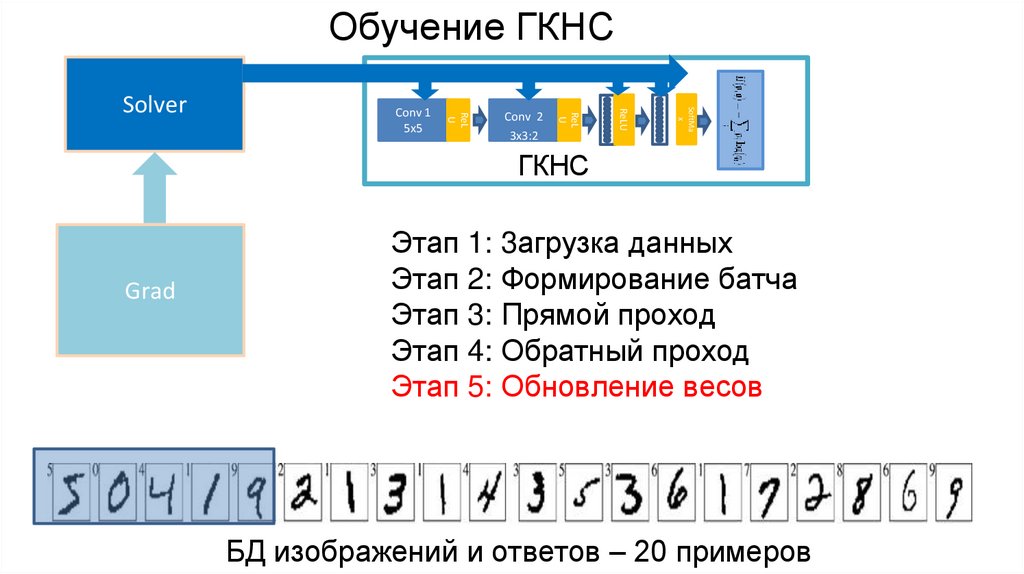

Обучение ГКНСSoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

Conv 1

5x5

ReL

U

Solver

ГКНС

Grad

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

25.

Обучение ГКНС1х10

SoftMa

x

Conv 2

3x3:2

ReLU

Conv 1

5x5

ReL

U

Батч = 5

1х64

ReL

U

Итерация –

обработка одного

батча

ГКНС

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

26.

Обучение ГКНС1х64

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

ReL

U

Conv 1

5x5

1х10

ГКНС

Батч = 5

Этап 1: 3агрузка данных

Этап 2: Формирование батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

БД изображений и ответов – 20 примеров

27.

Обучение ГКНС1х10

SoftMa

x

ReLU

Conv 2

3x3:2

ReL

U

Батч = 5

Conv 1

5x5

ReL

U

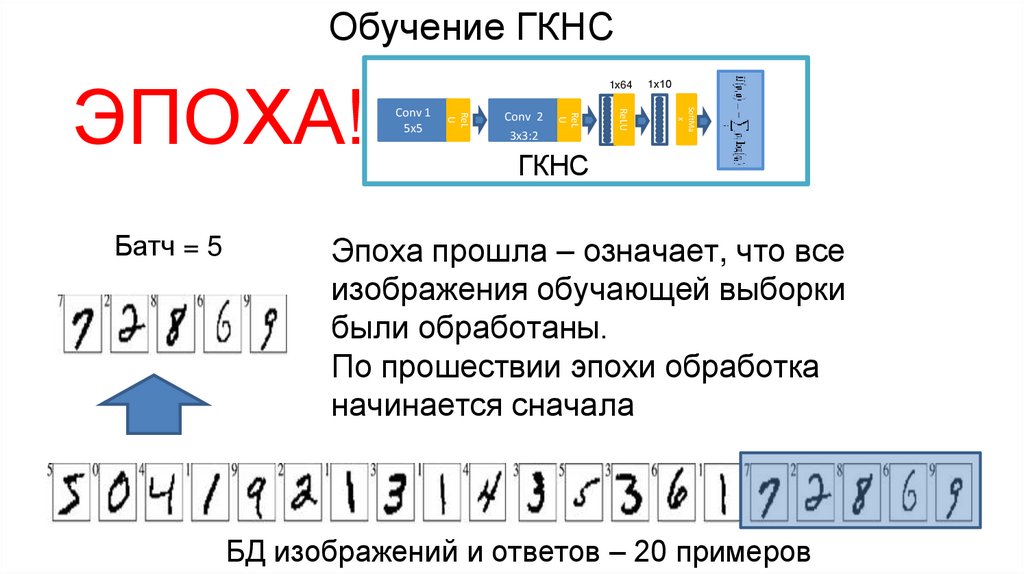

ЭПОХА!

1х64

ГКНС

Эпоха прошла – означает, что все

изображения обучающей выборки

были обработаны.

По прошествии эпохи обработка

начинается сначала

БД изображений и ответов – 20 примеров

28.

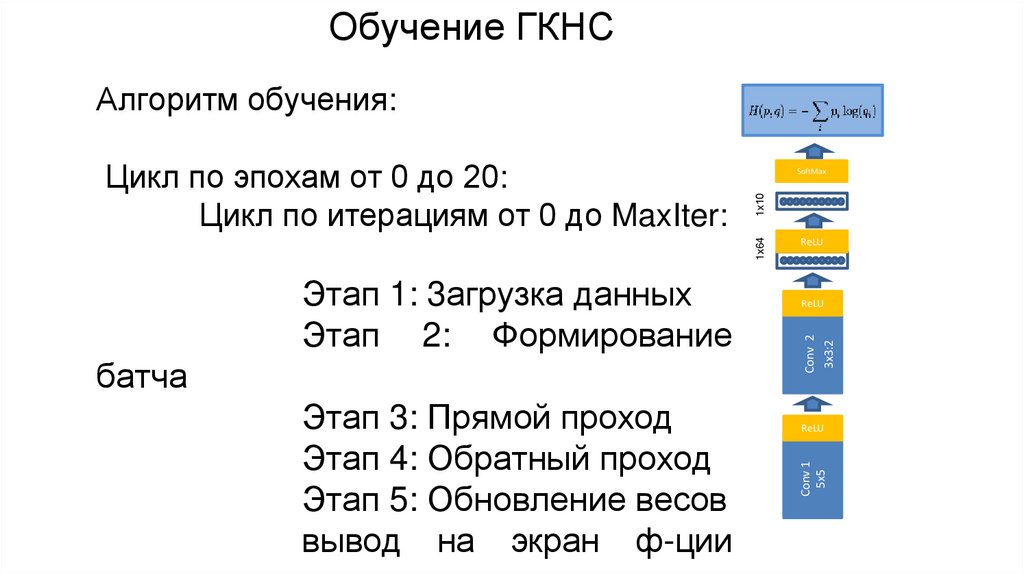

Обучение ГКНСАлгоритм обучения:

1х10

SoftMax

батча

Этап 3: Прямой проход

Этап 4: Обратный проход

Этап 5: Обновление весов

вывод на экран ф-ции

ReLU

Conv 2

3x3:2

Этап 1: 3агрузка данных

Этап 2: Формирование

ReLU

ReLU

Conv 1

5x5

1х64

Цикл по эпохам от 0 до 20:

Цикл по итерациям от 0 до MaxIter:

29.

Обучение ГКНСCrop (обрезка)Flip (отражение)инвертировать цвета

размытие

поворот

шум

Аугментация данных – набор преобразований входных

данных со случайными параметрами применяемых для

повышения качества обучения

30.

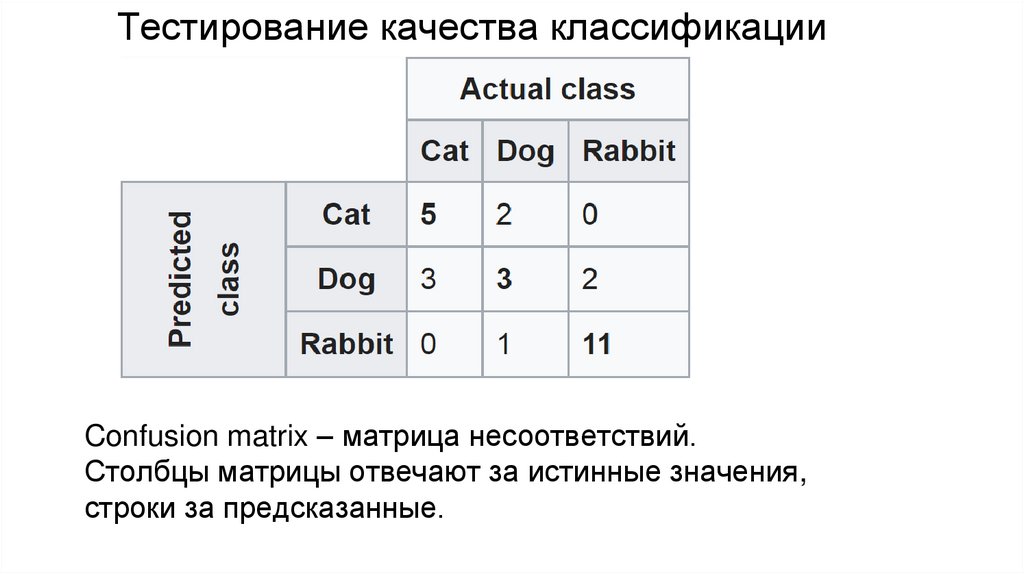

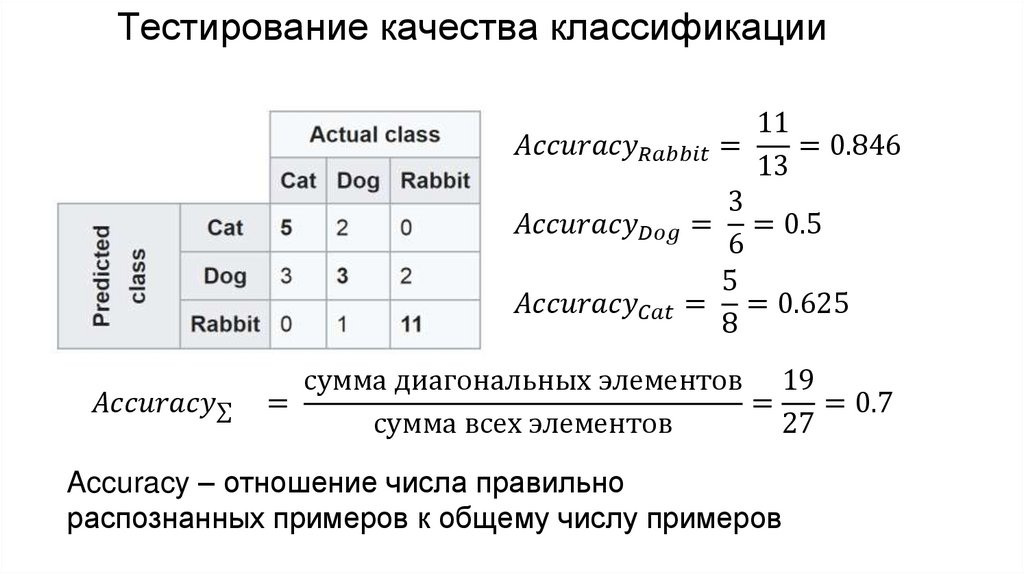

Тестирование качества классификацииConfusion matrix – матрица несоответствий.

Столбцы матрицы отвечают за истинные значения,

строки за предсказанные.

31.

Тестирование качества классификации11

education

education