Similar presentations:

Стабилизация перевернутого маятника с помощью алгоритма машинного обучения с подкреплением

1. Стабилизация перевернутого маятника с помощью алгоритма машинного обучения с подкреплением

МИНОБРНАУКИ РОССИИФЕДЕРАЛЬНОЕ ГОСУДАРСТВЕНННОЕ БЮДЖЕТНОЕ ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ ВЫСШЕГО ОБРАЗОВАНИЯ

«НИЖЕГОРОДСКИЙ ГОСУДАРСТВЕННЫЙ ТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ ИМ. Р.Е. АЛЕКСЕЕВА»

АРЗАМАССКИЙ ПОЛИТЕХНИЧЕСКИЙ ИНСТИТУТ (ФИЛИАЛ)

КАФЕДРА «ПРИКЛАДНАЯ МАТЕМАТИКА»

Стабилизация перевернутого маятника с помощью алгоритма

машинного обучения с подкреплением

Выполнил: студент группы АСПМ 18-1

Морозов М.А

Научный руководитель: к.т.н., доцент

Рябов А.В.

Консультант: к.т.н., доцент

Рябов А.В.

Консультант по экономической части: д.э.н,

Глебова О.В.

Консультант по безопасности и экологичности: к.т.н., доцент

Глебов В.В.

Арзамас 2022г.

2. Актуальность работы:

Актуальность представленной темы связана с принципиально новымподходом к решению данной задачи. Реализация данного подхода стала

возможной в связи с непрерывным ростом вычислительных возможностей и

появлению новых алгоритмов решения классических задач. Данные

технологии и алгоритмы позволяют решать известные задачи с меньшими

затратами вычислительных ресурсов, обеспечивая при этом высокую

точность

2

3. Цель и задачи

Цель работы:Стабилизация перевернутого маятника вблизи верхнего положения

равновесия при помощи алгоритма машинного обучения с

подкреплением.

Задачи:

• Рассмотреть существующие алгоритмы стабилизации перевернутого

маятника

• Применить алгоритм машинного обучения с подкреплением для

стабилизации маятника

• Провести анализ результатов стабилизации

• Оптимизировать и ускорить стабилизацию

3

4. Постановка задачи

Мы пытаемся решить классическую проблему стабилизации перевернутогомаятника вблизи верхнего положения равновесия. В такой постановке задачи

мы можем выполнить только два действия: повернуть влево или повернуть

вправо.

Что делает эту проблему сложной для алгоритмов Q-learning, так это то, что

действия являются непрерывными, а не дискретными. То есть вместо

использования двух дискретных действий, таких как -1 или + 1, мы должны

выбирать из бесконечных действий в диапазоне от -2 до + 2.

4

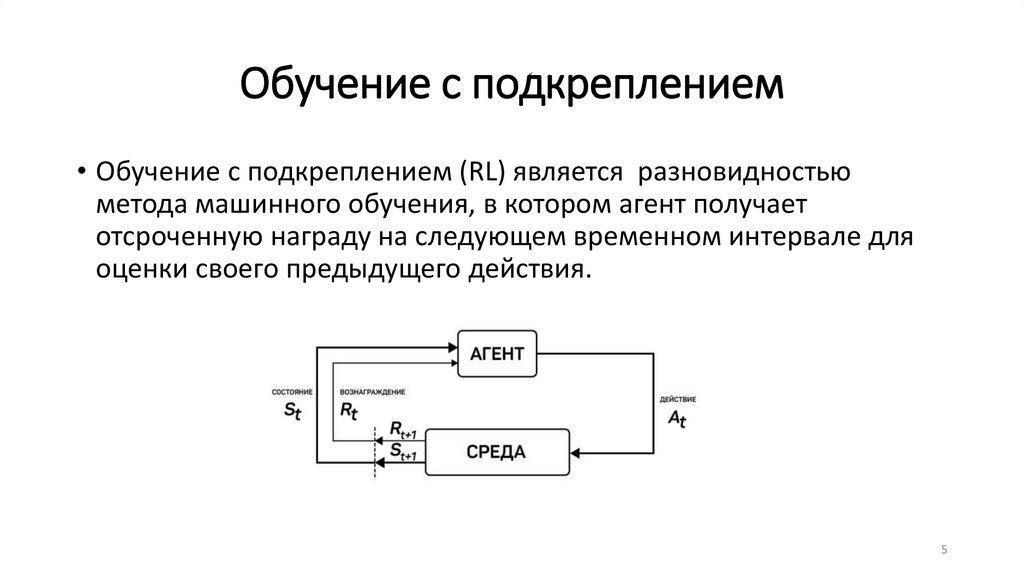

5. Обучение с подкреплением

• Обучение с подкреплением (RL) является разновидностьюметода машинного обучения, в котором агент получает

отсроченную награду на следующем временном интервале для

оценки своего предыдущего действия.

5

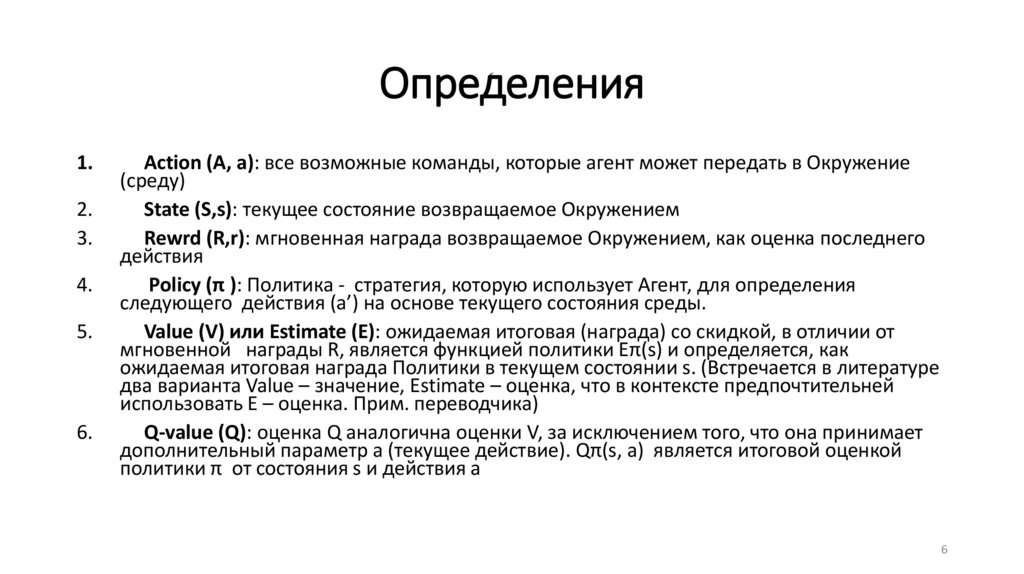

6. Определения

1.2.

3.

4.

5.

6.

Action (A, a): все возможные команды, которые агент может передать в Окружение

(среду)

State (S,s): текущее состояние возвращаемое Окружением

Rewrd (R,r): мгновенная награда возвращаемое Окружением, как оценка последнего

действия

Policy (π ): Политика - стратегия, которую использует Агент, для определения

следующего действия (a’) на основе текущего состояния среды.

Value (V) или Estimate (E): ожидаемая итоговая (награда) со скидкой, в отличии от

мгновенной награды R, является функцией политики Eπ(s) и определяется, как

ожидаемая итоговая награда Политики в текущем состоянии s. (Встречается в литературе

два варианта Value – значение, Estimate – оценка, что в контексте предпочтительней

использовать E – оценка. Прим. переводчика)

Q-value (Q): оценка Q аналогична оценки V, за исключением того, что она принимает

дополнительный параметр a (текущее действие). Qπ(s, a) является итоговой оценкой

политики π от состояния s и действия a

6

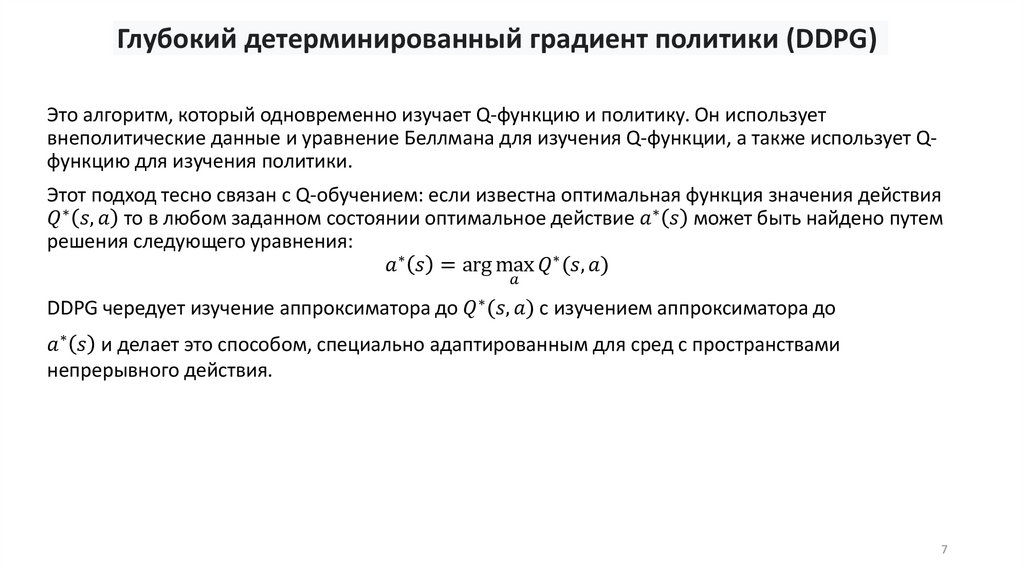

7. Глубокий детерминированный градиент политики (DDPG)

Это алгоритм, который одновременно изучает Q-функцию и политику. Он используетвнеполитические данные и уравнение Беллмана для изучения Q-функции, а также использует Qфункцию для изучения политики.

Этот подход тесно связан с Q-обучением: если известна оптимальная функция значения действия