Similar presentations:

Анализ данных. Лекция 1. Основные понятия и определения теории вероятностей

1.

Анализ данных2.

Анализ данныхЛекция 1

Основные понятия и определения теории

вероятностей

3.

Основные понятия и определенияИспытание.

Под испытанием

или

опытом

понимается

осуществление определенного комплекса действий или

условий.

Проведение этого испытания в каких-либо других

условиях считается уже другим опытом.

4.

Основные понятия и определенияСобытие.

Каждое испытание заканчивается некоторым

результатом. Такие пезультаты будем называть

исходами или событиями.

Таким образом,

под событием понимается

явление, которое наступает в результате данного

испытания.

5.

Простейшие модели теории вероятностейПервая модель: «Монета»

Подбрасываем монету один раз.

Решка

Орел

или

6.

Простейшие модели теории вероятностейВторая модель: «Кубик»

Подбрасываем один раз игральную кость.

События:

«нечетное»

1

3

«четное»

5

2

3

4

6

«составное»

«простое»

1

2

5

4

6

7.

Классификация событийДостоверным

называют

обязательно произойдет

в

(Обозначается ).

событие,

которое

данном испытании.

Невозможным

называют

заведомо не произойдет в

(Обозначается ).

событие,

которое

данном испытании.

Случайным или возможным называют событие,

которое в данном испытании может произойти, либо не

произойти.

Случайные события обозначаются

латинскими буквами A, B, C, …

прописными

8.

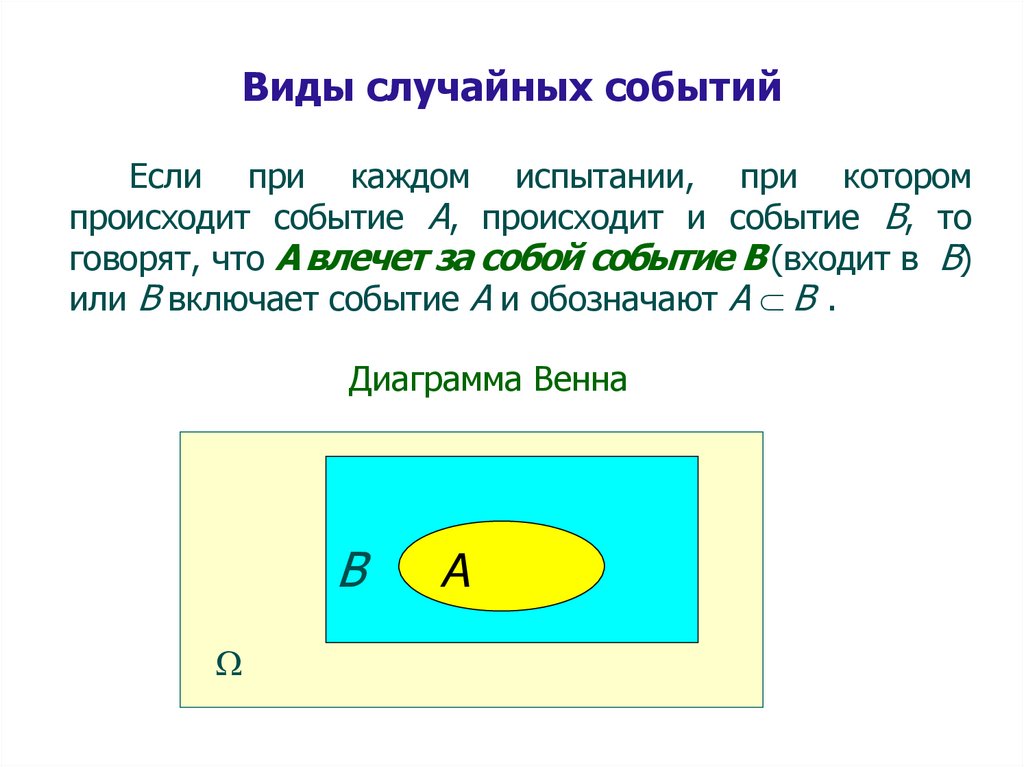

Виды случайных событийЕсли при каждом испытании, при котором

происходит событие А, происходит и событие В, то

говорят, что А влечет за собой событие В (входит в В)

или В включает событие А и обозначают А В .

Диаграмма Венна

B

A

9.

Виды случайных событийПример. Событие А – выпадение 3, В – выпадение

нечетного числа, то А В

А = 3 ,

В = 1, 3, 5 .

Так как 3 1, 3, 5 А В.

10.

Виды случайных событийОпределение. Если одновременно А В и В

А, то в этом случае события А и В называются

равносильными.

Записывают А=В

Пример.

Монета: Выпал орел

Не выпала решка

=

Кубик:

Выпала «6»

=

Выпало более 5

11.

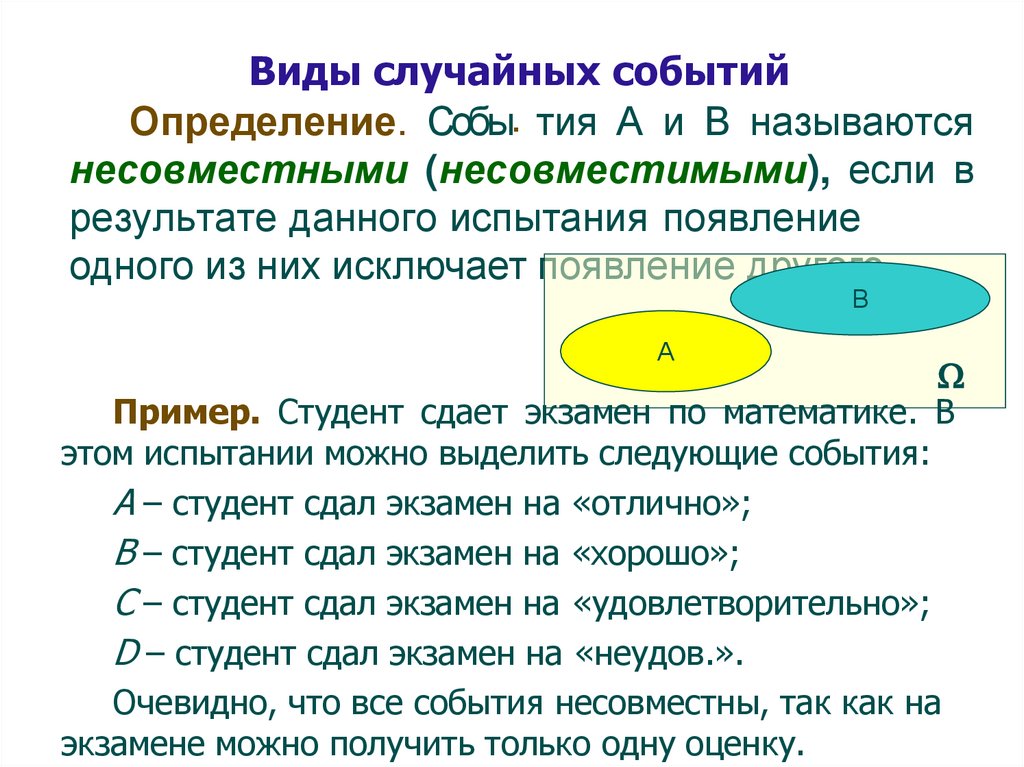

Виды случайных событийОпределение. Собы. тия А и В называются

несовместными (несовместимыми), если в

результате данного испытания появление

одного из них исключает появление другого.

В

А

Пример. Студент сдает экзамен по математике. В

этом испытании можно выделить следующие события:

A – студент сдал экзамен на «отлично»;

B – студент сдал экзамен на «хорошо»;

C – студент сдал экзамен на «удовлетворительно»;

D – студент сдал экзамен на «неудов.».

Очевидно, что все события несовместны, так как на

экзамене можно получить только одну оценку.

12.

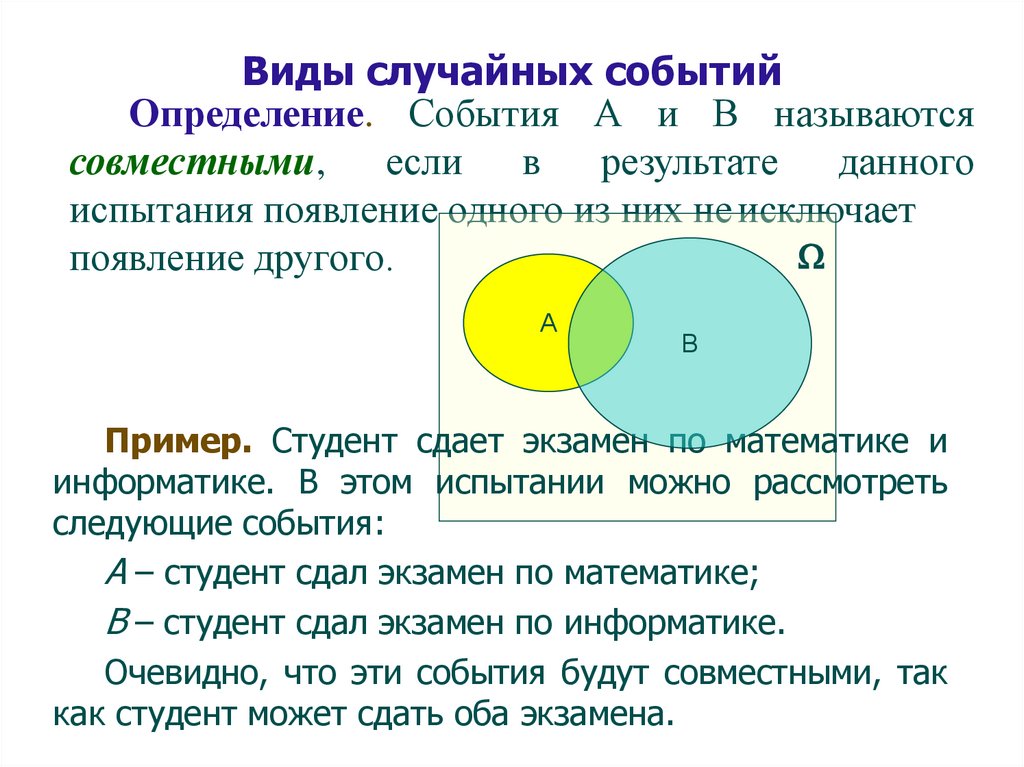

Виды случайных событийОпределение. События А и В называются

совместными, если

в

результате

данного

испытания появление одного из них не исключает

появление другого.

А

В

Пример. Студент сдает экзамен по математике и

информатике. В этом испытании можно рассмотреть

следующие события:

A – студент сдал экзамен по математике;

B – студент сдал экзамен по информатике.

Очевидно, что эти события будут совместными, так

как студент может сдать оба экзамена.

13.

Виды случайных событийОпределение.

Несколько

событий

называются единственно возможными, если

в результате испытания одно из них

обязательно должно произойти.

Пример. В примере со студентом события A, B, C и

D - единственно возможные.

14.

Виды случайных событийОпределение.

События

называются

равновозможными, если есть основания считать,

что ни одно из этих событий не является более

возможным, чем другие.

орел

1

2

решка

3

4

5

6

15.

Виды случайных событийОпределение. Совокупность единственно

возможных несовместных

событий данного

испытания называют полной группой.

орел

решка

Полная группа

четное

нечетное

Полная группа

четное

простое

совместны

16.

Виды случайных событийОпределение.

Два события называются

противополож ными, если они составляют

полную группу событий.

Обозначение:

А

AиA

A

17.

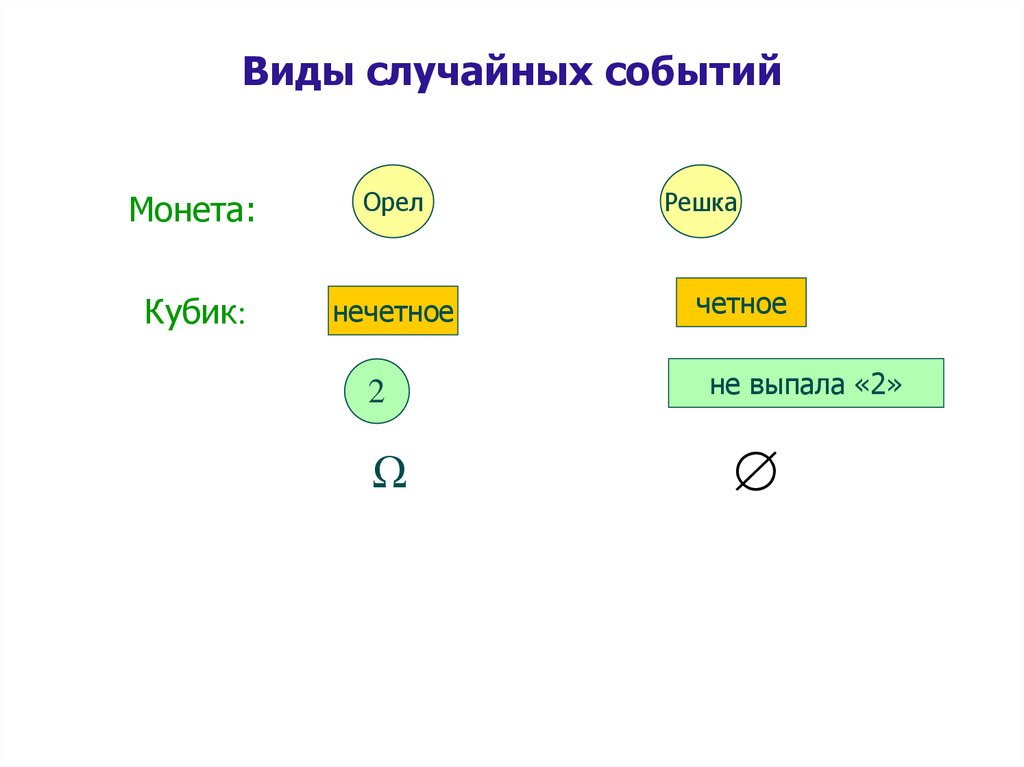

Виды случайных событийМонета:

Орел

Кубик:

нечетное

2

Ω

Решка

четное

не выпала «2»

18.

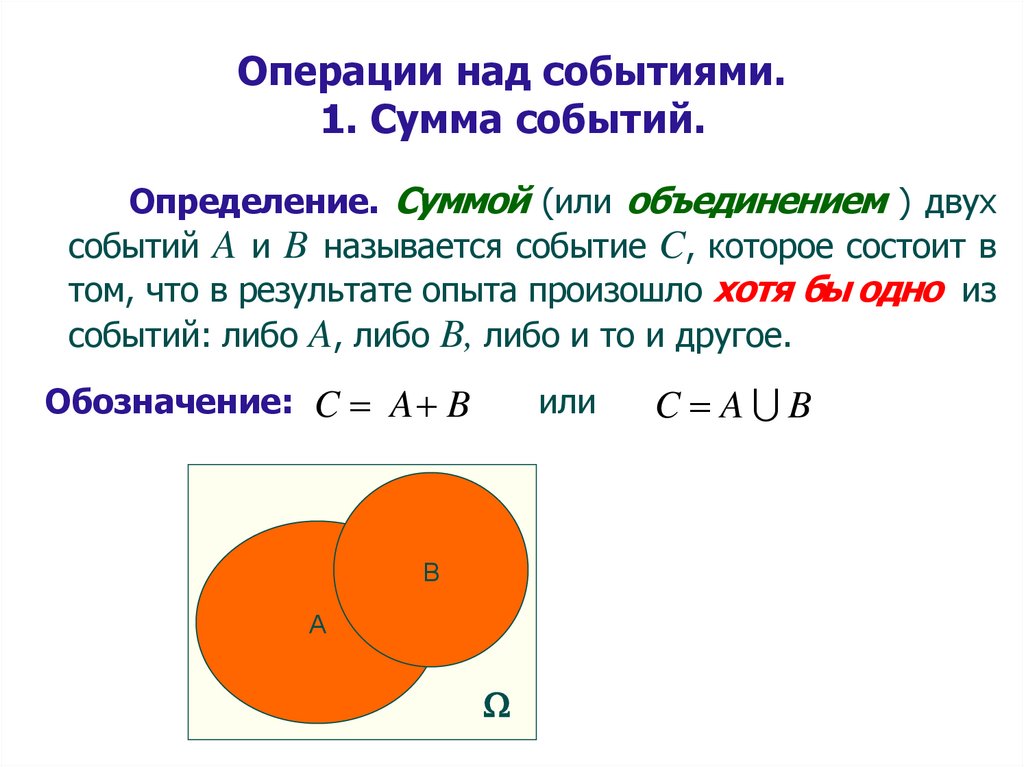

Операции над событиями.1. Сумма событий.

Определение. Суммой (или объединением ) двух

событий A и B называется событие C, которое состоит в

том, что в результате опыта произошло хотя бы одно из

событий: либо A, либо B, либо и то и другое.

Обозначение: C A B

или

В

А

C A B

19.

Операции над событиями.1. Сумма событий.

Пример. Два студента сдают экзамен. Пусть

событие А – первый студент сдал экзамен, B – второй

студент сдал экзамен.

Сумма событий – хотя бы один студент сдал экзамен

Пример. Из колоды карт извлекают одну карту.

Пусть событие А – извлечена «дама», B – извлечена

карта пиковой масти.

Сумма событий – извлеченная карта будет либо

дамой, либо картой пиковой масти, либо дамой

пиковой масти

20.

Свойства операции объединения.1.Если одно событие A содержится в другом событии B,

то их объединение равно большему событию B.

A B B, если A B.

2.Достоверное событие, объединенное с любым

возможным событием, – это достоверное событие.

A , если A возможное событие.

21.

Свойства операции объединения3.Объединение противоположных событий – это

достоверное событие.

A A .

4.Объединение события A с самим собой равно этому же

событию A.

A A A.

22.

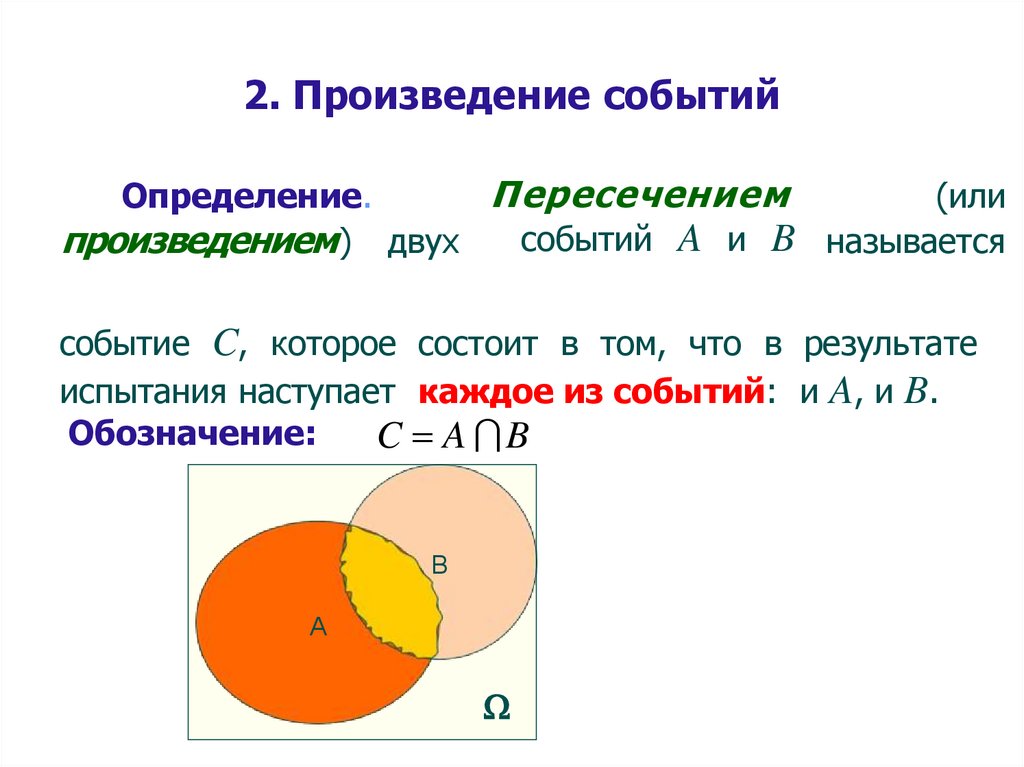

2. Произведение событийПересечением

Определение.

(или

событий A и B называется

произведением ) двух

событие C, которое состоит в том, что в результате

испытания наступает каждое из событий: и A, и B.

Обозначение:

C A B

В

А

23.

2. Произведение событийПример. Два студента сдают экзамен. Пусть

событие А – первый студент сдал экзамен, B – второй

студент сдал экзамен.

Произведение событий – оба студента сдали экзамен

Пример. Из колоды карт извлекают одну карту.

Пусть событие А – извлечена «дама», B – извлечена

карта пиковой масти.

Произведение событий – извлеченная карта будет

дамой пиковой масти.

24.

Свойства операции пересечения1.Если одно событие A содержится в другом событии B,

то их пересечение равно меньшему событию A.

A B A, если A B.

2.Пересечение несовместных событий – это невозможное

событие или

A B 0 , если A и B несовместны.

25.

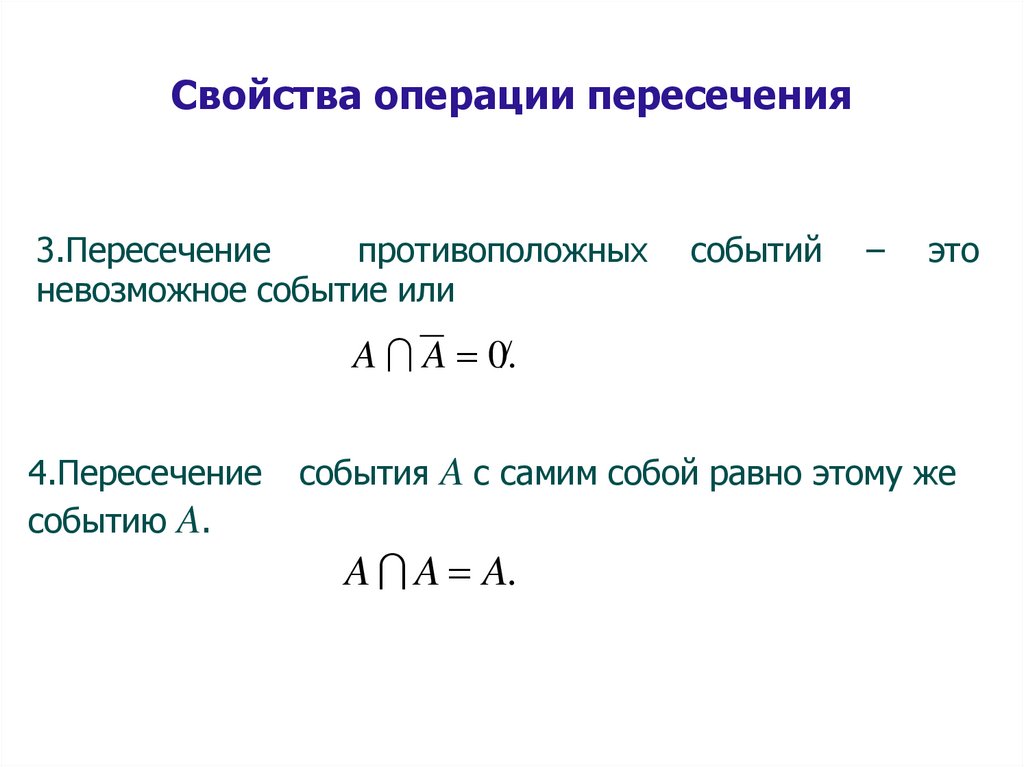

Свойства операции пересечения3.Пересечение

противоположных

невозможное событие или

событий

–

это

A A 0 .

4.Пересечение

событию A.

события A с самим собой равно этому же

A A A.

26.

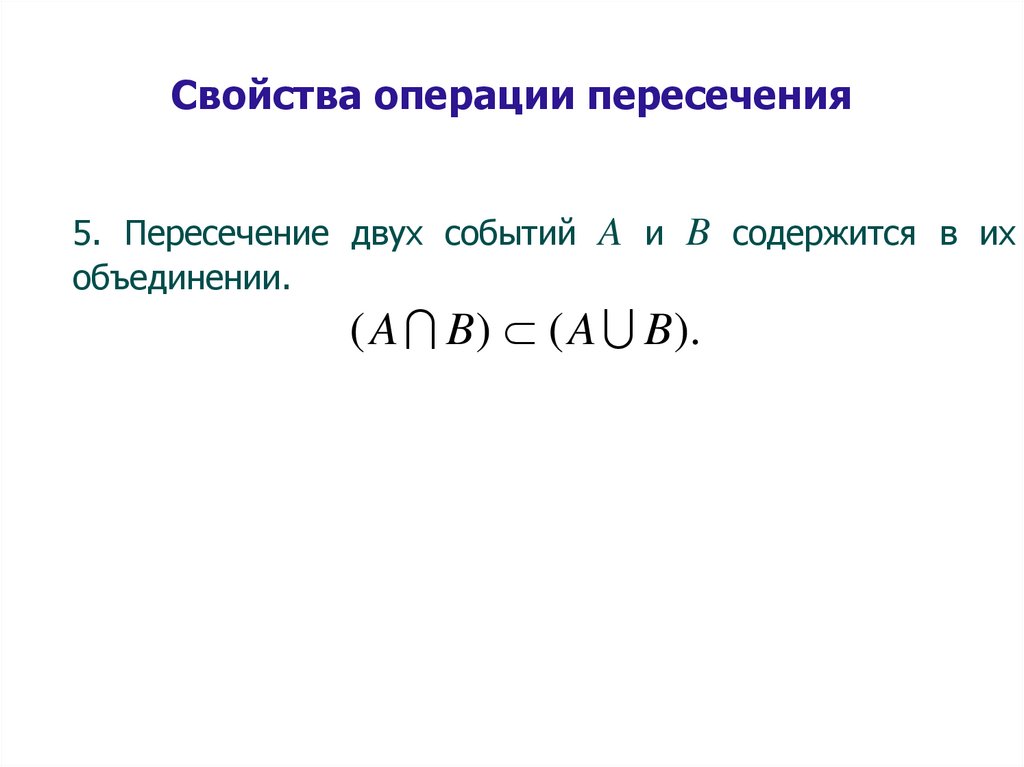

Свойства операции пересечения5. Пересечение двух событий A и B содержится в их

объединении.

( A B) ( A B).

27.

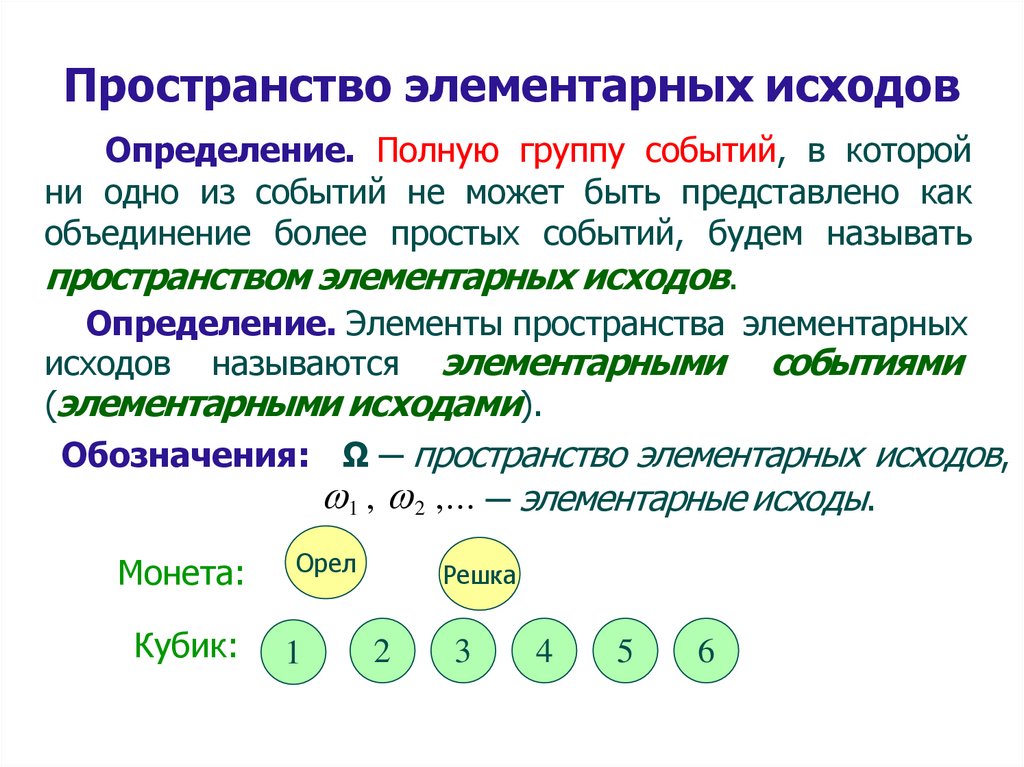

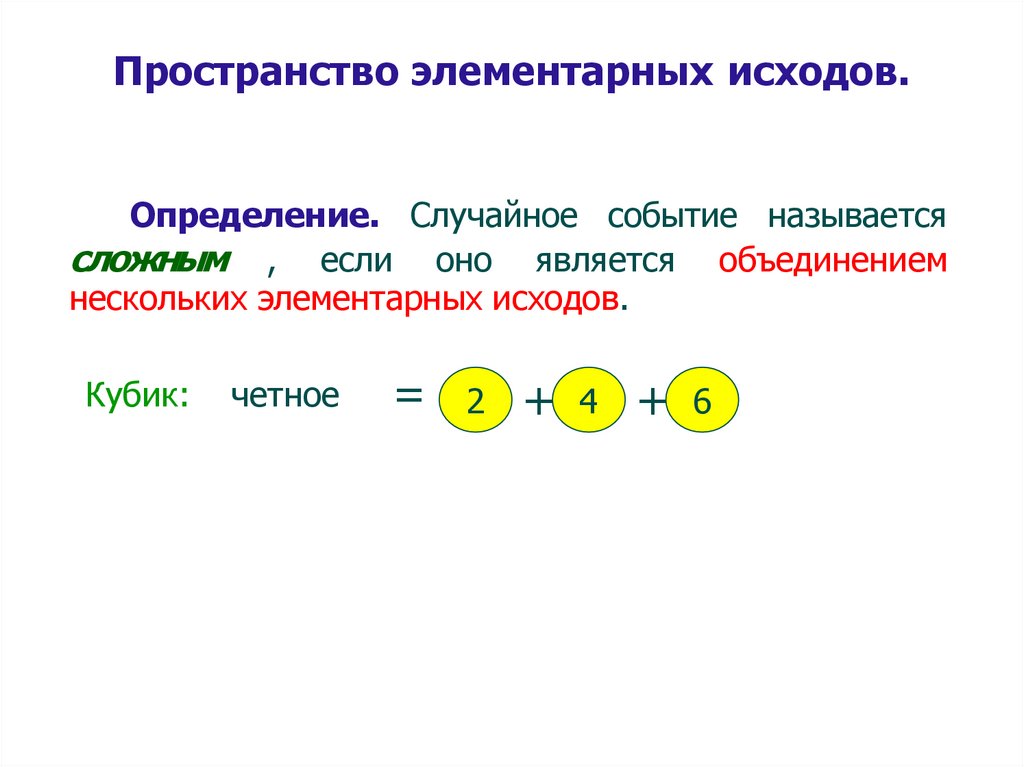

Пространство элементарных исходовОпределение. Полную группу событий, в которой

ни одно из событий не может быть представлено как

объединение более простых событий, будем называть

пространством элементарных исходов.

Определение. Элементы пространства элементарных

исходов называются элементарными событиями

(элементарными исходами).

Обозначения: Ω ─ пространство элементарных исходов,

1 , 2 ,... ─ элементарные исходы.

Монета:

Орел

Кубик:

1

Решка

2

3

4

5

6

28.

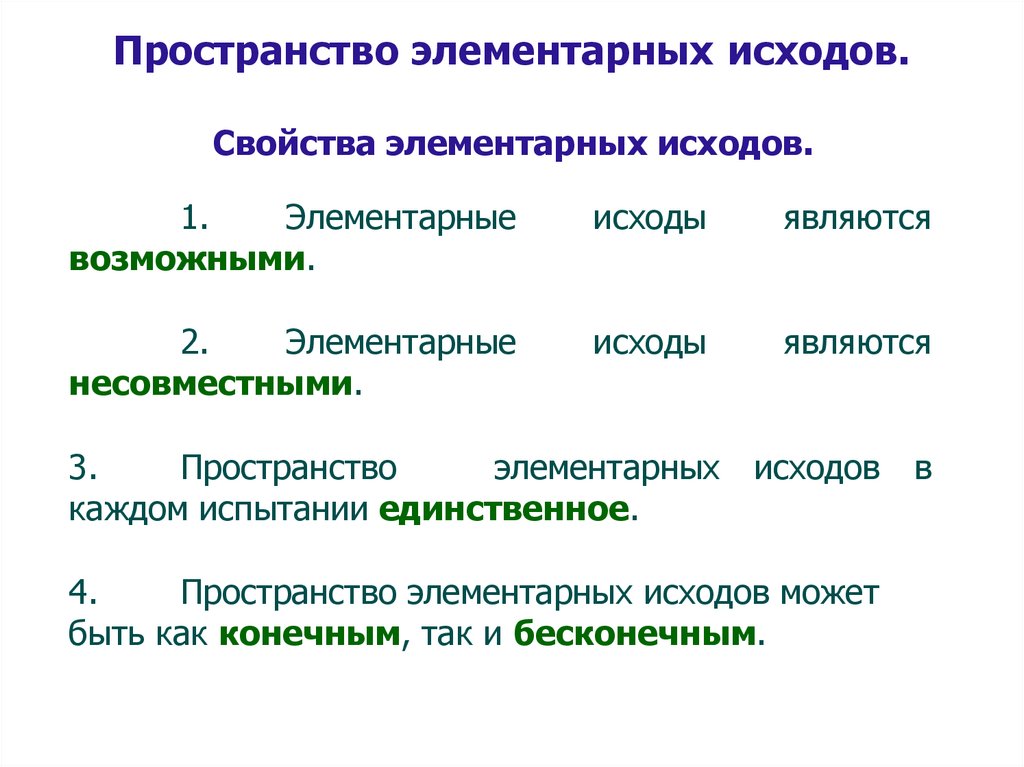

Пространство элементарных исходов.Свойства элементарных исходов.

1.

Элементарные

возможными.

исходы

являются

2.

Элементарные

несовместными.

исходы

являются

3.

Пространство

элементарных исходов в

каждом испытании единственное.

4.

Пространство элементарных исходов может

быть как конечным, так и бесконечным.

29.

Пространство элементарных исходов.Определение. Случайное событие называется

сложным , если оно является объединением

нескольких элементарных исходов.

Кубик:

четное

=

2

+ 4 + 6

30.

Статистическое и классическоеопределение вероятности события

Определение. Числовая характеристика,

показывающая

степень

объективной

возможности появления события называется

вероятностью данного события.

Вероятность

– это

наступления события.

мера

возможности

31.

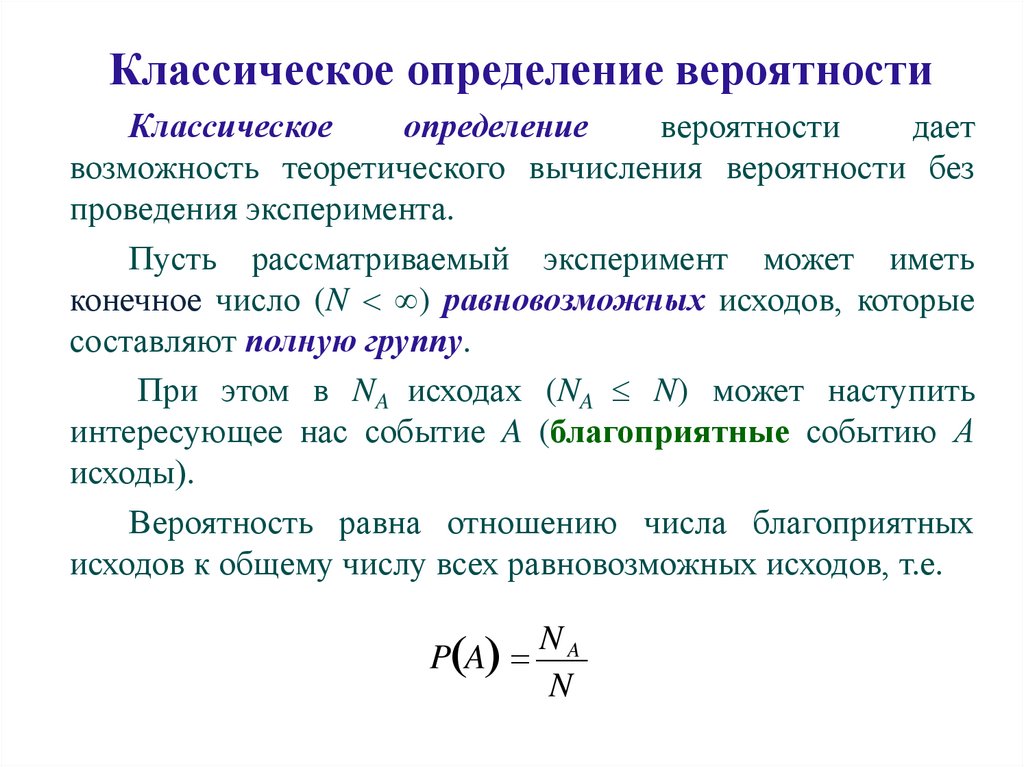

Классическое определение вероятностиКлассическое

определение

вероятности

дает

возможность теоретического вычисления вероятности без

проведения эксперимента.

Пусть рассматриваемый эксперимент может иметь

конечное число (N ) равновозможных исходов, которые

составляют полную группу.

При этом в NA исходах (NA N) может наступить

интересующее нас событие A (благоприятные событию А

исходы).

Вероятность равна отношению числа благоприятных

исходов к общему числу всех равновозможных исходов, т.е.

NA

P A

N

32.

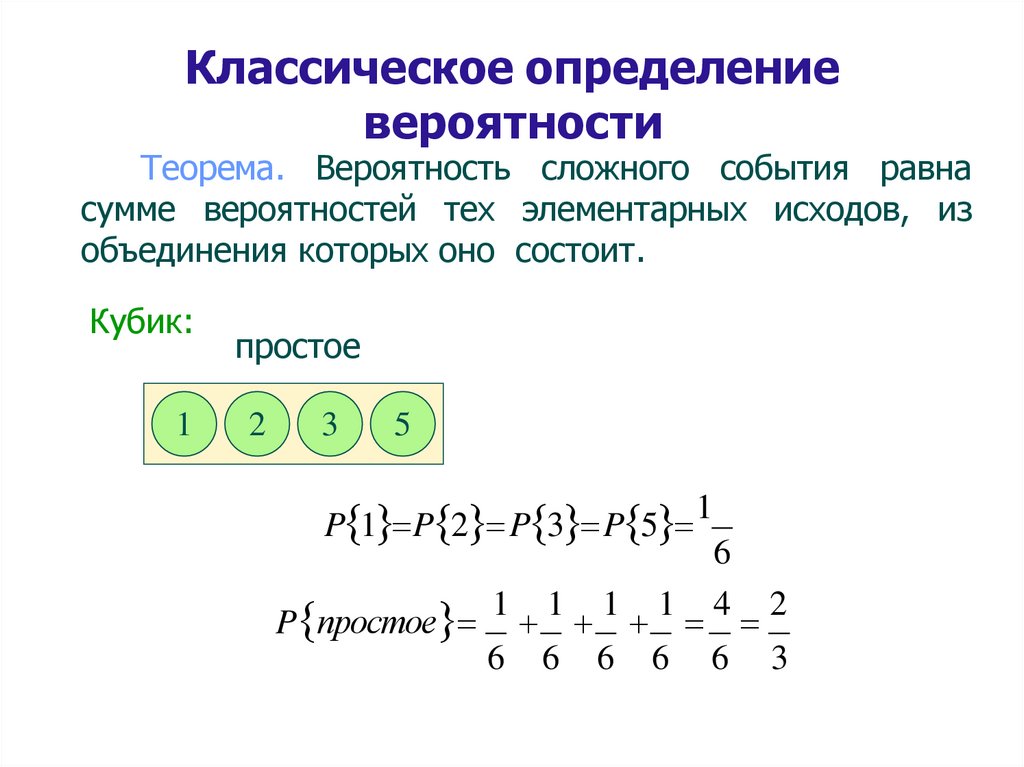

Классическое определениевероятности

Теорема. Вероятность сложного события равна

сумме вероятностей тех элементарных исходов, из

объединения которых оно состоит.

Кубик:

1

простое

2

3

5

P 1 P 2 P 3 P 5

P простое

1

6

1

6

1

6

1

6

1

6

4

6

2

3

33.

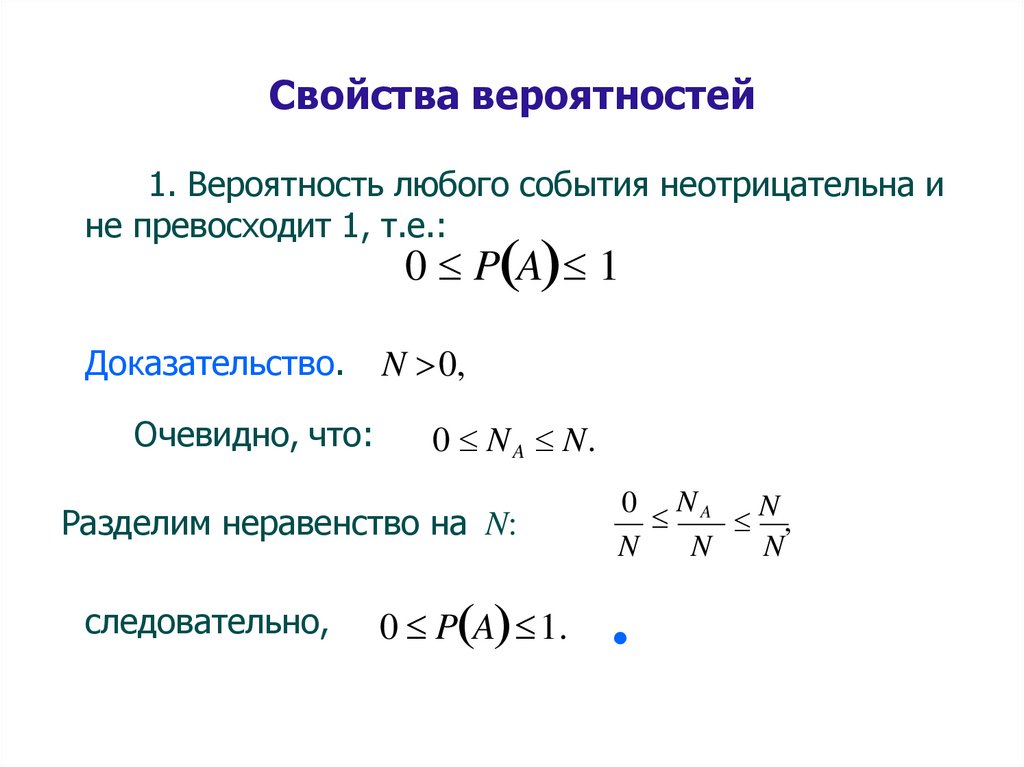

Свойства вероятностей1. Вероятность любого события неотрицательна и

не превосходит 1, т.е.:

0 P A 1

Доказательство.

Очевидно, что:

N 0,

0 N A N.

Разделим неравенство на N:

следовательно,

0 P A 1.

0 NA

N

,

N

N

N

34.

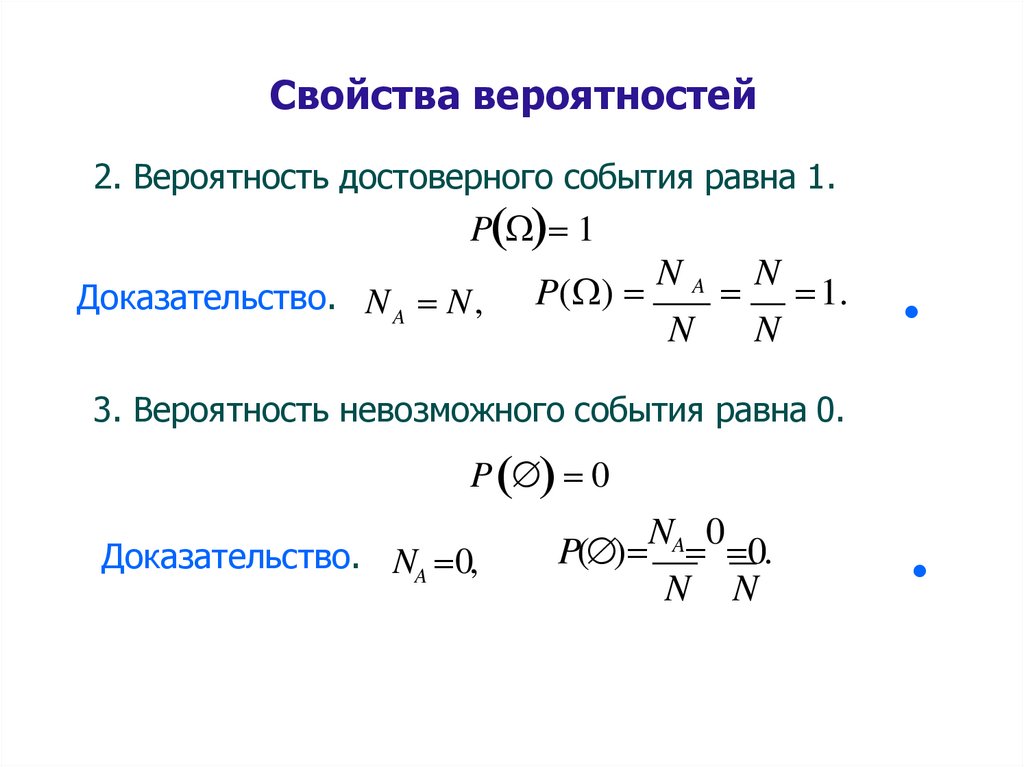

Свойства вероятностей2. Вероятность достоверного события равна 1.

P 1

Доказательство. N A N,

P( )

NA

N

N

1.

N

3. Вероятность невозможного события равна 0.

P 0

Доказательство. NA 0,

NA 0

P( ) 0.

N N

35.

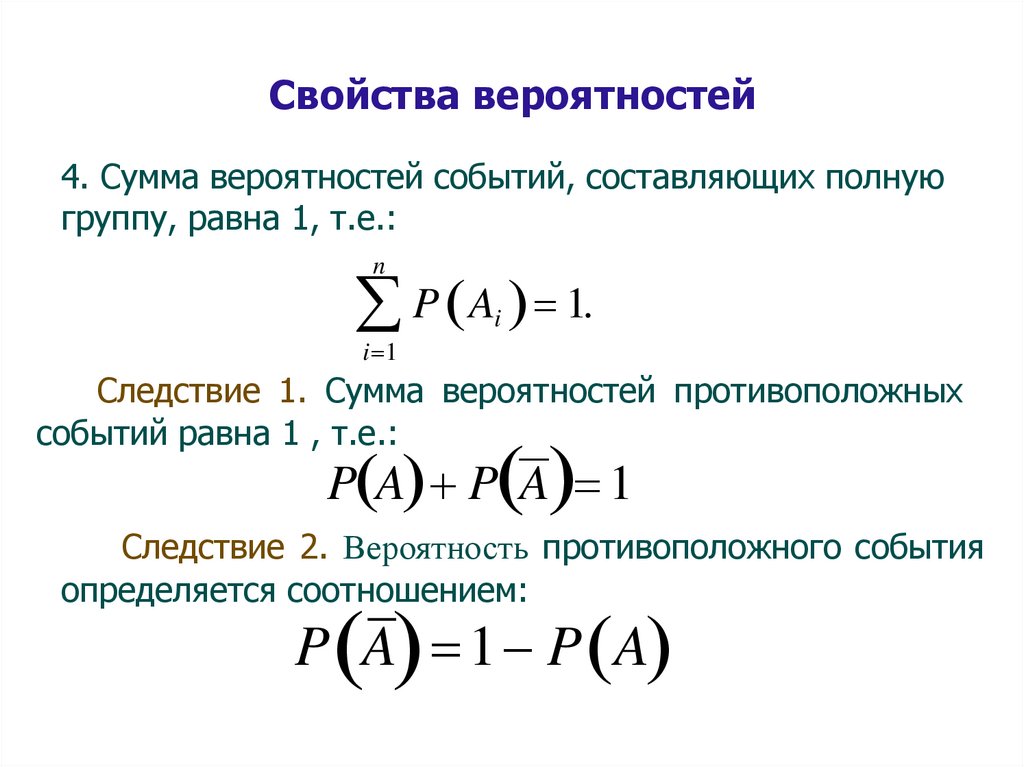

Свойства вероятностей4. Сумма вероятностей событий, составляющих полную

группу, равна 1, т.е.:

n

P A 1.

i

i 1

Следствие 1. Сумма вероятностей противоположных

событий равна 1 , т.е.:

P A P A 1

Следствие 2. Вероятность противоположного события

определяется соотношением:

P A 1 P A

36.

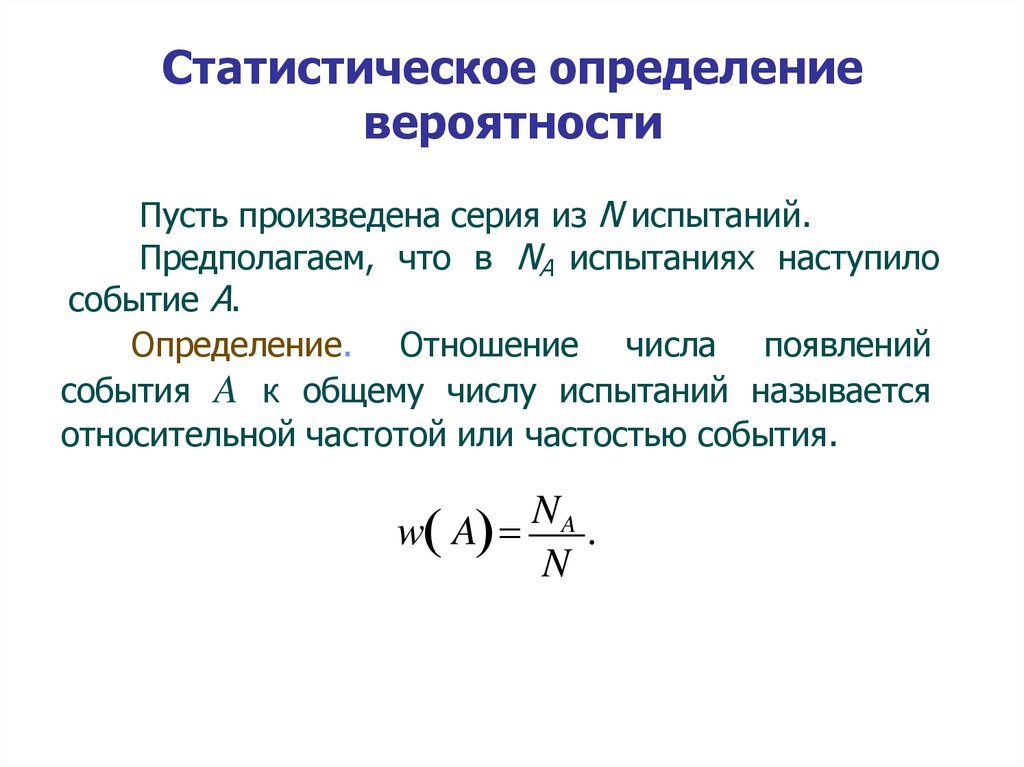

Статистическое определениевероятности

Пусть произведена серия из N испытаний.

Предполагаем, что в NA испытаниях наступило

событие А.

Определение. Отношение числа появлений

события A к общему числу испытаний называется

относительной частотой или частостью события.

NA

w A

.

N

37.

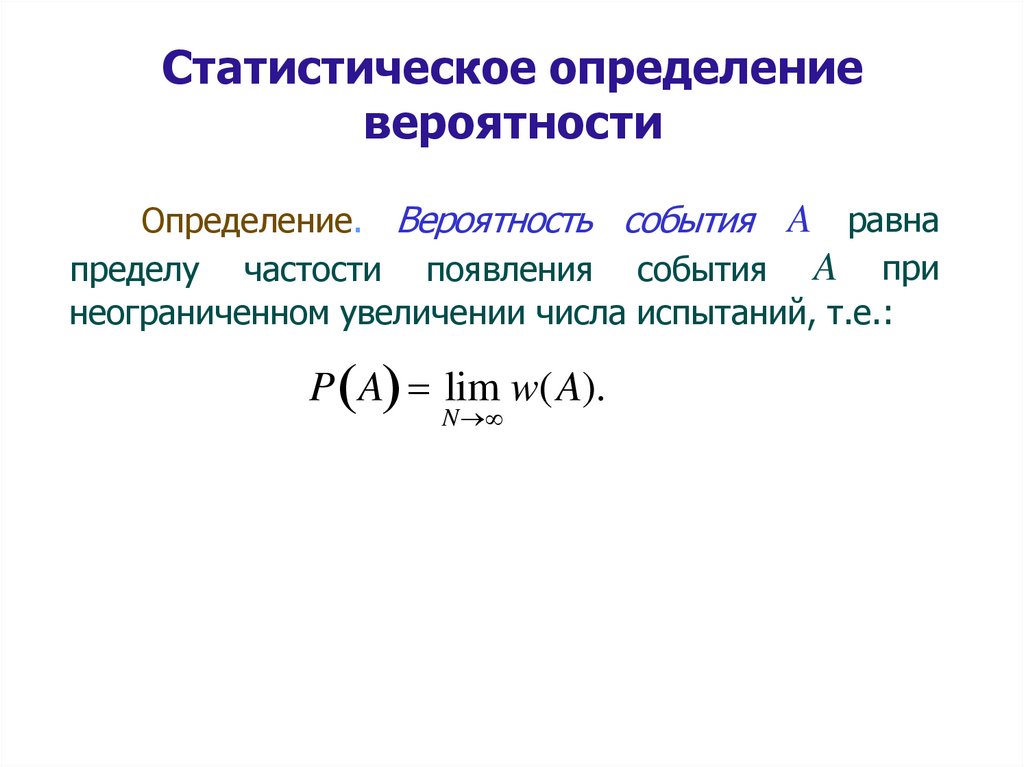

Статистическое определениевероятности

Определение. Вероятность события A равна

пределу частости появления события A при

неограниченном увеличении числа испытаний, т.е.:

P A lim w(A).

N

38.

Статистическое определение вероятности.Условия применимости

1.Рассматриваемые события должны быть исходами

только

тех

испытаний,

которые

могут

быть

воспроизведены неограниченное число раз при одном

и том же комплексе условий.

2.События

должны

обладать

так

называемой

статистической устойчивостью, или устойчивостью

относительных частот.

3.Число испытаний, в результате которых появляется

событие А должно быть достаточно велико.

P( A) w( A)

39.

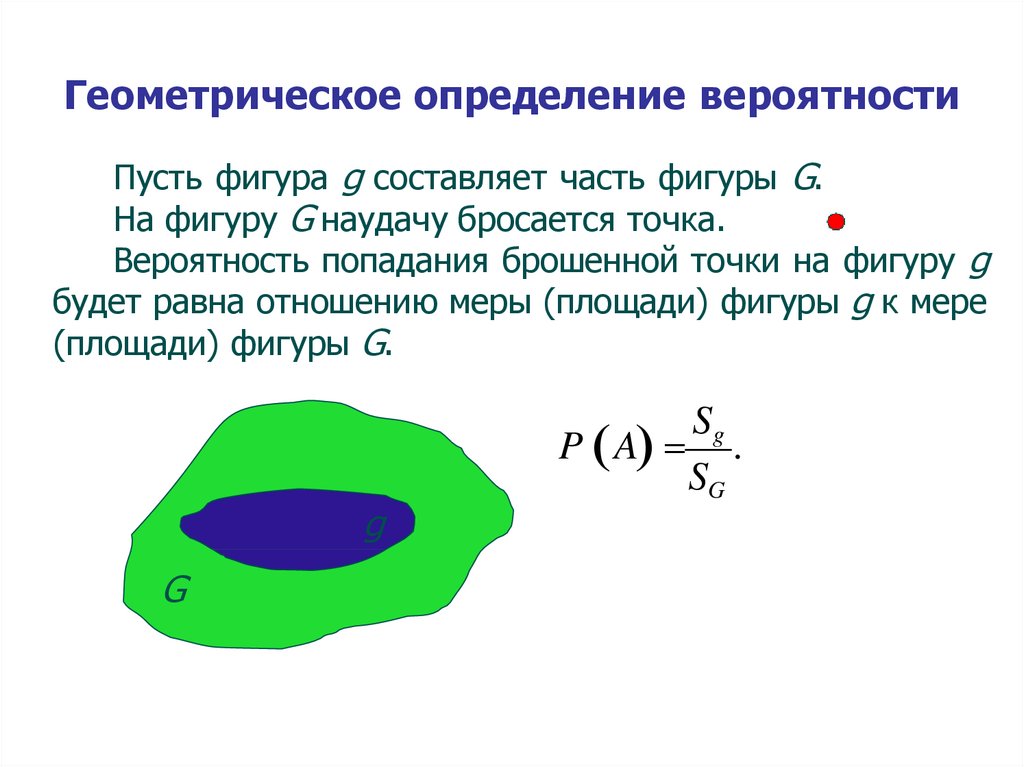

Геометрическое определение вероятностиПусть фигура g составляет часть фигуры G.

На фигуру G наудачу бросается точка.

Вероятность попадания брошенной точки на фигуру g

будет равна отношению меры (площади) фигуры g к мере

(площади) фигуры G.

g

G

Sg

P A .

SG

40.

Геометрическое определениевероятности

равна

Определение. Вероятность события A

отношению меры благоприятных исходов к мере общего

числа исходов.

mes A

P A

.

mes

41.

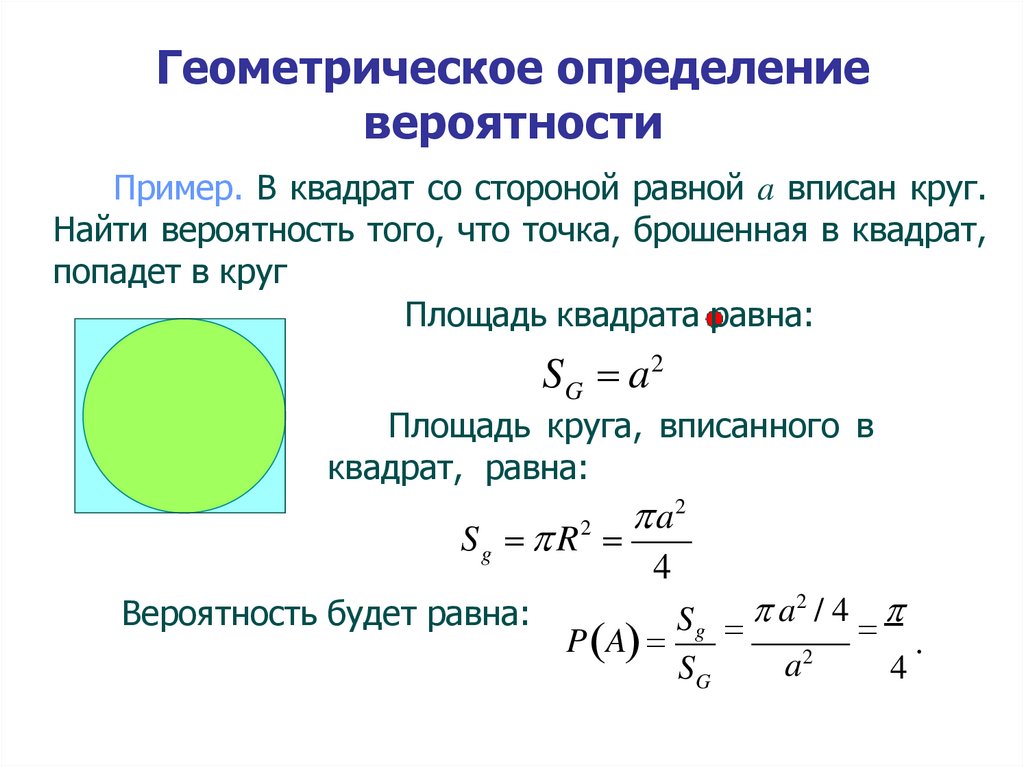

Геометрическое определениевероятности

Пример. В квадрат со стороной равной a вписан круг.

Найти вероятность того, что точка, брошенная в квадрат,

попадет в круг

Площадь квадрата равна:

SG a 2

Площадь круга, вписанного в

квадрат, равна:

Sg R

2

Вероятность будет равна:

a2

4

P A

2

a

/4

Sg

SG

a

2

4

.

42.

Спасибо за внимание43.

Анализ данныхАвтор:

доцент департамента

«Анализа данных, принятия решений и финансовых технологий»

к.ф.-м.н.

Потемкин Александр Владимирович

44.

Анализ данныхЛекция 2

Основные теоремы теории

вероятностей

45.

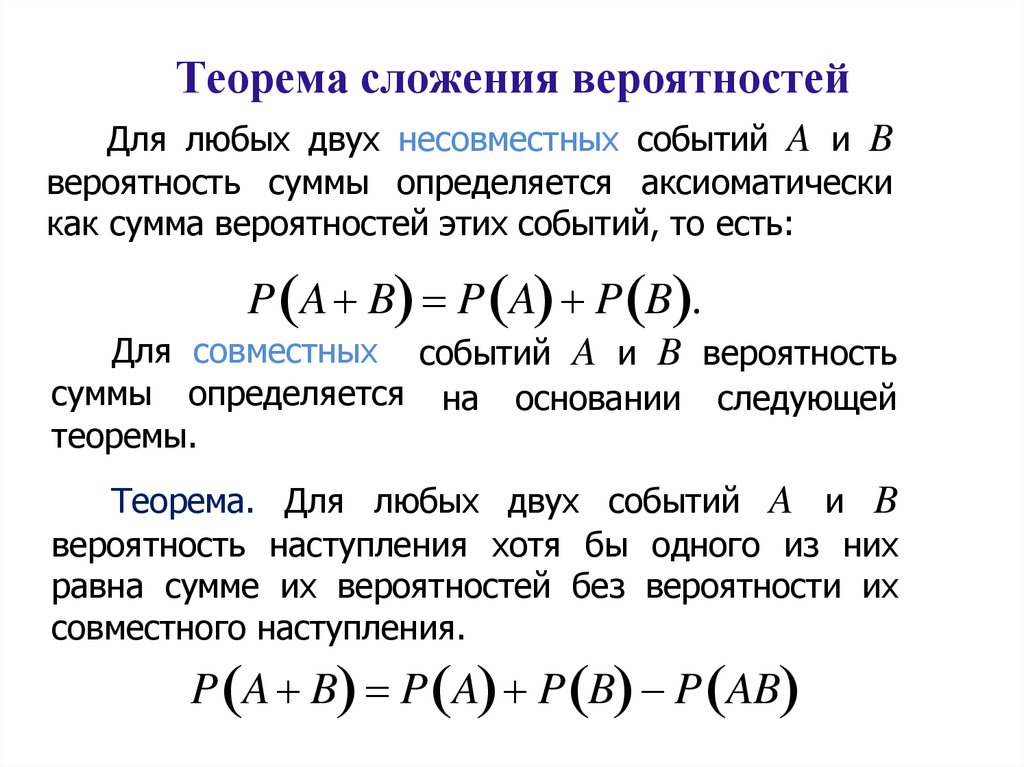

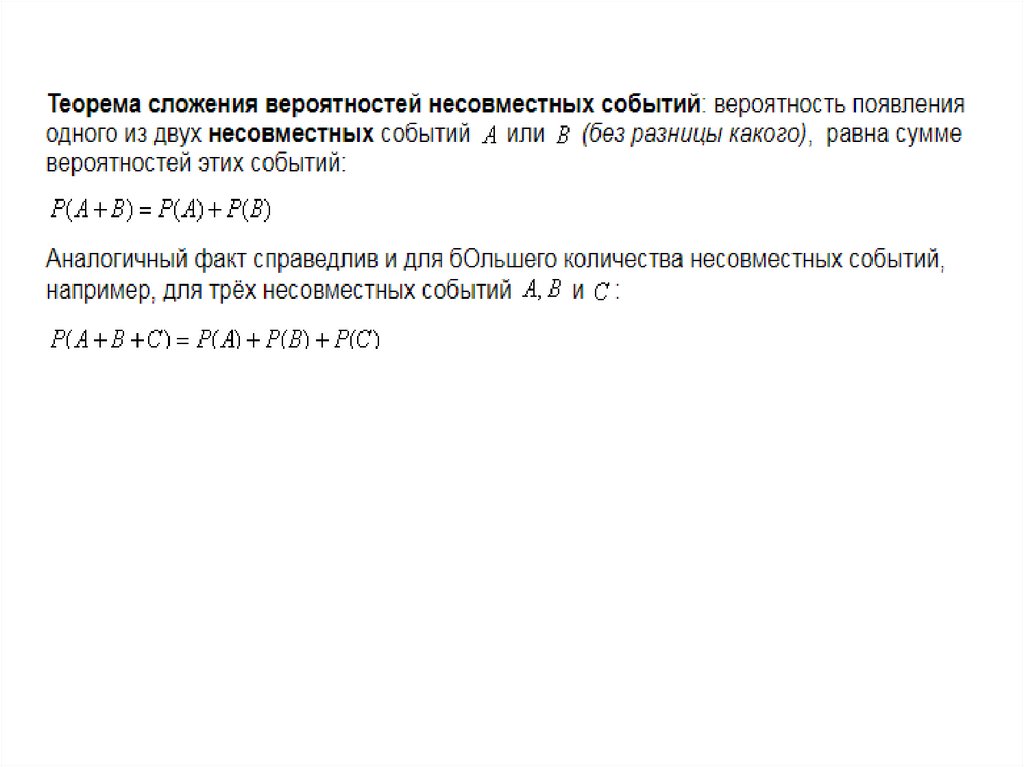

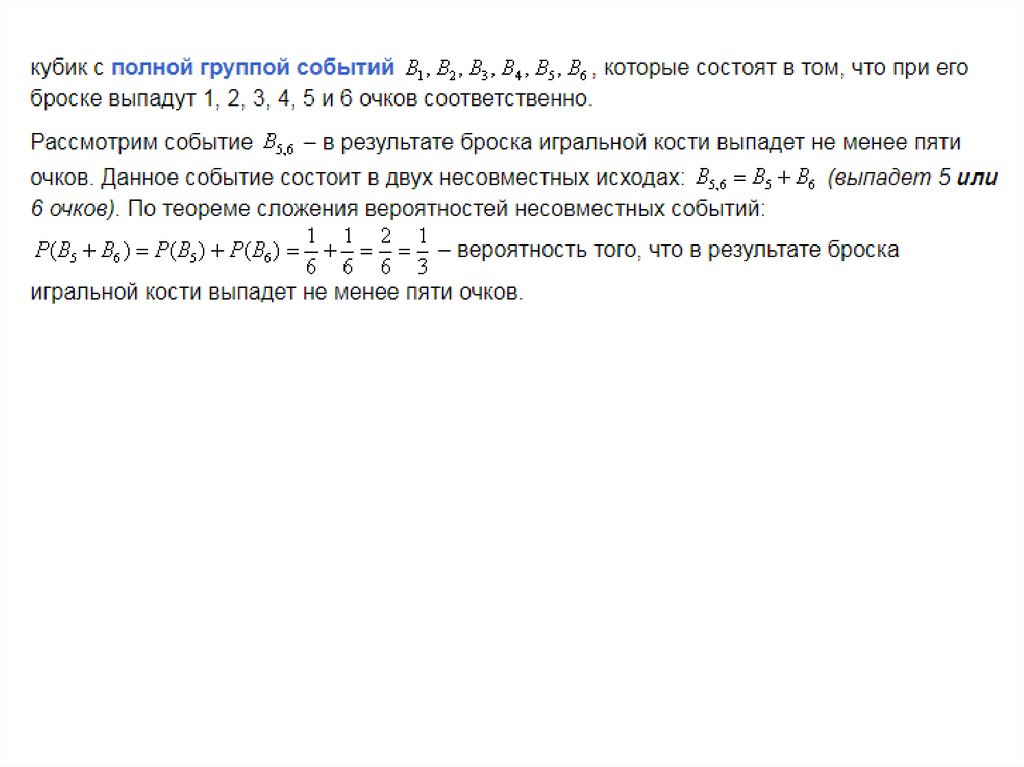

Теорема сложения вероятностейДля любых двух несовместных событий A и B

вероятность суммы определяется аксиоматически

как сумма вероятностей этих событий, то есть:

P A B P A P B .

Для совместных событий A и B вероятность

суммы определяется на основании следующей

теоремы.

Теорема. Для любых двух событий A и B

вероятность наступления хотя бы одного из них

равна сумме их вероятностей без вероятности их

совместного наступления.

P A B P A P B P AB

46.

47.

48.

11/20 = 0,5549.

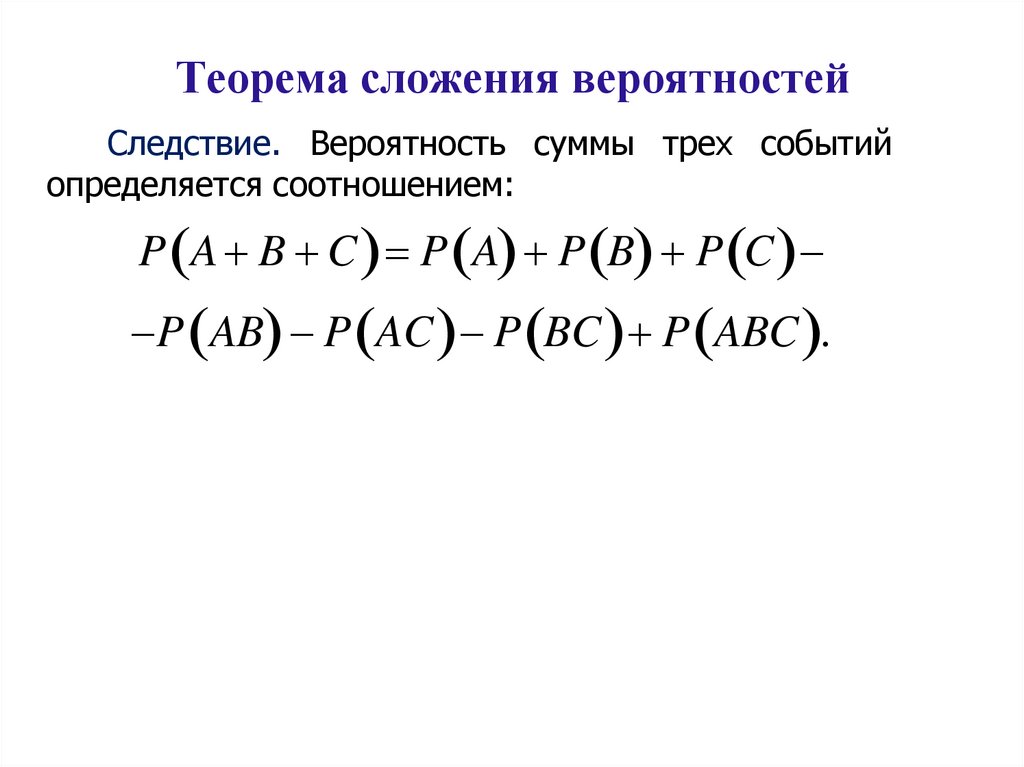

Теорема сложения вероятностейСледствие. Вероятность суммы трех событий

определяется соотношением:

P A B C P A P B P C

P AB P AC P BC P ABC .

50.

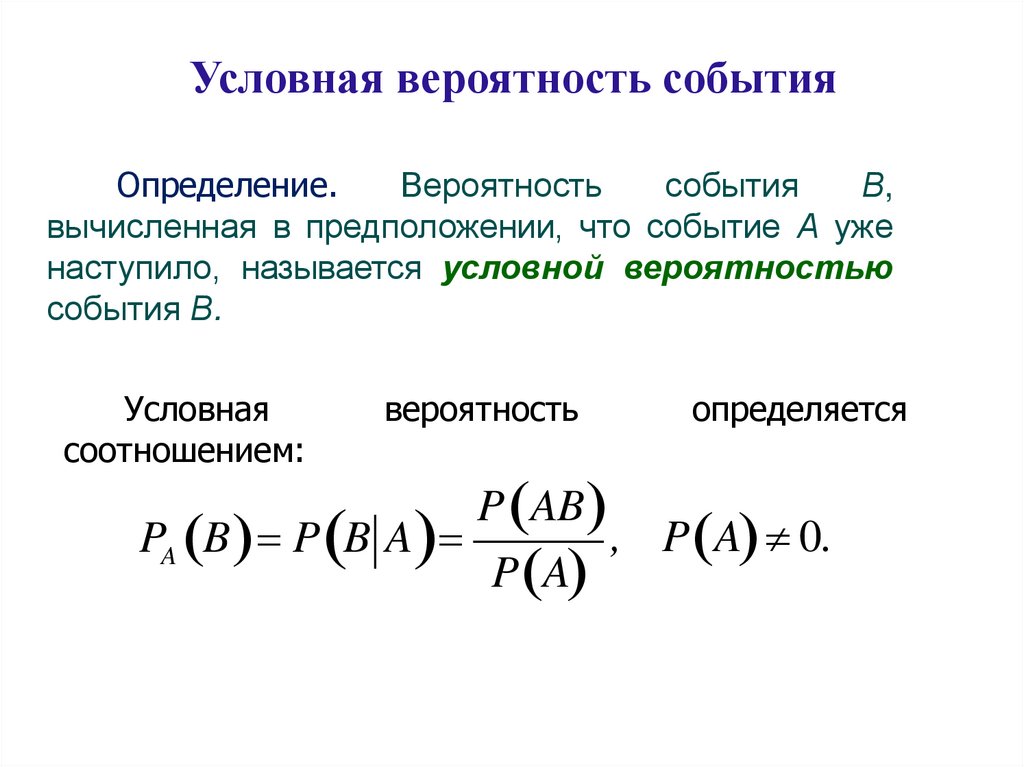

Условная вероятность событияОпределение.

Вероятность

события

В,

вычисленная в предположении, что событие А уже

наступило, называется условной вероятностью

события В.

Условная

соотношением:

вероятность

определяется

P AB

, P A 0.

PA B P B A

P A

51.

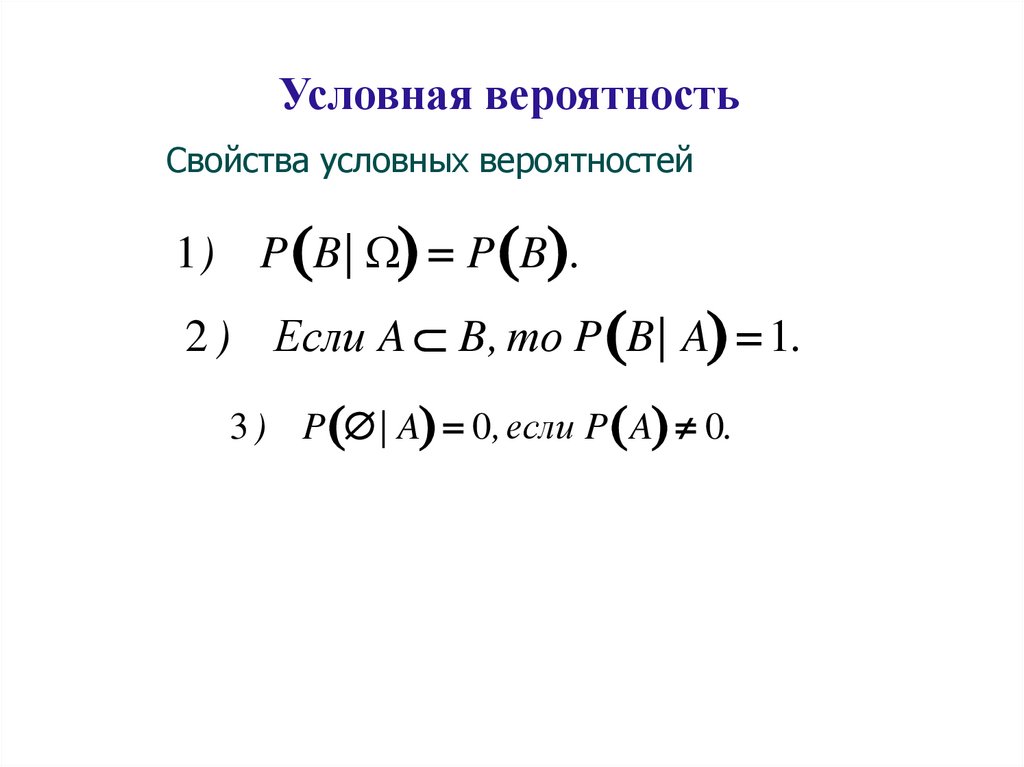

Условная вероятностьСвойства условных вероятностей

1) P B| P B .

2 ) Если A B, то P B| A 1.

3 ) P | A 0, если P A 0.

52.

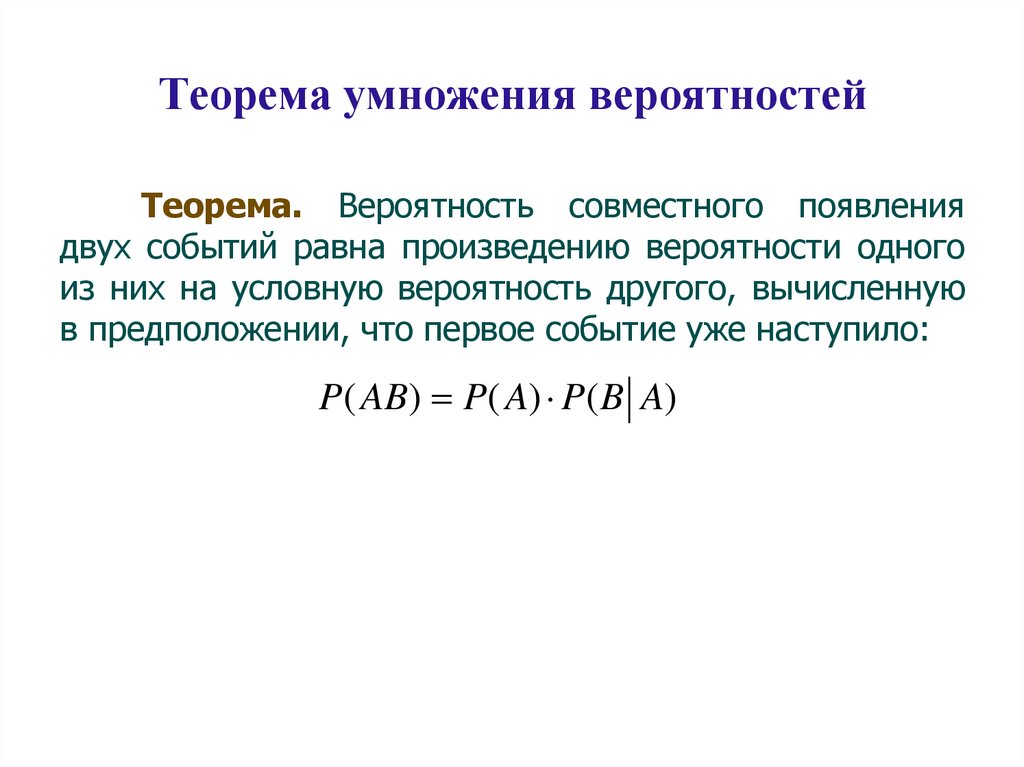

Теорема умножения вероятностейТеорема. Вероятность совместного появления

двух событий равна произведению вероятности одного

из них на условную вероятность другого, вычисленную

в предположении, что первое событие уже наступило:

P( AB) P( A) P(B A)

53.

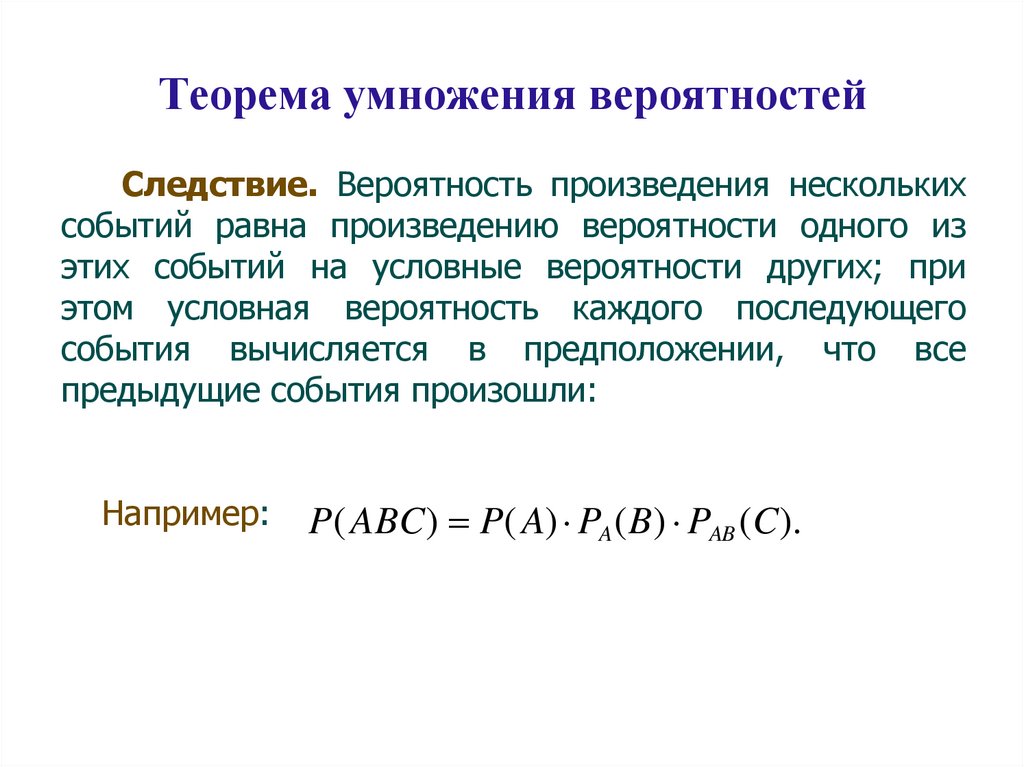

Теорема умножения вероятностейСледствие. Вероятность произведения нескольких

событий равна произведению вероятности одного из

этих событий на условные вероятности других; при

этом условная вероятность каждого последующего

события вычисляется в предположении, что все

предыдущие события произошли:

Например:

P( ABC) P( A) PA (B) PAB (C).

54.

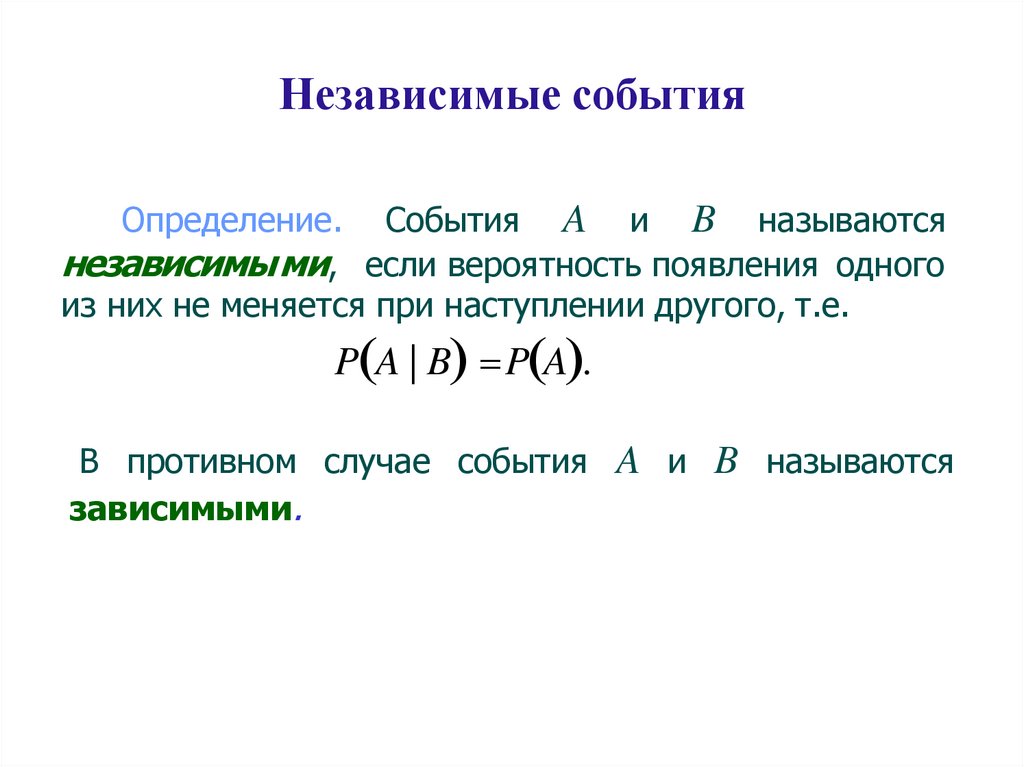

Независимые событияОпределение. События A и B называются

независимыми, если вероятность появления одного

из них не меняется при наступлении другого, т.е.

P A | B P A .

В противном случае события A и B называются

зависимыми.

55.

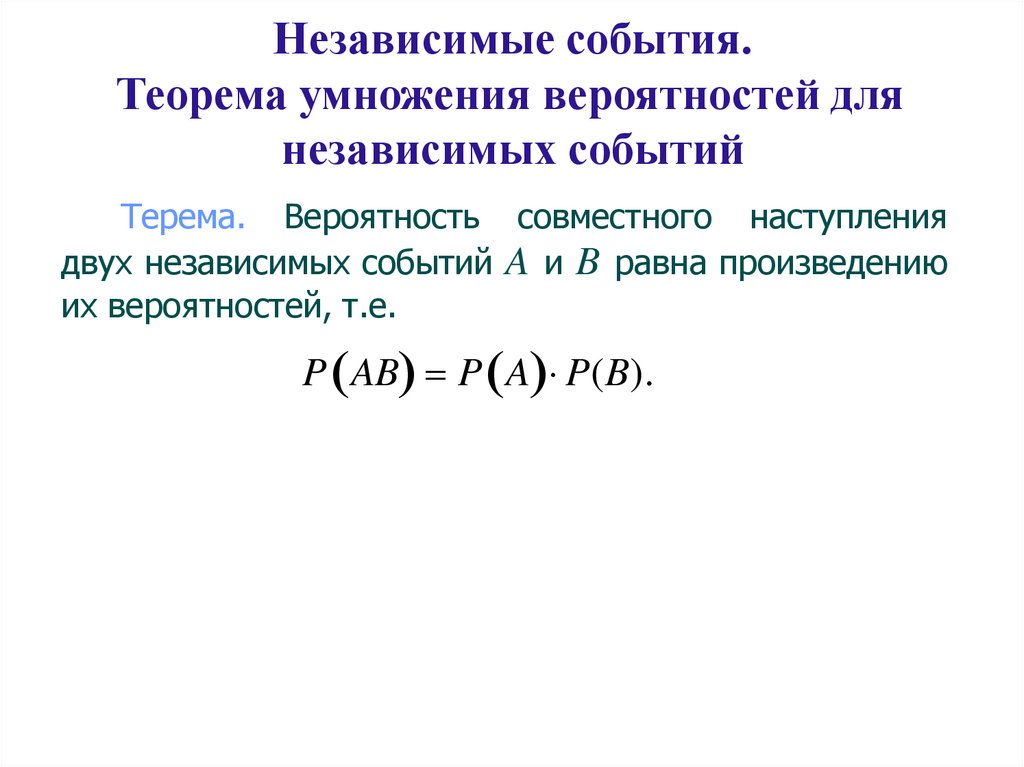

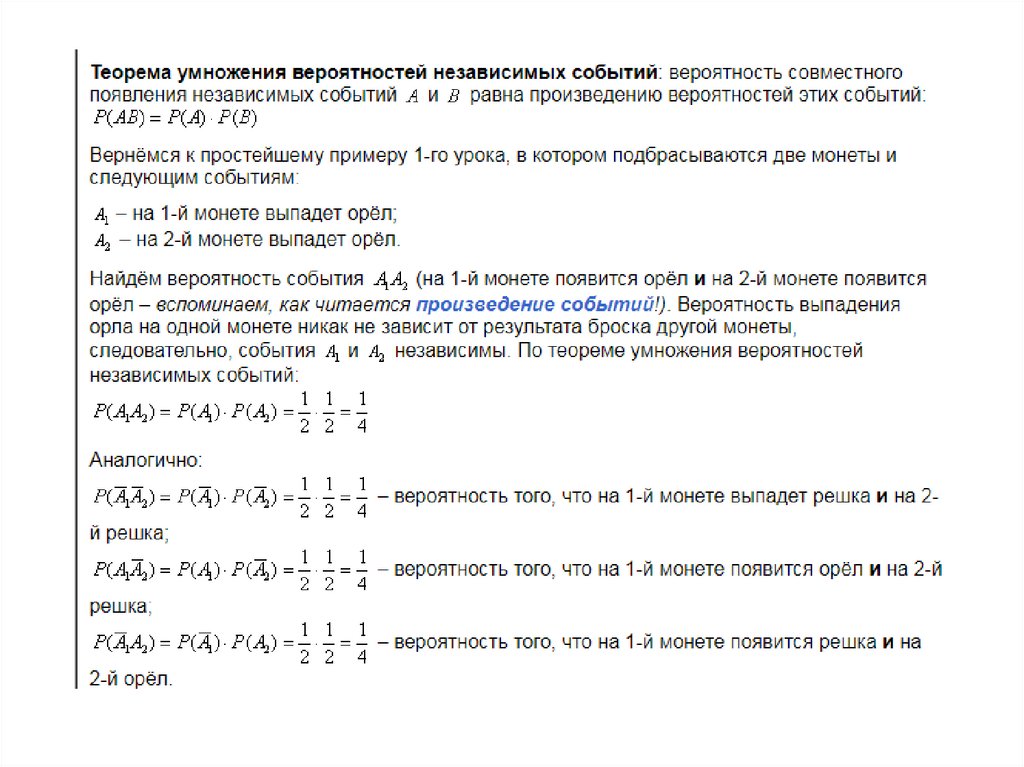

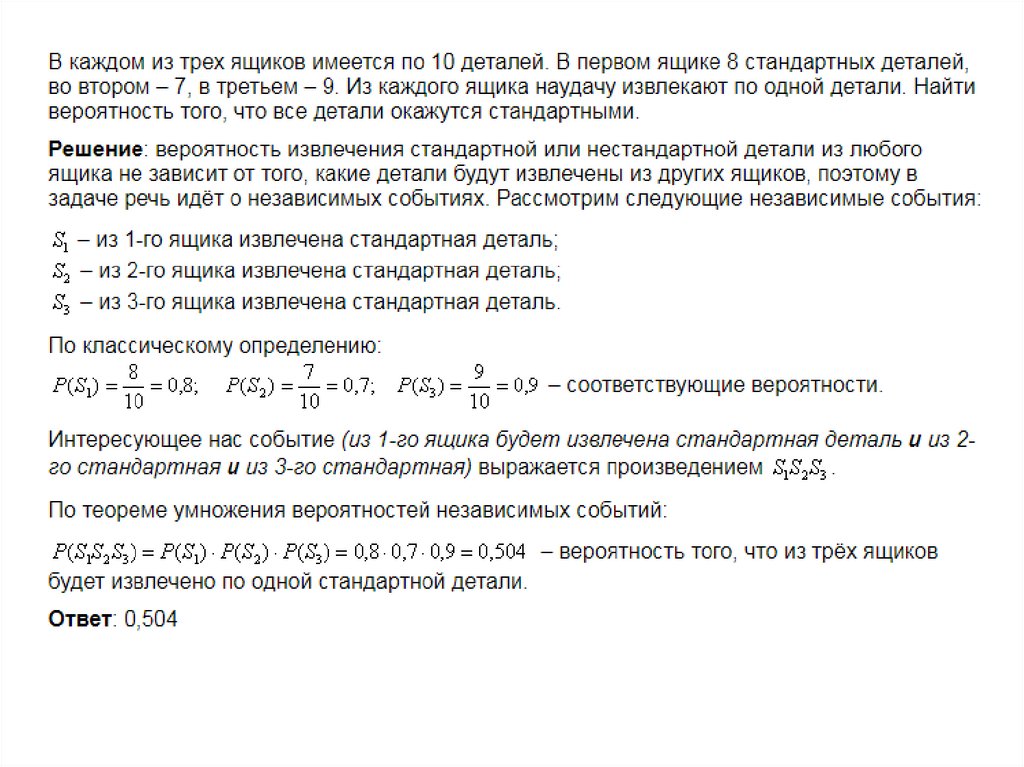

Независимые события.Теорема умножения вероятностей для

независимых событий

Терема. Вероятность совместного наступления

двух независимых событий A и B равна произведению

их вероятностей, т.е.

P AB P A P(B).

56.

Свойства независимых событий1. Если события А и В имеют ненулевые вероятности, то

если событие A не зависит от события B, то и событие

B не зависит от события A.

Доказательство. Пусть

P A | B P A ,

P AB

P AB P A P B .

P A

P B

P AB P A P B

P B .

Рассмотрим P B | A

P A

P A

тогда

57.

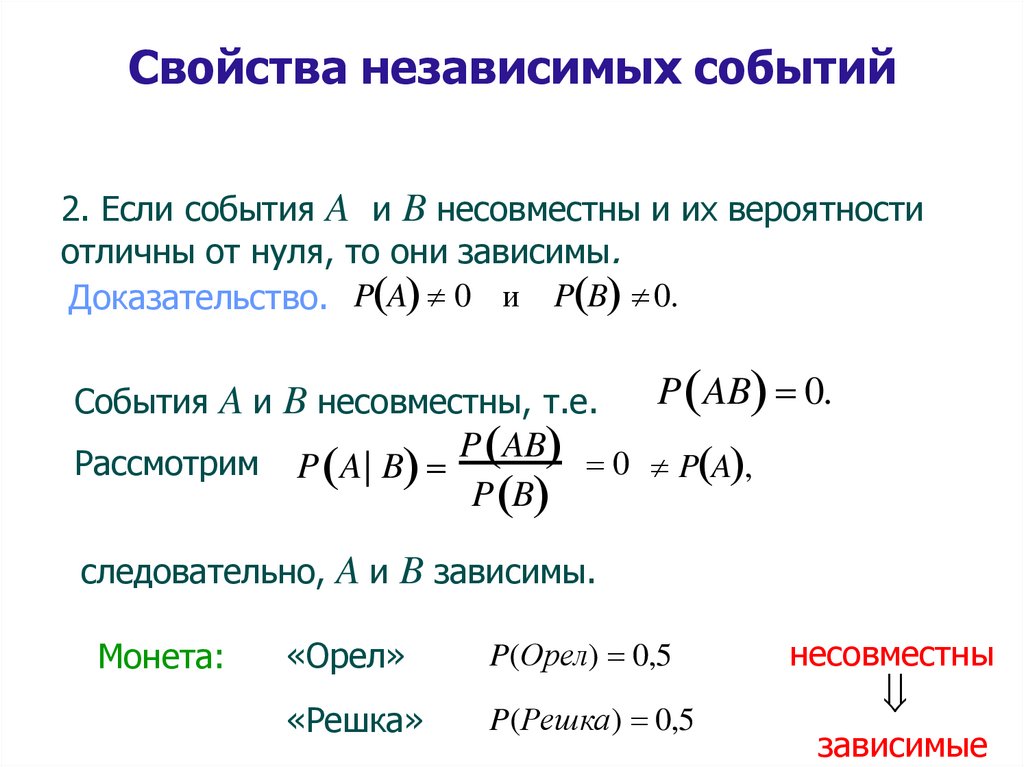

Свойства независимых событий2. Если события A и B несовместны и их вероятности

отличны от нуля, то они зависимы.

Доказательство. P A 0 и P B 0.

События A и B несовместны, т.е.

Рассмотрим

P A| B

P AB 0.

P AB 0

P A ,

P B

следовательно, A и B зависимы.

Монета:

«Орел»

P(Орел) 0,5

«Решка»

P(Решка) 0,5

несовместны

зависимые

58.

Свойства независимых событий3. Если события А и В имеют ненулевые вероятности и

независимы, то независимы и события:

A и B,

A и B,

A и B.

59.

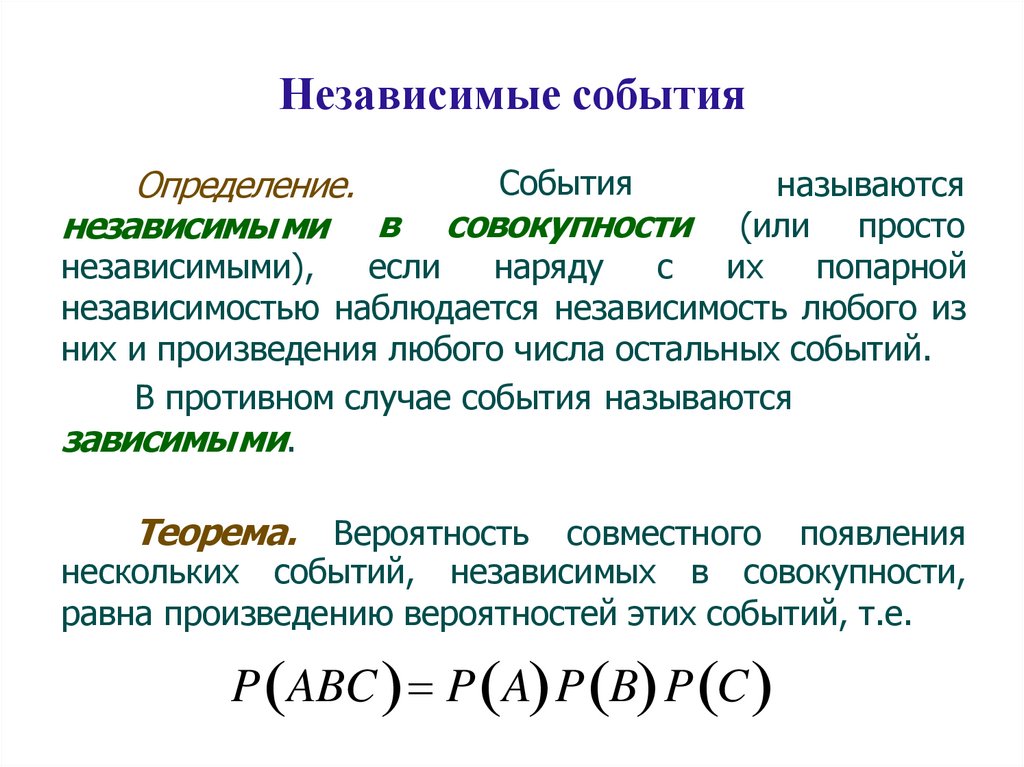

Независимые событияОпределение.

независимы ми в

События

называются

совокупности (или просто

независимыми),

если

наряду

с

их

попарной

независимостью наблюдается независимость любого из

них и произведения любого числа остальных событий.

В противном случае события называются

зависимыми.

Теорема. Вероятность

совместного появления

нескольких событий, независимых в совокупности,

равна произведению вероятностей этих событий, т.е.

P ABC P A P B P C

60.

Вероятность наступления хотя бы одногособытия

Замечание. В случаях трех и более совместных

событий соответствующая формула для вероятности

суммы весьма громоздка и проще переходить к

противоположному событию

Теорема.

Вероятность

суммы

нескольких

совместных событий (вероятность появления хотя бы

одного из них) равна разности между единицей и

вероятностью

произведения

противоположных

событий:

Р А1 А2 ... Аn 1 Р А1А2...An

61.

62.

63.

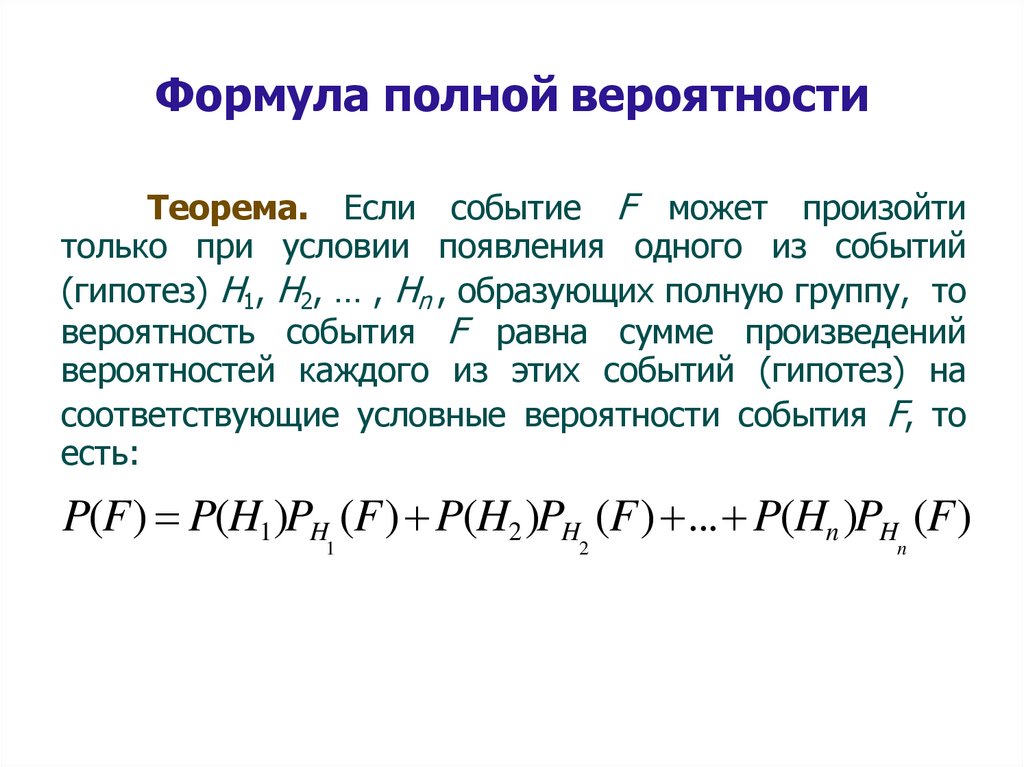

Формула полной вероятностиТеорема. Если событие F может произойти

только при условии появления одного из событий

(гипотез) H1, H2, … , Hn , образующих полную группу, то

вероятность события F равна сумме произведений

вероятностей каждого из этих событий (гипотез) на

соответствующие условные вероятности события F, то

есть:

P(F) P(H1)PH (F) P(H2 )PH (F) ... P(Hn )PH (F)

1

2

n

64.

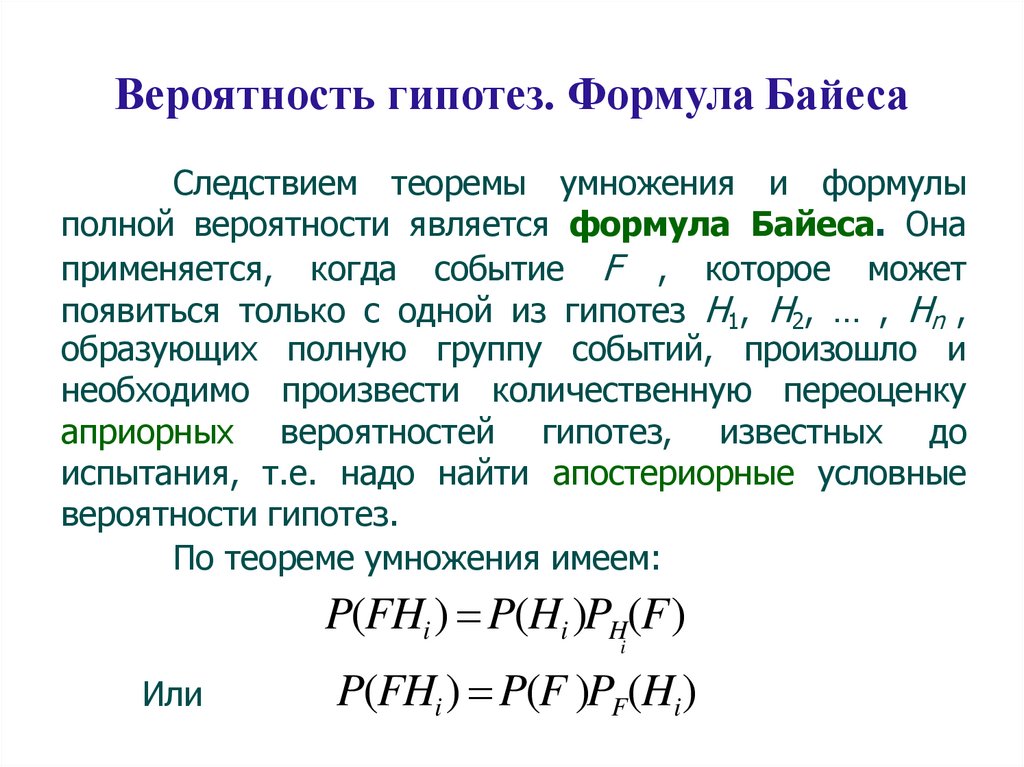

Вероятность гипотез. Формула БайесаСледствием теоремы умножения и формулы

полной вероятности является формула Байеса. Она

применяется, когда событие F , которое может

появиться только с одной из гипотез H1, H2, … , Hn ,

образующих полную группу событий, произошло и

необходимо произвести количественную переоценку

априорных вероятностей гипотез, известных до

испытания, т.е. надо найти апостериорные условные

вероятности гипотез.

По теореме умножения имеем:

P(FHi ) P(Hi )PH(F)

i

Или

P(FHi ) P(F )PF(Hi)

65.

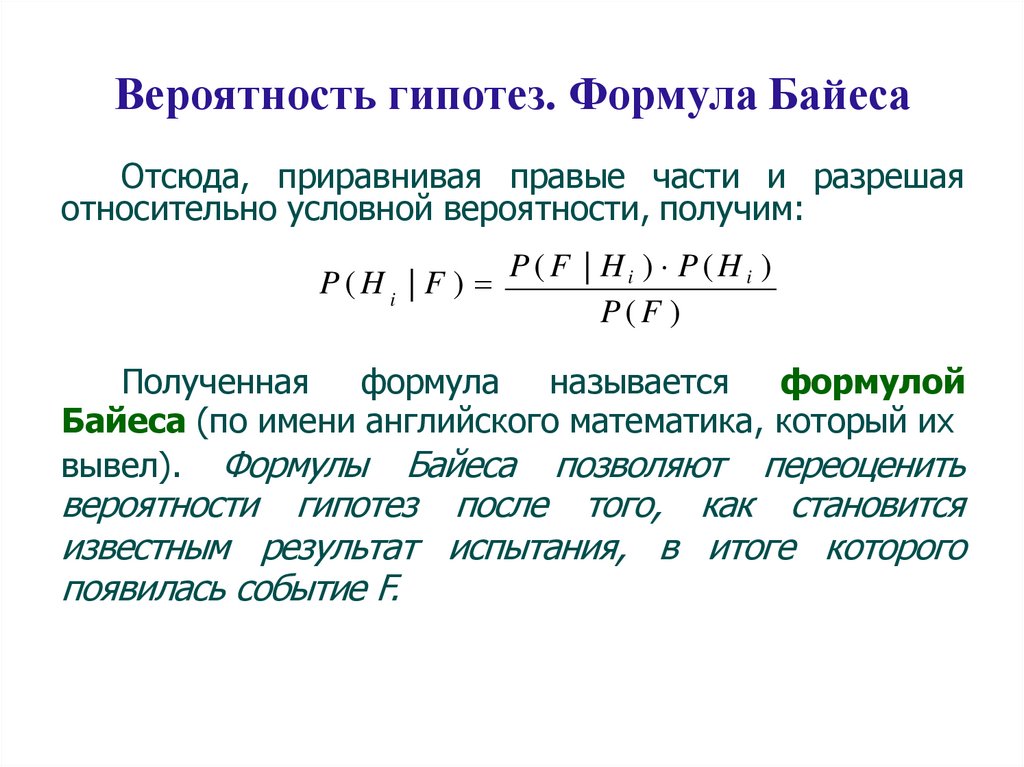

Вероятность гипотез. Формула БайесаОтсюда, приравнивая правые части и разрешая

относительно условной вероятности, получим:

P(Hi | F )

P(F | Hi ) P(Hi )

P(F )

Полученная формула называется формулой

Байеса (по имени английского математика, который их

вывел). Формулы Байеса позволяют переоценить

вероятности гипотез после того, как становится

известным результат испытания, в итоге которого

появилась событие F.

66.

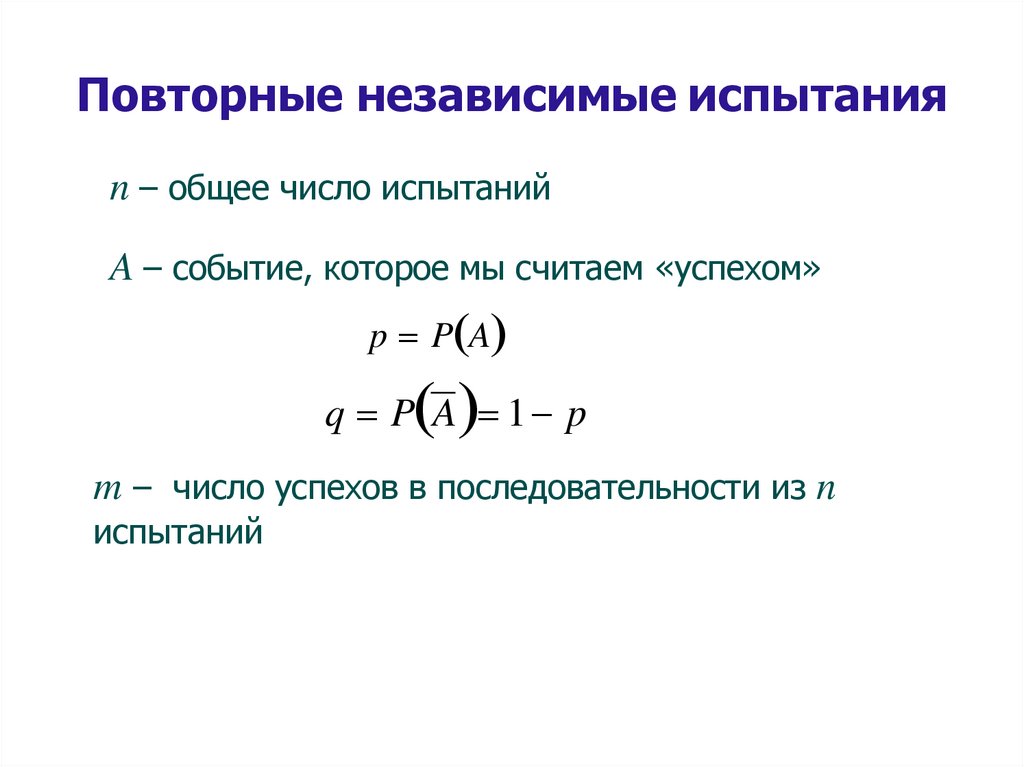

Повторные независимые испытанияn – общее число испытаний

A – событие, которое мы считаем «успехом»

p P A

q P A 1 p

m – число успехов в последовательности из n

испытаний

67.

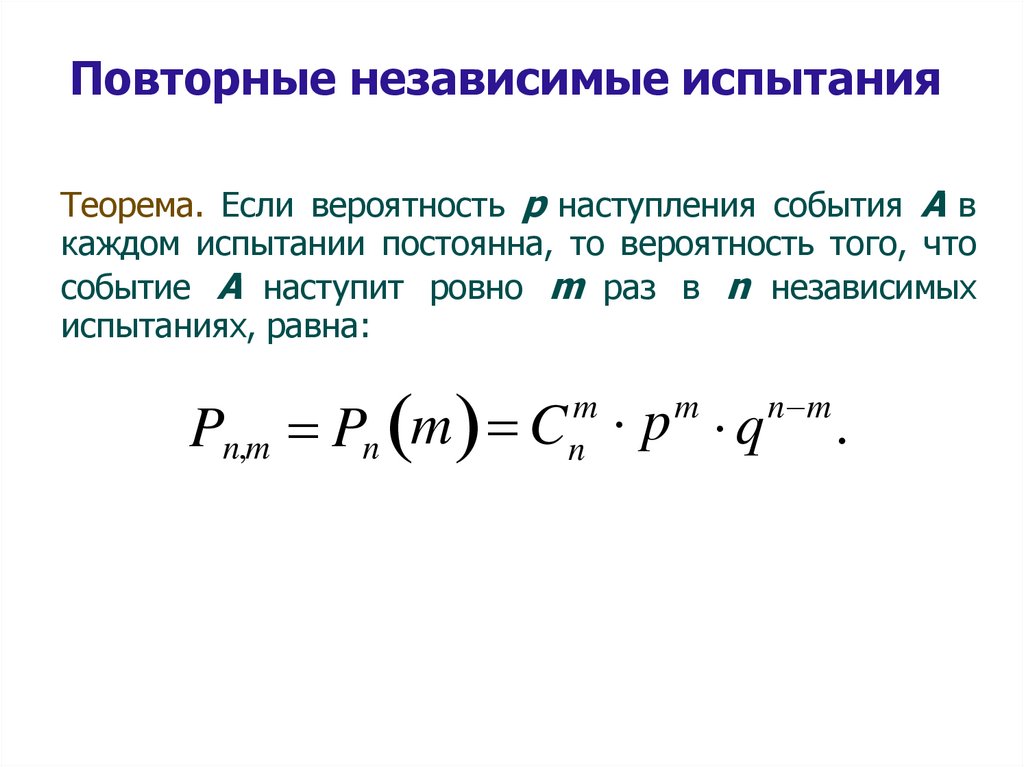

Повторные независимые испытанияТеорема. Если вероятность р наступления события А в

каждом испытании постоянна, то вероятность того, что

событие А наступит ровно m раз в n независимых

испытаниях, равна:

Pn,m Pn m C p q

m

n

m

n m

.

68.

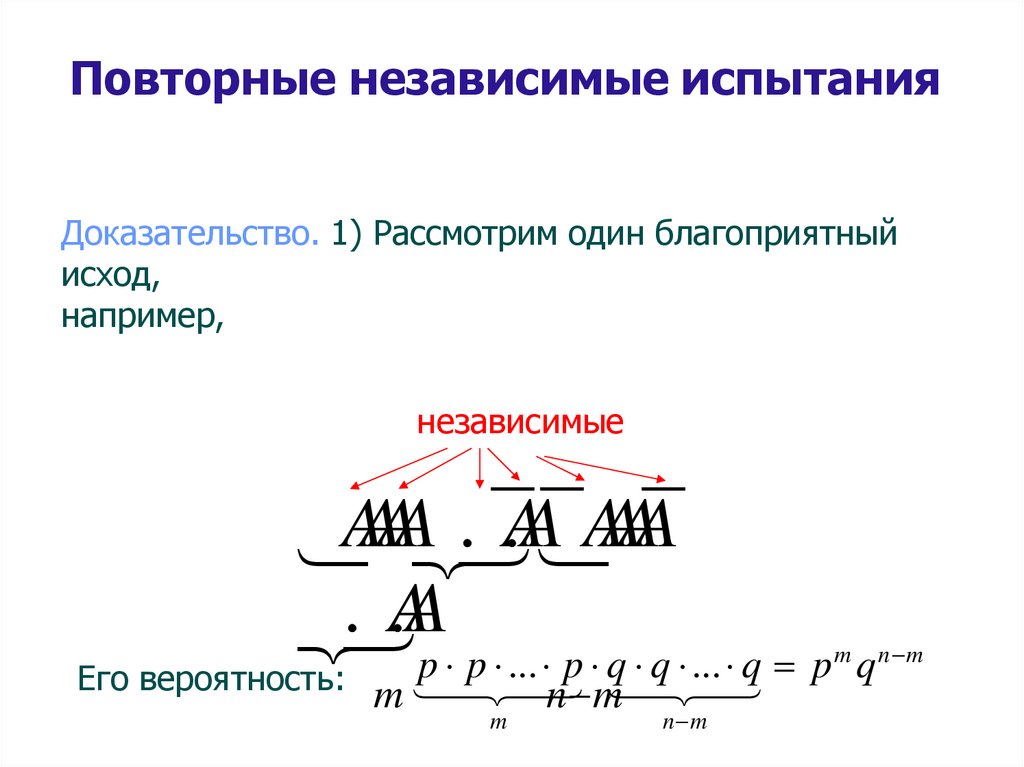

Повторные независимые испытанияДоказательство. 1) Рассмотрим один благоприятный

исход,

например,

независимые

A

A

A

A

.

.

A

A

A

A

A

A

. .AAp p ... p q q ... q p q

Его вероятность:

m

n m

m

n m

m

n m

69.

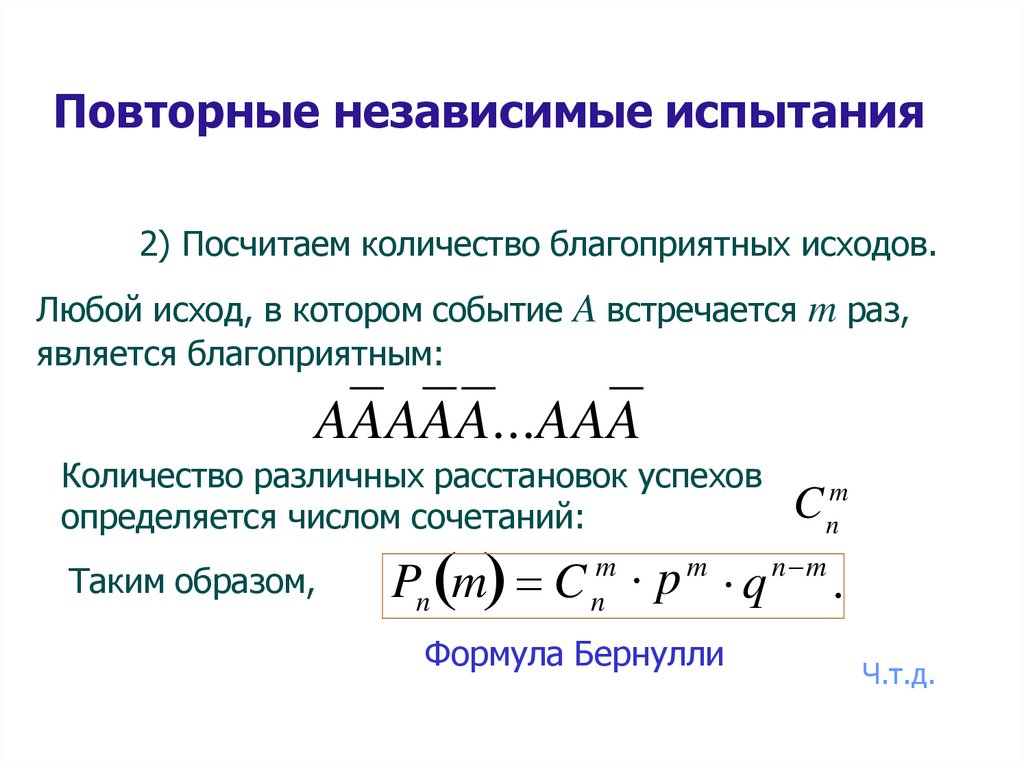

Повторные независимые испытания2) Посчитаем количество благоприятных исходов.

Любой исход, в котором событие A встречается m раз,

является благоприятным:

AAAAA...AAA

Количество различных расстановок успехов

определяется числом сочетаний:

Таким образом,

C nm

Pn m C nm p m q n m .

Формула Бернулли

Ч.т.д.

70.

Применение формулы Бернулли при большихзначениях n затруднительно. Поэтому возникает

желание иметь более простые формулы для

вычисления вероятности при больших n. Такие

формулы называются асимптотическими.

71.

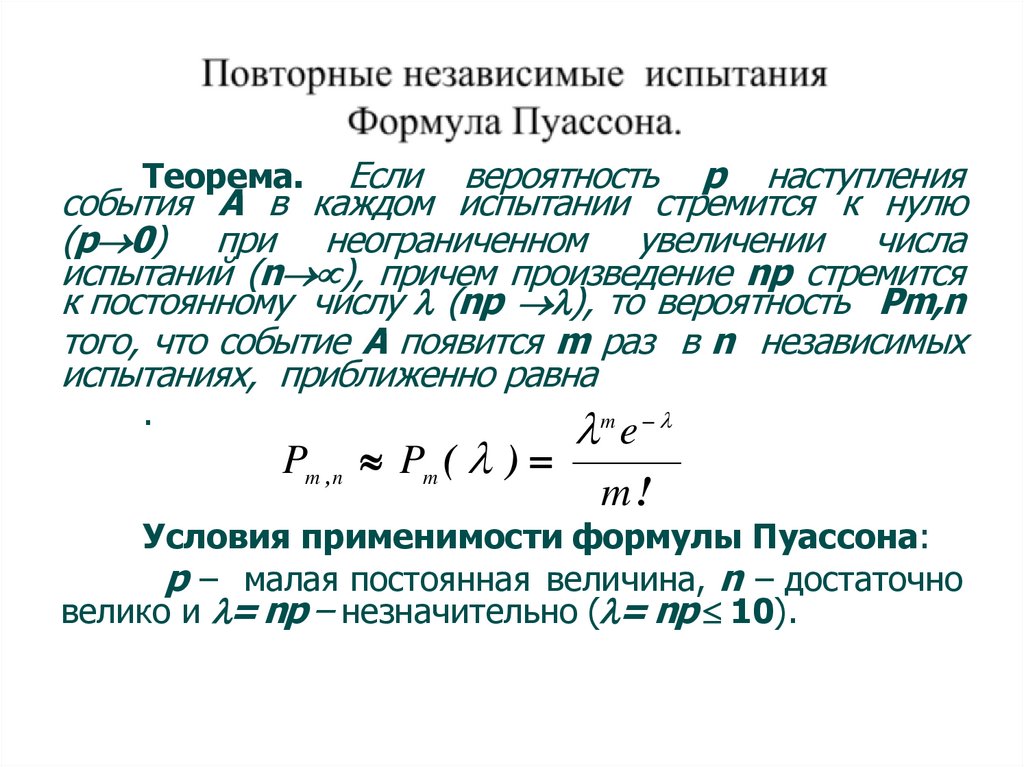

Если вероятность р наступлениясобытия А в каждом испытании стремится к нулю

(р 0) при неограниченном увеличении числа

испытаний (n ), причем произведение np стремится

к постоянному числу (np ), то вероятность Pm,n

того, что событие А появится m раз в n независимых

испытаниях, приближенно равна

Теорема.

.

Pm ,n Pm ( )

m e

m!

Условия применимости формулы Пуассона:

р – малая постоянная величина, n – достаточно

велико и = np – незначительно ( = np 10).

72.

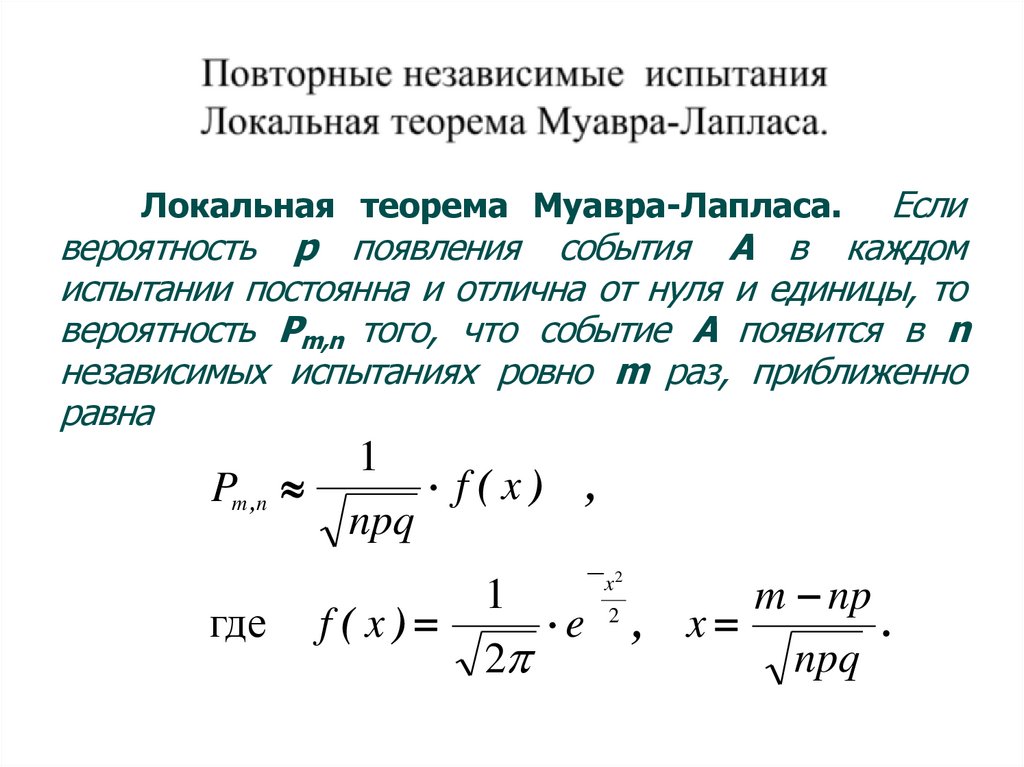

Есливероятность р появления события А в каждом

испытании постоянна и отлична от нуля и единицы, то

вероятность Рm,n того, что событие А появится в n

независимых испытаниях ровно m раз, приближенно

равна

Локальная теорема Муавра-Лапласа.

Pm ,n

где

1

f(x) ,

npq

f(x)

x2

1

m np

2

.

e , x

npq

2

73.

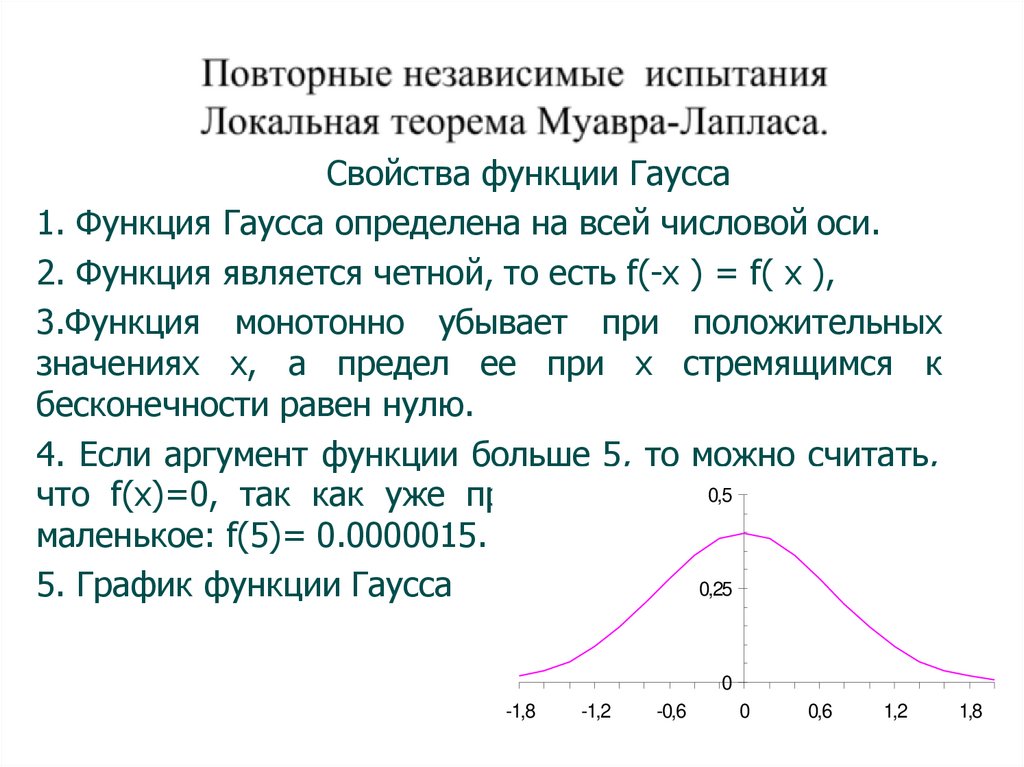

Свойства функции Гаусса1. Функция Гаусса определена на всей числовой оси.

2. Функция является четной, то есть f(-x ) = f( x ),

3.Функция монотонно убывает при положительных

значениях х, а предел ee при х стремящимся к

бесконечности равен нулю.

4. Если аргумент функции больше 5, то можно считать,

0,5

очень

что f(x)=0, так как уже при х=5 ее значение

маленькое: f(5)= 0.0000015.

0,25

5. График функции Гаусса

0

-1,8

-1,2

-0,6

0

0,6

1,2

1,8

74.

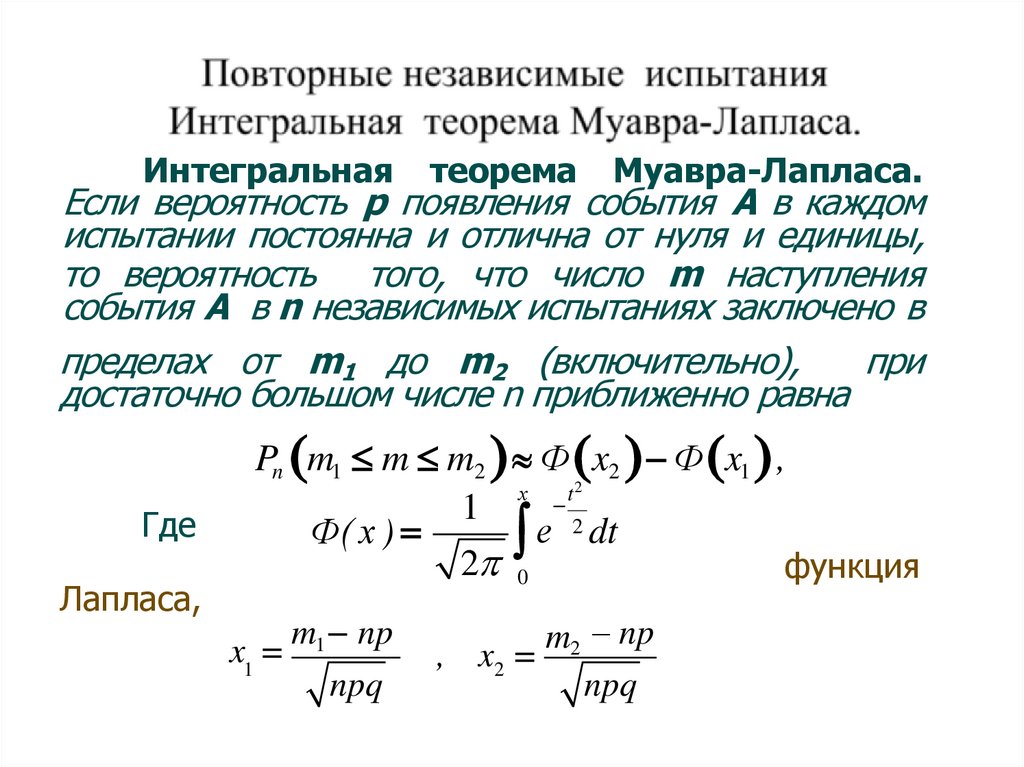

Интегральнаятеорема

Муавра-Лапласа.

Если вероятность р появления события А в каждом

испытании постоянна и отлична от нуля и единицы,

то вероятность того, что число m наступления

события А в n независимых испытаниях заключено в

пределах от m1 до m2 (включительно),

при

достаточно большом числе n приближенно равна

Где

Лапласа,

Pn m1 m m2 Ф x2 Ф x1 ,

х

t2

1

2 dt

е

Ф( х )

2 0

функция

m np

x1 1

npq

m2 np

, x2

npq

75.

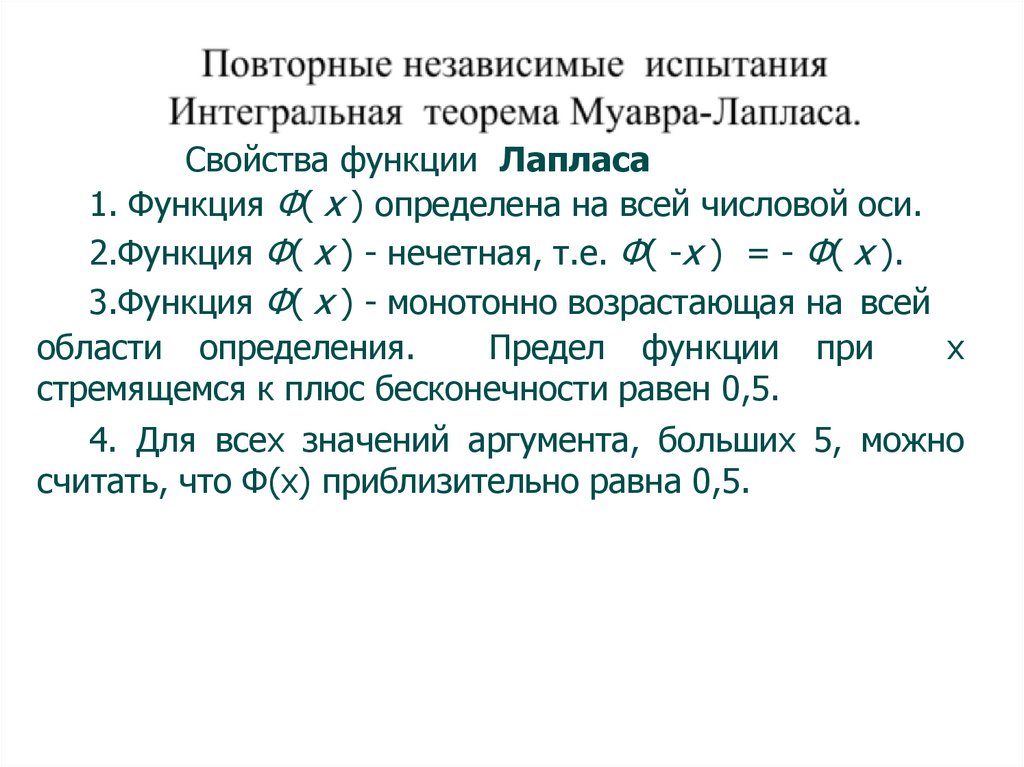

Свойства функции Лапласа1. Функция Ф( х ) определена на всей числовой оси.

2.Функция Ф( х ) - нечетная, т.е. Ф( -х ) = - Ф( х ).

3.Функция Ф( х ) - монотонно возрастающая на всей

области определения.

Предел функции при

х

стремящемся к плюс бесконечности равен 0,5.

4. Для всех значений аргумента, больших 5, можно

считать, что Ф(х) приблизительно равна 0,5.

76.

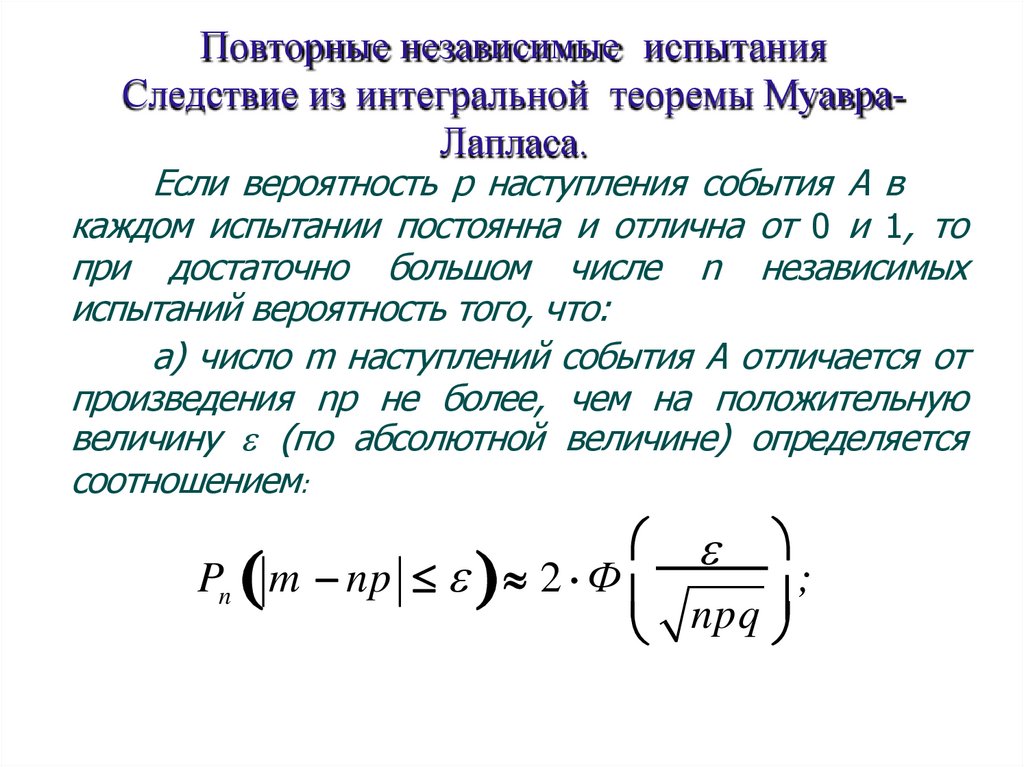

Повторные независимые испытанияСледствие из интегральной теоремы МуавраЛапласа.

Если вероятность р наступления события А в

каждом испытании постоянна и отлична от 0 и 1, то

при достаточно большом числе n независимых

испытаний вероятность того, что:

а) число m наступлений события А отличается от

произведения np не более, чем на положительную

величину (по абсолютной величине) определяется

соотношением:

Pn m np 2 Ф

;

npq

77.

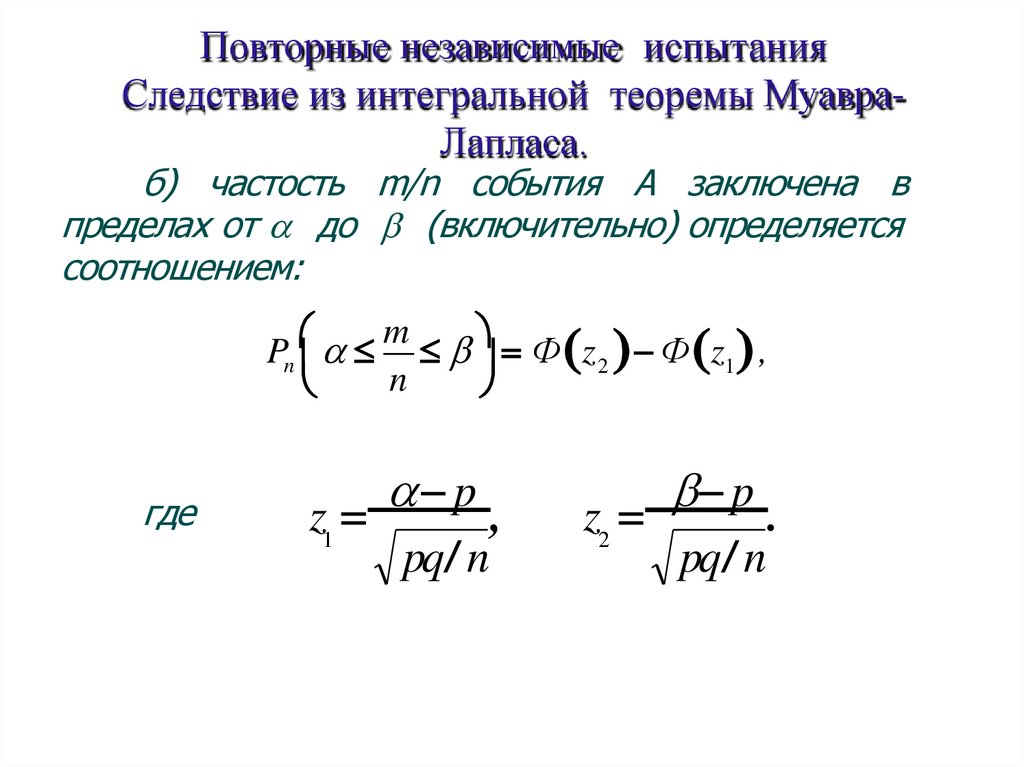

Повторные независимые испытанияСледствие из интегральной теоремы МуавраЛапласа.

б) частость m/n события А заключена в

пределах от до (включительно) определяется

соотношением:

m

Pn Ф z 2 Ф z1 ,

n

где

p

z

,

1

pq / n

p

z

.

2

pq / n

78.

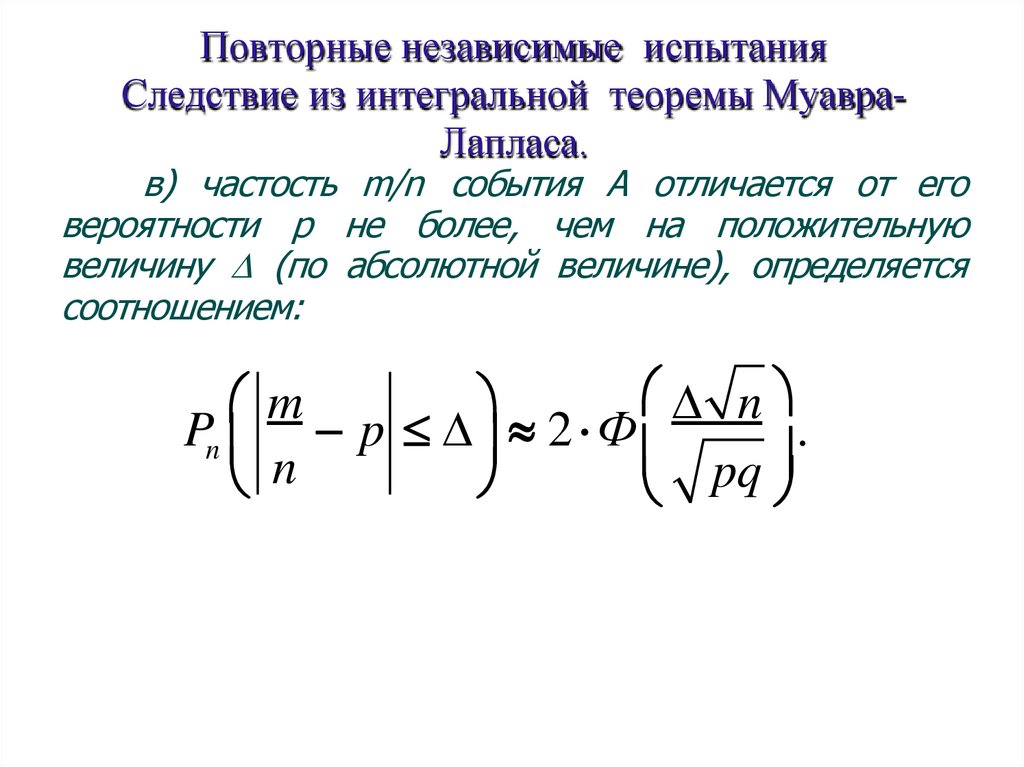

Повторные независимые испытанияСледствие из интегральной теоремы МуавраЛапласа.

в) частость m/n события А отличается от его

вероятности р не более, чем на положительную

величину (по абсолютной величине), определяется

соотношением:

n

m

Pn p 2 Ф

.

n

pq

79.

случайная величинаОпределение. Случайной величиной называется

переменная, которая в результате испытания принимает

то или иное числовое значение.

Пример. Число попаданий в мишень при выстрелах –

случайная величина.

Пример. Рост наудачу взятого человека – случайная

величина.

80.

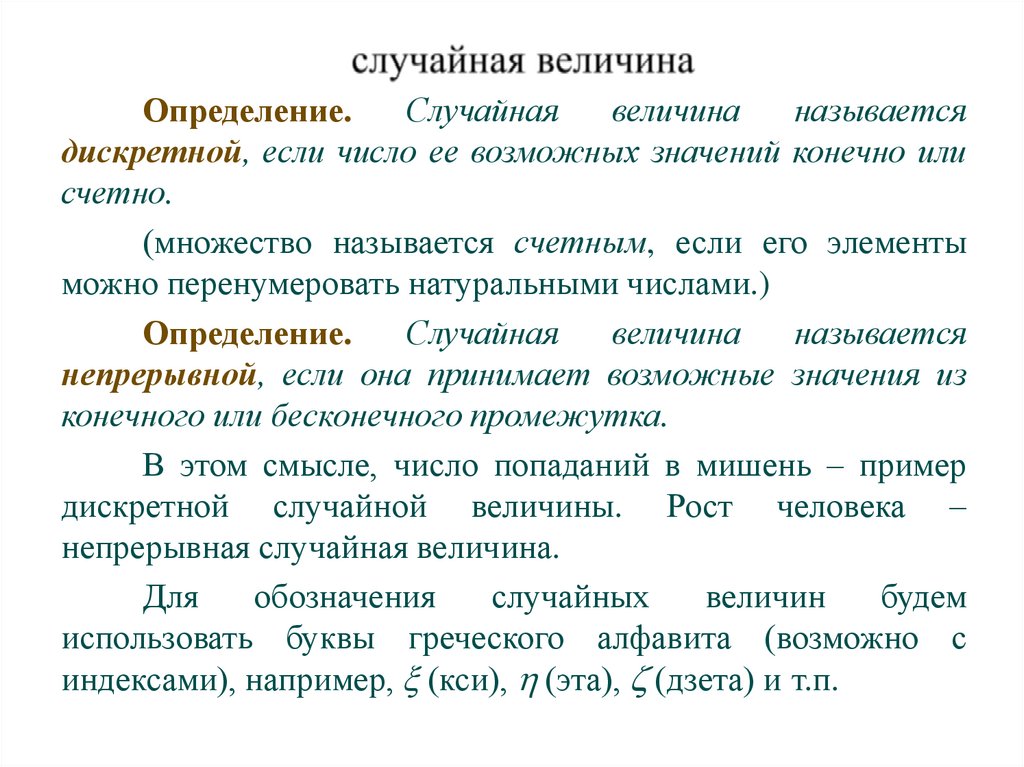

Определение.Случайная

величина

называется

дискретной, если число ее возможных значений конечно или

счетно.

(множество называется счетным, если его элементы

можно перенумеровать натуральными числами.)

Определение.

Случайная

величина

называется

непрерывной, если она принимает возможные значения из

конечного или бесконечного промежутка.

В этом смысле, число попаданий в мишень – пример

дискретной случайной величины. Рост человека –

непрерывная случайная величина.

Для

обозначения

случайных

величин

будем

использовать буквы греческого алфавита (возможно с

индексами), например, (кси), (эта), (дзета) и т.п.

81.

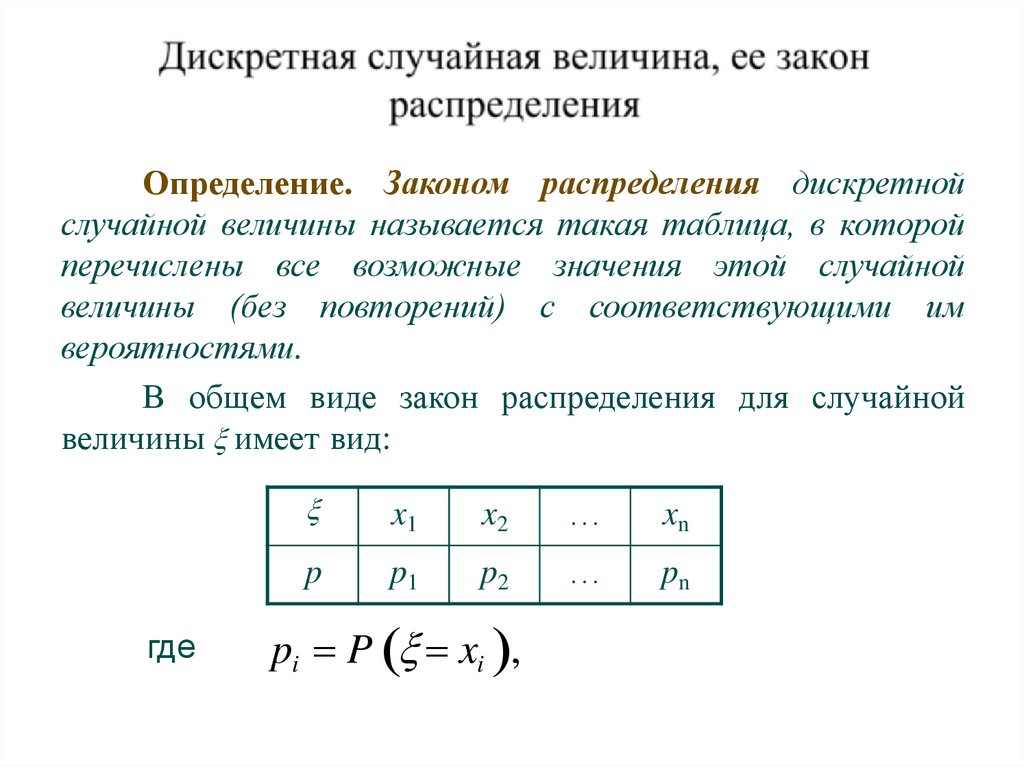

Определение. Законом распределения дискретнойслучайной величины называется такая таблица, в которой

перечислены все возможные значения этой случайной

величины (без повторений) с соответствующими им

вероятностями.

В общем виде закон распределения для случайной

величины имеет вид:

где

x1

x2

…

xn

p

p1

p2

…

pn

pi P xi ,

82.

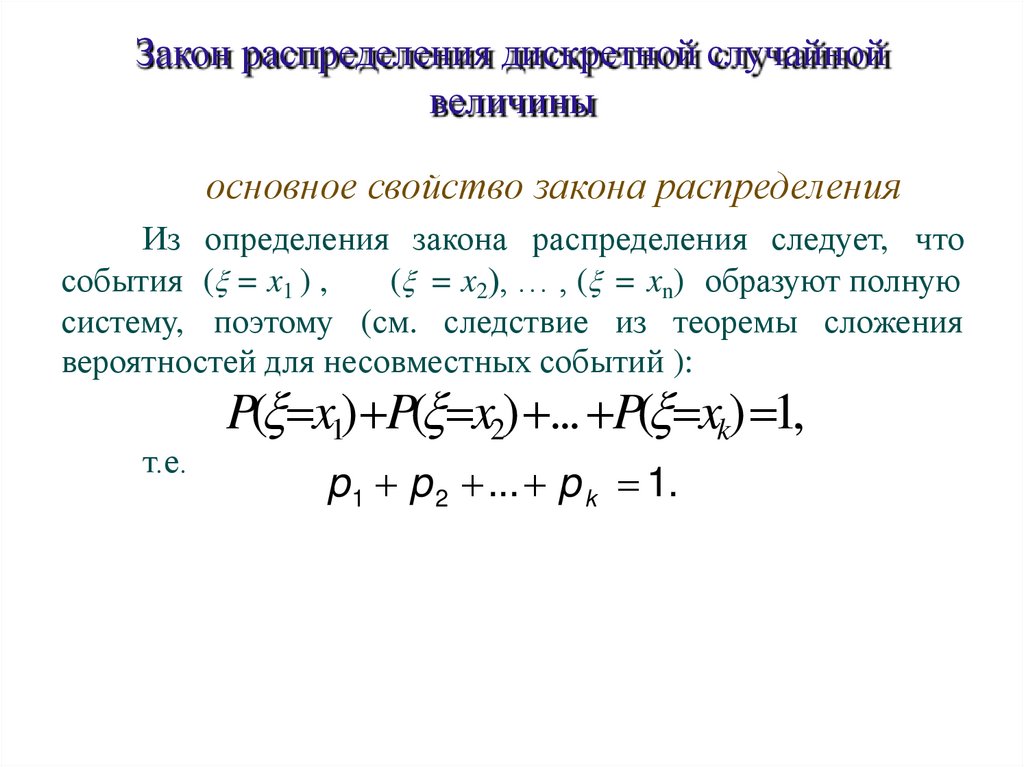

Закон распределения дискретной случайнойвеличины

основное свойство закона распределения

Из определения закона распределения следует, что

события ( = x1 ) ,

( = x2), … , ( = xn) образуют полную

систему, поэтому (см. следствие из теоремы сложения

вероятностей для несовместных событий ):

т.е.

P( x1) P( x2) ... P( xk) 1,

p 1 p 2 ... p k 1.

83.

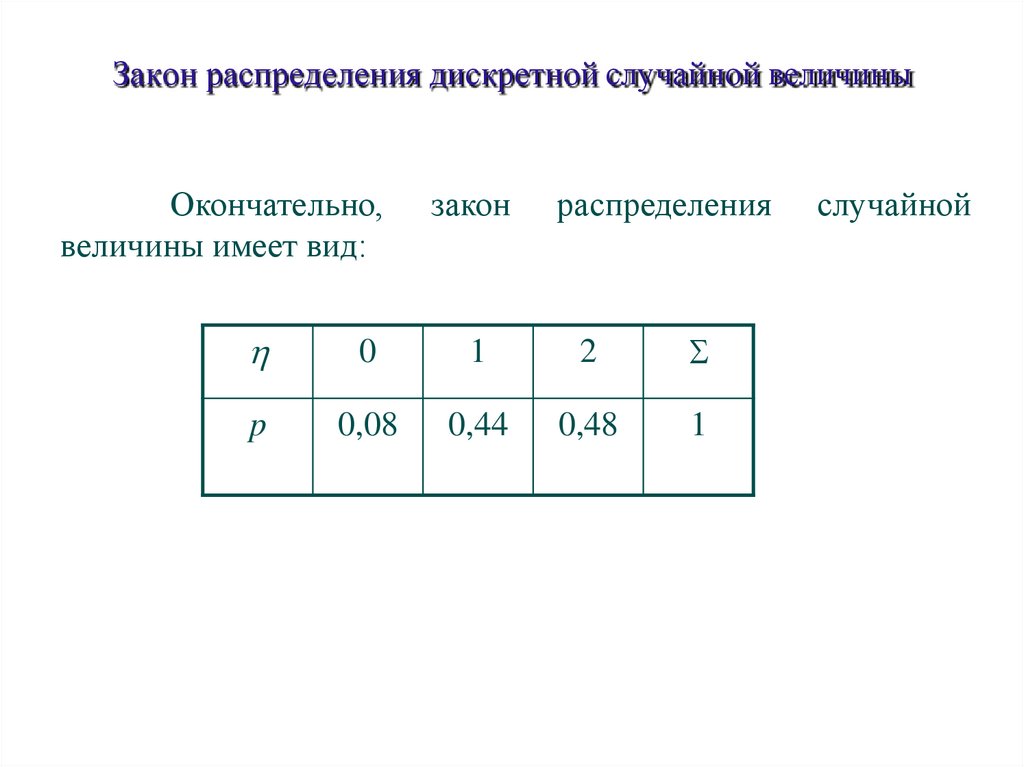

Закон распределения дискретной случайнойвеличины

Пример. Два стрелка одновременно выстреливают в

мишень. Вероятность попадания для первого равна 0,6,

для второго – 0,8. Составить закон распределения

случайной величины – общего числа попаданий в

мишень.

Решение. Возможные значения данной случайной

величины : 0, 1, 2. Обозначим события, состоящие в

попадании в мишень первого и второго стрелков через В1

и В2, соответственно.

P( 0) P(B1B2) P(B1)P(B2) (1 0,6) (1 0,8) 0, 4 0, 2 0,08;

P( 1) P(B1B2 B1B2) P(B1)P(B2) P(B1)P(B2) 0,6 0,2 0,4 0,8 0,44,

P( 2) P(B1B2 ) P(B1)P(B2 ) 0,6 0,8 0,48.

84.

Закон распределения дискретной случайной величиныОкончательно,

величины имеет вид:

закон

распределения

0

1

2

p

0,08

0,44

0,48

1

случайной

85.

Спасибо за внимание86.

Анализ данныхЛекция 3

Случайные величины, их законы

распределения.

87.

Арифметические операции над случайнымивеличинами

Пусть случайная величина и имеют следующие

законы распределения:

x1

x2

…

xn

y1

y2

…

ym

p

p1

p2

…

pn

p

p1

p2

…

pm

88.

Арифметические операции над случайными величинами1. Произведение сл.в. на постоянную величину С -это новая сл.в. С , которая с теми же вероятностями, что и

сл.в. принимает значения, равные, произведениям реализаций

сл.в. на С.

Следовательно, ее закон распределения будет иметь вид:

С

Сx1

Сx2

…

Сxn

p

p1

p2

…

pn

89.

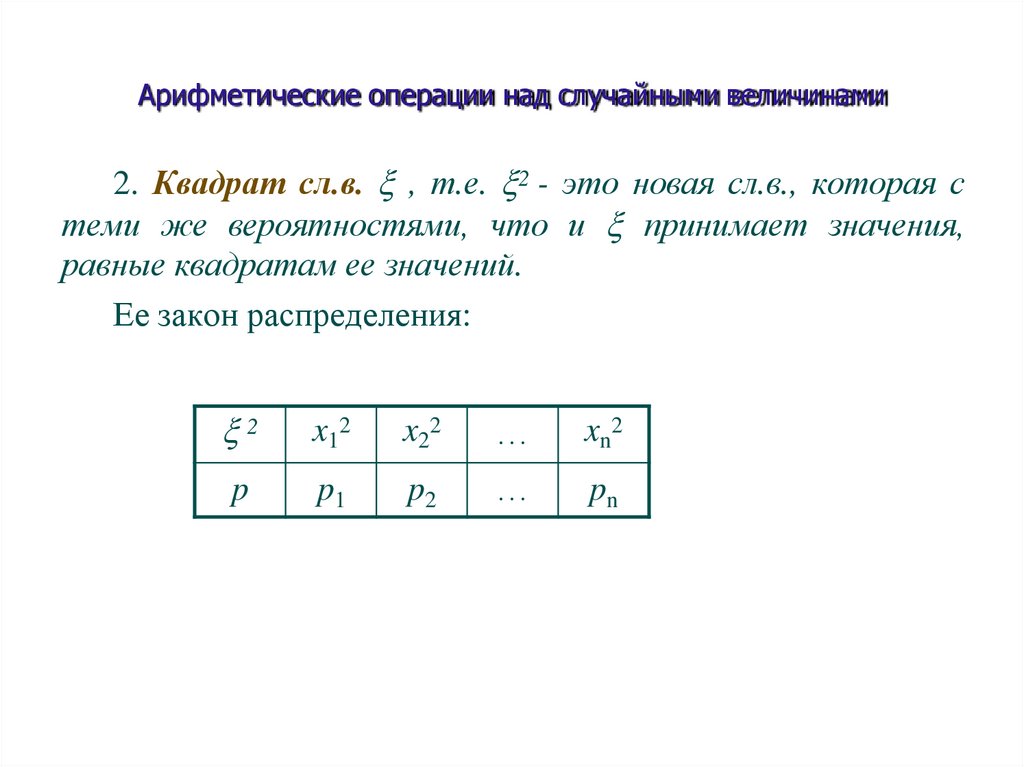

Арифметические операции над случайными величинами2. Квадрат сл.в. , т.е. 2 - это новая сл.в., которая с

теми же вероятностями, что и принимает значения,

равные квадратам ее значений.

Ее закон распределения:

2

x1 2

x2 2

…

xn 2

p

p1

p2

…

pn

90.

Арифметические операции над случайнымивеличинами

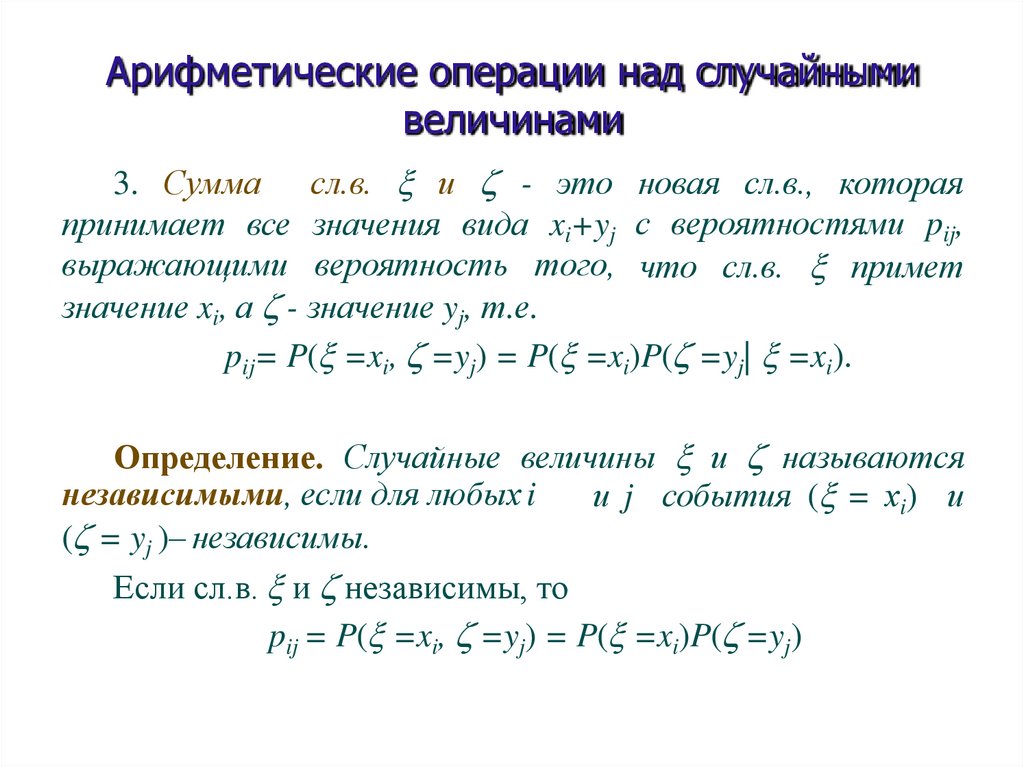

3. Сумма сл.в. и - это новая сл.в., которая

принимает все значения вида xi+yj с вероятностями pij,

выражающими вероятность того, что сл.в. примет

значение xi, а - значение yj, т.е.

pij= P( =xi, =yj) = P( =xi)P( =yj| =xi).

Определение. Случайные величины и называются

независимыми, если для любых i

и j события ( = хi) и

( = yj )– независимы.

Если сл.в. и независимы, то

pij = P( =xi, =yj) = P( =xi)P( =yj)

91.

Числовые характеристики дискретной случайнойвеличины.

Математическое ожидание

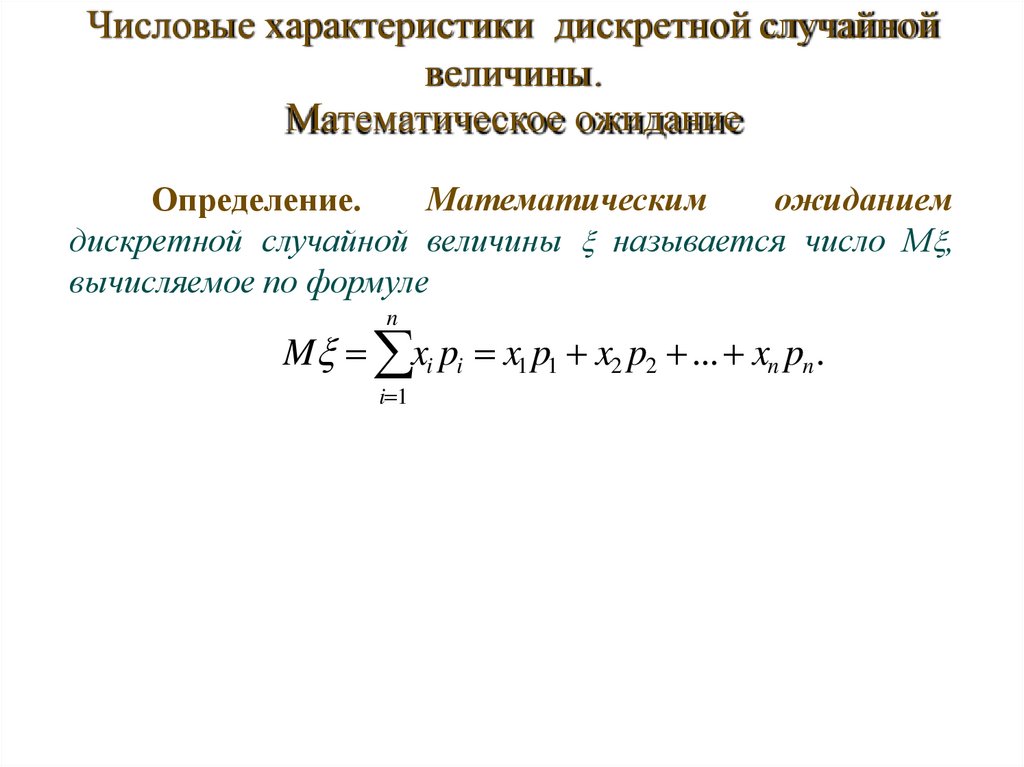

Определение.

Математическим

ожиданием

дискретной случайной величины называется число М ,

вычисляемое по формуле

n

M xi pi x1 p1 x2 p2 ... xn pn .

i 1

92.

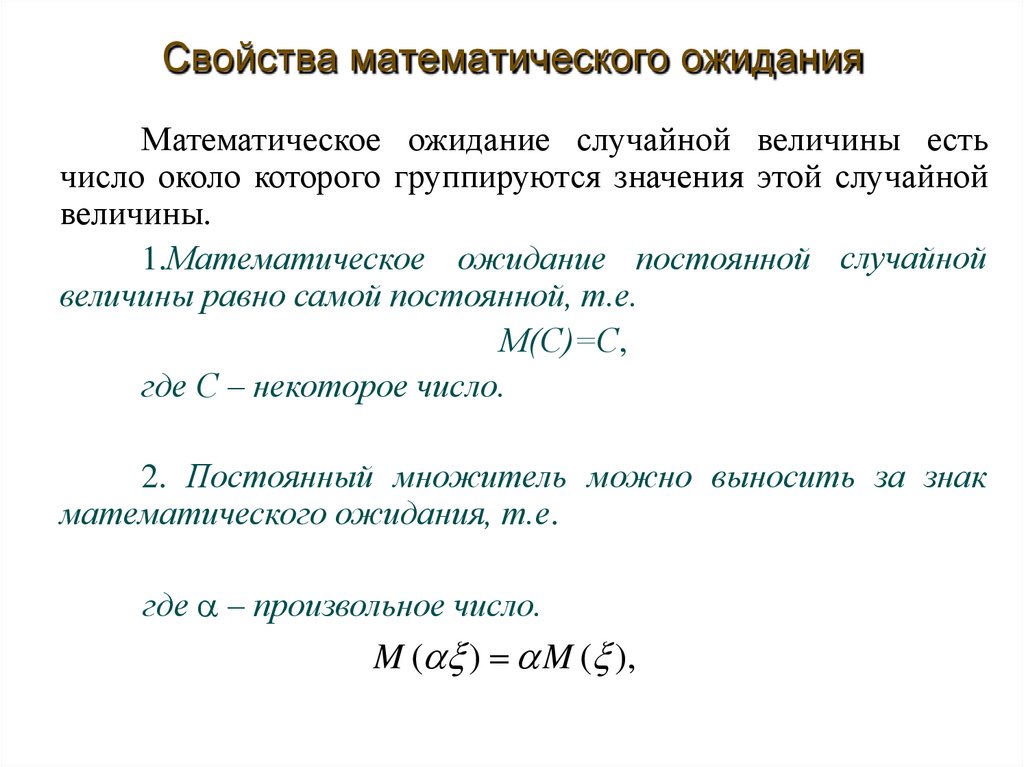

Свойства математического ожиданияМатематическое ожидание случайной величины есть

число около которого группируются значения этой случайной

величины.

1.Математическое ожидание постоянной случайной

величины равно самой постоянной, т.е.

М(С)=С,

где С – некоторое число.

2. Постоянный множитель можно выносить за знак

математического ожидания, т.е.

где – произвольное число.

M ( ) M ( ),

93.

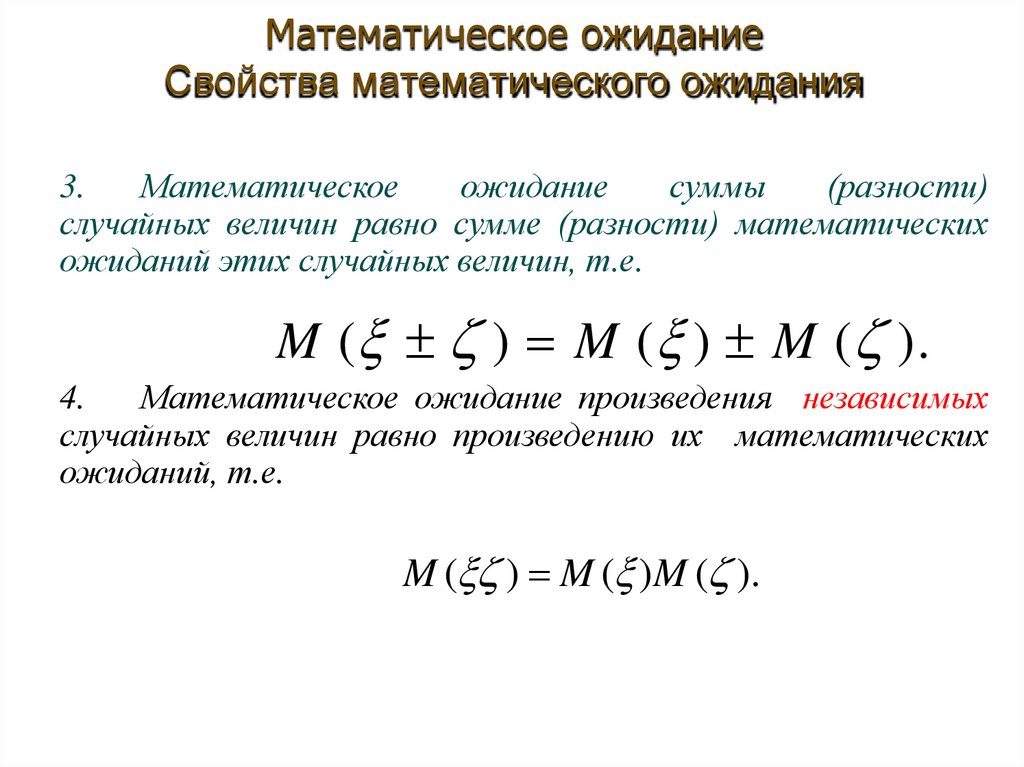

Математическое ожиданиеСвойства математического ожидания

3.

Математическое

ожидание

суммы

(разности)

случайных величин равно сумме (разности) математических

ожиданий этих случайных величин, т.е.

M ( ) M ( ) M ( ).

4.

Математическое ожидание произведения независимых

случайных величин равно произведению их математических

ожиданий, т.е.

M ( ) M ( )M ( ).

94.

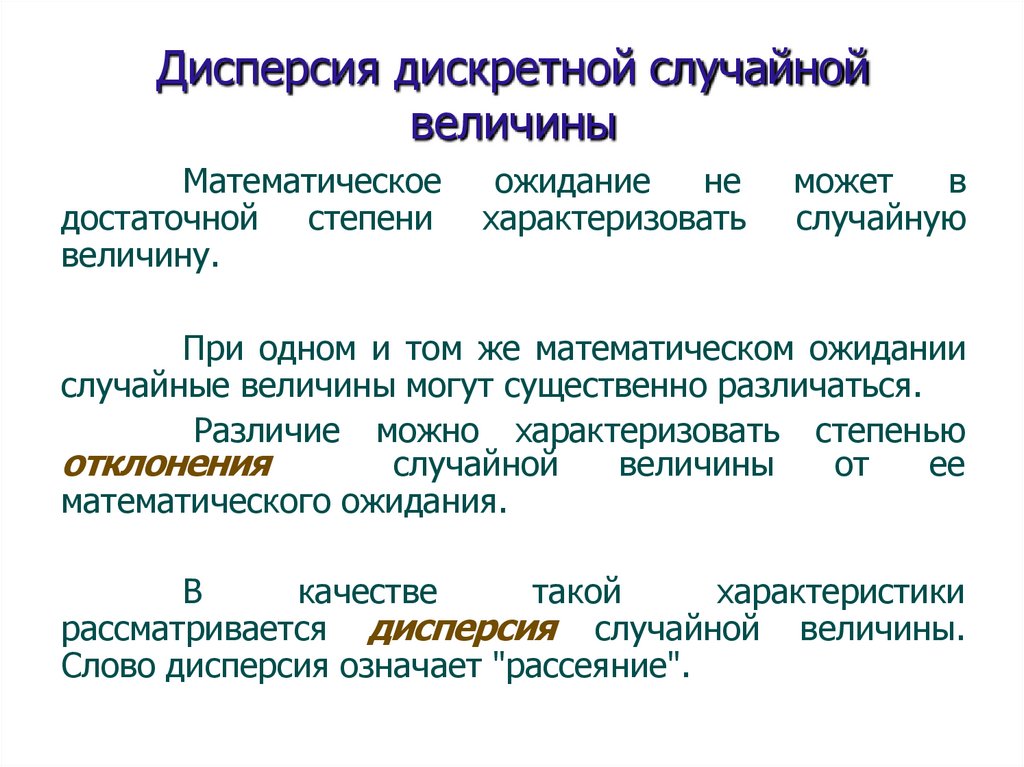

Дисперсия дискретной случайнойвеличины

Математическое

достаточной степени

величину.

ожидание

не

характеризовать

может

в

случайную

При одном и том же математическом ожидании

случайные величины могут существенно различаться.

Различие можно характеризовать степенью

отклонения

случайной

величины

от

ее

математического ожидания.

В

качестве

такой

характеристики

рассматривается дисперсия случайной величины.

Слово дисперсия означает "рассеяние".

95.

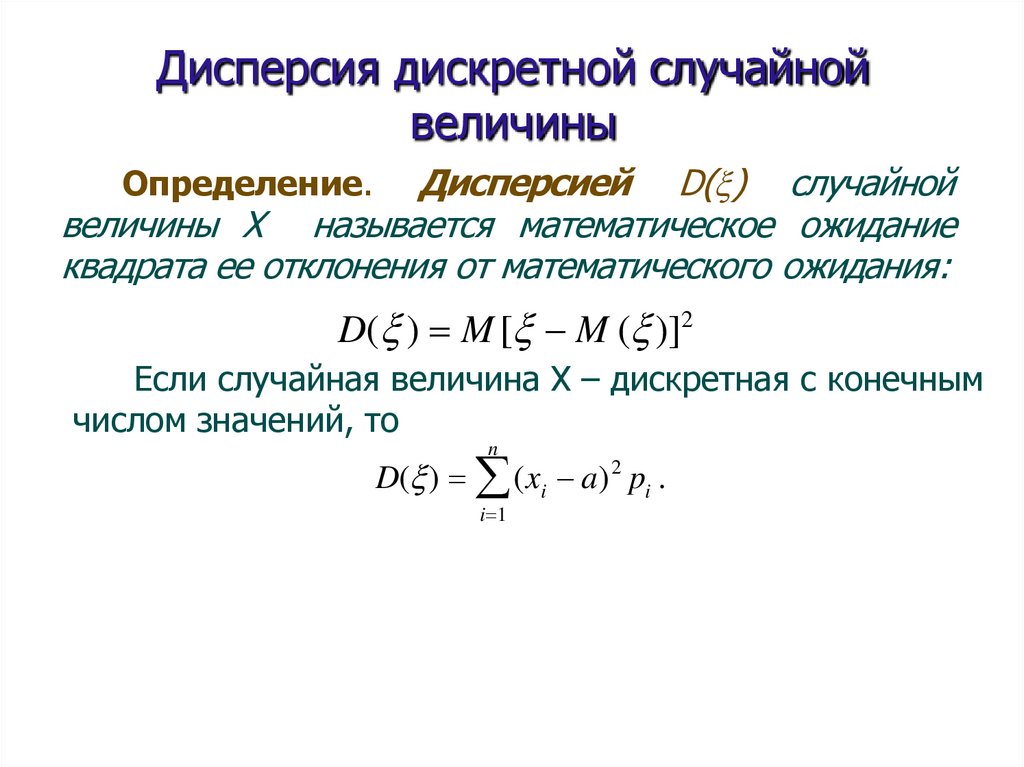

Дисперсия дискретной случайнойвеличины

Дисперсией D( ) случайной

величины Х называется математическое ожидание

квадрата ее отклонения от математического ожидания:

Определение.

D( ) M [ M ( )]2

Если случайная величина Х – дискретная с конечным

числом значений, то

n

D( ) (xi a) 2 pi .

i 1

96.

Дисперсия дискретной случайнойвеличины

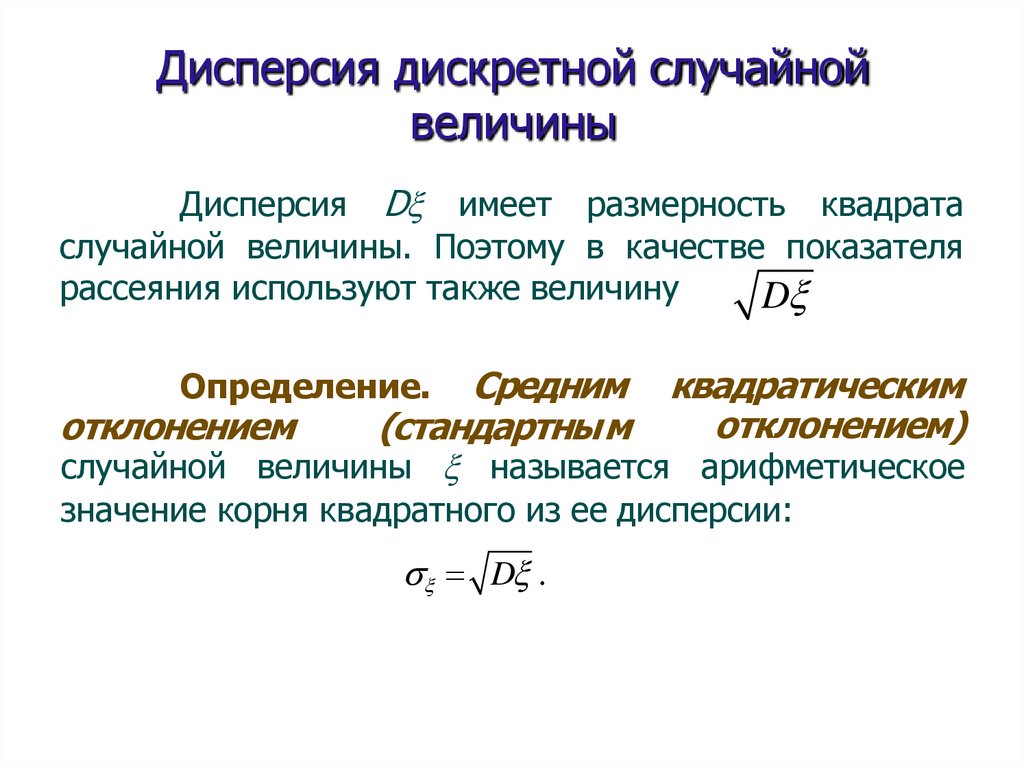

Дисперсия D имеет размерность квадрата

случайной величины. Поэтому в качестве показателя

рассеяния используют также величину

D

Средним квадратическим

отклонением)

отклонением

(стандартным

случайной величины называется арифметическое

Определение.

значение корня квадратного из ее дисперсии:

D .

97.

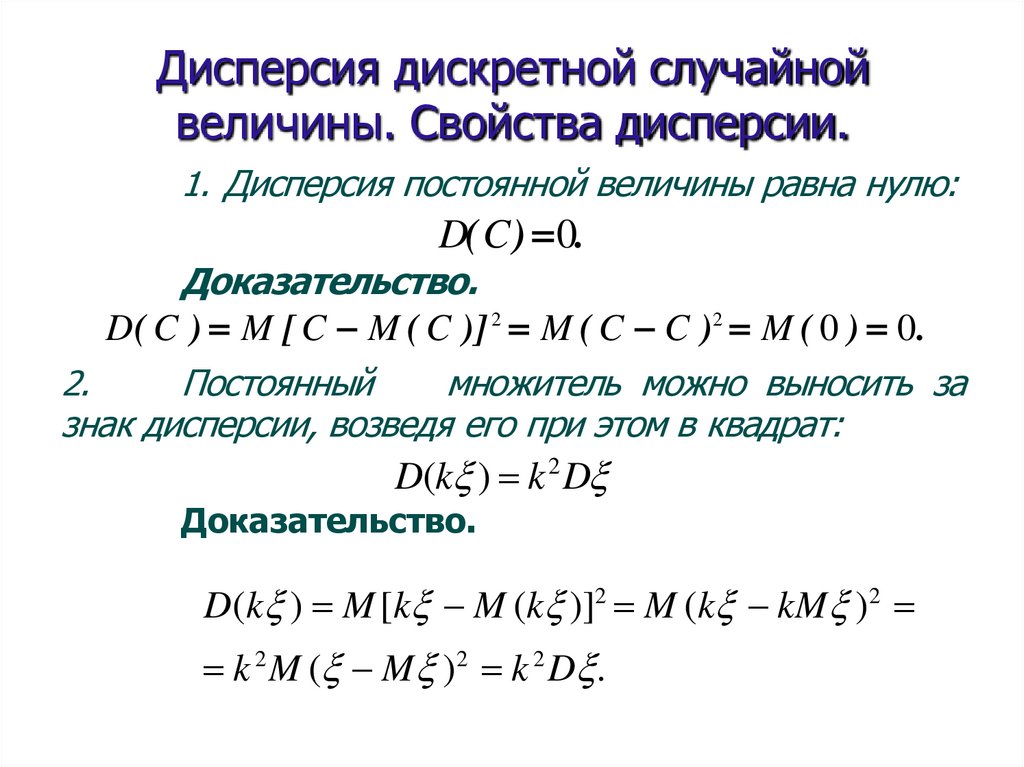

Дисперсия дискретной случайнойвеличины. Свойства дисперсии.

1. Дисперсия постоянной величины равна нулю:

D( C ) 0.

Доказательство.

D( C ) M [ C M ( C )] 2 M ( C C )2 M ( 0 ) 0.

2.

Постоянный

множитель можно выносить за

знак дисперсии, возведя его при этом в квадрат:

D(k ) k 2 D

Доказательство.

D(k ) M [k M (k )]2 M (k kM )2

k 2 M ( M )2 k 2 D .

98.

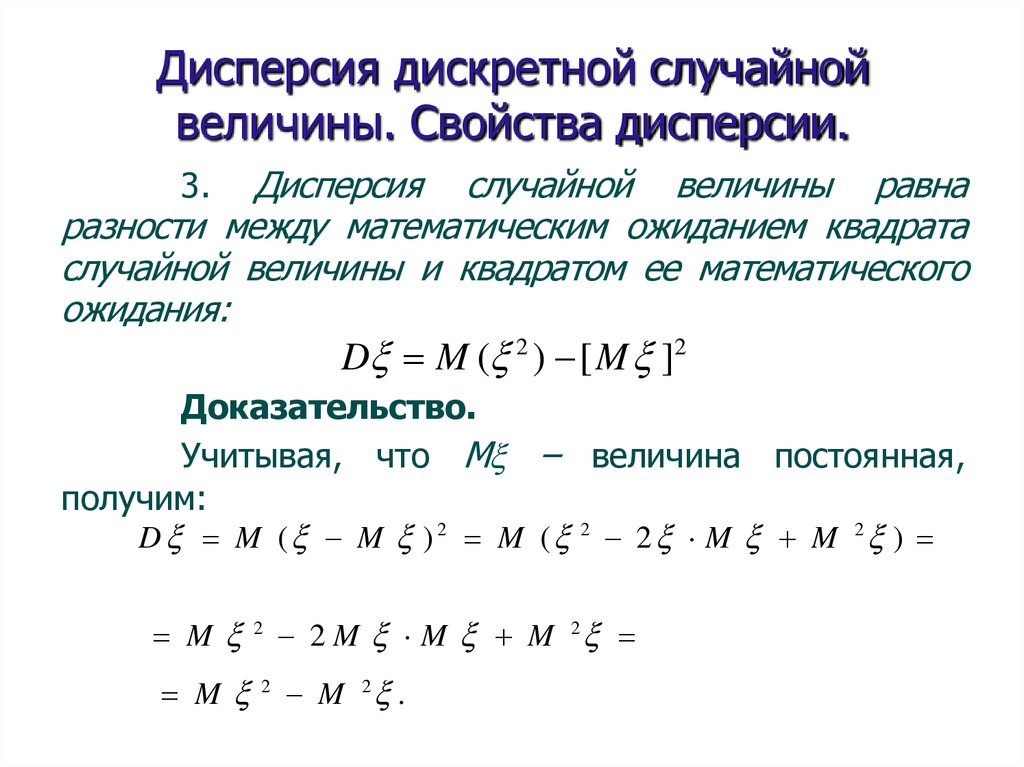

Дисперсия дискретной случайнойвеличины. Свойства дисперсии.

Дисперсия случайной величины равна

разности между математическим ожиданием квадрата

случайной величины и квадратом ее математического

ожидания:

D M ( 2 ) [M ]2

3.

Доказательство.

Учитывая, что М – величина постоянная,

получим:

D M ( M ) 2 M ( 2 2 M M 2 )

M 2 2 M M M 2

M 2 M 2 .

99.

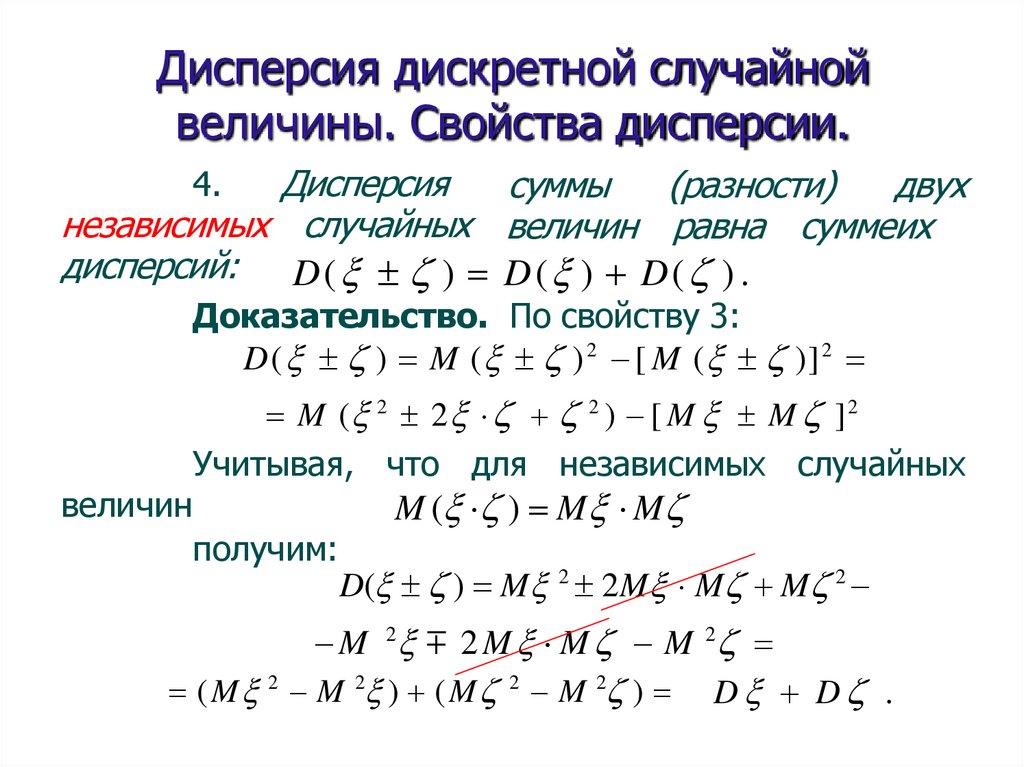

Дисперсия дискретной случайнойвеличины. Свойства дисперсии.

Дисперсия

суммы

(разности)

двух

независимых случайных величин равна суммеих

дисперсий: D( ) D( ) D( ) .

4.

Доказательство. По свойству 3:

D( ) M ( ) 2 [ M ( )] 2

величин

M ( 2 2 2 ) [ M M ]2

Учитывая, что для независимых случайных

получим:

M ( ) M M

D( ) M 2 2M M M 2

M 2 2 M M M 2

( M 2 M 2 ) ( M 2 M 2 ) D D .

100.

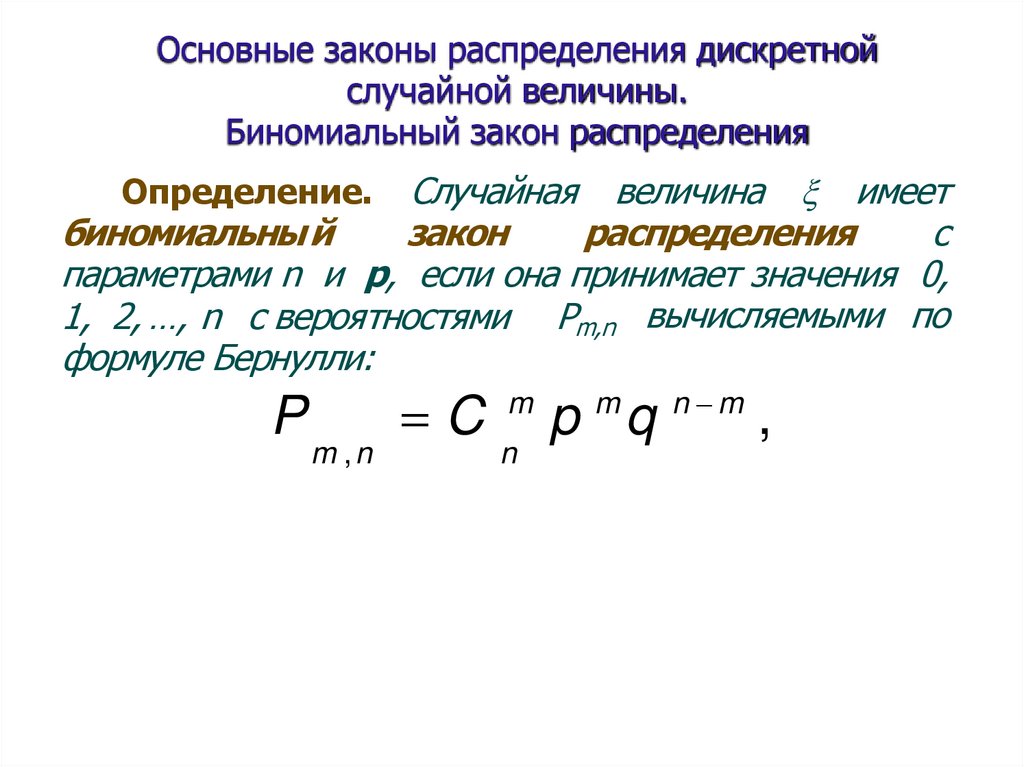

Основные законы распределения дискретнойслучайной величины.

Биномиальный закон распределения

Случайная величина имеет

биномиальны й

закон

распределения

с

параметрами n и p, если она принимает значения 0,

1, 2, …, n c вероятностями Pm,n вычисляемыми по

формуле Бернулли:

Определение.

P

m ,n

C

m

n

m

p q

n m

,

101.

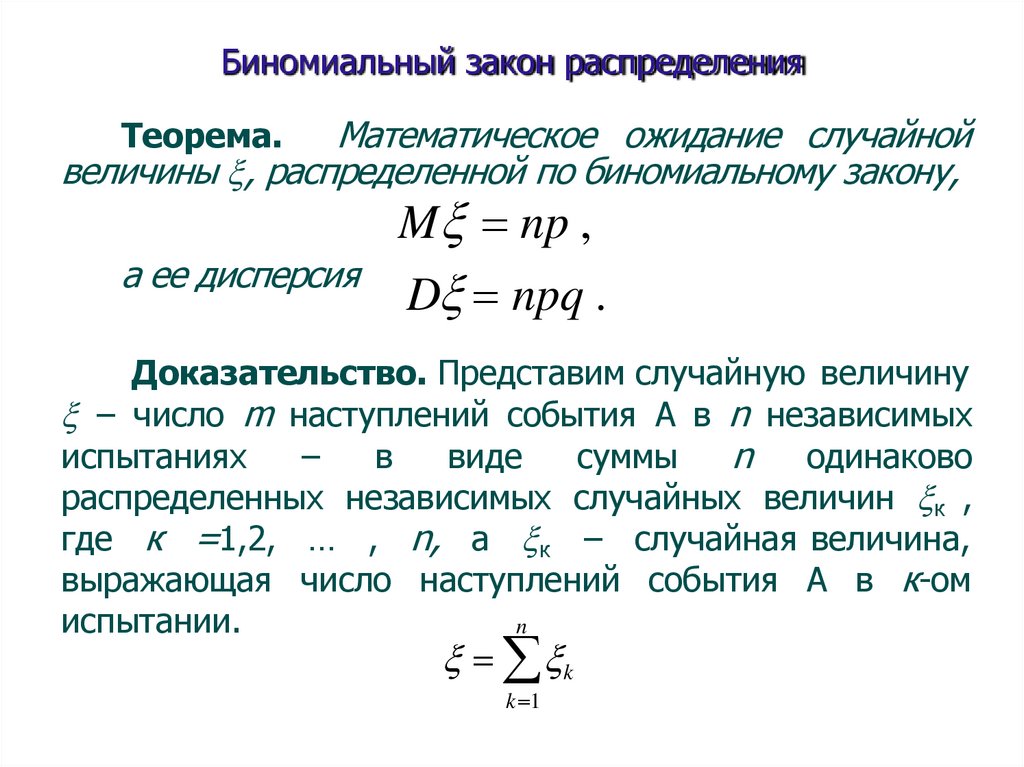

Биномиальный закон распределенияМатематическое ожидание случайной

величины , распределенной по биномиальному закону,

Теорема.

а ее дисперсия

M np ,

D npq .

Доказательство. Представим случайную величину

– число m наступлений события А в n независимых

испытаниях

–

в

виде

суммы

n одинаково

распределенных независимых случайных величин к ,

где к =1,2, … , n, а к – случайная величина,

выражающая число наступлений события А в к-ом

испытании.

n

k

k 1

102.

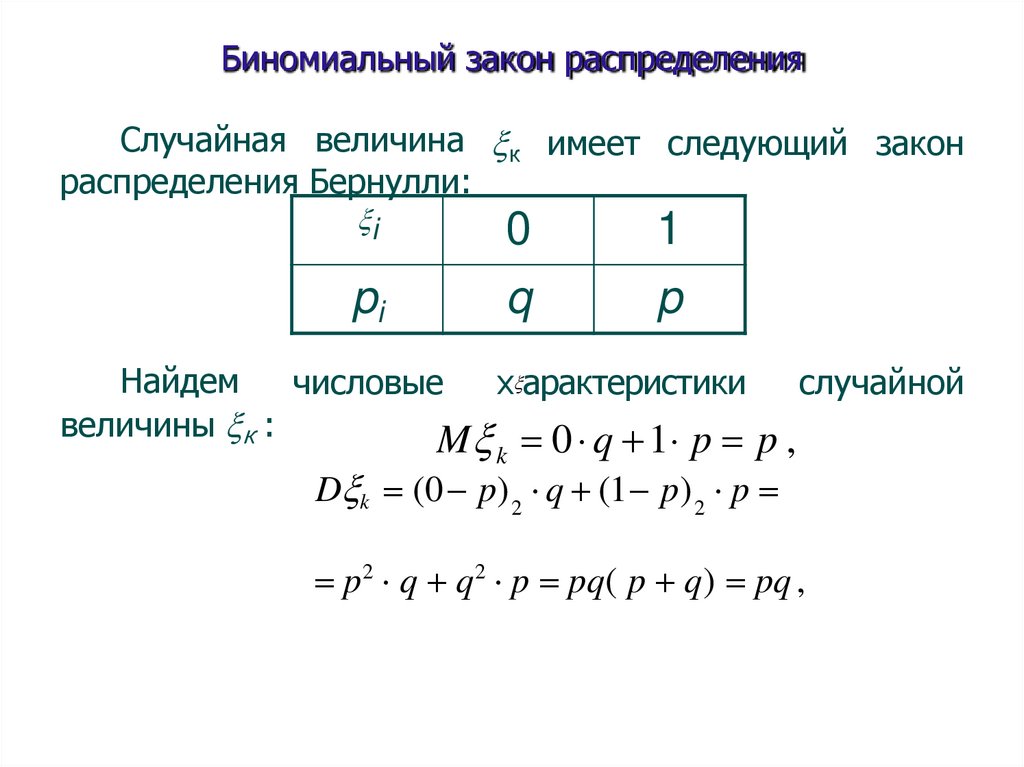

Биномиальный закон распределенияСлучайная величина к имеет следующий закон

распределения Бернулли:

i

0

1

pi

q

p

Найдем

числовые

х арактеристики

случайной

величины к :

M 0 q 1 p p ,

k

D k (0 p) 2 q (1 p) 2 p

p2 q q2 p pq( p q) pq ,

103.

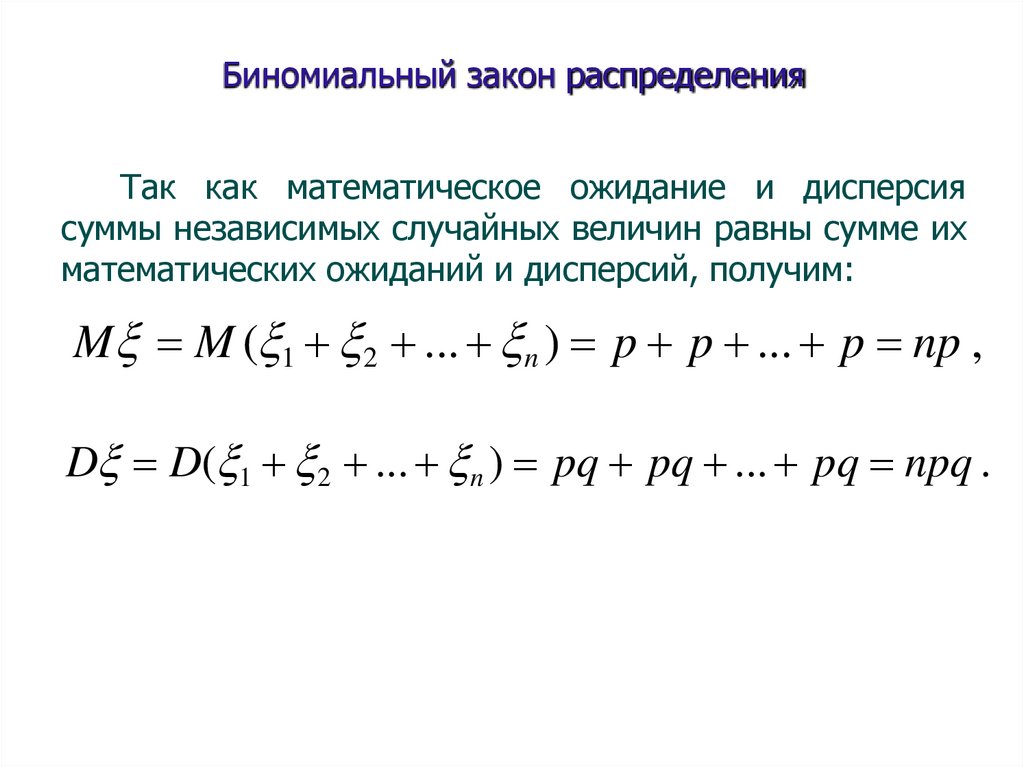

Биномиальный закон распределенияТак как математическое ожидание и дисперсия

суммы независимых случайных величин равны сумме их

математических ожиданий и дисперсий, получим:

M M ( 1 2 ... n ) p p ... p np ,

D D( 1 2 ... n ) pq pq ... pq npq .

104.

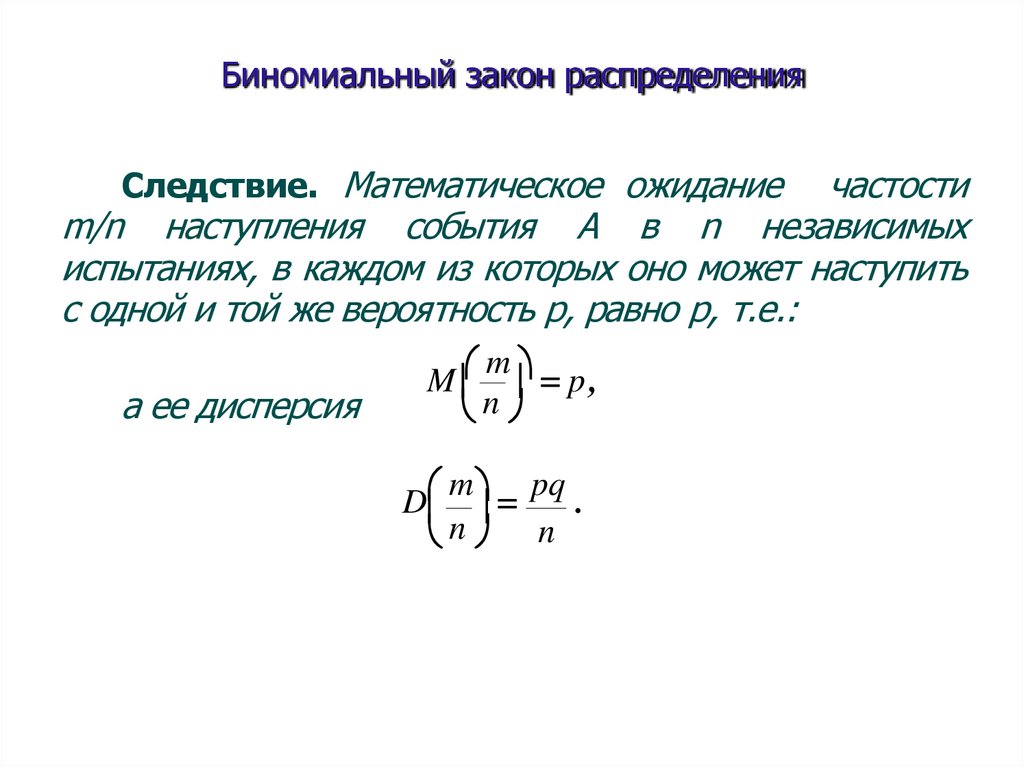

Биномиальный закон распределенияСледствие. Математическое ожидание

частости

m/n наступления события A в n независимых

испытаниях, в каждом из которых оно может наступить

с одной и той же вероятность р, равно р, т.е.:

а ее дисперсия

m

M p ,

n

m pq

D

.

n n

105.

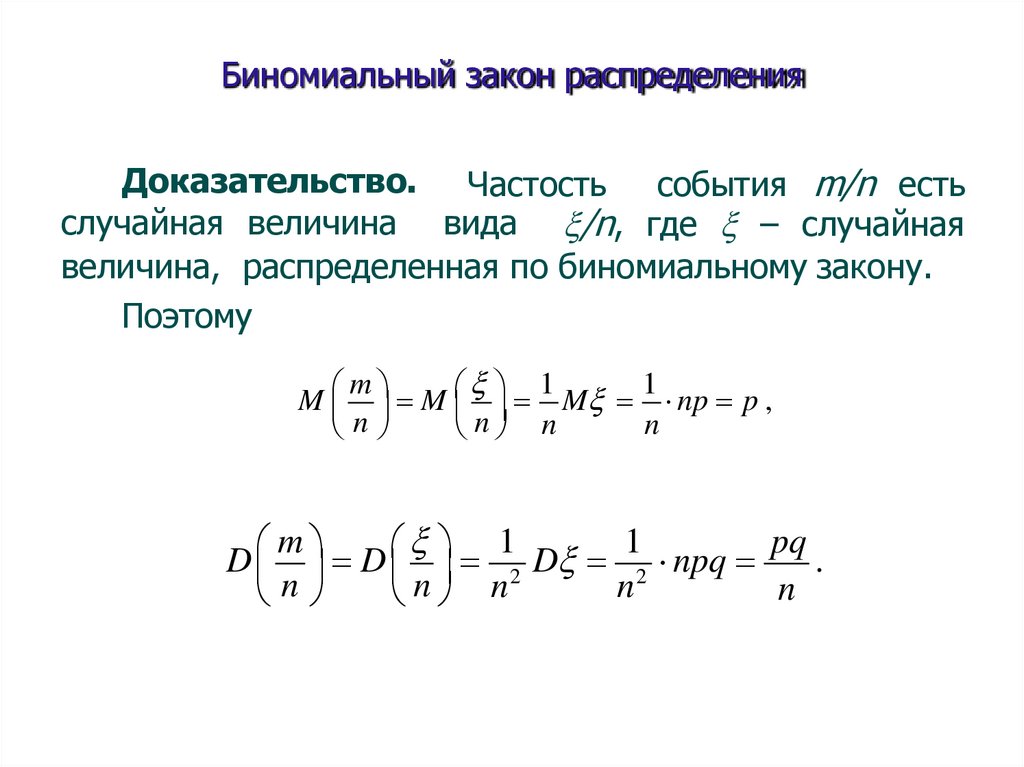

Биномиальный закон распределенияДоказательство. Частость события m/n есть

случайная величина вида /n, где – случайная

величина, распределенная по биномиальному закону.

Поэтому

m

1

1

M M M np p ,

n

n

n n

m

1

1

pq

D D 2 D 2 npq

.

n

n

n

n n

106.

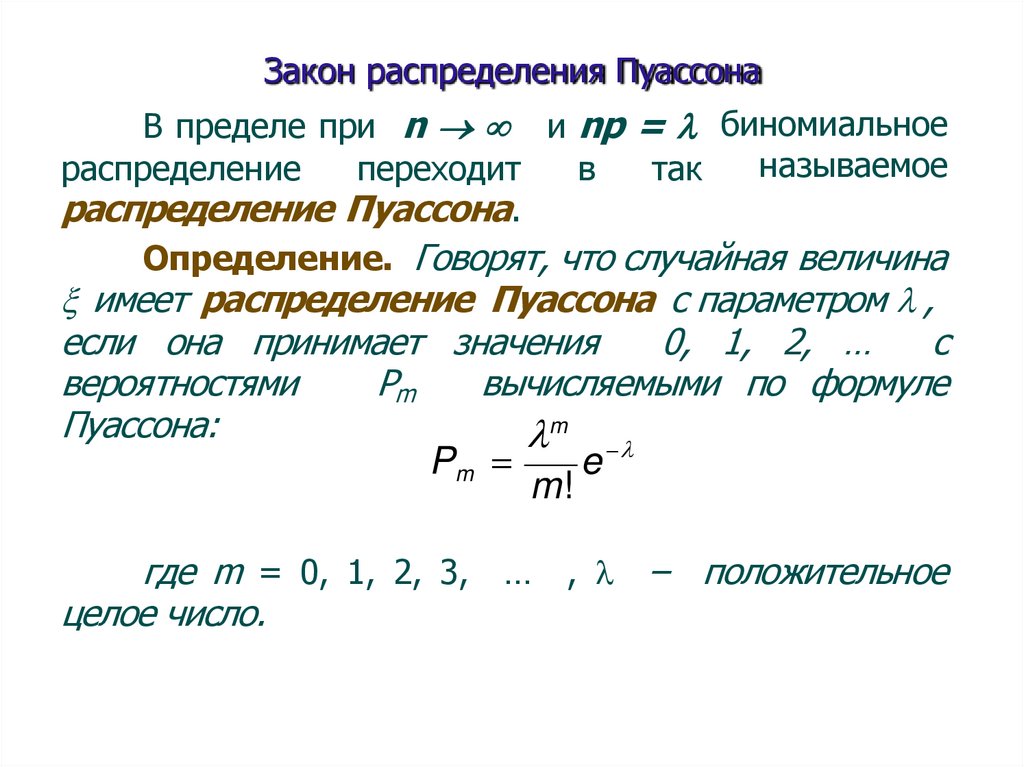

Закон распределения ПуассонаВ пределе при n и np = биномиальное

называемое

распределение

переходит

в

так

распределение Пуассона.

Определение. Говорят, что случайная величина

имеет распределение Пуассона с параметром ,

если она принимает значения

0, 1, 2, …

c

вероятностями

Pm

вычисляемыми по формуле

Пуассона:

m

Pm

e

m!

где m = 0, 1, 2, 3, … , – положительное

целое число.

107.

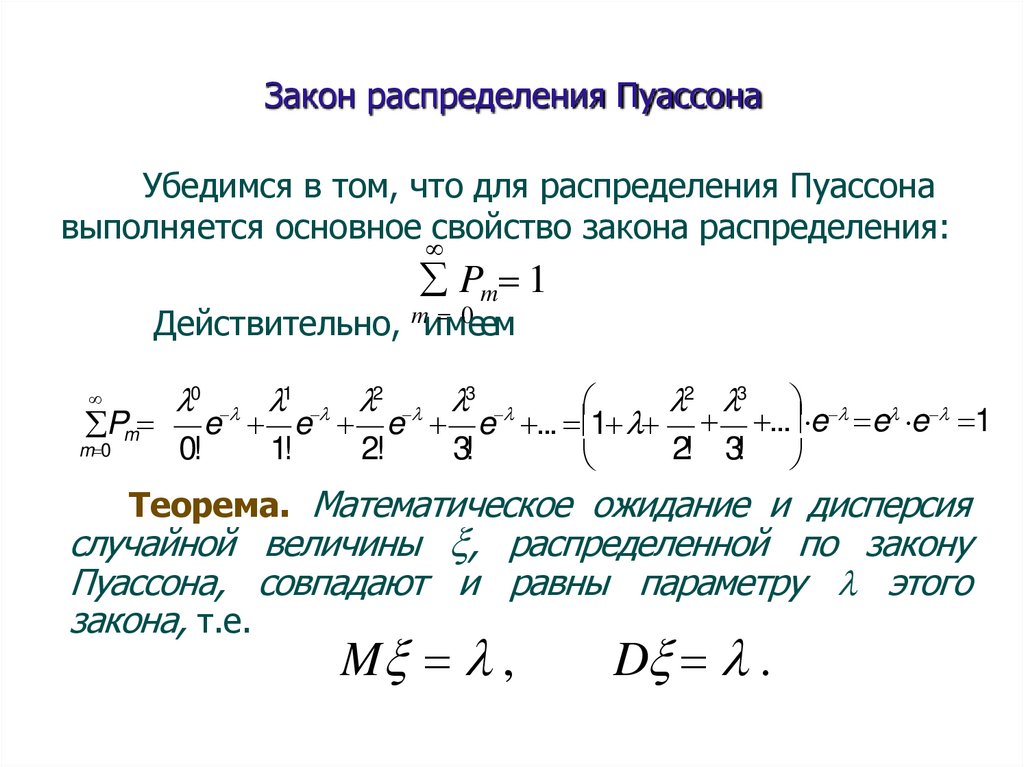

Закон распределения ПуассонаУбедимся в том, что для распределения Пуассона

выполняется основное свойство закона распределения:

Pm 1

Действительно, mи м0еем

2 3

e e e e ... 1 ... e e e 1

Pm

m 0

0!

1!

2!

3!

2! 3!

0 1 2 3

Теорема. Математическое ожидание и дисперсия

случайной величины , распределенной по закону

Пуассона, совпадают и равны параметру этого

закона, т.е.

M ,

D .

108.

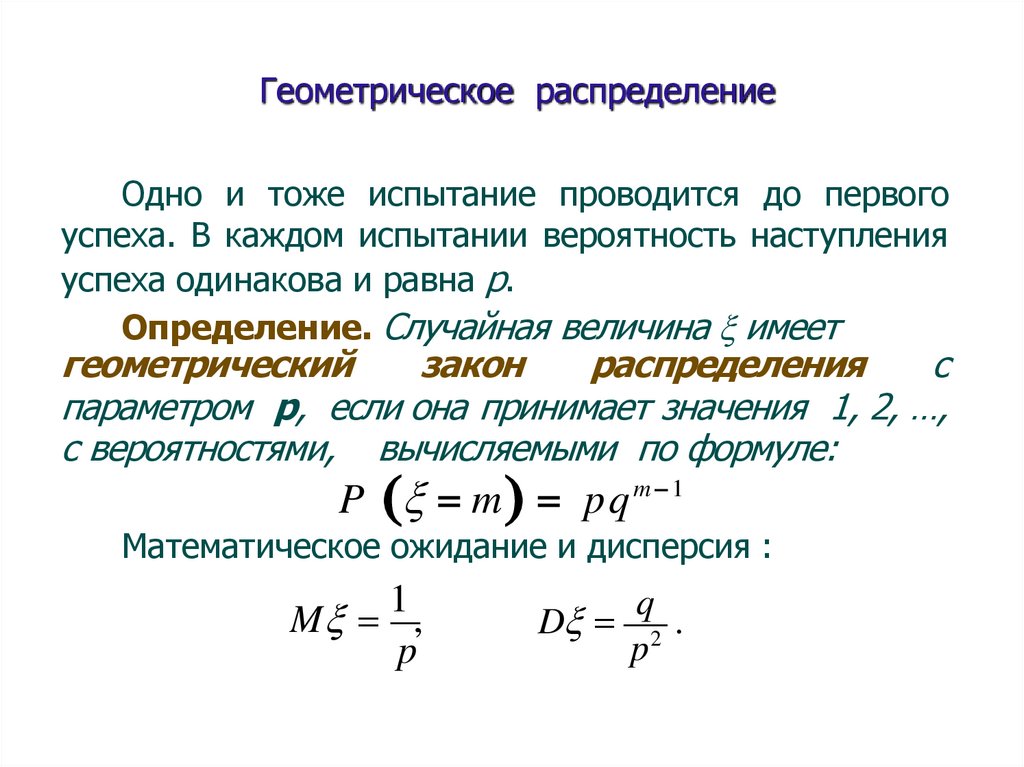

Геометрическое распределениеОдно и тоже испытание проводится до первого

успеха. В каждом испытании вероятность наступления

успеха одинакова и равна р.

Определение. Случайная величина имеет

геометрический

закон

распределения

с

параметром p, если она принимает значения 1, 2, …,

c вероятностями, вычисляемыми по формуле:

P m pq m 1

Математическое ожидание и дисперсия :

1

M ,

p

q

D 2 .

p

109.

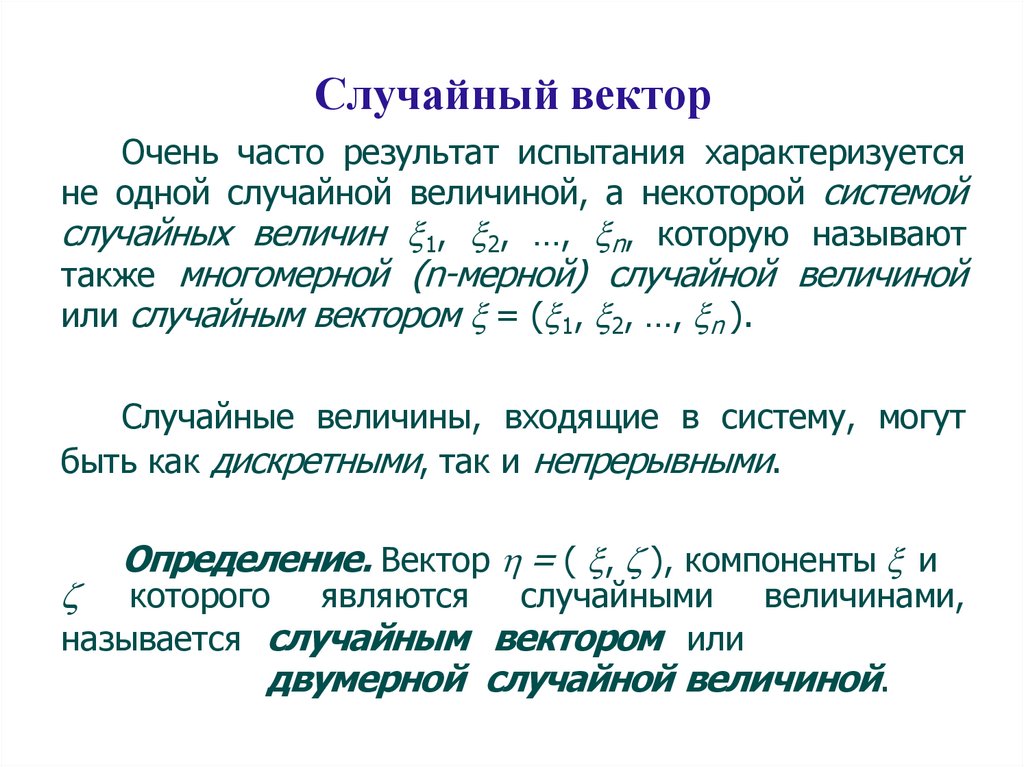

Случайный векторОчень часто результат испытания характеризуется

не одной случайной величиной, а некоторой системой

случайных величин 1, 2, …, n, которую называют

также многомерной (n-мерной) случайной величиной

или случайным вектором = ( 1, 2, …, n ).

Случайные величины, входящие в систему, могут

быть как дискретными, так и непрерывными.

Определение. Вектор = ( , ), компоненты и

которого являются случайными величинами,

называется случайным вектором или

двумерной случайной величиной.

110.

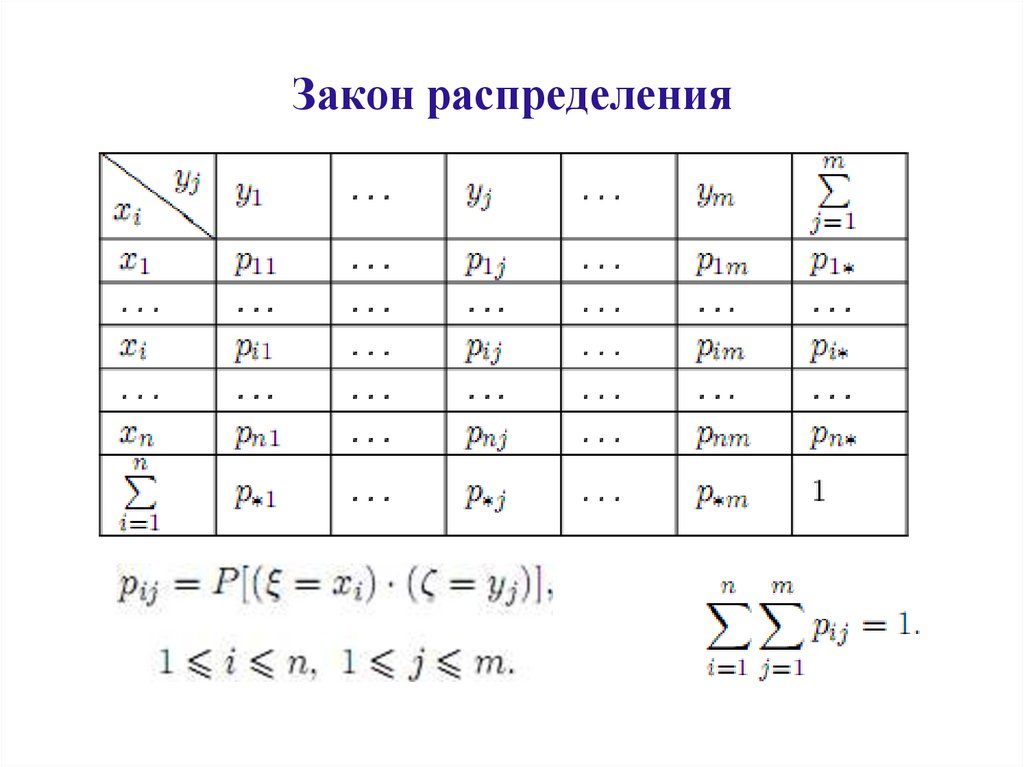

Закон распределения111.

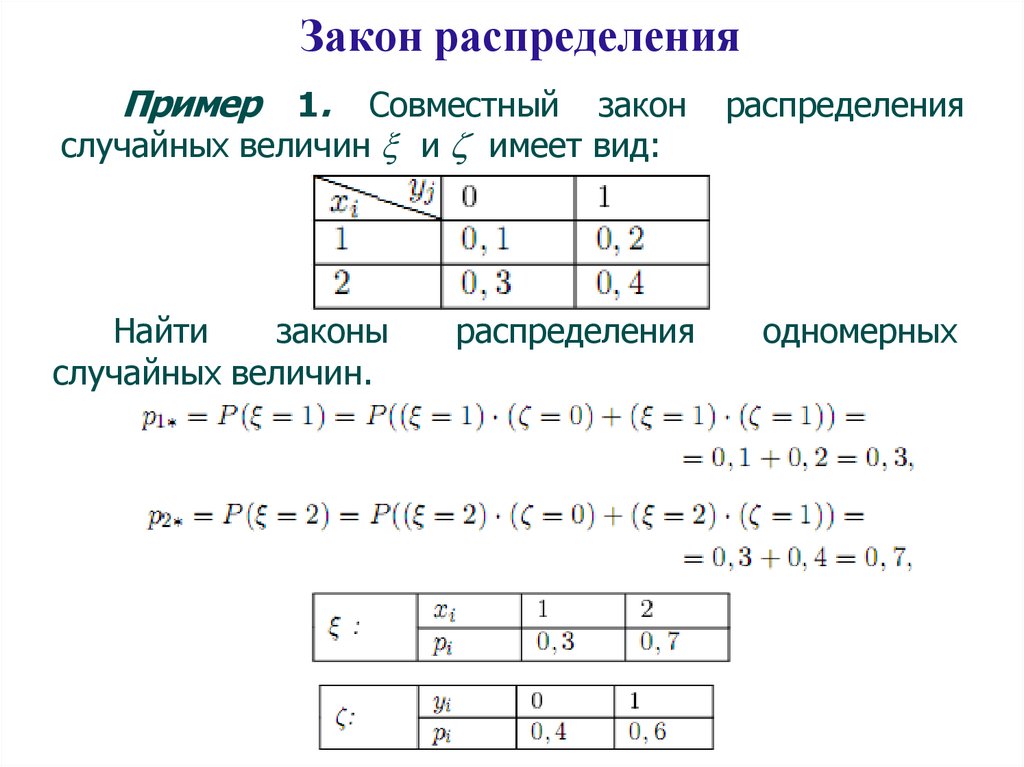

Закон распределенияПример

1. Совместный закон

случайных величин и имеет вид:

Найти

законы

случайных величин.

распределения

распределения

одномерных

112.

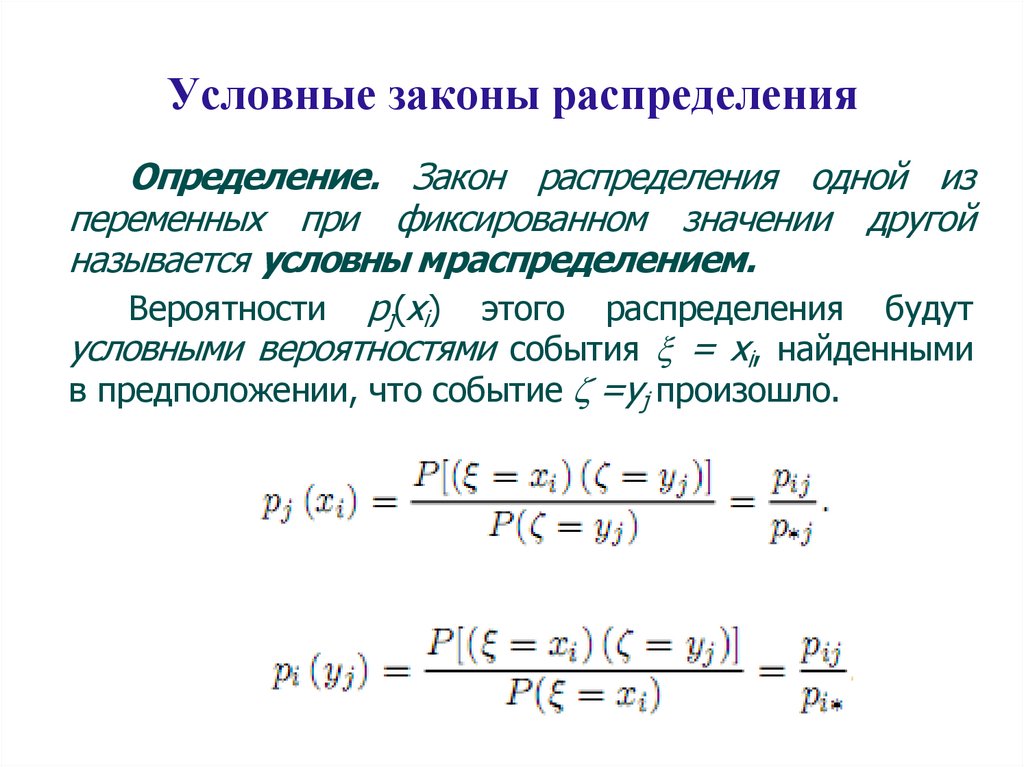

Условные законы распределенияОпределение. Закон распределения одной из

переменных при фиксированном значении другой

называется условны мраспределением.

Вероятности рj(xi) этого распределения будут

условными вероятностями события = хi, найденными

в предположении, что событие =yj произошло.

113.

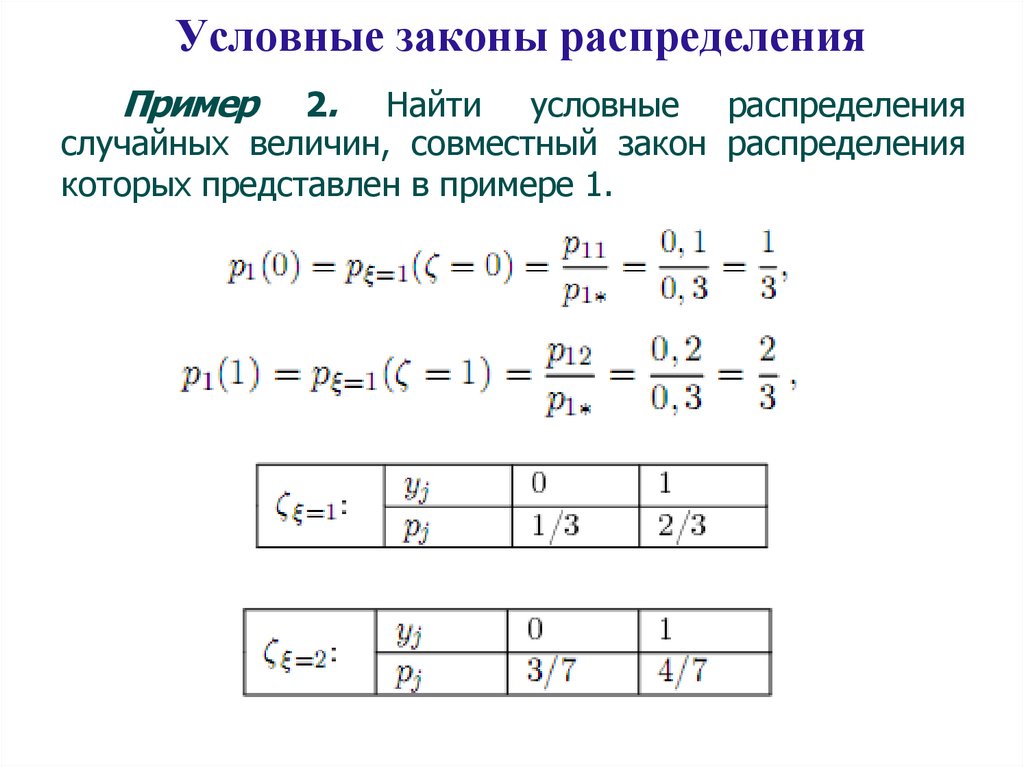

Условные законы распределенияПример

2. Найти условные распределения

случайных величин, совместный закон распределения

которых представлен в примере 1.

114.

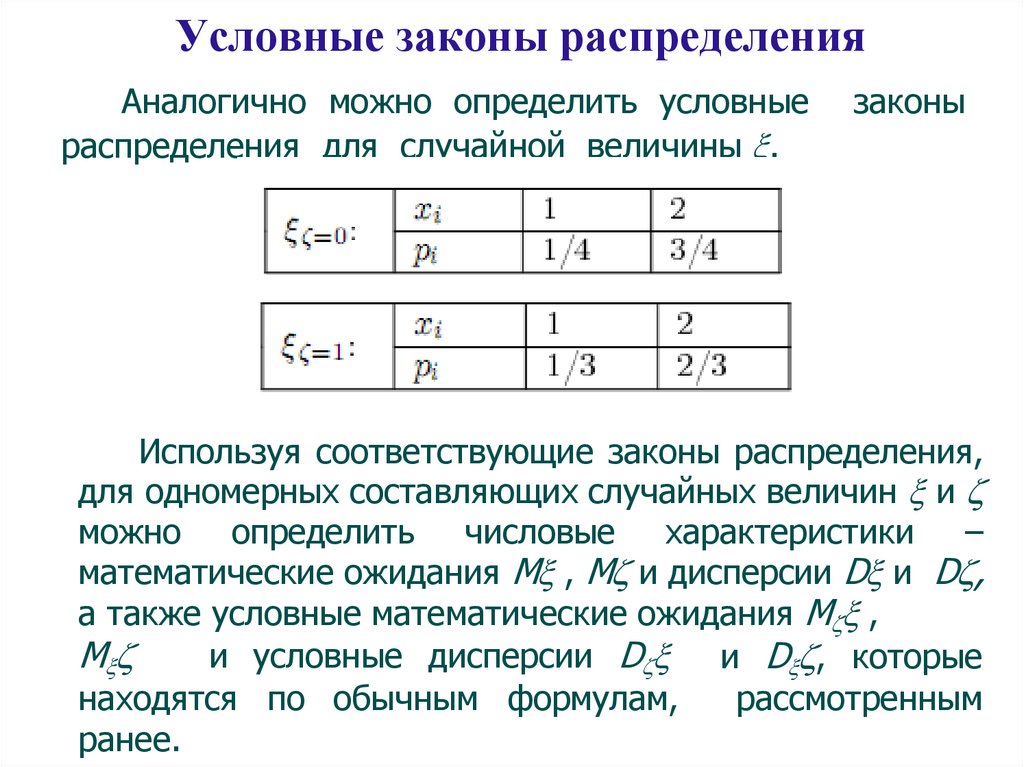

Условные законы распределенияАналогично можно определить условные

распределения для случайной величины .

законы

Используя соответствующие законы распределения,

для одномерных составляющих случайных величин и

можно определить числовые характеристики –

математические ожидания М , М и дисперсии D и D ,

а также условные математические ожидания М ,

М

и условные дисперсии D и D , которые

рассмотренным

находятся по обычным формулам,

ранее.

115.

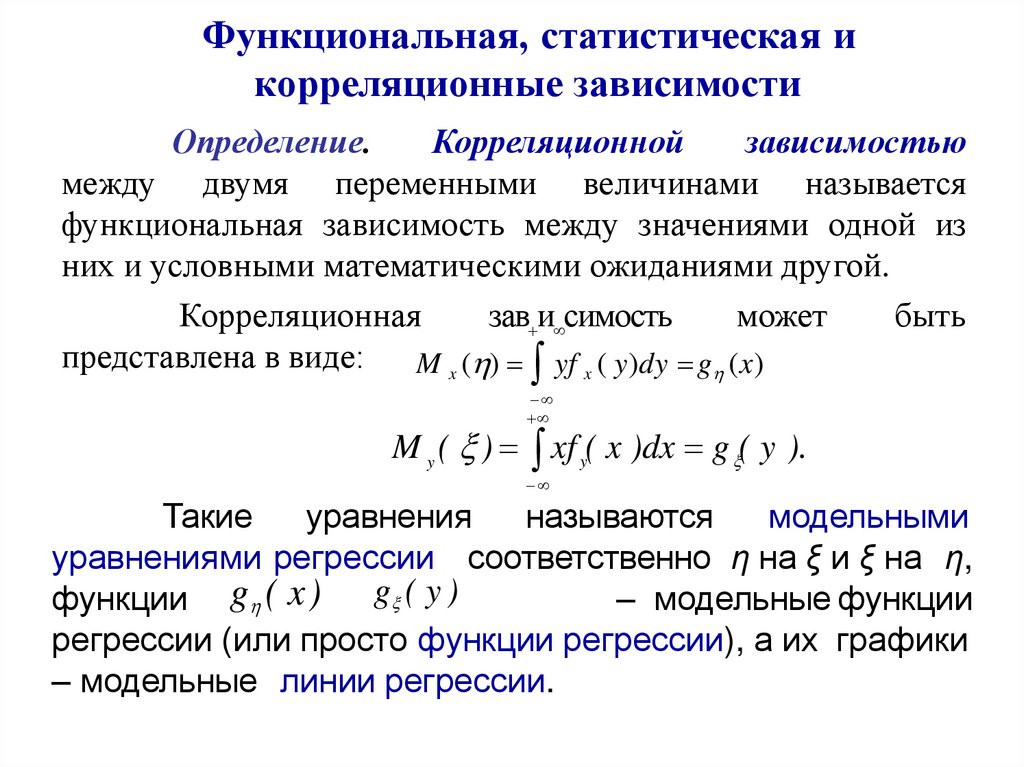

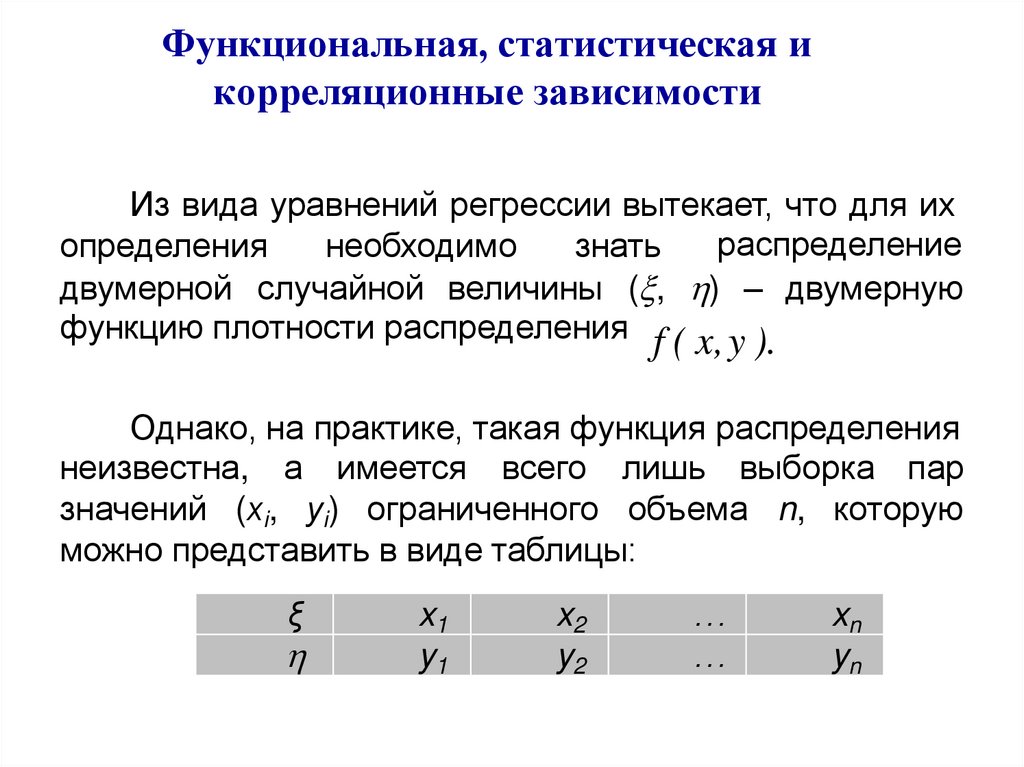

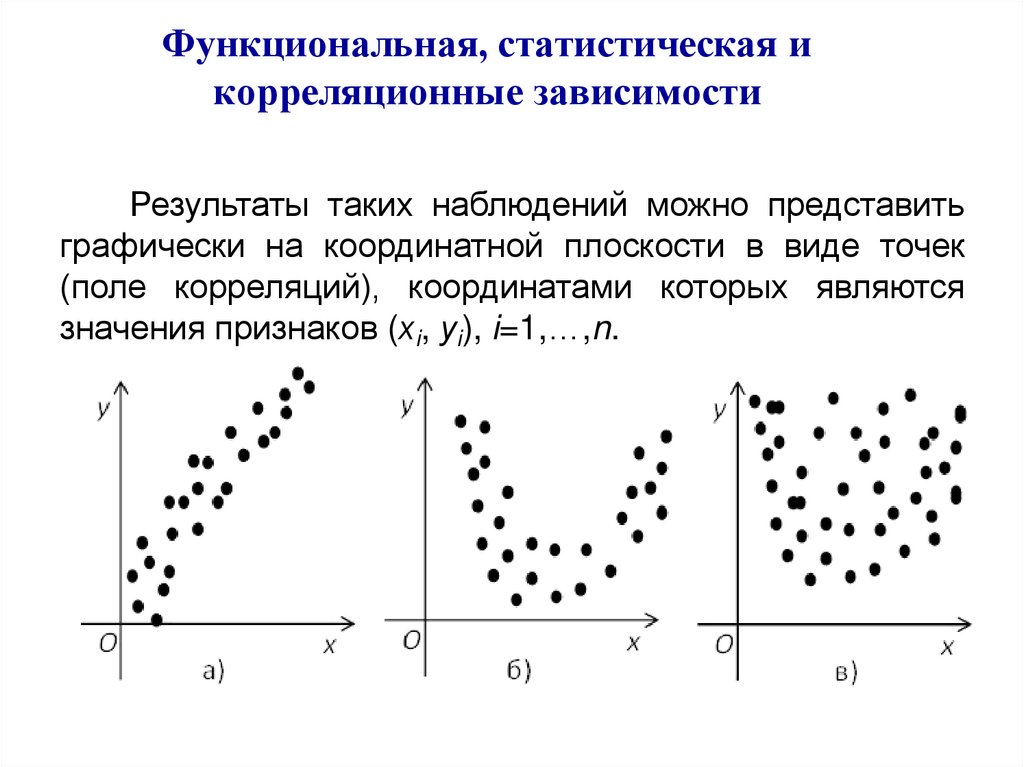

Условные законы распределенияОпределение.

Связь

между

переменными

называется

функциональной,

если

каждому

значению из области определения одной переменной

поставлено в соответствие однозначно определенное

значение другой переменной.

Определение. Функциональная связь между

значениями

одной

переменной

и

условными

математическими ожиданиями другой переменной

называется корреляционной.

Определение.

График

корреляционной

зависимости называется линией регрессии.

Корреляционные зависимости бывают двух видов y

по x и x по y в зависимости от того, которая из

переменных выполняет роль аргумента: x или y.

Соответственно, – точки корреляционной зависимости

y по x и – точки корреляционной зависимости x по y.

116.

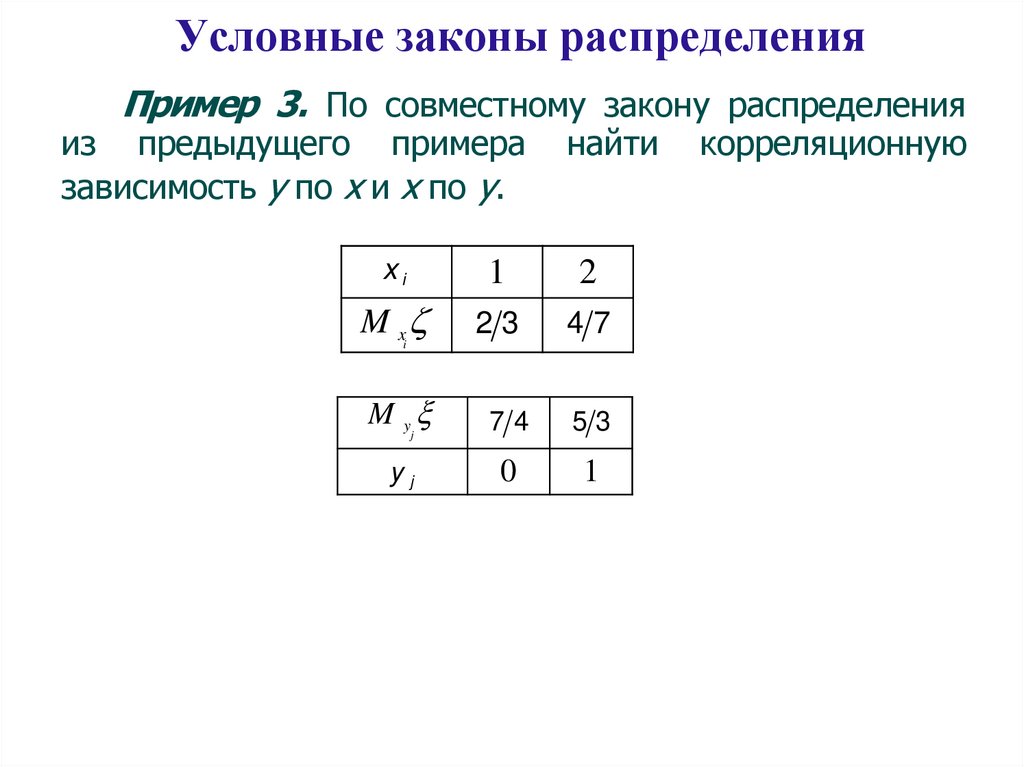

Условные законы распределенияПример 3. По совместному закону распределения

из предыдущего примера

зависимость y по x и x по y.

найти

xi

1

2

M x

23

47

M y

74

53

yj

0

1

i

j

корреляционную

117.

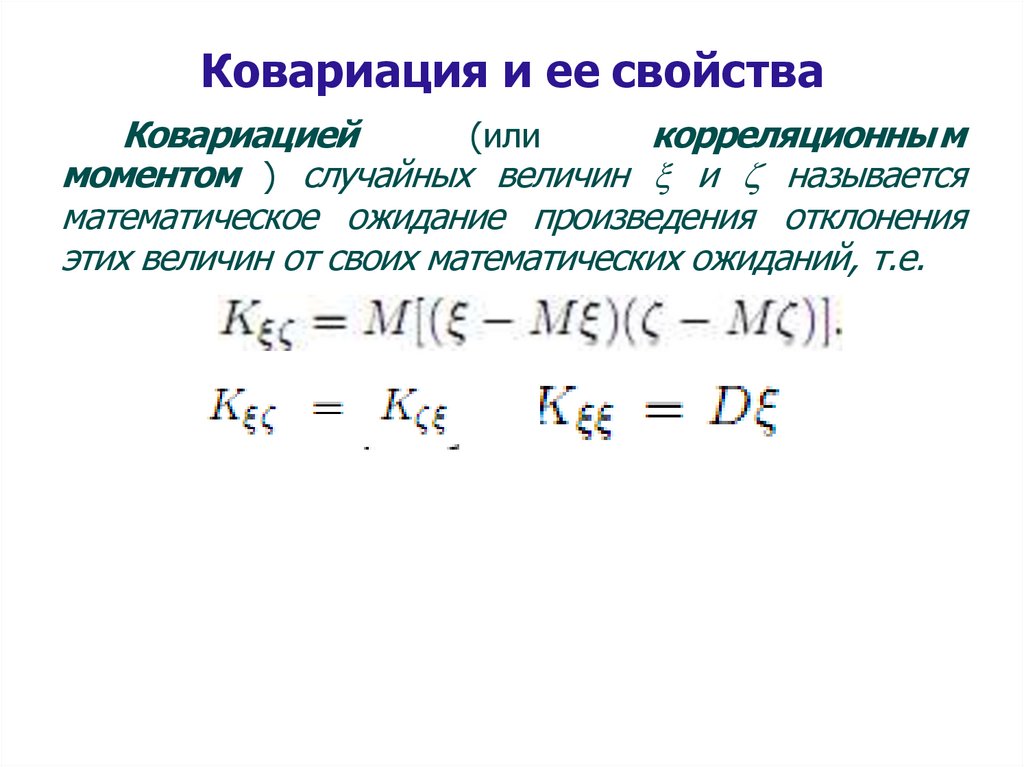

Ковариация и ее свойстваКовариацией

корреляционны м

(или

моментом ) случайных величин и называется

математическое ожидание произведения отклонения

этих величин от своих математических ожиданий, т.е.

118.

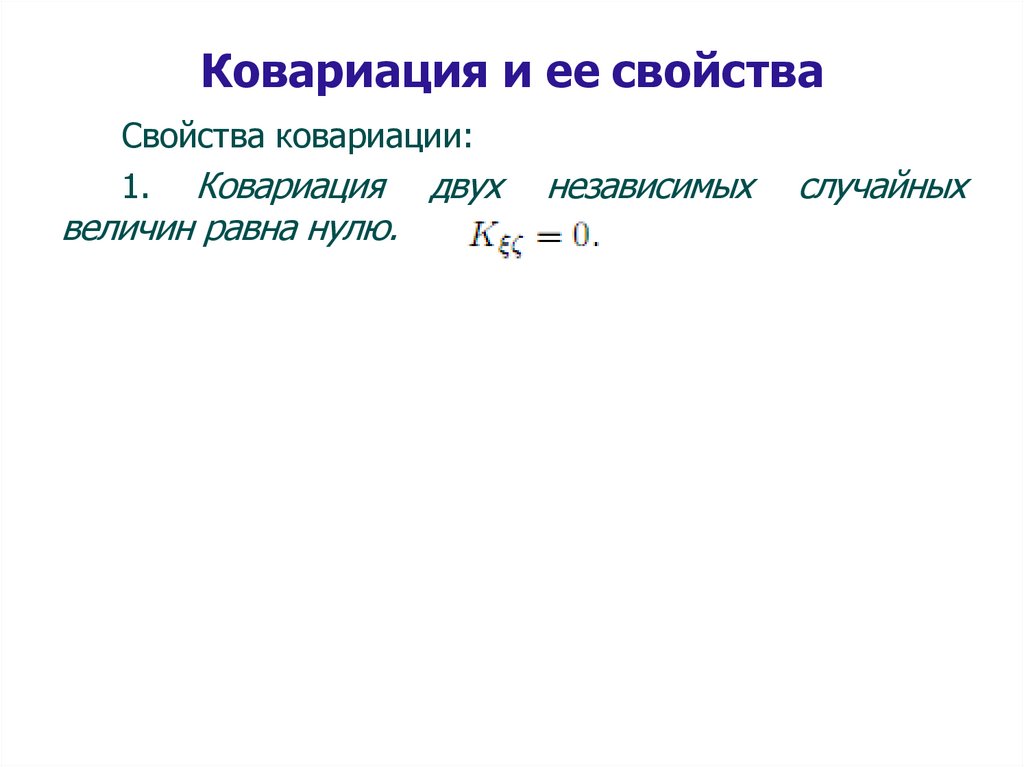

Ковариация и ее свойстваСвойства ковариации:

1. Ковариация двух

величин равна нулю.

независимых

случайных

119.

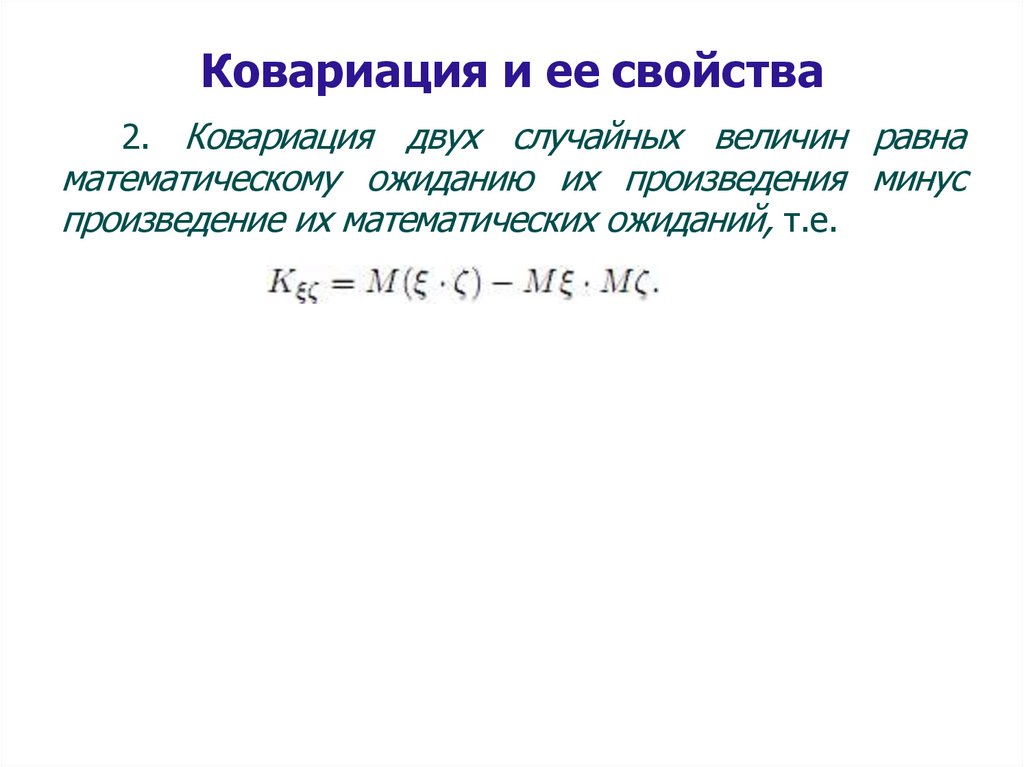

Ковариация и ее свойства2. Ковариация двух случайных величин равна

математическому ожиданию их произведения минус

произведение их математических ожиданий, т.е.

120.

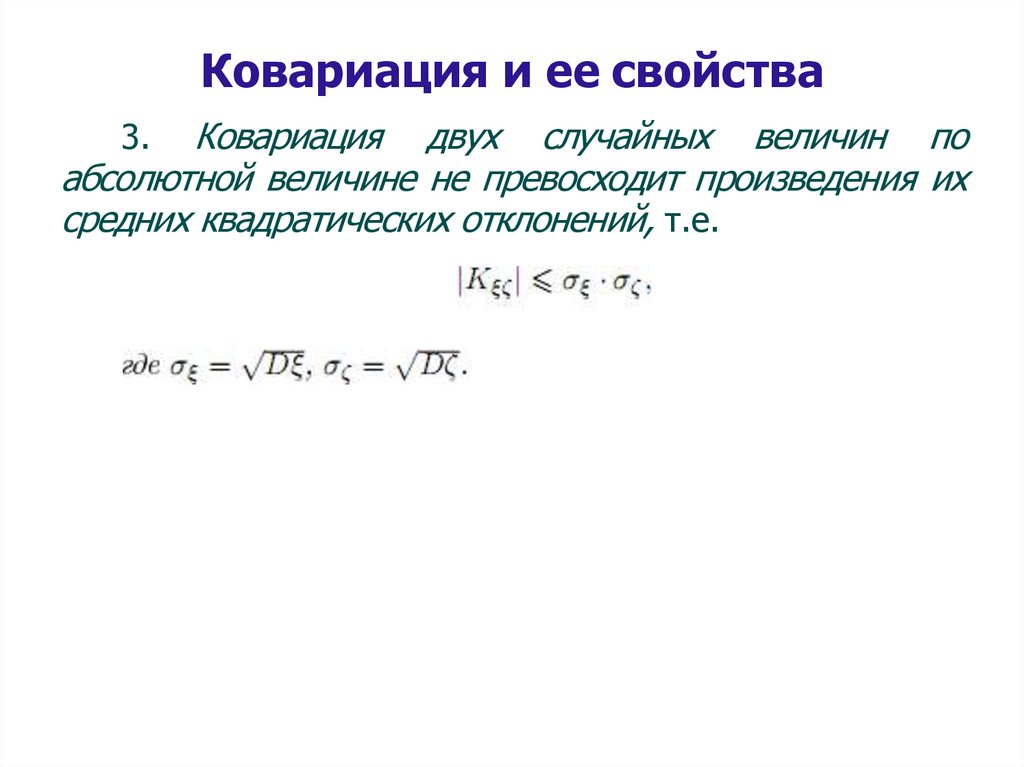

Ковариация и ее свойстваКовариация двух случайных величин по

абсолютной величине не превосходит произведения их

средних квадратических отклонений, т.е.

3.

121.

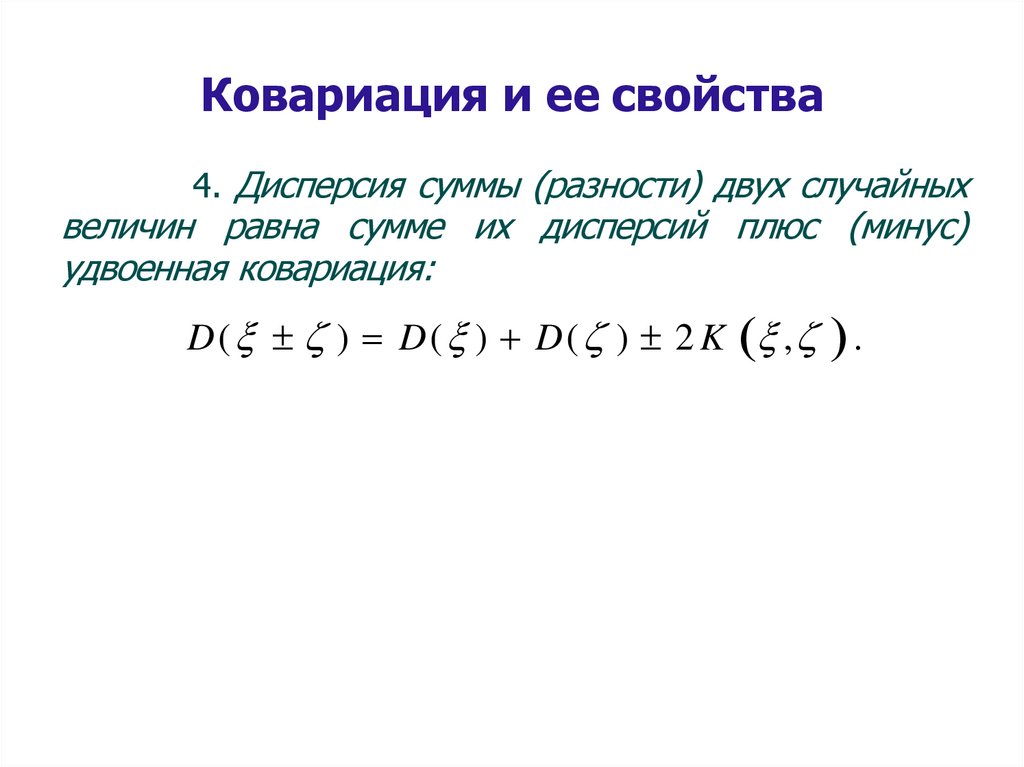

Ковариация и ее свойства4. Дисперсия суммы (разности) двух случайных

величин равна сумме их дисперсий плюс (минус)

удвоенная ковариация:

D( ) D( ) D( ) 2 K , .

122.

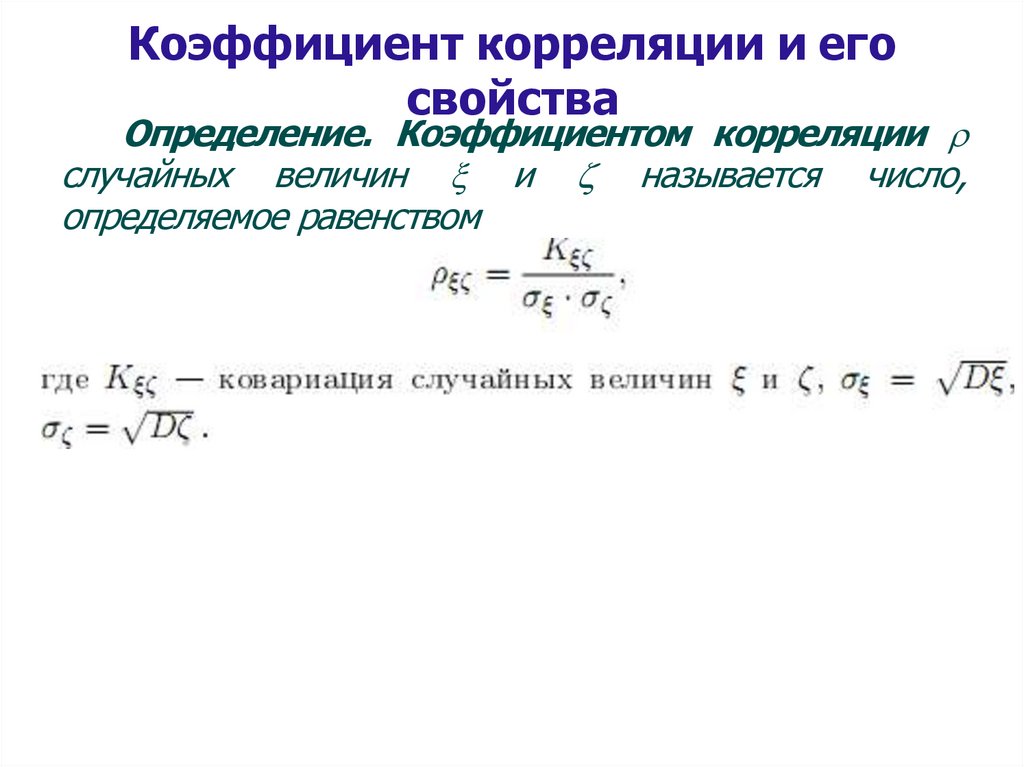

Коэффициент корреляции и егосвойства

Определение. Коэффициентом корреляции

случайных величин и называется число,

определяемое равенством

123.

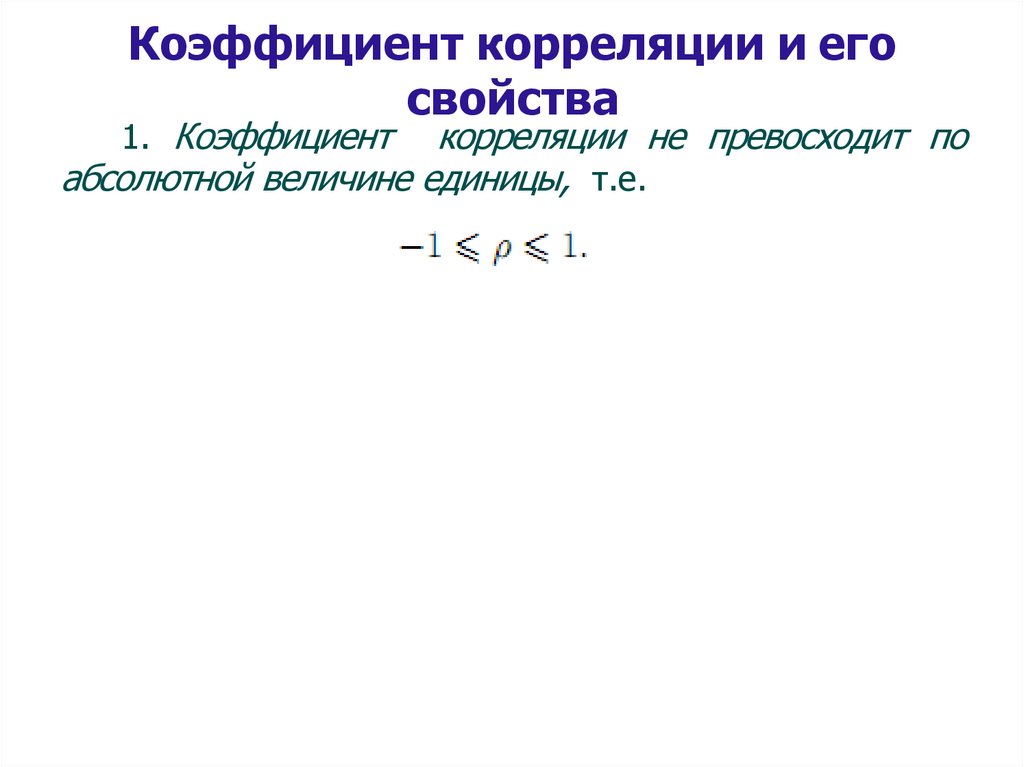

Коэффициент корреляции и егосвойства

1. Коэффициент

корреляции не превосходит по

абсолютной величине единицы, т.е.

124.

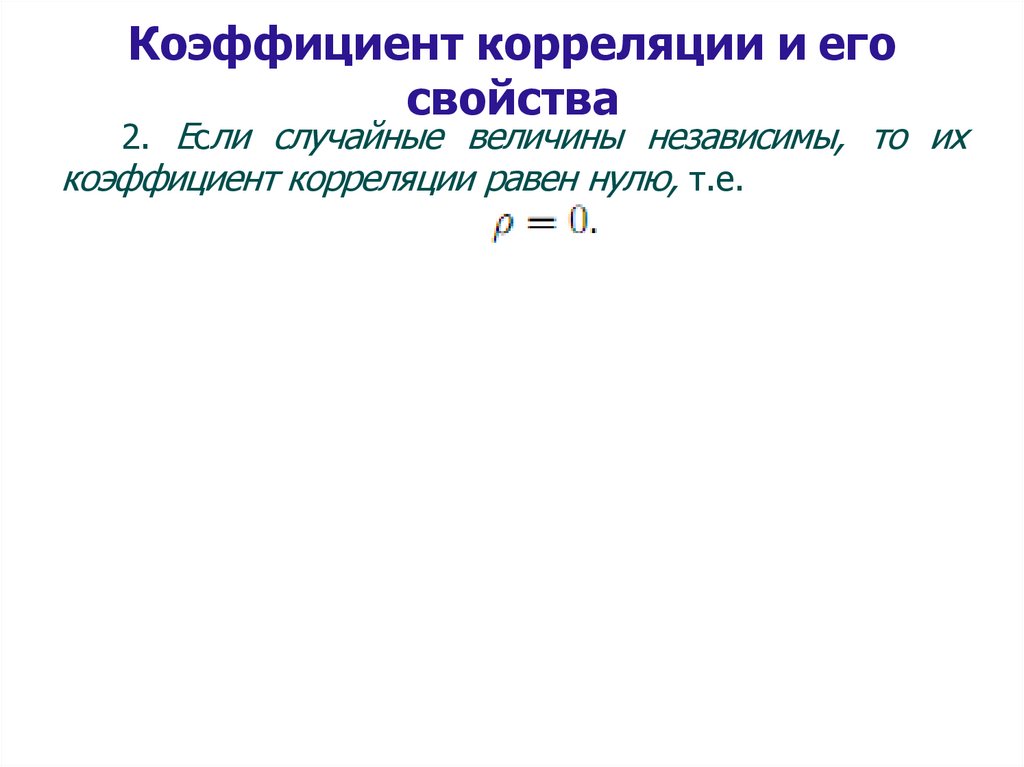

Коэффициент корреляции и егосвойства

2. Если случайные величины независимы, то их

коэффициент корреляции равен нулю, т.е.

125.

Коэффициент корреляции и егосвойства

3. Если модуль коэффициента корреляции двух

случайных величин равен 1, то между этими

случайными

величинами

существует

линейная

функциональная зависимость.

126.

Функция распределения случайнойвеличины.

В качестве

описания дискретной случайной

величины

ранее

рассматривали

закон

ее

распределения. Однако такое описание не является

единственным, а, главное, не универсально. Так, оно

неприменимо для описания непрерывной случайной

величины.

Для описания закона распределения случайной

величины возможен следующий подход: рассматривать

не вероятность события { =х} для разных значений х

(как это имеет место в законе распределения), а

вероятности события { <x} , где х – текущая

переменная. Вероятность P( <x), очевидно, зависит от

х, т.е. является некоторой функцией от х.

127.

Функция распределения случайнойвеличины.

Функцией распределения

случайной величины

называется функция F(x),

выражающая для каждого значения х вероятность того,

что случайная величина примет значение меньшее х:

Определение.

F (x) P( x) .

Геометрически

функция

распределения

интерпретируется как вероятность того, что случайная

точка попадет левее заданной точки х.

<x

0

x

x

128.

Свойства функции распределенияслучайной величины.

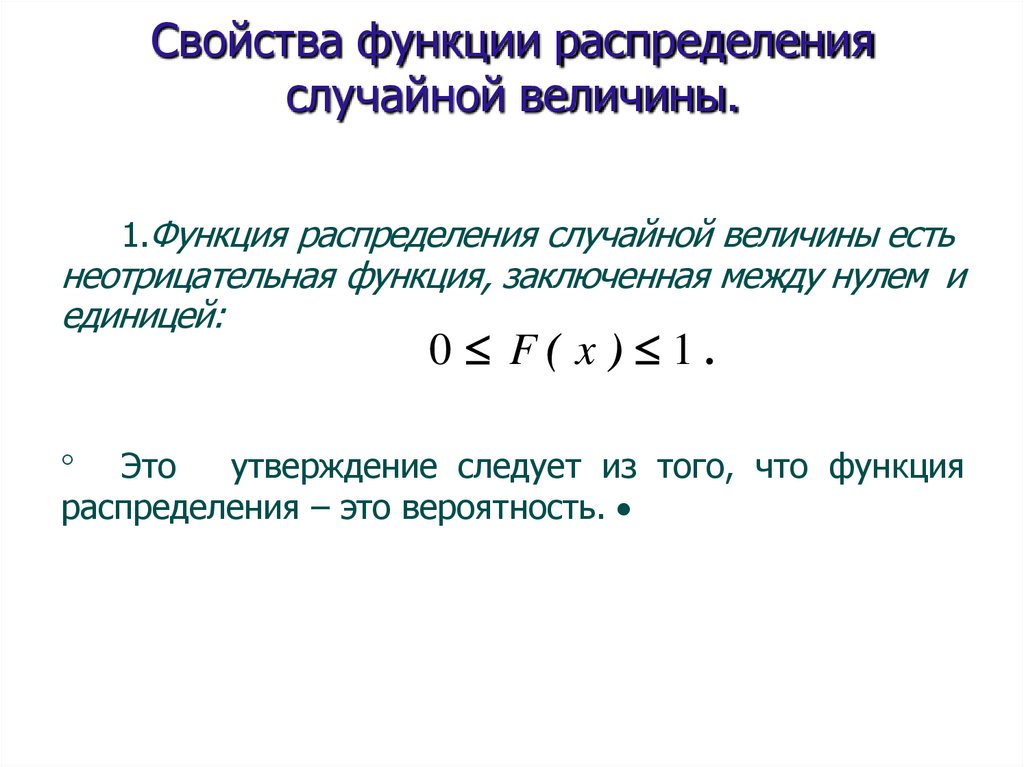

1.Функция распределения случайной величины есть

неотрицательная функция, заключенная между нулем и

единицей:

0 F( x ) 1.

Это

утверждение следует из того, что функция

распределения – это вероятность.

129.

Свойства функции распределенияслучайной величины.

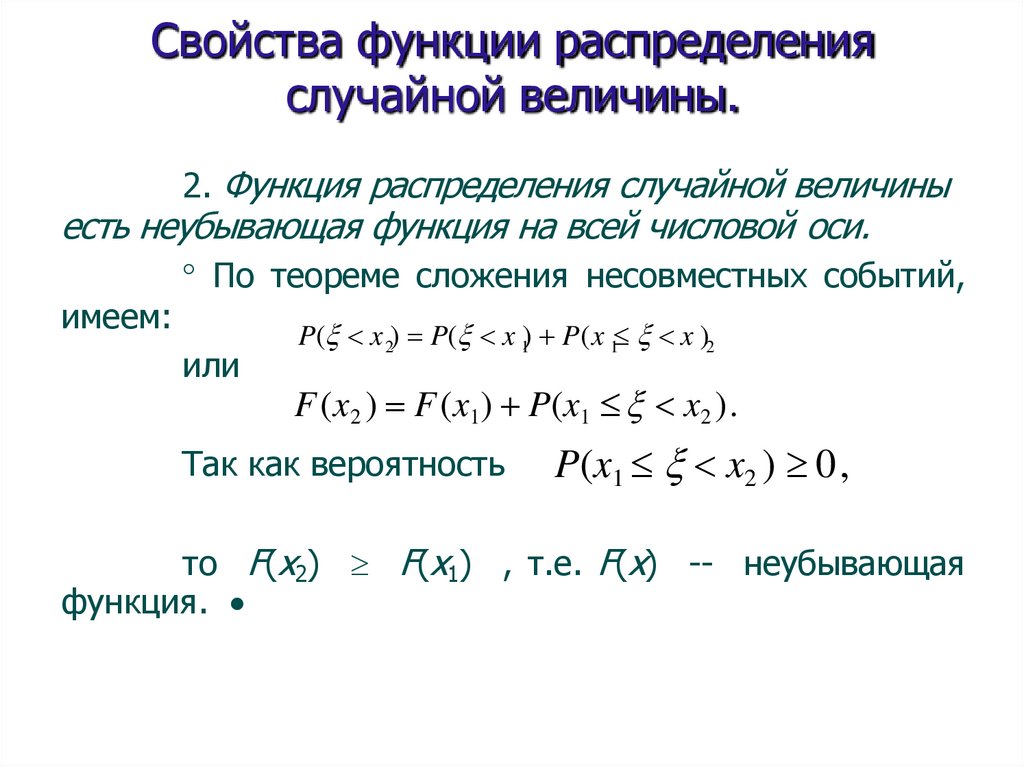

2. Функция распределения случайной величины

есть неубывающая функция на всей числовой оси.

имеем:

По теореме сложения несовместных событий,

или

P( x 2) P( x 1) P(x 1 x )2

F (x2 ) F (x1) P(x1 x2 ).

Так как вероятность

P(x1 x2 ) 0,

то F(x2) F(x1) , т.е. F(x) -- неубывающая

функция.

130.

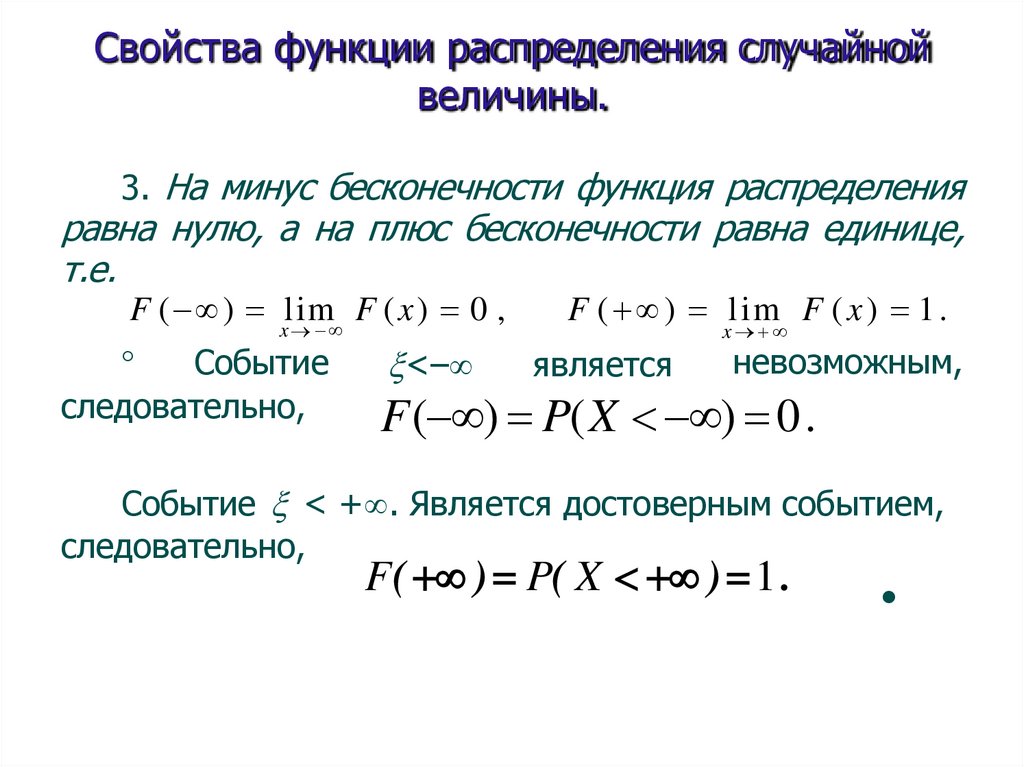

Свойства функции распределения случайнойвеличины.

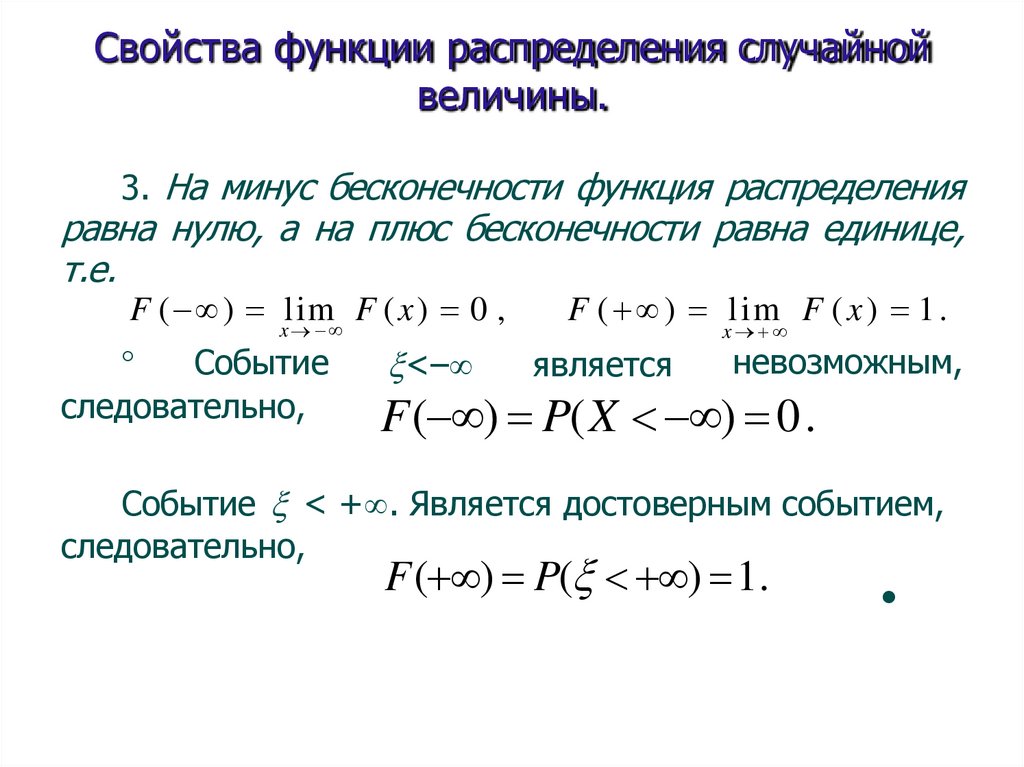

3. На минус бесконечности функция распределения

равна нулю, а на плюс бесконечности равна единице,

т.е.

F ( ) xlim

F (x) 0 ,

Событие

следовательно,

<–

F ( ) lim F ( x ) 1 .

является

x

невозможным,

F( ) P(X ) 0.

Событие < + . Является достоверным событием,

следовательно,

F( ) P( X ) 1 .

131.

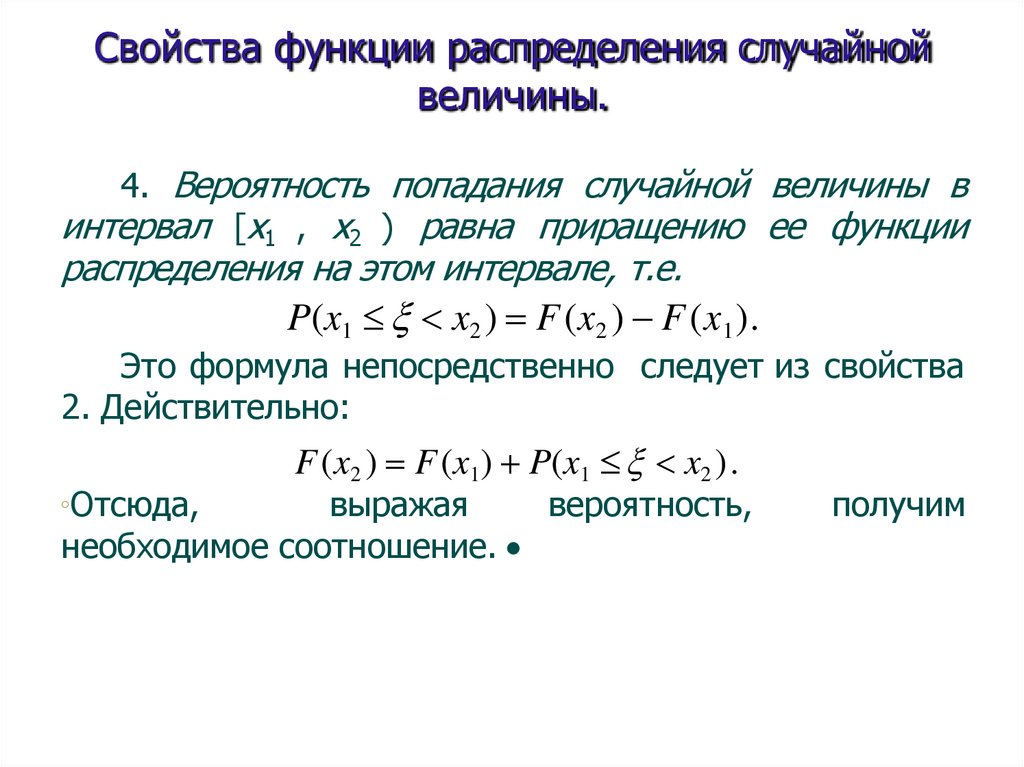

Свойства функции распределения случайнойвеличины.

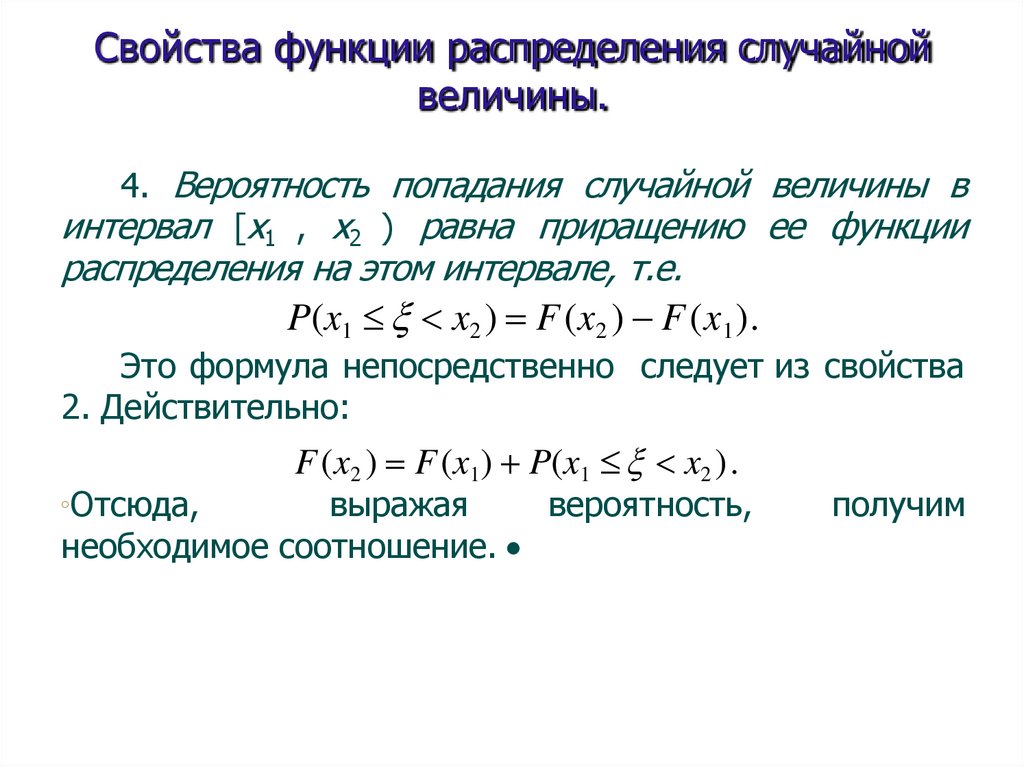

4. Вероятность попадания случайной величины в

интервал [x1 , x2 ) равна приращению ее функции

распределения на этом интервале, т.е.

P(x1 x2 ) F (x2 ) F (x 1 ).

Это формула непосредственно следует из свойства

2. Действительно:

Отсюда,

F (x2 ) F (x1) P(x1 x2 ).

выражая

вероятность,

необходимое соотношение.

получим

132.

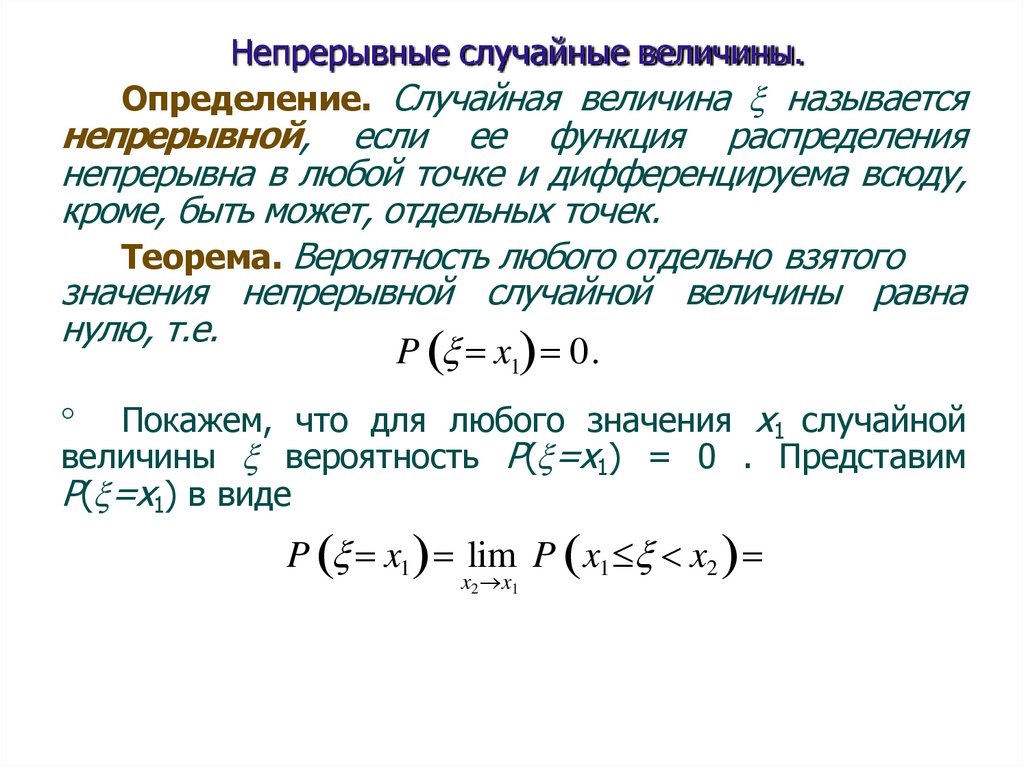

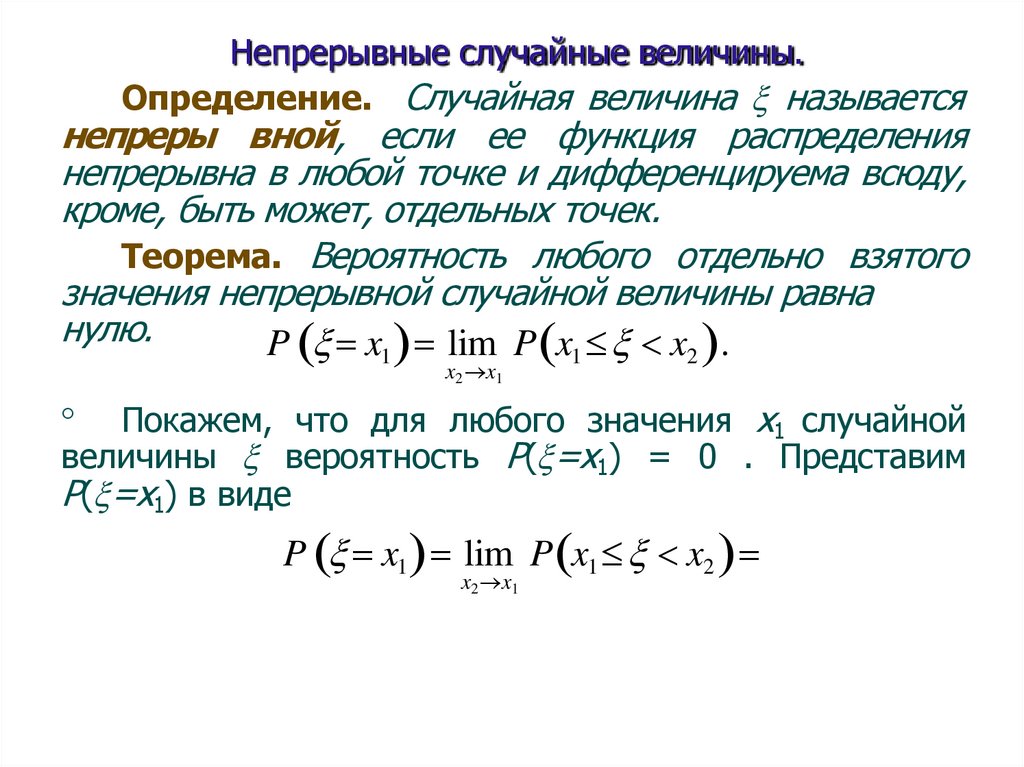

Непрерывные случайные величины.Определение. Случайная величина называется

непрерывной, если ее функция распределения

непрерывна в любой точке и дифференцируема всюду,

кроме, быть может, отдельных точек.

Теорема. Вероятность любого отдельно взятого

значения непрерывной случайной величины равна

нулю, т.е.

P x1 0.

Покажем, что для любого значения х1 случайной

величины вероятность Р( =х1) = 0 . Представим

Р( =х1) в виде

P x1 lim P x1 x2

x2 x1

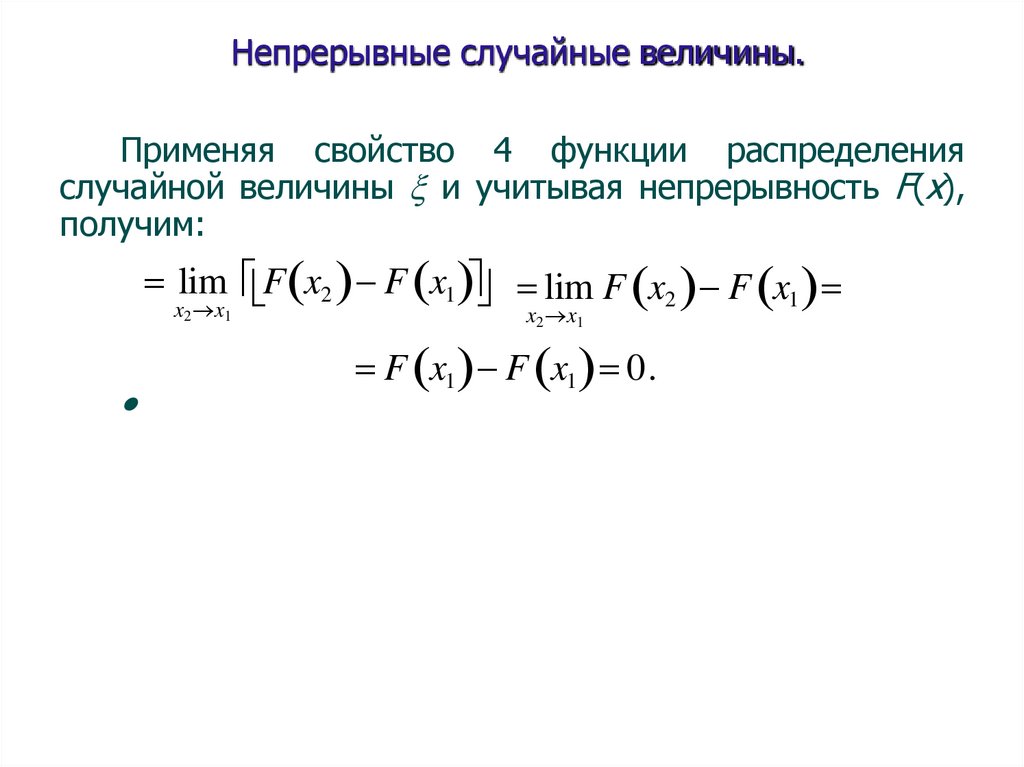

133.

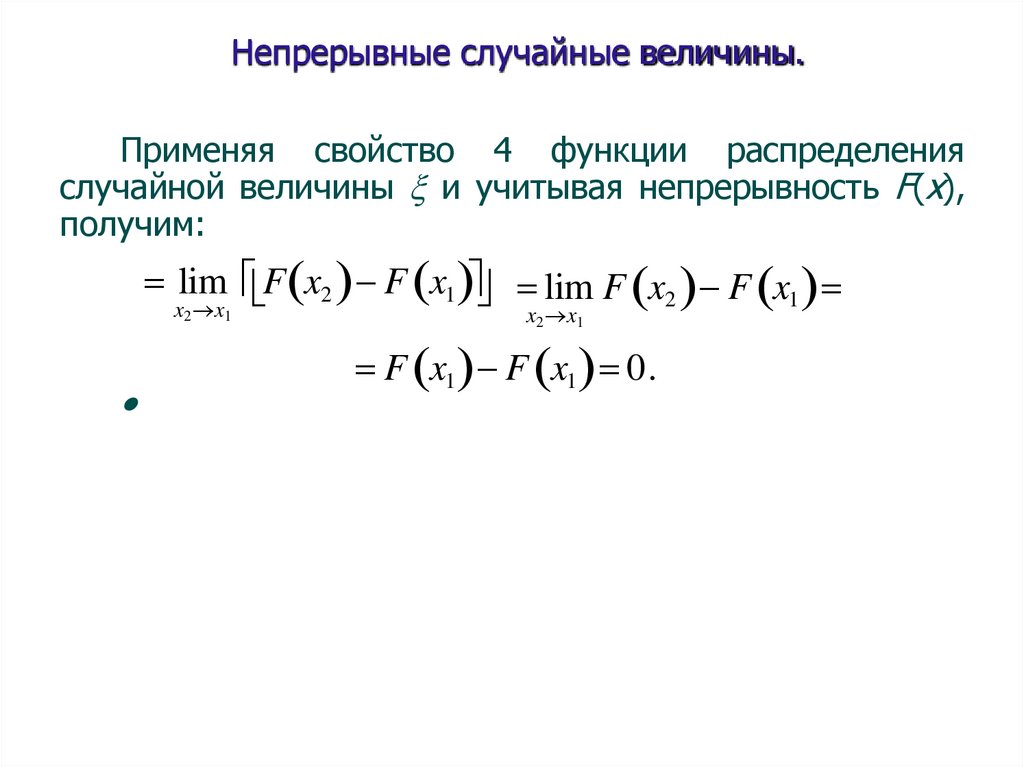

Непрерывные случайные величины.Применяя свойство 4 функции распределения

случайной величины и учитывая непрерывность F(x),

получим:

lim F x2 F x1 lim F x2 F x1

x2 x1

x2 x1

F x1 F x1 0.

134.

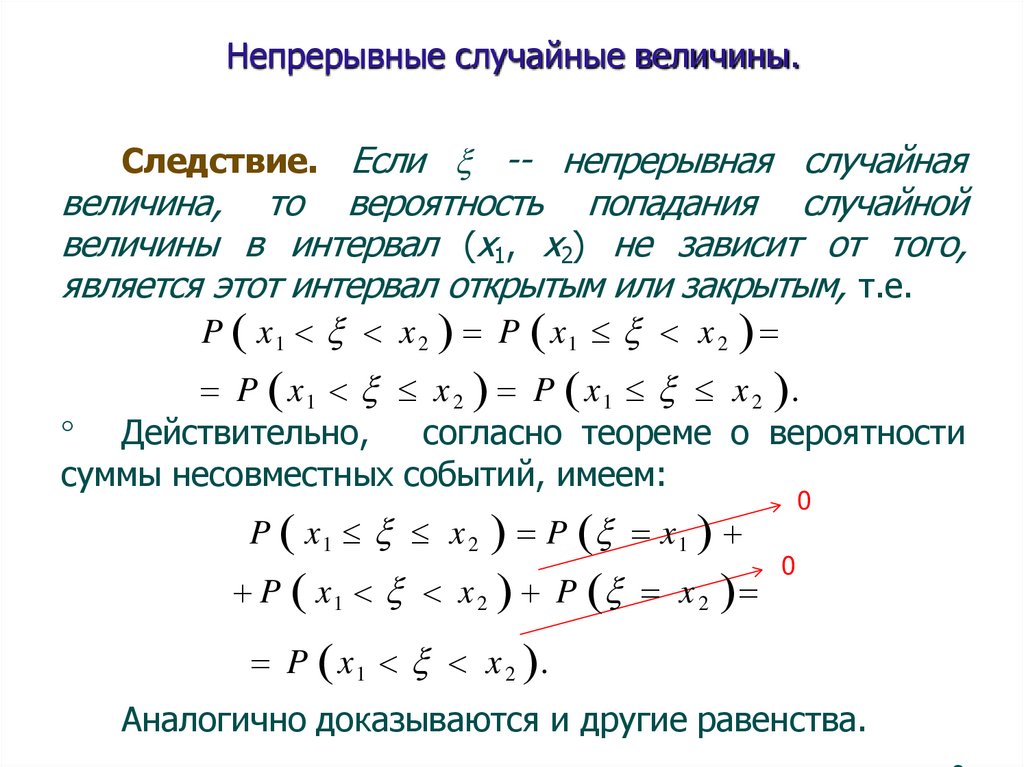

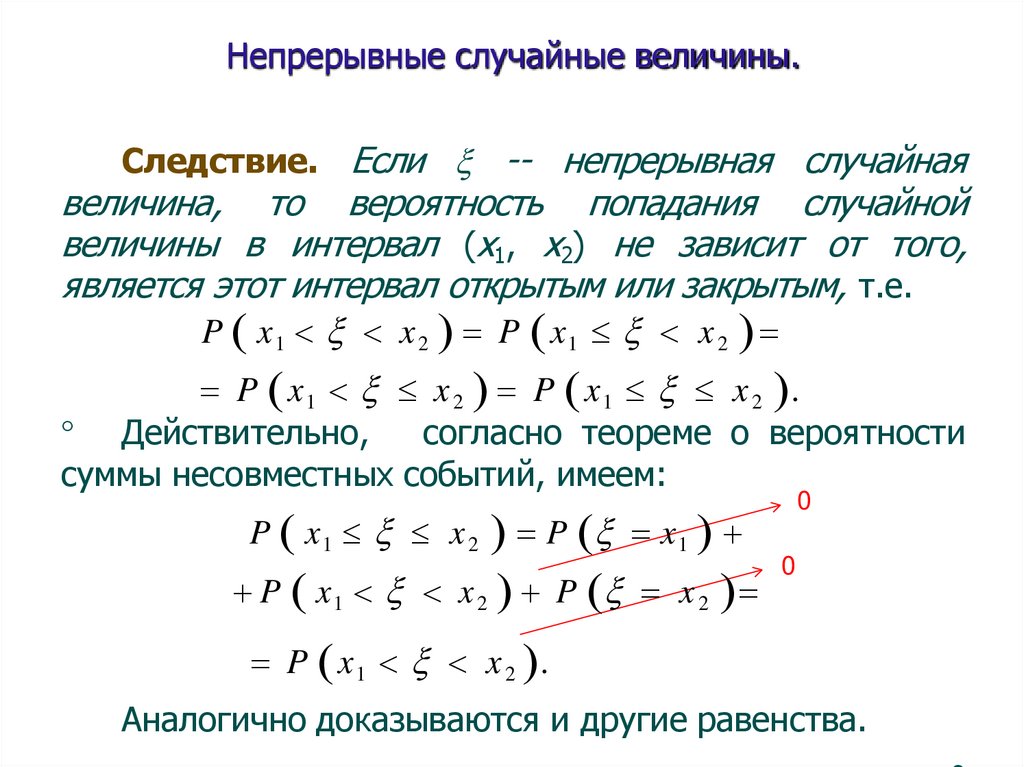

Непрерывные случайные величины.Следствие. Если -- непрерывная случайная

величина, то вероятность попадания случайной

величины в интервал (х1, х2) не зависит от того,

является этот интервал открытым или закрытым, т.е.

P x1 x 2 P x1 x 2

P x 1 x 2 P x 1 x 2 .

Действительно,

согласно теореме о вероятности

суммы несовместных событий, имеем:

0

P x1 x 2 P x1

P x1 x 2 P x 2

0

P x1 x 2 .

Аналогично доказываются и другие равенства.

135.

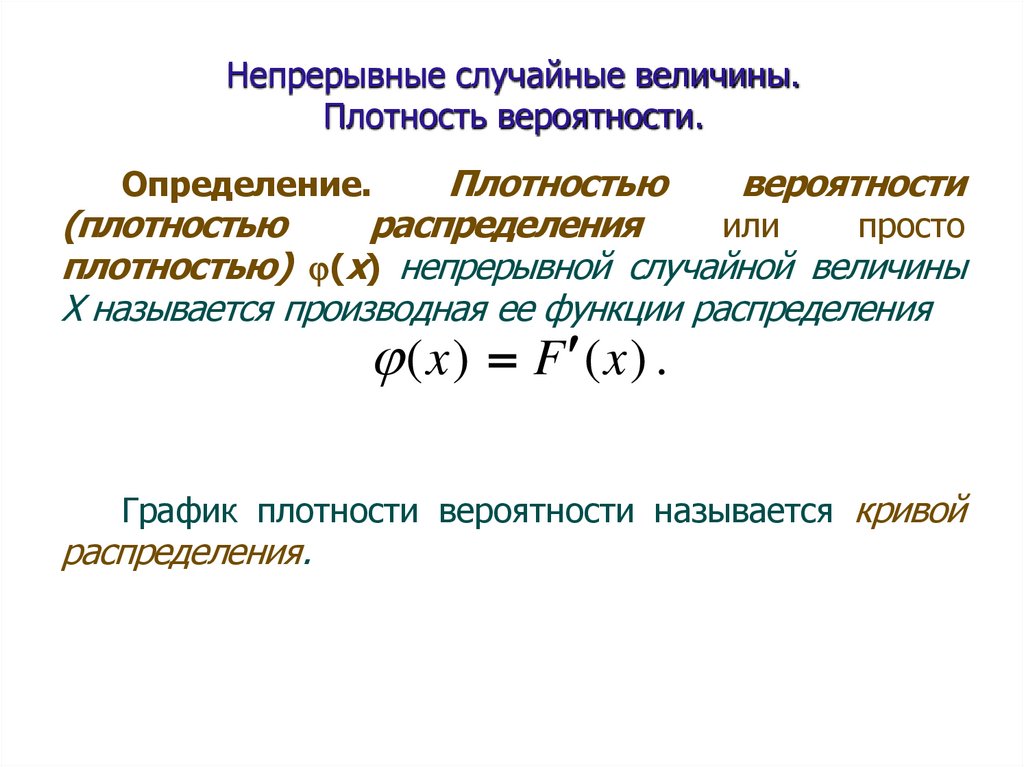

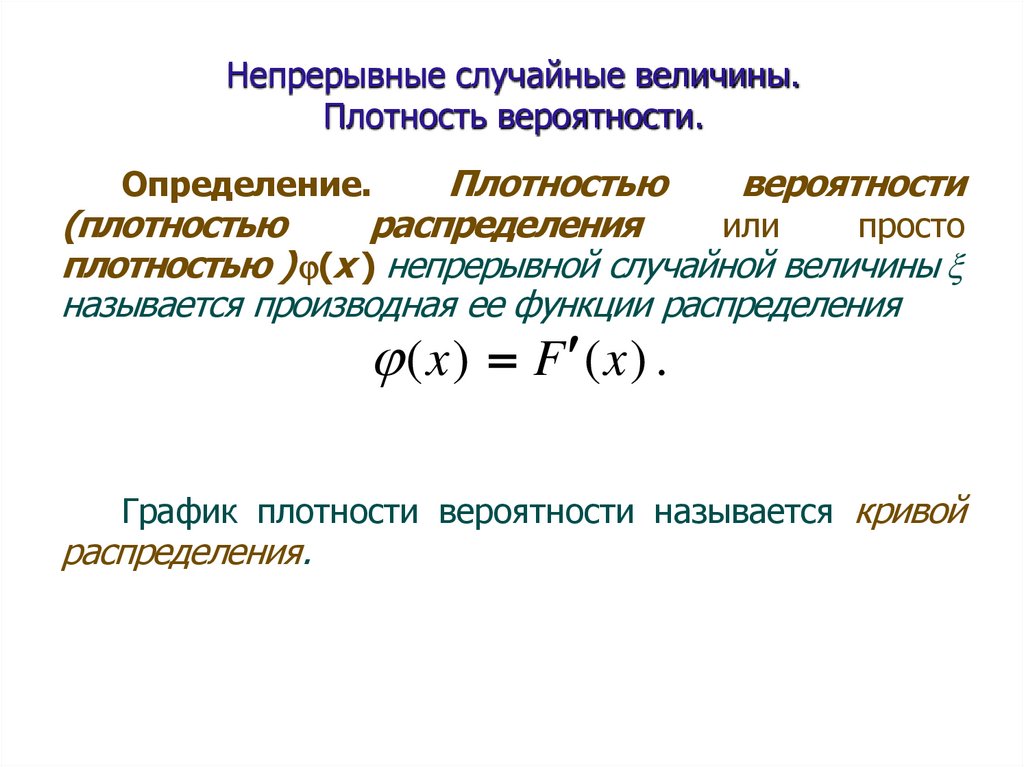

Непрерывные случайные величины.Плотность вероятности.

Плотностью

вероятности

(плотностью

распределения

или

просто

плотностью) (х) непрерывной случайной величины

Х называется производная ее функции распределения

Определение.

(x) F (x) .

График плотности вероятности называется кривой

распределения.

136.

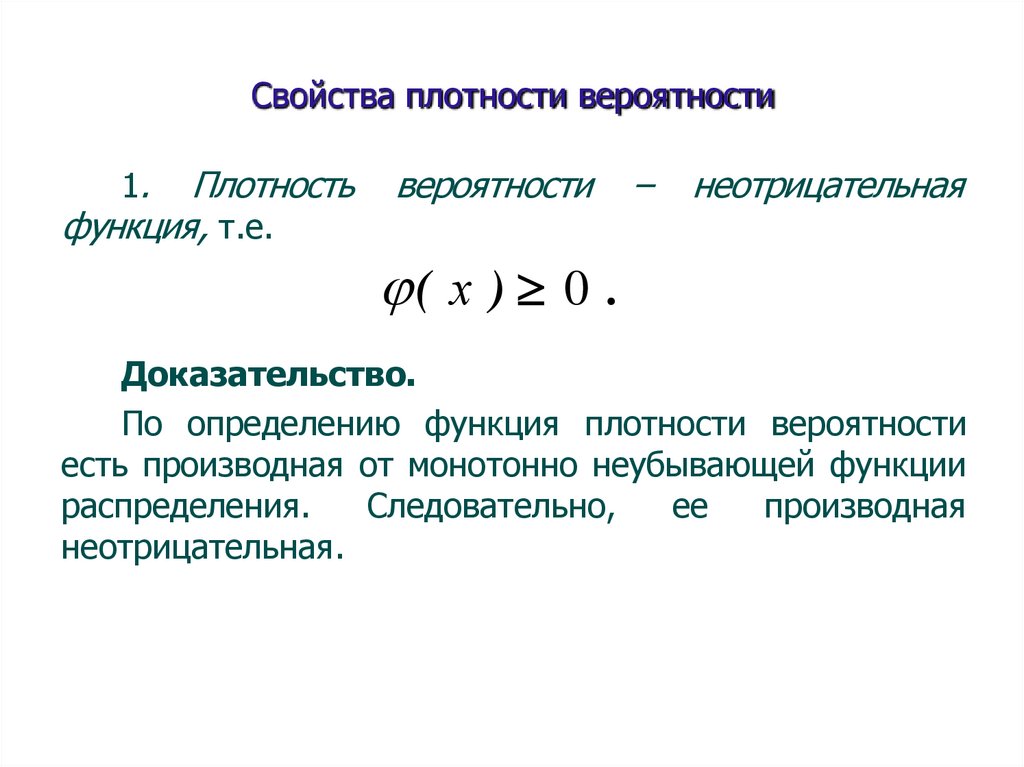

Свойства плотности вероятности1.

Плотность

функция, т.е.

вероятности

–

неотрицательная

( х ) 0 .

Доказательство.

По определению функция плотности вероятности

есть производная от монотонно неубывающей функции

распределения.

Следовательно,

ее

производная

неотрицательная.

137.

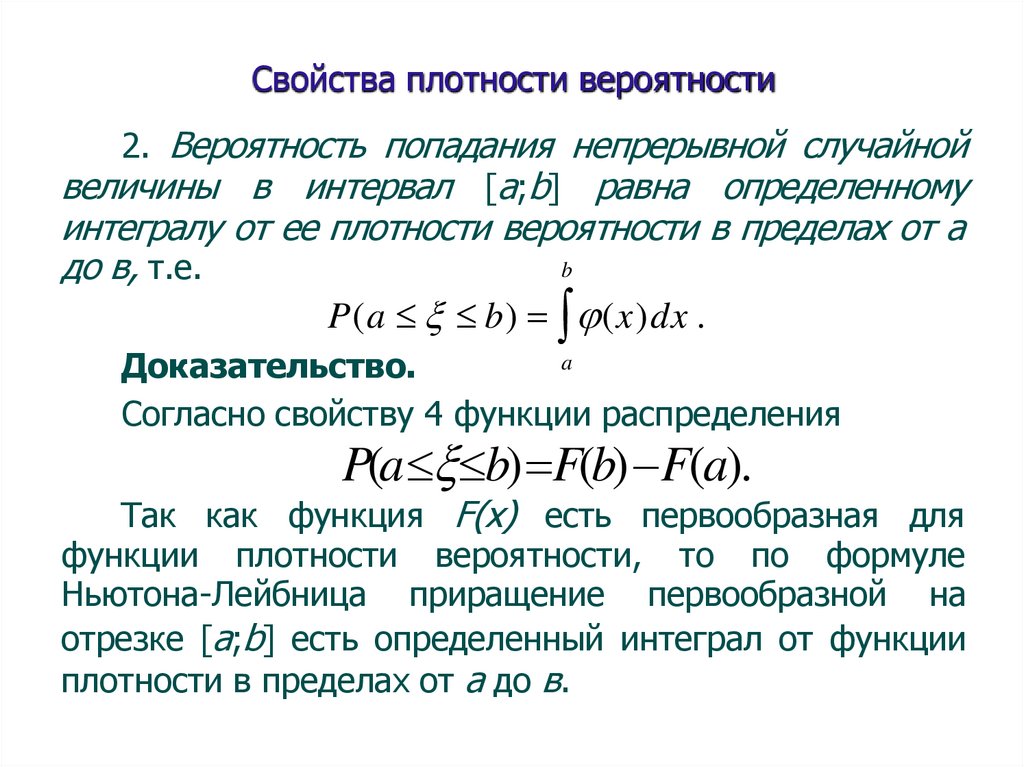

Свойства плотности вероятности2. Вероятность попадания непрерывной случайной

величины в интервал [a;b] равна определенному

интегралу от ее плотности вероятности в пределах от а

b

до в, т.е.

P(a b) (x)dx .

a

Доказательство.

Согласно свойству 4 функции распределения

P(a b) F(b) F(a).

Так как функция F(x) есть первообразная для

функции плотности вероятности, то по формуле

Ньютона-Лейбница приращение первообразной на

отрезке [a;b] есть определенный интеграл от функции

плотности в пределах от а до в.

138.

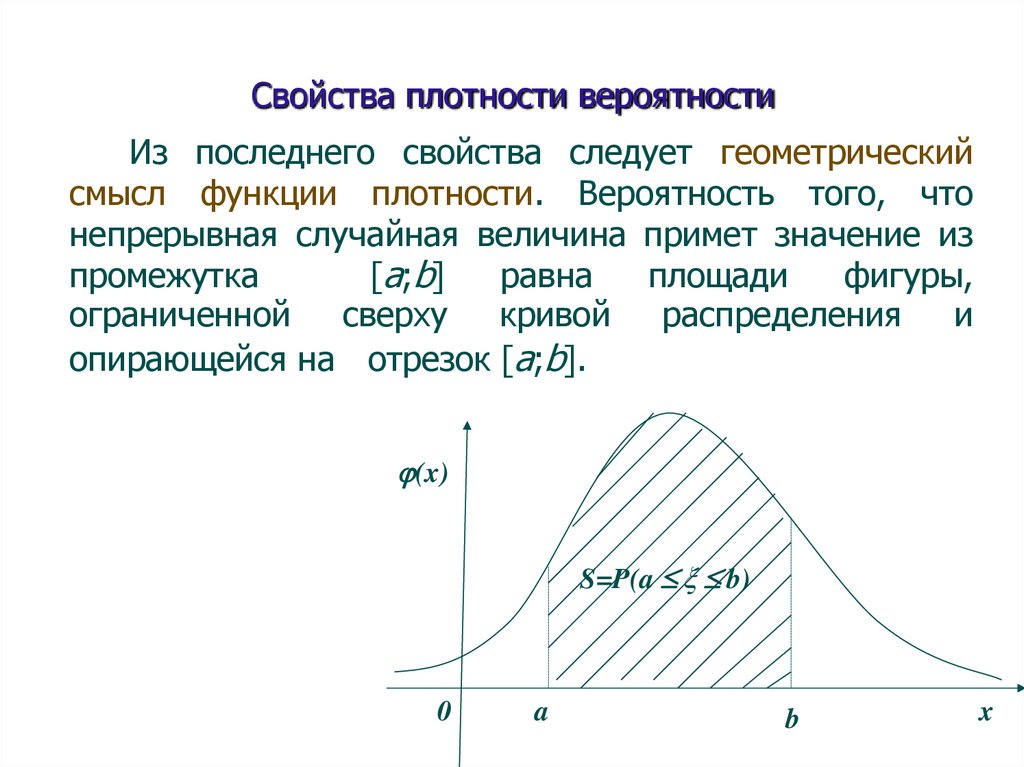

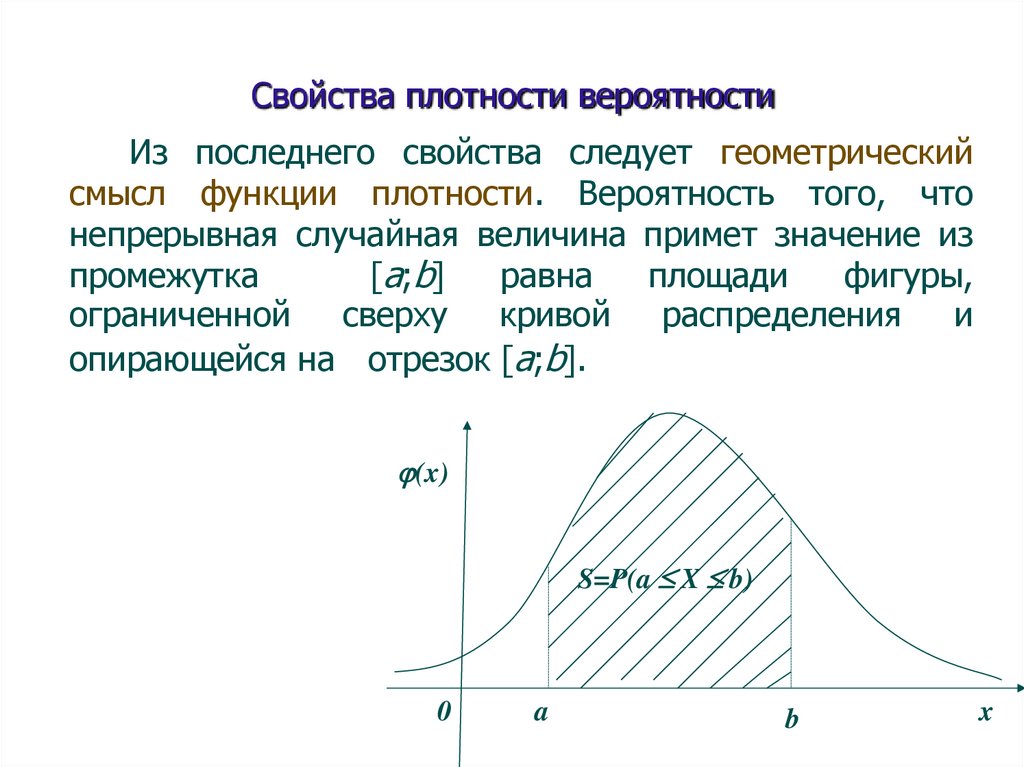

Свойства плотности вероятностиИз последнего свойства следует геометрический

смысл функции плотности. Вероятность того, что

непрерывная случайная величина примет значение из

[a;b]

равна

площади

фигуры,

промежутка

ограниченной

сверху

кривой

распределения

и

опирающейся на отрезок [a;b].

(x)

S=P(a b)

0

a

b

x

139.

Свойства плотности вероятности3. Функция распределения непрерывной случайной

величины может быть выражена через плотность

вероятности по формуле:

x

F ( x ) ( x )dx .

Эта формула получается из предыдущей (свойство

2) при а - , если верхний предел в заменить на

переменный предел х.

140.

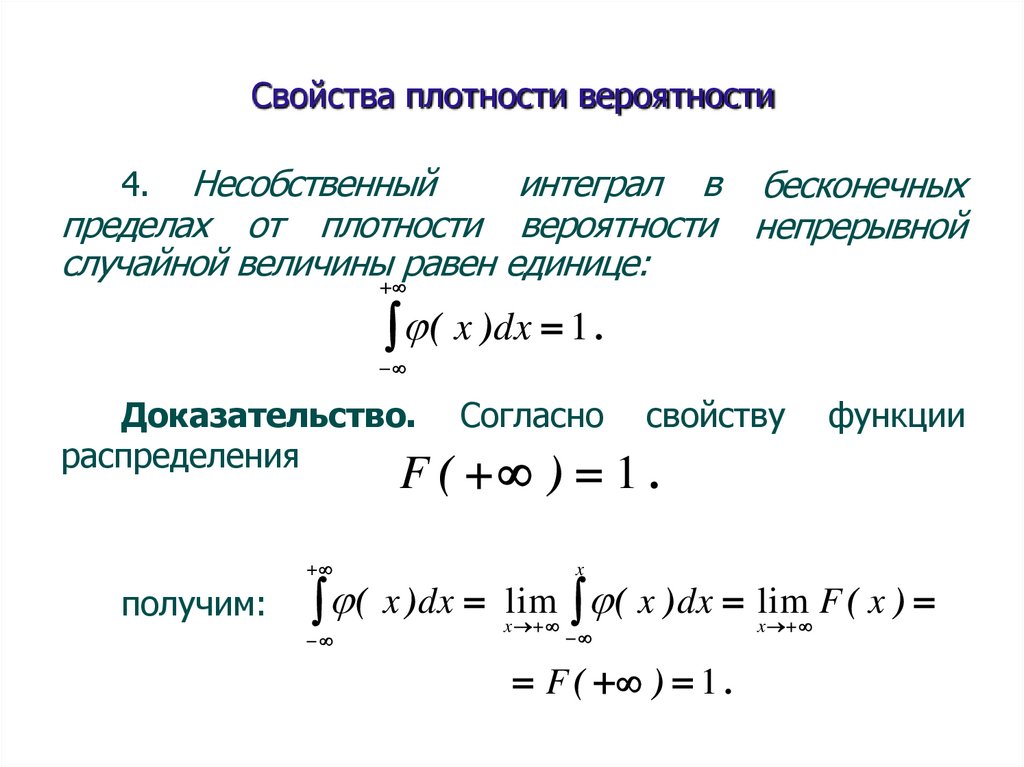

Свойства плотности вероятностиНесобственный

интеграл в бесконечных

пределах от плотности вероятности непрерывной

случайной величины равен единице:

4.

( x )dx 1 .

Доказательство.

распределения

Согласно

свойству

функции

F ( ) 1 .

получим:

x

( x )dx lim ( x )dx lim F ( x )

x

F ( ) 1 .

x

141.

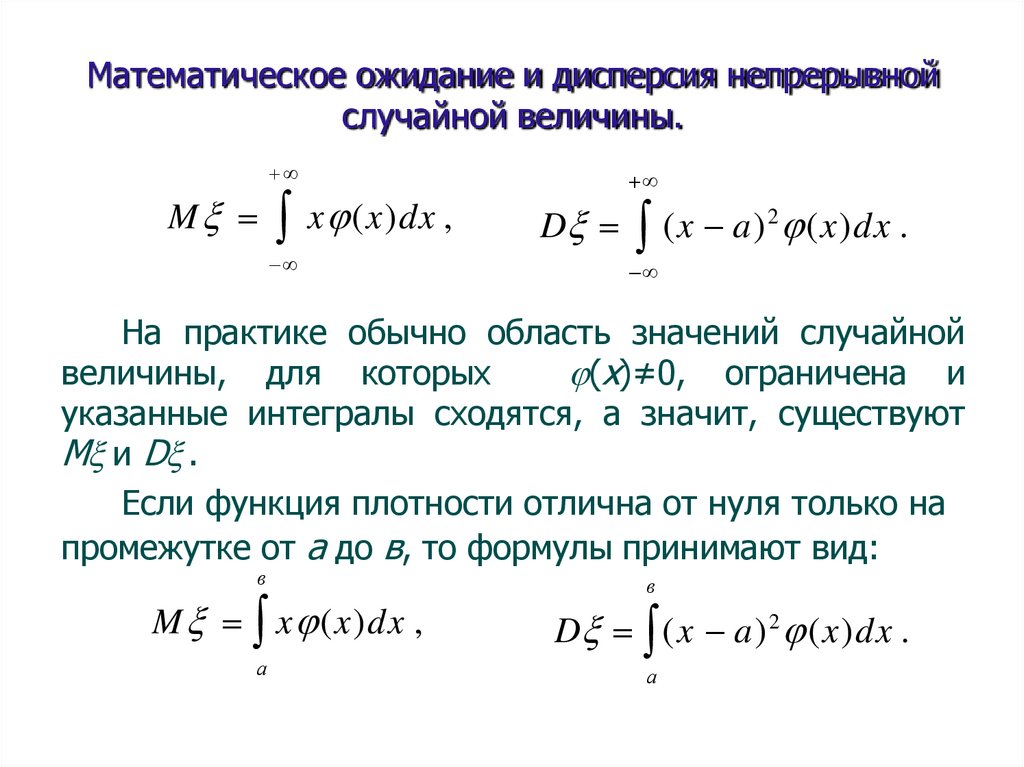

Математическое ожидание и дисперсия непрерывнойслучайной величины.

M x (x)dx ,

D (x a) 2 (x)dx .

На практике обычно область значений случайной

величины, для которых (x) # 0, ограничена и

указанные интегралы сходятся, а значит, существуют

М и D .

Если функция плотности отлична от нуля только на

промежутке от а до в, то формулы принимают вид:

в

M x (x)dx ,

а

в

D (x a) 2 (x)dx .

а

142.

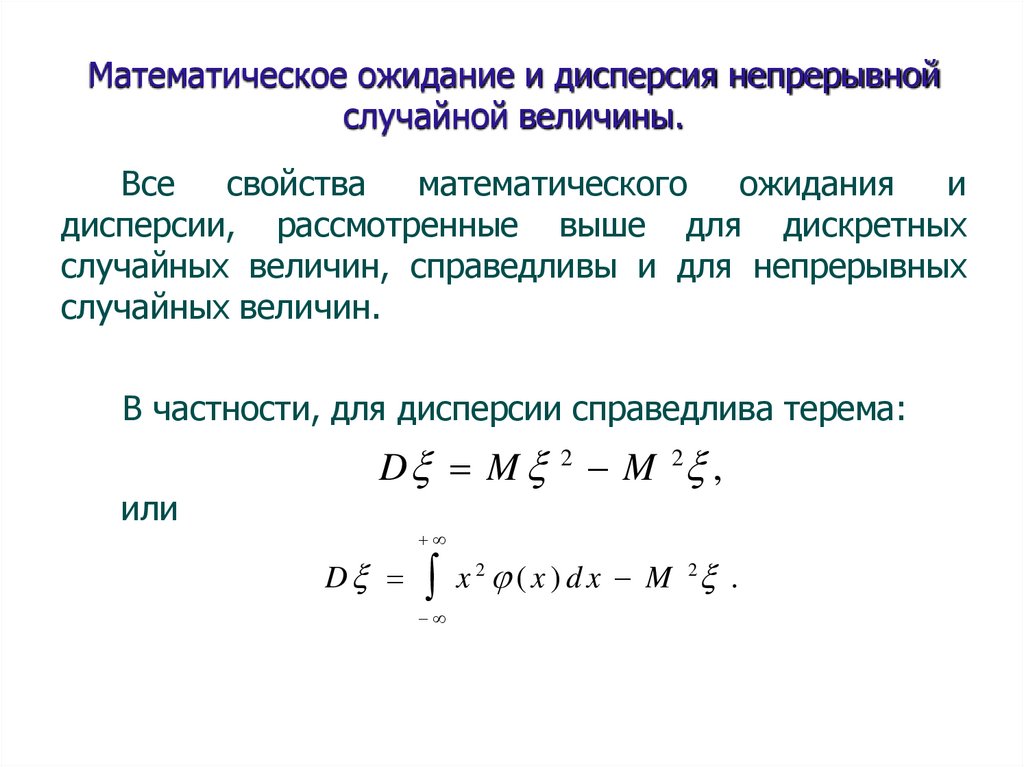

Математическое ожидание и дисперсия непрерывнойслучайной величины.

Все

свойства

математического

ожидания

и

дисперсии, рассмотренные выше для дискретных

случайных величин, справедливы и для непрерывных

случайных величин.

В частности, для дисперсии справедлива терема:

или

D M 2 M 2 ,

D

x (x)dx M .

2

2

143.

Спасибо за внимание144.

Анализ данныхАвтор:

доцент департамента

«Анализа данных, принятия решений и финансовых технологий»

к.ф.-м.н.

Потемкин Александр Владимирович

145.

Анализ данныхЛекция 4

Непрерывные случайные величины

146.

Функция распределения случайнойвеличины.

Функцией распределения

случайной величины

называется функция F(x),

выражающая для каждого значения х вероятность того,

что случайная величина примет значение меньшее х:

Определение.

F (x) P( x) .

Геометрически

функция

распределения

интерпретируется как вероятность того, что случайная

точка попадет левее заданной точки х.

<x

0

x

x

147.

Свойства функции распределенияслучайной величины.

1.Функция распределения случайной величины есть

неотрицательная функция, заключенная между нулем и

единицей:

0 F( x ) 1.

Это

утверждение следует из того, что функция

распределения – это вероятность.

148.

Свойства функции распределенияслучайной величины.

2. Функция распределения случайной величины

есть неубывающая функция на всей числовой оси.

имеем:

По теореме сложения несовместных событий,

или

P( x 2) P( x 1) P(x 1 x )2

F (x2 ) F (x1) P(x1 x2 ).

Так как вероятность

P(x1 x2 ) 0,

то F(x2) F(x1) , т.е. F(x) -- неубывающая

функция.

149.

Свойства функции распределения случайнойвеличины.

3. На минус бесконечности функция распределения

равна нулю, а на плюс бесконечности равна единице,

т.е.

F ( ) xlim

F (x) 0 ,

Событие

следовательно,

<–

F ( ) lim F ( x ) 1 .

является

x

невозможным,

F( ) P(X ) 0.

Событие < + . Является достоверным событием,

следовательно,

F( ) P( ) 1.

150.

Свойства функции распределения случайнойвеличины.

4. Вероятность попадания случайной величины в

интервал [x1 , x2 ) равна приращению ее функции

распределения на этом интервале, т.е.

P(x1 x2 ) F (x2 ) F (x 1 ).

Это формула непосредственно следует из свойства

2. Действительно:

Отсюда,

F (x2 ) F (x1) P(x1 x2 ).

выражая

вероятность,

необходимое соотношение.

получим

151.

Непрерывные случайные величины.Определение. Случайная величина называется

непреры вной, если ее функция распределения

непрерывна в любой точке и дифференцируема всюду,

кроме, быть может, отдельных точек.

Теорема. Вероятность любого отдельно взятого

значения непрерывной случайной величины равна

нулю.

P x1 lim P x1 x2 .

x2 x1

Покажем, что для любого значения х1 случайной

величины вероятность Р( =х1) = 0 . Представим

Р( =х1) в виде

P x1 lim P x1 x2

x2 x1

152.

Непрерывные случайные величины.Применяя свойство 4 функции распределения

случайной величины и учитывая непрерывность F(x),

получим:

lim F x2 F x1 lim F x2 F x1

x2 x1

x2 x1

F x1 F x1 0.

153.

Непрерывные случайные величины.Следствие. Если -- непрерывная случайная

величина, то вероятность попадания случайной

величины в интервал (х1, х2) не зависит от того,

является этот интервал открытым или закрытым, т.е.

P x1 x 2 P x1 x 2

P x 1 x 2 P x 1 x 2 .

Действительно,

согласно теореме о вероятности

суммы несовместных событий, имеем:

0

P x1 x 2 P x1

P x1 x 2 P x 2

0

P x1 x 2 .

Аналогично доказываются и другие равенства.

154.

Непрерывные случайные величины.Плотность вероятности.

Плотностью

вероятности

(плотностью

распределения

или

просто

плотностью ) (х ) непрерывной случайной величины

называется производная ее функции распределения

Определение.

(x) F (x) .

График плотности вероятности называется кривой

распределения.

155.

Свойства плотности вероятности1.

Плотность

функция, т.е.

вероятности

–

неотрицательная

( х ) 0 .

Доказательство.

По определению функция плотности вероятности

есть производная от монотонно неубывающей функции

распределения.

Следовательно,

ее

производная

неотрицательная.

156.

Свойства плотности вероятности2. Вероятность попадания непрерывной случайной

величины в интервал [a;b] равна определенному

интегралу от ее плотности вероятности в пределах от а

b

до в, т.е.

P(a b) (x)dx .

a

Доказательство.

Согласно свойству 4 функции распределения

P(a b) F(b) F(a).

Так как функция F(x) есть первообразная для

функции плотности вероятности, то по формуле

Ньютона-Лейбница приращение первообразной на

отрезке [a;b] есть определенный интеграл от функции

плотности в пределах от а до в.

157.

Свойства плотности вероятностиИз последнего свойства следует геометрический

смысл функции плотности. Вероятность того, что

непрерывная случайная величина примет значение из

[a;b]

равна

площади

фигуры,

промежутка

ограниченной

сверху

кривой

распределения

и

опирающейся на отрезок [a;b].

(x)

S=P(a X b)

0

a

b

x

158.

Свойства плотности вероятности3. Функция распределения непрерывной случайной

величины может быть выражена через плотность

вероятности по формуле:

x

F ( x ) ( x )dx .

Эта формула получается из предыдущей (свойство

2) при а - , если верхний предел в заменить на

переменный предел х.

159.

Свойства плотности вероятностиНесобственный

интеграл в бесконечных

пределах от плотности вероятности непрерывной

случайной величины равен единице:

4.

( x )dx 1 .

Доказательство.

распределения

Согласно

свойству

функции

F ( ) 1 .

получим:

x

( x )dx lim ( x )dx lim F ( x )

x

F ( ) 1 .

x

160.

Математическое ожидание и дисперсия непрерывнойслучайной величины.

M x (x)dx ,

D (x a) 2 (x)dx .

На практике обычно область значений случайной

(x)≠0, ограничена и

величины, для которых

указанные интегралы сходятся, а значит, существуют

М и D .

Если функция плотности отлична от нуля только на

промежутке от а до в, то формулы принимают вид:

в

M x (x)dx ,

а

в

D (x a) 2 (x)dx .

а

161.

Математическое ожидание и дисперсия непрерывнойслучайной величины.

Все

свойства

математического

ожидания

и

дисперсии, рассмотренные выше для дискретных

случайных величин, справедливы и для непрерывных

случайных величин.

В частности, для дисперсии справедлива терема:

или

D M 2 M 2 ,

D

x (x)dx M .

2

2

162.

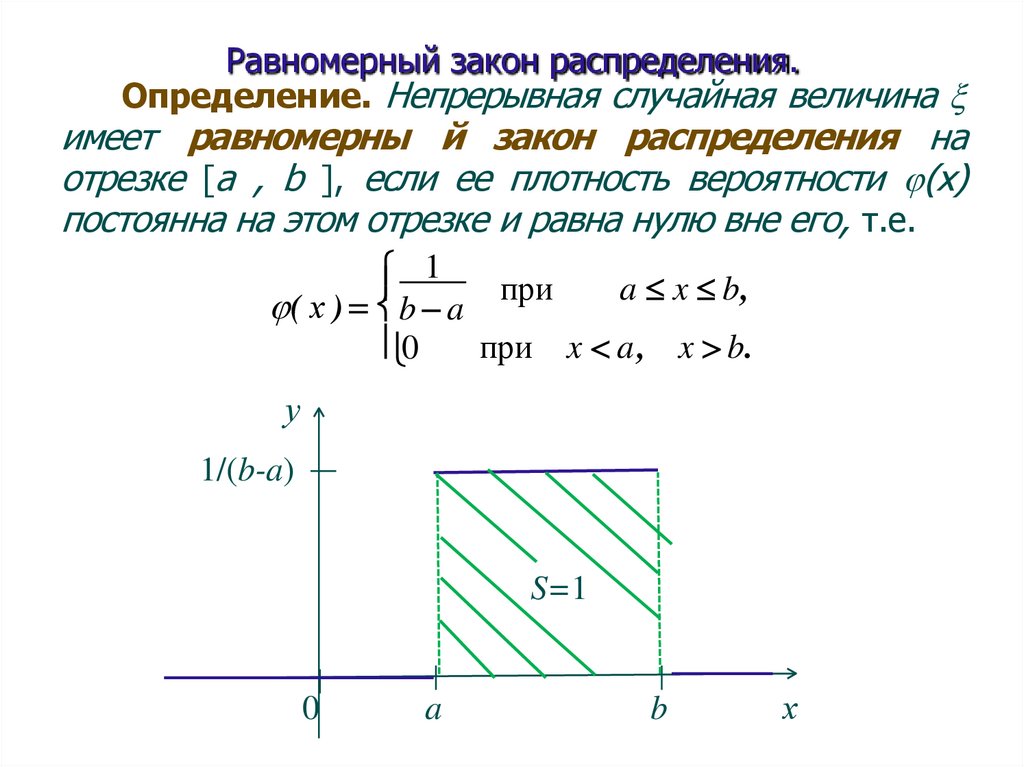

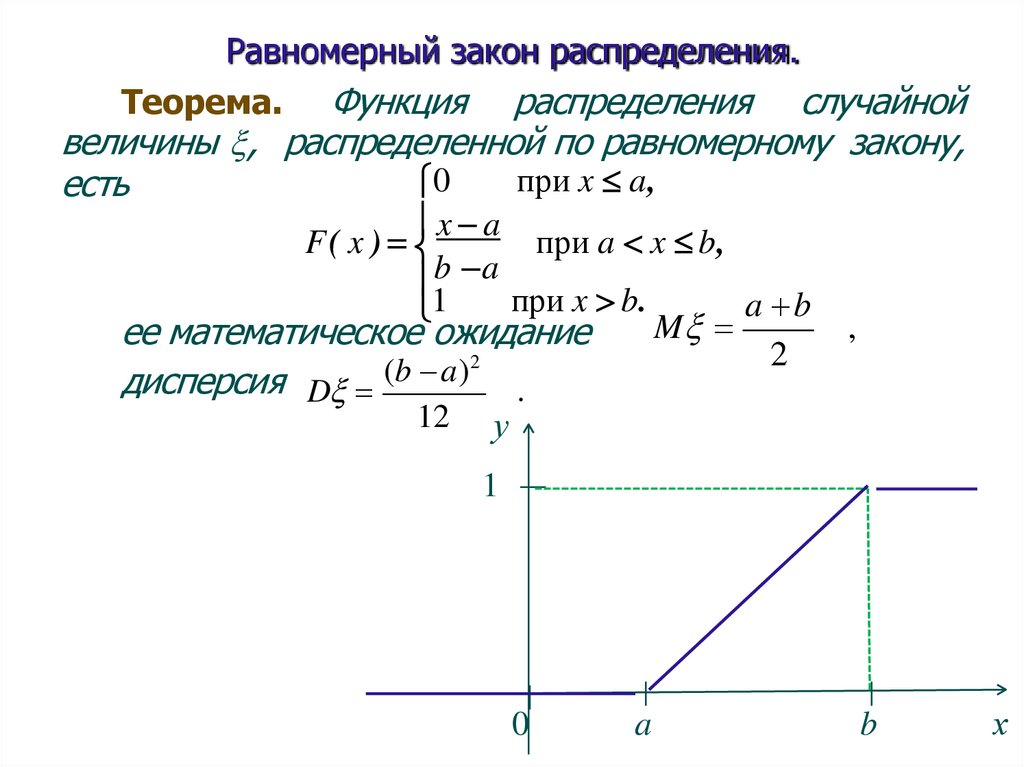

Равномерный закон распределения.Определение. Непрерывная случайная величина

имеет равномерны й закон распределения на

отрезке [a , b ], если ее плотность вероятности (х)

постоянна на этом отрезке и равна нулю вне его, т.е.

1

a x b,

( х ) b a при

0

при x a, x b.

у

1/(b-a)

S=1

0

a

b

х

163.

Равномерный закон распределения.Функция распределения случайной

величины , распределенной по равномерному закону,

при x a,

0

есть

Теорема.

x a

F( x )

при a x b,

b a

при x b.

a b

1

M

ее математическое ожидание

2

2

(b

a)

дисперсия D

.

12 у

,

1

0

a

b

х

164.

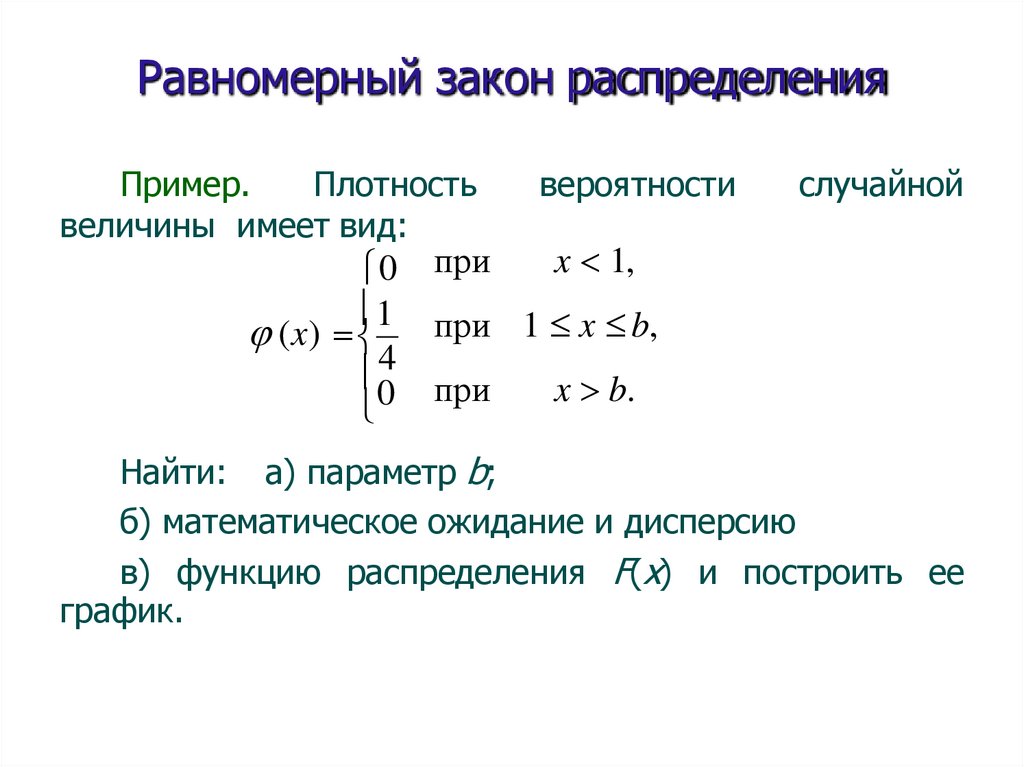

Равномерный закон распределенияПример.

Плотность

величины имеет вид:

0

1

(x)

04

при

вероятности

случайной

x 1,

при 1 x b,

при

x b.

Найти: а) параметр b;

б) математическое ожидание и дисперсию

в) функцию распределения F(x) и построить ее

график.

165.

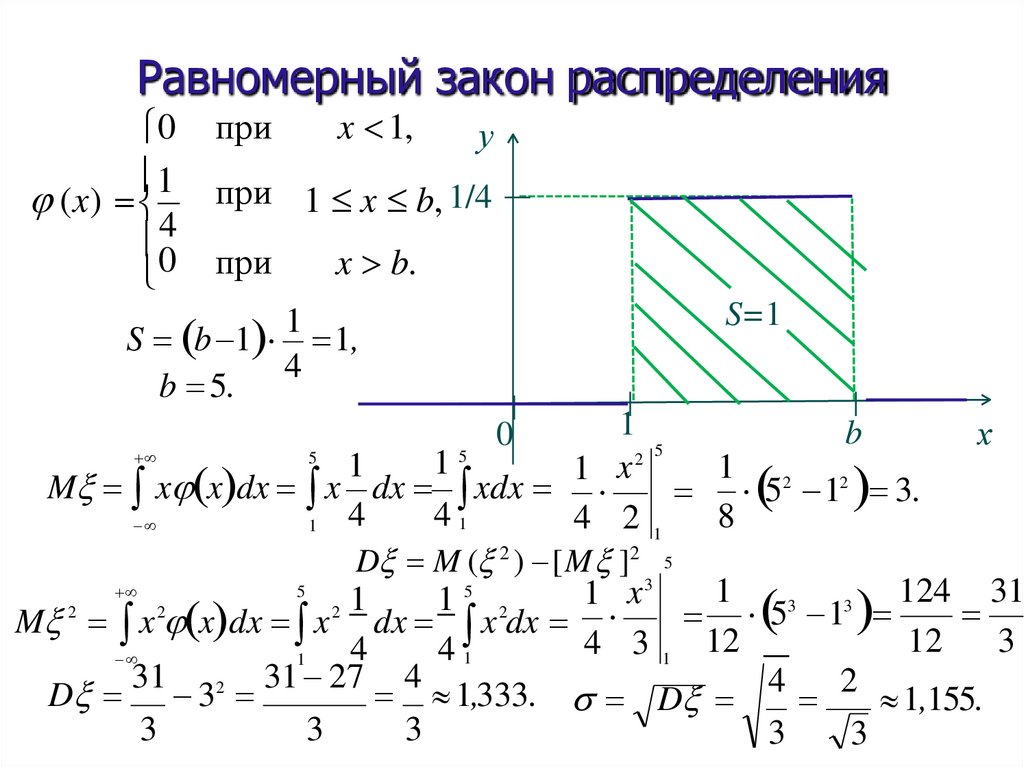

Равномерный закон распределения0

1

(x)

04

при

x 1,

у

при 1 x b, 1/4

при

x b.

S=1

1

S b 1 1,

4

b 5.

1

b

х

5

5

2 5

1

1

1 2 2

1 x

M x x dx x dx xdx

5 1 3.

4

41

8

4 21

1

D M ( 2 ) [M ]2 5

3

5

5

1

124 31

x

1

1 2

3

3

2

2

2 1

5 1

M x x dx x dx x dx

12

3

4 3 1 12

4

41

1

31

31 27 4

D 32

1,333. D 4 2 1,155.

3

3

3

3

3

0

166.

Равномерный закон распределенияФункция распределения

непрерывной случайной

x

величины

F x t dt.

x 1:

x

x

F x t dt 0dt 0 ;

x

1

x

1

1

1

1 x 5:

F x t dt 0dt dt t x 1 ;

4 1 54

4

1 4

x

5

x

1

1

x 5 : F x t dt 0dt dt 0dt 1 t 1 5 1 1.

4

4 1 4

5

4

у1

0, при x 1,

1

1

F x x 1 , при 1 x 5,

4

1, при x 5.

0

x

1

b

х

167.

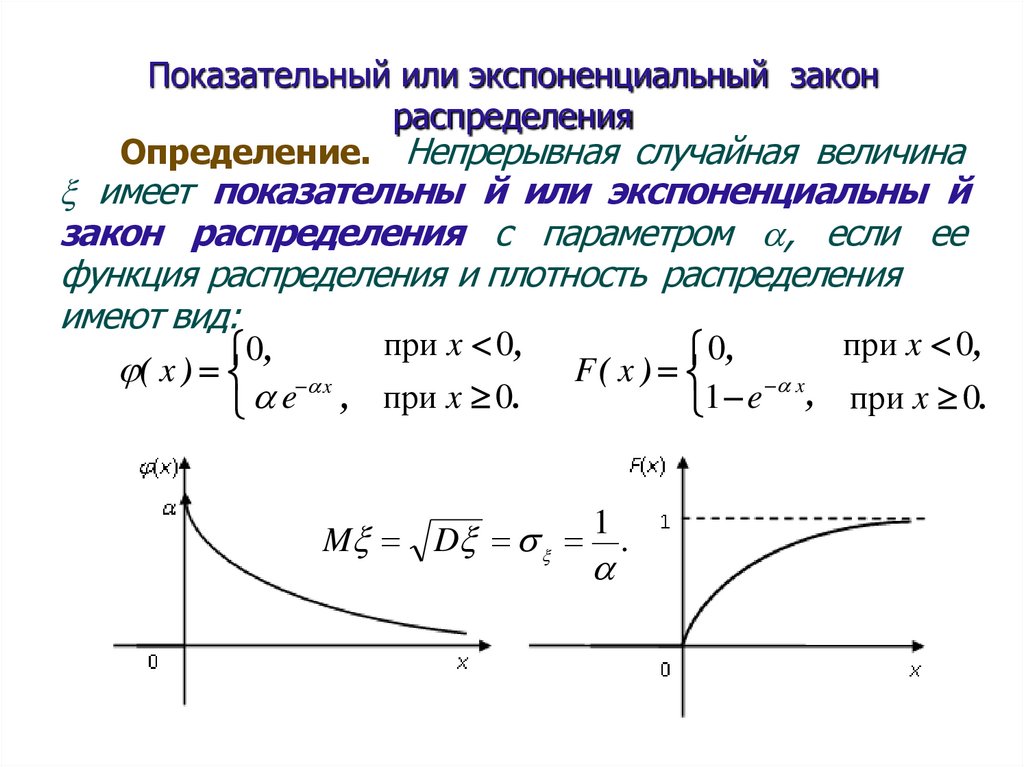

Показательный или экспоненциальный законраспределения

Определение. Непрерывная случайная величина

имеет показательны й или экспоненциальны й

закон распределения с параметром , если ее

функция распределения и плотность распределения

имеют вид:

при x 0,

при x 0,

0,

0,

F( x )

( x ) x

x

, при x 0.

e

,

при

x

0.

1

e

M D

1

.

168.

Показательный или экспоненциальный законраспределения

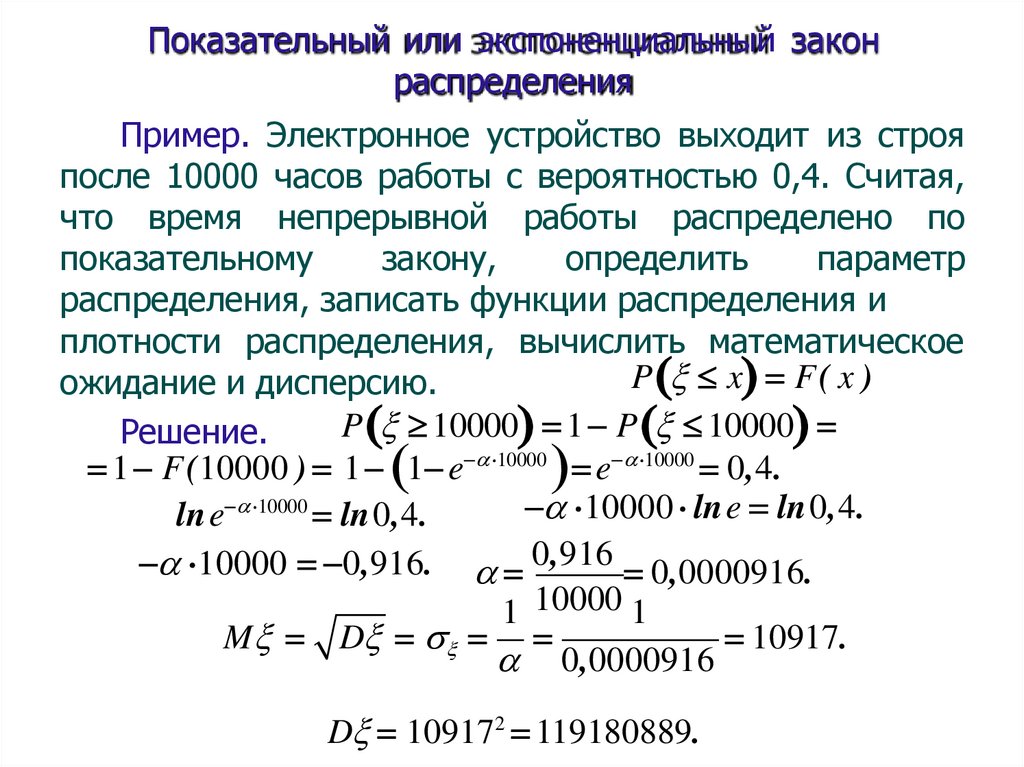

Пример. Электронное устройство выходит из строя

после 10000 часов работы с вероятностью 0,4. Считая,

что время непрерывной работы распределено по

показательному

закону,

определить

параметр

распределения, записать функции распределения и

плотности распределения, вычислить математическое

P x F( x )

ожидание и дисперсию.

P 10000 1 P 10000

Решение.

1 F (10000 ) 1 1 e 10000 e 10000 0,4.

10000 lne ln0,4.

lne 10000 ln0,4.

10000 0,916. 0,916 0,0000916.

1 10000 1

M D

10917.

0,0000916

D 109172 119180889.

169.

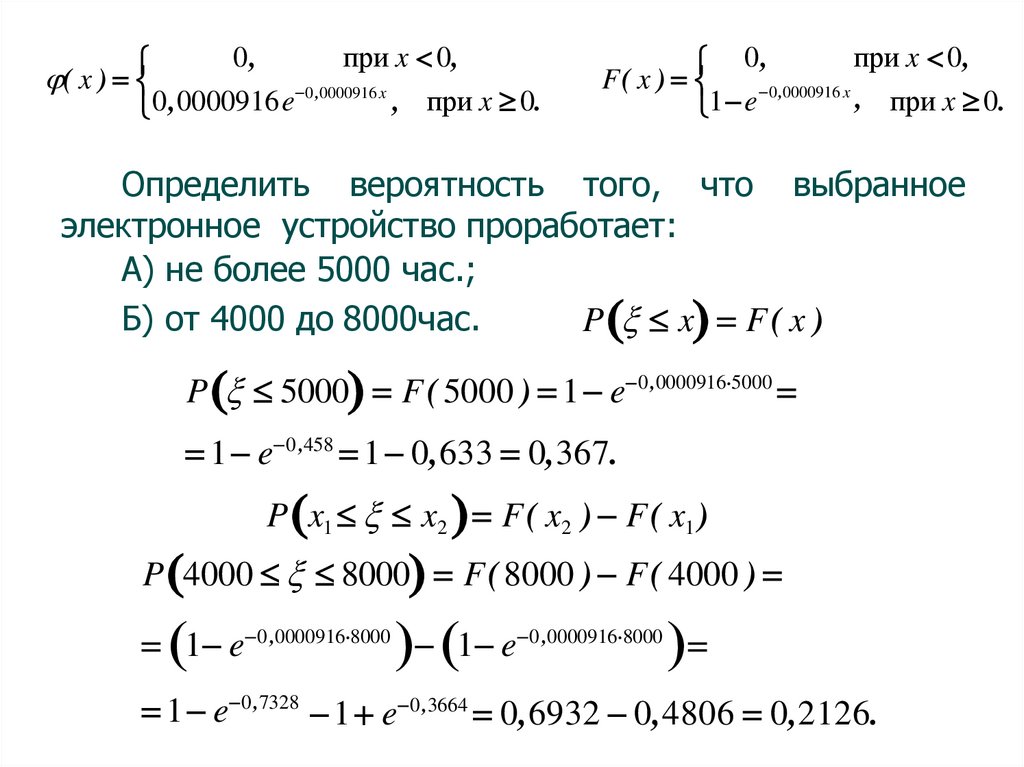

0,при x 0,

0 ,0000916 x

, при x 0.

0,0000916e

( x )

при x 0,

0,

F( x )

0 ,0000916 x

, при x 0.

1 e

Определить вероятность того, что выбранное

электронное устройство проработает:

А) не более 5000 час.;

Б) от 4000 до 8000час.

P x F( x )

P 5000 F( 5000 ) 1 e 0 ,0000916 5000

1 e 0 ,458 1 0,633 0,367.

P x1 x2 F( x2 ) F( x1 )

P 4000 8000 F( 8000 ) F( 4000 )

1 e 0 ,0000916 8000 1 e 0 ,0000916 8000

1 e 0 ,7328 1 e 0 ,3664 0,6932 0,4806 0,2126.

170.

Спасибо за внимание171.

Анализ данныхЛекция 5

Нормальный закон распределения.

Предельные теоремы теории вероятностей.

Закон больших чисел.

172.

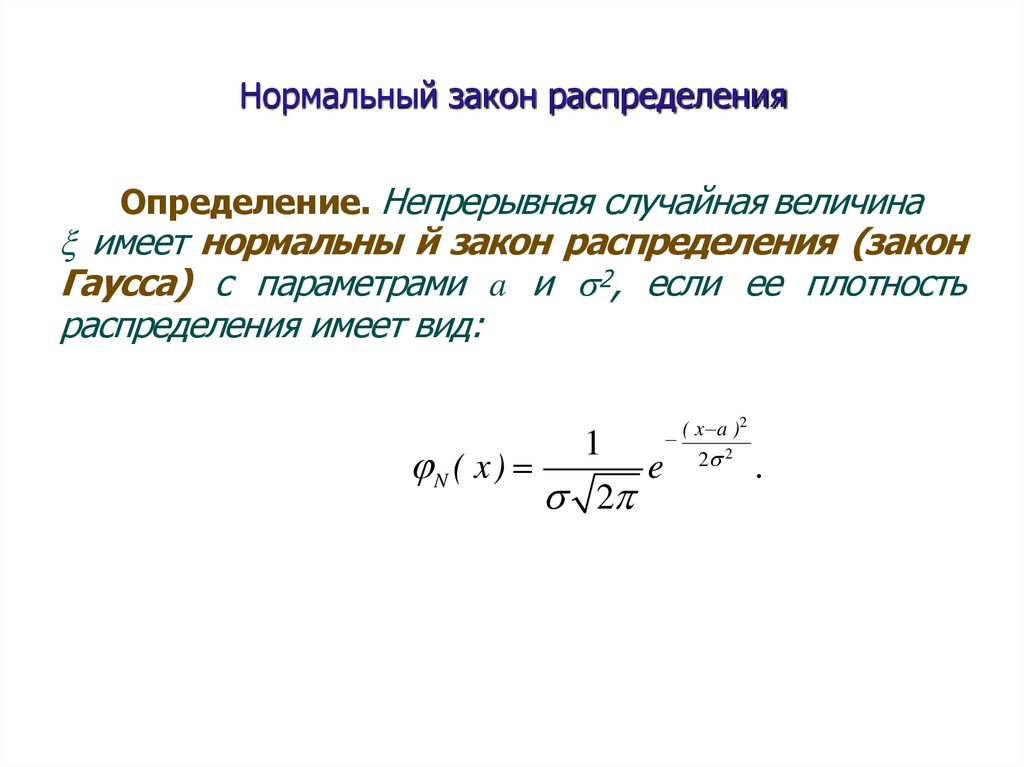

Нормальный закон распределенияОпределение. Непрерывная случайная величина

имеет нормальны й закон распределения (закон

Гаусса) с параметрами a и 2, если ее плотность

распределения имеет вид:

1

e

N ( x)

2

( x a )2

2 2

.

173.

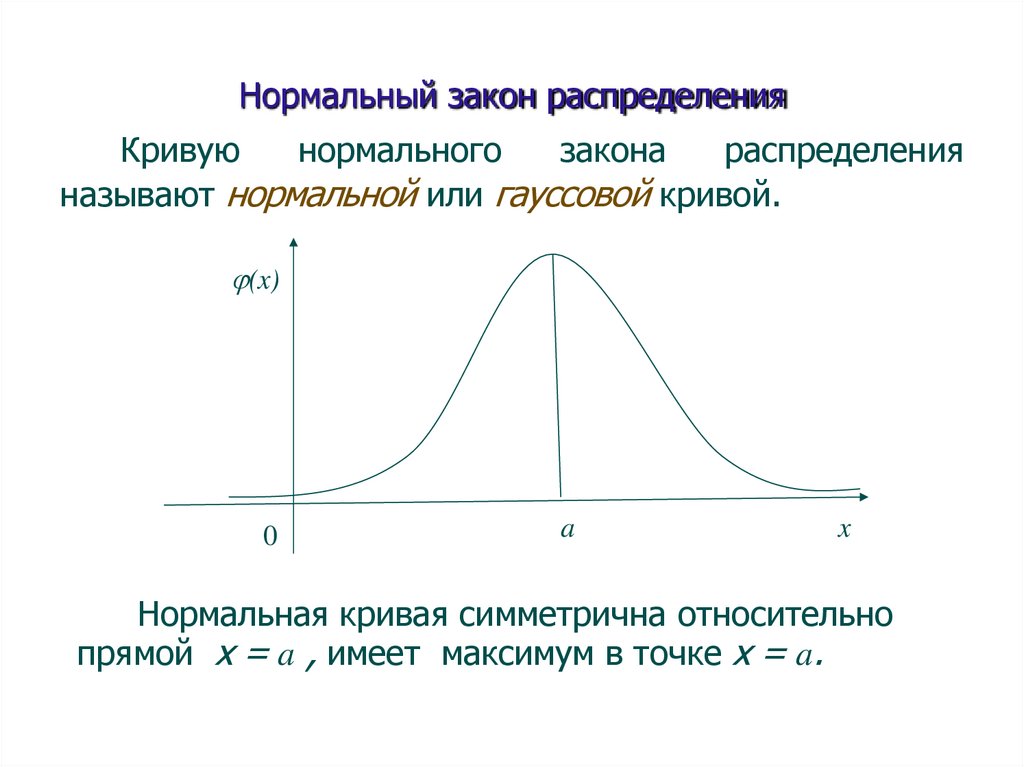

Нормальный закон распределенияКривую

нормального

закона

распределения

называют нормальной или гауссовой кривой.

(x)

0

a

x

Нормальная кривая симметрична относительно

прямой х = a , имеет максимум в точке х = a.

174.

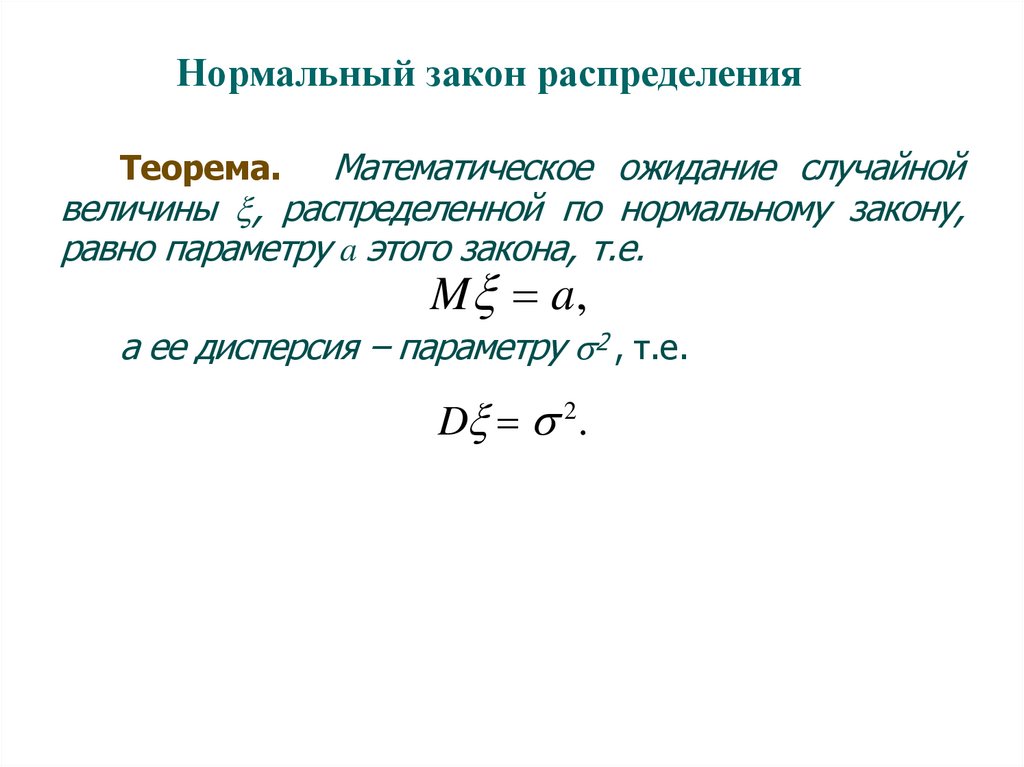

Нормальный закон распределенияМатематическое ожидание случайной

величины , распределенной по нормальному закону,

равно параметру a этого закона, т.е.

Теорема.

M a,

а ее дисперсия – параметру 2 , т.е.

D 2.

175.

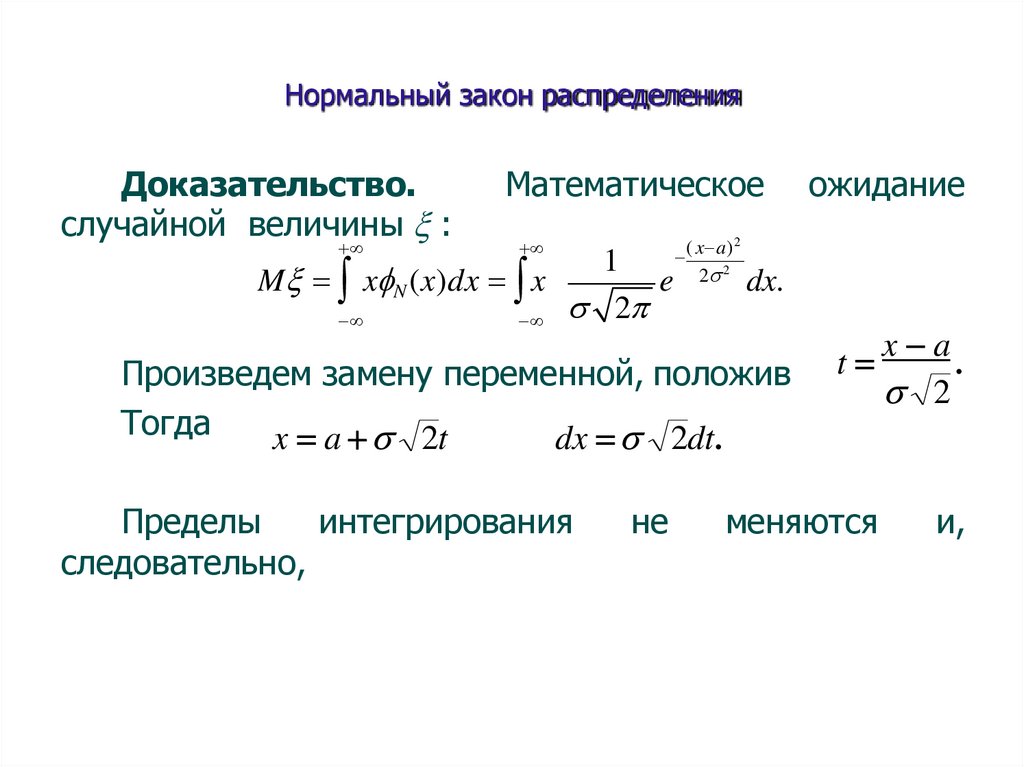

Нормальный закон распределенияДоказательство.

случайной величины :

Математическое

1

M x N (x)dx x

e

2

( x a) 2

2 2

dx.

t

x a

.

2

меняются

и,

Произведем замену переменной, положив

Тогда

x a 2t

dx 2dt.

Пределы

интегрирования

следовательно,

не

ожидание

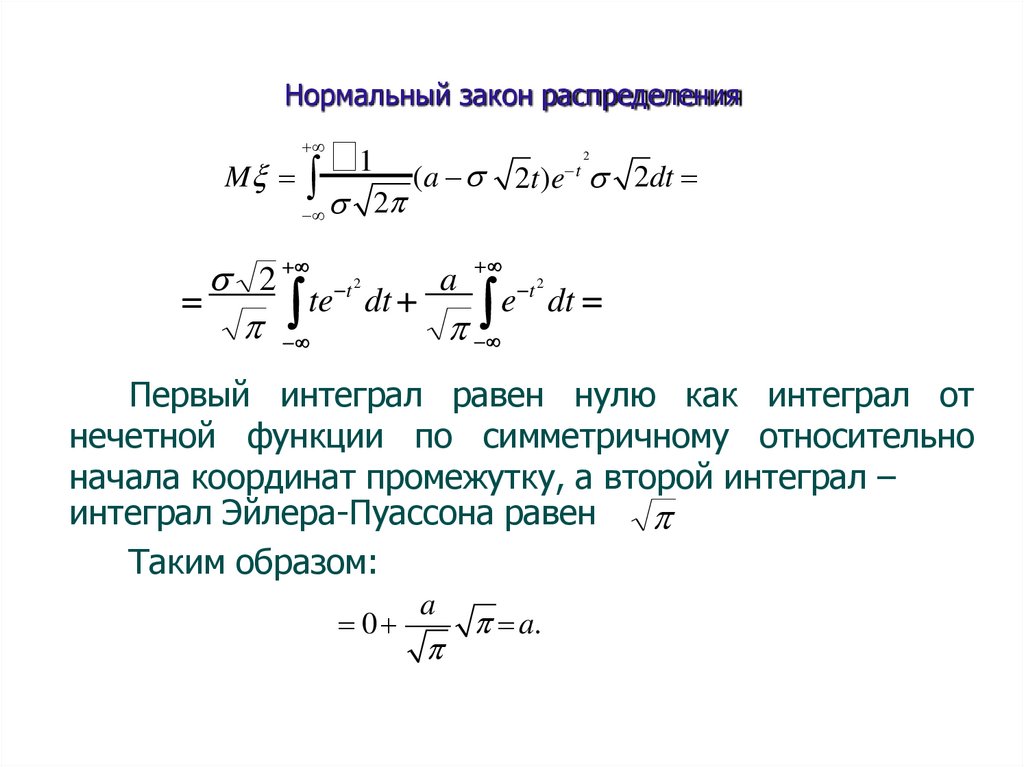

176.

Нормальный закон распределения1 (a 2t)e 2dt

M

2

t

2

a

2 t

t

te

dt

e

dt

2

2

Первый интеграл равен нулю как интеграл от

нечетной функции по симметричному относительно

начала координат промежутку, а второй интеграл –

интеграл Эйлера-Пуассона равен

Таким образом:

0

a

a.

177.

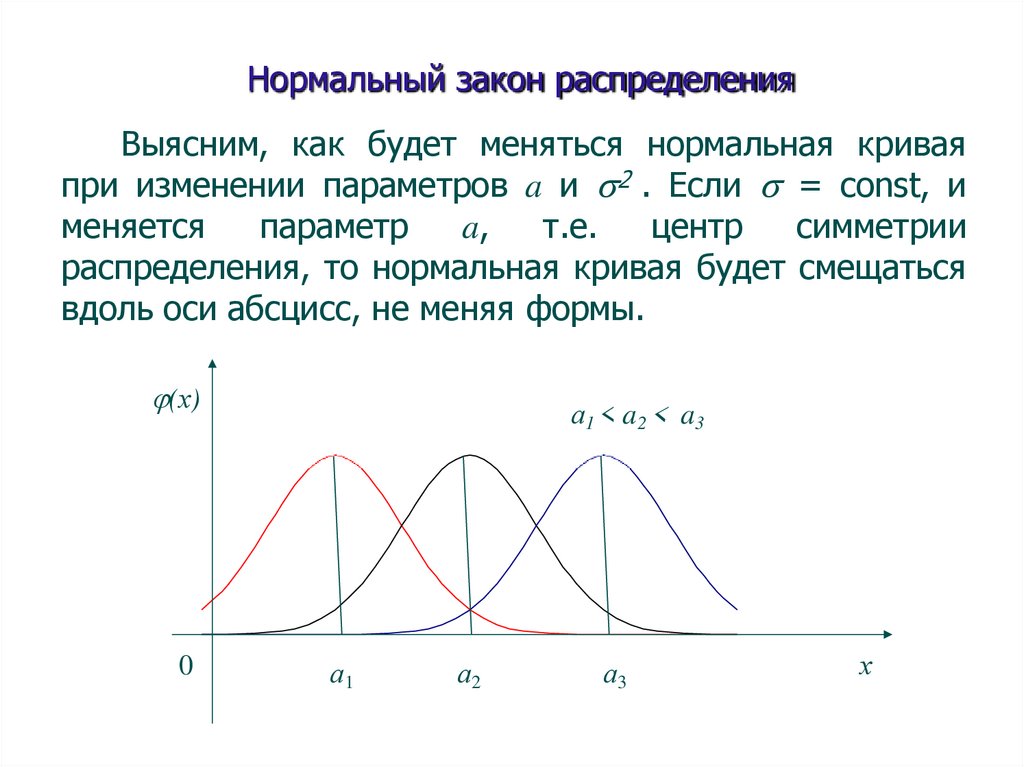

Нормальный закон распределенияВыясним, как будет меняться нормальная кривая

при изменении параметров a и 2 . Если = const, и

меняется

параметр

a,

т.е.

центр

симметрии

распределения, то нормальная кривая будет смещаться

вдоль оси абсцисс, не меняя формы.

(х)

0

а 1 < a 2 < a3

а1

а2

а3

х

178.

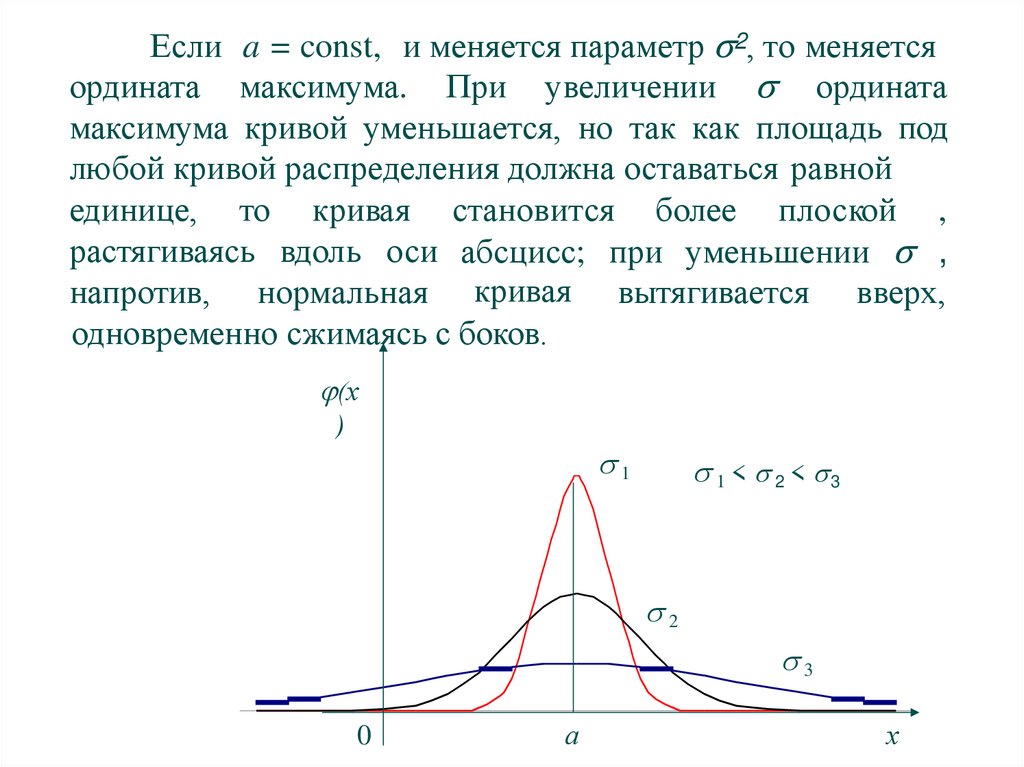

Если a = const, и меняется параметр 2, то меняетсяордината максимума. При увеличении ордината

максимума кривой уменьшается, но так как площадь под

любой кривой распределения должна оставаться равной

единице, то кривая становится более плоской ,

растягиваясь вдоль оси абсцисс; при уменьшении ,

напротив, нормальная кривая вытягивается вверх,

одновременно сжимаясь с боков.

(х

)

1

1 < 2 < 3

2

3

0

а

х

179.

Нормальный закон распределенияТаким

образом,

параметр

a

характеризует

положение, а параметр 2 – форму нормальной кривой.

Нормальный закон распределения случайной

величины с параметрами a = 0, 2 = 1 , т.е. N(0,1),

называется стандартным или нормированным, а

соответствующая нормальная кривая – стандартной или

нормированной.

180.

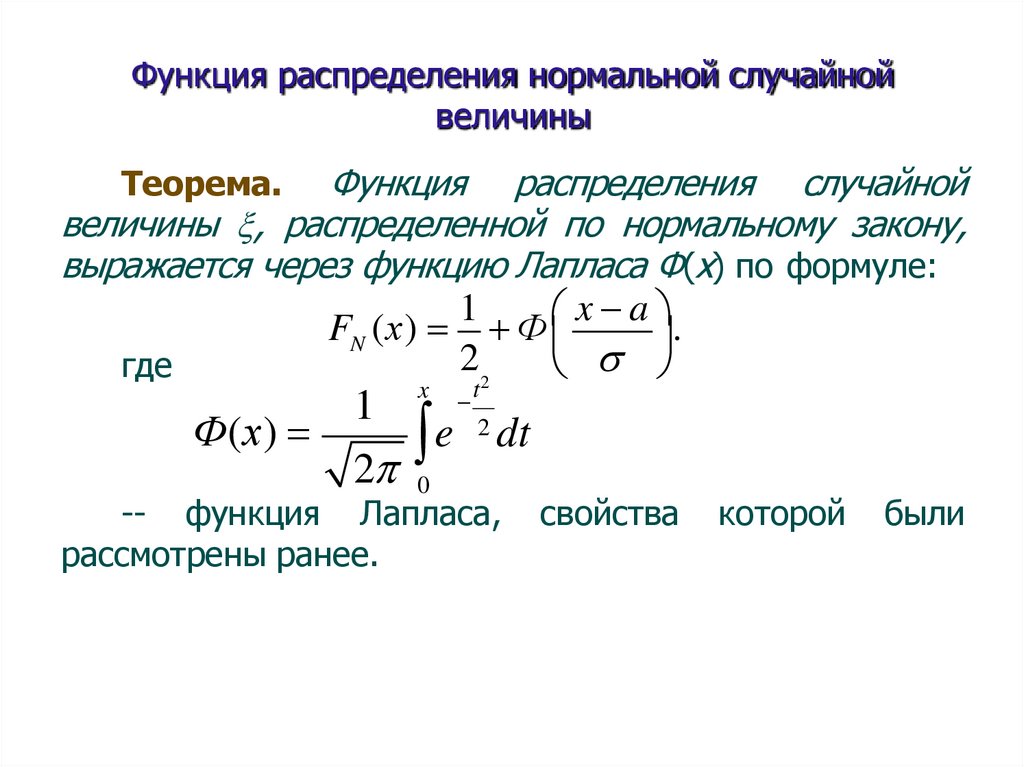

Функция распределения нормальной случайнойвеличины

Функция распределения случайной

величины , распределенной по нормальному закону,

выражается через функцию Лапласа Ф(х) по формуле:

1

x a

FN (х) Ф

.

22

где

Теорема.

x

t

1

2 dt

Ф(х)

e

2 0

-- функция Лапласа,

рассмотрены ранее.

свойства

которой

были

181.

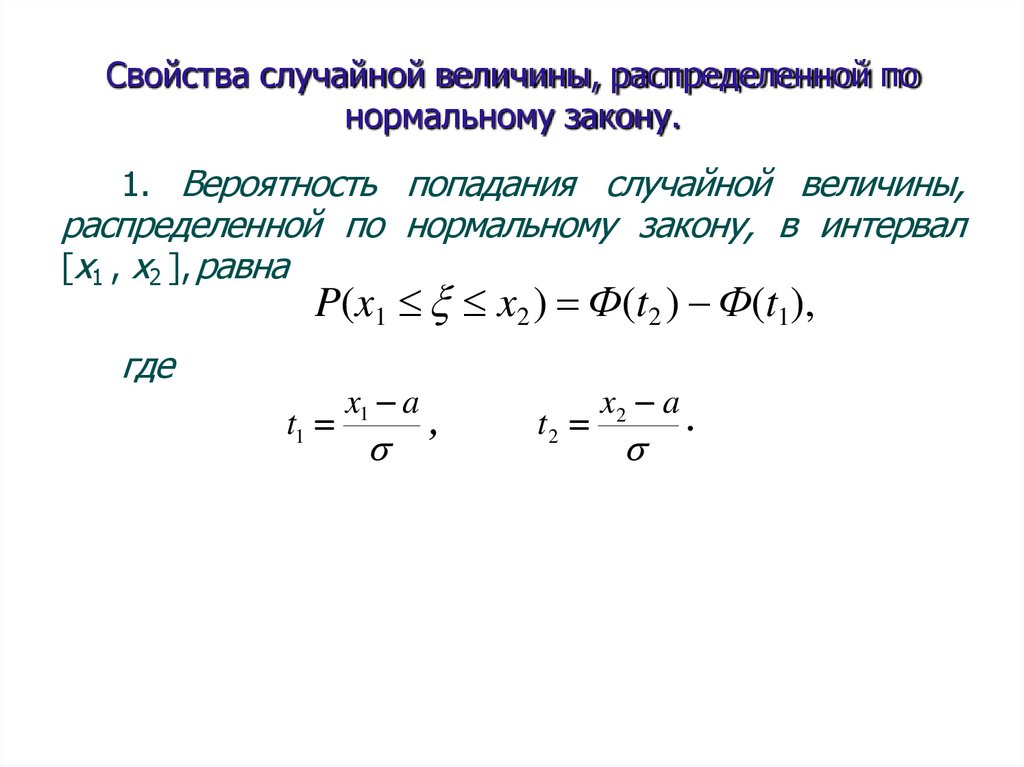

Свойства случайной величины, распределенной понормальному закону.

1. Вероятность попадания случайной величины,

распределенной по нормальному закону, в интервал

[x1 , x2 ], равна

P(x1 x2 ) Ф(t2 ) Ф(t1),

где

t1

x1 a

,

t2

x2 a

.

182.

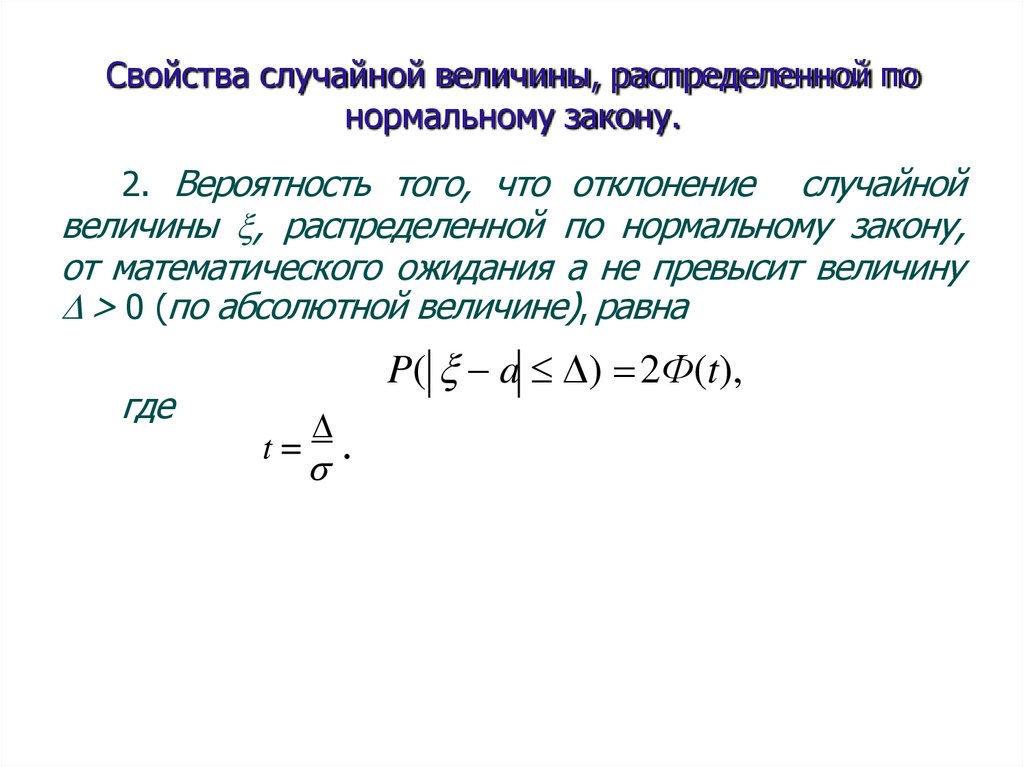

Свойства случайной величины, распределенной понормальному закону.

2. Вероятность того, что отклонение

случайной

величины , распределенной по нормальному закону,

от математического ожидания а не превысит величину

> 0 (по абсолютной величине), равна

где

P( a ) 2Ф(t),

t

.

183.

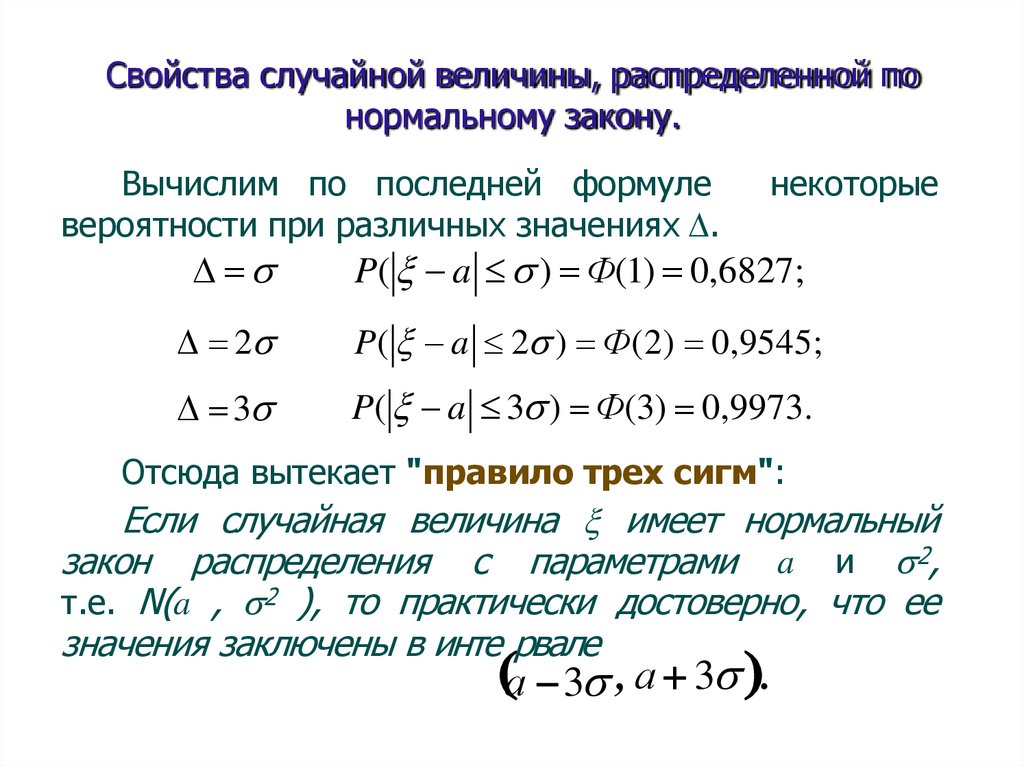

Свойства случайной величины, распределенной понормальному закону.

Вычислим по последней формуле

вероятности при различных значениях .

некоторые

P( a ) Ф(1) 0,6827;

2

P( a 2 ) Ф(2) 0,9545;

3

P( a 3 ) Ф(3) 0,9973.

Отсюда вытекает "правило трех сигм":

Если случайная величина имеет нормальный

закон распределения с параметрами a и 2,

т.е. N(a , 2 ), то практически достоверно, что ее

значения заключены в инте рвале

а 3 , а 3 .

184.

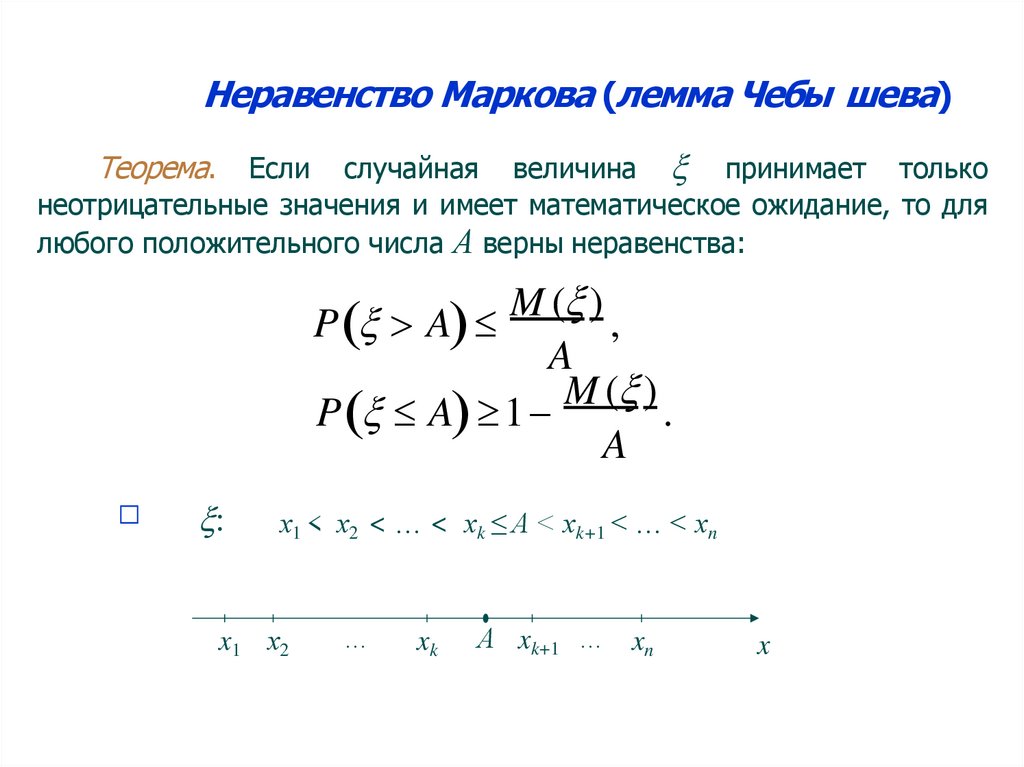

Неравенство Маркова (лемма Чебы шева)Если случайная величина принимает только

неотрицательные значения и имеет математическое ожидание, то для

любого положительного числа А верны неравенства:

Теорема.

M ( )

P A

,

A

M ( )

P A 1

.

A

□

:

х1 < х2 < … < хk ≤ A < хk+1 < … < хn

x1 х2

…

xk

А xk+1 … xn

x

185.

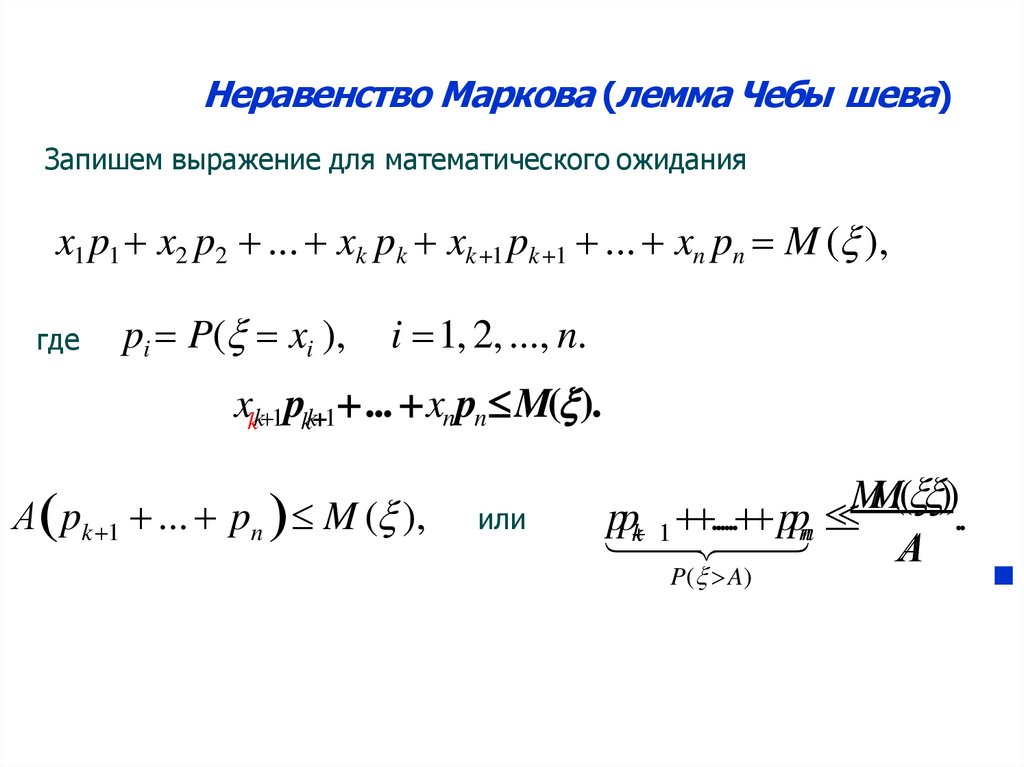

Неравенство Маркова (лемма Чебы шева)Запишем выражение для математического ожидания

x1 p1 x2 p2 ... xk pk xk 1 pk 1 ... xn pn M ( ),

где

pi P( xi ),

i 1, 2, ..., n.

xkk 1 pkk 1 ... xn pn M( ).

А pk 1 ... pn M ( ),

или

MM(( ))

pp ..... pp

..

k 1 nn

А

P( A)

■

186.

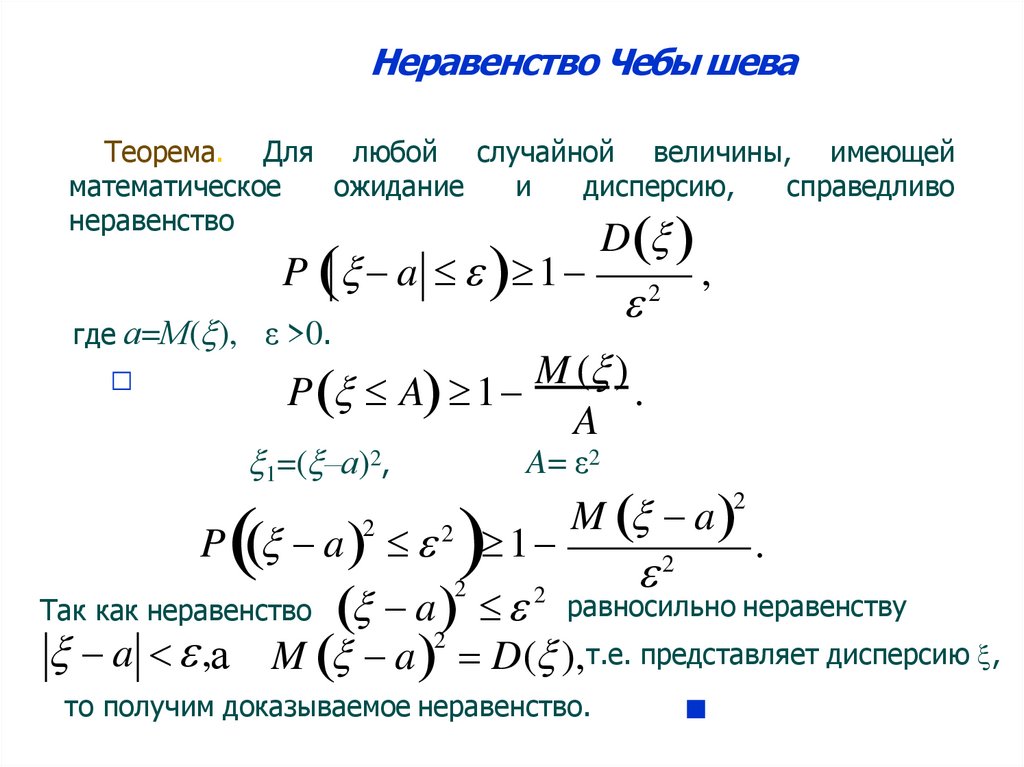

Неравенство Чебы шеваТеорема. Для любой случайной величины, имеющей

математическое

ожидание

и

дисперсию,

справедливо

неравенство

P a 1

где а=М( ), ε >0.

D

2

,

M ( )

P A 1

.

A

□

1=( –а)2,

P a

2

2

1

M a

2

2

.

a2 равносильно неравенству

M a D( ),т.е. представляет дисперсию ,

Так как неравенство

a ,а

A= ε2

2

2

то получим доказываемое неравенство.

■

187.

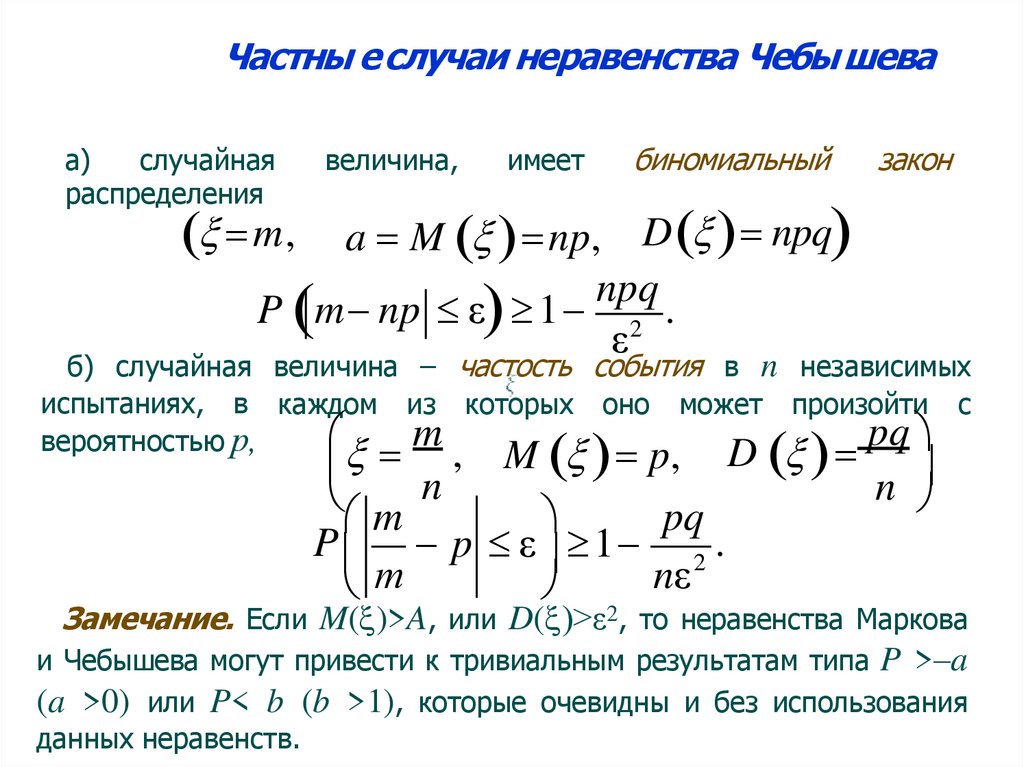

Частны е случаи неравенства Чебы шеваа)

случайная

распределения

величина,

имеет

биномиальный

закон

a M np, D npq

npq

P m np ε 1 2 .

ε

m,

б) случайная величина – частость события в n независимых

испытаниях, в каждом из которых оно может произойти с

pq

m

вероятностью р,

n , M p, D

n

m

pq

P p ε 1 2 .

nε

т

Замечание. Если M( )>A, или D( )>ε2, то неравенства Маркова

и Чебышева могут привести к тривиальным результатам типа P >–a

(a >0) или P< b (b >1), которые очевидны и без использования

данных неравенств.

188.

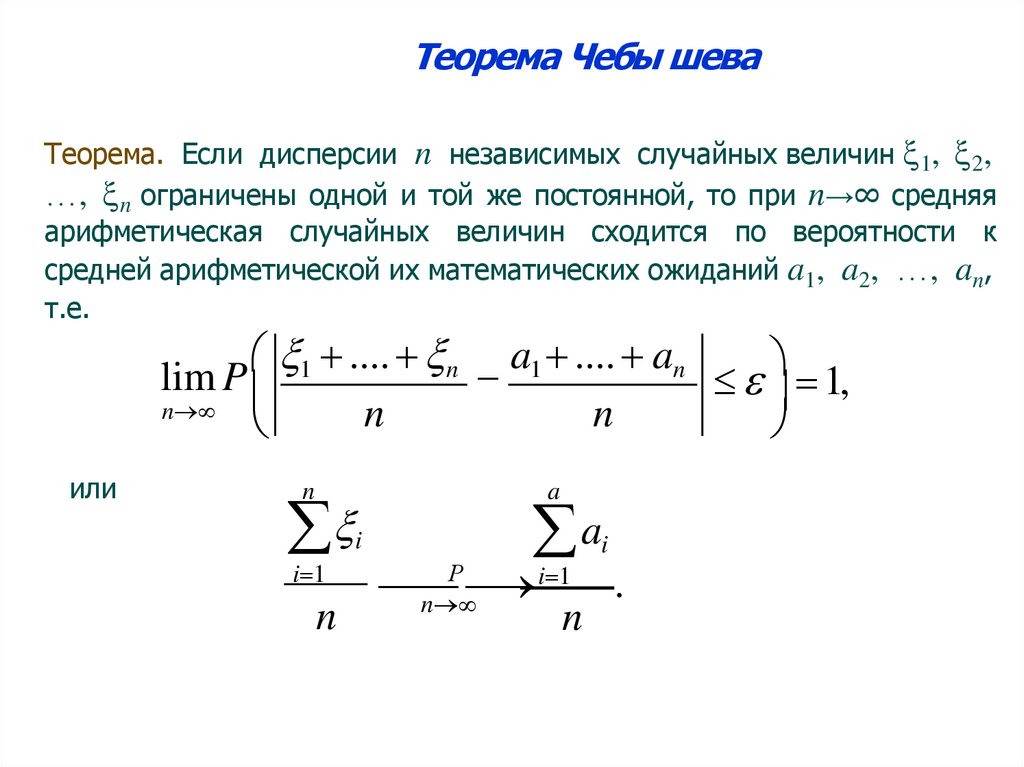

Теорема Чебы шеваТеорема. Если дисперсии n независимых случайных величин 1, 2,

…, n ограничены одной и той же постоянной, то при n→∞ средняя

арифметическая случайных величин сходится по вероятности к

средней арифметической их математических ожиданий a1, a2, …, an,

т.е.

1 .... n a1 .... an

lim P

1,

n

n

n

или

n

i

i 1

n

a

a

i

Р

i 1

.

n

n

189.

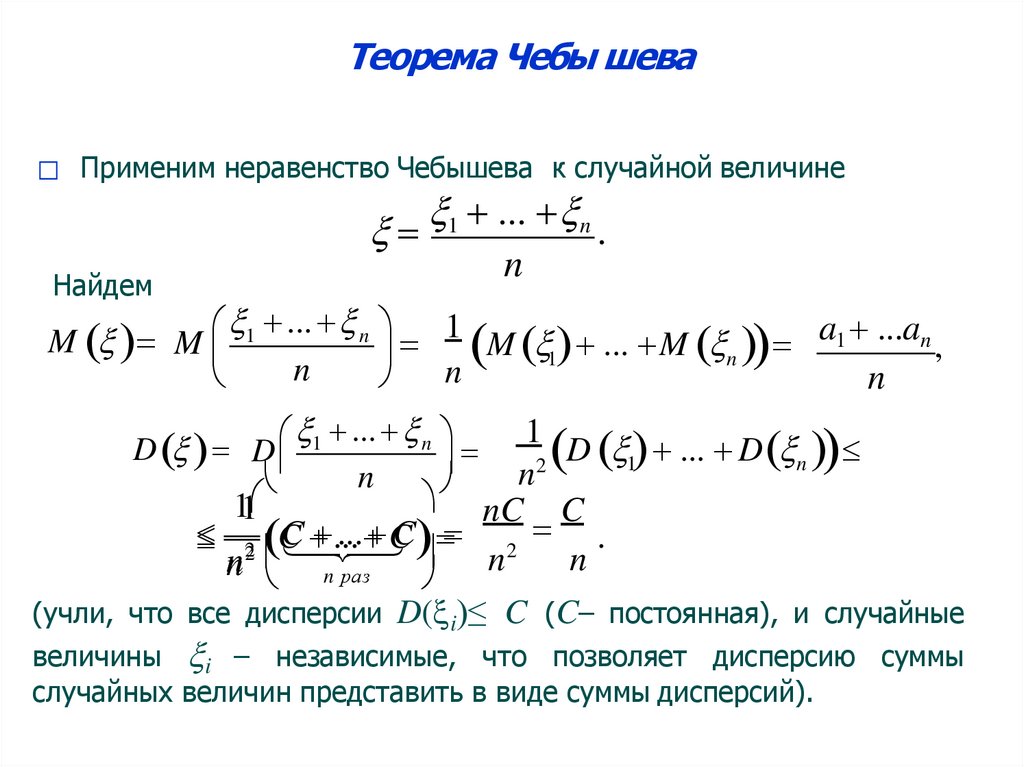

Теорема Чебы шева□ Применим неравенство Чебышева к случайной величине

1 ... n

.

n

Найдем

1 ... n 1

a1 ...an

M M

M

...

M

,

1

n

n

n

n

... n

D D 1

n

1

D ... D n

2 1

n

nC C

11

C

...

C 2 .

2 C

...

C

n

n

n n раз

(учли, что все дисперсии D( i)≤ C (C– постоянная), и случайные

величины i – независимые, что позволяет дисперсию суммы

случайных величин представить в виде суммы дисперсий).

190.

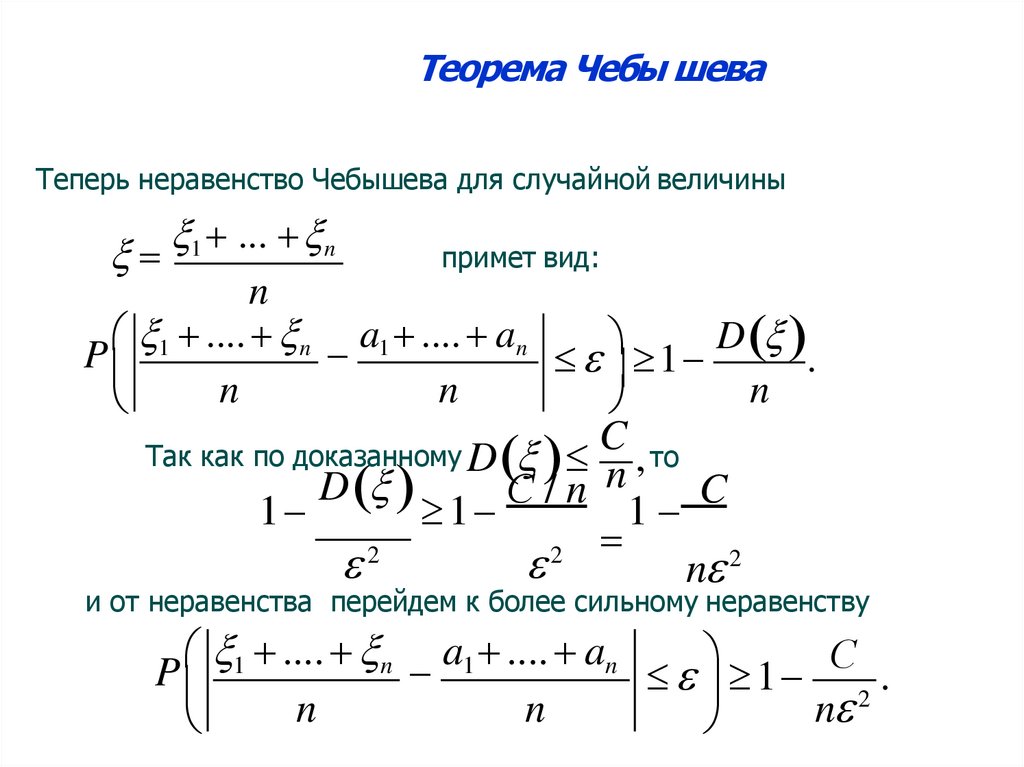

Теорема Чебы шеваТеперь неравенство Чебышева для случайной величины

1 ... n

примет вид:

n

.... n a1 .... an

D

P 1

1

.

n

n

n

C то

n ,

D

С/n

C

1

1

1

2

2

n 2

Так как по доказанному D

и от неравенства перейдем к более сильному неравенству

1 .... n a1 .... an

С

P

1 2 .

n

n

n

191.

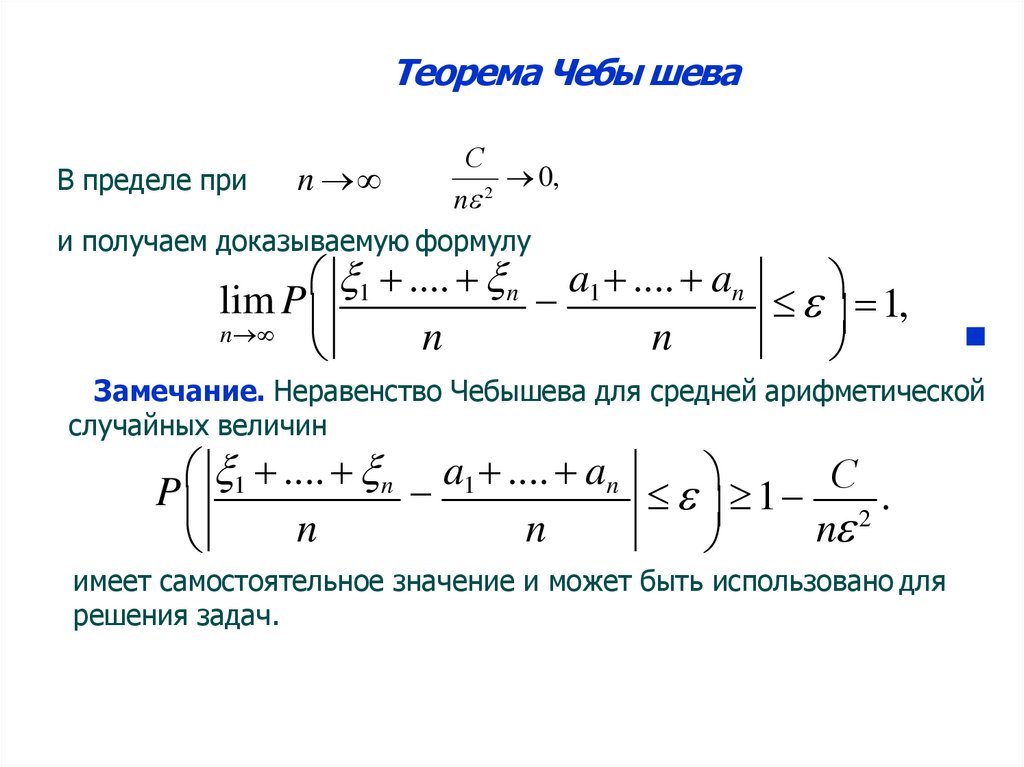

Теорема Чебы шеваС

0,

В пределе при

n

2

n

и получаем доказываемую формулу

1 .... n a1 .... an

lim P

1,

n

n

n

■

Замечание. Неравенство Чебышева для средней арифметической

случайных величин

.... n a1 .... an

С

P 1

1 2 .

n

n

n

имеет самостоятельное значение и может быть использовано для

решения задач.

192.

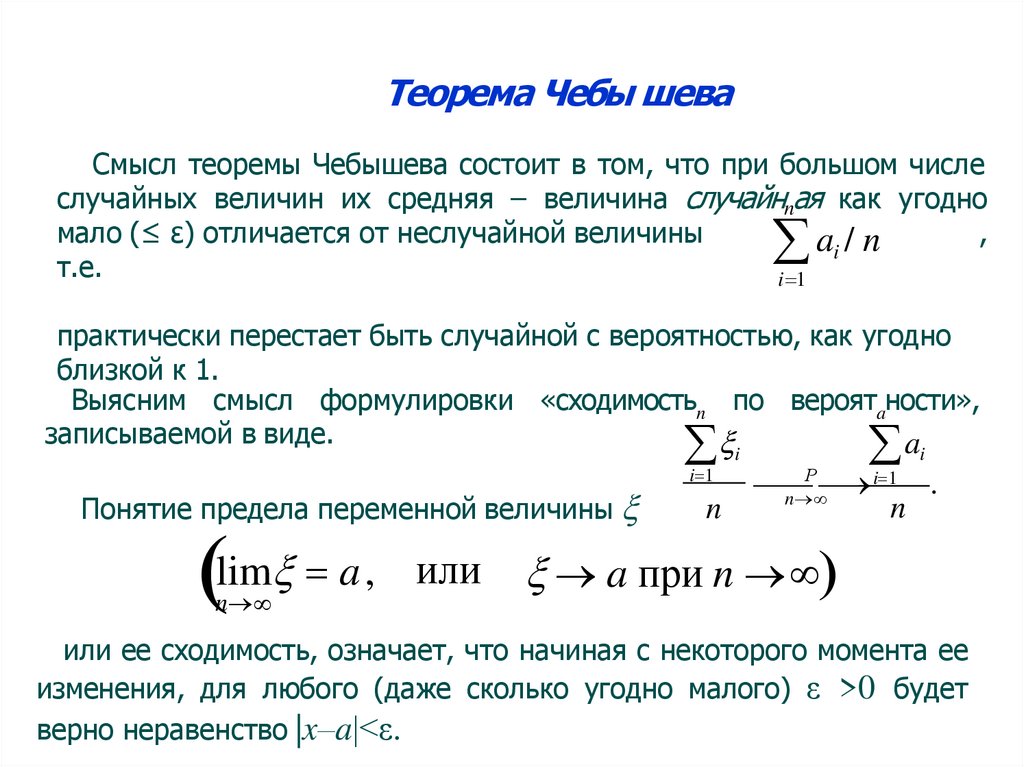

Теорема Чебы шеваСмысл теоремы Чебышева состоит в том, что при большом числе

случайных величин их средняя – величина случайнnая как угодно

мало (≤ ε) отличается от неслучайной величины

,

ai / n

т.е.

i 1

практически перестает быть случайной с вероятностью, как угодно

близкой к 1.

Выясним смысл формулировки «сходимостьn по вероятaности»,

записываемой в виде.

a

Понятие предела переменной величины

i 1

n

i

i

Р

i 1 .

n

n

lim a , или a при n

n

или ее сходимость, означает, что начиная с некоторого момента ее

изменения, для любого (даже сколько угодно малого) ε >0 будет

верно неравенство |x–a|<ε.

193.

Теорема Чебы шеваСходимость по вероятности

a ,

Р

n

означает, что неравенство |x–a|<ε, начиная с некоторого момента

изменения переменной , будет выполняться не в любом случае, но

почти всегда, в подавляющем числе случаев, т.е. с вероятностью,

сколь угодно близкой к 1 при n .

194.

Теорема Чебы шеваТеорема Чебышева имеет большое практическое значение.

Например, деятельность страховых компаний, расчеты страховых

взносов и премий основаны на том, что известные средние убытки

застрахованных лиц за прошедший период в силу закона больших

чисел практически не изменятся за период страхования.

В финансовом анализе дисперсия случайной величины –

доходности некоторого актива (акции, ценной бумаги) характеризует

его риск. Действие закона больших чисел проявляется в уменьшении

дисперсии средней случайных величин с ростом n.

Поэтому, например, увеличение числа ценных бумаг разного вида

приводит к снижению риска составленного из этих бумаг

инвестиционного портфеля. Отсюда следует один из принципов

работы

на

финансовом

рынке,

известный

как

принцип

диверсификации (разнообразия) и вполне согласующийся с

народной мудростью: «не клади все яйца в одну корзину».

195.

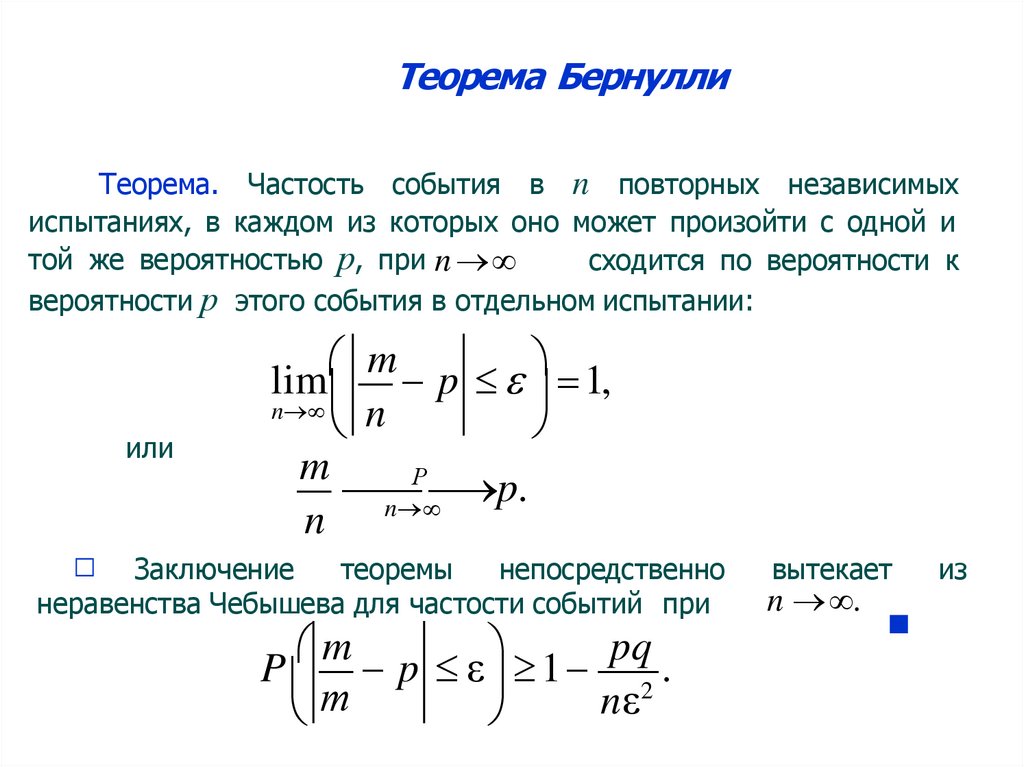

Теорема БернуллиТеорема. Частость события в n повторных независимых

испытаниях, в каждом из которых оно может произойти с одной и

той же вероятностью р, при n

сходится по вероятности к

вероятности р этого события в отдельном испытании:

или

□

m

lim p 1,

n

n

m

Р

p.

n

n

Заключение

теоремы

непосредственно

неравенства Чебышева для частости событий при

m

pq

P p ε 1 2 .

nε

т

вытекает

n .

■

из

196.

Теорема БернуллиСмысл теоремы Бернулли состоит в том, что частость m/n –

величина случайная при большом n как угодно мало отличается от

вероятности p – величины неслучайной, т.е. практически перестает

быть случайной с вероятностью, как угодно близкой к 1 при n .

Теорема

Бернулли,

являющаяся

следствием

теоремы

Чебышева, дает теоретическое обоснование замены неизвестной

вероятности

события

его

частостью,

или

статистической

вероятностью. Например, неизвестную вероятность рождения

мальчика в соответствии с этой теоремой можно заменить его

частостью, которая по многолетним данным составляет приближенно

0,515.

197.

Центральная предельная теорема – теоремаЛяпунова

Теорема. Если случайная величина представляет

собой сумму очень большого числа взаимно независимых

случайных величин i, i=1,2,3,...,n, имеющих конечные

математические ожидания и дисперсии, влияние каждой из

которых на всю сумму ничтожно мало, т.е. ни одна из

величин по своему значению резко не отличается от

остальных. то при неограниченном увеличении n

распределение

нормальному с

приближается к

ожиданием,

математическим

равным

сумме

математических ожиданий и дисперсией, равной сумме

дисперсий..

N M , D

198.

Центральная предельная теорема – теоремаЛяпунова

Согласно теореме Ляпунова, при решении многих

практических задач, связанных со случайной величиной ,

являющейся

средним

арифметическим

наблюдаемых

значений случайной величины , можно утверждать, что

среднеарифметическое значение сл.в. распределено по

нормальному закону:

N a, 2 / n

199.

Спасибо за внимание200.

Анализ данныхЛекция

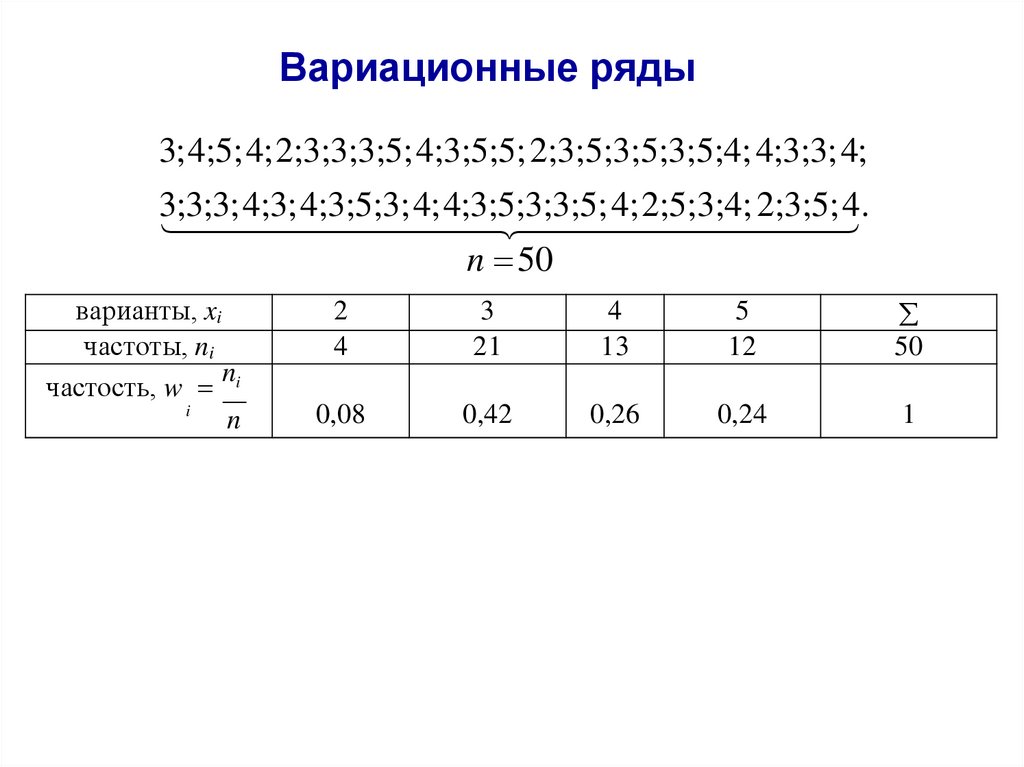

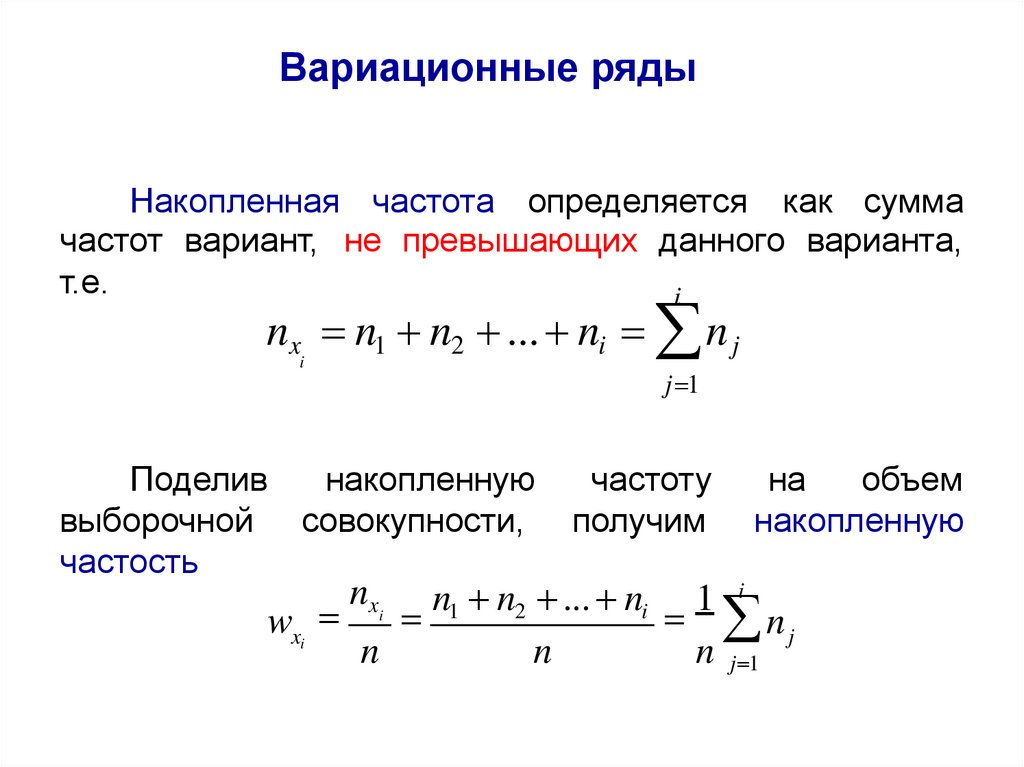

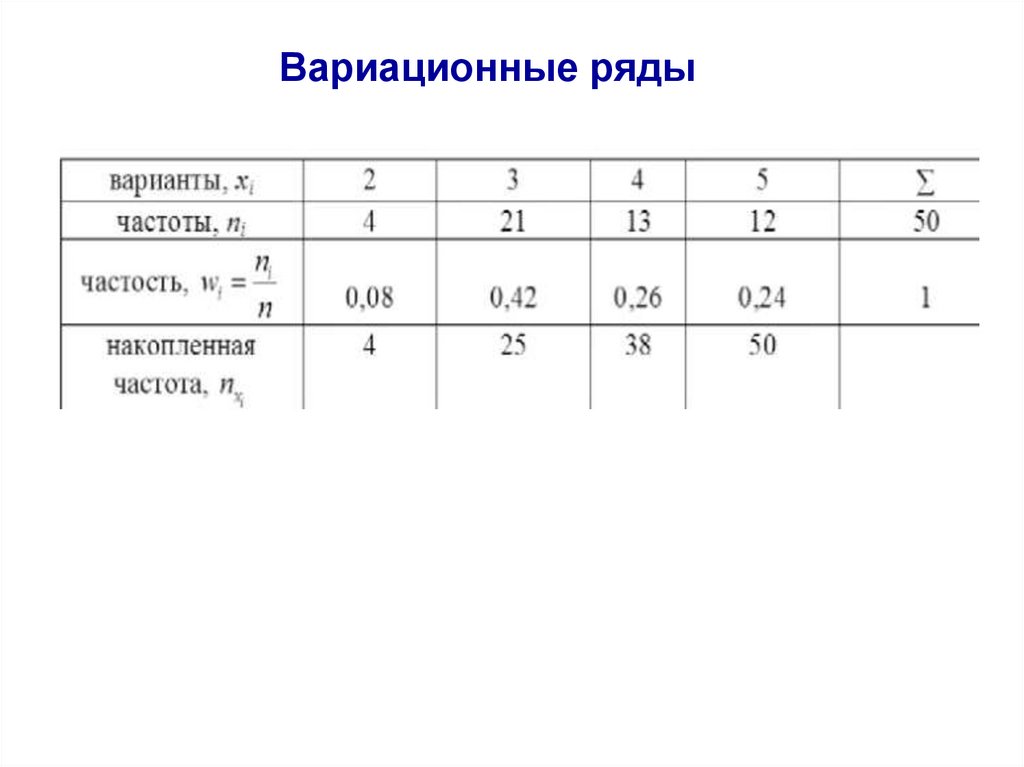

Генеральная совокупность и выборка.

Вариационные ряды и их графическое

представление

201.

Анализ данныхАвтор:

доцент департамента

«Анализа данных, принятия решений и финансовых технологий»

к.ф.-м.н.

Потемкин Александр Владимирович

Лекция 6

202.

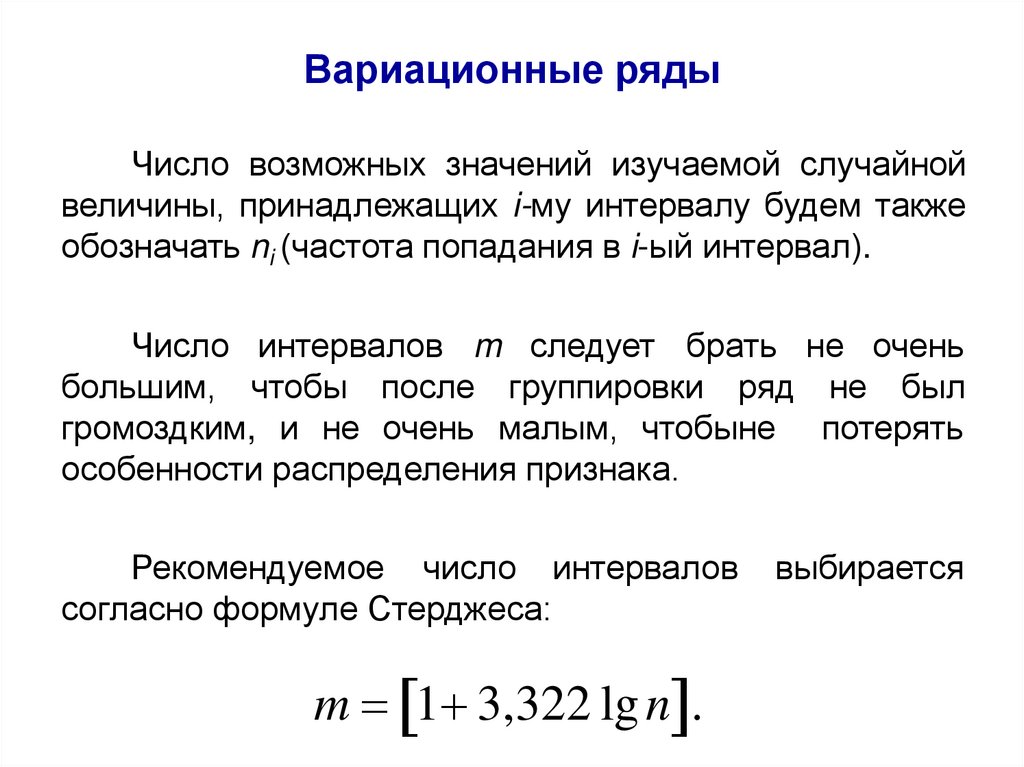

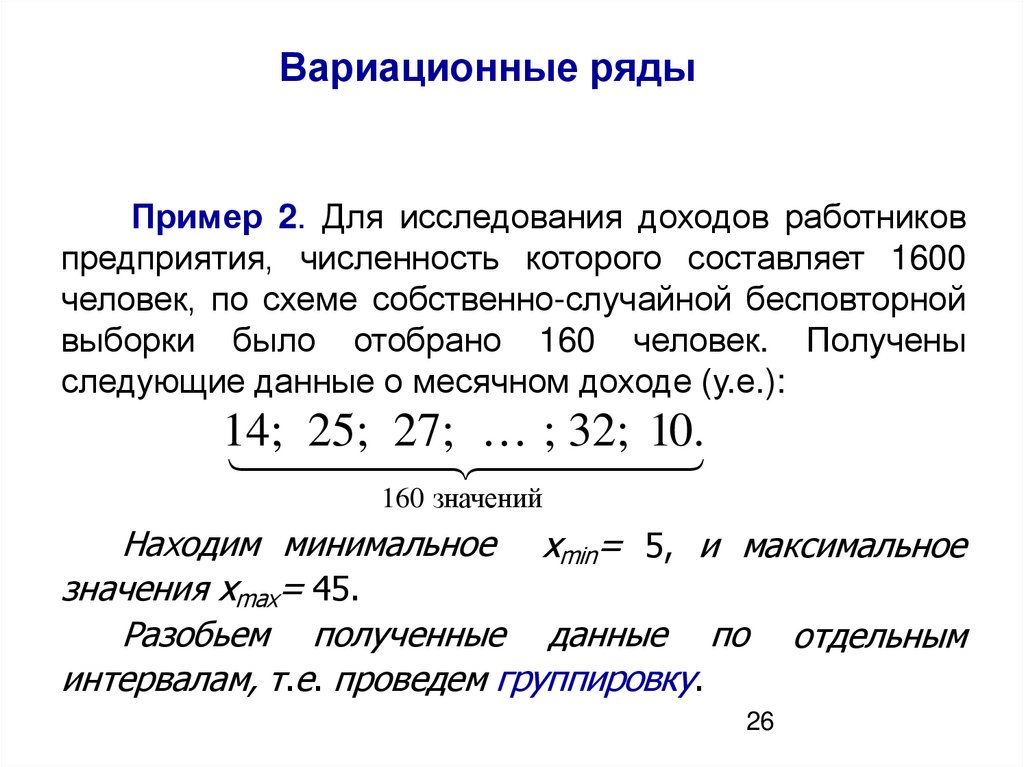

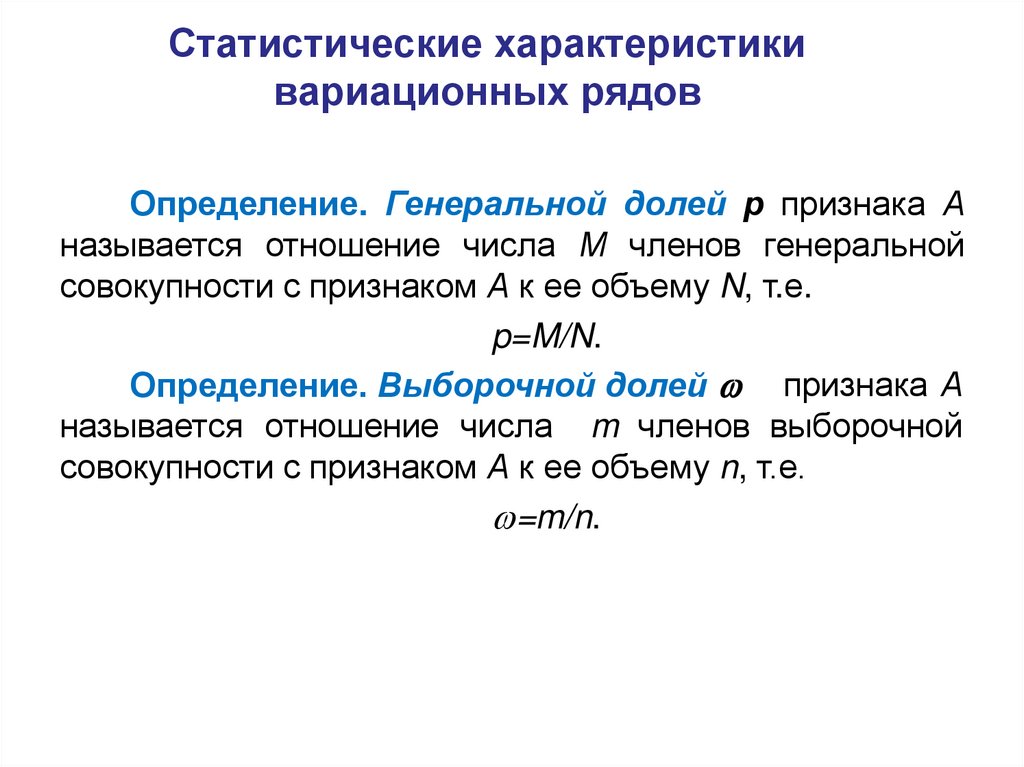

Генеральная совокупность ивыборка

Анализ данных – дисциплина, опирающаяся на

методы и модели, изучаемые в математической

статистике.

Математическая статистика – раздел математики,

тесно связанный с теорией вероятностей.

Статистика изучает методы сбора и анализа

результатов наблюдений массовых случайных явлений с

целью выявления существующих закономерностей.

203.

Генеральная совокупность ивыборка

Различие

между

теорией

вероятности

и

математической статистикой заключается в том, что

типичная задача теории вероятности – по известным

вероятностям простых случайных событий вычислить

вероятность более сложного события.

Типичная задача математической статистики – на

основании результатов наблюдений оценить вероятность

случайного события или характеристики случайной

величины.

Для

осуществления

последнего

широко

используются выборочные методы.

204.

Генеральная совокупность ивыборка

Выборочные методы анализа данных являются

одной из составных частей математической статистики,

предметом которой является изучение совокупности

однородных

объектов

относительно

некоторого

качественного

или

количественного

признака,

характеризующего

эти

объекты

по

результатам

наблюдений.

совокупностью

Определение.

Генеральной

называют совокупность всех мысленно возможных

объектов данного вида,

над которыми проводятся

наблюдения.

205.

Генеральная совокупность ивыборка

В практике статистических обследований различают

два вида наблюдений:

сплошное, когда изучаются все объекты генеральной

совокупности относительно некоторого признака;

не сплошное (или выборочное), когда изучается только

часть объектов (выборочный метод) генеральной

совокупности.

Определение. Выборочной совокупностью, или

просто выборкой, называют совокупность случайно

отобранных объектов из генеральной совокупности.

206.

Генеральная совокупность ивыборка

Объемом

совокупности

(выборочной

генеральной)

называют

число

объектов

совокупности:

N – объем генеральной совокупности;

n – объем выборочной совокупности.

Предполагается, что N>n.

или

этой

Генеральная совокупность может

конечной, так и бесконечной ( N ).

как

быть

207.

Генеральная совокупность ивыборка

Суть выборочного метода состоит в том, чтобы

по некоторой части генеральной совокупности

(выборке) выносить суждения о ее свойствах в целом.

Для того, чтобы по выборке можно было

достаточно уверенно судить об изучаемой случайной

величине, выборка должна быть репрезентативной

(или представительной).

Репрезентативность

выборки

означает,

что

объекты выборки достаточно хорошо представляют

генеральную совокупность.

208.

Генеральная совокупность ивыборка

Репрезентативность

выборки

обеспечивается

выполнением трех требований: