Similar presentations:

Презентація прикладів рішення задач по курсу ОТПІ

1. Презентація прикладів рішення задач по курсу ОТПІ

2. Задача №1

Відомо, що одне з рівноімовірнисних можливих повідомлень несе6 біти інформації. Із скількох якісних признаків m складається

алфавіт, якщо число можливих комбінацій повідомлення N = 128?

Розвязок:

В умові задачі навмисно введена помилка, бо при 6 біт інформації

число можливих комбінацій повідомлення буде 64. Тому одне рівноІмовірносне можливе повідомлення має нести 7 бітів інформації. В цьому випадку правильне рішення буде:

Розв'язок : N = mn ; 128 = m7 ; тобто m = 2, так як I = log2 N =

Log2 128 = 7 може бути тільки у випадку, якщо N = mn = 27

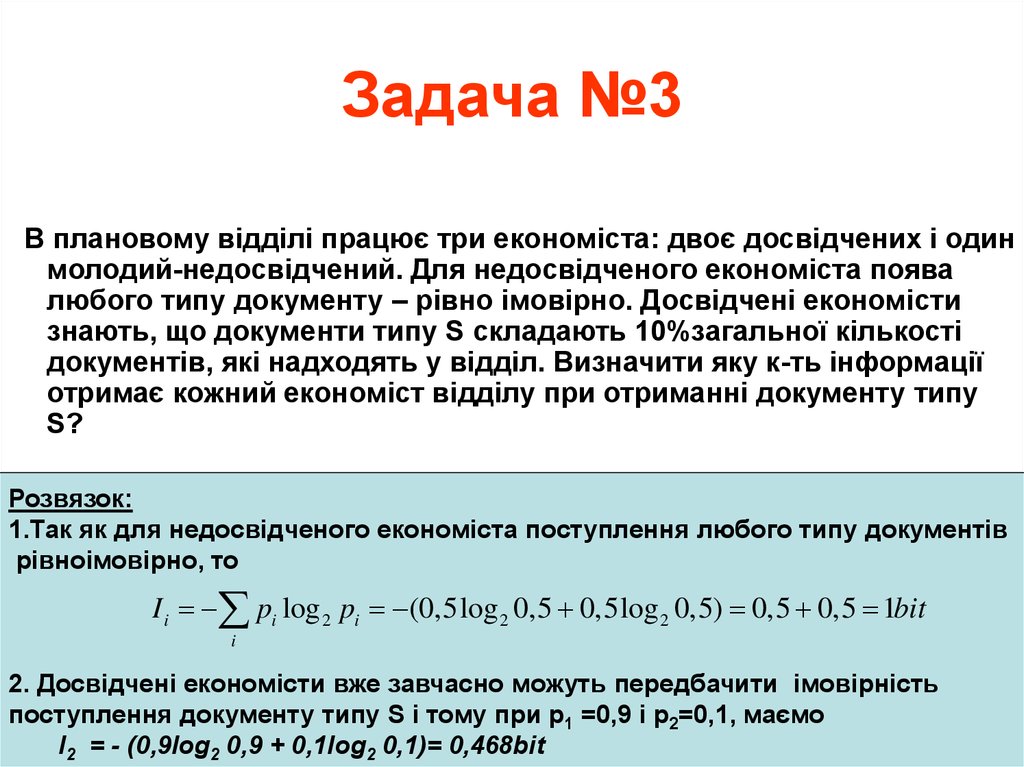

3. Задача №3

В плановому відділі працює три економіста: двоє досвідчених і одинмолодий-недосвідчений. Для недосвідченого економіста поява

любого типу документу – рівно імовірно. Досвідчені економісти

знають, що документи типу S складають 10%загальної кількості

документів, які надходять у відділ. Визначити яку к-ть інформації

отримає кожний економіст відділу при отриманні документу типу

S?

Розвязок:

1.Так як для недосвідченого економіста поступлення любого типу документів

рівноімовірно, то

I i pi log 2 pi (0,5log 2 0,5 0,5log 2 0,5) 0,5 0,5 1bit

i

2. Досвідчені економісти вже завчасно можуть передбачити імовірність

поступлення документу типу S і тому при р1 =0,9 і р2=0,1, маємо

І2 = - (0,9log2 0,9 + 0,1log2 0,1)= 0,468bit

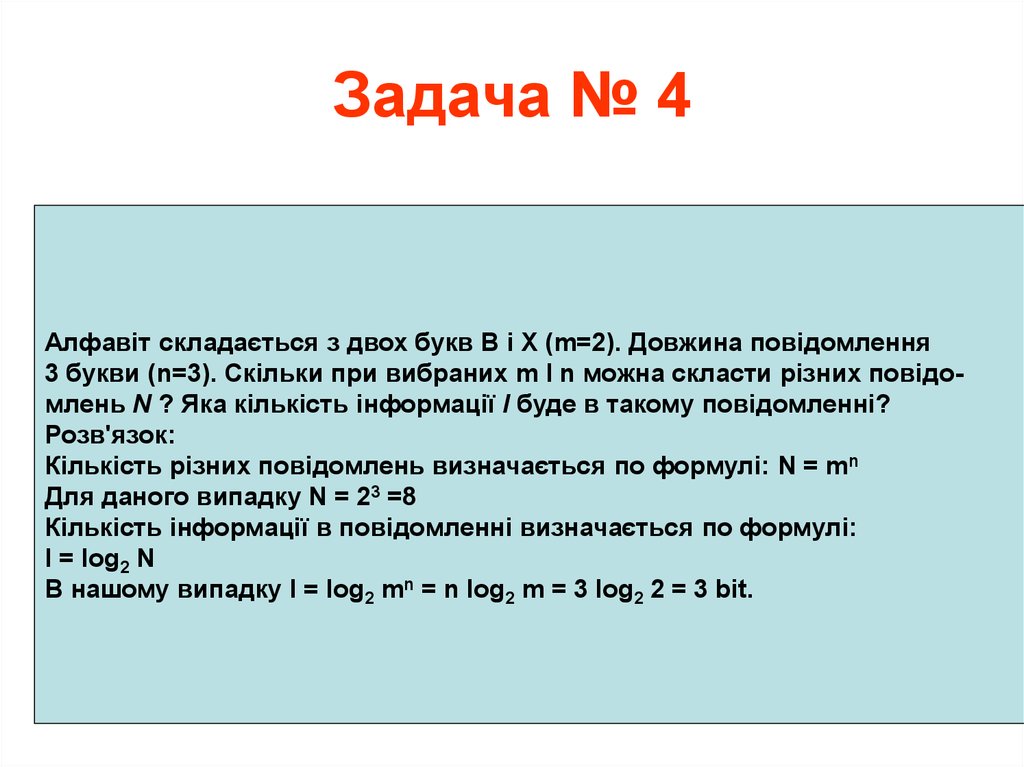

4. Задача № 4

Алфавіт складається з двох букв В і Х (m=2). Довжина повідомлення3 букви (n=3). Скільки при вибраних m I n можна скласти різних повідомлень N ? Яка кількість інформації I буде в такому повідомленні?

Розв'язок:

Кількість різних повідомлень визначається по формулі: N = mn

Для даного випадку N = 23 =8

Кількість інформації в повідомленні визначається по формулі:

I = log2 N

В нашому випадку І = log2 mn = n log2 m = 3 log2 2 = 3 bit.

5. Задача № 20

Скільки питань типу "так" або "ні", тобто бітів інформації, треба задати людині, яка задумала число в межах від 1 до 100 ( N=100), використовуючи самийоптимальний спосіб знаходження невідомого числа "Ділення пополам". Для

вирішення задачі використати формулу Р.Хартлі, врахувавши, що кількість

інформації, яка закладена в відповіді "так" / "ні", рівна одному біту.

Розв'язок:

Кількість інформації I необхідної для визначення конкретного елемента, є

логарифм по основі 2 від загальної кількості елементів N, тобто

I = log2 N = log2 100 = lg100/lg2 =6,66 bit ~ 7 bit.

Другими словами треба задати 7 питань типу "так" або "ні", щоб знайти

задумане число

ПРИКЛАД ДЛЯ ДІАЛОГУ, щоб знайти невідоме задумане число

від 1 до 100. Хай задумане число буде 27:

Використовуючи метод "Ділення пополам", задаємо питання

Задумане число більше 50 – НІ. Задумане число більше 25 – ТАК. Задумане

число більше 38 – НІ задумане число менше 32 – ТАК. Задумане число

менше 29 – ТАК. Задумане число більше 27 – НІ. Це число 26 – НІ. Значить,

якщо це число не 26 і не більше 27, то це число - 27. Що би визначити задумане число методом "Ділення пополам". нам потрібно було задати 7 питань,

які мають 7 біт інформації.

6. Задача №27

Повідомлення передається вісімковим алфавітом m = 8 по 4 символи(n = 4) в повідомленні. Всього передано 10 повідомлень (k=10). Яка

кількість інформації буде передана в цих повідомленнях?

Розв'язок:

К-ть інформації в одному повідомленні I = n log2 m. Одночасно в К повідомленнях буде I = k n log2 m інформації: I = 10·4·log2 8 = 120 bit

7. Задача №32

В алфавіті три букви А, В, С. ( m = 3 ) 1.Складіть максимальну кількістьповідомлень N комбінуючи по 3 букви (n=3) в повідомленні.

2.Яка к-ть інформації припадає на одне таке повідомлення?

Розв'язок:

1. m = 3: n =3: N = mn =33 =27; 2. I = log2 N = log2 27 = 4,75489 bit

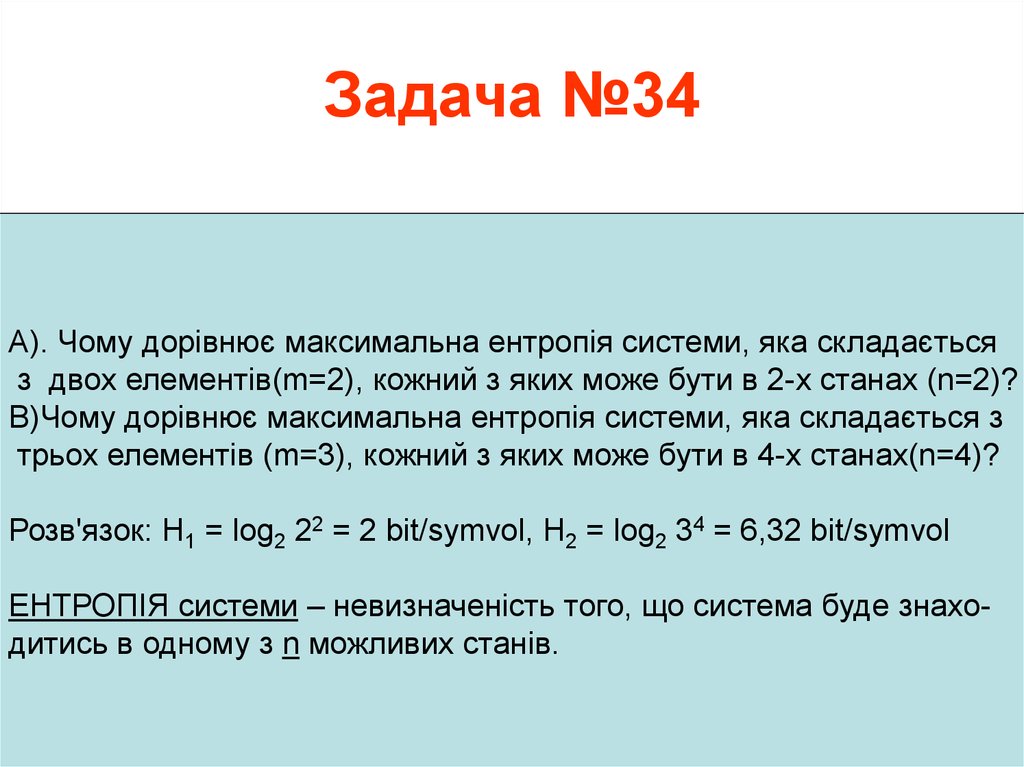

8. Задача №34

А). Чому дорівнює максимальна ентропія системи, яка складаєтьсяз двох елементів(m=2), кожний з яких може бути в 2-х станах (n=2)?

В)Чому дорівнює максимальна ентропія системи, яка складається з

трьох елементів (m=3), кожний з яких може бути в 4-х станах(n=4)?

Розв'язок: H1 = log2 22 = 2 bit/symvol, H2 = log2 34 = 6,32 bit/symvol

ЕНТРОПІЯ системи – невизначеність того, що система буде знаходитись в одному з n можливих станів.

9. Задача №42

Визначити, скільки необхідно способів, щоби передати положенняфігур на шаховій дошці? Чому дорівнює к-ть Інформації в кожному

випадку?

Розв'язок №1: Можна пронумерувати всі клітинки шахматної дошки і

передати номер клітинки. Для цього буде потрібно 64 якісних признаків (m=64), але для передачі номера клітинки достатньо буде

одного повідомлення (n=1). При цьому к-ть інформації буде

I = nlog2 m = 1·log2 64 = 6 bit

Розв'язок №2: Вказати на дошці необхідну клітинку можна також,

якщо передати координати по горизонталі і вертикалі. Для цього

достатньо восьми (m=8) якісних при знаків (вісім номерів по горизонталі і вісім по вертикалі). Але тепер треба передати два повідомлення

(n=2). При цьому к-ть переданої інформації буде

I = nlog2 m = 2·log2 8 = 6 bit

Розв'язок №3

???

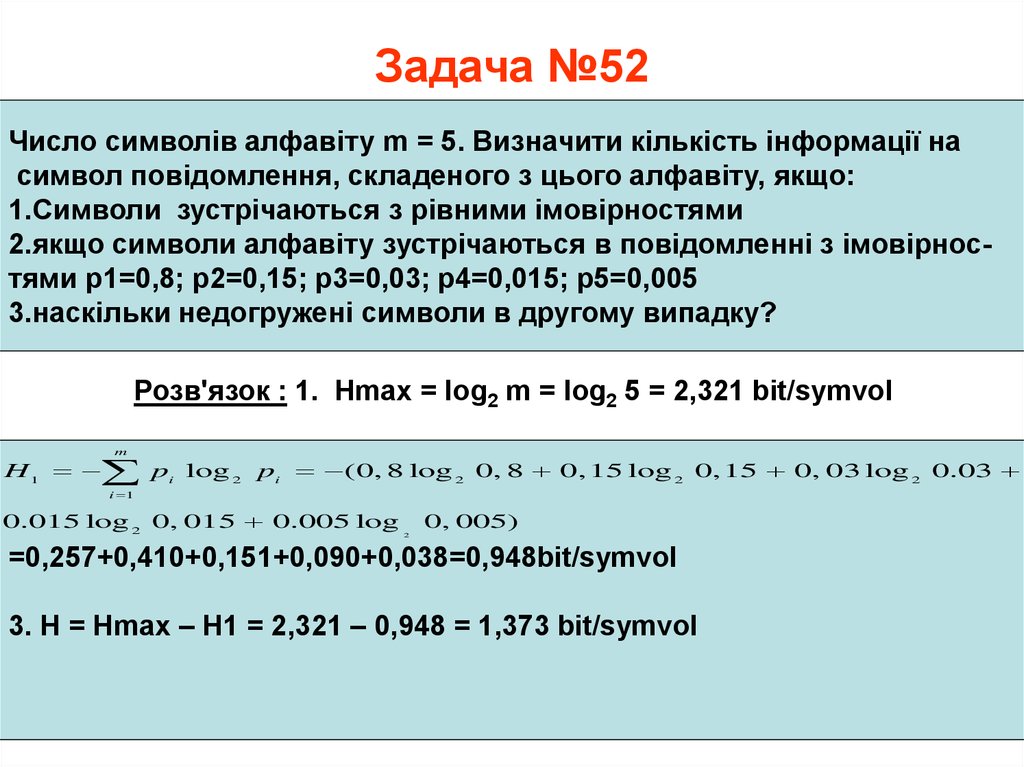

10. Задача №52

Число символів алфавіту m = 5. Визначити кількість інформації насимвол повідомлення, складеного з цього алфавіту, якщо:

1.Символи зустрічаються з рівними імовірностями

2.якщо символи алфавіту зустрічаються в повідомленні з імовірностями р1=0,8; р2=0,15; р3=0,03; р4=0,015; р5=0,005

3.наскільки недогружені символи в другому випадку?

Розв'язок : 1. Hmax = log2 m = log2 5 = 2,321 bit/symvol

m

H 1 pi log 2 pi (0, 8 log 2 0, 8 0, 15 log 2 0, 15 0, 03 log 2 0.03

i 1

0.015 log 2 0, 015 0.005 log

0, 005)

2

=0,257+0,410+0,151+0,090+0,038=0,948bit/symvol

3. H = Hmax – H1 = 2,321 – 0,948 = 1,373 bit/symvol

11. Задача №63

В повідомленні, яке складено з 5-ти признаків (m=5),і які використовуютьсяз різною імовірністю, що дорівнює р1=0.7;р2=0,2;р3=0.08;р4=0,015;р5=0,005

Всього в повідомленні прийнято 20 знаків (n=20). Визначити к-ть інформації у всьому повідомленні.

Яка к-ть інформації в даному повідомленні, якщо поява всіх знаків має рівну

імовірність?

Розв'язок:

1.К-ть інформації в повідомленні з різною імовірністю:

m

I1 n pi log 2 pi

i 1

20(0,36 0,464 0,291 0,09 0,038) 24,9bit

2.Ентропія на один символ Н1=24,9:20 = 2,32 біт/символ

3.К-ть інформації в m признаках І2 = 20 log2 m=20·2,32=46,4bit

4.Ентропія цього повідомлення Н2= log2 m=2,32 біт

12. Задача №64

За 2008 рік на Львівській залізниці магніто-динамічним методом було виявлено біля 160 дефектних і гостродефектних рейок з дефектами по кодам 10, 11,14, 17, 21,22, 30.

1. З усіх виявлених дефектних рейок,як показав аналіз, Імовірності появи

дефектів по коду 10 складала 0,39, по коду 11 – 0,18, по коду 14 – 0,24 і по

коду 17 – 0,18

Треба знайти математичне сподівання і дисперсію появи цих дефектів

informatics

informatics