Similar presentations:

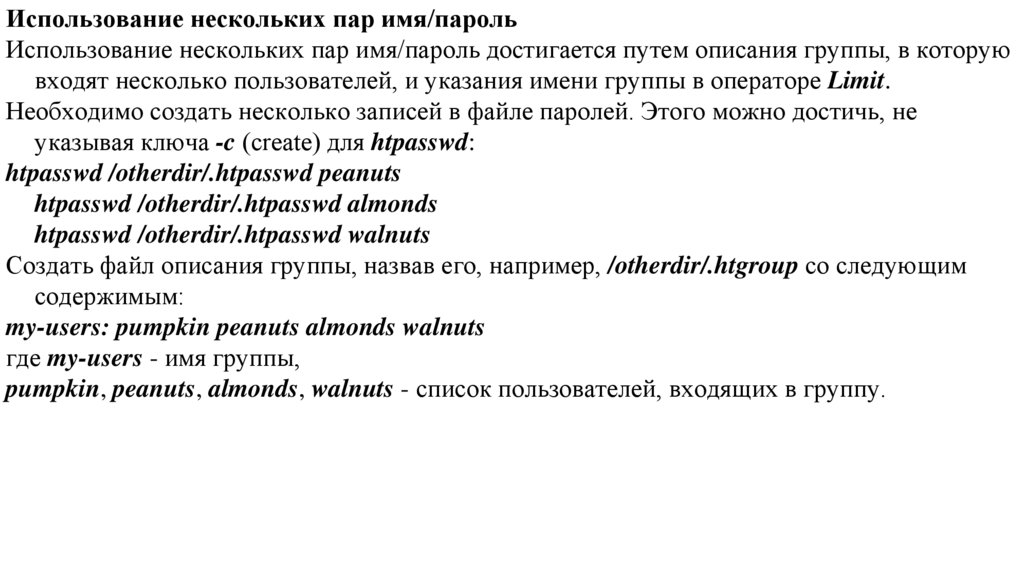

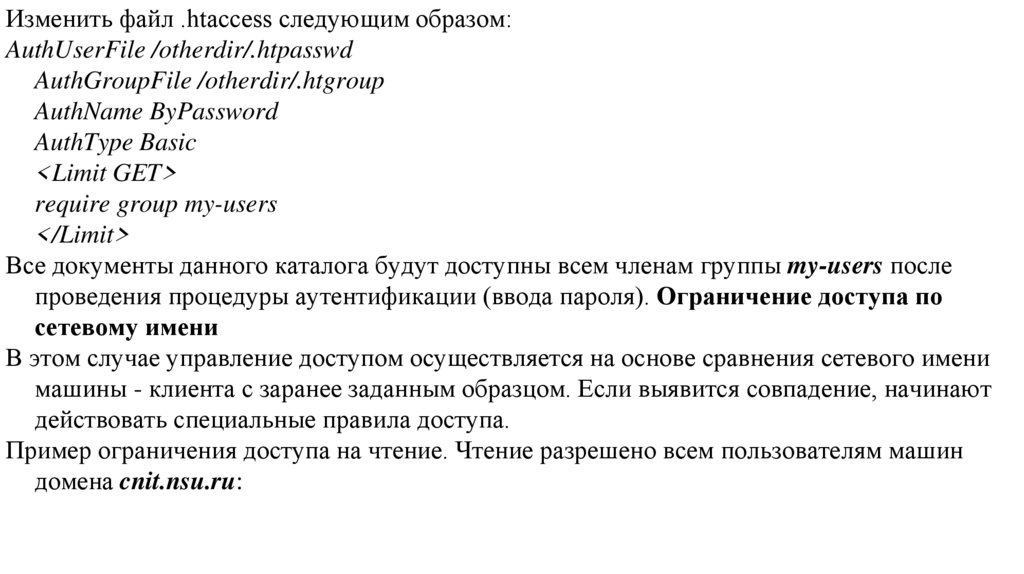

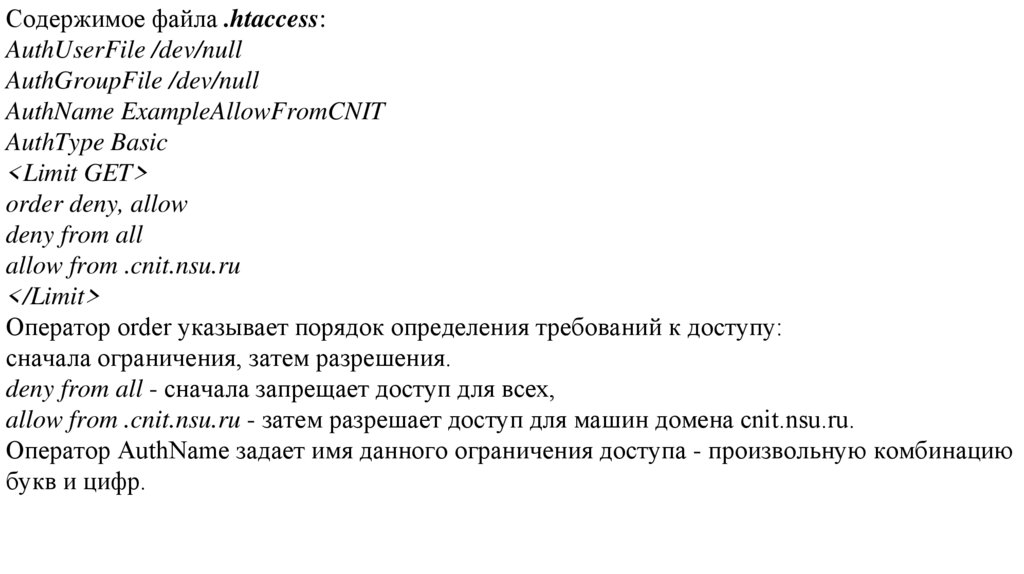

Реляционная модель

1.

2.

Реляционная модель предоставляет средства описания данных на основе только ихестественной структуры, т.е. без потребности введения какой-либо дополнительной

структуры для целей машинного представления. Соответственно, эта модель обеспечивает

основу языка данных высокого уровня, который поддерживает максимальную

независимость программ, с одной стороны, и машинного представления и организации

данных с другой.

Преимуществом реляционного представления является также то, что оно образует

надежную основу для решения проблем порождаемости, избыточности и согласованности

отношений

С другой стороны, сетевая модель привела к возникновению ряда недоразумений, не

последним из которых является ошибочное образование связей при образовании

отношений

3.

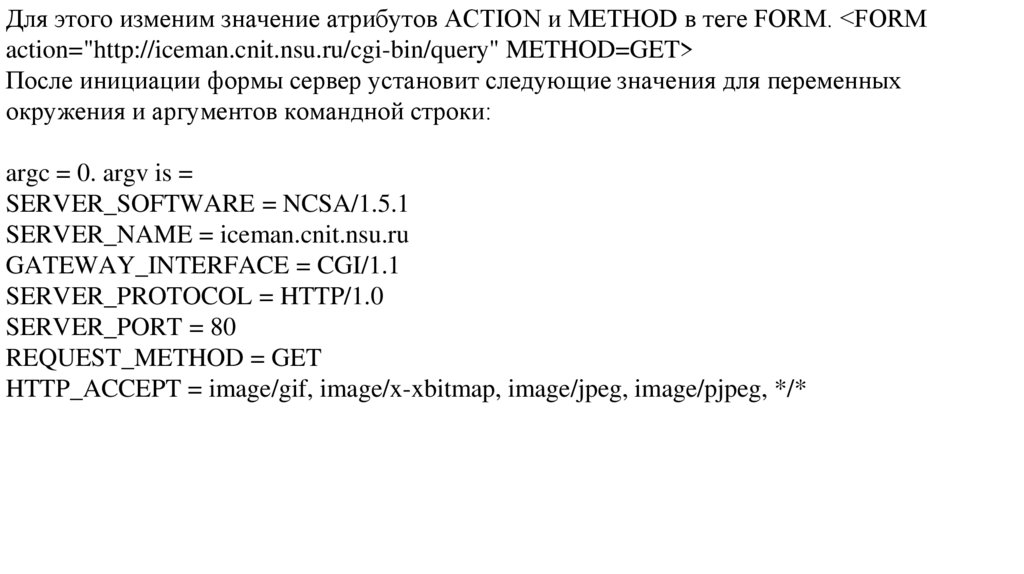

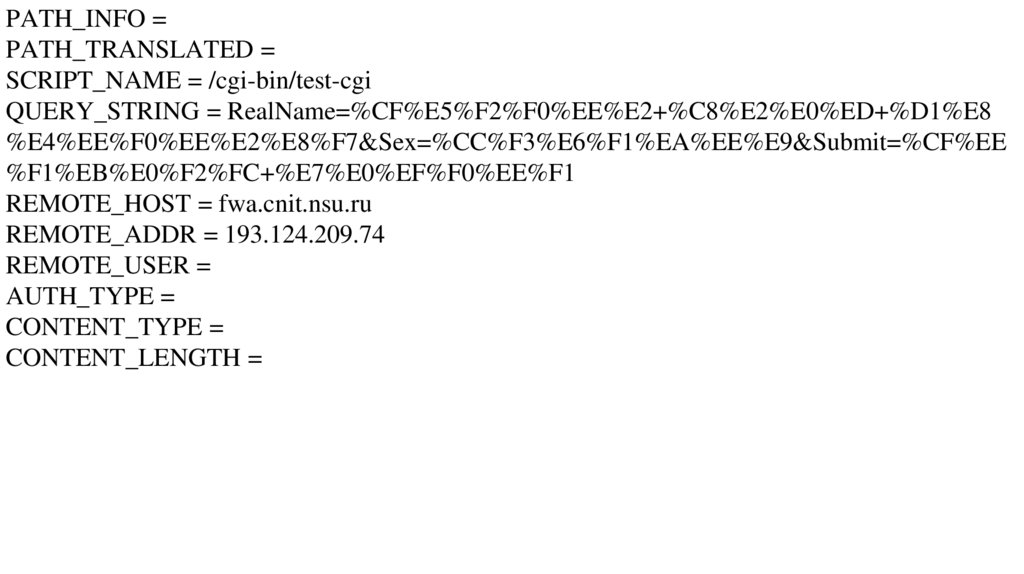

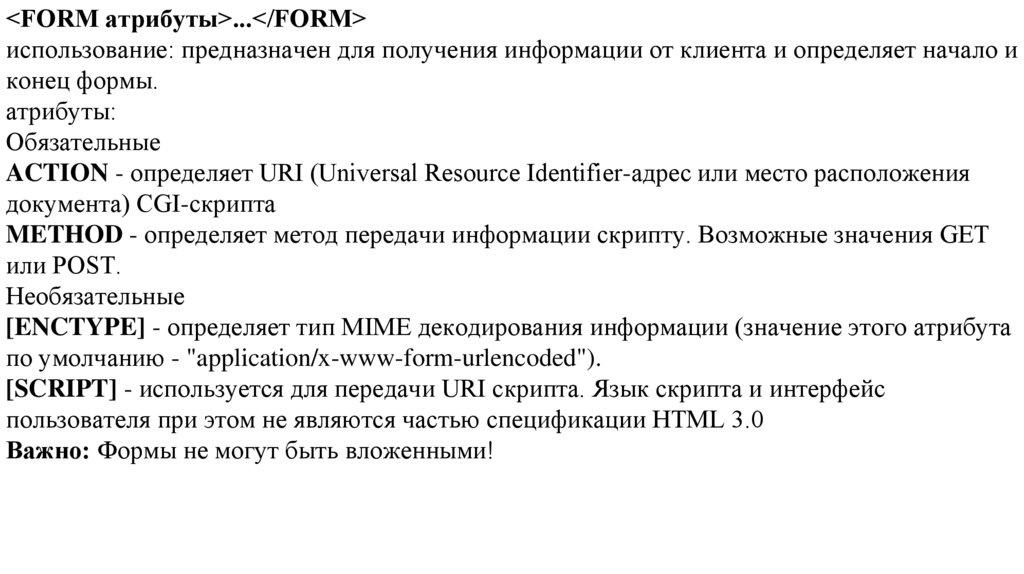

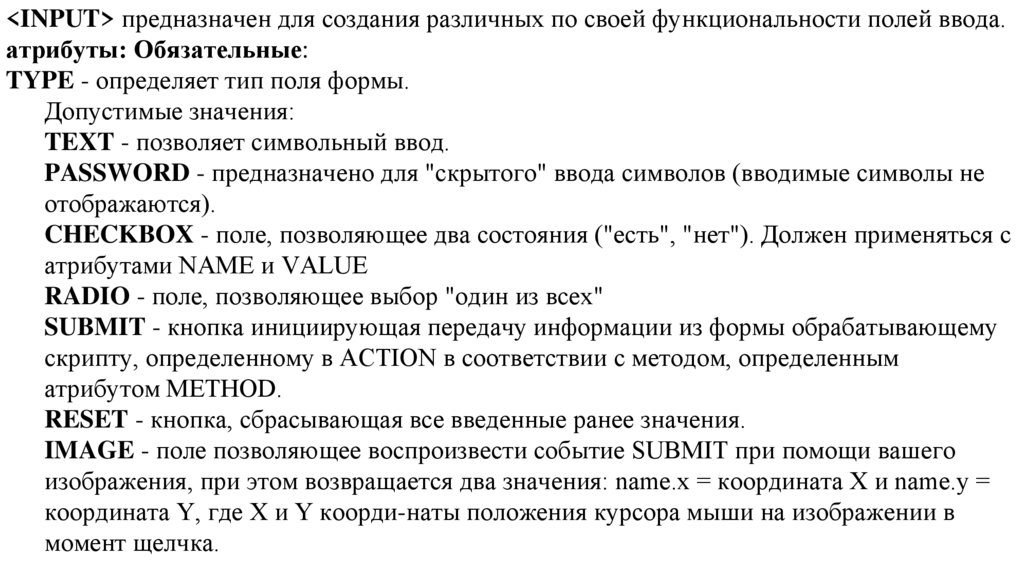

Зависимости данных в существующих системахОбеспечение таблиц описания данных в разрабатываемых сегодня системах является

существенным продвижением на пути к независимости данных . Наличие таких таблиц

облегчает изменения некоторых характеристик представления данных, хранимых в банках

данных. Однако набор характеристик представления данных, которые могут быть

изменены без нанесения логического ущерба некоторым прикладным программам,

продолжает оставаться ограниченным.

Модель данных, с которыми работают пользователи,

загромождается характеристиками представления;

в особенности это касается представлений коллекций данных (а не одиночных элементов

данных).

Тремя основными видами зависимости данных, которые все еще требуется устранить,

являются зависимость порядка, зависимость индексации и зависимость путей доступа.

В некоторых системах эти зависимости четко не отделены одна от другой.

4.

Зависимость порядка. Элементы данных в банке данных могут храниться разнымиспособами, некоторые из которых не предполагают наличия какого-либо порядка,

некоторые допускают участие каждого элемента только в одном порядке, а некоторые – в

нескольких порядках. Обратим внимание на те существующие системы, в которых

требуется или хотя бы допускается хранение элементов данных, по крайней мере, в одном

полном порядке, тесно связанном с зависимым от аппаратуры порядком адресов.

Например, записи в файле, описывающем детали, могут храниться в порядке убывания

серийных номеров. В таких системах обычно допускается, чтобы прикладные программы

основывались на предположении о том, что порядок представления записей идентичен

порядку их хранения (или является его частью). Эти прикладные программы,

использующие свойства упорядоченности файла, скорее всего не смогут правильно

работать, если по какой-то причине потребуется изменить этот порядок.

5.

Зависимость индексации. В контексте форматированных данных индекс обычнополагается компонентом представления данных, ориентированным исключительно на

увеличение эффективности. Наличие индексов ускоряет выполнение запросов и операций

обновления, но в то же время замедляет выполнение операций вставки и удаления.

С точки зрения информативности индекс является избыточным компонентом

представления данных. Если в системе используются индексы, и она должна хорошо

справляться с изменениями активности среды по отношению к банку данных, то, вероятно,

потребуется возможность время от времени создавать и уничтожать индексы.

Возникает вопрос: могут ли при этом остаться неизменными прикладные программы и

интерактивная деятельность?

В современных системах форматированных данных применяются разнообразные подходы

к индексации.

6.

В TDMS обеспечивается обязательная индексация по всем атрибутам.В текущей версии IMS пользователю предоставляется выбор для каждого файла: между

полным отсутствием индексации (иерархическая последовательная организация) и

индексацией только по первичному ключу (иерархическая индексно-последовательная

организация). Ни в одном из этих случаев логика пользовательского представления не

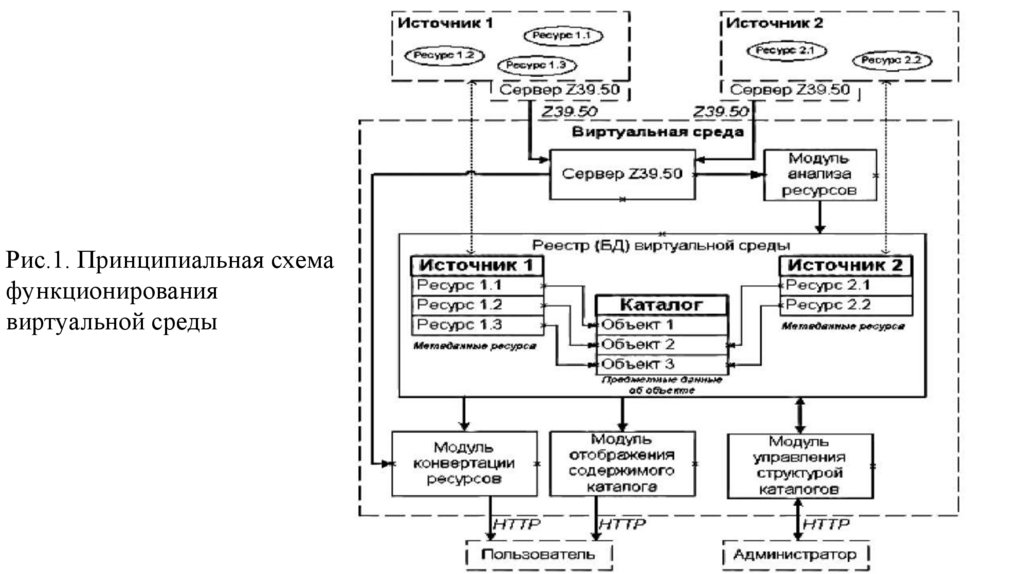

зависит от обязательно поддерживаемых индексов.

Однако в IDS проектировщикам файлов предоставляется возможность выбора индексных

атрибутов и добавления индексов в структуру файла с использованием средств

дополнительных цепочек.

Прикладные программы, в которых для повышения эффективности используются эти

индексные цепочки, должны ссылаться на них по именам. Такие программы не смогут

работать правильно, если эти цепочки будут впоследствии удалены

7.

Зависимость путей доступа. Многие существующие системы форматированных данныхпредоставляют пользователю файлы с древовидной организацией или немного более

общие сетевые модели данных. На прикладные программы, предназначенные для работы с

этими системами, логически влияют изменения структуры деревьев и сетей. Пример.

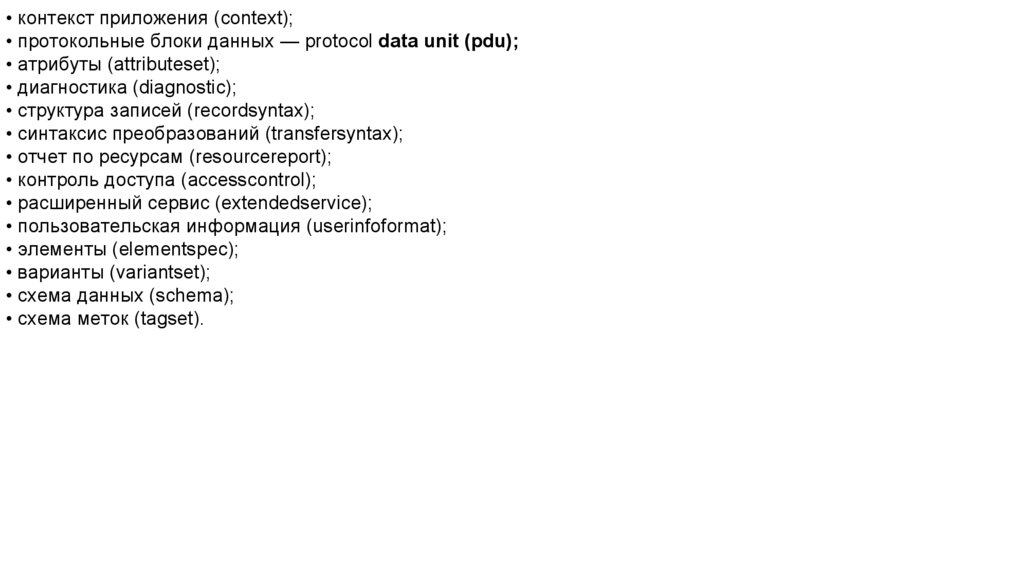

Предположим, что банк данных содержит информацию о деталях и проектах. Для каждой

детали хранится номер детали, название детали, описание детали, количество

используемых деталей этого типа и количество заказанных деталей. Для каждого проекта

хранится номер проекта, название проекта и описание проекта. Если в проекте

используется некоторый тип детали, регистрируется и количество деталей этого типа,

предназначенных для данного проекта. Предположим, что система требует, чтобы

пользователь или проектировщик файлов объявлял или определял данные в терминах

древовидных структур. Тогда для представления упомянутой выше информации годится

любая из представленных ниже иерархических структур

8.

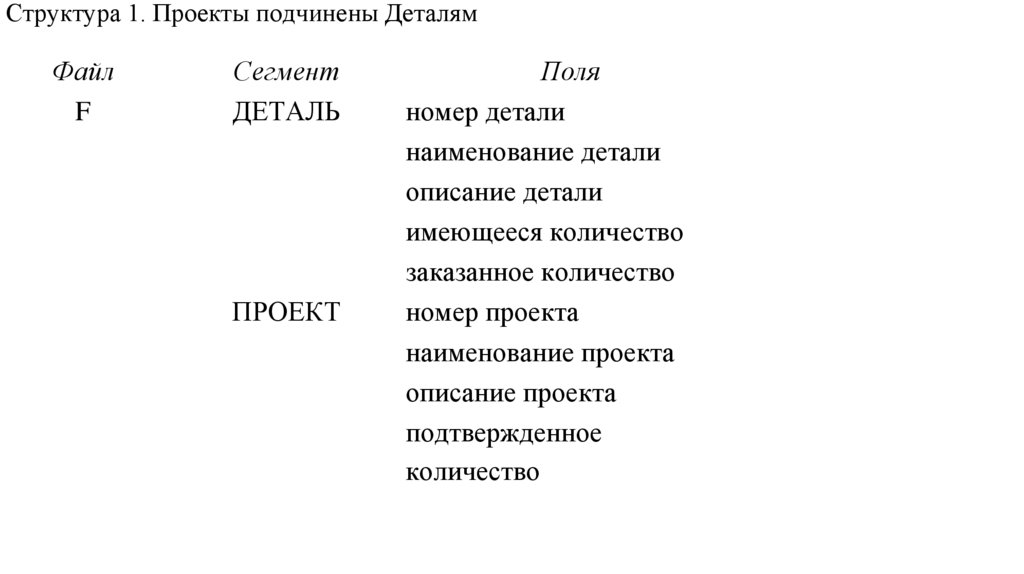

Структура 1. Проекты подчинены ДеталямФайл

F

Сегмент

ДЕТАЛЬ

ПРОЕКТ

Поля

номер детали

наименование детали

описание детали

имеющееся количество

заказанное количество

номер проекта

наименование проекта

описание проекта

подтвержденное

количество

9.

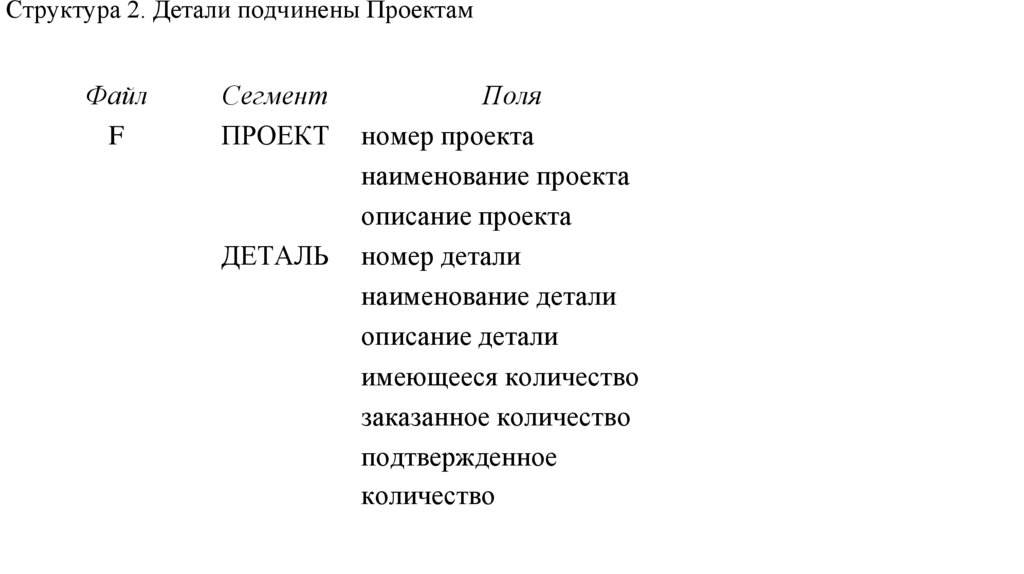

Структура 2. Детали подчинены ПроектамФайл

F

Сегмент

ПРОЕКТ

ДЕТАЛЬ

Поля

номер проекта

наименование проекта

описание проекта

номер детали

наименование детали

описание детали

имеющееся количество

заказанное количество

подтвержденное

количество

10.

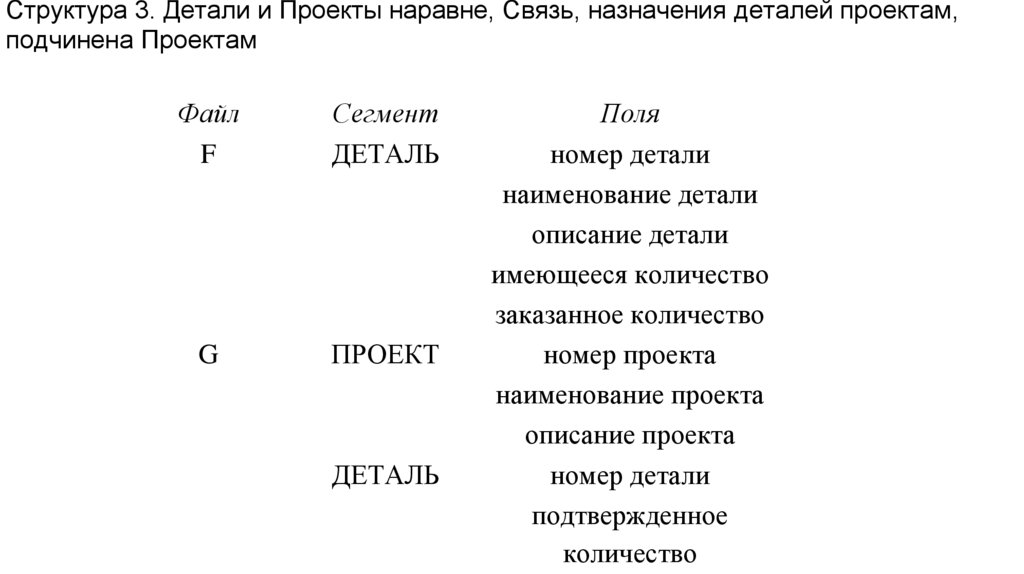

Структура 3. Детали и Проекты наравне, Связь, назначения деталей проектам,подчинена Проектам

Файл

F

Сегмент

ДЕТАЛЬ

G

ПРОЕКТ

ДЕТАЛЬ

Поля

номер детали

наименование детали

описание детали

имеющееся количество

заказанное количество

номер проекта

наименование проекта

описание проекта

номер детали

подтвержденное

количество

11.

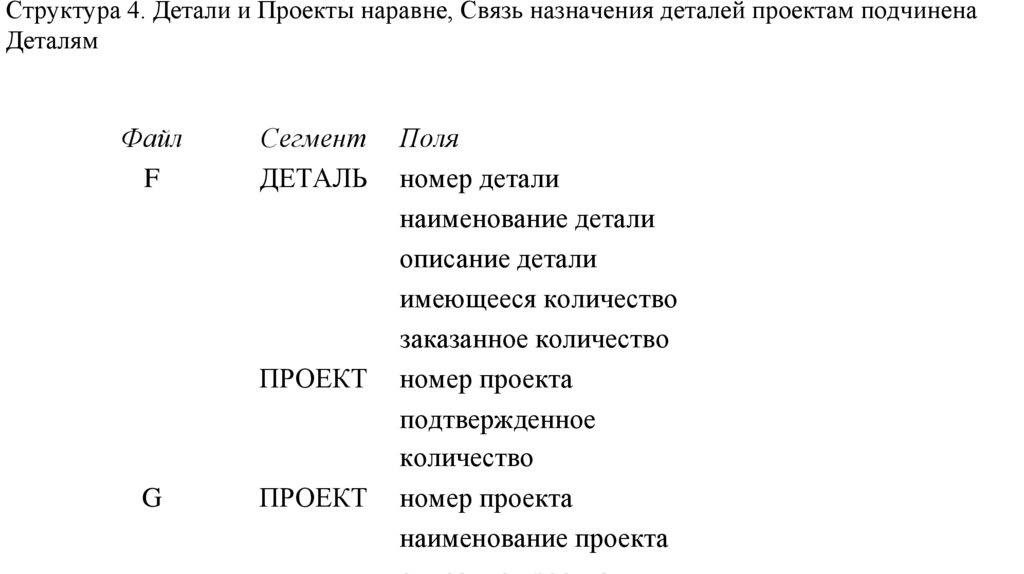

Структура 4. Детали и Проекты наравне, Связь назначения деталей проектам подчиненаДеталям

Файл

F

Сегмент

ДЕТАЛЬ

ПРОЕКТ

G

ПРОЕКТ

Поля

номер детали

наименование детали

описание детали

имеющееся количество

заказанное количество

номер проекта

подтвержденное

количество

номер проекта

наименование проекта

12.

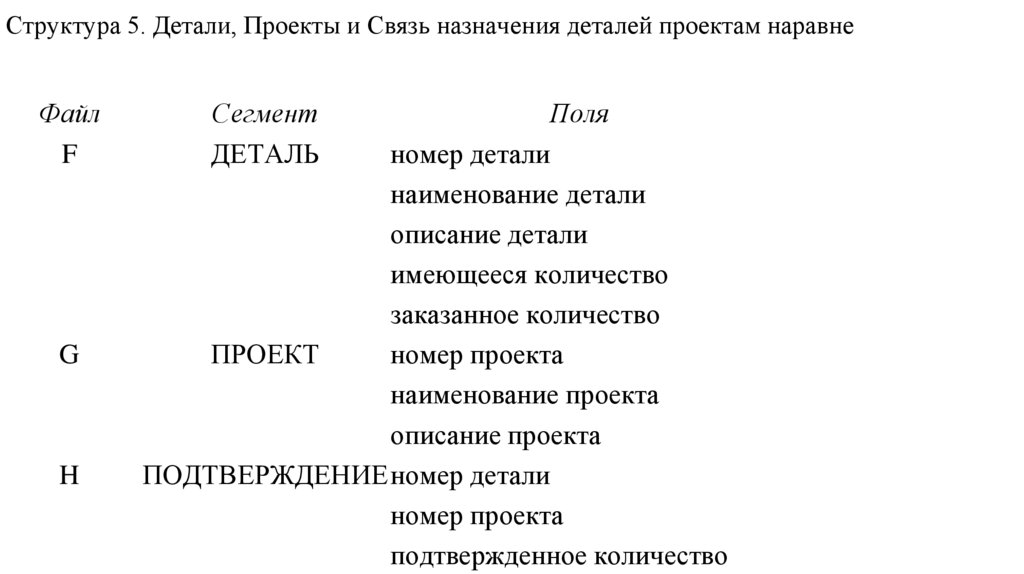

Структура 5. Детали, Проекты и Связь назначения деталей проектам наравнеФайл

F

G

H

Сегмент

ДЕТАЛЬ

Поля

номер детали

наименование детали

описание детали

имеющееся количество

заказанное количество

ПРОЕКТ

номер проекта

наименование проекта

описание проекта

ПОДТВЕРЖДЕНИЕ номер детали

номер проекта

подтвержденное количество

13.

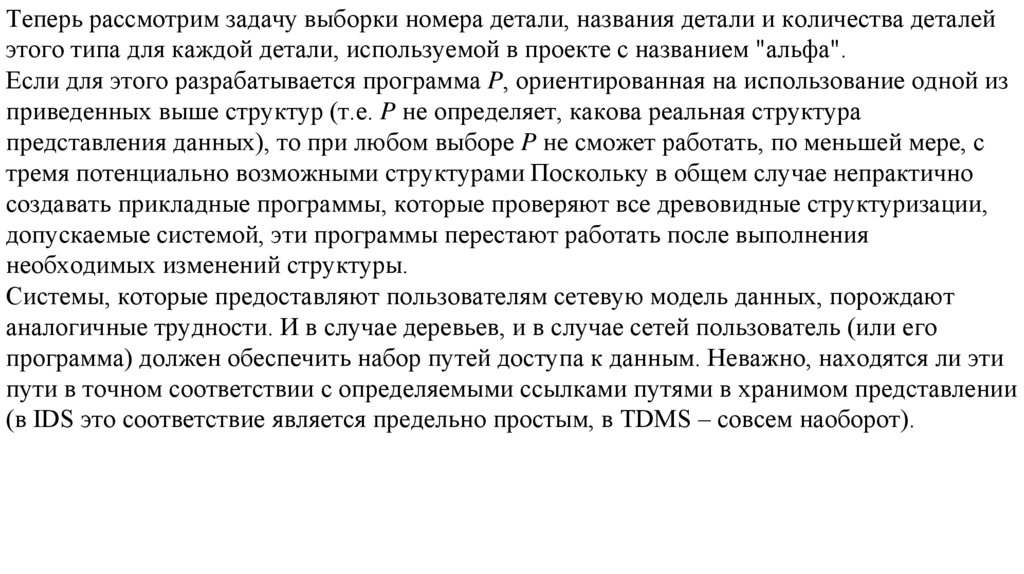

Теперь рассмотрим задачу выборки номера детали, названия детали и количества деталейэтого типа для каждой детали, используемой в проекте с названием "альфа".

Если для этого разрабатывается программа P, ориентированная на использование одной из

приведенных выше структур (т.е. P не определяет, какова реальная структура

представления данных), то при любом выборе P не сможет работать, по меньшей мере, с

тремя потенциально возможными структурами Поскольку в общем случае непрактично

создавать прикладные программы, которые проверяют все древовидные структуризации,

допускаемые системой, эти программы перестают работать после выполнения

необходимых изменений структуры.

Системы, которые предоставляют пользователям сетевую модель данных, порождают

аналогичные трудности. И в случае деревьев, и в случае сетей пользователь (или его

программа) должен обеспечить набор путей доступа к данным. Неважно, находятся ли эти

пути в точном соответствии с определяемыми ссылками путями в хранимом представлении

(в IDS это соответствие является предельно простым, в TDMS – совсем наоборот).

14.

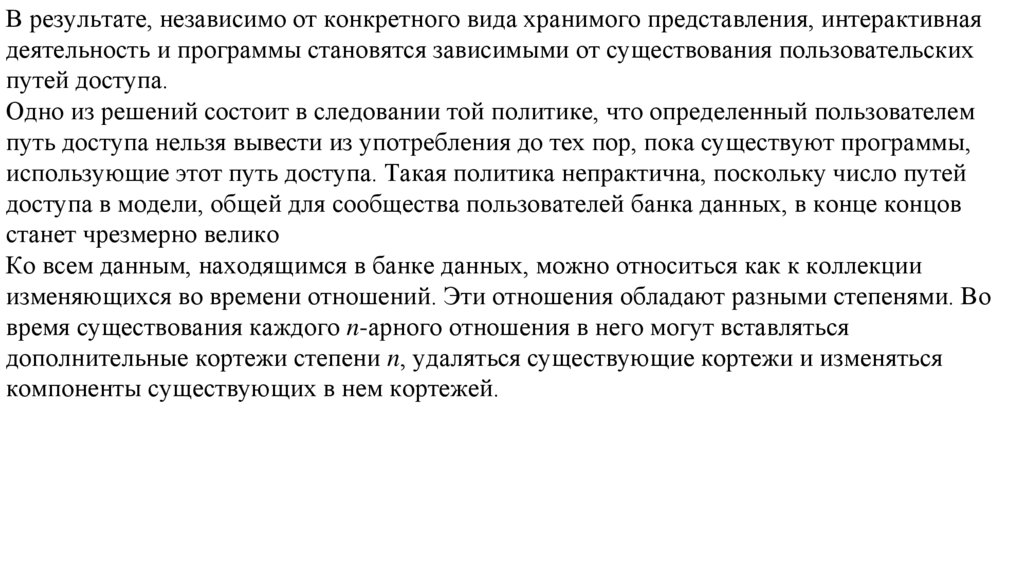

В результате, независимо от конкретного вида хранимого представления, интерактивнаядеятельность и программы становятся зависимыми от существования пользовательских

путей доступа.

Одно из решений состоит в следовании той политике, что определенный пользователем

путь доступа нельзя вывести из употребления до тех пор, пока существуют программы,

использующие этот путь доступа. Такая политика непрактична, поскольку число путей

доступа в модели, общей для сообщества пользователей банка данных, в конце концов

станет чрезмерно велико

Ко всем данным, находящимся в банке данных, можно относиться как к коллекции

изменяющихся во времени отношений. Эти отношения обладают разными степенями. Во

время существования каждого n-арного отношения в него могут вставляться

дополнительные кортежи степени n, удаляться существующие кортежи и изменяться

компоненты существующих в нем кортежей.

15.

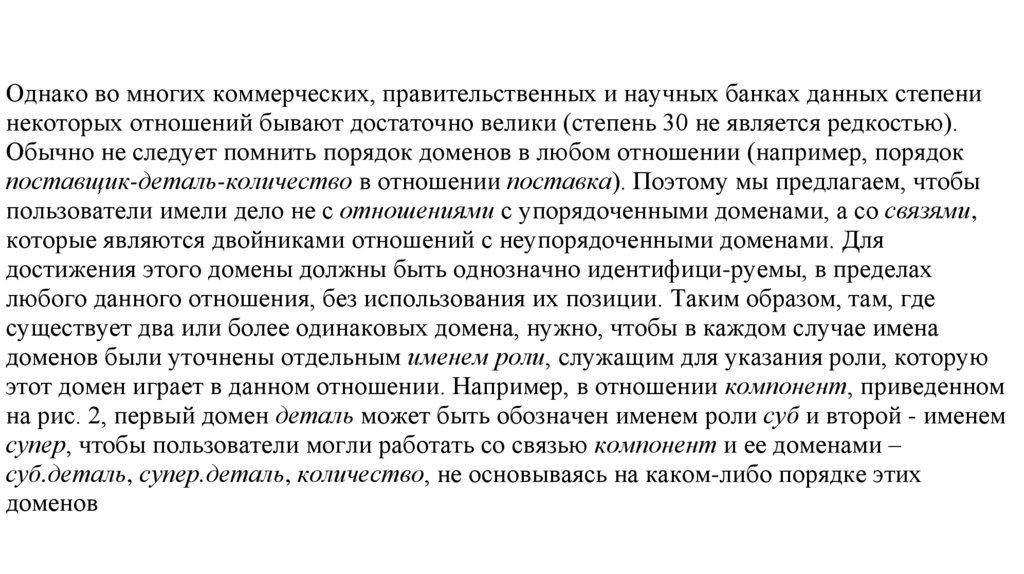

Однако во многих коммерческих, правительственных и научных банках данных степенинекоторых отношений бывают достаточно велики (степень 30 не является редкостью).

Обычно не следует помнить порядок доменов в любом отношении (например, порядок

поставщик-деталь-количество в отношении поставка). Поэтому мы предлагаем, чтобы

пользователи имели дело не с отношениями с упорядоченными доменами, а со связями,

которые являются двойниками отношений с неупорядоченными доменами. Для

достижения этого домены должны быть однозначно идентифици-руемы, в пределах

любого данного отношения, без использования их позиции. Таким образом, там, где

существует два или более одинаковых домена, нужно, чтобы в каждом случае имена

доменов были уточнены отдельным именем роли, служащим для указания роли, которую

этот домен играет в данном отношении. Например, в отношении компонент, приведенном

на рис. 2, первый домен деталь может быть обозначен именем роли суб и второй - именем

супер, чтобы пользователи могли работать со связью компонент и ее доменами –

суб.деталь, супер.деталь, количество, не основываясь на каком-либо порядке этих

доменов

16.

Предлагается, чтобы пользователи взаимодействовали с реляционной моделью данных,состоящей из изменяющихся во времени связей (а не с отношениями). Каждый

пользователь не должен знать ничего больше про связь, кроме ее имени и имен ее доменов

(с указанными в случае необходимости именами ролей) и эта информация могла бы

предоставляться системой в меню-ориентированном стиле (с соблюдением ограничений

безопасности и конфиденциальности) по запросу пользователя. Существует много

альтернативных способов применения реляционной модели в банках данных

Общее требование для элементов отношения – обеспечение взаимосвязи с другими

элементами данного отношения или с элементами другого отношения. Ключи

обеспечивают средства пользовательского уровня (но не только эти средства), для

выражения таких взаимосвязей.

17.

Ранее существовала строгая тенденция трактовать данные в банке данных как состоящие издвух частей – одна часть состоит из описаний сущностей (например, описания

поставщиков), а другая часть состоит из отношений между различными сущностями или

типами сущностей (например, отношение поставка). Такое различие трудно сохранять,

если отношение может содержать внешние ключи для какого-либо другого отношения. В

пользовательской реляционной модели отсутствуют преимущества от проведения такого

разделения (тем не менее, такие преимущества могут существовать при применении

реляционных концепций к машинному представлению пользовательского набора связей).

18.

Сеть распределенных вычислений: решения OracleНедорогие - blade-серверы и ОС Linux гарантируют максимальную экономическую

эффективность сети распределенных вычислений.

Oracle 10g содержит оригинальные базовые технологии для создания GRID – Oracle Real

Application Clusters, Oracle Streams и Oracle Transportable Tablespaces и отвечает

эксплуатационным требованиям сети распределенных вычислений, таким как

универсальность, RAS (надежность, готовность, удобство обслуживания), защищенность,

масштабируемость и управляемость.

Комплект инструментов Oracle Globus Development Kit (OGDK) позволяет применять

технологию Oracle со стандартными инструментами Globus. Корпорация Oracle для

поддержки всех новых стандартов сети распределенных вычислений сотрудничает с

организацией Global Grid Forum (GGF).

19.

Oracle Real Application ClustersУправление кластерами БД как сетью распределенных вычислений предприятия

осуществляется за счет использования интегрированного кластерного программного

обеспечения (integrated clusterware). Это программное обеспечение представляет собой

набор общих сервисов по обслуживанию кластеров, встроенных в Oracle Database 10g с

целью облегчить создание кластеров базы данных и управление ими. Решение Oracle Real

Application Clusters 10g также включает новое программное обеспечение для управления

рабочей нагрузкой кластеров, предназначенное для перераспределения вычислительных

возможностей компонентов кластерной базы данных, как только это потребуется для

решения бизнес-задач.

20.

Включены усовершенствованные возможности автоматизированного управления и новаяконсоль Database Control с web-интерфейсом.

Database Control представляет собой диагностический монитор, отображающий в

графическом виде текущее состояние функционирующей базы данных.

Администраторы могут проводить профилактический мониторинг баз данных и

быстро получать предупреждения и рекомендации с целью обеспечения оптимальной

производительности и надежности работы систем.

Консоль Database Control может даже выявить неудачно написанный фрагмент кода

приложения, предложить лучший вариант и автоматически настроить базу данных для

обеспечения оптимальной производительности.

Можно проводить диагностику производительности, настройку приложений и

управление распределением памяти.

21.

Oracle Database 10g включает также модуль автоматическогоуправления хранилищем данных (Automatic Storage Management, ASM) – ПО,

предназначенное для упрощения конфигурирования системы хранения данных и

управления базами данных.

Модуль ASM автоматически реализует взаимодействие базы данных с файлами данных и

подсистемами хранения данных, распределяет нагрузку на систему хранения данных,

исключает необходимость постоянного мониторинга систем хранения данных для

поиска «точек повышенной загрузки» и «узких мест», которые снижают скорость

обработки данных; упрощает структуру информационного центра и снижает расходы на

управление системой. Oracle сотрудничает с компаниями-разработчиками

промышленных систем хранения данных, такими, как EMC, Hitachi, HP, Network

Appliance и Xiotech, для обеспечения совместной работы модуля ASM с сетевыми

устройствами хранения данных и сетями хранилищ данных, предлагаемыми этими

компаниями.

22.

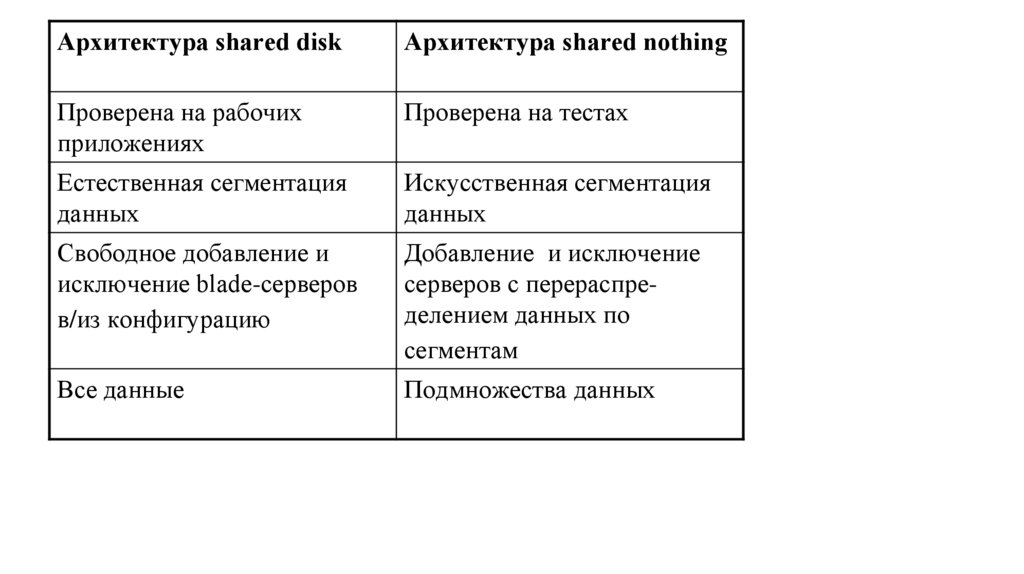

СУБД Oracle 10g для Linux-кластеров обладает высокой масштабируемостью, что былодоказано на вычислительных комплексах с 32 и более узлами. Как выяснилось, не

существует принципиальных технологических барьеров для увеличения числа узлов в

кластерах. RAC обеспечивает высокую степень утилизации ресурсов, причем на

недорогих blade-фермах.

Технология Oracle RAC основана на архитектуре с разделяемым диском (shared disk

architecture), что отличает ее от СУБД других производителей, которые строятся на

принципиальной иной архитектуре (shared nothing architecture). Данные в такой

архитектуре искусственно разнесены по сегментам базы данных. При добавлении новых

blade-серверов все данные нужно заново сегментировать, чтобы перенести часть из них

на новые серверы. Аналогично, когда нужно изъять из системы blade-серверы, данные

тоже приходится предварительно сегментировать.

23.

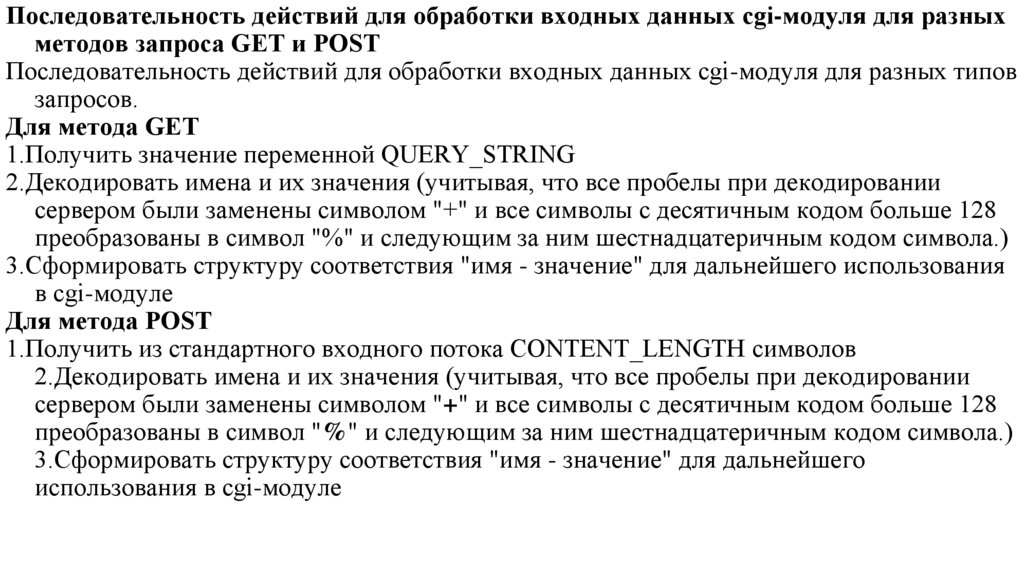

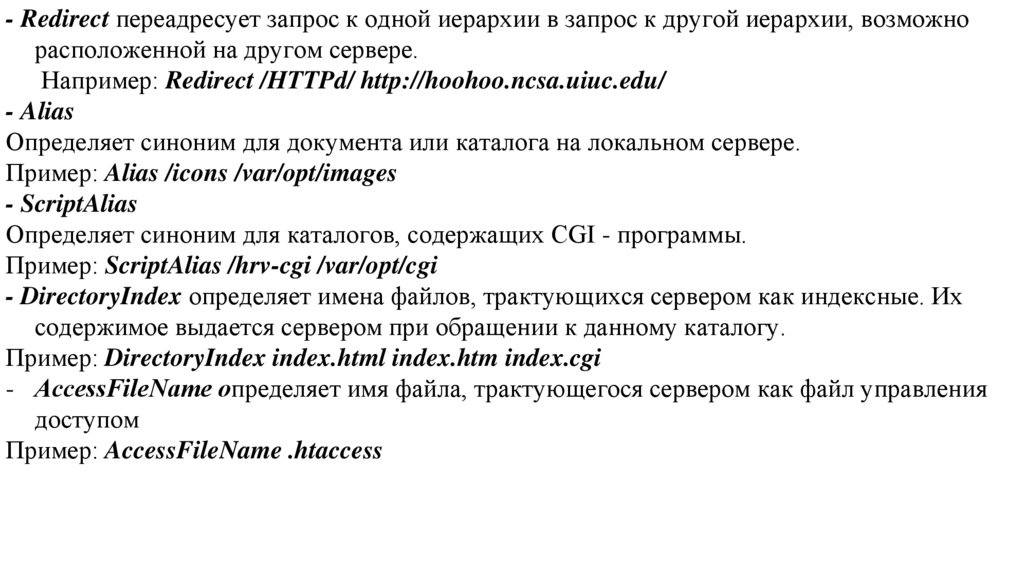

Архитектура shared diskАрхитектура shared nothing

Проверена на рабочих

приложениях

Проверена на тестах

Естественная сегментация

данных

Искусственная сегментация

данных

Свободное добавление и

исключение blade-серверов

в/из конфигурацию

Добавление и исключение

серверов с перераспределением данных по

сегментам

Все данные

Подмножества данных

24.

Модуль Oracle Transportable Tablespaces обеспечивает пользователей сетираспределенных вычислений чрезвычайно быстрым механизмом перемещения

подмножества данных из одной базы данных Oracle в другую, позволяет

выделять фрагменты баз данных Oracle, переносить или копировать их в

другое место, а затем присоединять к другой базе данных. Перемещение

фрагментов данных заключается лишь в считывании или записи небольшого

количества метаданных. Кроме того, Transportable Tablespaces может

одновременно составлять таблицы «только для чтения» из двух или более баз

данных.

25.

Модуль Oracle Streams позволяет распространять данные среди баз данных, узлов илиферм blade-серверов сети распределенных вычислений. Он создает унифицирован-ную

структуру для распространения данных, формирования очередей сообщений,

репликации, управления событиями, загрузки данных в хранилище, оповещений и

публикации/ подписки в рамках единой технологии. Oracle Streams может

синхронизировать одновременно две или более копии баз данных по мере их

обновления. Модуль автоматически регистрирует изменения в базе данных,

распространяет эти изменения в узлы, которые подписаны на получение этих

изменений, реализует их; а также обнаруживает и разрешает возможные конфликты по

данным. Модуль может использоваться приложениями и непосредственно для

организации очередей сообщений, обеспечивающих связь между приложениями в

пределах сети распределенных вычислений.

26.

Модули Distributed SQL и Distributed TransactionsС помощью модуля Oracle Distributed SQL пользователи сети распределенных

вычислений могут эффективно получать и объединять данные, хранящиеся в различных

базах данных Oracle и базах данных других производителей. Прозрачный удаленный

доступ к данным посредством Distributed SQL позволяет приложениям работать с любой

другой базой данных без внесения каких-либо изменений в код программ. В процессе

интеграции данных из нескольких источников СУБД Oracle оптимизирует планы

исполнения запросов. Кроме того, СУБД Oracle автоматически выполняет транзакции с

данными из нескольких источников. Функция Oracle XA позволяет пользователям сети

распределенных вычислений координировать выполнение транзакций, затрагивающих

несколько баз данных.

Гетерогенный доступ посредством механизмов Transparent Gateways

27.

В данную группу включены следующие продукты:Oracle Open System Gateways – подгруппа продуктов (шлюзов), обеспечивающих доступ

(посредством SQL) к данным, хранящимся в отличных от Oracle базах данных на всех

платформах открытых систем. В настоящий момент поддерживается доступ к

следующим базам данных: MS SQL Server, Sybase, Rdb, Ingres, Informix, Teradata, RMS

Mainframe Integration Gateways – подгруппа продуктов (шлюзов), обеспечивающих

доступ к СУБД DB2 на мэйнфреймах.

Replication Services (сервисы репликации), обеспечивающие репликацию данных из БД

Oracle в «чужие» базы данных (равно как и из «чужих» баз данных в БД Oracle). Для

репликации используются прозрачные шлюзы.

Enterprise Integration Gateways – включает шлюзы к СУБД DB2 для платформы AS/400

(DB2/400) и шлюз к системам IBM DRDA, а также Procedural Gateways (процедурные

шлюзы),

28.

Procedural Gateways (процедурные шлюзы), обеспечиваю-щие обработку вызововудаленных процедур, причем удаленные процедуры определены и выполняются в

отличной от Oracle программной системе. В эту подгруппу включен и Access

Manager (менеджер доступа), основным назначением которого является поддержка

доступа «чужих» приложений посредством языка запросов SQL к базам данных

Oracle.

Пользователи СРВ могут применять функции планирования работ в СУБД

Oracle. Функции управления очередями заданий (jobs) обеспечивает гибкий

механизм планирова-ния задач СУБД. Задания можно выполнять в

определен-ное время и с определенными временными интервалами. Имеется

возможность указать максимальное число про-цессов, которое будет

использоваться для выполнения заданий. При использовании OracleReal

Application Cluster 10g можно направить задание на любой из доступных узлов

для исполнения соответствующим экземпляром Oracle Database.

29.

Oracle Resource Manager позволяет администраторам ресурсов ограничивать ресурсыСУБД Oracle, выделяемые пользователям сети. Функция управления ресурсами

гарантирует, что каждый пользователь сети получит долю имеющихся вычислительных

ресурсов в соответствии с их (пользователей) приоритетами

Стандартная среда сети распределенных вычислений

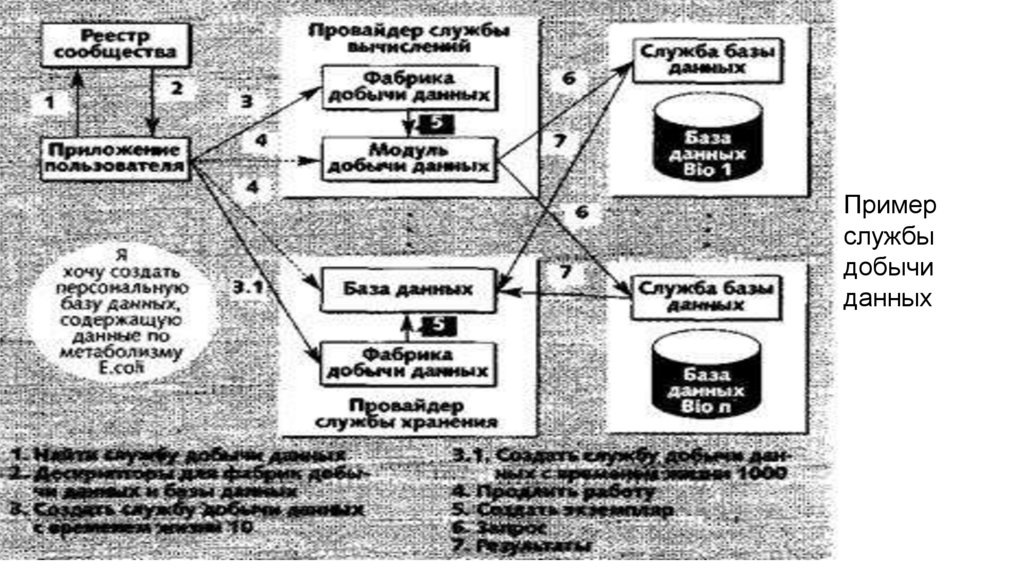

Комплект инструментов Oracle Globus содержит набор компонентов, которые можно

использовать для создания приложений СРВ, а также инструменты программирования.

Комплект Globus стал де-факто стандартом среды разработки СРВ.

Oracle Globus Development Kit (OGDK) содержит сценарии для эффективного

использования технологии Oracle с комплектом инструментов Globus.

30.

Доступ через СРВ к Oracle10g UtilitiesМодуль Globus Resource Allocation Manager (GRAM) обеспечивает выделение ресурсов,

создание и мониторинг процессов, а также управление ими. GRAM преобразуют

запросы на языке Resource Specification Language (RSL) в команды, понятные

локальным планировщикам. Применяя эту функцию, пользователи СРВ могут удаленно

задействовать такие утилиты Oracle, как export, import и sqlplus, для выполнения

необходимых действий в Oracle Database 10g. Этот механизм можно использовать для

настройки удаленных баз данных в сети распределенных вычислений. Доступ через

СРВ к Oracle10g Database

OGDK использует модуль Globus GRAM для исполнения программ PL/SQL или команд

SQL, описанных в Globus RSL. Он может применяться и для передачи заданий

планиров-щику Oracle через API PL/SQL планировщика, вследствие чего пользователи

сети могут выполнять задачи на удален-ных базах данных, планировать и

контролировать их испол-нение.

31.

Служба информации о ресурсах сети (GRIS) для Oracle DatabaseСлужба информации о ресурсах сети распределенных вычислений (GRIS),

входящая в комплекс инструментов Globus, предоставляет информацию для

контроля за ресурсами сети распределенных вычислений и их обнаружения.

Эта функция позволяет пользователям сети распределенных вычислений

обнаруживать базы данных Oracle и проверять их. GRIS для Oracle Database

отображает атрибуты и свойства базы данных, которые могут потребоваться

пользователям сети распределенных вычислений.

32.

Универсальность Oracle по отношению к операционным системам и оборудованиюозначает, что все продукты семейства Oracle 10g способны поддерживать неоднородные

СРВ, которые, как известно, позволяют использовать любое имеющееся оборудование, а

не только оборудование одного производителя.

Oracle 10g может работать как в конфигурациях СРВ, так и вне их, так что можно,

например, взять приложение, разработанное для SMP-систем, и перенести его в

инфраструктуру СРВ.

Oracle 10g работает на всех популярных операционных системах, причем обеспечивает

одни и те же функции и возможности, так как базовый код остается тем же.

Универсальность Oracle означает, что, в каком бы направлении ни развивалась сеть

распределенных вычислений, какая бы операционная система в ней ни доминировала,

Oracle 10g все равно будет работать в этой сети.

33.

Утилизация простаивающих ресурсов – один из примеров применения СРВ. Идеяутилизации неиспользуемых ресур-сов тысяч персональных компьютеров,

простаивающих каждую ночь, чрезвычайно привлекательна. У такого решения

огромный потенциал. Особенно популярно оно среди ученых: при значительной

нехватке средств им приходится решать параллельные задачи. Типичным примером СРВ

является центральный сервер, распределяющий работу между большим числом

небольших компьютеров. Этот же сервер собирает и систематизирует результаты

расчетов. И все же у такой модели СРВ много ограничений. Главная проблема в том, что

ресурсы – простаивающие персональные компьютеры – часто выходят из-под

административного контроля тех, кто ими пользуется. Степень готовности и надежности

распределенных ресурсов ограничена, что чрезвычайно затрудняет планирование

вычислений.

34.

Кроме того, слабость или отсутствие модели доверия (trust model) в таких СРВпрепятствуют их использованию для обработки какой бы то ни было конфиденциальной

или частной информации. Наконец, класс приложений, допускающих

распараллеливание, весьма ограничен, что минимизирует преимущества таких сетей

распределенных вычислений для многих организаций.

Тем не менее утилизация ресурсов посредством сети распределенных вычислений успешно

применяется для решения сложных проблем. Примером такой реализации сети

распределенных вычислений можно считать проект SETI@home, в котором свободные

компьютеры, подключенные к интернету, обрабатывают данные радиотелескопа с

целью поиска признаков существования внеземных цивилизаций.

35.

Разделение ресурсов – еще один способ реализации сети распределенных вычислений.Внедрив сеть распределенных вычислений с разделением ресурсов, организации

смогут задействовать недоиспользуемые ресурсы в пределах одного или нескольких

предприятий. Участники такой сети распределенных вычислений получают

возможность легко обмениваться вычислительными ресурсами и данными, перемещая

приложения и информацию по сети распределенных вычислений с тем, чтобы

задействовать свободные ресурсы.

В результате создается умеренное число средних и крупных узлов, которые могут

относиться к одному административному домену или охватывать несколько

административных доменов. Планировщики сети распределенных вычислений следят

за наличием свободных ресурсов и должным образом распределяют их.

36.

Для внедрения сети распределенных вычислений такого типа многие заказчики применяюттехнологию Oracle. CERN выбрал технологических партнеров для реализации проекта

сети распределенных вычислений LHC (Большой Адронный Коллайдер), которая

позволит тысячам физиков во всем мире анализировать петабайты распределенных

данных об элементарных частицах. Одним из участников проекта является компания

Oracle с программными продуктами Oracle Database 10g и Oracle Application Server 10g,

отвечающие требованиям сети распределенных вычислений LHC. Oracle Database 10g

гарантирует масштабируемость, разделение информации и функции поддержки

сверхбольших баз данных (VLDB), необходимые тысячам пользователей для обмена

данными в рамках сети распределенных вычислений LHC. Oracle Transportable

Tablespaces обеспечит CERN быстродействующим механизмом распределения больших

объемов данных между множеством узлов.

37.

Значительное количество администрируемых доменов, организационные барьеры,проблемы доверия и интенсивное перемещение данных между узлами сети ставят под

вопрос для многих организаций эффективность подхода разделения ресурсов

Сеть распределенных вычислений с выделением ресурсов решает эти проблемы за счет

создания централизованных пулов вычислительных ресурсов, которые могут

предоставляться всем приложениям-участникам.

38.

Испытания для определения предельных ограничений на передачу данных враспределенной среде

39.

Сотрудники Центра ядерных исследований CERN совершили масштабные испытанияраспределенной компьютерной сети Солидного адронного коллайдера (БАК),

наибольшего ускорителя элементарных частиц. Основной задачей нынешних испытаний

было узнать предельные ограничения на передачу данных в распределенной среде. На

протяжении опыта Scale Testing for the Experiment Programme ’09 объемные массивы

данных передавались между вычислительными узлами, расположенными в разных

государствах. В Европе сейчас насчитывается 11 вычислительных узлов, соединенных

выделенными волоконно-оптическими каналами. Эти узлы передают информацию на

обработку еще в 140 центров 33 государств. Ян Берд, начальник компьютерного

подразделения CERN, сказал, что тестирование прошло удачно, и мощностей

телекоммуникационной инфраструктуры хватит с запасом. Скорость передачи данных

по сетевым каналам на момент запуска БАК составит 1,3 Гбайт/с. Во время испытаний

удалось достичь скорости в 4 Гбайт/с.

40.

Грид-вычисления ( grid — решётка, сеть) — это форма распределенных вычислений, вкоторой «виртуальный суперкомпьютер» представлен в виде кластеров, соединённых с

помощью сети, слабосвязанных гетерогенных компьютеров, работающих вместе для

выполнения огромного количества заданий (операций, работ). Эта технология применяется

для решения научных, математических задач, требующих значительных вычислительных

ресурсов. Грид-вычисления используются также в коммерческой инфраструктуре для

решения таких трудоёмких задач, как экономическое прогнозирование, сейсмоанализ,

разработка и изучение свойств новых лекарств.

Грид с точки зрения сетевой организации представляет собой согласованную, открытую и

стандартизованную среду, которая обеспечивает гибкое, безопасное, скоординированное

разделение вычислительных ресурсов и ресурсов хранения информации, которые являются

частью этой среды, в рамках одной виртуальной организации

41.

Технология GRID используется для реализации географически распределеннойвычислительной и информационной среды, которая объединяет в единую

инфраструктуру ресурсы различных типов и обеспечивает коллективный доступ к этим

ресурсам В классической реализации GRID фокусируется на обеспечении

распределенных вычислений в фиксированной среде с заданной конфигурацией.

Основное решение – объедине-ние ресурсов в межпрограммном слое. Необходимо

создавать специальную инфраструктуру GRID вследствие сложности установки,

поддержки, управления, масштабирования GRID-сети, функциональных ограничений

программного обеспечения.

Одна из современных задач развития GRID это общедоступность и расширение области ее

использования, что требует значительного уменьшения сложности ее установки и

поддержки

42.

В настоящее время выделяют три основных типа грид-систем:Добровольные гриды — гриды на основе использования добровольно предоставляемого

свободного ресурса персональных компьютеров;

Научные гриды — хорошо распараллеливаемые приложения программируются

специальным образом (например, с использованием Globus Toolkit);

Гриды на основе выделения вычислительных ресурсов по требованию (коммерческий

грид, enterprise grid) — обычные коммерческие приложения работают на виртуальном

компьютере, который, в свою очередь, состоит из нескольких физических компьютеров,

объединённых с помощью грид-технологий.

43.

Общедоступная GRID должна обеспечивать предоставление по требованиюинфраструктуры и приложений, ориентированных на использование высоких

технологий во всех сферах деятельности человеческого сообщества - медицина,

электронные медиа, инженерная сфера, обеспечение коммуникаций для электронного

бизнеса и тому подобное для широкого слоя пользователей в хорошо защищенной,

общедоступной, расширяемой и стандартизированной компьютерной среде через

Промежуточное программное обеспечение GRID, поддерживающее массовое

распространение, должно обладать многими свойствами инфраструктуры «по

требованию». Оно должно быть разделяемым между разными пользователями,

предоставлять стандартизиро-ванные службы и протоколы связи, а также быть гибким и

расширяемым. Вычислительная парадигма современной GRID строится вокруг

основной цели: предоставлять ресурсы столь же легко, как электричество через сеть.

44.

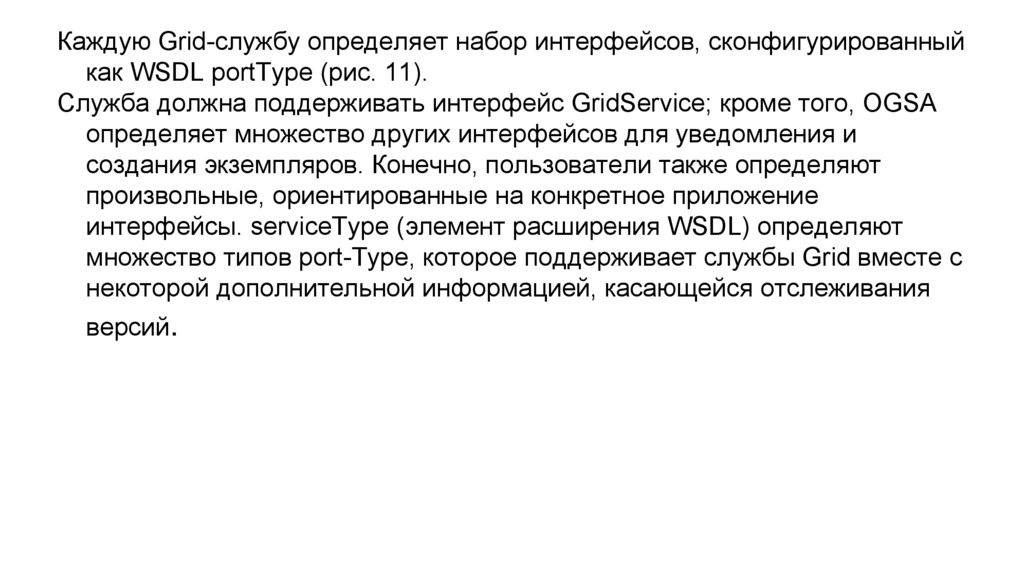

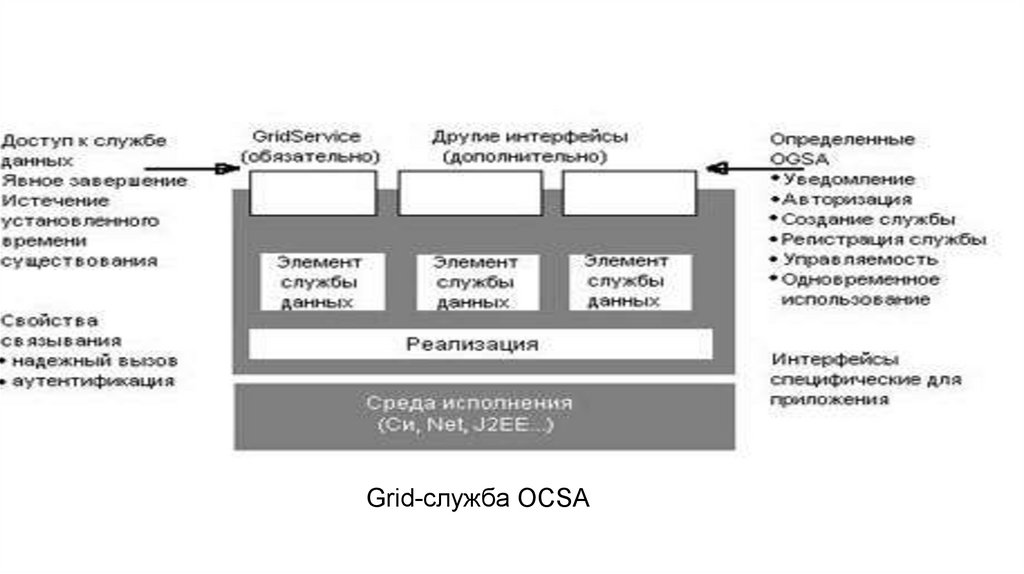

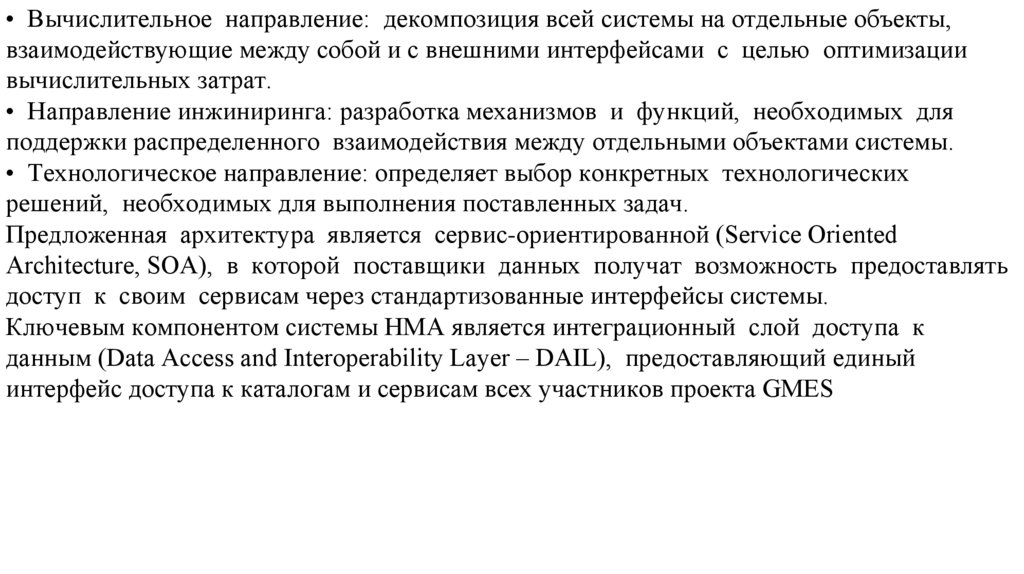

Предъявляемые требования к интеграции и интероперабель-ности большого количестваприложений, обусловили развитие технологии GRID в направлении открытой

архитектуры OGSA (Open Grid Services Architecture).

Объединение GRID и соответствующих стандартов WEB-служб - большой шаг в

направлении уменьшения сложности использования, управления и поддержки GRID.

Использование стандарта WSRF, который является низкоуровневым описанием

инфраструктуры, реализации модели OGSA, предлагает возможность предоставлять

низкоуровневую виртуализацию доступных ресурсов, что значительно повышает

универсальность GRID.

Основной идеей сегодняшней GRID становиться формирование динамической среды,

состоящей из взаимодействующих неоднородных вычислительных узлов, без

определенной фиксированной инфраструктуры и с минимальными административными

требованиями.

45.

Мобильные GRIDНаиболее актуальные современные исследования в области GRID посвящены

необходимости решения проблемы совместимости GRID и мобильных сетей.

Использование беспроводных устройств, которые имеют достаточно ограниченные

ресурсы вычислительной мощности, энергии, адресного пространства, накладывают

существенные ограничения при решении вычислительных заданий повышенной

ресурсоемкости и хранения больших объемов данных, однако за счет привлечения

дополнительных ресурсов, доступных при сочетании с GRID, такое использование

вполне возможно. Более того использование мобильных GRID позволило бы обеспечить

применение приложений GRID в тех местах где это можно лишь представить, а в

будущем технология GRID могла бы

войти в набор обычных услуг для мобильных пользователей

46.

Мобильные GRID характеризуется динамической структурой и допускают перемещениекак пользователей GRID, так и запрашиваемых ресурсов. Узлы мобильных GRID не

является кластерами или супер-компьютерами, это произвольный диапазон мобильных

устройств с гетерогенными свойствами: вычислительный ресурс процессора, объем

памяти, пропускная способность каналов связи, задержка. Кроме того, мобильная сеть

подвержена проблемам разрыва связей и выхода узлов из строя или перемещения за

пределы досягаемости. Мобильные узлы имеют гетерогенное время выполнения

подзадачи, и могут останавливать вычисление произвольно в случае непредвиденного

перемещения. В связи с этим совместное выполнение задания временно откладывается,

и возникают проблемы реконфигурации, репликации, резервирования данных, и тому

подобное.

47.

Такие нестабильные ситуации называются автономными отказами, они приводятк задержке и блокировке выполнения подзадач и как следствие к частичной

или полной потере результатов выполнения задания. Отмеченные проблемы

осложняют планирование и управление выполняемыми подзадачами.

Таким образом, характеристики и особенности мобильных GRID обуславливают

необходимость разработки стратегий управления и механизмов планирования

которые бы адаптировались к динамической вычислительной среде.

48.

Тенденции·тенденции в области компьютерных платформ:

Каждый производитель компьютерной платформы либо анонсировал, либо уже поставляет

так называемые blade-серверы (blade servers). Они обеспечивают самую дешевую

вычислительную мощность – иногда на 80% дешевле той, что дают системы на основе

симметричной многопроцессорной обработки (SMP). Blade-серверы легко составляются

в blade-фермы (blade farms), которые представляют собой самую эффективную и

масштабируемую разновидность недорогой вычислительной системы. Теперь bladeфермы оснащаются каналами межкомпьютерного взаимодействия (interconnects), что

превращает их в кластеры – самую экономически эффективную форму недорогих

вычислительных комплексов. Эти кластеры, скорее всего, станут архитектурой

вычислительной техники будущего.

49.

· тенденции в области операционных систем:В сфере программного обеспечения Linux опережает по темпам роста популярности другие

операционные системы. Linux пока нельзя масштабировать до крупной SMPсистемы. Но на blade-серверах, оснащенных несколькими недорогими процессорами,

Linux работает отлично. Экономические преимущества blade-серверов перед SMPсистемами обеспечивают первым доминирование, а так как Linux уже сейчас является

ключевой операционной системой для blade-серверов, это еще сильнее ускоряет

распространение Linux. Наконец, у Linux есть ценовое преимущество, которое

приобретает все большее значение по мере роста числа blade-серверов, что опять-таки

способствует распространению этой ОС. И вполне естественно, что недорогие кластеры

хорошо сочетаются с недорогой операционной системой Linux.

50.

· виртуализация:Виртуализация – один из самых модных сегодня терминов как в индустрии

программного обеспечения, так и в индустрии аппаратуры. Нет ничего более

виртуального, чем коммунальные услуги. Множество поставщиков стараются

доказать, что их новая стратегия состоит в виртуализации или коммунальных

вычислениях, – а это именно то, что характерно для сети распределенных

вычислений. С большой долей вероятности можно утверждать, что скоро все

они возьмут на вооружение сети распределенных вычислений.

51.

· рост популярности концепции Grid:Grid – концепция сети распределенных вычислений – становится все популярнее

в индустрии информационных технологий. Некоторые крупные

производители, в том числе Oracle, уже предлагают технологию,

поддерживающую сеть распределенных вычислений. Другие, например IBM,

планируют предложить такую технологию. Создана организация по

стандартизации сети распределенных вычислений – Global Grid Forum (GGF),

которую поддержали все крупные производители.

52.

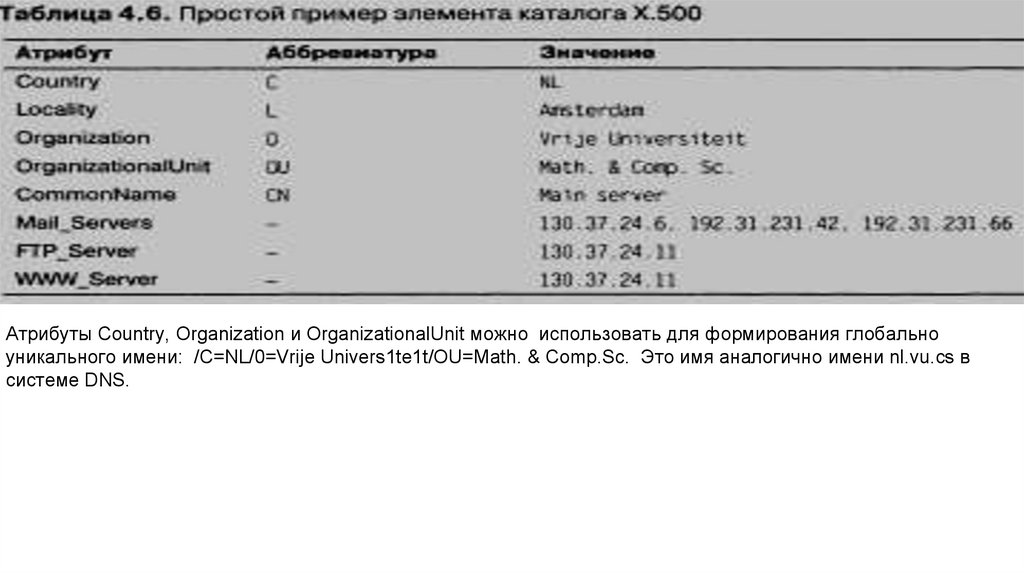

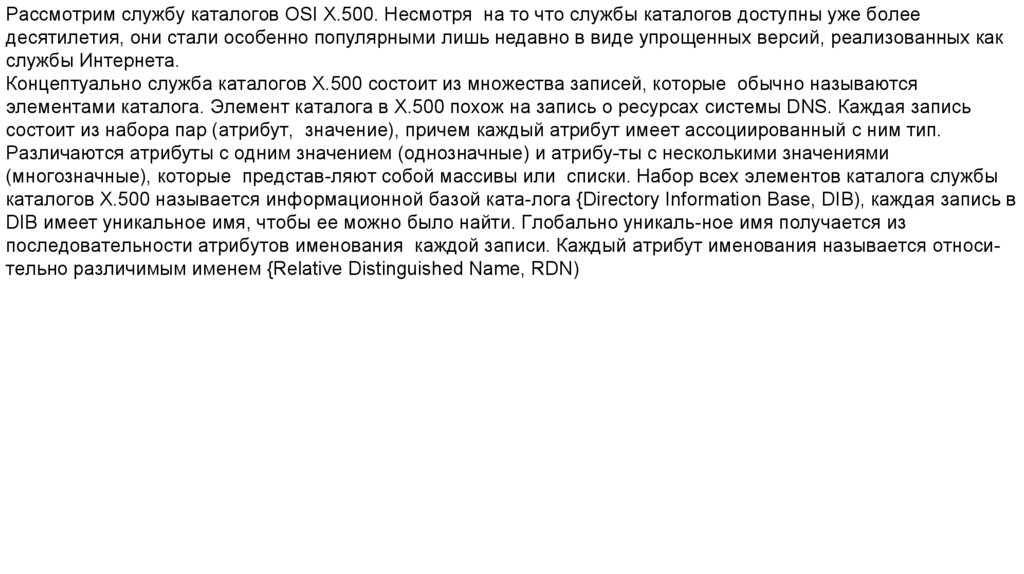

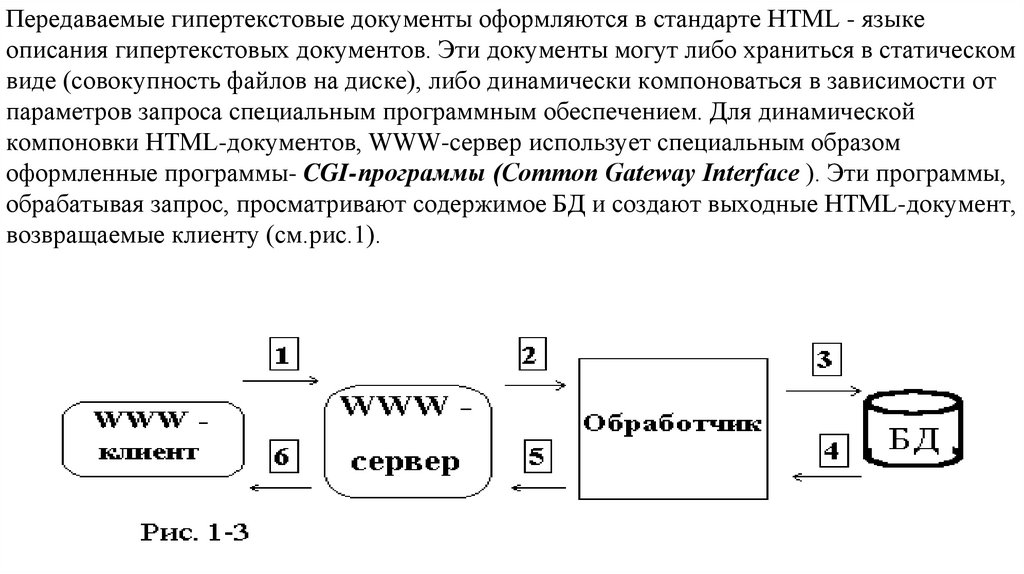

Рассмотрим службу каталогов OSI Х.500. Несмотря на то что службы каталогов доступны уже болеедесятилетия, они стали особенно популярными лишь недавно в виде упрощенных версий, реализованных как

службы Интернета.

Концептуально служба каталогов Х.500 состоит из множества записей, которые обычно называются

элементами каталога. Элемент каталога в Х.500 похож на запись о ресурсах системы DNS. Каждая запись

состоит из набора пар (атрибут, значение), причем каждый атрибут имеет ассоциированный с ним тип.

Различаются атрибуты с одним значением (однозначные) и атрибу-ты с несколькими значениями

(многозначные), которые представ-ляют собой массивы или списки. Набор всех элементов каталога службы

каталогов Х.500 называется информационной базой ката-лога {Directory Information Base, DIB), каждая запись в

DIB имеет уникальное имя, чтобы ее можно было найти. Глобально уникаль-ное имя получается из

последовательности атрибутов именования каждой записи. Каждый атрибут именования называется относительно различимым именем {Relative Distinguished Name, RDN)

53.

Атрибуты Country, Organization и OrganizationalUnit можно использовать для формирования глобальноуникального имени: /C=NL/0=Vrije Univers1te1t/OU=Math. & Comp.Sc. Это имя аналогично имени nl.vu.cs в

системе DNS.

54.

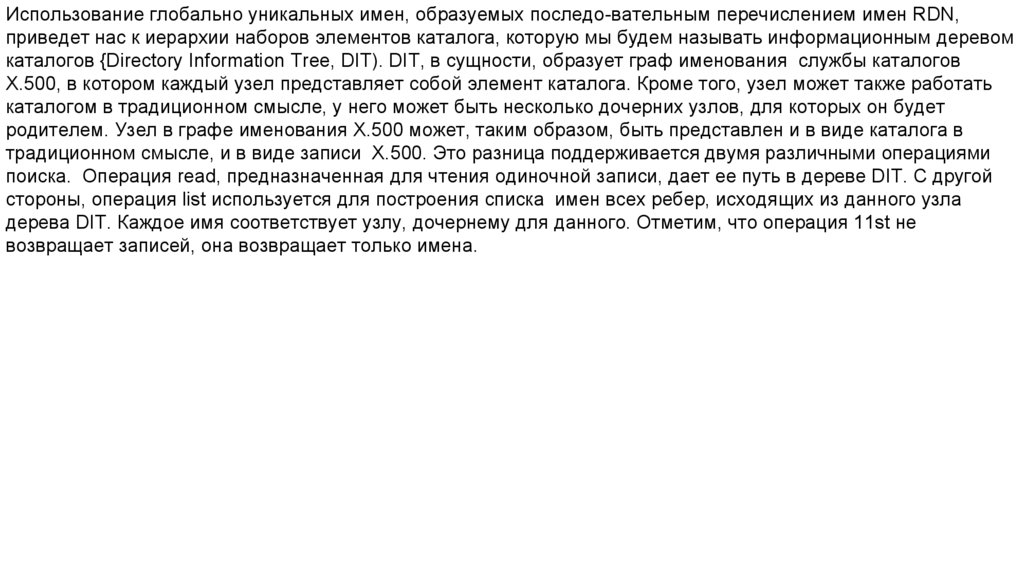

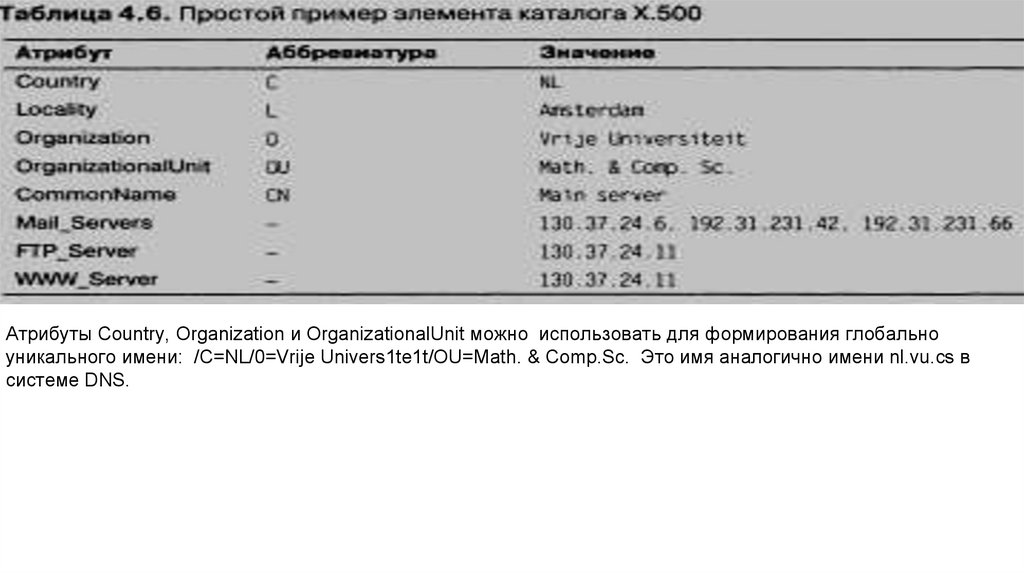

Использование глобально уникальных имен, образуемых последо-вательным перечислением имен RDN,приведет нас к иерархии наборов элементов каталога, которую мы будем называть информационным деревом

каталогов {Directory Information Tree, DIT). DIT, в сущности, образует граф именования службы каталогов

Х.500, в котором каждый узел представляет собой элемент каталога. Кроме того, узел может также работать

каталогом в традиционном смысле, у него может быть несколько дочерних узлов, для которых он будет

родителем. Узел в графе именования Х.500 может, таким образом, быть представлен и в виде каталога в

традиционном смысле, и в виде записи Х.500. Это разница поддерживается двумя различными операциями

поиска. Операция read, предназначенная для чтения одиночной записи, дает ее путь в дереве DIT. С другой

стороны, операция list используется для построения списка имен всех ребер, исходящих из данного узла

дерева DIT. Каждое имя соответствует узлу, дочернему для данного. Отметим, что операция 11st не

возвращает записей, она возвращает только имена.

55.

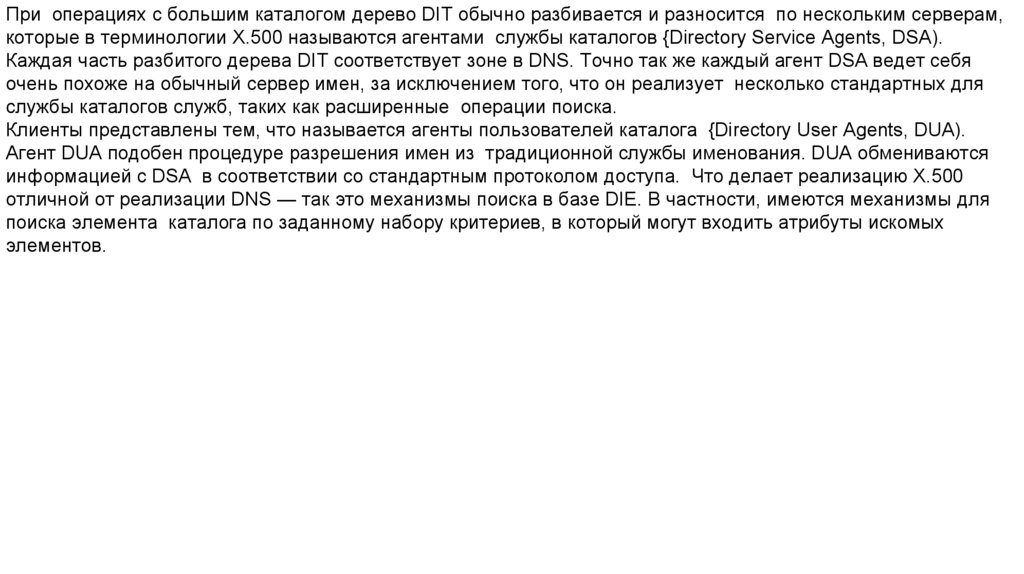

При операциях с большим каталогом дерево DIT обычно разбивается и разносится по нескольким серверам,которые в терминологии Х.500 называются агентами службы каталогов {Directory Service Agents, DSA).

Каждая часть разбитого дерева DIT соответствует зоне в DNS. Точно так же каждый агент DSA ведет себя

очень похоже на обычный сервер имен, за исключением того, что он реализует несколько стандартных для

службы каталогов служб, таких как расширенные операции поиска.

Клиенты представлены тем, что называется агенты пользователей каталога {Directory User Agents, DUA).

Агент DUA подобен процедуре разрешения имен из традиционной службы именования. DUA обмениваются

информацией с DSA в соответствии со стандартным протоколом доступа. Что делает реализацию Х.500

отличной от реализации DNS — так это механизмы поиска в базе DIE. В частности, имеются механизмы для

поиска элемента каталога по заданному набору критериев, в который могут входить атрибуты искомых

элементов.

56.

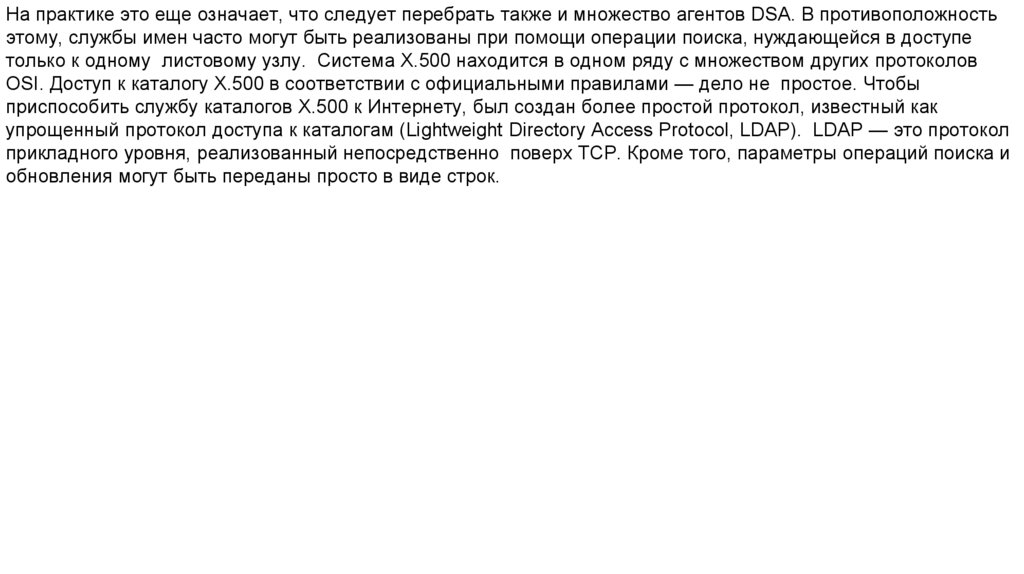

На практике это еще означает, что следует перебрать также и множество агентов DSA. В противоположностьэтому, службы имен часто могут быть реализованы при помощи операции поиска, нуждающейся в доступе

только к одному листовому узлу. Система Х.500 находится в одном ряду с множеством других протоколов

OSI. Доступ к каталогу Х.500 в соответствии с официальными правилами — дело не простое. Чтобы

приспособить службу каталогов Х.500 к Интернету, был создан более простой протокол, известный как

упрощенный протокол доступа к каталогам (Lightweight Directory Access Protocol, LDAP). LDAP — это протокол

прикладного уровня, реализованный непосредственно поверх TCP. Кроме того, параметры операций поиска и

обновления могут быть переданы просто в виде строк.

57.

Для эффективной реализации полномасштабного пространства имен, такого как в DNS, удобно разбитьпространство имен на три уровня. Глобальный и административный уровни характеризуются тем, что

содержимое узлов этих частей пространства имен относительно постоянно. Вследствие этого репликация и

кэширование способны повысить эффективность реализации. Содержимое узлов управленческого уровня

часто изменяется. Поэтому производительность операций поиска и обновления на этом уровне можно

удовлетворить путем реализации узлов на локальных высокопроизводительных серверах имен.

58.

Z39.50 — клиент-серверный протокол для поиска и получения ин-формации с удаленных компьютерных базданных. Он описывается ANSI/NISO стандартом Z39.50, а также ISO-стандартом 23950. Основное агентство,

которое обслуживает стандарт — библиотека Конгресса. Широко применим в библиотечных кругах и часто

вклю-чен в автоматизированные библиотечные информационные системы и персональные системы

управления библиографической информа-цией. Межбиблиотечные поисковые каталоги для межбиблиотечного абонемента часто реализованы через запросы Z39.50. Протокол Z39.50 используется с 1970-х годов,

обновлённые версии выходили в 1988, 1992, 1995 и 2003 годах. На семантике протокола Z39.50 основан

универсальный язык запросов Contextual Query Language (CQL, ранее — Common Query Language).

Z39.50 наиболее часто используется для запросов к библиографи-ческим базам данных, представленным в

формате MARC, поэтому эти два стандарта обычно связывают между собой. Но, на самом деле, Z39.50 может

использоваться для доступа к данным, представ-ленным и в других форматах.

59.

Протокол Z39.50 поддерживает ряд функций, в том числе поиск, выборку, сортировку и просмотр. Поисковыезапросы формулируются с помощью атрибутов, как правило, из набора BIB-1, включающего в себя шесть

атрибутов, использующихся при поиске информации на сервере: использование, отношение, положение,

структура, усечение, полнота. Синтаксис протокола Z39.50 позволяет формулировать очень сложные запросы.

интаксис Z39.50 не привязан к структуре конкретной базы данных. Это позволяет формулировать без

необходимости знать что-либо о целевой базе данных; но это также означает, что результаты одного и того же

запроса могут варьироваться в широких пределах между различными серверами. Один сервер может

обратиться к индексу автора; другой, например, к индексу личных имен, вне зависимости от того, являются ли

они авторами; третий может не иметь индекса названия и перейти к поиску по индексу ключевых слов; а

четвёр-тый может вообще возвращать ошибку.

60.

Постольку, поскольку Z39.50 был разработан очень давно, он не очень хорошо сочетается с современнойинфраструктурой веб.

Библиотекой Конгресса США была разработана пара протоколов SRU/SRW (Search/Retrieve via URL и

Search/Retrieve Web service), которые позволяют выполнять запросы на Contextual Query Language, но

использовать HTTP в качестве транспорта. Они призваны заменить собой Z39.50, но, в настоящее время,

сосуществуют с ним. SRU — это REST-протокол, SRW использует технологию SOAP. Оба протокола работают

со структурами данных в формате XML и являются функционально идентичными.

61.

Основные службы протокола Z39.50В самом протоколе объявлены 11 сервисов, которые и выполняют весь спектр действий предусмотренных в

протоколе:

• служба Init: инициализирует Z-ассоциацию, и позволяет клиенту и серверу обменяться информацией о

поддерживаемых службах.

• служба Search: создает результирующее множество в соответствии с заданными клиентом критериями

поиска.

В качестве средства для отбора записей предусмотрено три типа запросов: 0, 1, 101.

• 0 – это запрос с произвольным синтаксисом.

• 1 – это запрос, записываемый в обратной польской записи (RPN) с операторами AND, OR, ANDNOT (язык,

равносильный STAIRS).

• 101 – запрос аналогичный 1, но с дополнительным оператором PROXY, описывающим синтагматическую

близость связываемых этим оператором терминов в тексте искомой записи.

62.

В качестве терминов используется текст, сопряженный с произволь-ным набором атрибутов, несущих какслужебную, так и поисковую информацию. В качестве результата служба возвращает идентифи-катор

результирующего множества и его мощность.

• служба Present: отвечает за передачу записей между клиентом и сервером. Передача предусматривает

выбор синтаксиса (если это необходимо), также возможна сегментация результирующего множества и/или

отдельных документов.

• служба Scan: осуществляет сканирование базы данных с целью извлечения терминов для поиска и

предоставления их списка клиенту. В качестве параметров принимает термин-шаблон, размер шага,

количество возвращаемых терминов.

• служба Explain: позволяет клиенту получать с сервера необходи-мую для поиска и настройки

вспомогательную информацию. В протоколе существуют специализированные форматы, призванные

описывать синтаксисы поддерживаемых форматов, подключенные к серверу базы данных, поддерживаемые

наборы атрибутов и т.д.

63.

служба Sort: осуществляет сортировку результирующего множества.• служба delResSet: позволяет клиенту удалять созданные им результирующие множества.

Остальные службы протокола имеют вспомогательный характер и не относятся непосредственно к процедуре

поиска. Особняком стоит слежба ExtendedService, которая позволяет присоединять к основным службам

протокола произвольные службы, создаваемые владельцами сервера. Z39.50 – это попытка

стандартизировать про-цедуру поиска. За счет этого можно строить различные поисковые системы, с самой

различной архитектурой. На сегодняшний момент протокол широко используется в области поиска

библиографичес-кой информации [LOC] , для обслуживания программы GILS (Government Information Locator

Service[GILS1] в США; Global Information Locator Service [GILS2] и в других странах), в медицин-ских базах

данных и в экологических[GELOS] и геодезических про-граммах типа FGDC [FGDC] ,

64.

а также в распределенных географических информационных системах ArcView[ESRI] и многочисленныхдругих[NSDI] ). Перечень URL со ссылками на географические ИПС можно найти, например, на сервере "GIS

Online В настоящее время протокол развит настолько, что позволяет обрабатывать различные данные —

финансовую, химическую, техническую информацию, тексты и изображения.

Технология сетевого доступа к базам данных по протоколу Z39.50 существенно отличается от других

технологий. Различие обусловлено самой сутью протокола: его ориентацией на работу с базами данных,

абстрагированных от конкретных систем.

65.

Минимальная конфигурация системы на основе Z39.50 –это програ-мма-сервер + программа-клиент, вбольшинстве случаев связанные между собою по сети TCP/IP – через Интернет (Z39.50 входит в число

"известных служб", и имеет порт 210). Также в эту конфигу-рацию могут добавляться программы-шлюзы,

тезаурусы, PROXY-серверы и др. средства.

Существующие реализации протокола, необходимо подразделить эти реализации на четыре категории:

• серверные части

• клиентские части

• программы-шлюзы

• вспомогательное программное обеспечение

Серверные части протокола Z39.50 представлены в двух категориях: коммерческие и бесплатные. Среди

коммерческих серверных программ (всего их насчитывается более 20) наиболее выделяется сервер Z39.

66.

MetaStar компании BlueAngel Technologies, который обладает большим набором возможностей и во всейполноте реализует протокол. Среди бесплатных серверов существуют лишь два: Isite, разрабатываемый

организацией CNIDR и Zebra server, разрабатыва-емый датской компаний еndexdata. Каждая серверная

реализация протокола обладает собственной, зачастую нигде более не встречаемой спецификой. К примеру,

Isite не поддерживает именование результатов и оператор PROXY, но корректно поддерживает индексацию

кириллицы на платформе Windows NT, а Zebra server Наоборот

Все реализации также существенно различаются по типам хранимых данных (тех, для которых могут быть

построены индексы, хранящие значения точек входа): например MetaStar ориентирован на формат XML, Isite

поддерживает SGML, HTML, и др., а Zebra – GRS-1, Text, MARC. Т.е. то, что в стандарте объявлено

универсальным, на практике создает проблему совместимости.

67.

Среди клиентских программ можно выделить две категории: специализированные клиенты, предназначенныедля работы со строго определенными серверами или данными (прежде всего, библиотечные клиенты) и

универсальные, способные конфигури-роваться под каждую конкретную задачу (Znavigator, Willow).

68.

Состав протокола Z39.50. В основе Z39.50 лежит модель абстрактной базы данных. Каждый элемент этоймодели имеет описание с однозначным толкованием и стандартизуется с присвоением уникального

идентификатора — OID.

Термин база данных в спецификации Z39.50 означает набор файлов каждый из которых имеет свое уникальное

имя. Единицей хранения информации, которая может быть найдена при обращении к базе данных, является

запись файла. Все записи одного файла должны иметь одинаковую структуру (т. е. состоять из одного и того же

набора элементов и точек доступа). Точка доступа — это уникальный или неуникальный ключ, который может

быть указан самостоятельно или в совокупности с другими ключами в поисковом критерии. Ключ может быть

элементом данных, состоять из нескольких элементов или быть частью элемента. Работа с каждой конкретной

СУБД согласно Z39.50 должна быть организована только через эту абстрактную модель путем обмена пакетами

данных (PDU), содержащими последовательности объектов, идентифицируемых по меткам. В стандарте описаны

следующие классы объектов:

69.

• контекст приложения (context);• протокольные блоки данных — protocol data unit (pdu);

• атрибуты (attributeset);

• диагностика (diagnostic);

• структура записей (recordsyntax);

• синтаксис преобразований (transfersyntax);

• отчет по ресурсам (resourcereport);

• контроль доступа (accesscontrol);

• расширенный сервис (extendedservice);

• пользовательская информация (userinfoformat);

• элементы (elementspec);

• варианты (variantset);

• схема данных (schema);

• схема меток (tagset).

70.

71.

Рассмотрим службу каталогов OSI Х.500. Несмотря на то что службы каталогов доступны уже болеедесятилетия, они стали особенно популярными лишь недавно в виде упрощенных версий, реализованных как

службы Интернета.

Концептуально служба каталогов Х.500 состоит из множества записей, которые обычно называются

элементами каталога. Элемент каталога в Х.500 похож на запись о ресурсах системы DNS. Каждая запись

состоит из набора пар (атрибут, значение), причем каждый атрибут имеет ассоциированный с ним тип.

Различаются атрибуты с одним значением (однозначные) и атрибу-ты с несколькими значениями

(многозначные), которые представ-ляют собой массивы или списки. Набор всех элементов каталога службы

каталогов Х.500 называется информационной базой ката-лога {Directory Information Base, DIB), каждая запись в

DIB имеет уникальное имя, чтобы ее можно было найти. Глобально уникаль-ное имя получается из

последовательности атрибутов именования каждой записи. Каждый атрибут именования называется относительно различимым именем {Relative Distinguished Name, RDN)

72.

Атрибуты Country, Organization и OrganizationalUnit можно использовать для формирования глобальноуникального имени: /C=NL/0=Vrije Univers1te1t/OU=Math. & Comp.Sc. Это имя аналогично имени nl.vu.cs в

системе DNS.

73.

Использование глобально уникальных имен, образуемых последо-вательным перечислением имен RDN,приведет нас к иерархии наборов элементов каталога, которую мы будем называть информационным деревом

каталогов {Directory Information Tree, DIT). DIT, в сущности, образует граф именования службы каталогов

Х.500, в котором каждый узел представляет собой элемент каталога. Кроме того, узел может также работать

каталогом в традиционном смысле, у него может быть несколько дочерних узлов, для которых он будет

родителем. Узел в графе именования Х.500 может, таким образом, быть представлен и в виде каталога в

традиционном смысле, и в виде записи Х.500. Это разница поддерживается двумя различными операциями

поиска. Операция read, предназначенная для чтения одиночной записи, дает ее путь в дереве DIT. С другой

стороны, операция list используется для построения списка имен всех ребер, исходящих из данного узла

дерева DIT. Каждое имя соответствует узлу, дочернему для данного. Отметим, что операция 11st не

возвращает записей, она возвращает только имена.

74.

При операциях с большим каталогом дерево DIT обычно разбивается и разносится по нескольким серверам,которые в терминологии Х.500 называются агентами службы каталогов {Directory Service Agents, DSA).

Каждая часть разбитого дерева DIT соответствует зоне в DNS. Точно так же каждый агент DSA ведет себя

очень похоже на обычный сервер имен, за исключением того, что он реализует несколько стандартных для

службы каталогов служб, таких как расширенные операции поиска.

Клиенты представлены тем, что называется агенты пользователей каталога {Directory User Agents, DUA).

Агент DUA подобен процедуре разрешения имен из традиционной службы именования. DUA обмениваются

информацией с DSA в соответствии со стандартным протоколом доступа. Что делает реализацию Х.500

отличной от реализации DNS — так это механизмы поиска в базе DIE. В частности, имеются механизмы для

поиска элемента каталога по заданному набору критериев, в который могут входить атрибуты искомых

элементов.

75.

На практике это еще означает, что следует перебрать также и множество агентов DSA. В противоположностьэтому, службы имен часто могут быть реализованы при помощи операции поиска, нуждающейся в доступе

только к одному листовому узлу. Система Х.500 находится в одном ряду с множеством других протоколов

OSI. Доступ к каталогу Х.500 в соответствии с официальными правилами — дело не простое. Чтобы

приспособить службу каталогов Х.500 к Интернету, был создан более простой протокол, известный как

упрощенный протокол доступа к каталогам (Lightweight Directory Access Protocol, LDAP). LDAP — это протокол

прикладного уровня, реализованный непосредственно поверх TCP. Кроме того, параметры операций поиска и

обновления могут быть переданы просто в виде строк.

76.

Для эффективной реализации полномасштабного пространства имен, такого как в DNS, удобно разбитьпространство имен на три уровня. Глобальный и административный уровни характеризуются тем, что

содержимое узлов этих частей пространства имен относительно постоянно. Вследствие этого репликация и

кэширование способны повысить эффективность реализации. Содержимое узлов управленческого уровня

часто изменяется. Поэтому производительность операций поиска и обновления на этом уровне можно

удовлетворить путем реализации узлов на локальных высокопроизводительных серверах имен.

77.

Z39.50 — клиент-серверный протокол для поиска и получения ин-формации с удаленных компьютерных базданных. Он описывается ANSI/NISO стандартом Z39.50, а также ISO-стандартом 23950. Основное агентство,

которое обслуживает стандарт — библиотека Конгресса. Широко применим в библиотечных кругах и часто

вклю-чен в автоматизированные библиотечные информационные системы и персональные системы

управления библиографической информа-цией. Межбиблиотечные поисковые каталоги для межбиблиотечного абонемента часто реализованы через запросы Z39.50. Протокол Z39.50 используется с 1970-х годов,

обновлённые версии выходили в 1988, 1992, 1995 и 2003 годах. На семантике протокола Z39.50 основан

универсальный язык запросов Contextual Query Language (CQL, ранее — Common Query Language).

Z39.50 наиболее часто используется для запросов к библиографи-ческим базам данных, представленным в

формате MARC, поэтому эти два стандарта обычно связывают между собой. Но, на самом деле, Z39.50 может

использоваться для доступа к данным, представ-ленным и в других форматах.

78.

Протокол Z39.50 поддерживает ряд функций, в том числе поиск, выборку, сортировку и просмотр. Поисковыезапросы формулируются с помощью атрибутов, как правило, из набора BIB-1, включающего в себя шесть

атрибутов, использующихся при поиске информации на сервере: использование, отношение, положение,

структура, усечение, полнота. Синтаксис протокола Z39.50 позволяет формулировать очень сложные запросы.

интаксис Z39.50 не привязан к структуре конкретной базы данных. Это позволяет формулировать без

необходимости знать что-либо о целевой базе данных; но это также означает, что результаты одного и того же

запроса могут варьироваться в широких пределах между различными серверами. Один сервер может

обратиться к индексу автора; другой, например, к индексу личных имен, вне зависимости от того, являются ли

они авторами; третий может не иметь индекса названия и перейти к поиску по индексу ключевых слов; а

четвёр-тый может вообще возвращать ошибку.

79.

Постольку, поскольку Z39.50 был разработан очень давно, он не очень хорошо сочетается с современнойинфраструктурой веб.

Библиотекой Конгресса США была разработана пара протоколов SRU/SRW (Search/Retrieve via URL и

Search/Retrieve Web service), которые позволяют выполнять запросы на Contextual Query Language, но

использовать HTTP в качестве транспорта. Они призваны заменить собой Z39.50, но, в настоящее время,

сосуществуют с ним. SRU — это REST-протокол, SRW использует технологию SOAP. Оба протокола работают

со структурами данных в формате XML и являются функционально идентичными.

80.

Основные службы протокола Z39.50В самом протоколе объявлены 11 сервисов, которые и выполняют весь спектр действий предусмотренных в

протоколе:

• служба Init: инициализирует Z-ассоциацию, и позволяет клиенту и серверу обменяться информацией о

поддерживаемых службах.

• служба Search: создает результирующее множество в соответствии с заданными клиентом критериями

поиска.

В качестве средства для отбора записей предусмотрено три типа запросов: 0, 1, 101.

• 0 – это запрос с произвольным синтаксисом.

• 1 – это запрос, записываемый в обратной польской записи (RPN) с операторами AND, OR, ANDNOT (язык,

равносильный STAIRS).

• 101 – запрос аналогичный 1, но с дополнительным оператором PROXY, описывающим синтагматическую

близость связываемых этим оператором терминов в тексте искомой записи.

81.

В качестве терминов используется текст, сопряженный с произволь-ным набором атрибутов, несущих какслужебную, так и поисковую информацию. В качестве результата служба возвращает идентифи-катор

результирующего множества и его мощность.

• служба Present: отвечает за передачу записей между клиентом и сервером. Передача предусматривает

выбор синтаксиса (если это необходимо), также возможна сегментация результирующего множества и/или

отдельных документов.

• служба Scan: осуществляет сканирование базы данных с целью извлечения терминов для поиска и

предоставления их списка клиенту. В качестве параметров принимает термин-шаблон, размер шага,

количество возвращаемых терминов.

• служба Explain: позволяет клиенту получать с сервера необходи-мую для поиска и настройки

вспомогательную информацию. В протоколе существуют специализированные форматы, призванные

описывать синтаксисы поддерживаемых форматов, подключенные к серверу базы данных, поддерживаемые

наборы атрибутов и т.д.

82.

служба Sort: осуществляет сортировку результирующего множества.• служба delResSet: позволяет клиенту удалять созданные им результирующие множества.

Остальные службы протокола имеют вспомогательный характер и не относятся непосредственно к процедуре

поиска. Особняком стоит слежба ExtendedService, которая позволяет присоединять к основным службам

протокола произвольные службы, создаваемые владельцами сервера. Z39.50 – это попытка

стандартизировать про-цедуру поиска. За счет этого можно строить различные поисковые системы, с самой

различной архитектурой. На сегодняшний момент протокол широко используется в области поиска

библиографичес-кой информации [LOC] , для обслуживания программы GILS (Government Information Locator

Service[GILS1] в США; Global Information Locator Service [GILS2] и в других странах), в медицин-ских базах

данных и в экологических[GELOS] и геодезических про-граммах типа FGDC [FGDC] ,

83.

а также в распределенных географических информационных системах ArcView[ESRI] и многочисленныхдругих[NSDI] ). Перечень URL со ссылками на географические ИПС можно найти, например, на сервере "GIS

Online В настоящее время протокол развит настолько, что позволяет обрабатывать различные данные —

финансовую, химическую, техническую информацию, тексты и изображения.

Технология сетевого доступа к базам данных по протоколу Z39.50 существенно отличается от других

технологий. Различие обусловлено самой сутью протокола: его ориентацией на работу с базами данных,

абстрагированных от конкретных систем.

84.

Минимальная конфигурация системы на основе Z39.50 –это програ-мма-сервер + программа-клиент, вбольшинстве случаев связанные между собою по сети TCP/IP – через Интернет (Z39.50 входит в число

"известных служб", и имеет порт 210). Также в эту конфигу-рацию могут добавляться программы-шлюзы,

тезаурусы, PROXY-серверы и др. средства.

Существующие реализации протокола, необходимо подразделить эти реализации на четыре категории:

• серверные части

• клиентские части

• программы-шлюзы

• вспомогательное программное обеспечение

Серверные части протокола Z39.50 представлены в двух категориях: коммерческие и бесплатные. Среди

коммерческих серверных программ (всего их насчитывается более 20) наиболее выделяется сервер Z39.

85.

MetaStar компании BlueAngel Technologies, который обладает большим набором возможностей и во всейполноте реализует протокол. Среди бесплатных серверов существуют лишь два: Isite, разрабатываемый

организацией CNIDR и Zebra server, разрабатыва-емый датской компаний еndexdata. Каждая серверная

реализация протокола обладает собственной, зачастую нигде более не встречаемой спецификой. К примеру,

Isite не поддерживает именование результатов и оператор PROXY, но корректно поддерживает индексацию

кириллицы на платформе Windows NT, а Zebra server Наоборот

Все реализации также существенно различаются по типам хранимых данных (тех, для которых могут быть

построены индексы, хранящие значения точек входа): например MetaStar ориентирован на формат XML, Isite

поддерживает SGML, HTML, и др., а Zebra – GRS-1, Text, MARC. Т.е. то, что в стандарте объявлено

универсальным, на практике создает проблему совместимости.

86.

Среди клиентских программ можно выделить две категории: специализированные клиенты, предназначенныедля работы со строго определенными серверами или данными (прежде всего, библиотечные клиенты) и

универсальные, способные конфигури-роваться под каждую конкретную задачу (Znavigator, Willow).

87.

Состав протокола Z39.50. В основе Z39.50 лежит модель абстрактной базы данных. Каждый элемент этоймодели имеет описание с однозначным толкованием и стандартизуется с присвоением уникального

идентификатора — OID.

Термин база данных в спецификации Z39.50 означает набор файлов каждый из которых имеет свое уникальное

имя. Единицей хранения информации, которая может быть найдена при обращении к базе данных, является

запись файла. Все записи одного файла должны иметь одинаковую структуру (т. е. состоять из одного и того же

набора элементов и точек доступа). Точка доступа — это уникальный или неуникальный ключ, который может

быть указан самостоятельно или в совокупности с другими ключами в поисковом критерии. Ключ может быть

элементом данных, состоять из нескольких элементов или быть частью элемента. Работа с каждой конкретной

СУБД согласно Z39.50 должна быть организована только через эту абстрактную модель путем обмена пакетами

данных (PDU), содержащими последовательности объектов, идентифицируемых по меткам. В стандарте описаны

следующие классы объектов:

88.

• контекст приложения (context);• протокольные блоки данных — protocol data unit (pdu);

• атрибуты (attributeset);

• диагностика (diagnostic);

• структура записей (recordsyntax);

• синтаксис преобразований (transfersyntax);

• отчет по ресурсам (resourcereport);

• контроль доступа (accesscontrol);

• расширенный сервис (extendedservice);

• пользовательская информация (userinfoformat);

• элементы (elementspec);

• варианты (variantset);

• схема данных (schema);

• схема меток (tagset).

89.

90.

Хранилища многомерных данных(Data Warehouse)Определение, сформулированное "отцом-основателем" хранилищ данных Биллом

Инмоном: "Хранилище данных - это предметно-ориентированное, привязанное ко времени

и неизменяемое собрание данных для поддержки процесса принятия управляющих

решений". Данные в хранилище попадают из оперативных систем (OLTP-систем), которые

предназначены для автоматизации бизнес-процессов. Кроме того, хранилище может

пополняться за счет внешних источников, например статистических отчетов.

Под хранилищем можно понимать не обязательно гигантское скопление данных - главное,

чтобы оно было удобно для анализа. Для маленьких хранилищ предназначается отдельный

термин - Data Marts (киоски данных).

91.

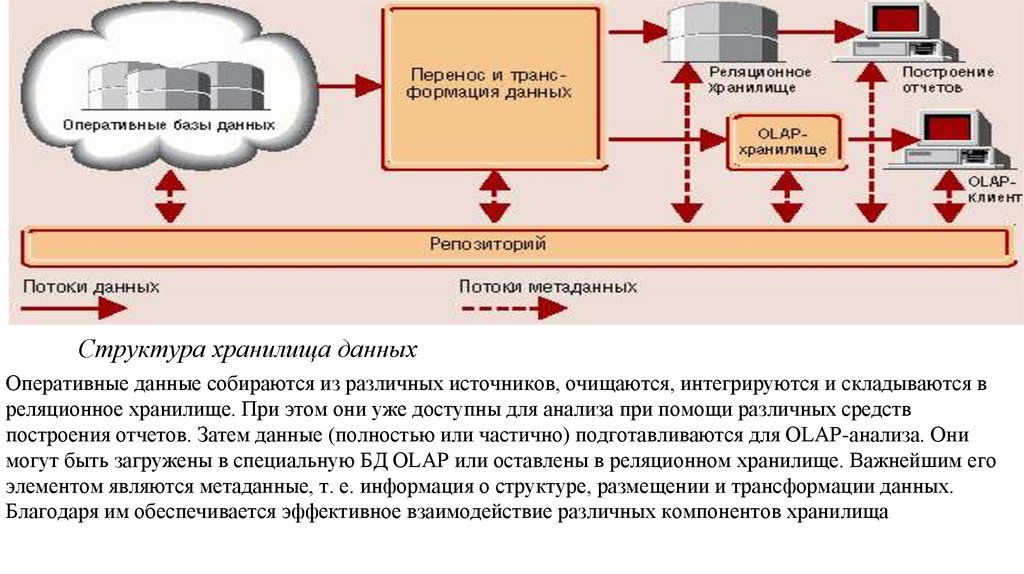

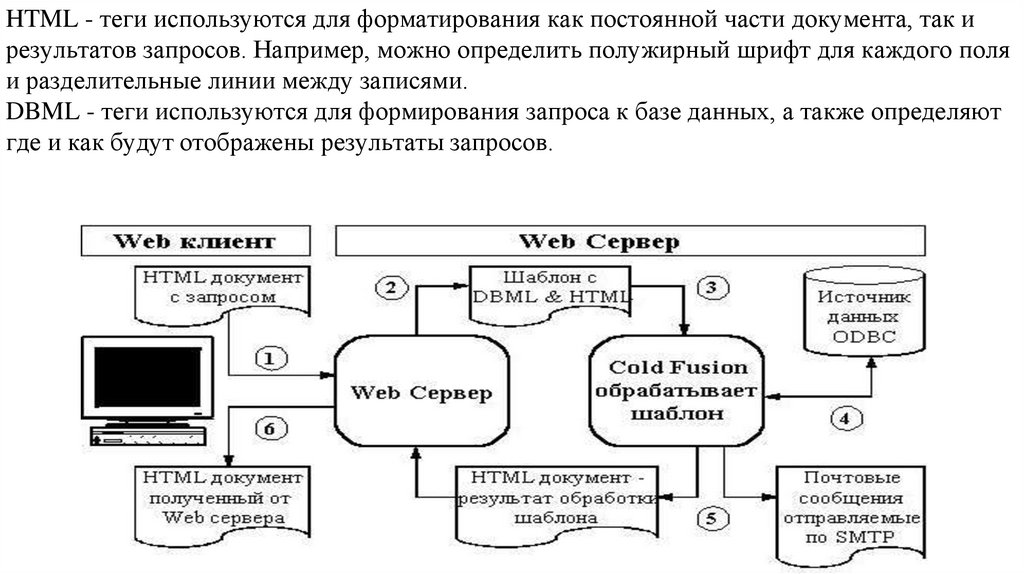

Структура хранилища данныхОперативные данные собираются из различных источников, очищаются, интегрируются и складываются в

реляционное хранилище. При этом они уже доступны для анализа при помощи различных средств

построения отчетов. Затем данные (полностью или частично) подготавливаются для OLAP-анализа. Они

могут быть загружены в специальную БД OLAP или оставлены в реляционном хранилище. Важнейшим его

элементом являются метаданные, т. е. информация о структуре, размещении и трансформации данных.

Благодаря им обеспечивается эффективное взаимодействие различных компонентов хранилища

92.

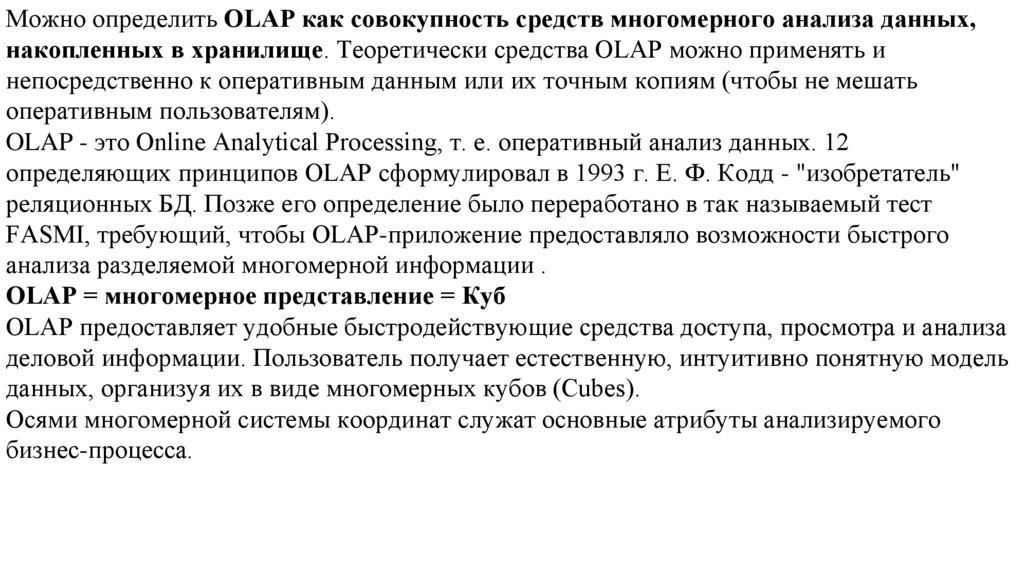

Можно определить OLAP как совокупность средств многомерного анализа данных,накопленных в хранилище. Теоретически средства OLAP можно применять и

непосредственно к оперативным данным или их точным копиям (чтобы не мешать

оперативным пользователям).

OLAP - это Online Analytical Processing, т. е. оперативный анализ данных. 12

определяющих принципов OLAP сформулировал в 1993 г. Е. Ф. Кодд - "изобретатель"

реляционных БД. Позже его определение было переработано в так называемый тест

FASMI, требующий, чтобы OLAP-приложение предоставляло возможности быстрого

анализа разделяемой многомерной информации .

OLAP = многомерное представление = Куб

OLAP предоставляет удобные быстродействующие средства доступа, просмотра и анализа

деловой информации. Пользователь получает естественную, интуитивно понятную модель

данных, организуя их в виде многомерных кубов (Cubes).

Осями многомерной системы координат служат основные атрибуты анализируемого

бизнес-процесса.

93.

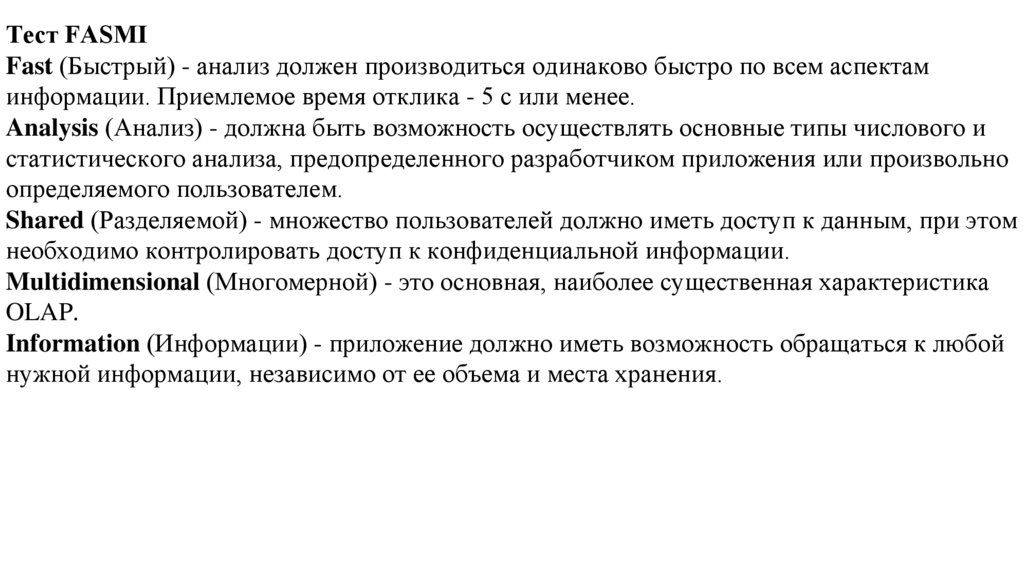

Тест FASMIFast (Быстрый) - анализ должен производиться одинаково быстро по всем аспектам

информации. Приемлемое время отклика - 5 с или менее.

Analysis (Анализ) - должна быть возможность осуществлять основные типы числового и

статистического анализа, предопределенного разработчиком приложения или произвольно

определяемого пользователем.

Shared (Разделяемой) - множество пользователей должно иметь доступ к данным, при этом

необходимо контролировать доступ к конфиденциальной информации.

Multidimensional (Многомерной) - это основная, наиболее существенная характеристика

OLAP.

Information (Информации) - приложение должно иметь возможность обращаться к любой

нужной информации, независимо от ее объема и места хранения.

94.

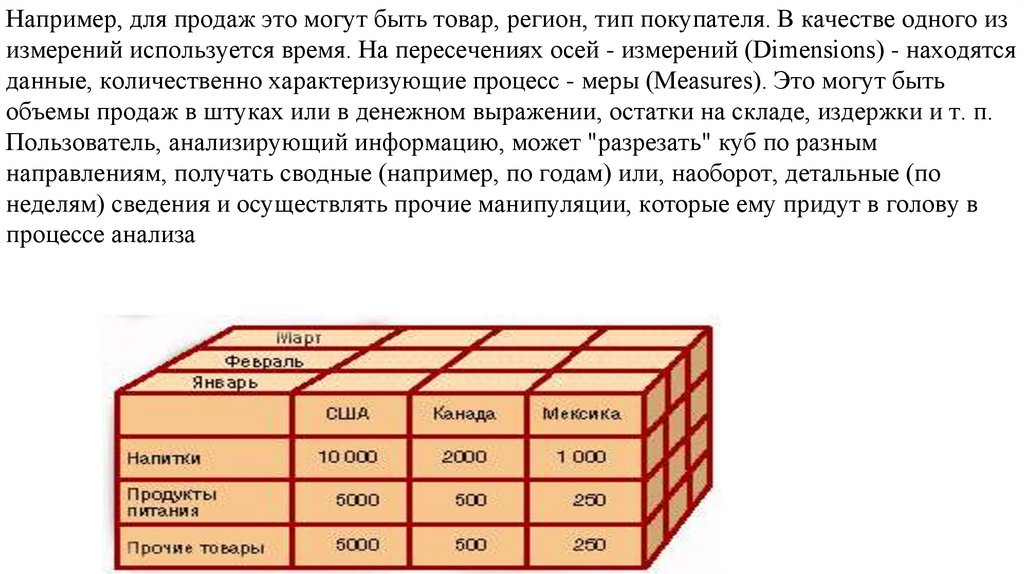

Например, для продаж это могут быть товар, регион, тип покупателя. В качестве одного изизмерений используется время. На пересечениях осей - измерений (Dimensions) - находятся

данные, количественно характеризующие процесс - меры (Measures). Это могут быть

объемы продаж в штуках или в денежном выражении, остатки на складе, издержки и т. п.

Пользователь, анализирующий информацию, может "разрезать" куб по разным

направлениям, получать сводные (например, по годам) или, наоборот, детальные (по

неделям) сведения и осуществлять прочие манипуляции, которые ему придут в голову в

процессе анализа

95.

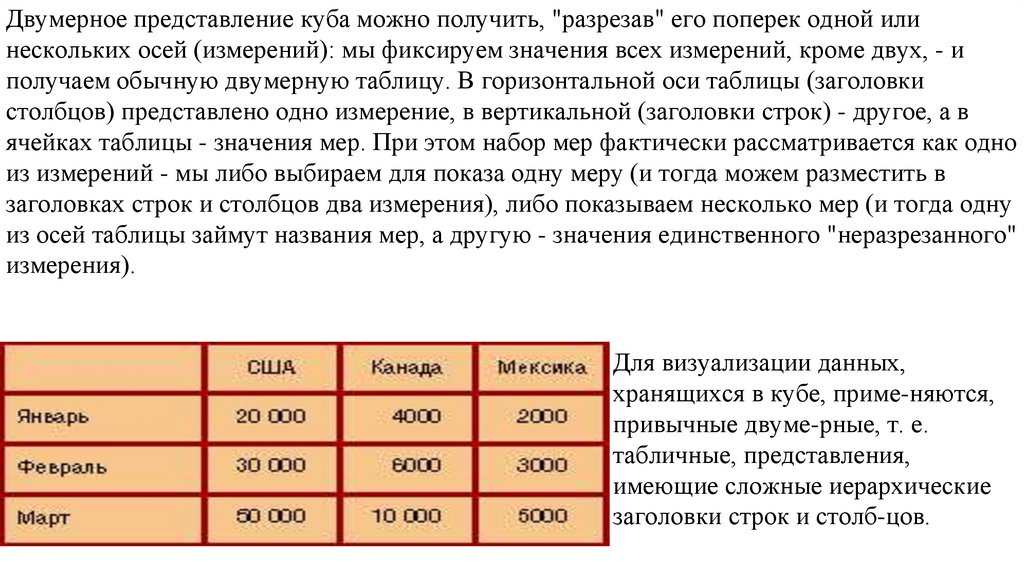

Двумерное представление куба можно получить, "разрезав" его поперек одной илинескольких осей (измерений): мы фиксируем значения всех измерений, кроме двух, - и

получаем обычную двумерную таблицу. В горизонтальной оси таблицы (заголовки

столбцов) представлено одно измерение, в вертикальной (заголовки строк) - другое, а в

ячейках таблицы - значения мер. При этом набор мер фактически рассматривается как одно

из измерений - мы либо выбираем для показа одну меру (и тогда можем разместить в

заголовках строк и столбцов два измерения), либо показываем несколько мер (и тогда одну

из осей таблицы займут названия мер, а другую - значения единственного "неразрезанного"

измерения).

Для визуализации данных,

хранящихся в кубе, приме-няются,

привычные двуме-рные, т. е.

табличные, представления,

имеющие сложные иерархические

заголовки строк и столб-цов.

96.

Двумерный срезкуба для нескольких

мер

Двумерный срез куба с несколькими измерениями на одной оси

97.

МеткиЗначения, "откладываемые" вдоль измерений, называются членами или метками (members).

Метки используются как для "разрезания" куба, так и для ограничения (фильтрации)

выбираемых данных - когда в измерении, остающемся "неразрезанным", нас интересуют не

все значения, а их подмножество, например три города из нескольких десятков. Значения

меток отображаются в двумерном представлении куба как заголовки строк и столбцов.

Иерархии и уровни

Метки могут объединяться в иерархии, состоящие из одного или нескольких уровней

(levels). Например, метки измерения "Магазин" (Store) естественно объединяются в

иерархию с уровнями:

All (Мир)

Country (Страна)

State (Штат)

City (Город)

Store (Магазин).

98.

Многомерность в OLAP-приложениях может быть разделена на три уровня:* Многомерное представление данных - средства конечного пользователя,

обеспечивающие многомерную визуализацию и манипулирование данными; слой

многомерного представления абстрагирован от физической структуры данных и

воспринимает данные как многомерные.

* Многомерная обработка - средство (язык) формулирования многомерных запросов

(традиционный реляционный язык SQL здесь оказывается непригодным) и процессор,

умеющий обработать и выполнить такой запрос.

* Многомерное хранение - средства физической организации данных, обеспечивающие

эффективное выполнение многомерных запросов.

99.

Первые два уровня в обязательном порядке присутствуют во всех OLAP-средствах. Третийуровень, хотя и является широко распространенным, не обязателен, так как данные для

многомерного представления могут извлекаться и из обычных реляционных структур;

процессор многомерных запросов в этом случае транслирует многомерные запросы в SQLзапросы, которые выполняются реляционной СУБД.

Конкретные OLAP-продукты, как правило, представляют собой либо средство

многомерного представления данных, OLAP-клиент (например, Pivot Tables в Excel 2000

фирмы Microsoft или ProClarity фирмы Knosys), либо многомерную серверную СУБД,

OLAP-сервер (например, Oracle Express Server или Microsoft OLAP Services).

Слой многомерной обработки обычно бывает встроен в OLAP-клиент и/или в OLAPсервер, но может быть выделен в чистом виде, как, например, компонент Pivot Table

Service фирмы Microsoft.

100.

Средства OLAP-анализа могут извлекать данные и непосредственно из реляционныхсистем.

Такой подход был более привлекательным в те времена, когда OLAP-серверы

отсутствовали в прайс-листах ведущих производителей СУБД. Но сегодня и Oracle, и

Informix, и Microsoft предлагают полноценные OLAP-серверы, и даже те IT-менеджеры,

которые не любят разводить в своих сетях "зоопарк" из ПО разных производителей, могут

купить (точнее, обратиться с соответствую-щей просьбой к руководству компании) OLAPсервер той же марки, что и основной сервер баз данных.

OLAP-серверы, или серверы многомерных БД, могут хранить свои многомерные данные

по-разному

В любом хранилище данных - и в обычном, и в многомерном - наряду с детальными

данными, извлекаемыми из оперативных систем, хранятся и суммарные показатели

(агрегированные показатели, агрегаты), такие, как суммы объемов продаж по месяцам, по

категориям товаров и т. п. Агрегаты хранятся в явном виде с единственной целью ускорить выполнение запросов.

101.

Поэтому при загрузке данных в многомерную БД вычисляются и сохраняются всесуммарные показатели или их часть

Но, как известно, за все надо платить. И за скорость обработки запросов к суммарным

данным приходится платить увеличением объемов данных и времени на их загрузку.

Причем увеличение объема может стать буквально катастрофическим - в одном из

опубликованных стандартных тестов полный подсчет агрегатов для 10 Мб исходных

данных потребовал 2,4 Гб, т. е. данные выросли в 240 раз! Степень "разбухания" данных

при вычислении агрегатов зависит от количества измерений куба и структуры этих

измерений, т. е. соотношения количества "отцов" и "детей" на разных уровнях измерения.

Для решения проблемы хранения агрегатов применяются подчас сложные схемы,

позволяющие при вычислении далеко не всех возможных агрегатов достигать

значительного повышения производительности выполнения запросов.

102.

Как детальные данные, так и агрегаты могут храниться либо в реляционных, либо вмногомерных структурах.

Многомерное хранение позволяет обращаться с данными как с многомерным массивом,

благодаря чему обеспечиваются одинаково быстрые вычисления суммарных показателей и

различные многомерные преобразования по любому из измерений.

Некоторое время назад OLAP-продукты поддерживали либо реляционное, либо

многомерное хранение.

Сегодня, как правило, один и тот же продукт обеспечивает оба этих вида хранения, а также