Similar presentations:

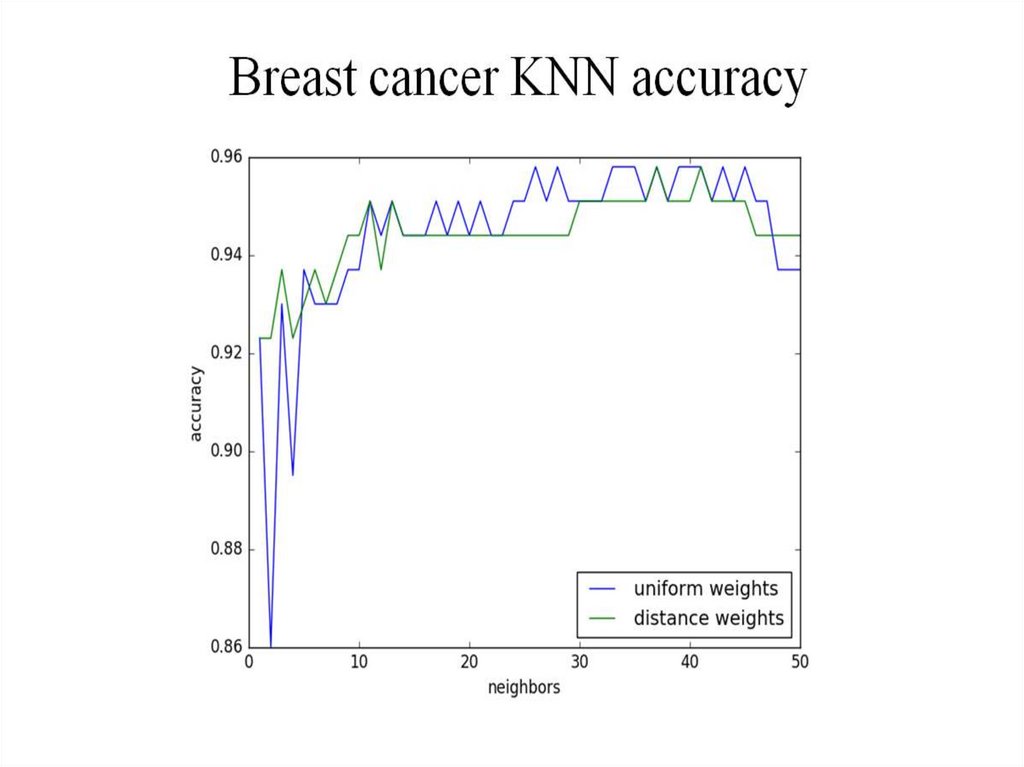

KNN. Задача классификации

1.

2.

3.

4.

5.

6.

7.

8.

9.

10.

11.

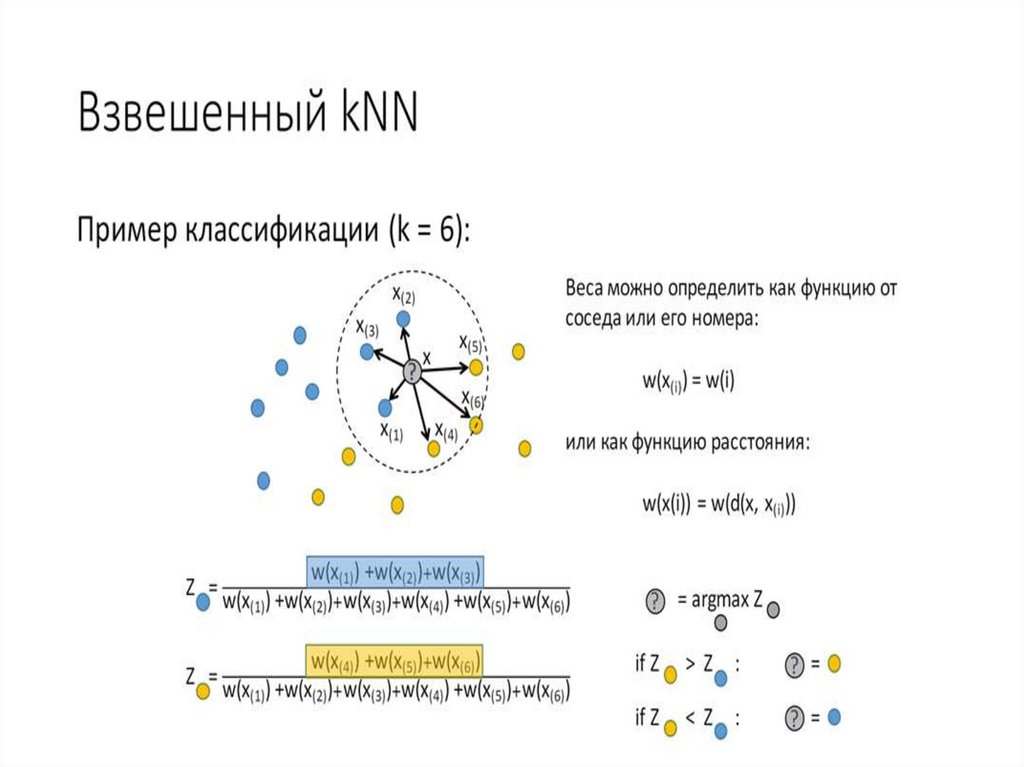

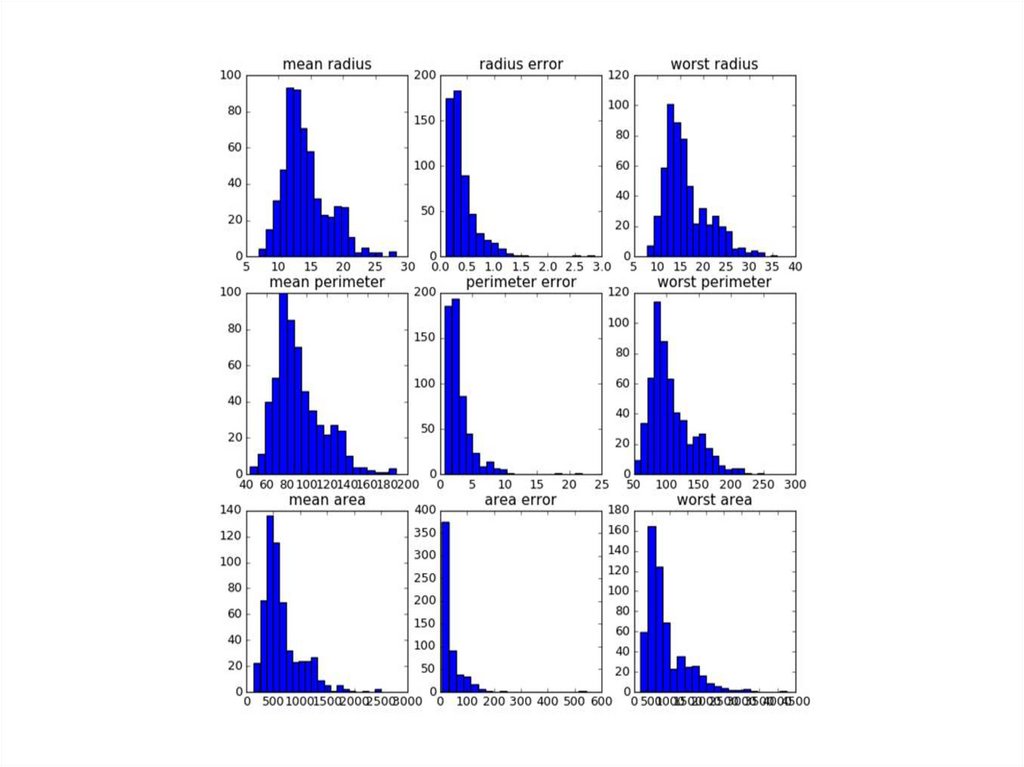

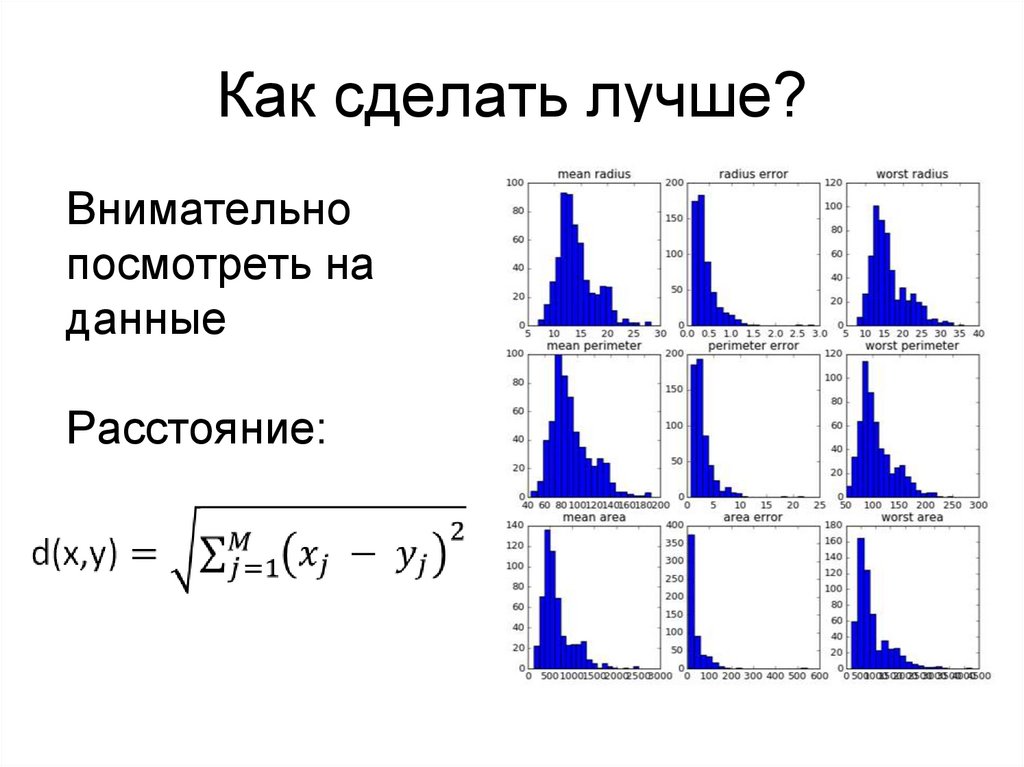

Как сделать лучше?Внимательно

посмотреть на

данные

Расстояние:

12.

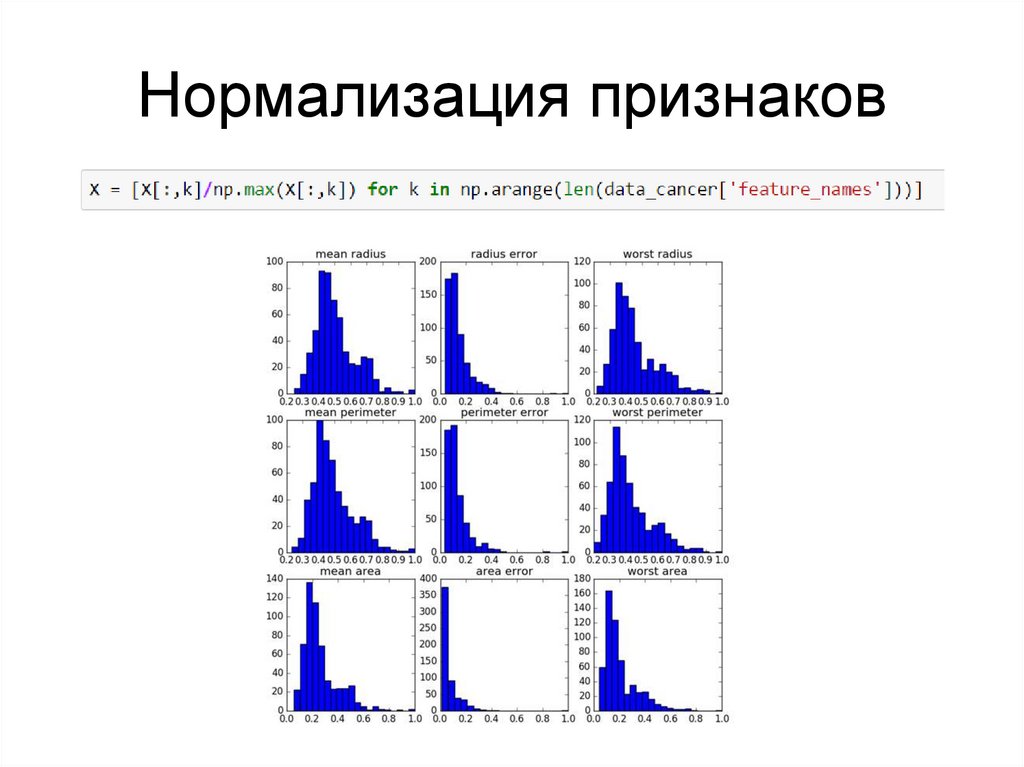

Нормализация признаков13.

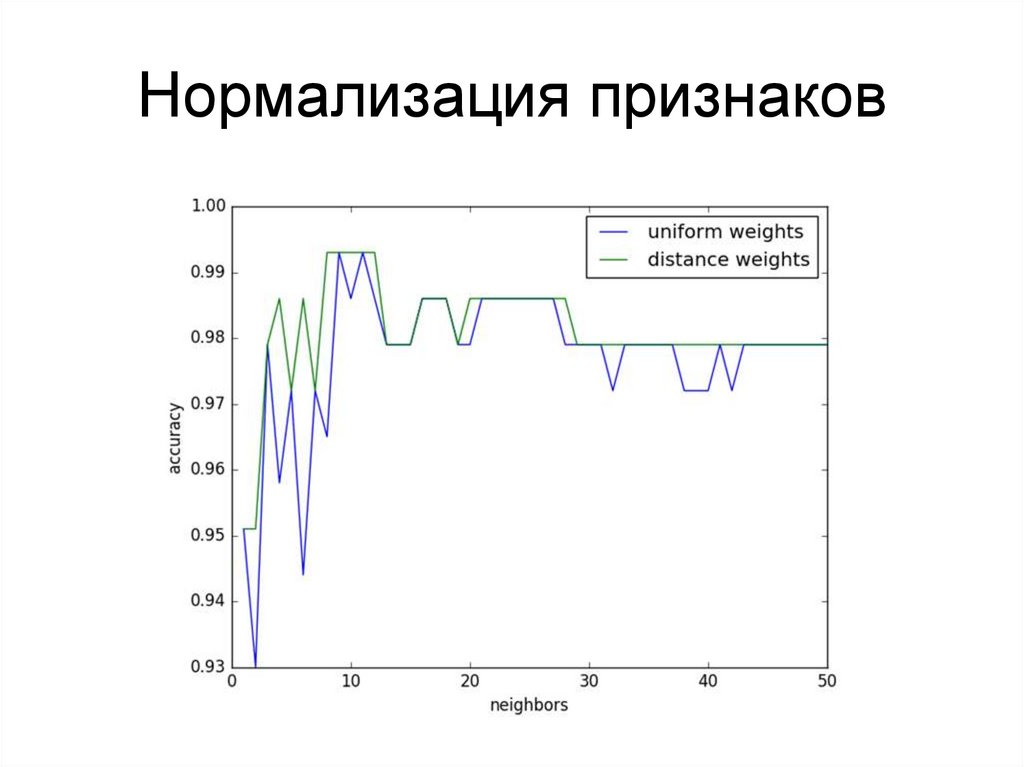

Нормализация признаков14.

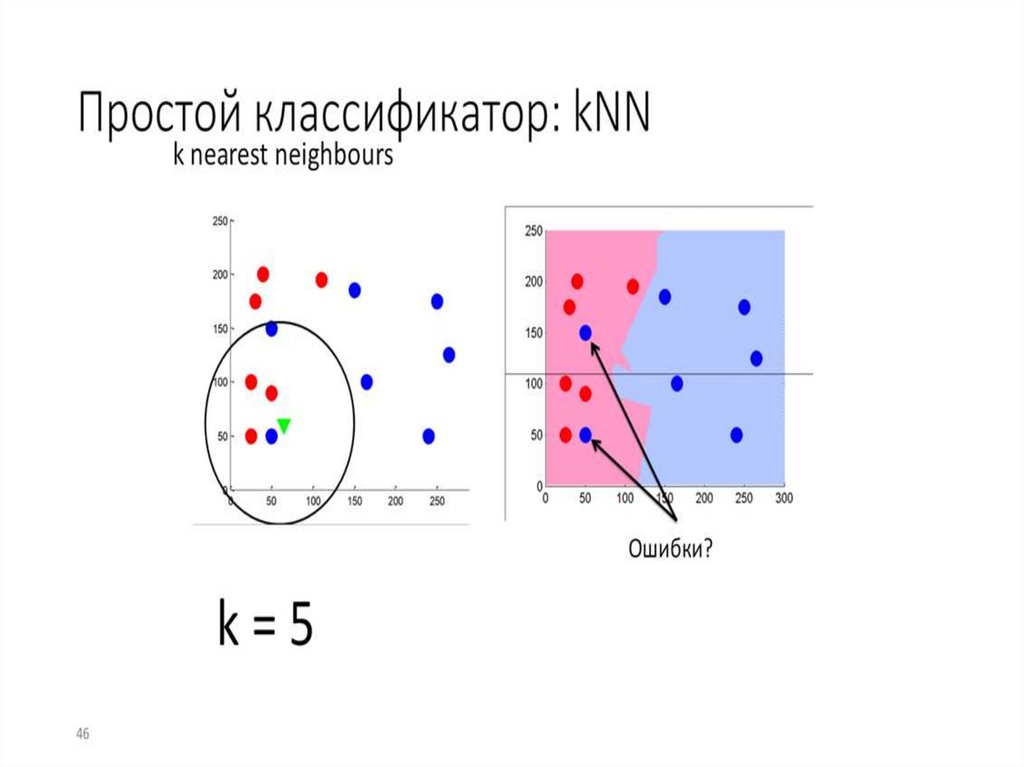

Почему равномерно взвешенный 2NN всегдане лучше чем 1NN?

15.

Почему равномерно взвешенный 2NN всегдане лучше чем 1NN?

- если класс второго ближайшего соседа совпадает с

классом первого, ответ алгоритма не меняется

- если класс второго ближайшего соседа не совпадает с

классом первого, возникает неопределенность и

алгоритм не дает никакого ответа.

16.

17.

18.

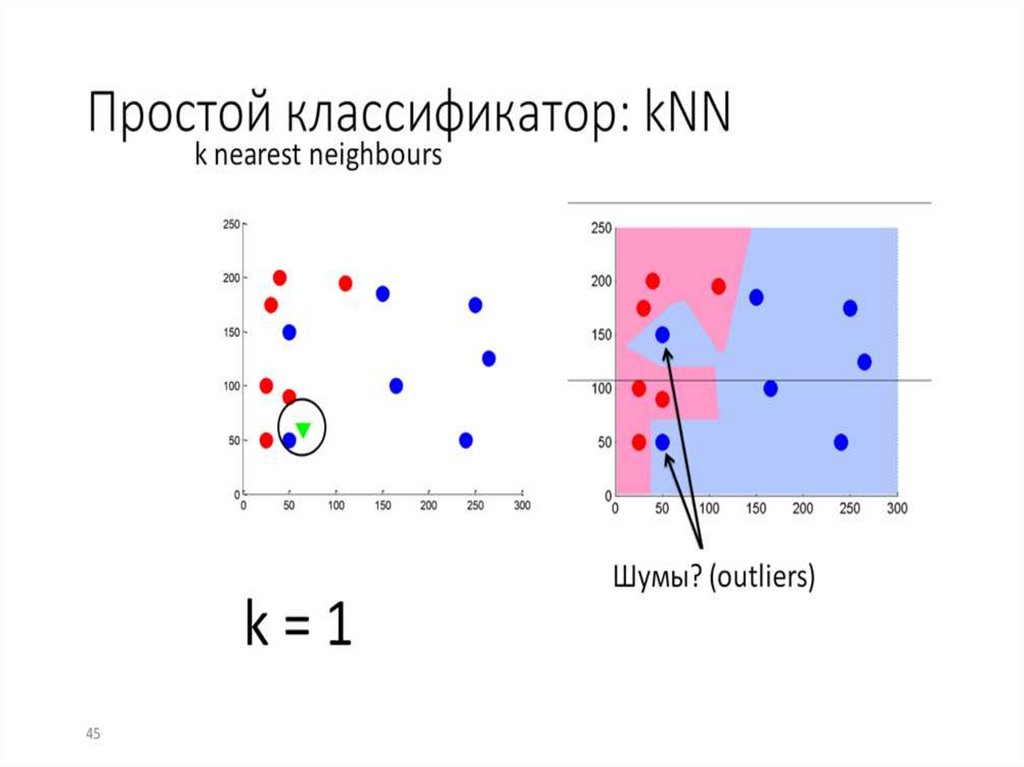

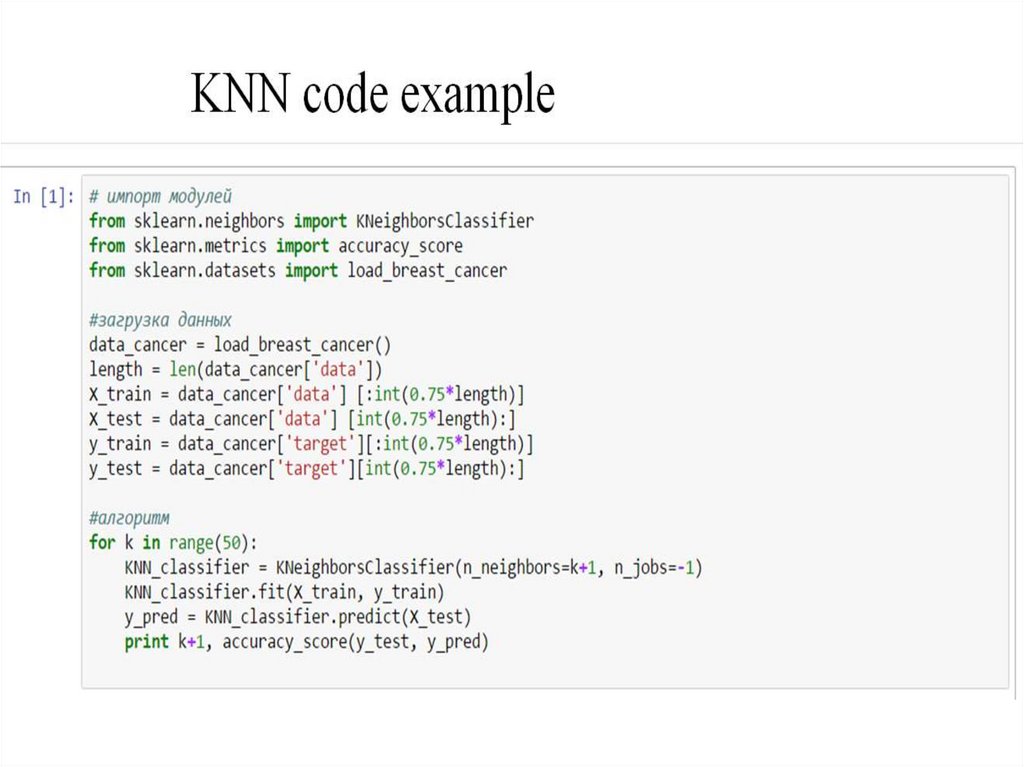

KNN summaryДля классификации каждого из объектов тестовой

выборки необходимо последовательно выполнить

следующие операции:

● Вычислить расстояние до каждого из объектов

обучающей выборки

● Отобрать k объектов обучающей выборки,

расстояние до которых минимально

● Класс классифицируемого объекта — это класс,

наиболее часто встречающийся среди k ближайших

соседей

19.

20.

21.

22.

23.

24.

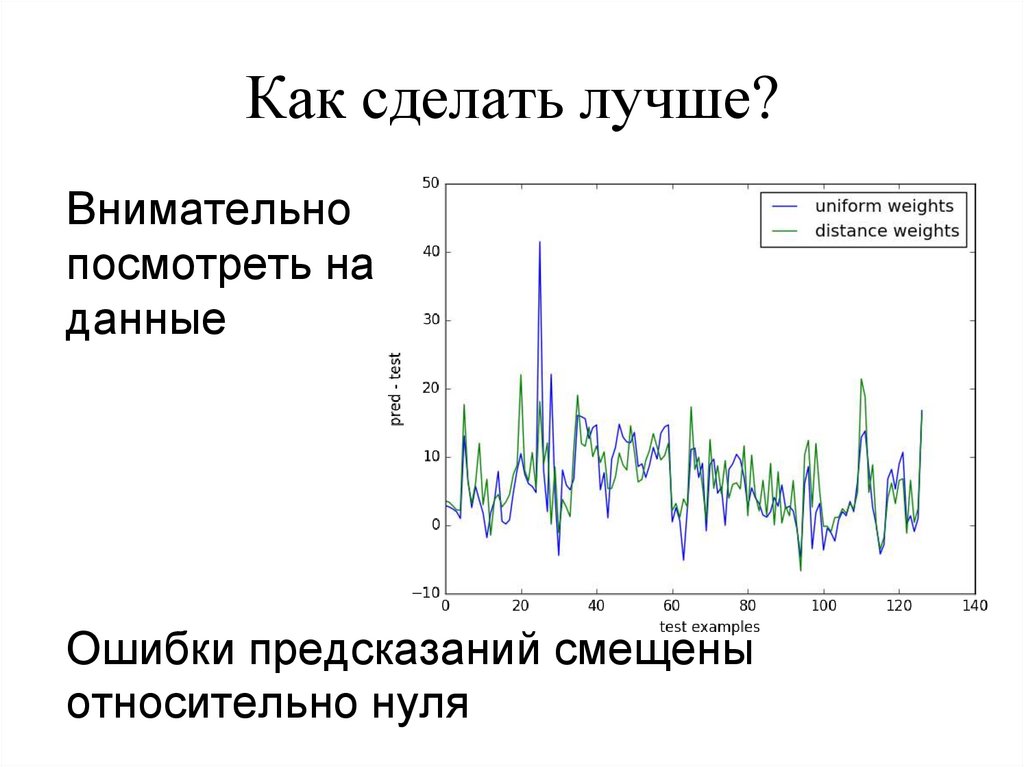

Как сделать лучше?Внимательно

посмотреть на

данные

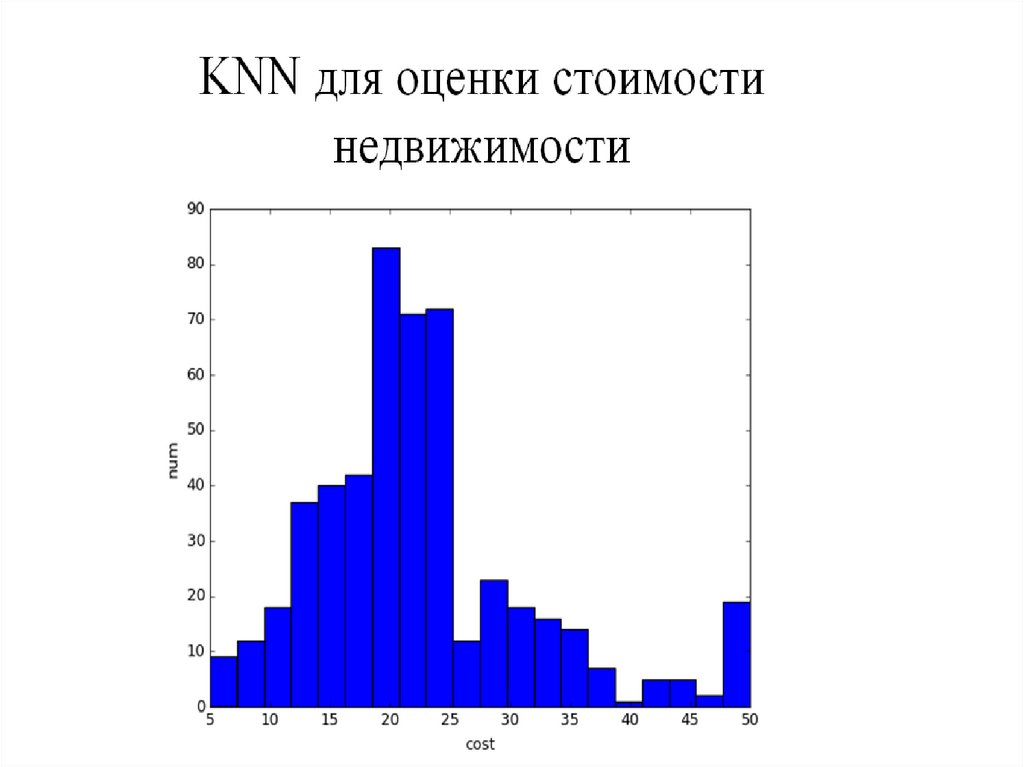

Ошибки предсказаний смещены

относительно нуля

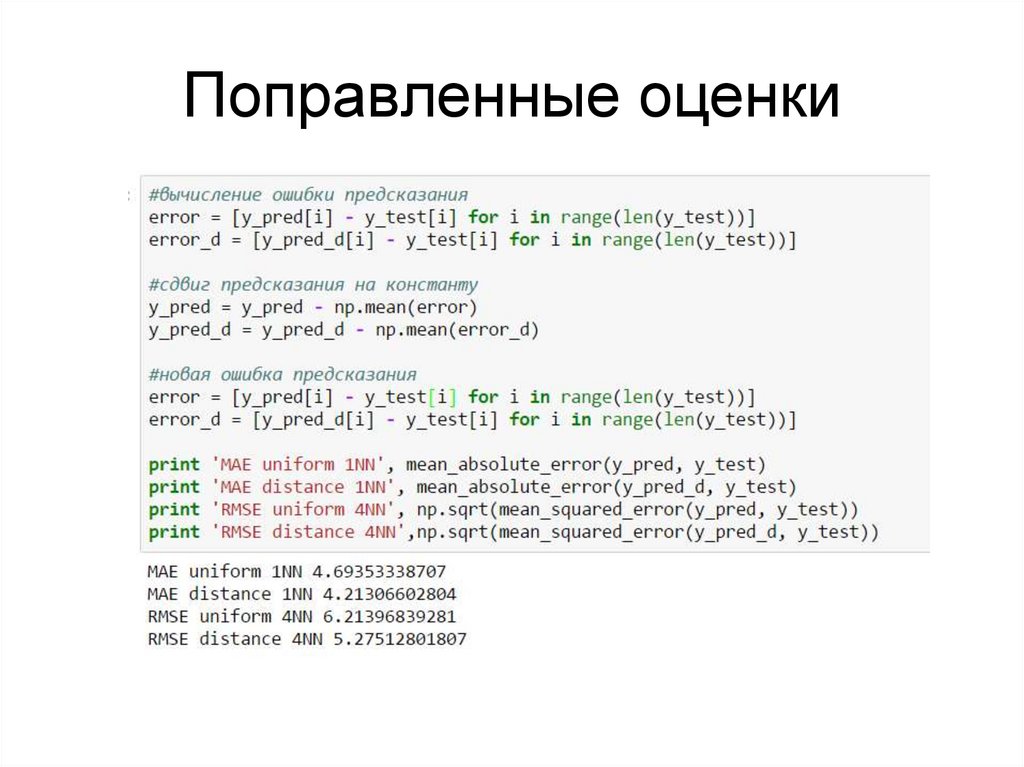

programming

programming