Similar presentations:

Многослойные сети. Алгоритмы обучения

1.

Курс «Нейронные сети и системы нечеткой логики»Лекция 2

Многослойные сети. Алгоритмы обучения.

2. Структура многослойных сетей

Слой 1Слой 2

1. Сети с прямой передачей сигнала (многослойные персептроны, feedforward-сети);

2. Сети с радиально-базисными функциями;

3. Многослойные сети

Особенности:1. Нейроны выходного слоя обычно имеют линейную функцию активации;

2. Принцип работы существенно зависит от выбранной функции активации скрытых

нейронов;

3. Наиболее часто используемая структура сети;

Преимущества:

1. Принцип работы легко описывается матричными уравнениями;

2. Универсальный аппроксиматор/классификатор;

Недостатки:

1. Сложные алгоритмы обучения;

2. Отсутствие точной методики выбора количества слоев и нейронов в них;

4.

Алгоритмы обученияКлассификация алгоритмов

1.

2.

3.

4.

По математическому аппарату:

Алгоритмы локальной оптимизации с вычислением частных

производных первого порядка;

Алгоритмы локальной оптимизации с вычислением частных

производных первого и второго порядка;

Стохастические алгоритмы оптимизации;

Глобальные методы оптимизации.

По наличию эталонного сигнала

1. Контролируемое обучение.

2. Неконтролируемое обучение (без учителя).

5.

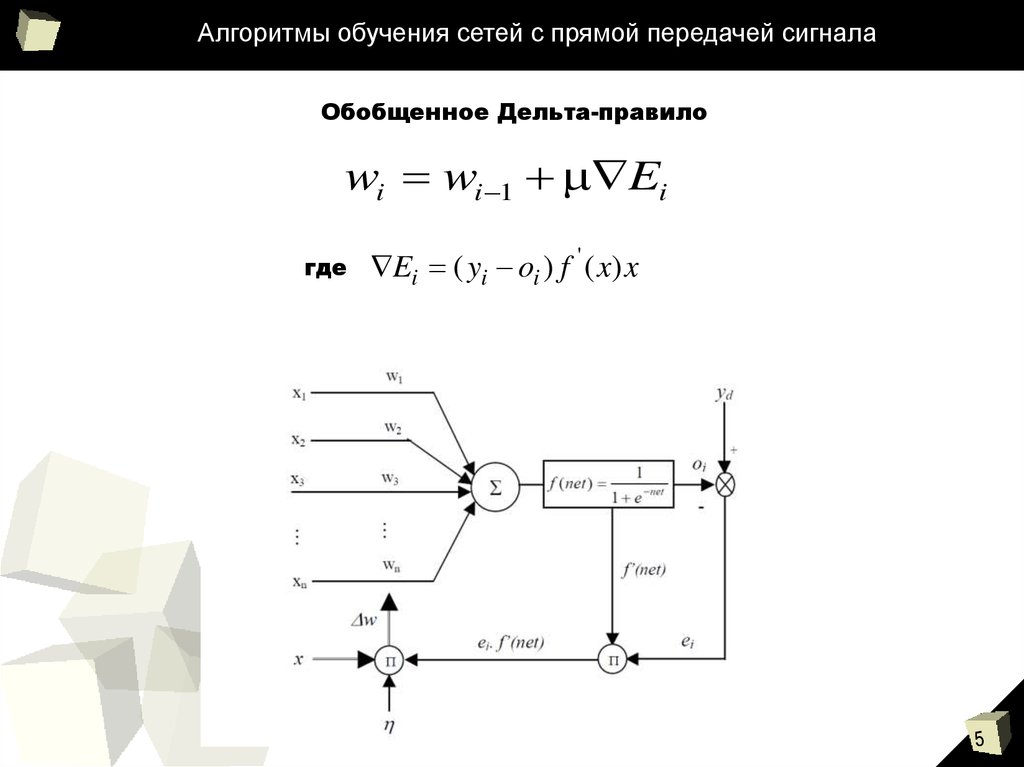

Алгоритмы обучения сетей с прямой передачей сигналаОбобщенное Дельта-правило

wi wi 1 Ei

где

Ei ( yi oi ) f ' ( x) x

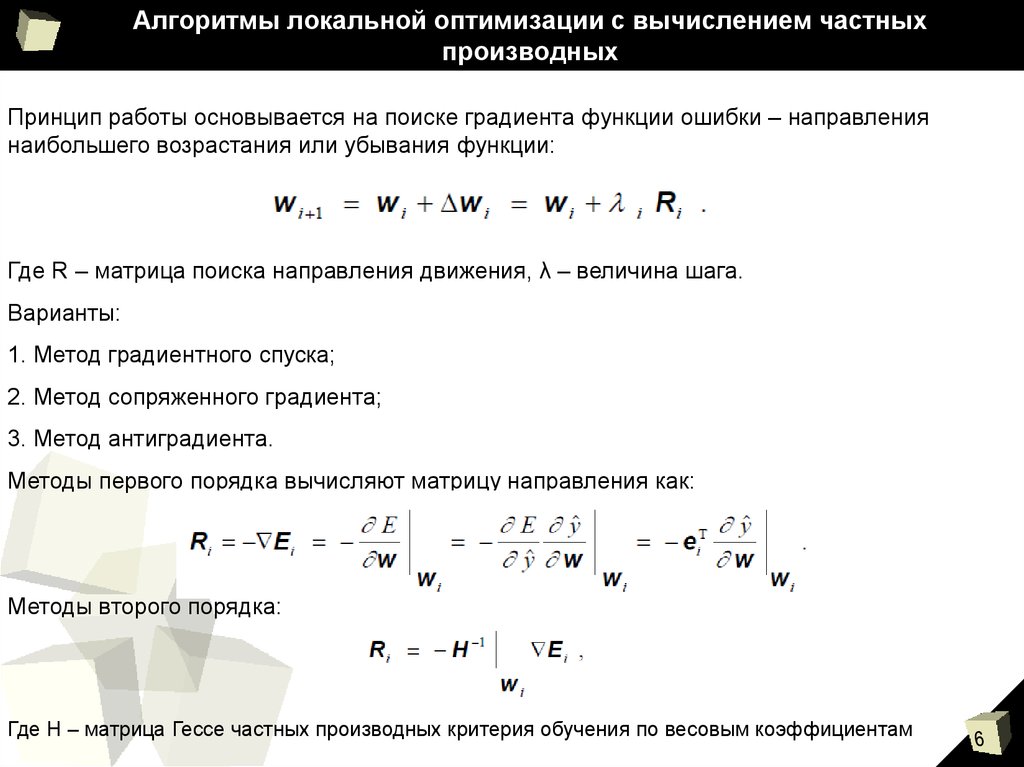

6. Алгоритмы локальной оптимизации с вычислением частных производных

Принцип работы основывается на поиске градиента функции ошибки – направлениянаибольшего возрастания или убывания функции:

Где R – матрица поиска направления движения, λ – величина шага.

Варианты:

1. Метод градиентного спуска;

2. Метод сопряженного градиента;

3. Метод антиградиента.

Методы первого порядка вычисляют матрицу направления как:

Методы второго порядка:

Где Н – матрица Гессе частных производных критерия обучения по весовым коэффициентам

7. Стохастические методы обучения

В основе работы – поиск и обход локальных минимумов функции ошибки по принципу«проб и ошибок».

Варианты:

1. Машины Больцманна;

2. Метод Монте-Карло и др.

Случайный характер изменения направления поиска увеличивает затраты времени на

обучение сетей. Такой алгоритм применяется редко в чистом виде.

Использование генетических алгоритмов позволяет ускорить поиск и обход локальных

минимумов за счет случайных «мутаций».

8. Методы глобальной оптимизации

Решение задачи глобальной оптимизации состоит в систематическом переборе значенийвсех аргументов.

Данный метод применяется только для сетей с простой структурой, поскольку сложность

математических расчетов существенно возрастает с увеличением размерности решаемой

задачи.

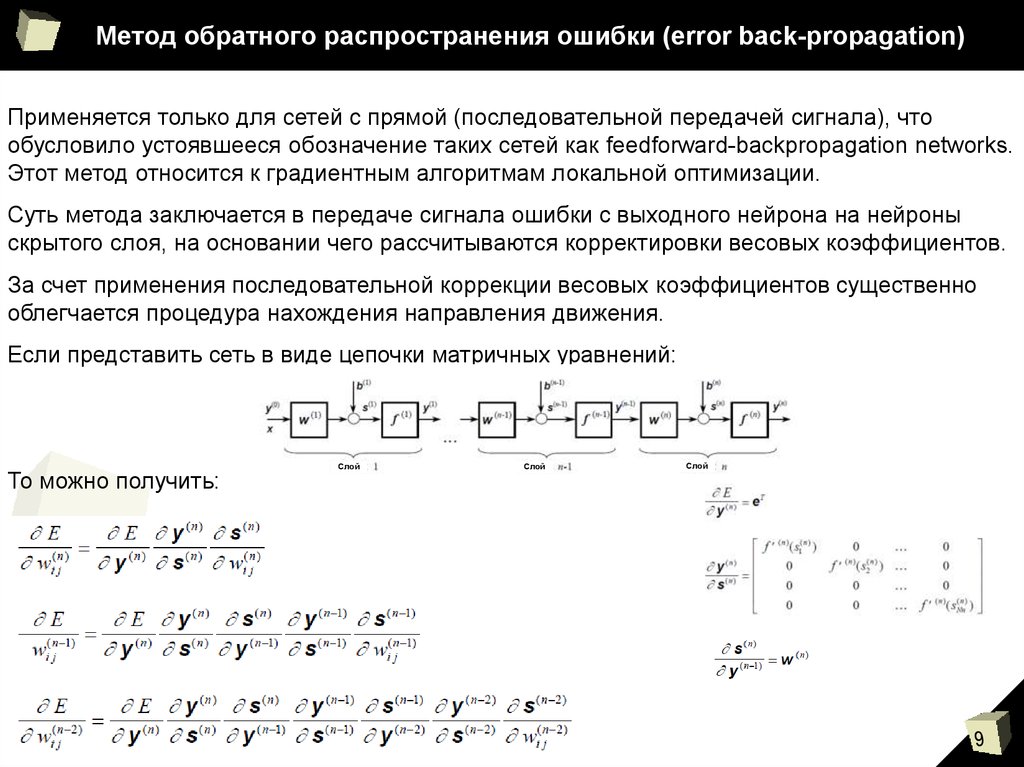

9. Метод обратного распространения ошибки (error back-propagation)

Применяется только для сетей с прямой (последовательной передачей сигнала), чтообусловило устоявшееся обозначение таких сетей как feedforward-backpropagation networks.

Этот метод относится к градиентным алгоритмам локальной оптимизации.

Суть метода заключается в передаче сигнала ошибки с выходного нейрона на нейроны

скрытого слоя, на основании чего рассчитываются корректировки весовых коэффициентов.

За счет применения последовательной коррекции весовых коэффициентов существенно

облегчается процедура нахождения направления движения.

Если представить сеть в виде цепочки матричных уравнений:

То можно получить:

Слой

Слой

Слой

10. Метод обратного распространения ошибки (error back-propagation)

1. Выходной слой:2. Скрытый слой:

Производная от функции активации нейронов:

11.

Алгоритмы обученияНедостатки метода обратного распространения

ошибки

12. Некоторые алгоритмы неконтролируемого обучения

1. Правило Хебба.Если нейрон получает на вход сигнал другого

нейрона и они оба являются активными, то есть,

имеют

одинаковый

знак,

то

весовой

коэффициент связи этих нейронов необходимо

усилить.

2. Правило Хопфилда.

Если входной и выходной сигнал одновременно

активны или неактивны, весовой коэффициент

связи этих сигналов необходимо увеличить на

величину коэффициента обучения, в противном

случае его необходимо уменьшить на эту же

величину.

3. Правило Кохонена (победитель получает все).

На выход нейронной сети подается выходной

сигнал

нейрона

с

наибольшим

значением

выходного

сигнала

(победителя).

Корректировка

весовых

коэффициентов

осуществляется только для этого нейрона и

нейронов

из

некоторой

окрестности

в

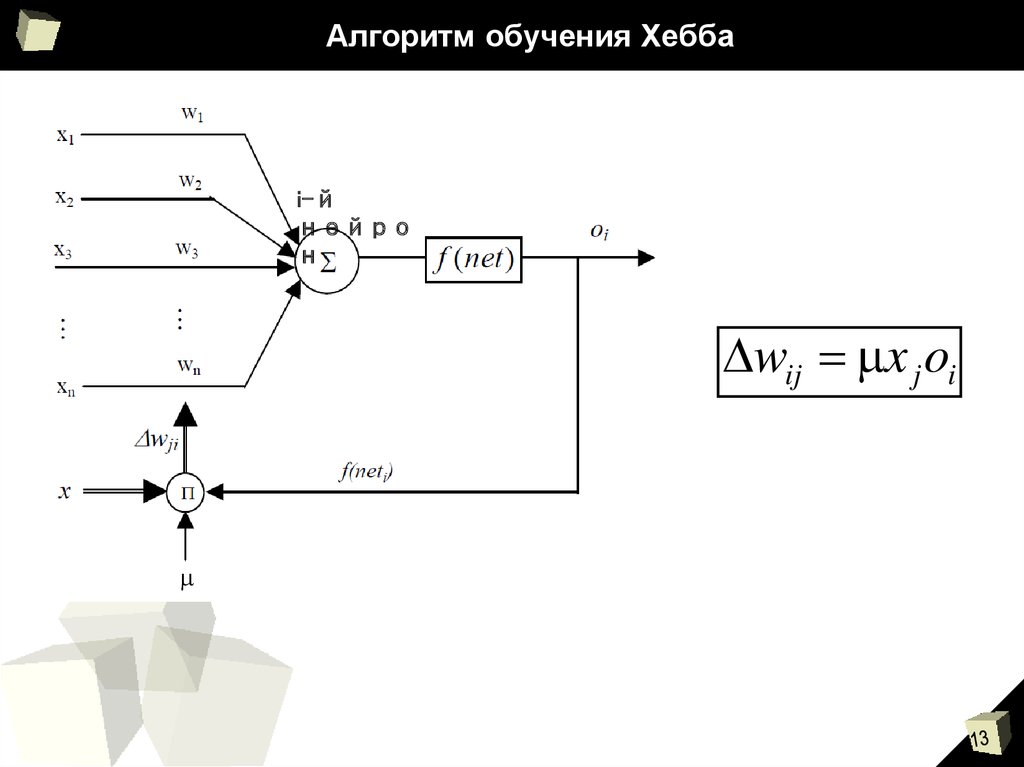

13. Алгоритм обучения Хебба

i-йнейро

н

wij x j oi

14. Алгоритм конкурентного обучения Кохонена

НейронпобедительНормализация

вектора весовых

коэффициентов:

wiT wi 1

Коррекция

вектора весовых

коэффициентов:

wm x wm

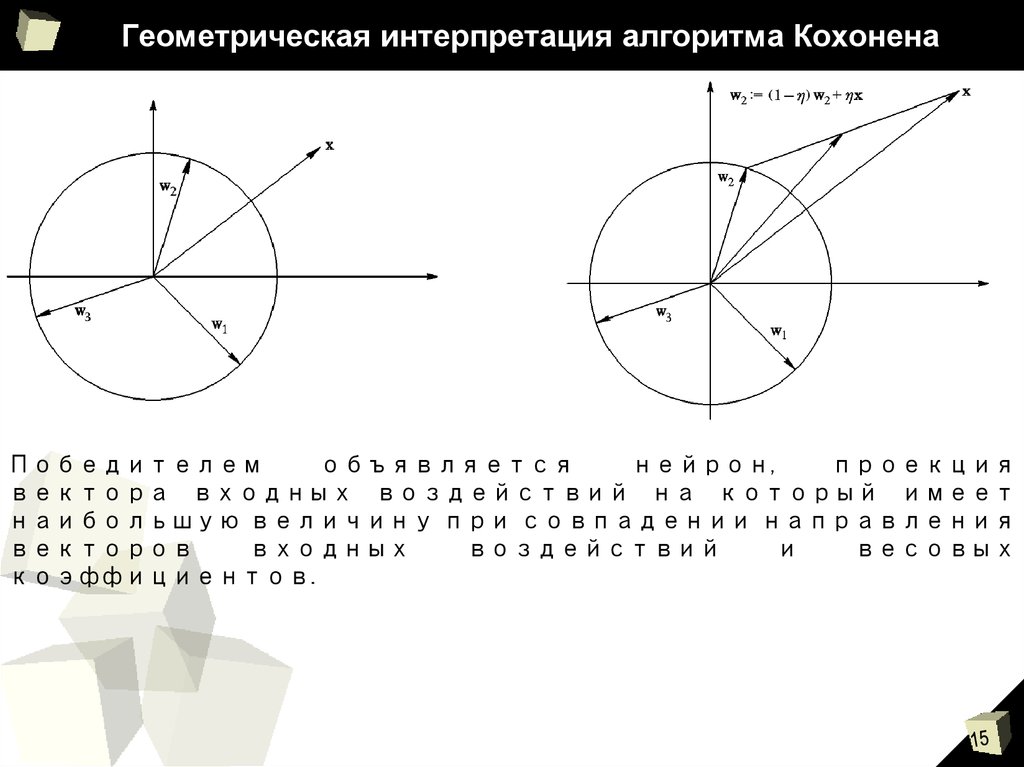

15. Геометрическая интерпретация алгоритма Кохонена

Победителемобъявляется

нейрон,

проекция

вектора входных воздействий на который имеет

наибольшую величину при совпадении направления

векторов

входных

воздействий

и

весовых

коэффициентов.

16. Сети Кохонена с самоорганизующейся структурой

Сеть с самоорганизующейся структурой(SOM – self-organising map) выполняет

отображение

последовательности

входных воздействий на многомерный

массив узловых точек.

Условие выбора наилучшего соответствия:

c x wi min x wi

x wi

x

n

j 1

wij

2

j

17. Топологии сетей Кохонена

Топология типа «Сетка» - «Grid»18. Топологии сетей Кохонена

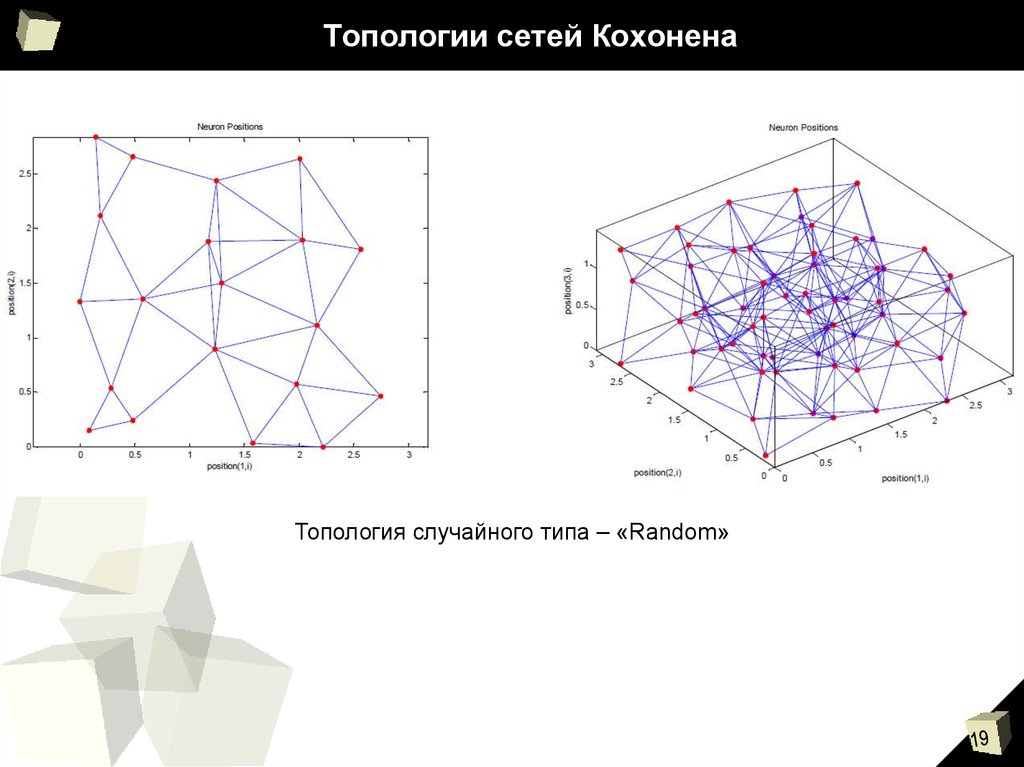

Топология типа «Шестиугольник» - «Hexagon»19. Топологии сетей Кохонена

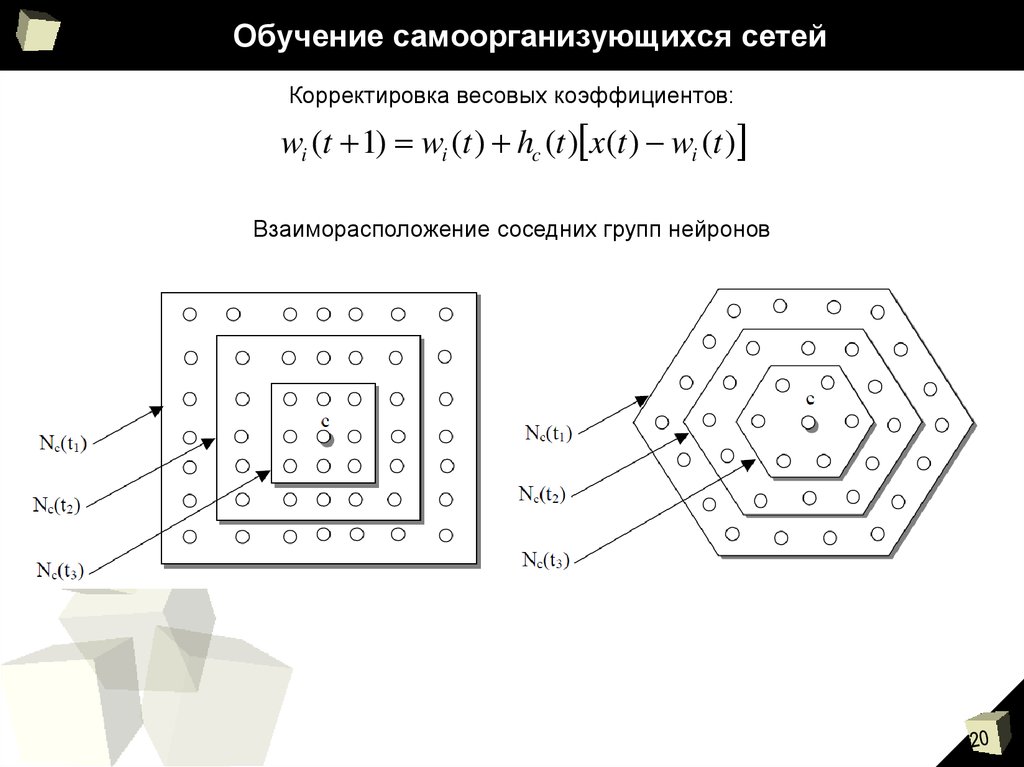

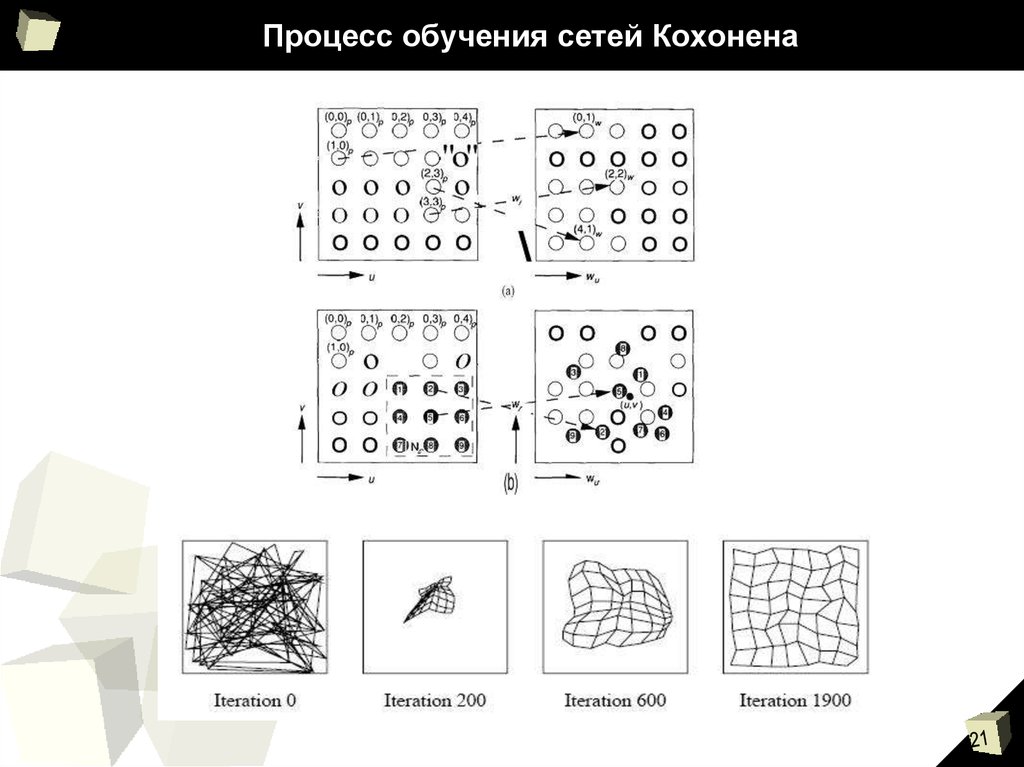

Топология случайного типа – «Random»20. Обучение самоорганизующихся сетей

Корректировка весовых коэффициентов:wi (t 1) wi (t ) hc (t ) x(t ) wi (t )

Взаиморасположение соседних групп нейронов

biology

biology